Heim >Technologie-Peripheriegeräte >KI >Die KI-Gedankenlesetechnologie wurde verbessert! Eine Brille steuert den Bostoner Roboterhund direkt und macht gehirngesteuerte Roboter zur Realität

Die KI-Gedankenlesetechnologie wurde verbessert! Eine Brille steuert den Bostoner Roboterhund direkt und macht gehirngesteuerte Roboter zur Realität

- 王林nach vorne

- 2024-02-07 08:15:281484Durchsuche

Erinnern Sie sich noch an die KI-Gedankenlesefähigkeiten von früher? In letzter Zeit hat sich die Fähigkeit, „alle Wünsche wahr werden zu lassen“, wieder weiterentwickelt,

– Menschen können Roboter direkt durch ihre eigenen Gedanken steuern!

MIT-Forscher haben das Ddog-Projekt veröffentlicht. Sie entwickelten unabhängig voneinander ein Brain-Computer-Interface (BCI)-Gerät zur Steuerung des Roboterhundes Spot von Boston Dynamics.

Hunde können sich in bestimmte Bereiche bewegen, Menschen dabei helfen, Dinge zu besorgen, oder Fotos entsprechend den Gedanken des Menschen machen.

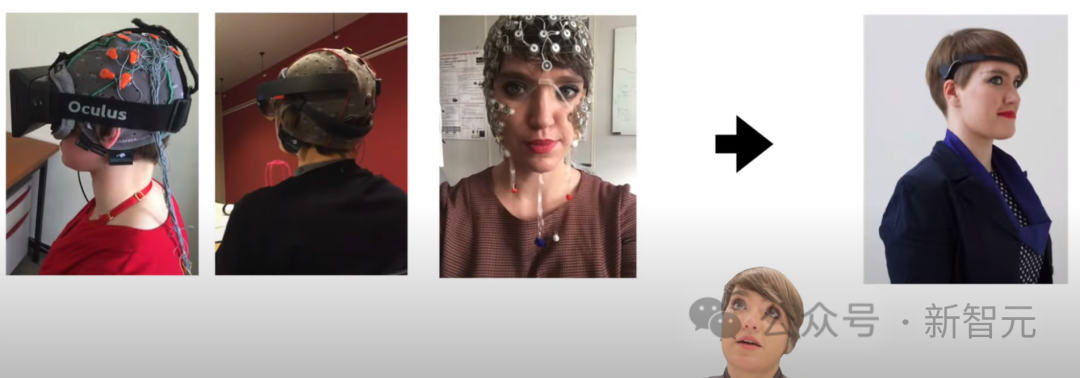

Im Vergleich zur vorherigen Kopfbedeckung, die den Einsatz vieler Sensoren zum „Lesen der Gedanken“ erforderte, wird das Gehirn-Computer-Schnittstellengerät dieses Mal in Form einer drahtlosen Brille (AttentivU) präsentiert.

Obwohl das im Video gezeigte Verhalten einfach ist, besteht der Zweck dieses Systems darin, Spot in ein grundlegendes Kommunikationstool zu verwandeln, um Menschen mit Krankheiten wie ALS, Zerebralparese oder Rückenmarksverletzungen zu helfen.

Nur zwei iPhones und eine Brille können verzweifelten Menschen praktische Hilfe und Pflege bringen.

Und wie wir in entsprechenden Artikeln sehen werden, basiert dieses System tatsächlich auf einer sehr komplexen Technik.

Papieradresse: https://doi.org/10.3390/s24010080

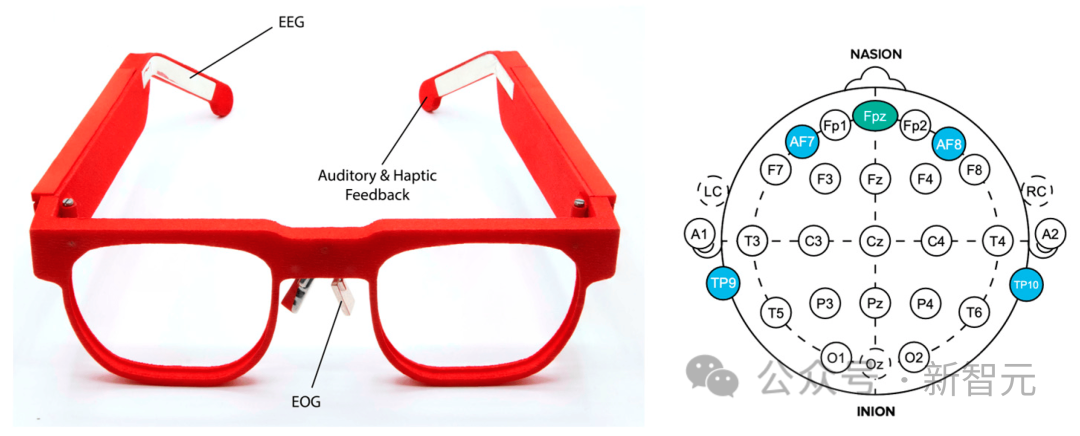

Das Ddog-System verwendet AttentivU als Gehirn-Computer-Schnittstellensystem, und der Sensor ist in den Rahmen eingebettet, um das Elektroenzephalogramm einer Person zu messen (EEG) oder Gehirnaktivität und Elektrookulogramm oder Augenbewegung.

Die Grundlage dieser Forschung ist Brain Switch des MIT, ein Echtzeit-BCI mit geschlossenem Regelkreis, der es Benutzern ermöglicht, nonverbal und in Echtzeit mit Betreuern zu kommunizieren.

Die Erfolgsquote des Ddog-Systems liegt bei 83,4 %, und dies ist das erste Mal, dass ein drahtloses, nicht-visuelles BCI-System in Spot in einem Anwendungsfall für persönliche Assistenten integriert wurde.

Im Video können wir die Entwicklung von Gehirnschnittstellengeräten und einige Gedanken der Entwickler sehen.

Zuvor hat das Forschungsteam die Interaktion zwischen der Gehirn-Computer-Schnittstelle und dem Smart Home abgeschlossen und nun die Steuerung eines Roboters abgeschlossen, der sich bewegen und bedienen kann.

Diese Studien haben besonderen Menschen einen Lichtblick gegeben und ihnen Hoffnung gegeben, in Zukunft zu überleben und sogar besser zu leben.

Im Vergleich zur oktopusähnlichen Sensorkopfbedeckung sind die Brillen unten tatsächlich viel cooler.

Nach Angaben der National Organization for Rare Diseases gibt es derzeit 30.000 ALS-Patienten in den Vereinigten Staaten und jedes Jahr werden schätzungsweise 5.000 neue Fälle diagnostiziert. Darüber hinaus leiden laut Cerebral Palsy Guide etwa 1 Million Amerikaner an Zerebralparese.

Viele dieser Menschen haben oder werden irgendwann die Fähigkeit verlieren, zu gehen, sich anzuziehen, zu sprechen, zu schreiben und sogar zu atmen.

Obwohl es Kommunikationshilfen gibt, handelt es sich bei den meisten um Augengeräte, die es Benutzern ermöglichen, über einen Computer zu kommunizieren. Es gibt nicht viele Systeme, die es Benutzern ermöglichen, mit der Welt um sie herum zu interagieren.

Dieses vierbeinige Robotersystem von BCI dient als früher Prototyp und ebnet den Weg für die zukünftige Entwicklung moderner persönlicher Assistenzroboter.

Hoffentlich können wir in zukünftigen Iterationen noch mehr erstaunliche Funktionen sehen.

Gehirngesteuerter Vierbeiner-Roboter

In dieser Arbeit untersuchen Forscher, wie drahtlose und tragbare BCI-Geräte einen Vierbeiner-Roboter steuern können – Boston Dynamics' Spot.

Das von den Forschern entwickelte Gerät misst die Aktivität des Elektroenzephalogramms (EEG) und Elektrookulogramms (EOG) des Benutzers über im Brillengestell eingebettete Elektroden.

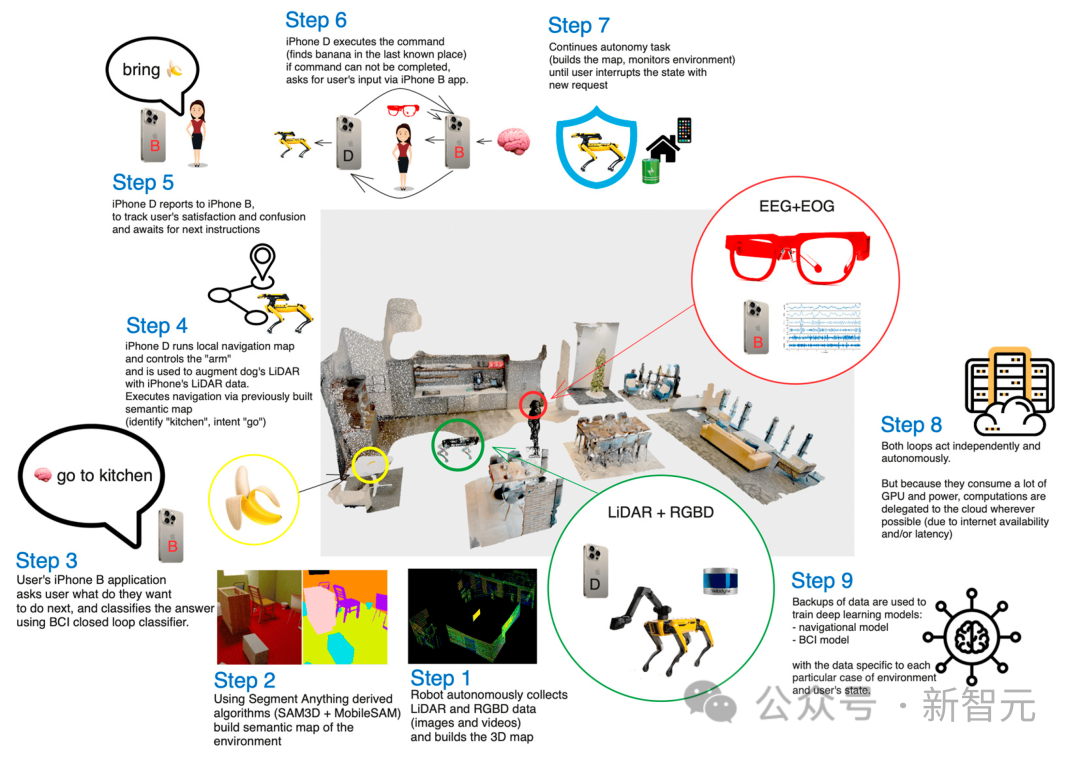

Benutzer beantworten im Kopf eine Reihe von Fragen („Ja“ oder „Nein“), und jede Frage entspricht einer Reihe voreingestellter Spot-Operationen.

Fordern Sie Spot beispielsweise auf, durch einen Raum zu gehen, einen Gegenstand (z. B. eine Flasche Wasser) aufzunehmen und ihn dann für den Benutzer zurückzuholen.

Roboter und BCI

Bis heute ist das EEG eine der praktischsten und anwendbarsten nicht-invasiven Gehirn-Computer-Schnittstellenmethoden.

BCI-Systeme können mithilfe endogener (spontaner) oder exogener (evozierter) Signale gesteuert werden.

In exogenen Gehirn-Computer-Schnittstellen treten evozierte Signale auf, wenn eine Person auf äußere Reize wie visuelle oder akustische Hinweise achtet.

Zu den Vorteilen dieser Methode gehören ein minimalistisches Training und hohe Bitraten von bis zu 60 Bit/min. Dies erfordert jedoch, dass sich der Benutzer immer auf den Reiz konzentriert, was die Anwendbarkeit im wirklichen Leben einschränkt. Darüber hinaus ermüden Benutzer bei der Verwendung exogener BCIs schnell.

In endogenen Gehirn-Computer-Schnittstellen werden Steuersignale unabhängig von jeglicher äußerer Stimulation generiert und können vom Benutzer bei Bedarf vollständig ausgeführt werden. Für Benutzer mit sensorischen Beeinträchtigungen bietet dies eine natürlichere und intuitivere Art der Interaktion, da Benutzer spontan Befehle an das System erteilen können.

Diese Methode erfordert jedoch normalerweise eine längere Einarbeitungszeit und hat eine niedrigere Bitrate.

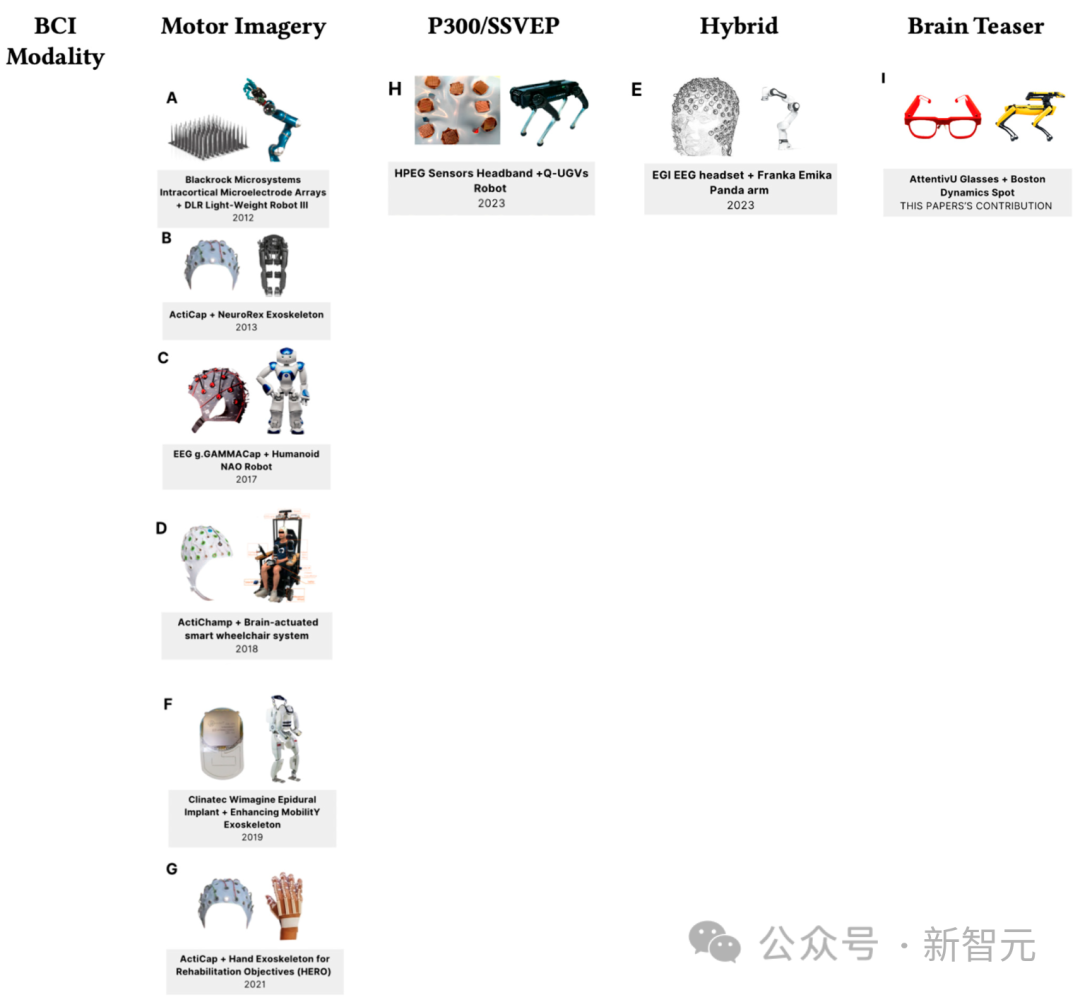

Roboteranwendungen mit Gehirn-Computer-Schnittstellen eignen sich häufig für hilfsbedürftige Menschen und umfassen häufig Rollstühle und Exoskelette.

Die folgende Abbildung zeigt die neuesten Fortschritte bei der Gehirn-Computer-Schnittstelle und der Robotiktechnologie ab 2023.

Vierbeinerroboter werden häufig zur Unterstützung von Benutzern in komplexen Arbeitsumgebungen oder Verteidigungsanwendungen eingesetzt.

Einer der bekanntesten vierbeinigen Roboter ist der Spot von Boston Dynamics, der bis zu 15 Kilogramm Nutzlast transportieren und Wartungsstellen wie Tunnel iterativ kartieren kann. Auch die Immobilien- und Bergbaubranche setzt vierbeinige Roboter wie Spot ein, um Baustellen mit komplexer Logistik zu überwachen.

Dieser Artikel verwendet den von der mobilen BCI-Lösung gesteuerten Spot-Roboter und basiert auf Kopfrechenaufgaben. Die Gesamtarchitektur heißt Ddog.

Ddog-Architektur

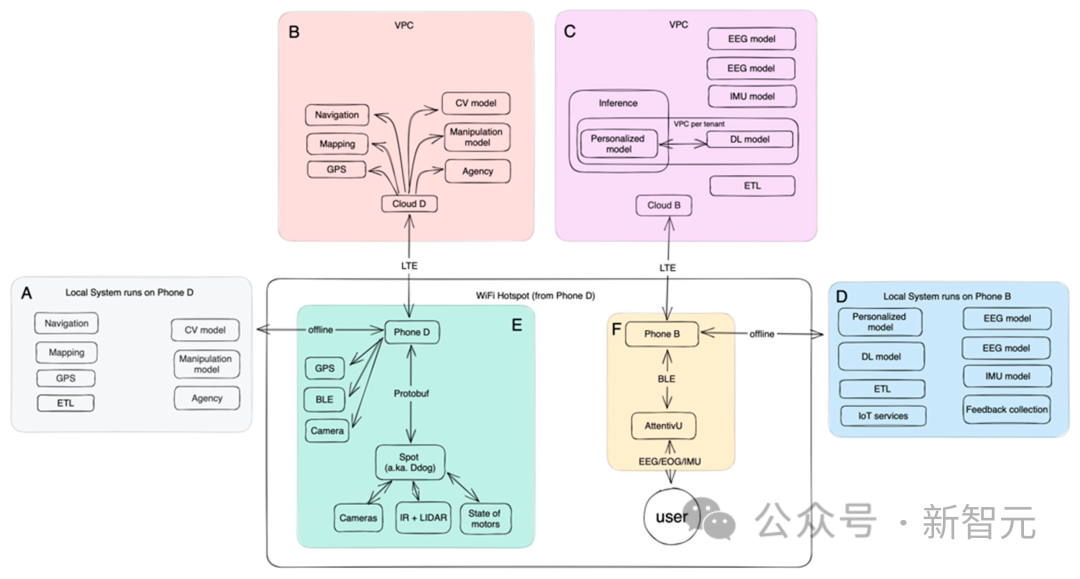

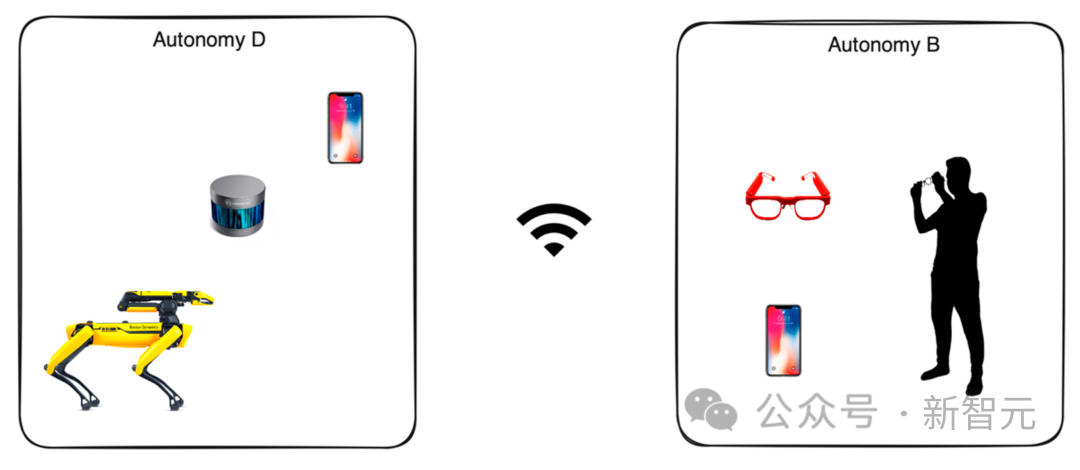

Die folgende Abbildung zeigt die Gesamtstruktur von Ddog:

Ddog ist eine autonome Anwendung, die es Benutzern ermöglicht, den Spot-Roboter durch Eingaben von BCI und der Anwendung zu steuern nutzt Stimme. Geben Sie Benutzern und ihren Betreuern Feedback.

Das System ist so konzipiert, dass es vollständig offline oder vollständig online funktioniert. Die Online-Version verfügt über einen fortschrittlicheren Satz maschineller Lernmodelle sowie besser abgestimmte Modelle und ist für lokale Geräte energieeffizienter.

Das gesamte System ist für reale Szenarien konzipiert und ermöglicht in den meisten Teilen eine schnelle Iteration.

Auf der Clientseite interagiert der Benutzer mit dem Gehirn-Computer-Schnittstellengerät (AttentivU) über eine mobile Anwendung, die das Bluetooth Low Energy (BLE)-Protokoll verwendet, um mit dem Gerät zu kommunizieren.

Das Mobilgerät des Benutzers kommuniziert mit einem anderen Telefon, das den Spot-Roboter steuert, um dem Benutzer Handlungsfähigkeit, Manipulation, Navigation und letztendlich Unterstützung zu ermöglichen.

Die Kommunikation zwischen Telefonen kann über WLAN oder ein Mobilfunknetz erfolgen. Das gesteuerte Mobiltelefon richtet einen WLAN-Hotspot ein und sowohl Ddog als auch das Mobiltelefon des Benutzers sind mit diesem Hotspot verbunden. Im Online-Modus können Sie auch eine Verbindung zu Modellen herstellen, die in der Cloud ausgeführt werden.

Serverseite

Die Serverseite verwendet Kubernetes (K8S)-Cluster, und jeder Cluster wird in seiner eigenen Virtual Private Cloud (VPC) bereitgestellt.

Die Cloud arbeitet in einer dedizierten VPC, die normalerweise in derselben Availability Zone näher an den Endbenutzern bereitgestellt wird, wodurch die Reaktionslatenz für jeden Dienst minimiert wird.

Jeder Container im Cluster ist für einen einzigen Zweck konzipiert (Microservice-Architektur), jeder Dienst ist ein laufendes KI-Modell, seine Aufgaben umfassen: Navigation, Kartierung, Computer Vision, Manipulation, Positionierung und Agentur.

Mapping: Ein Dienst, der Informationen über die Umgebung des Roboters aus verschiedenen Quellen sammelt. Es bildet statische, unbewegliche Daten ab (einen Baum, ein Gebäude, eine Wand), erfasst aber auch dynamische Daten, die sich im Laufe der Zeit ändern (ein Auto, eine Person).

Navigation: Basierend auf den in früheren Diensten gesammelten und erweiterten Kartendaten ist der Navigationsdienst für die Konstruktion des Pfades zwischen Punkt A und Punkt B in Raum und Zeit verantwortlich. Darüber hinaus ist es für die Konstruktion alternativer Routen sowie die Schätzung des Zeitaufwands verantwortlich.

Computer Vision: Sammeln Sie visuelle Daten von Roboterkameras und ergänzen Sie sie mit Daten von Ihrem Telefon, um räumliche und zeitliche Darstellungen zu erstellen. Dieser Dienst versucht auch, jeden visuellen Punkt zu segmentieren und Objekte zu identifizieren.

Die Cloud ist für das Training von BCI-bezogenen Modellen verantwortlich, einschließlich Elektroenzephalogramm (EEG), Elektrookulogramm (EOG) und Inertial Measurement Unit (IMU).

Auf Mobiltelefonen bereitgestellte Offline-Modelle führen die Datenerfassung und -aggregation durch und nutzen gleichzeitig die mobilen Modelle von TensorFlow (optimiert für kleinere RAM- und ARM-basierte CPUs) für Echtzeit-Inferenz.

Vision und Betrieb

Die ursprüngliche Version, die zur Bereitstellung des Segmentierungsmodells verwendet wurde, war ein einzelnes TensorFlow-3D-Modell, das LIDAR-Daten nutzte. Die Autoren erweiterten dies dann auf ein Wenig-Schuss-Modell und verbesserten es durch die Ausführung komplementärer Modelle auf Neural Radiation Field (NeRF)- und RGBD-Daten.

Die von Ddog gesammelten Rohdaten werden von fünf Kameras aggregiert. Jede Kamera kann Graustufen-, Fischaugen-, Tiefen- und Infrarotdaten liefern. Im Greifarm des Arms befindet sich außerdem eine sechste Kamera mit 4K-Auflösung und LED-Funktionen, die mit einem vortrainierten TensorFlow-Modell zur Erkennung von Objekten arbeitet.

Punktwolken werden aus Lidar-Daten und RGBD-Daten von Ddog und Mobiltelefonen generiert. Nachdem die Datenerfassung abgeschlossen ist, werden sie über ein einziges Koordinatensystem normalisiert und an einen globalen Zustand angepasst, der alle Bild- und 3D-Positionierungsdaten zusammenführt.

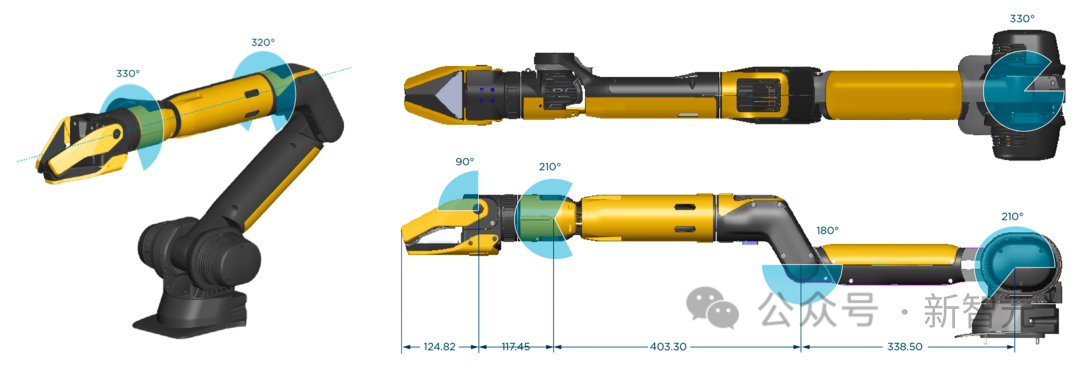

Der Betrieb hängt vollständig von der Qualität des am Ddog installierten Roboterarmgreifers ab. Der Greifer im Bild unten wird von Boston Dynamics hergestellt.

Beschränken Sie Ihre Anwendungsfälle auf grundlegende Interaktionen mit Objekten an vordefinierten Orten.

Der Autor zeichnete einen großen Laborraum und richtete ihn als „Wohnung“ mit einem „Küchen“-Bereich (mit einem Tablett mit verschiedenen Tassen und Flaschen), einem „Wohnzimmer“-Bereich (mit Kissen), einem kleinen Sofa und ein kleiner Couchtisch) und ein „Fenster-Lounge“-Bereich.

Die Anzahl der Anwendungsfälle wächst ständig. Die einzige Möglichkeit, die meisten davon abzudecken, besteht darin, ein System bereitzustellen, das über einen bestimmten Zeitraum kontinuierlich läuft, und die Daten zur Optimierung solcher Abläufe und Erfahrungen zu nutzen.

AttentivU

EEG-Daten werden vom AttentivU-Gerät erfasst. Die Elektroden der AttentivU-Brille bestehen aus natürlichem Silber und befinden sich gemäß dem internationalen 10-20-Elektrodenplatzierungssystem bei TP9 und TP10. Die Brille umfasst außerdem zwei EOG-Elektroden an den Nasenpads und eine EEG-Referenzelektrode am Fpz.

Diese Sensoren können die benötigten Informationen liefern und bei Bedarf einen geschlossenen Regelkreis in Echtzeit ermöglichen.

Das Gerät verfügt über zwei Modi, EEG und EOG, mit denen Signale von Aufmerksamkeit, Engagement, Müdigkeit und kognitiver Belastung in Echtzeit erfasst werden können. Das EEG wurde als neurophysiologischer Indikator für den Übergang zwischen Wachheit und Schlaf verwendet,

, während EOG auf der Messung bioelektrischer Signale basiert, die bei Augenbewegungen aufgrund der Hornhaut-Netzhaut-Dipoleigenschaften induziert werden. Untersuchungen zeigen, dass Augenbewegungen mit der Art des Gedächtniszugriffs korrelieren, der zur Ausführung bestimmter Aufgaben erforderlich ist, und ein gutes Maß für visuelles Engagement, Aufmerksamkeit und Schläfrigkeit sind.

Experiment

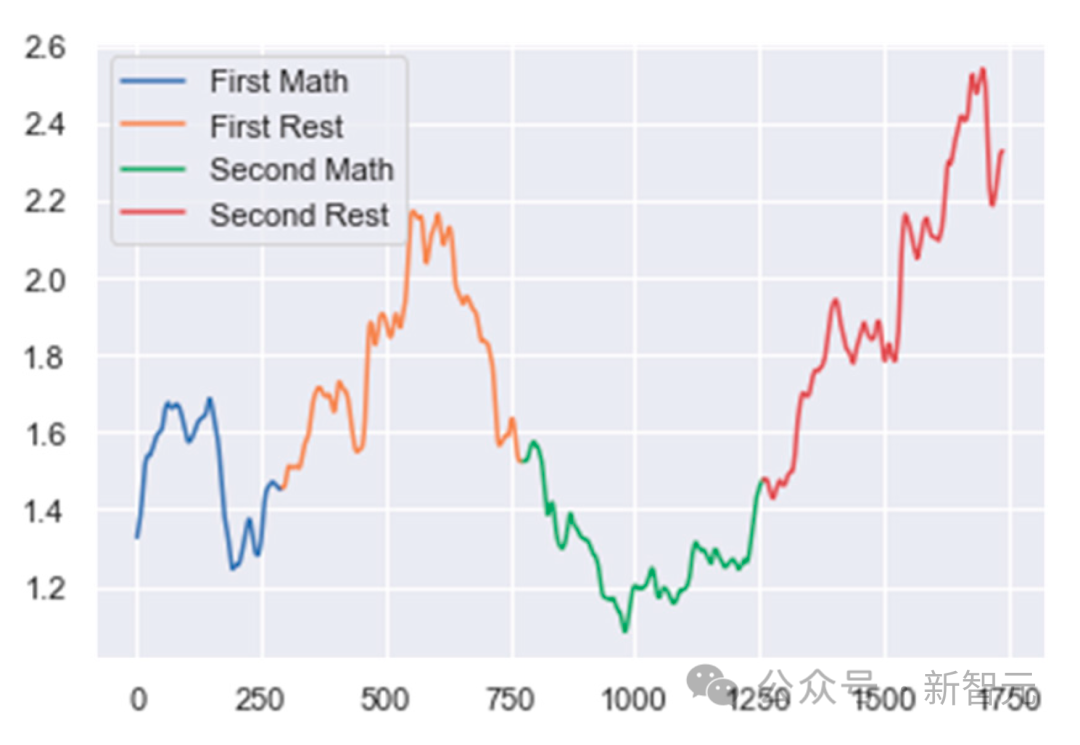

Teilen Sie zunächst die EEG-Daten in mehrere Fenster auf. Definieren Sie jedes Fenster als eine 1 Sekunde lange EEG-Datendauer mit 75 % Überlappung mit dem vorherigen Fenster.

Dann kommt die Datenvorverarbeitung und -bereinigung. Die Daten wurden mithilfe einer Kombination aus einem 50-Hz-Notch-Filter und einem Bandpassfilter mit einem Durchlassbereich von 0,5 Hz bis 40 Hz gefiltert, um die Entfernung von Netzrauschen und unerwünschten hohen Frequenzen sicherzustellen.

Als nächstes erstellte der Autor einen Artefakt-Ablehnungsalgorithmus. Eine Epoche wird abgelehnt, wenn die absolute Leistungsdifferenz zwischen zwei aufeinanderfolgenden Epochen größer als ein vordefinierter Schwellenwert ist.

Im letzten Schritt der Klassifizierung mischten die Autoren verschiedene Spektralband-Leistungsverhältnisse, um die aufgabenbasierte geistige Aktivität jedes Probanden zu verfolgen. Für MA beträgt das Verhältnis (Alpha/Delta). Für WA beträgt das Verhältnis (Delta/Low Beta) und für ME beträgt das Verhältnis (Delta/Alpha).

Verwenden Sie dann einen Änderungspunkterkennungsalgorithmus, um Änderungen in diesen Verhältnissen zu verfolgen. Plötzliche Zunahmen oder Abnahmen dieser Verhältnisse deuten auf eine Veränderung im mentalen Zustand des Benutzers hin.

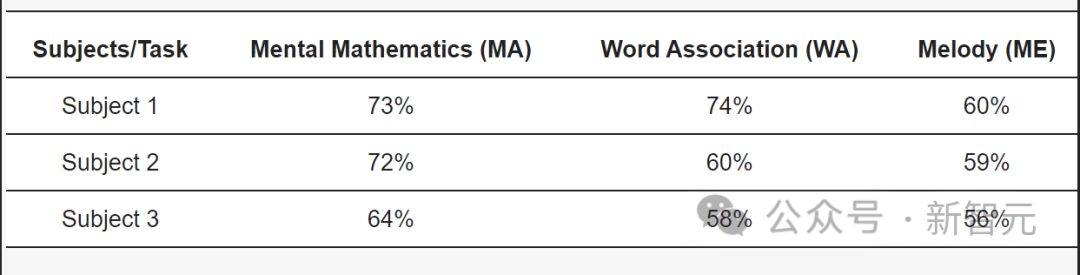

Bei Probanden mit ALS erreichte unser Modell eine Genauigkeit von 73 % bei der MA-Aufgabe, 74 % bei der WA-Aufgabe und 60 % bei der ME-Aufgabe.

Das obige ist der detaillierte Inhalt vonDie KI-Gedankenlesetechnologie wurde verbessert! Eine Brille steuert den Bostoner Roboterhund direkt und macht gehirngesteuerte Roboter zur Realität. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was bedeutet Support apple.com/iphone/restore?

- Metaforscher unternehmen einen neuen Versuch der KI: Sie bringen Robotern das physische Navigieren bei, ohne Karten oder Training

- Das Training von ViT und MAE reduziert den Rechenaufwand um die Hälfte! Sea und die Peking-Universität haben gemeinsam den effizienten Optimierer Adan vorgeschlagen, der für tiefe Modelle verwendet werden kann

- Analyse der KI-Trainingsbeschleunigungsprinzipien und Austausch technischer Praxis

- SRT nutzt die Technologie der Soft-Robotik als Kernstück, um bei der Herstellung qualitativ hochwertiger Entwicklungen zu helfen