Heim >Technologie-Peripheriegeräte >KI >Metaforscher unternehmen einen neuen Versuch der KI: Sie bringen Robotern das physische Navigieren bei, ohne Karten oder Training

Metaforscher unternehmen einen neuen Versuch der KI: Sie bringen Robotern das physische Navigieren bei, ohne Karten oder Training

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 20:31:121723Durchsuche

Die Abteilung für künstliche Intelligenz von Meta Platforms erklärte kürzlich, dass sie KI-Modellen mithilfe einer kleinen Menge an Trainingsdaten beibringen, wie man das Laufen in der physischen Welt lernt, und dabei schnelle Fortschritte gemacht haben.

Diese Forschung kann die Zeit, in der KI-Modelle visuelle Navigationsfähigkeiten erwerben, erheblich verkürzen. Bisher war zum Erreichen solcher Ziele wiederholtes „Reinforcement Learning“ unter Verwendung großer Datensätze erforderlich.

Meta-KI-Forscher sagten, dass diese Erforschung der visuellen KI-Navigation erhebliche Auswirkungen auf die virtuelle Welt haben wird. Die Grundidee des Projekts ist nicht kompliziert: der KI dabei zu helfen, sich genauso wie Menschen durch den physischen Raum zu bewegen, einfach durch Beobachtung und Erkundung.

Die KI-Abteilung von Meta erklärte: „Wenn wir beispielsweise möchten, dass uns eine AR-Brille beim Auffinden von Schlüsseln hilft, müssen wir einen Weg finden, der KI dabei zu helfen, den Aufbau unbekannter und sich ständig ändernder Umgebungen zu verstehen Da sich die Menschen auf hochpräzise voreingestellte Karten verlassen, die viel Rechenleistung verbrauchen, können sie sich problemlos um die Ecken des Couchtisches bewegen, ohne dass es zu Kollisionen kommt Im Fall der „verkörperten KI“ wird das KI-System durch den interaktiven Mechanismus in der 3D-Simulation trainiert. In diesem Bereich hat Meta nach eigenen Angaben ein vielversprechendes „Punktziel-Navigationsmodell“ etabliert, das in neuen Umgebungen ohne Karten oder GPS-Sensoren navigieren kann.

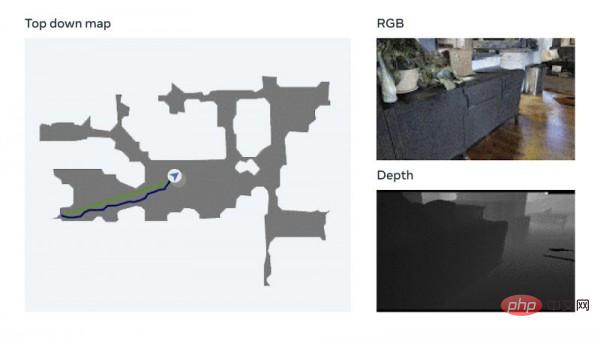

Das Modell nutzt eine Technologie namens visuelle Messung, die es der KI ermöglicht, ihre aktuelle Position anhand visueller Eingaben zu verfolgen. Meta sagte, dass diese Datenerweiterungstechnologie schnell effektive neuronale Modelle trainieren kann, ohne dass eine manuelle Datenanmerkung erforderlich ist. Meta erwähnte auch, dass sie Tests auf ihrer eigenen Habitat 2.0-KI-Trainingsplattform (die die Benchmark-Aufgabe „Realistic PointNav“ verwendet, um Simulationen im virtuellen Raum durchzuführen) mit einer Erfolgsquote von 94 % abgeschlossen haben.

Meta erklärte: „Obwohl unsere Methode nicht alle Szenarien im Datensatz vollständig gelöst hat, hat diese Forschung zunächst gezeigt, dass die Fähigkeit, in realen Umgebungen zu navigieren, nicht unbedingt eine explizite Zuordnung erfordert.“

Meta erklärte: „Obwohl unsere Methode nicht alle Szenarien im Datensatz vollständig gelöst hat, hat diese Forschung zunächst gezeigt, dass die Fähigkeit, in realen Umgebungen zu navigieren, nicht unbedingt eine explizite Zuordnung erfordert.“

In Um das KI-Navigationstraining weiter zu verbessern, ohne auf Karten angewiesen zu sein, hat Meta einen Trainingsdatensatz namens Habitat-Web erstellt, der mehr als 100.000 verschiedene von Menschen demonstrierte Objekt-Ziel-Navigationsmethoden enthält. Der Habitat-Simulator, der in einem Webbrowser läuft, kann problemlos eine Verbindung zum Mechanical Turk-Dienst von Amazon.com herstellen, sodass Benutzer virtuelle Roboter sicher aus der Ferne bedienen können. Meta sagte, die resultierenden Daten würden als Schulungsmaterial verwendet, um KI-Agenten dabei zu helfen, „Ergebnisse auf dem neuesten Stand der Technik“ zu erzielen. Das Scannen des Raums, um die gesamten räumlichen Eigenschaften zu verstehen, das Überprüfen, ob sich in Ecken Hindernisse befinden usw. sind alles effiziente Verhaltensweisen bei der Objektsuche, die KI von Menschen lernen kann.

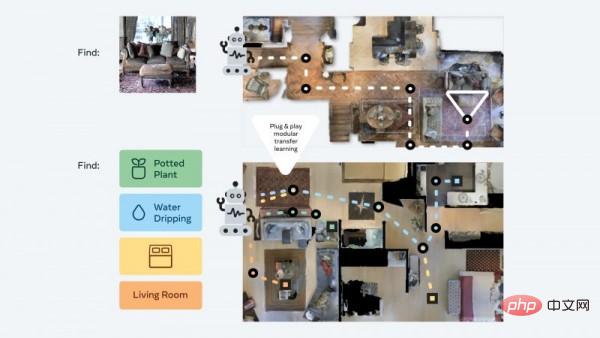

Darüber hinaus hat das Meta AI-Team auch einen sogenannten „Plug-and-Play“-Modulansatz entwickelt, der Robotern helfen kann, durch ein einzigartiges „Zero-Sample-Experience-Learning-Framework“ eine Generalisierung in einer Vielzahl von semantischen Navigationsaufgaben und Zielmodi zu erreichen. . Auf diese Weise können KI-Agenten weiterhin grundlegende Navigationsfähigkeiten erwerben, ohne dass ressourcenintensive Karten und Schulungen erforderlich sind, und können verschiedene Aufgaben in einer 3D-Umgebung ohne zusätzliche Anpassungen ausführen.

Meta erklärt, dass diese Agenten während des Trainings kontinuierlich nach Bildzielen suchen. Sie erhalten ein Foto, das an einem zufälligen Ort in der Umgebung aufgenommen wurde, und versuchen dann mithilfe der autonomen Navigation, den Ort zu finden. Meta-Forscher sagten: „Unsere Methode reduziert die Trainingsdaten auf 1/12,5 und die Erfolgsquote ist 14 % höher als die neueste Transfer-Learning-Technologie, sagte Holger Mueller, Analyst bei Constellation Research, in einem Interview mit der neuesten Meta-Methode.“ Es wird erwartet, dass die Entwicklung eine Schlüsselrolle in seinen Metaverse-Entwicklungsplänen spielt. Er glaubt, dass die KI in der Lage sein muss, diesen neuen Raum zu verstehen, wenn die virtuelle Welt in Zukunft zur Norm werden kann, und die Kosten für das Verständnis sollten nicht zu hoch sein.

Meta erklärt, dass diese Agenten während des Trainings kontinuierlich nach Bildzielen suchen. Sie erhalten ein Foto, das an einem zufälligen Ort in der Umgebung aufgenommen wurde, und versuchen dann mithilfe der autonomen Navigation, den Ort zu finden. Meta-Forscher sagten: „Unsere Methode reduziert die Trainingsdaten auf 1/12,5 und die Erfolgsquote ist 14 % höher als die neueste Transfer-Learning-Technologie, sagte Holger Mueller, Analyst bei Constellation Research, in einem Interview mit der neuesten Meta-Methode.“ Es wird erwartet, dass die Entwicklung eine Schlüsselrolle in seinen Metaverse-Entwicklungsplänen spielt. Er glaubt, dass die KI in der Lage sein muss, diesen neuen Raum zu verstehen, wenn die virtuelle Welt in Zukunft zur Norm werden kann, und die Kosten für das Verständnis sollten nicht zu hoch sein.

Mueller fügte hinzu: „Die Fähigkeit der KI, die physische Welt zu verstehen, muss durch softwarebasierte Methoden erweitert werden. Meta geht derzeit diesen Weg und hat Fortschritte bei der verkörperten KI gemacht, indem es ein System entwickelt, das seine Umgebung ohne Schulung autonom verstehen kann. Ich freue mich darauf, erste praktische Anwendungen davon zu sehen.“

Diese realen Anwendungsfälle sind möglicherweise nicht mehr weit von uns entfernt. Meta sagte, der nächste Schritt bestehe darin, diese Ergebnisse von der Navigation auf den mobilen Betrieb zu übertragen und KI-Agenten zu entwickeln, die bestimmte Aufgaben ausführen können (z. B. die Identifizierung einer Brieftasche und deren Rückgabe an ihren Besitzer).

Das obige ist der detaillierte Inhalt vonMetaforscher unternehmen einen neuen Versuch der KI: Sie bringen Robotern das physische Navigieren bei, ohne Karten oder Training. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr