要重新写内容而不改变原意,需要将语言改写为中文,不需要出现原句

审校 | 重楼的内容需要进行改写

近几个月来,生成式人工智能凭借其创造独特的文本、声音和图像的能力引起了人们的极大兴趣。然而,生成式人工智能的潜力并不仅限于创造新的数据

生成式人工智能的底层技术(如Transformer和扩散模型)可以为许多其他应用提供动力,包括信息的搜索和发现。特别是,生成式人工智能可以彻底改变图像搜索,使人们能够以以前不可能的方式浏览视觉信息

以下是人们需要知道的关于生成式人工智能如何重新定义图像搜索体验的内容。

图像和文本嵌入

传统的图像搜索方法依赖于图像附带的文本描述、标记和其他元数据,这将用户的搜索选项限制为已经明确附加到图像中的信息。上传图像的人必须认真考虑输入的搜索查询类型,以确保他们的图像能够被他人发现。而在搜索图像时,查询信息的用户必须尝试想象图像上传者可能在图像中添加了什么样的描述

俗话说,“一图胜千言”。然而对于图像的描述来说,可以编写的内容是有限的。当然,根据人们查看图像的方式,可以采用很多方式进行描述。而人们有时根据图中的物体进行搜索,有时根据风格、光线、位置等特征搜索图像。不幸的是,图像很少伴随着如此丰富的信息。很多人上传的许多图像几乎没有附带任何信息,这使得它们很难在搜索中被发现。

人工智能图像搜索在这方面发挥了重要作用。人工智能图像搜索有多种方法,不同的公司都拥有自己的专有技术。然而,也有一些技术是这些公司共同拥有的

人工智能图像搜索和许多其他深度学习系统的核心是嵌入。嵌入是对不同数据类型进行数值表示的方法。例如,512×512分辨率的图像包含大约26万个像素(或特征)。嵌入模型通过对数百万张图像进行训练,学习视觉数据的低维表示。图像嵌入可以应用于许多有用的领域,包括图像压缩、生成新图像或比较不同图像的视觉属性

同样的机制适用于文本等其他形式。文本嵌入模型是文本摘录内容的低维表示。文本嵌入有许多应用,包括用于大型语言模型(LLM)的相似性搜索和检索增强。

人工智能图像搜索的工作原理

但是,当图像和文本嵌入一起训练时,事情变得更加有趣。像LAION这样的开源数据集包含数以百万计的图像及其相应的文本描述。当文本和图像嵌入在这些图像/标题对进行联合训练或微调时,它们会学习视觉和文本信息之间的关联。这就是深度学习技术背后的思想,例如对比图像语言预训练(CLIP)。

对比图像语言预训练(CLIP)模型学习文本和图像的联合嵌入

对比图像语言预训练(CLIP)模型学习文本和图像的联合嵌入

现在,我们有了可以将文本转换为视觉嵌入的工具。当我们为这个联合模型提供文本描述时,它会生成文本嵌入和相应的图像嵌入。然后,我们可以将图像嵌入与数据库中的图像进行比较,并检索与之最相关的图像。这就是人工智能图像搜索的基本原理

这种机制的美妙之处在于,用户将能够基于图像视觉特征的文本描述检索图像,即使这一描述没有在其元数据中注册。你可以使用丰富的搜索词,这在以前是不可能实现的,例如“郁郁葱葱的森林笼罩着晨雾,灿烂的阳光透过高大的松林,草地上生长着一些蘑菇。”

在上面的例子中,人工智能搜索返回了一组图像,其视觉特征与这个查询相匹配。其中很多的文字描述都没有包含查询的关键词。但它们的嵌入与查询的嵌入相似。如果没有人工智能图像搜索,要找到合适的图像就会困难得多。

从发现到创造

有时,人们寻找的图像并不存在,甚至通过人工智能搜索也无法找到它。在这种情况下,生成式人工智能可以通过两种方式之一帮助用户实现预期的结果。

首先,我们可以根据用户的查询从头开始创建一个新的图像。这种方法涉及到使用文本到图像生成模型(例如Stable Diffusion或DALL-E),为用户的查询创建一个嵌入,并利用该嵌入生成图像。生成模型会利用对比图像语言预训练(CLIP)等联合嵌入模型和其他架构(例如Transformer或扩散模型),将嵌入的数值转换为令人惊叹的图像

DALL-E使用对比图像语言预训练(CLIP)和扩散从文本生成图像

DALL-E使用对比图像语言预训练(CLIP)和扩散从文本生成图像

第二种方法是利用现有的图像,并根据个人喜好使用生成模型进行编辑。例如,在一张展示松林的图片中,草地上缺少了蘑菇。用户可以选择一张合适的图像作为起点,并通过生成模型将蘑菇添加进去

生成式人工智能创造了一个全新的范例,模糊了发现和创造力之间的界限。而在单一界面中,用户可以查找图像、编辑图像或创建全新的图像。

原文标题:How generative AI is redefining image search,作者:Ben Dickson

以上是生成式人工智能如何重新定义图像搜索的详细内容。更多信息请关注PHP中文网其他相关文章!

5个免费数据分析课程 - 分析VidhyaApr 19, 2025 am 11:11 AM

5个免费数据分析课程 - 分析VidhyaApr 19, 2025 am 11:11 AM踏上数据驱动的职业旅程而不会破坏银行! 本文重点介绍了五个非凡的免费数据分析课程,非常适合两位经验丰富的专业人士,他们寻求扩大技能和好奇的新手渴望探索T

如何使用OpenAgi构建自主AI代理? - 分析VidhyaApr 19, 2025 am 11:10 AM

如何使用OpenAgi构建自主AI代理? - 分析VidhyaApr 19, 2025 am 11:10 AM利用AI代理商的力量与OpenAgi:综合指南 想象一下不懈的助手,总是可以简化您的任务并提供有见地的建议。这就是AI代理商的承诺,Openagi赋予您建造它们

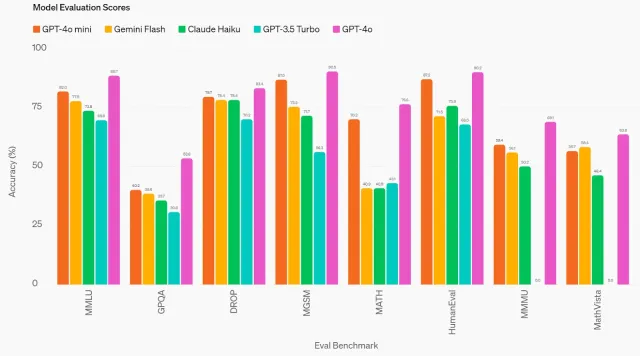

GPT-4O MINI:OpenAI的最新模型如何堆叠?Apr 19, 2025 am 11:09 AM

GPT-4O MINI:OpenAI的最新模型如何堆叠?Apr 19, 2025 am 11:09 AMOpenai的最新产品GPT-4O Mini标志着朝着负担得起且可访问的高级AI迈出的重要一步。 这种小型语言模型(SLM)直接挑战诸如Llama 3和Gemma 2之类的竞争对手,具有低潜伏期,成本效益和A

从技术创新者到医疗保健先驱:Geetha Manjunath博士的AI故事Apr 19, 2025 am 11:02 AM

从技术创新者到医疗保健先驱:Geetha Manjunath博士的AI故事Apr 19, 2025 am 11:02 AMNiramai Analytix的创始人兼首席执行官Geetha Manjunath博士的这一集由“领导数据”的剧集。 Manjunath博士拥有AI和Healthcare的25年以上的经验,并获得了印度科学学院的博士学位和MBA来回。

用Ollama -Analytics Vidhya简化本地LLM部署Apr 19, 2025 am 11:01 AM

用Ollama -Analytics Vidhya简化本地LLM部署Apr 19, 2025 am 11:01 AM利用Ollama本地开源LLMS的力量:综合指南 运行大型语言模型(LLMS)本地提供无与伦比的控制和透明度,但是设置环境可能令人生畏。 Ollama简化了这个过程

如何使用Monsterapi微调大语言模型Apr 19, 2025 am 10:49 AM

如何使用Monsterapi微调大语言模型Apr 19, 2025 am 10:49 AM利用微调LLM的功能与Monsterapi:综合指南 想象一个虚拟助手完美理解并预测您的需求。 由于大型语言模型(LLMS)的进步,这已成为现实。 但是,

5统计测试每个数据科学家都应该知道-Analytics VidhyaApr 19, 2025 am 10:27 AM

5统计测试每个数据科学家都应该知道-Analytics VidhyaApr 19, 2025 am 10:27 AM数据科学的基本统计测试:综合指南 从数据中解锁有价值的见解至关重要。 掌握统计测试对于实现这一目标至关重要。这些测试使数据科学家能够严格瓦尔

如何使用Florence -2 -Analytics Vidhya执行计算机视觉任务Apr 19, 2025 am 10:21 AM

如何使用Florence -2 -Analytics Vidhya执行计算机视觉任务Apr 19, 2025 am 10:21 AM介绍 原始变压器的引入为当前的大语言模型铺平了道路。同样,在引入变压器模型之后,引入了视觉变压器(VIT)。喜欢

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

Dreamweaver Mac版

视觉化网页开发工具

记事本++7.3.1

好用且免费的代码编辑器

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。