自然语言处理(NLP)已经快速提高,特别是随着检索型发电(RAG)管道的出现,该管道有效地解决了复杂,信息密集的查询。通过将基于检索的系统的精度与生成模型的创造力相结合,RAG管道可以增强具有高相关性和背景问题的能力,无论是通过从研究论文中提取部分,总结冗长的文档还是基于广泛的知识库来解决用户查询的能力。但是,抹布管道中的一个主要挑战是管理大型文档,因为整个文本通常超过了诸如GPT-4之类的模型的令牌限制,因此必须有效的分解技术。

这需要文档构成技术,该技术将文本分解为较小,更易于管理的零件,同时保留上下文和相关性,从而确保可以检索到最有意义的信息以提高响应准确性。无论是通过固定尺寸,语义含义还是句子边界,碎布管道的有效性都会受到块状策略的重大影响。在此博客中,我们将探索各种块技术,为每个块提供代码片段,并讨论这些方法如何有助于构建强大而有效的RAG管道。准备发现分块如何增强您的抹布管道?让我们开始吧!

学习目标

- 清楚地了解什么是块状及其在自然语言处理(NLP)和检索功能生成(RAG)系统中的意义。

- 熟悉各种构造策略,包括其定义,优势,缺点和理想的实施用例。

- 了解实践实施:通过查看每个分块策略的代码示例获取实践知识,并演示如何在现实世界中实施它们。

- 发展能够评估不同块方法之间权衡的能力,以及这些选择如何影响检索速度,准确性和整体系统性能。

- 为自己配备技能,以有效地将分块策略整合到抹布管道中,从而提高文件检索和响应的质量。

本文作为数据科学博客马拉松的一部分发表。

目录

- 什么是块,为什么重要?

- 抹布管道的分块策略

- 针对不同方案进行优化

- 不同策略的用例

- 结论

- 常见问题

什么是块,为什么重要?

在检索型发电(RAG)管道的背景下,分块是指将大型文档分解为较小,易于管理的零件或块的过程,以进行更有效的检索和生成。由于像GPT-4这样的大多数大型语言模型(LLMS)对他们可以立即处理的令牌数量有限制,因此分解可确保将文档分为该部分可以处理该模型,同时保留准确检索所必需的上下文和意义。

如果没有适当的分解,则破布管道可能会错过关键信息或提供不完整的,外观的响应。目的是创建大块,在足够大以保持含义和足够小以适合模型的处理限制之间达到平衡。结构良好的块有助于确保检索系统可以准确识别文档的相关部分,然后生成模型可以使用该部分来生成知情的响应。

要考虑的关键因素

- 块的大小:每个块的大小对于抹布管道的效率至关重要。块可以基于令牌(例如,每块300个令牌)或句子(例如,每块2-5个句子)。对于像GPT-4这样的模型,基于令牌的块通常由于令牌限制而效果很好,但是基于句子的块可能会提供更好的背景。权衡是在计算效率和保留含义之间:较小的块速度更快,但可能会失去上下文,而较大的块保持背景,但风险超过令牌限制。

- 上下文保存:分解对于维持文档的语义完整性至关重要。如果块切断了中间句子或逻辑部分的中间,则检索和生成过程可能会失去宝贵的背景。通过确保每个块包含一个连贯的含义单元,例如完整的段落或完整的思想,诸如基于语义的块或使用滑动窗口之类的技术可以帮助保护跨块的上下文。

- 处理不同的方式:抹布管道通常处理多模式文档,其中可能包括文本,图像和表。每种方式都需要不同的策略。文本可以通过句子或令牌分开,而表和图像应视为单独的块,以确保它们被正确检索和呈现。特定于模式的块确保了包含有价值信息的图像或表格独立保存和检索,但与文本保持一致。

简而言之,块不仅在于将文本分成部分,而且是关于设计保留含义和上下文的正确块,处理多种方式并适合模型的约束。正确的分解策略可以显着提高检索准确性和管道产生的响应质量。

抹布管道的分块策略

有效的块有助于保持环境,提高检索准确性,并确保在抹布管道中的检索和发电阶段之间的平稳相互作用。在下面,我们将介绍不同的分块策略,解释何时使用它们,并探索它们的优势和缺点 - 然后是代码示例。

1。固定尺寸的块

固定尺寸的块将文档分解成一个预定义尺寸的块,通常是通过单词计数,令牌计数或字符计数。

何时使用:

当您需要简单,直接的方法时,文档结构并不重要。处理较小,较不复杂的文档时,它运行良好。

优点:

- 易于实现。

- 一致的块大小。

- 快速计算。

缺点:

- 可能会破坏句子或段落,失去上下文。

- 对于维持含义很重要的文件而言,这并不理想。

def fixed_size_chunk(text,max_words = 100):

单词= text.split()

返回[''.join(单词[i:i max_words])在范围内(0,len(words),

max_words)]

#应用固定尺寸的大块

fixe_chunks = fixed_size_chunk(sample_text)

对于fixe_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:此示例文本的输出和以下代码如下。最终结果将根据用例或所考虑的文件而有所不同。

sample_text =“” 介绍 数据科学是一个跨学科领域,使用科学方法,过程, 算法和系统,以从结构化和 非结构化数据。它从统计学,计算机科学,机器学习, 以及各种数据分析技术以发现模式,做出预测和 得出可行的见解。 数据科学可以在许多行业中应用,包括医疗保健,金融, 营销和教育,它可以帮助组织做出数据驱动决策, 优化流程并了解客户行为。 大数据概述 大数据是指随着不断增长而增长的大量,多样的信息 费率。它包括信息量,速度或速度 是创建和收集的,数据点的多样性或范围是 覆盖。 数据科学方法 数据科学有几种重要方法: 1。回归分析 2。分类 3。聚类 4。神经网络 数据科学的挑战 - 数据质量:数据质量差会导致结论不正确。 - 数据隐私:确保敏感信息的隐私。 - 可伸缩性:有效处理大量数据集。 结论 在许多行业中,数据科学仍然是驱动力,提供见解 这可以导致更好的决策和优化的结果。它仍然在不断发展 结合最新技术进步的领域。 ”“”

2。基于句子的块

此方法根据自然句子边界构成文本。每个块都包含一定数量的句子,并保留语义单元。

何时使用:

保持连贯的想法至关重要,而中间句子的分裂将导致失去意义。

优点:

- 保留句子级别的含义。

- 更好的上下文保存。

缺点:

- 零件尺寸不均匀,句子的长度各不相同。

- 当句子太长时,模型的令牌限制可能会超过令牌限制。

进出口

nlp = spacy.load(“ en_core_web_sm”)

def stone_chunk(文本):

doc = nlp(文本)

返回[已发送的doc.sent.text]

#应用基于句子的块

句子_chunks =句子_chunk(sample_text)

对于句子_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:

3。基于段落的块

该策略根据段落边界将文本分配,将每个段落视为一部分。

何时使用:

最适合结构化文档,例如报告或文章,其中每个段落包含一个完整的想法或论点。

优点:

- 自然文档细分。

- 在段落中保留更大的上下文。

缺点:

- 段落的长度各不相同,导致块不平衡的大小。

- 长段落可能仍然超过令牌限制。

def段_chunk(文本):

段落= text.split('\ n \ n')

返回段落

#应用基于段落的大块

段落= chunks =段

段落中的块:chunks:

打印(块,'\ n --- \ n')

代码输出:

4。基于语义的块

该方法使用机器学习模型(例如变形金刚)根据语义含义将文本分成块。

何时使用:

保留最高级别的上下文是至关重要的,例如复杂的技术文档。

优点:

- 上下文有意义的块。

- 捕获句子之间的语义关系。

缺点:

- 需要高级NLP模型,这些模型在计算上昂贵。

- 实施更复杂。

Def Semantic_chunk(text,max_len = 200):

doc = nlp(文本)

块= []

current_chunk = []

用于在文档中发送的信息:

current_chunk.append(send.text)

如果len(''.join(current_chunk))> max_len:

chunks.append(''.join(current_chunk))

current_chunk = []

如果Current_chunk:

chunks.append(''.join(current_chunk))

返回块

#应用基于语义的块

semantic_chunks = semantic_chunk(sample_text)

对于smantic_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:

5。特定于模式的块

该策略分别处理不同的内容类型(文本,图像,表格)。每种方式都根据其特征独立地分块。

何时使用:

对于包含多种内容类型的文档,例如PDF或具有混合媒体的技术手册。

优点:

- 针对混合媒体文件量身定制。

- 允许自定义处理不同方式。

缺点:

- 复杂的实施和管理。

- 每种方式都需要不同的处理逻辑。

def modality_chunk(文本,图像=无,表=无):

#此功能假设您已预处理文本,图像和表格

text_chunks =段落_chunk(text)

返回{'text_chunks':text_chunks,'images':图像,'表':表}

#应用特定方式特定的块

modality_chunks = modality_chunk(sample_text,images = ['img1.png'],表= ['table1'])

打印(modality_chunks)

代码输出:示例文本仅包含文本模式,因此只能获得一个块,如下所示。

6。滑动窗口块

滑动窗口块会产生重叠的块,从而使每个块可以与下一个内容共享其部分内容。

何时使用:

当您需要确保块之间的背景连续性(例如法律或学术文件中)。

优点:

- 保存跨块的环境。

- 减少块边界处的信息损失。

缺点:

- 可以通过在多个块中重复内容来引入冗余。

- 需要更多的处理。

def sliding_window_chunk(text,chunk_size = 100,重叠= 20):

tokens = text.split()

块= []

对于我的范围(0,len(tokens),chunk_size-重叠):

块=''.join(tokens [i:i chunk_size])

Chunks.append(块)

返回块

#应用滑动窗口块

sliding_chunks = sliding_window_chunk(sample_text)

对于sliding_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:图像输出不会捕获重叠;还提供了手动文本输出供参考。注意文本重叠。

---应用sliding_window_chunk --- 块1: 简介数据科学是一个使用科学的跨学科领域 提取知识和见解的方法,过程,算法和系统 来自结构化和非结构化数据。它从统计学,计算机中获取 科学,机器学习和各种数据分析技术 模式,做出预测并得出可行的见解。数据科学可以 在许多行业中应用,包括医疗保健,金融,市场营销, 和教育,它可以帮助组织做出数据驱动的决策,优化 流程并了解客户行为。大数据的概述大数据参考 以不断增长的速度增长的大量,多样化的信息集。 它涵盖了信息量,速度 ----------------------------------------------------------------------------- 块2: 是指以不断增长的速度增长的大量,多样化的信息。 它包括信息量,速度或速度 创建和收集,以及涵盖的数据点的多样性或范围。 数据科学方法数据科学中使用了几种重要方法: 1。回归分析2。分类3。聚类4。神经网络 数据科学的挑战 - 数据质量:数据质量差可以导致 不正确的结论。 - 数据隐私:确保敏感的隐私 信息。 - 可伸缩性:有效处理大量数据集。结论 数据科学继续是驾驶 ----------------------------------------------------------------------------- 块3: 确保敏感信息的隐私。 - 可伸缩性:处理大量 数据集有效。结论数据科学仍然是一个驱动力 在许多行业中,提供可以带来更好决策和的见解 优化的结果。它仍然是一个不断发展的领域,结合了最新的 技术进步。 -----------------------------------------------------------------------------

7。分层块

层次结构分解以多个层次(例如各节,小节和段落)分解文档。

何时使用:

对于高度结构化的文件,例如学术论文或法律文本,维持层次结构至关重要。

优点:

- 保留文档结构。

- 将上下文保持在多个粒度的层次。

缺点:

- 实施更复杂。

- 可能导致不平衡的部分。

def errarchical_chunk(text,section_keywords):

部分= []

current_section = []

对于文本中的行。Splitlines():

如果有任何(pecord_keyword中的关键字中的关键字):

如果Current_section:

section.append(“ \ n” .join(current_section))

current_section = [line]

别的:

current_section.append(line)

如果Current_section:

section.append(“ \ n” .join(current_section))

返回部分

#应用层次结构

section_keywords = [“简介”,“概述”,“方法”,“结论”]

errarchical_chunks = errarchical_chunk(sample_text,section_keywords)

对于erarchical_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:

8。内容吸引的大块

此方法根据内容特征调整了分块(例如,在段落级别将文本块,表作为单独的实体)。

何时使用:

对于具有异质内容的文档,例如电子书或技术手册,必须根据内容类型来不同。

优点:

- 灵活并适应不同的内容类型。

- 维护多种格式的文档完整性。

缺点:

- 需要复杂的动态块逻辑。

- 对于具有不同内容结构的文档很难实施。

def content_aware_chunk(文本):

块= []

current_chunk = []

对于文本中的行。Splitlines():

如果line.startswith((('##','###','rutiest','结论')):

如果Current_chunk:

chunks.append('\ n'.join(current_chunk))

current_chunk = [line]

别的:

current_chunk.append(line)

如果Current_chunk:

chunks.append('\ n'.join(current_chunk))

返回块

#应用内容吸引的大块

content_chunks = content_aware_chunk(sample_text)

对于content_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:

9。桌面块

该策略通过将其提取为独立块并将其转换为Markdown或JSON等格式来处理文档表,以更轻松地处理

何时使用:

对于包含表格数据的文档,例如财务报告或技术文档,该表包含重要信息。

优点:

- 保留表结构以进行有效的下游处理。

- 允许独立处理表格数据。

缺点:

- 在转换过程中,格式可能会丢失。

- 需要特殊处理具有复杂结构的桌子。

导入大熊猫作为pd

def table_aware_chunk(表):

return table.to_markDown()

#样本表数据

表= pd.dataframe({

“名称”:[“约翰”,“爱丽丝”,“鲍勃”],

“年龄”:[25,30,22],

“职业”:[“工程师”,“医生”,“艺术家”]

}))

#应用桌面块

table_markDown = table_aware_chunk(表)

打印(table_markdown)

代码输出:在此示例中,考虑了一个表;请注意,仅在代码输出中将表块块。

10。基于代币的块

基于令牌的分块基于固定数量的令牌而不是单词或句子的拆分文本。它使用了NLP模型(例如,拥抱Face的变形金刚)的引物。

何时使用:

对于在令牌上运行的模型,例如具有令牌限制的基于变压器的模型(例如,GPT-3或GPT-4)。

优点:

- 与基于变压器的模型搭配得很好。

- 确保尊重令牌限制。

缺点:

- 令牌化可能会拆分句子或断开上下文。

- 并非总是与自然语言边界保持一致。

从变形金刚导入GPT2Tokenizer

tokenizer = gpt2tokenizer.from_pretaining(“ gpt2”)

def token_based_chunk(text,max_tokens = 200):

tokens = tokenizer(text)[“ input_ids”]

chunks = [tokens [i:i max_tokens]在范围内(0,len(tokens),max_tokens)]

返回[tokenizer.decode(块),用于块中的块]

#应用基于令牌的大块

token_chunks = token_based_chunk(sample_text)

对于token_chunks中的块:

打印(块,'\ n --- \ n')

代码输出

11。基于实体的块

基于实体的块状杠杆称为实体识别(NER),以基于公认的实体(例如人,组织或位置)将文本分解成块。

何时使用:

对于特定实体很重要的文档,即将作为上下文单位(例如简历,合同或法律文件)保持。

优点:

- 保持命名实体完好无损。

- 可以通过专注于相关实体来提高检索准确性。

缺点:

- 需要训练有素的NER模型。

- 实体可能会重叠,导致复杂的块边界。

DEF ENTITY_BASED_CHUNK(文本):

doc = nlp(文本)

实体= [doc.ent in doc.ents中的ent.text]

返回实体

#应用基于实体的块

entity_chunks = entity_based_chunk(sample_text)

打印(Entity_chunks)

代码输出:为此,培训输入的特定NER模型是理想的方法。键输出是参考和代码样本。

12。基于主题的块

该策略使用潜在的Dirichlet分配(LDA)或其他主题建模算法等技术将文档分配为文本,以分割文本。

何时使用:

有关涵盖多个主题的文档,例如新闻文章,研究论文或具有不同主题的报告。

优点:

- 将相关信息组合在一起。

- 帮助基于特定主题的重点检索。

缺点:

- 需要其他处理(主题建模)。

- 对于简短文档或重叠主题可能并不精确。

来自sklearn.feature_extraction.text Import countvectorizer

来自Sklearn.Decostosion Itmot intentdirichletallatocation

导入numpy作为NP

def topic_based_chunk(text,num_topics = 3):

#将文字分成零件的句子

句子= text.split('。')

#向量化句子

vectorizer = countvectorizer()

ston_vectors = vectorizer.fit_transform(句子)

#将LDA应用于主题建模

lda = litentdirichletallallocation(n_components = num_topics,Random_State = 42)

lda.fit(stone_vectors)

#获取主题字的发行

topic_word = lda.components_

vocabulary = vectorizer.get_feature_names_out()

#确定每个主题的顶级单词

主题= []

对于topic_idx,枚举中的主题(topic_word):

top_words_idx = topic.argsort()[: - 6:-1]

topic_keywords = [vocabulary [i] for top_words_idx]

TOPICS.APPEND(“ topor {}:{}”。格式(topic_idx 1,',',',join(topic_keywords))))))

#生成带有主题的大块

chunks_with_topics = []

对于我,列举(句子)中的句子:

topic_assignments = lda.transform(vectorizer.transform([[句子])))

分配_topic = np.argmax(topic_assignments)

chunks_with_topics.append((topics [aissited_topic],句子))

返回chunks_with_topics

#获取基于主题的块

topic_chunks = topic_based_chunk(sample_text,num_topics = 3)

#显示结果

对于主题,topic_chunks中的块:

print(f“ {topic}:{chunk} \ n”)

代码输出:

13。基于页面的块

这种方法根据页面边界分配文档,该文档通常用于PDF或格式的文档,其中每个页面都被视为块。

何时使用:

对于面向页面的文档,例如PDF或打印的报告,页面边界具有语义重要性。

优点:

- 易于使用PDF文档实现。

- 尊重页面边界。

缺点:

- 页面可能与自然文本中断不符。

- 页面之间可能会丢失上下文。

DEF PAGE_BASED_CHUNK(页):

#基于预处理的页面列表(模拟PDF页面文本)拆分)

返回页面

#样本页

页面= [“第1页内容”,“第2页内容”,“第3页内容”]

#应用基于页面的块

page_chunks = page_based_chunk(页)

page_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:示例文本基于页码缺乏隔离,因此代码输出不超出此片段的范围。读者可以使用代码段,并在其文档上尝试以获取基于页面的块输出。

14。基于关键字的块

此方法基于预定义的关键字或短语,这些文档发出了信号主题转移的文档(例如,“简介”,“结论”)。

何时使用:

最适合遵循清晰结构的文档,例如科学论文或技术规格。

优点:

- 根据关键字捕获自然主题中断。

- 适用于结构化文档。

缺点:

- 需要一组预定义的关键字。

- 不适合非结构化文本。

def keyword_based_chunk(文本,关键字):

块= []

current_chunk = []

对于文本中的行。Splitlines():

如果有任何(关键字中的关键字为关键字):

如果Current_chunk:

chunks.append('\ n'.join(current_chunk))

current_chunk = [line]

别的:

current_chunk.append(line)

如果Current_chunk:

chunks.append('\ n'.join(current_chunk))

返回块

#应用基于关键字的块

关键字= [“简介”,“概述”,“结论”,“方法”,“挑战”]

keyword_chunks = keyword_based_chunk(sample_text,关键字)

对于关键字_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:

15。混合块

混合块结合了基于内容类型和文档结构的多个块策略。例如,文本可以通过句子块,而表和图像则分别处理。

何时使用:

对于包含各种内容类型的复杂文档,例如技术报告,业务文件或产品手册。

优点:

- 高度适应多种文档结构。

- 允许对不同内容类型进行颗粒状控制。

缺点:

- 实施更复杂。

- 需要自定义逻辑来处理每种内容类型。

DEF HYBRID_CHUNK(文本):

段落=段落_chunk(文本)

hybrid_chunks = []

段落中的段落:

hybrid_chunks = stone_chunk(段落)

返回hybrid_chunks

#应用混合块

hybrid_chunks = hybrid_chunk(sample_text)

对于Hybrid_chunks中的块:

打印(块,'\ n --- \ n')

代码输出:

奖励:整个笔记本都可以供读者使用代码并轻松地可视化Chucking输出(笔记本链接)。随时浏览并尝试这些策略来构建下一个破布应用程序。

接下来,我们将研究一些块的交通,并尝试在用例方案上了解一些想法。

针对不同方案进行优化

在构建检索型发电(RAG)管道时,针对特定用例和文档类型进行优化块至关重要。不同的方案根据文档大小,内容多样性和检索速度具有不同的要求。让我们根据这些因素探讨一些优化策略。

大规模文档的大块

学术论文,法律文本或政府报告等大型文件通常遍布数百页,并包含各种类型的内容(例如,文本,图像,表格,表格,脚注)。此类文档的分块策略应在捕获相关环境和使块尺寸保持易于管理方面的尺寸之间取得平衡。

主要注意事项:

- 语义凝聚力:使用诸如基于句子的,基于段落或层次结构的策略来保护各个部分的上下文并保持语义连贯性。

- 特定于模式的处理:对于具有表,图形或图像的法律文档,特定于方式和表面感知的块策略可确保丢失重要的非文本信息。

- 上下文保存:对于条款之间的上下文至关重要的法律文件,滑动窗口块可以确保连续性并防止破坏重要的部分。

大规模文件的最佳策略:

- 层次结构:将文档分为各节,小节和段落,以维护文档结构不同级别的上下文。

- 滑动窗口块:确保块之间不会丢失文本的关键部分,从而保持重叠部分之间的上下文流体。

示例用例:

- 法律文件检索:为法律研究构建的抹布系统可能优先考虑滑动窗口或层次结构块,以确保条款和法律先例准确,凝聚力。

块大小,检索速度和准确性之间的权衡

块的大小直接影响检索速度和结果的准确性。较大的块倾向于保留更多的环境,提高检索的准确性,但是由于需要更多的内存和计算,它们可以减慢系统的速度。相反,较小的块可以更快地检索,但有失去重要上下文信息的风险。

关键权衡:

- 较大的块(例如500-1000个令牌):保留更多上下文,从而导致RAG管道中更准确的响应,尤其是对于复杂的问题。但是,它们可能会减慢检索过程,并在推理过程中消耗更多的内存。

- 较小的块(例如100-300令牌):更快的检索速度和较少的内存使用情况,但由于关键信息可能会在块之间分配,因此准确性可能会降低。

优化策略:

- 滑动窗口块:将较小块的优势与上下文保存相结合,确保重叠内容可以提高准确性而不会失去太大的速度。

- 基于令牌的分解:在使用具有令牌限制的变压器模型时,尤其重要。确保块适合模型约束,同时保持效率。

示例用例:

- 快速常见问题解答系统:在常见问题系统等应用程序中,小块(基于令牌或句子的基于句子)的工作状况最好,因为问题通常很短,并且速度优先于深层语义理解。在这种情况下,可以接受降低准确性的权衡,因为检索速度是主要问题。

不同策略的用例

每种分块策略都适合不同类型的文档和检索场景,因此了解何时使用特定方法可以大大改善RAG管道中的性能。

小文件或常见问题

对于较小的文档,例如常见问题解答或客户支持页面,检索速度至关重要,并且并非总是必须保持完美的上下文。诸如基于句子的块或基于关键字的块之类的策略可以很好地工作。

- 策略:基于句子的块

- 用例: FAQ检索,快速,简短的答案是规范和上下文不会在长时间段落中扩展。

长格式文件

对于诸如研究论文或法律文件之类的长期文档,上下文更重要,并因语义或等级界限而崩溃变得很重要。

- 策略:基于分层或基于语义的块

- 用例:法律文件检索,确保准确检索条款或引用至关重要。

混合文档

在具有混合内容类型的文档(例如图像,表格和文本)(例如科学报告)中,特定于模态的分解对于确保单独处理每种类型的内容以获得最佳结果至关重要。

- 策略:特定于方式或表达的块

- 用例:表和数字在文档的信息中起重要作用的科学报告。

多主题文档

涵盖多个主题或部分(例如电子书或新闻文章)的文档受益于基于主题的块策略。这样可以确保每个块都集中在一个连贯的主题上,这对于需要检索特定主题的用例是理想的选择。

- 策略:基于主题的块

- 用例:新闻检索或多主题研究论文,其中每个块围绕着一个集中的主题,以进行精确和特定于主题的检索。

结论

在此博客中,我们已经深入研究了在检索演示生成(RAG)管道中块的关键作用。分块是一个基础过程,将大型文档转换为较小,易于管理的零件,使模型能够有效地检索和生成相关信息。每种分块策略都呈现出自己的优势和缺点,因此必须根据特定用例选择适当的方法。通过了解不同的策略如何影响检索过程,您可以优化抹布系统的性能。

选择正确的分块策略取决于几个因素,包括文档类型,上下文保存的需求以及检索速度和准确性之间的平衡。无论您是使用学术论文,法律文件还是混合文件文件,选择适当的方法都可以显着提高您的抹布管道的有效性。通过迭代和完善您的块方法,您可以适应不断变化的文档类型和用户需求,以确保您的检索系统保持稳健和高效。

关键要点

- 适当的分解对于提高抹布系统的检索准确性和模型效率至关重要。

- 根据文档类型和复杂性选择块策略,以确保有效处理。

- 选择方法时,请考虑块大小,检索速度和准确性之间的权衡。

- 将策略调整为特定应用程序,例如常见问题解答,学术论文或混合文档。

- 定期评估和完善分块策略,以满足不断发展的文件需求和用户期望。

常见问题

Q 1。NLP中有什么块技术?答:NLP中的分解技术涉及将大型文本分解为较小的,易于管理的部分,以提高处理效率,同时保持上下文和相关性。

问2。如何为文档选择正确的块策略?答:分块策略的选择取决于几个因素,包括文档的类型,结构和特定用例。例如,固定尺寸的块可能适用于较小的文档,而基于语义的块对需要上下文保存的复杂文本更好。 Evaluating the pros and cons of each strategy will help determine the best approach for your specific needs.

Q 3. Can chunking strategies affect the performance of a RAG pipeline?A. Yes, the choice of chunking strategy can significantly impact the performance of a RAG pipeline. Strategies that preserve context and semantics, such as semantic-based or sentence-based chunking, can lead to more accurate retrieval and generation results. Conversely, methods that break context (eg, fixed-size chunking) may reduce the quality of the generated responses, as relevant information may be lost between chunks.

Q4。 How do chunking techniques improve RAG pipelines?A. Chunking techniques improve RAG pipelines by ensuring that only meaningful information is retrieved, leading to more accurate and contextually relevant responses.

Q. What is Chunking in RAG?A. Retrieval-Augmented Generation (RAG) pipelines, chunking is the process of breaking down large documents into smaller, manageable pieces (chunks). This is necessary because large language models (LLMs) have token limits. Chunking ensures the model can handle the text while preserving context and meaning for accurate retrieval and response generation.

The media shown in this article is not owned by Analytics Vidhya and is used at the Author's discretion.

以上是15个构建杰出破布系统的块技术的详细内容。更多信息请关注PHP中文网其他相关文章!

5个免费数据分析课程 - 分析VidhyaApr 19, 2025 am 11:11 AM

5个免费数据分析课程 - 分析VidhyaApr 19, 2025 am 11:11 AM踏上数据驱动的职业旅程而不会破坏银行! 本文重点介绍了五个非凡的免费数据分析课程,非常适合两位经验丰富的专业人士,他们寻求扩大技能和好奇的新手渴望探索T

如何使用OpenAgi构建自主AI代理? - 分析VidhyaApr 19, 2025 am 11:10 AM

如何使用OpenAgi构建自主AI代理? - 分析VidhyaApr 19, 2025 am 11:10 AM利用AI代理商的力量与OpenAgi:综合指南 想象一下不懈的助手,总是可以简化您的任务并提供有见地的建议。这就是AI代理商的承诺,Openagi赋予您建造它们

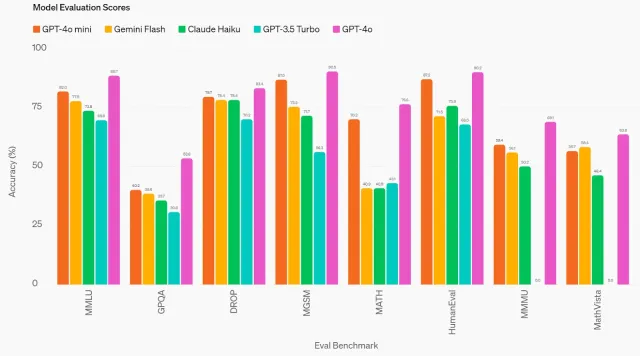

GPT-4O MINI:OpenAI的最新模型如何堆叠?Apr 19, 2025 am 11:09 AM

GPT-4O MINI:OpenAI的最新模型如何堆叠?Apr 19, 2025 am 11:09 AMOpenai的最新产品GPT-4O Mini标志着朝着负担得起且可访问的高级AI迈出的重要一步。 这种小型语言模型(SLM)直接挑战诸如Llama 3和Gemma 2之类的竞争对手,具有低潜伏期,成本效益和A

从技术创新者到医疗保健先驱:Geetha Manjunath博士的AI故事Apr 19, 2025 am 11:02 AM

从技术创新者到医疗保健先驱:Geetha Manjunath博士的AI故事Apr 19, 2025 am 11:02 AMNiramai Analytix的创始人兼首席执行官Geetha Manjunath博士的这一集由“领导数据”的剧集。 Manjunath博士拥有AI和Healthcare的25年以上的经验,并获得了印度科学学院的博士学位和MBA来回。

用Ollama -Analytics Vidhya简化本地LLM部署Apr 19, 2025 am 11:01 AM

用Ollama -Analytics Vidhya简化本地LLM部署Apr 19, 2025 am 11:01 AM利用Ollama本地开源LLMS的力量:综合指南 运行大型语言模型(LLMS)本地提供无与伦比的控制和透明度,但是设置环境可能令人生畏。 Ollama简化了这个过程

如何使用Monsterapi微调大语言模型Apr 19, 2025 am 10:49 AM

如何使用Monsterapi微调大语言模型Apr 19, 2025 am 10:49 AM利用微调LLM的功能与Monsterapi:综合指南 想象一个虚拟助手完美理解并预测您的需求。 由于大型语言模型(LLMS)的进步,这已成为现实。 但是,

5统计测试每个数据科学家都应该知道-Analytics VidhyaApr 19, 2025 am 10:27 AM

5统计测试每个数据科学家都应该知道-Analytics VidhyaApr 19, 2025 am 10:27 AM数据科学的基本统计测试:综合指南 从数据中解锁有价值的见解至关重要。 掌握统计测试对于实现这一目标至关重要。这些测试使数据科学家能够严格瓦尔

如何使用Florence -2 -Analytics Vidhya执行计算机视觉任务Apr 19, 2025 am 10:21 AM

如何使用Florence -2 -Analytics Vidhya执行计算机视觉任务Apr 19, 2025 am 10:21 AM介绍 原始变压器的引入为当前的大语言模型铺平了道路。同样,在引入变压器模型之后,引入了视觉变压器(VIT)。喜欢

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

Dreamweaver Mac版

视觉化网页开发工具

记事本++7.3.1

好用且免费的代码编辑器

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。