大模型的「幻觉」问题马上要有解了?

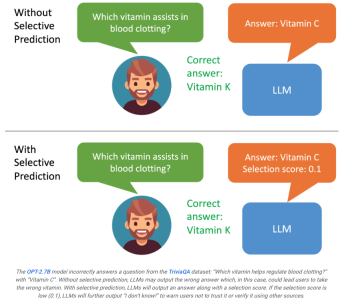

威斯康星麦迪逊大学和谷歌的研究人员最近推出ASPIRE系统,使大模型能够自评输出。

如果用户看到模型的生成的结果评分不高,就能意识到这个回复可能是幻觉。

如果系统能够根据评分结果进一步筛选输出内容,例如当评分较低时,大模型可以生成类似"我无法回答此问题"的语句,这可能最大程度地改善幻觉问题。

论文地址:https://aclanthology.org/2023.findings-emnlp.345.pdf

ASPIRE能让LLM输出答案以及答案的置信度得分。

研究人员的实验结果表明,ASPIRE在各种QA数据集(例如 CoQA 基准)上显著优于传统的选择性预测方法。

让LLM不仅要回答问题,还要评估这些答案 。

在选择性预测的基准测试上,研究人员通过ASPIRE系统取得了超过10倍规模的模型的成绩。

就像让学生在课本后面验证他们自己的答案,虽然听起来有点不靠谱,但是细细一想,每个人在做出一道题目之后,确实会对答案的满意程度会有一个评分。

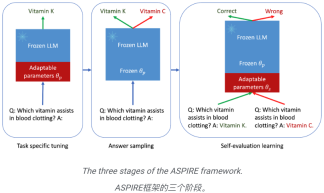

这就是ASPIRE的本质,它涉及三个阶段:

(1) 针对特定任务的调优,

(2) 答案采样,

(3) 自我评估学习。

在研究人员看来,ASPIRE不仅仅是另一个框架,它代表着一个全面提升LLM可靠性,降低幻觉的美好未来。

如果LLM可以成为决策过程中值得信赖的合作伙伴。

只要通过不断优化选择性预测的能力,人类距离充分发挥大模型的潜力就又近了一步。

研究人员希望能凭借ASPIRE,开启下一代LLM的进化,从而能创建更可靠和更具有自我意识的人工智能。

ASPIRE 的机制

针对特定任务的微调

ASPIRE执行特定于任务的微调以训练适应性参数 ,同时冻结LLM。

,同时冻结LLM。

给定生成任务的训练数据集,它会微调预训练的LLM以提高其预测性能。

为此,可以采用参数高效的微调技术(例如,软提示词微调和LoRA)来微调任务上的预训练LLM,因为它们可以有效地通过少量目标获得强泛化任务数据。

具体来说,LLM参数(θ)被冻结,并添加自适应参数 进行微调。

进行微调。

仅更新 θ (p) 以最小化标准 LLM 训练损失(例如交叉熵)。

这种微调可以提高选择性预测性能,因为它不仅提高了预测精度,而且还提高了正确输出序列的可能性。

答案取樣

在針對特定任務進行調優後,ASPIRE使用LLM和學習到的 為每個訓練問題產生不同的答案,並建立用於自評估學習的資料集。

為每個訓練問題產生不同的答案,並建立用於自評估學習的資料集。

研究人員的目標是產生具有高可能性的輸出序列。他們使用波束搜尋(Beam Search)作為解碼演算法來產生高似然輸出序列,並使用Rouge-L度量來確定產生的輸出序列是否正確。

自評估學習

#在對每個查詢的高似然輸出進行取樣後,ASPIRE添加自適應參數 ,並且僅微調

,並且僅微調 來學習自評估。

來學習自評估。

由於輸出序列的產生只取決於θ 和 ,因此凍結θ 和學習到的

,因此凍結θ 和學習到的 可以避免在學習自評估時改變LLM的預測行為-評估。

可以避免在學習自評估時改變LLM的預測行為-評估。

研究者優化了 ,使得改編後的LLM可以自己區分正確和錯誤的答案。

,使得改編後的LLM可以自己區分正確和錯誤的答案。

在這個框架中,可以用任何參數有效的微調方法來訓練 和

和 。

。

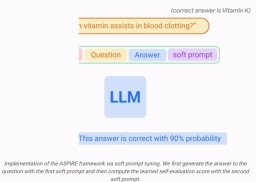

在這項工作中,研究人員使用軟提示微調,這是一種簡單而有效的機制,用於學習「軟提示」來調節凍結的語言模型,從而比傳統的離散文本提示更有效地執行特定的下游任務。

這種方法背後的核心在於認識到,如果能夠發展出有效激發自我評價的提示,那麼應該可以透過結合有針對性的訓練目標的軟提示微調來發現這些提示。

在訓練 #和

#和 後,研究人員透過波束搜尋解碼獲得查詢的預測(beam search decoding)。

後,研究人員透過波束搜尋解碼獲得查詢的預測(beam search decoding)。

然後,研究人員定義一個選擇分數,將產生答案的可能性與學習到的自我評估分數(即,預測對於查詢正確的可能性)結合起來,以做出選擇性預測。

結果

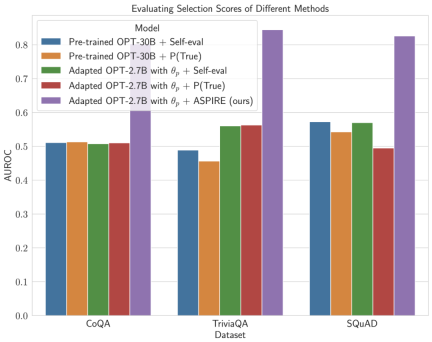

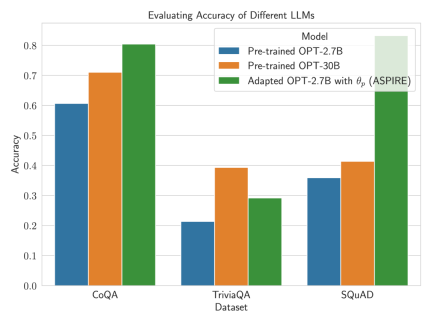

為了證明ASPIRE的效果,研究人員使用各種開放式預訓練Transformer (OPT)模型在三個問答數據集(CoQA、TriviaQA和SQuAD)上進行評估。

通过使用软提示调整训练 研究人员观察到LLM的准确性大幅提高。

研究人员观察到LLM的准确性大幅提高。

例如,与使用CoQA和SQuAD数据集的较大预训练OPT-30B模型相比,采用ASPIRE的OPT-2.7B模型表现出更好的性能。

这些结果表明,通过适当的调整,较小的LLM在某些情况下可能有能力匹配或可能超过较大模型的准确性。

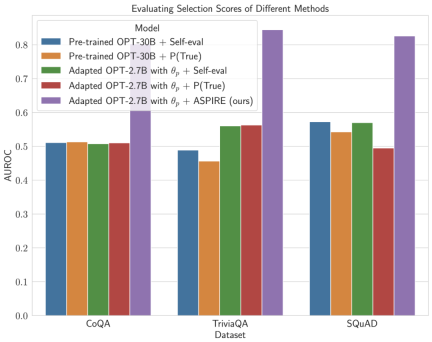

当深入研究固定模型预测的选择分数计算时,ASPIRE获得了比所有数据集的基线方法更高的AUROC分数(随机选择的正确输出序列比随机选择的不正确输出序列具有更高选择分数的概率)。

例如,在CoQA基准上,与基线相比,ASPIRE将AUROC从51.3%提高到80.3%。

TriviaQA数据集评估中出现了一个有趣的模式。

虽然预训练的OPT-30B模型表现出更高的基线精度,但当应用传统的自我评估方法(Self-eval和P(True))时,其选择性预测的性能并没有显著提高。

相比之下,小得多的OPT-2.7B模型在使用ASPIRE进行增强后,在这方面表现优于其他模型。

这种差异体现了一个重要的问题:利用传统自我评估技术的较大LLM在选择性预测方面可能不如较小的ASPIRE增强模型有效。

研究人员与ASPIRE的实验之旅强调了LLM格局的关键转变:语言模型的容量并不是其性能的全部和最终目的。

相反,可以通过策略调整来大幅提高模型的有效性,即使在较小的模型中也可以进行更精确、更自信的预测。

因此,ASPIRE证明了LLM的潜力,它可以明智地确定自己答案的确定性,并在选择性预测任务中显著地超越地超越其他10倍体量的模型。

以上是谷歌新方法ASPIRE:賦予LLM自我評分能力,有效解決「幻覺」問題,超越10倍體積模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

擁抱面部是否7B型號奧林匹克賽車擊敗克勞德3.7?Apr 23, 2025 am 11:49 AM

擁抱面部是否7B型號奧林匹克賽車擊敗克勞德3.7?Apr 23, 2025 am 11:49 AM擁抱Face的OlympicCoder-7B:強大的開源代碼推理模型 開發以代碼為中心的語言模型的競賽正在加劇,擁抱面孔與強大的競爭者一起參加了比賽:OlympicCoder-7B,一種產品

4個新的雙子座功能您可以錯過Apr 23, 2025 am 11:48 AM

4個新的雙子座功能您可以錯過Apr 23, 2025 am 11:48 AM你們當中有多少人希望AI可以做更多的事情,而不僅僅是回答問題?我知道我有,最近,我對它的變化感到驚訝。 AI聊天機器人不僅要聊天,還關心創建,研究

Camunda為經紀人AI編排編寫了新的分數Apr 23, 2025 am 11:46 AM

Camunda為經紀人AI編排編寫了新的分數Apr 23, 2025 am 11:46 AM隨著智能AI開始融入企業軟件平台和應用程序的各個層面(我們必須強調的是,既有強大的核心工具,也有一些不太可靠的模擬工具),我們需要一套新的基礎設施能力來管理這些智能體。 總部位於德國柏林的流程編排公司Camunda認為,它可以幫助智能AI發揮其應有的作用,並與新的數字工作場所中的準確業務目標和規則保持一致。該公司目前提供智能編排功能,旨在幫助組織建模、部署和管理AI智能體。 從實際的軟件工程角度來看,這意味著什麼? 確定性與非確定性流程的融合 該公司表示,關鍵在於允許用戶(通常是數據科學家、軟件

策劃的企業AI體驗是否有價值?Apr 23, 2025 am 11:45 AM

策劃的企業AI體驗是否有價值?Apr 23, 2025 am 11:45 AM參加Google Cloud Next '25,我渴望看到Google如何區分其AI產品。 有關代理空間(此處討論)和客戶體驗套件(此處討論)的最新公告很有希望,強調了商業價值

如何為抹布找到最佳的多語言嵌入模型?Apr 23, 2025 am 11:44 AM

如何為抹布找到最佳的多語言嵌入模型?Apr 23, 2025 am 11:44 AM為您的檢索增強發電(RAG)系統選擇最佳的多語言嵌入模型 在當今的相互聯繫的世界中,建立有效的多語言AI系統至關重要。 強大的多語言嵌入模型對於RE至關重要

麝香:奧斯汀的機器人需要每10,000英里進行干預Apr 23, 2025 am 11:42 AM

麝香:奧斯汀的機器人需要每10,000英里進行干預Apr 23, 2025 am 11:42 AM特斯拉的Austin Robotaxi發射:仔細觀察Musk的主張 埃隆·馬斯克(Elon Musk)最近宣布,特斯拉即將在德克薩斯州奧斯汀推出的Robotaxi發射,最初出於安全原因部署了一支小型10-20輛汽車,並有快速擴張的計劃。 h

AI震驚的樞軸:從工作工具到數字治療師和生活教練Apr 23, 2025 am 11:41 AM

AI震驚的樞軸:從工作工具到數字治療師和生活教練Apr 23, 2025 am 11:41 AM人工智能的應用方式可能出乎意料。最初,我們很多人可能認為它主要用於代勞創意和技術任務,例如編寫代碼和創作內容。 然而,哈佛商業評論最近報導的一項調查表明情況並非如此。大多數用戶尋求人工智能的並非是代勞工作,而是支持、組織,甚至是友誼! 報告稱,人工智能應用案例的首位是治療和陪伴。這表明其全天候可用性以及提供匿名、誠實建議和反饋的能力非常有價值。 另一方面,營銷任務(例如撰寫博客、創建社交媒體帖子或廣告文案)在流行用途列表中的排名要低得多。 這是為什麼呢?讓我們看看研究結果及其對我們人類如何繼續將

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。