ホームページ >テクノロジー周辺機器 >AI >Mamba は時系列的に Transformer と同等の効果を発揮しますか?

Mamba は時系列的に Transformer と同等の効果を発揮しますか?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-04-02 11:31:191629ブラウズ

Mamba は最近最も人気のあるモデルの 1 つであり、業界では Transformer に代わる可能性があると考えられています。今回紹介する記事では、Mamba モデルが時系列予測タスクに有効であるかどうかを検討します。この記事では、まず Mamba の基本原理を紹介し、次にこの記事を組み合わせて、Mamba が時系列予測シナリオで効果的であるかどうかを検討します。 Mamba モデルは、自己回帰アーキテクチャを使用して時系列データの長期的な依存関係をキャプチャする深層学習ベースのモデルです。従来のモデルと比較して、Mamba モデルは時系列予測タスクで優れたパフォーマンスを発揮します。 この論文は、実験と比較分析を通じて、Mamba モデルが時系列予測タスクにおいて良好な結果をもたらすことを発見しました。将来の時系列値を正確に予測し、長期的な依存関係をより適切に捕捉できます。 概要

論文タイトル: Mamba は時系列予測に効果的ですか?

ダウンロード アドレス:https://www.php.cn/link /f06d497659096949ed7c01894ba38694

1. Mamba の基本原理

Mamba は状態空間モデルに基づいた構造ですが、RNN に非常によく似ています。 Transformer と比較すると、Mamba の時間計算量はトレーニング フェーズと推論フェーズの両方で系列長に比例して増加し、計算効率は Transformer の構造に依存します。

Mamba のコアは次の 4 つの部分に分割できます。

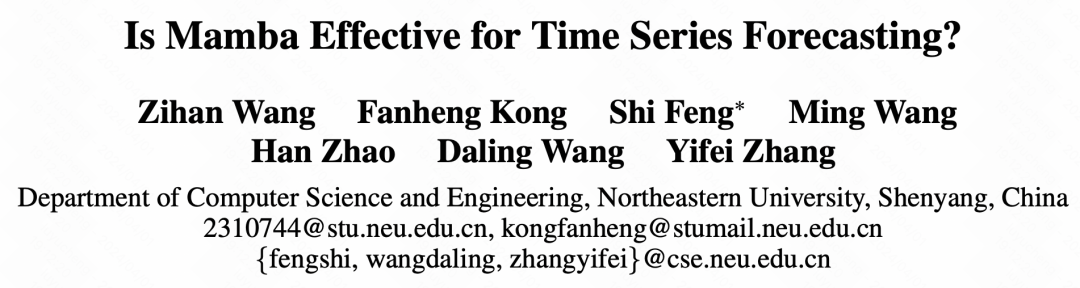

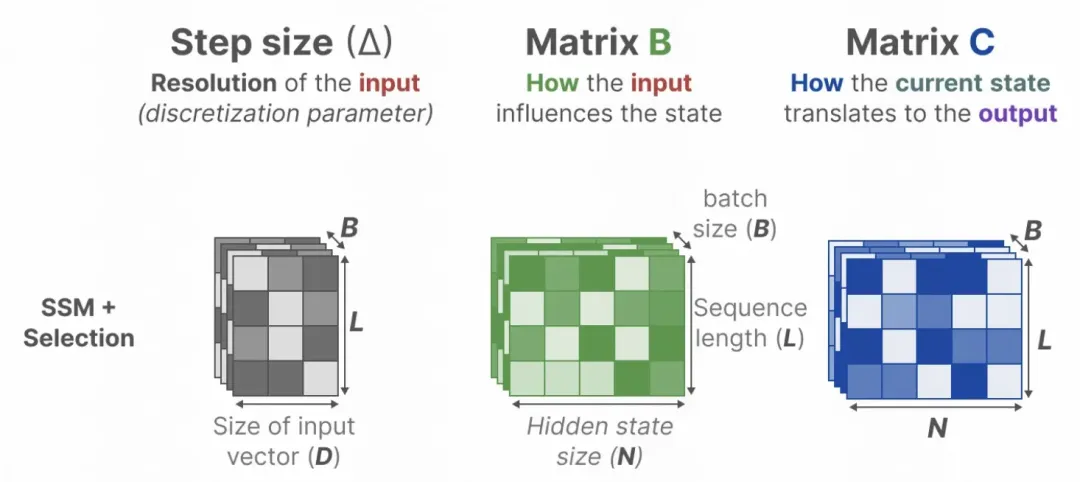

状態空間モデル (SSM) は、状態が現在の状態に及ぼす影響とその影響を記述するために使用される手法です。出力数学モデル上の現在の状態。状態空間モデルでは、前の状態と現在の瞬間の入力が次の状態に影響し、現在の状態が出力に与える影響が想定されます。 SSM は次の形式で表現できます。行列 A、B、C、および D はハイパーパラメータです。 行列 A は、現在の状態に対する前の状態の影響を表します。 行列 B は、現時点での入力が次の状態に影響を与えることを示します。 行列 C は、現在の状態が出力に及ぼす影響を表します。 行列 D は、入力が出力に与える直接的な影響を表します。 現時点での現在の出力と入力を観察することで、次の状態の値を推測できます。現在の観測結果とその時の状態に基づいて決定されます。 SSM は、動的システム モデリング、状態推定、制御アプリケーションなどの分野で使用できます。

画像

画像

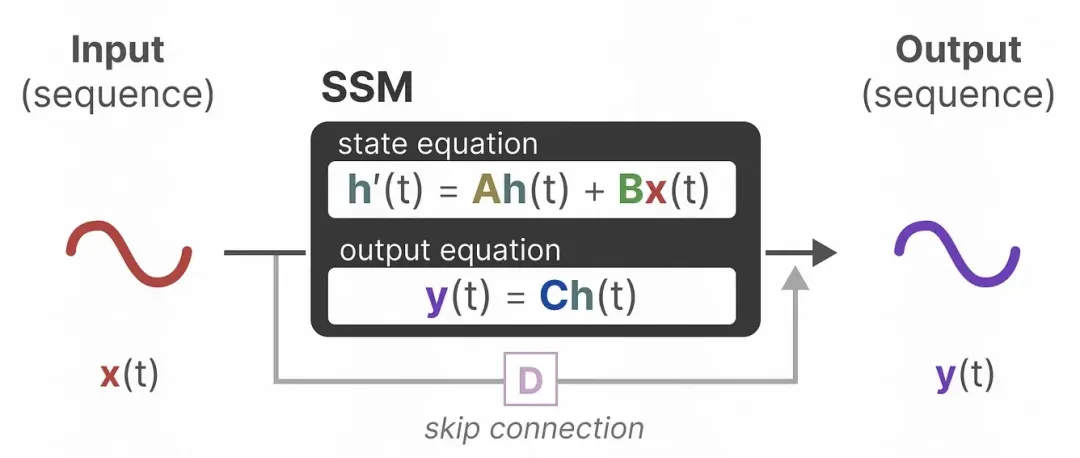

コンボリューション式: コンボリューションを使用して SSM を表現し、トレーニング フェーズでの同時計算を実現します。SSM の計算出力式を時間に応じて変換することで、拡張では、対応するコンボリューション カーネルを特定の形式に設計することで、コンボリューションを使用して、各瞬間の出力を前の 3 つの瞬間の出力の関数として表現できます。

Picture

Picture

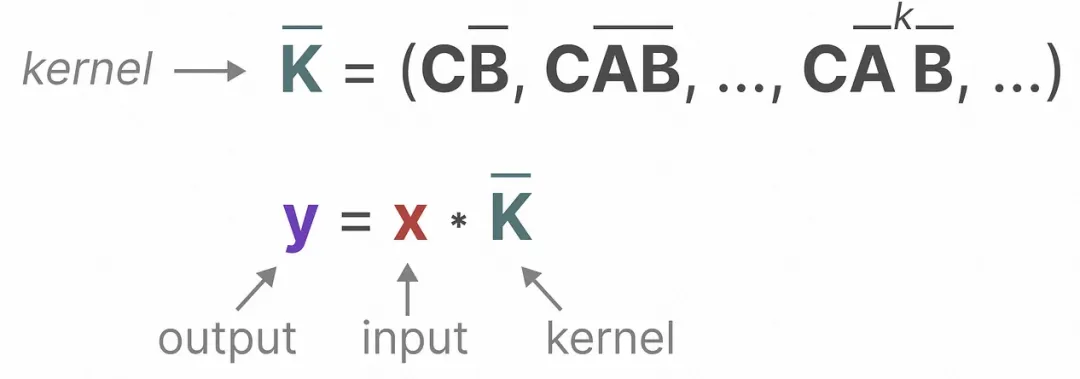

Hippo Matrix: パラメータ A については、履歴情報の減衰融合を実現するために Hippo Matrix が導入されます;

Picture

Picture

選択モジュール:パラメータBとパラメータCのパーソナライズされた履歴情報の選択を実現し、各瞬間のパラメータ行列を入力に関する関数に変換することで、各瞬間のパーソナライズされたパラメータを実現します。

写真

写真

Mamba に関するさらに詳細なモデル分析と、その後の Mamba 関連の作業も Knowledge Planet に更新されています。地球上での深い学び。

2. Mamba 時系列モデル

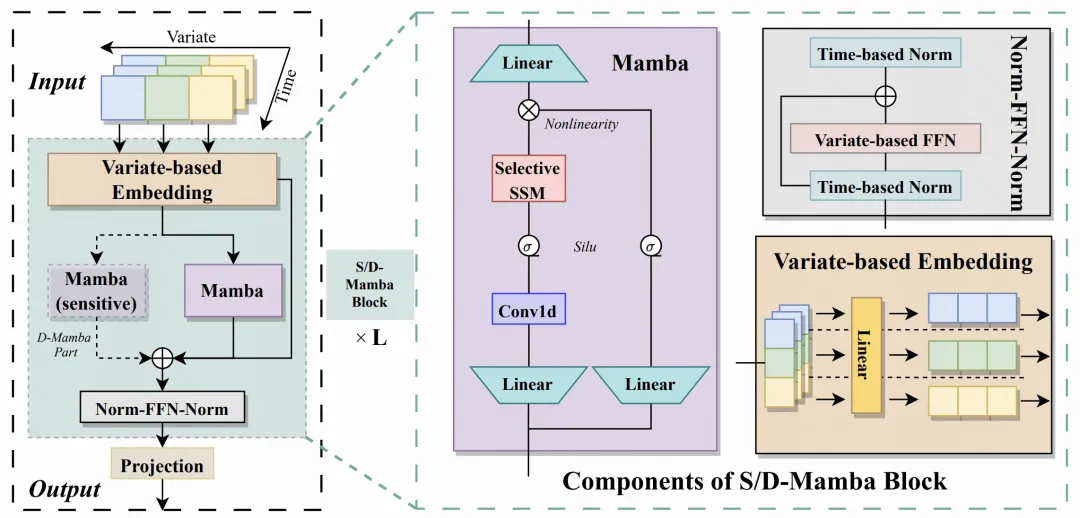

以下では、この記事で提案する Mamba 時系列予測フレームワークを紹介します。これは、時系列データを適応させるための Mamba に基づいています。全体は、Embedding、S/D-Mamba 層、Norm-FFN-Norm Layer の 3 つの部分に分かれています。

Embedding: iTransformer の処理方法と同様に、各変数が個別にマッピングされ、各変数のエンベディングが生成され、各変数のエンベディングが後続の Mamba に入力されます。したがって、この記事は、iTransformer のモデル構造を Mamba 構造に変更する変形とみなすこともできます;

S/D-Mamba レイヤー: Embedding の入力次元は [batch_size, variable_number, dim ]、および Mamba への入力。この記事では、2 つの Mamba レイヤー S と D について説明します。これらは、それぞれ、各レイヤーに 1 つのマンバを使用するか 2 つのマンバを使用するかを示します。2 つのマンバは、2 つの出力を加算して、それぞれの出力結果を取得します。層;

Norm-FFN-Norm 層: 出力層では、正規化層と FFN 層を使用して Mamba の出力表現を正規化およびマッピングし、残差ネットワークと組み合わせて、モデルの収束と安定性を向上させます。

写真

写真

3. 実験結果

次の写真は記事の中核となる実験結果であり、Mamba と iTransformer、PatchTST、その他の主流を比較しています。インダストリ モデル効果の時系列。この論文では、さまざまな予測ウィンドウ、一般化特性などについて実験的な比較も行っています。実験の結果、Mamba はコンピューティング リソースの点で優れているだけでなく、モデル効果の点でも Transformer 関連のモデルに匹敵し、長期的なモデリングにおいても有望であることが示されました。 ############写真############

以上がMamba は時系列的に Transformer と同等の効果を発揮しますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。