ホームページ >テクノロジー周辺機器 >AI >Arthur Bench を使用した LLM 評価を 1 つの記事で理解する

Arthur Bench を使用した LLM 評価を 1 つの記事で理解する

- 王林転載

- 2024-02-04 17:33:02831ブラウズ

皆さんこんにちは、私はルーガです。今日は人工知能 (AI) の生態分野に関連するテクノロジー、つまり LLM 評価について話します。

1. 従来のテキスト評価が直面する課題

近年、大規模言語モデル (LLM) の急速な開発と改善により、従来のテキスト評価が行われるようになりました。一部の側面のメソッドは適用されなくなる可能性があります。テキスト評価の分野では、BLEU などの「単語出現」ベースの評価方法や、BERTScore などの「事前学習済みの自然言語処理モデル」ベースの評価方法などを聞いたことがあるでしょう。これらの方法は、テキストの品質と類似性を評価するためのより正確な指標を提供します。 LLM の急速な発展は、テキスト評価の分野に新たな課題と機会をもたらしており、この発展傾向に適応するために評価手法を継続的に探索し、改善する必要があります。

これらの方法はかつてはうまく機能していましたが、LLM 環境技術の発展に伴い、今日のニーズを完全に満たすほど強力ではなくなってきています。

LLM の急速な開発と改善により、私たちは新たな課題と機会に直面しています。 LLM の機能とパフォーマンス レベルは向上し続けているため、BLEU などの単語出現ベースの評価方法では、LLM で生成されたテキストの品質と意味の正確さを完全に把握できない可能性があります。対照的に、LLM はより流暢で一貫性があり、意味的に豊かなテキストを生成できますが、従来の単語出現ベースの評価方法ではこれらの利点を正確に測定できません。

さらに、BERTScore などの事前トレーニング済みモデルに基づく評価方法は、多くのタスクで良好なパフォーマンスを示していますが、いくつかの課題にも直面しています。事前トレーニングされたモデルは、LLM (言語モデル) の固有の特性と特定のタスクにおけるそのパフォーマンスを完全に考慮していない可能性があります。したがって、事前トレーニングされたモデルに基づく評価方法のみに依存すると、LLM の機能を完全に評価できない可能性があります。これは、特定のタスクにおける LLM のパフォーマンスと能力をより正確に評価して理解するために、新しい評価方法のさらなる研究と開発が必要であることを意味します。これには、ミッション要件によりよく適合するように、タスク固有の微調整と LLM のカスタマイズが含まれる場合があります。同時に、評価方法の多様性を考慮し、手動評価と他の測定指標を組み合わせて、より包括的で正確な評価結果を得る必要もあります。評価方法を継続的に改善および開発することで、LLM の可能性をよりよく理解して活用し、自然言語処理の分野でさらなる進歩を推進することができます。

2. LLM ガイダンス評価はなぜ必要ですか? そして、それによってどのような課題がもたらされますか?

一般に、実際のビジネス シナリオで LLM ガイダンス評価手法を使用する最も価値のあることは、そのスピードと感度です。 。

1. 効率

まず、LLM を使用して評価をガイドすると、通常は実装速度が速くなります。以前の評価パイプラインと比較して、LLM ガイド付き評価の作成には比較的少ない労力で済み、実装も簡単です。 LLM ガイド付き評価の場合、準備する必要があるのは 2 つだけです。評価基準を説明する書面による説明と、プロンプト テンプレートで使用する例です。独自の事前トレーニング済み NLP モデルを構築したり、評価者として機能するように既存の NLP モデルを微調整したりするのと比較して、LLM を使用してこれらのタスクを完了する方が効率的です。 LLM を使用すると、評価基準の反復も高速になります。

2. 感度

第 2 に、LLM は一般に、事前トレーニングされた NLP モデルや前述の評価方法よりも感度が高くなります。この敏感さはいくつかの点でプラスの影響を及ぼし、LLM が特定の状況をより柔軟に処理できるようになります。ただし、この感度により、LLM 評価結果の予測が難しくなる可能性もあります。

前に説明したように、LLM 評価は他の評価方法よりも敏感です。ただし、LLM をエバリュエーターとして構成するにはさまざまな方法があり、その動作は選択した構成に応じて大きく異なる可能性があります。さらに、別の課題は、評価に含まれる推論ステップが多すぎる場合、または同時に処理する変数が多すぎる場合に、LLM 評価者が行き詰まってしまう可能性があることです。したがって、評価を設計および実装するときは、正確で有効な評価結果を確保するために、LLM の構成と評価タスクの複雑さを慎重に考慮する必要があります。

LLM の特性により、さまざまな構成やパラメータ設定によって評価結果が影響を受ける可能性があります。つまり、LLM を評価するときは、期待どおりに動作するようにモデルを慎重に選択し、構成する必要があります。構成が異なると出力結果も異なる場合があるため、評価者は、正確で信頼性の高い評価結果を得るために、ある程度の時間と労力をかけて LLM の設定を調整および最適化する必要があります。

さらに、評価者は、複雑な推論や複数の変数の同時処理を必要とする評価タスクに直面すると、いくつかの課題に直面する可能性があります。これは、複雑な状況を扱う場合、LLM の推論能力が制限される可能性があるためです。 LLM では、評価の正確さと信頼性を確保するために、これらのタスクに対処するために追加の努力が必要になる場合があります。

3. Arthur Bench とは何ですか?

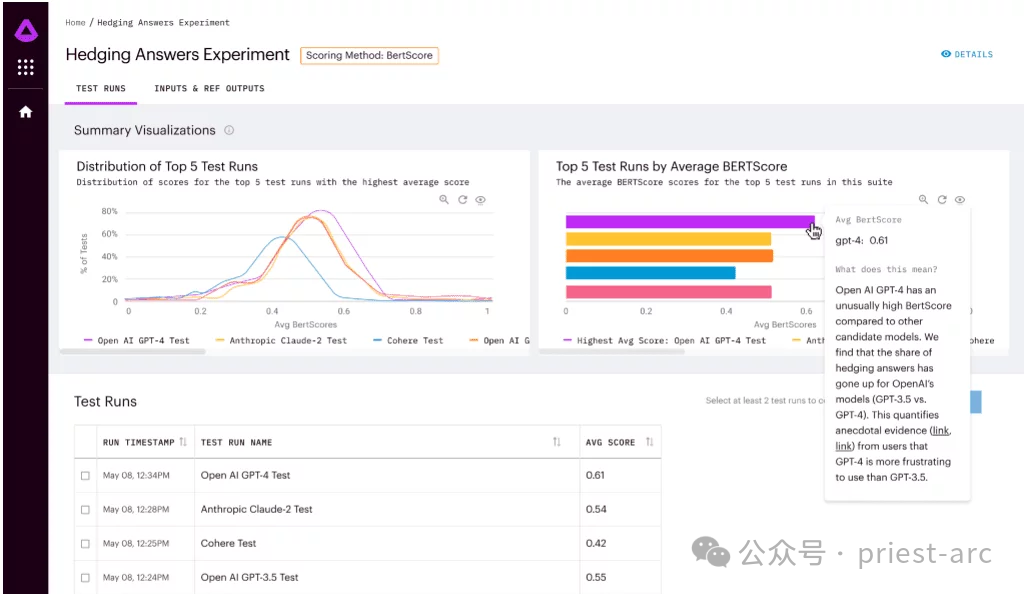

Arthur Bench は、生成テキスト モデル (LLM) のパフォーマンスを比較するために使用されるオープン ソースの評価ツールです。これを使用して、さまざまな LLM モデル、キュー、ハイパーパラメーターを評価し、さまざまなタスクでの LLM パフォーマンスに関する詳細なレポートを提供できます。

Arthur Bench の主な特徴:Arthur Bench の主な特徴:

- 異なる LLM モデルの比較: Arthur Bench を使用すると、異なるベンダーのモデル、異なるバージョンのモデル、異なるトレーニング データ セットを使用したモデルなど、異なる LLM モデルのパフォーマンスを比較できます。

- ヒントの評価: Arthur Bench を使用して、LLM パフォーマンスに対するさまざまなヒントの影響を評価できます。プロンプトは、LLM によるテキストの生成をガイドするために使用される指示です。

- ハイパーパラメータのテスト: Arthur Bench を使用して、LLM パフォーマンスに対するさまざまなハイパーパラメータの影響をテストできます。ハイパーパラメータは、LLM の動作を制御する設定です。

一般的に、Arthur Bench ワークフローには主に次の段階が含まれており、詳細な分析は次のとおりです:

1. タスク定義

この段階では、評価の目標を明確にする必要があります。Arthur Bench は、以下を含むさまざまな評価タスクをサポートします。

- Q&A: 自由形式の、難しい、または曖昧な質問について LLM をテストします。理解して答える能力。

- 要約: テキストから重要な情報を抽出し、簡潔な要約を生成する LLM の能力を評価します。

- 翻訳: 異なる言語間で正確かつ流暢に翻訳する LLM の能力を調べます。

- コード生成: 自然言語記述に基づいてコードを生成する LLM の機能をテストします。

2. モデルの選択

この段階では、主に評価対象の選択を行います。 Arthur Bench は、GPT-3、LaMDA、Megatron-Turing NLG など、OpenAI、Google AI、Microsoft などの有名な機関の最先端テクノロジーをカバーする、さまざまな LLM モデルをサポートしています。研究のニーズに基づいて、評価用の特定のモデルを選択できます。

3.パラメータ設定

機種選定が完了したら、微調整に進みます。 LLM パフォーマンスをより正確に評価するために、Arthur Bench ではユーザーがヒントとハイパーパラメーターを構成できるようにしています。

- ヒント: 生成されるテキスト (質問、説明、指示など) の方向と内容について LLM をガイドします。

- ハイパーパラメータ: LLM の動作を制御する主要な設定 (学習率、トレーニング ステップ数、モデル アーキテクチャなど)。

洗練された構成により、さまざまなパラメータ設定の下での LLM のパフォーマンスの違いを深く調査し、より参考値のある評価結果を得ることができます。

4. 評価の実行: 自動プロセス

最後のステップは、自動プロセスを利用してタスク評価を実行することです。通常、Arthur Bench は、評価タスクを実行するための簡単な構成を必要とする自動評価プロセスを提供します。次の手順が自動的に実行されます。

- LLM モデルを呼び出し、テキスト出力を生成します。

- 特定のタスクについては、対応する評価指標を適用して分析します。

- 詳細なレポートを作成し、評価結果を提示します。

4. Arthur Bench の使用シナリオ分析

高速なデータ駆動型 LLM 評価の鍵として、Arthur Bench は主に、特に次のようなソリューションを提供します:

1. モデルの選択と検証

モデルの選択と検証は、人工知能の分野において重要なステップであり、モデルの有効性と信頼性を確保するために非常に重要です。このプロセスにおいて、アーサー・ベンチの役割は極めて重要でした。彼の目標は、一貫した指標と評価方法を使用して、多くの大規模言語モデル (LLM) オプションの中から情報に基づいた意思決定を行えるよう、信頼できる比較フレームワークを企業に提供することです。

Arthur Bench は専門知識と経験を活用して各 LLM オプションを評価し、一貫した指標を使用して長所と短所を比較します。同氏は、企業が情報に基づいた明確な選択を行えるように、モデルのパフォーマンス、精度、速度、リソース要件などの要素を考慮します。

Arthur Bench は、一貫した指標と評価手法を使用することで、企業に信頼できる比較フレームワークを提供し、企業が各 LLM オプションの利点と制限を完全に評価できるようにします。これにより、企業は情報に基づいた意思決定を行い、人工知能の急速な進歩を最大限に活用し、アプリケーションで可能な限り最高のエクスペリエンスを保証できるようになります。

2. 予算とプライバシーの最適化

人工知能モデルを選択する場合、すべてのアプリケーションが最先端または高価な大規模言語モデル (LLM) を必要とするわけではありません。場合によっては、より安価な AI モデルを使用してミッション要件を満たすことができます。

この予算最適化アプローチは、企業が限られたリソースで賢明な選択を行うのに役立ちます。最も高価なモデルや最先端のモデルを選ぶのではなく、特定のニーズに基づいて適切なモデルを選択してください。より手頃な価格のモデルは、いくつかの面で最先端の LLM よりもパフォーマンスが若干劣る可能性がありますが、一部の単純なタスクや標準的なタスクについては、Arthur Bench が依然としてニーズを満たすソリューションを提供できます。

さらに、Arthur Bench 氏は、このモデルを社内に導入することで、データ プライバシーの管理を強化できると強調しました。機密データやプライバシー問題を伴うアプリケーションの場合、企業は外部のサードパーティ LLM に依存するのではなく、内部でトレーニングされた独自のモデルを使用することを好む場合があります。内部モデルを使用することで、企業はデータの処理と保存をより詳細に制御し、データのプライバシーをより適切に保護できます。

3. アカデミック ベンチマークを現実世界のパフォーマンスに変換する

アカデミック ベンチマークとは、学術研究で確立されたモデルの評価指標と手法を指します。これらの指標と手法は通常、特定のタスクまたはドメインに固有であり、そのタスクまたはドメインにおけるモデルのパフォーマンスを効果的に評価できます。

ただし、学術的なベンチマークは、現実世界のモデルのパフォーマンスを必ずしも直接反映するとは限りません。これは、現実世界のアプリケーション シナリオはより複雑であることが多く、データ分散、モデル展開環境など、より多くの要素を考慮する必要があるためです。

Arthur Bench は、学術的なベンチマークを現実世界のパフォーマンスに変換するのに役立ちます。この目標は次の方法で達成されます:

- モデルの精度、効率、堅牢性などの複数の側面をカバーする包括的な評価指標のセットを提供します。これらの指標は、学術的なベンチマークに基づくモデルのパフォーマンスを反映するだけでなく、現実世界におけるモデルの潜在的なパフォーマンスも反映します。

- 複数のモデル タイプをサポートし、異なるタイプのモデルを比較できます。これにより、企業はアプリケーション シナリオに最適なモデルを選択できるようになります。

- 企業がさまざまなモデルのパフォーマンスの違いを直観的に理解できるようにする視覚的な分析ツールを提供します。これにより、企業はより簡単に意思決定を行うことができます。

5. Arthur Bench の機能分析

高速なデータ駆動型 LLM 評価の鍵として、Arthur Bench には次の機能があります:

1. フルスコア メトリックのセット

Arthur Bench には、概要品質からユーザー エクスペリエンスまですべてをカバーする包括的なスコア メトリック セットがあります。これらのスコアリング指標をいつでも使用して、さまざまなモデルを評価および比較できます。これらのスコア指標を組み合わせて使用すると、各モデルの長所と短所を完全に理解するのに役立ちます。

これらのスコア指標の範囲は非常に広く、要約の品質、正確さ、流暢さ、文法の正しさ、文脈理解能力、論理的一貫性などが含まれますが、これらに限定されません。 Arthur Bench は、これらの指標に照らして各モデルを評価し、その結果を総合的なスコアに結合して、企業が情報に基づいた意思決定を行えるように支援します。

さらに、企業に特定のニーズや懸念事項がある場合、Arthur Bench は企業の要件に基づいてカスタム スコアリング指標を作成および追加できます。これは、企業固有のニーズをより適切に満たし、評価プロセスが企業の目標および基準と一致していることを確認するために行われます。

2. ローカル バージョンとクラウド ベースのバージョン

ローカル デプロイと自律制御を希望する場合は、GitHub リポジトリの権限からアクセスしてデプロイできます。 Arthur Bench をあなたのローカル環境に。このようにして、誰もが Arthur Bench の操作を完全に習得および制御し、自分のニーズに応じてカスタマイズおよび構成することができます。

一方、利便性と柔軟性を好むユーザーには、クラウドベースの SaaS 製品も利用できます。クラウド経由で Arthur Bench にアクセスして使用するために登録することを選択できます。この方法により、ローカルでの面倒なインストールや設定が不要となり、提供される機能やサービスをすぐに利用することができます。

3. 完全なオープンソース

オープンソース プロジェクトとして、Arthur Bench は透明性、スケーラビリティ、コミュニティ コラボレーションの点で典型的なオープンソースの特徴を示しています。このオープンソースの性質は、プロジェクトがどのように機能するかをより深く理解し、ニーズに合わせてカスタマイズおよび拡張するための豊富な利点と機会をユーザーに提供します。同時に、Arthur Bench のオープン性は、ユーザーがコミュニティのコラボレーションに積極的に参加し、他のユーザーと協力して開発することも奨励します。このオープンな協力モデルは、プロジェクトの継続的な開発と革新を促進すると同時に、ユーザーにとってより大きな価値と機会を生み出します。

つまり、Arthur Bench は、ユーザーが評価指標をカスタマイズできるオープンで柔軟なフレームワークを提供し、金融分野で広く使用されています。アマゾン ウェブ サービスおよび Cohere とのパートナーシップによりフレームワークがさらに進化し、開発者が Bench 用の新しいメトリクスを作成し、言語モデル評価の分野の進歩に貢献することが奨励されます。

参考:

- [1] https://github.com/arthur-ai/bench

- [2] https://neurohive.io/ en/news/arthur-bench-framework-for-evaluating-lang-models/

以上がArthur Bench を使用した LLM 評価を 1 つの記事で理解するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。