Maison >Périphériques technologiques >IA >Les performances LLM sont améliorées jusqu'à 60 % ! Chef-d'œuvre de Google ICLR 2024 : laissez le grand modèle de langage apprendre le « langage des graphiques »

Les performances LLM sont améliorées jusqu'à 60 % ! Chef-d'œuvre de Google ICLR 2024 : laissez le grand modèle de langage apprendre le « langage des graphiques »

- 王林avant

- 2024-03-27 20:46:33772parcourir

Dans le domaine de l'informatique, une structure de graphe est constituée de nœuds (représentant des entités) et d'arêtes (représentant des relations entre entités).

Les photos sont partout.

Internet peut être considéré comme un immense réseau et les moteurs de recherche utilisent des méthodes graphiques pour organiser et afficher les informations.

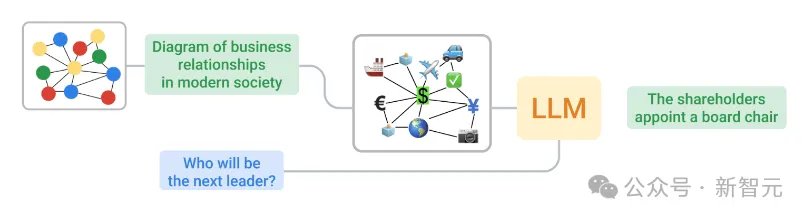

Les LLM sont principalement formés sur du texte ordinaire, donc convertir des graphiques en texte compréhensible par les LLM est une tâche difficile car la structure du graphique est fondamentalement différente du texte.

Lors de l'ICLR 2024, une équipe de Google a exploré comment transformer les données graphiques en une forme adaptée aux LLM.

Adresse papier : https://openreview.net/pdf?id=IuXR1CCrSi

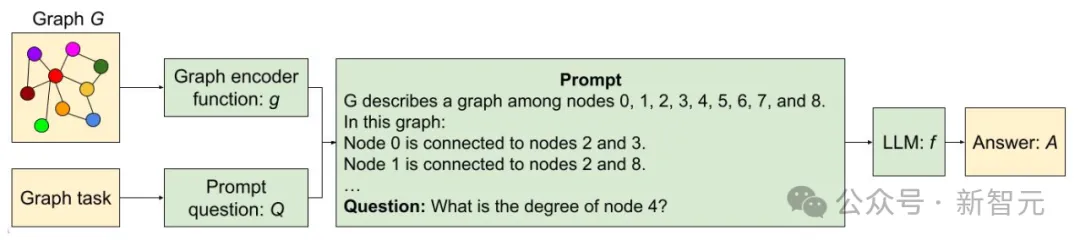

Utilisez deux méthodes différentes pour encoder les graphiques en texte et renvoyer le texte et les questions à LLM Dans le processus

, ils ont également développé un benchmark appelé GraphQA pour explorer des approches permettant de résoudre différents problèmes de raisonnement graphique et ont montré comment exprimer ces problèmes d'une manière qui soit bénéfique pour LLM pour résoudre les problèmes liés aux graphiques.

En utilisant la bonne méthode, les LLM peuvent améliorer les performances des tâches graphiques jusqu'à 60 %.

GraphOA : Un « examen » pour les LLM

Tout d'abord, l'équipe de Google a conçu le benchmark GraphQA, qui peut être considéré comme un examen conçu pour évaluer la capacité du LLM à résoudre des problèmes de graphes spécifiques.

GraphOA garantit la diversité de l'étendue et du nombre de connexions en utilisant plusieurs types de graphiques pour trouver les écarts possibles dans les LLM lors du traitement des graphiques, et rend l'ensemble du processus plus proche de ce que les LLM peuvent rencontrer dans les applications pratiques.

Un cadre pour raisonner avec les LLM à l'aide de GraphIQA

Bien que les tâches soient simples, comme vérifier si des arêtes existent, calculer le nombre de nœuds ou d'arêtes, etc., ces tâches nécessitent que les LLM comprennent le relation entre les nœuds et les arêtes. La relation entre eux est cruciale pour un raisonnement graphique plus complexe.

Dans le même temps, l'équipe a également exploré comment convertir des graphiques en texte que les LLM peuvent traiter, par exemple en résolvant les deux problèmes clés suivants :

Encodage de nœud : Comment représentons-nous un seul nœud ? Les nœuds peuvent inclure des entiers simples, des noms communs (personnes, caractères) et des lettres.

Edge Coding : Comment décrivons-nous les relations entre les nœuds ? Les méthodes peuvent inclure des notations entre crochets, des expressions (telles que « sont amis ») et des représentations symboliques (telles que des flèches).

En fin de compte, les chercheurs ont systématiquement combiné diverses méthodes de codage de nœuds et de bords pour produire des fonctions telles que celles présentées dans la figure ci-dessous.

Exemple de fonction d'encodage graphique

Comment fonctionnent les LLM ?

L'équipe de recherche a mené trois expériences clés sur GraphOA :

- Test de la capacité des LLM à gérer des tâches graphiques

- Test de l'impact de la taille des LLM sur les performances

- Test de l'impact de différents formes de graphiques sur les performances Impact

Dans la première expérience, les LLM ont effectué des performances médiocres, et sur la plupart des tâches de base, les LLM n'ont pas fait mieux que des suppositions aléatoires.

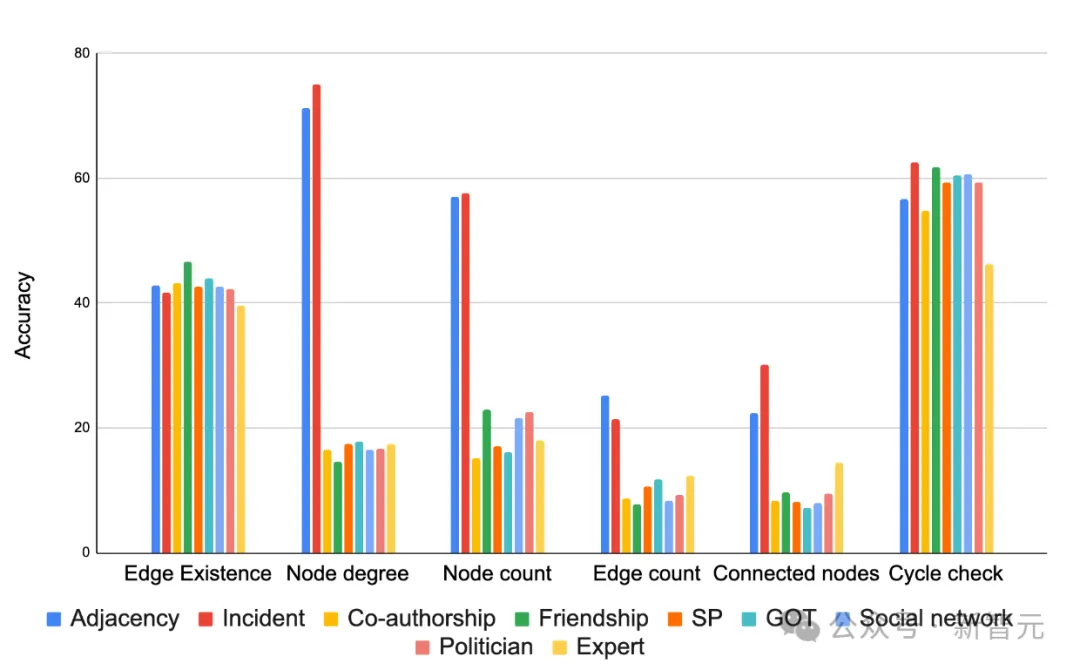

Mais la méthode d'encodage affecte de manière significative les résultats, comme le montre la figure ci-dessous, dans la plupart des cas, l'encodage « incident » fonctionne bien dans la plupart des tâches. Le choix d'une fonction d'encodage appropriée peut grandement améliorer la précision de la tâche.

Comparaison de diverses fonctions d'encodeur graphique basées sur différentes précisions de tâches

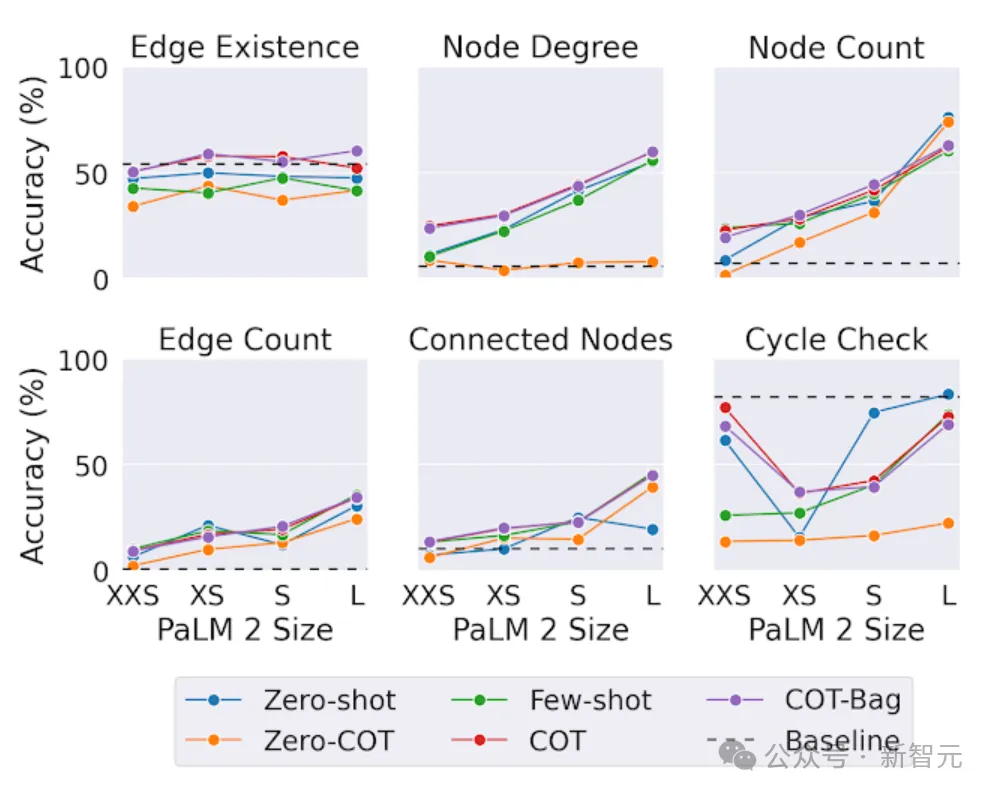

Dans le deuxième test, les chercheurs ont testé la même tâche graphique sur des modèles de différentes tailles.

En termes de conclusion, dans la tâche d'inférence de graphe, le modèle plus grand a mieux fonctionné,

Cependant, fait intéressant, dans la tâche "existence des bords" (déterminer si deux nœuds du graphe sont connectés), la taille est pas aussi important que d'autres tâches.

Même le plus grand LLM ne peut pas toujours battre les solutions de base simples sur le problème de vérification du cycle (déterminer si un cycle existe dans le graphique). Cela montre que les LLM peuvent encore s'améliorer sur certaines tâches graphiques.

L'impact de la capacité du modèle sur les tâches de raisonnement graphique de PaLM 2-XXS, les gens utilisent GraphOA pour générer des graphiques de différentes structures à des fins d'analyse.

Exemples de graphiques générés par différents générateurs de graphiques de GraphQA. ER, BA, SBM et SFN sont respectivement Erdős-Rényi, Barabási-Albert, modèle de bloc stochastique et réseau sans échelle.

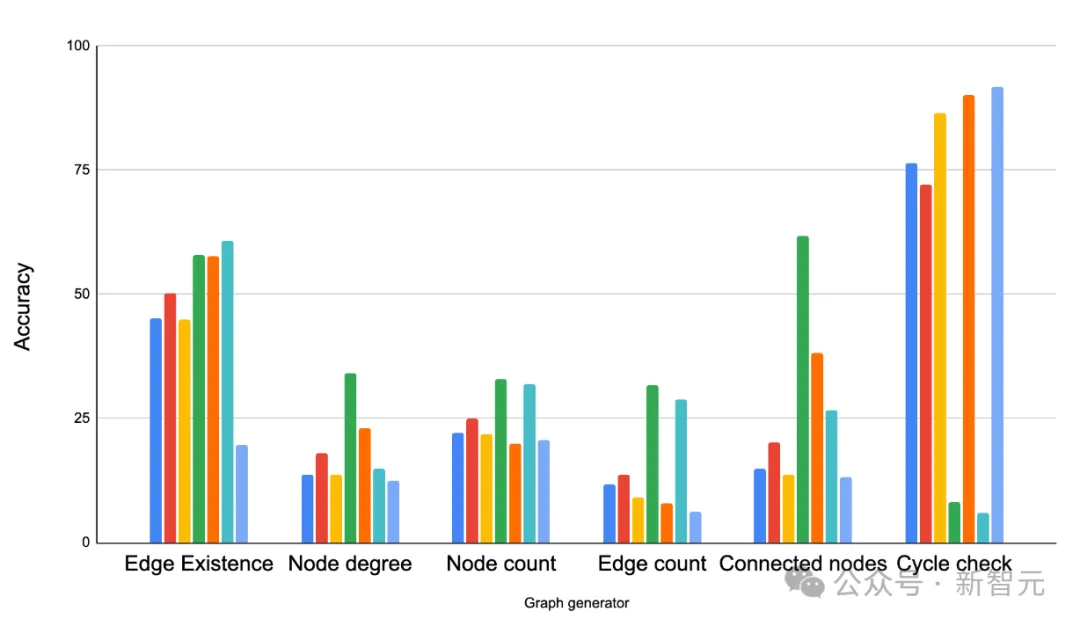

Les résultats montrent que la structure du graphique a un grand impact sur les performances des LLM.

Par exemple, dans une tâche demandant si des boucles existent, les LLM fonctionnent bien dans les graphiques étroitement connectés (où les boucles sont courantes) mais mal dans les graphiques de chemin (où les boucles ne se produisent jamais).

Mais en même temps, fournir des échantillons mixtes aide les LLM à s'adapter. Par exemple, dans la tâche de détection de cycle, les chercheurs ont ajouté des exemples contenant des cycles et d'autres qui n'en contiennent pas dans les invites comme exemples de quelques-uns. L'apprentissage par tir. Grâce à cette méthode, les performances des LLM sont améliorées.

Comparez différents générateurs de graphiques sur différentes tâches graphiques. La principale observation est que la structure du graphe a un impact significatif sur les performances du LLM. ER, BA, SBM et SFN font respectivement référence à Erdős-Rényi, Barabási-Albert, au modèle de bloc stochastique et au réseau sans échelle.

Ce n'est que le début pour permettre aux LLM de comprendre les graphiques

Dans l'article, l'équipe de Google a initialement exploré la meilleure façon de représenter les graphiques sous forme de texte afin que les LLM puissent les comprendre.

Améliore considérablement la précision des LLM sur les problèmes de graphiques (d'environ 5 % à plus de 60 % d'amélioration) à l'aide de techniques de codage correctes.

Nous avons également identifié trois principaux facteurs d'influence, à savoir la méthode d'encodage de conversion des graphiques en texte, les types de tâches des différents graphiques et la structure de densité des graphiques.

Ce n'est que le début pour les LLM de comprendre les graphiques. Avec l'aide du nouveau benchmark GraphQA, nous attendons avec impatience de poursuivre les recherches pour explorer davantage de possibilités de LLM.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tutoriel vidéo de formation pratique sur la conception fonctionnelle du système logiciel Java

- Comment TensorFlow met en œuvre l'entraînement aléatoire et l'entraînement par lots

- Dans la technologie des bases de données, quels sont les quatre principaux modèles de données ?

- Utiliser Pytorch pour mettre en œuvre l'apprentissage contrastif SimCLR pour une pré-formation auto-supervisée

- Utilisez la vision pour inciter ! Shen Xiangyang a présenté le nouveau modèle de l'Institut de recherche IDEA, qui ne nécessite aucune formation ni réglage précis et peut être utilisé directement.