Maison >Périphériques technologiques >IA >Pénétrez dans la couche inférieure de l'IA ! L'équipe de NUS Youyang utilise un modèle de diffusion pour construire les paramètres du réseau neuronal, LeCun aime ça

Pénétrez dans la couche inférieure de l'IA ! L'équipe de NUS Youyang utilise un modèle de diffusion pour construire les paramètres du réseau neuronal, LeCun aime ça

- PHPzavant

- 2024-02-26 10:43:131224parcourir

Le modèle de diffusion a inauguré une nouvelle application majeure :

Tout comme Sora générant des vidéos, il génère des paramètres pour les réseaux de neurones et pénètre directement dans la couche inférieure de l'IA !

Il s'agit du dernier résultat de recherche open source de l'équipe du professeur You Yang de l'Université nationale de Singapour, en collaboration avec UCB, Meta AI Laboratory et d'autres institutions.

Plus précisément, l'équipe de recherche a proposé un modèle de diffusion p(arameter)-diff pour générer des paramètres de réseau neuronal.

Utilisez-le pour générer des paramètres réseau, la vitesse est jusqu'à 44 fois plus rapide que la formation directe et les performances ne sont pas inférieures.

Après la sortie du modèle, il a rapidement suscité des discussions animées au sein de la communauté de l'IA. Les experts du cercle ont montré la même attitude étonnante que les gens ordinaires en voyant Sora.

Certaines personnes se sont même directement exclamées que cela équivaut fondamentalement à la création d'une nouvelle IA par l'IA.

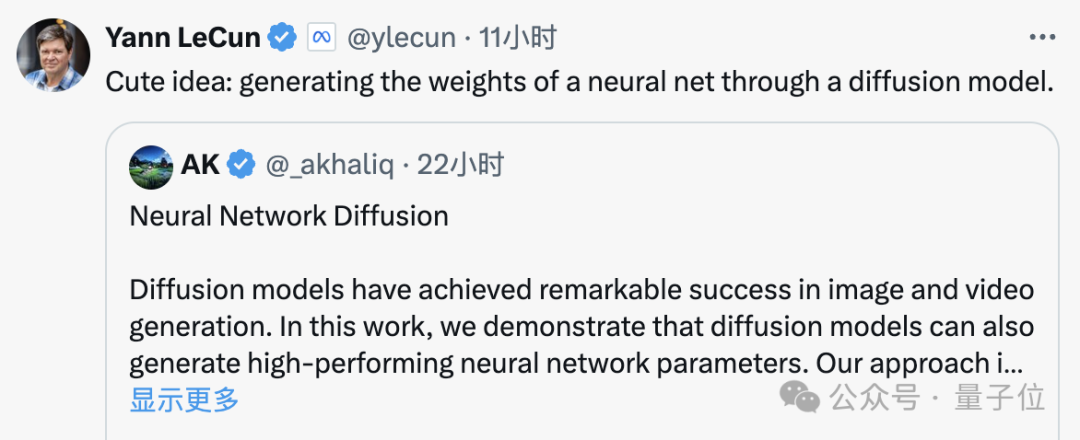

Même le géant de l'IA, LeCun, a loué cette réalisation après l'avoir vue, affirmant que c'était vraiment une idée mignonne.

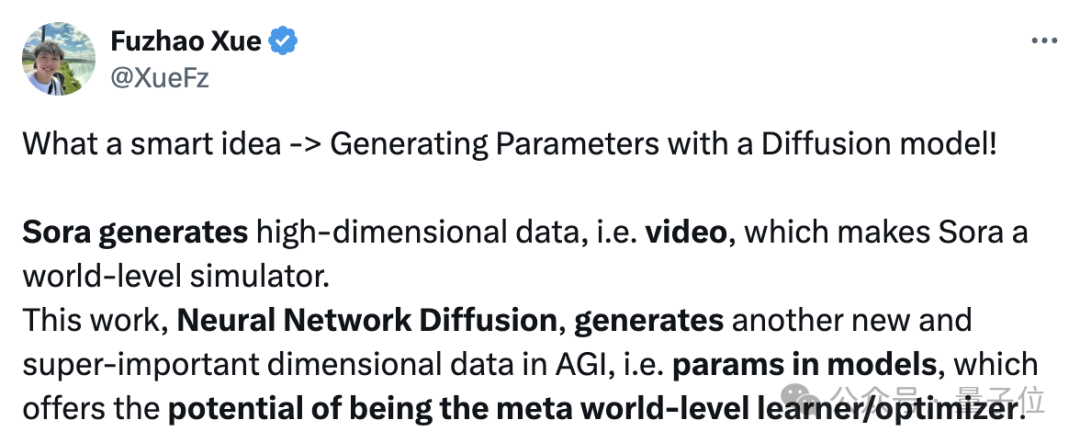

En fait, p-diff a la même signification que Sora, le Dr Fuzhao Xue (Xue Fuzhao) du même laboratoire a expliqué en détail :

Sora génère des données de grande dimension, c'est-à-dire des vidéos. fait de Sora un simulateur de monde (se rapprochant de l'AGI à partir d'une seule dimension).

Et ce travail, la diffusion du réseau neuronal, peut générer des paramètres dans le modèle, a le potentiel de devenir un apprenant/optimiseur de classe mondiale, évoluant vers l'AGI à partir d'une autre nouvelle dimension importante.

Pour en revenir au sujet, comment p-diff génère-t-il les paramètres du réseau neuronal ?

Combinaison de l'auto-encodeur avec le modèle de diffusion

Pour comprendre ce problème, nous devons d'abord comprendre les caractéristiques de fonctionnement du modèle de diffusion et du réseau neuronal.

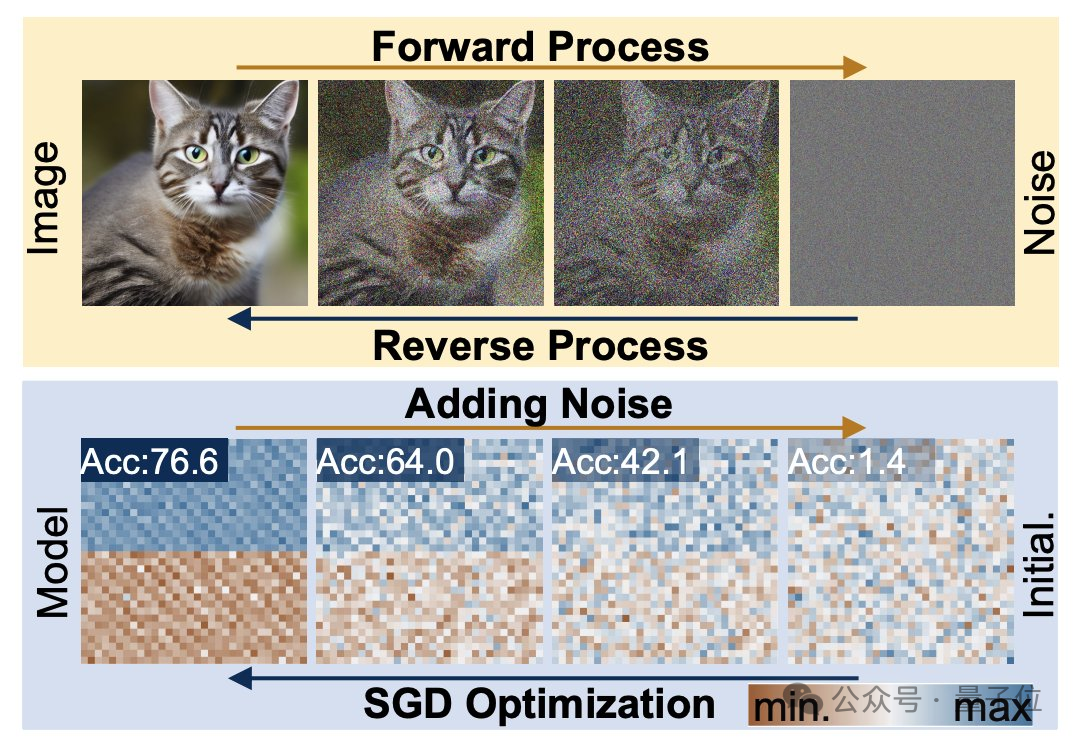

Le processus de génération de diffusion est la transformation d'une distribution aléatoire en une distribution très spécifique Grâce à l'ajout de bruit composé, l'information visuelle est réduite à une simple distribution de bruit.

L'entraînement des réseaux neuronaux suit également ce processus de transformation et peut également être dégradé par l'ajout de bruit. Inspirés par cette fonctionnalité, les chercheurs ont proposé la méthode p-diff.

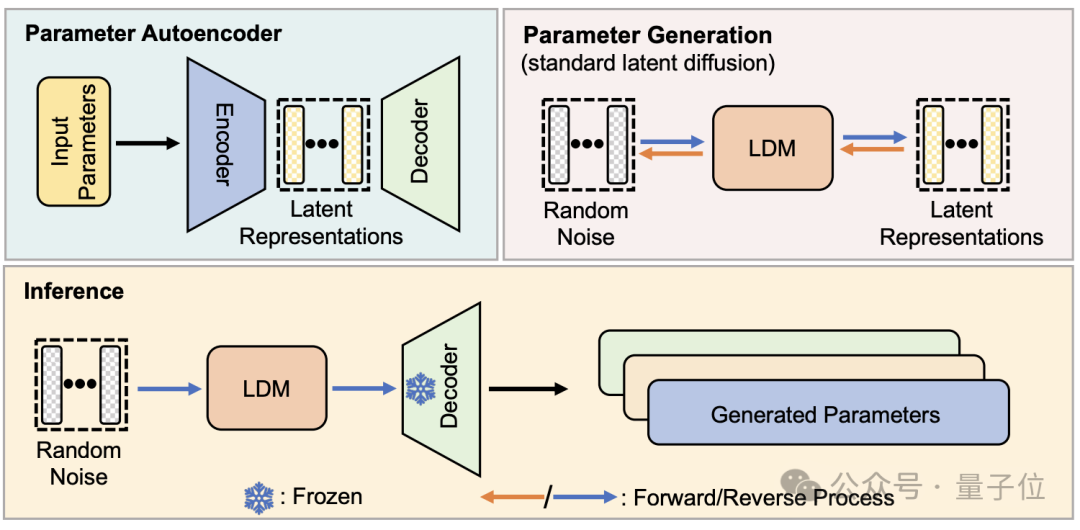

D'un point de vue structurel, p-diff est conçu par l'équipe de recherche sur la base du modèle standard de diffusion latente et combiné avec l'auto-encodeur.

Le chercheur sélectionne d'abord une partie des paramètres de réseau qui ont été entraînés et fonctionnent bien, et les développe sous une forme vectorielle unidimensionnelle.

Utilisez ensuite l'auto-encodeur pour extraire la représentation latente du vecteur unidimensionnel comme données d'entraînement pour le modèle de diffusion. Cela peut capturer les caractéristiques clés des paramètres d'origine.

Pendant le processus de formation, les chercheurs ont laissé p-diff apprendre la distribution des paramètres via des processus aller et retour. Une fois terminé, le modèle de diffusion synthétise ces représentations potentielles à partir de bruit aléatoire, comme le processus de génération d'informations visuelles.

Enfin, la représentation latente nouvellement générée est restituée aux paramètres réseau par le décodeur correspondant à l'encodeur et utilisée pour construire un nouveau modèle.

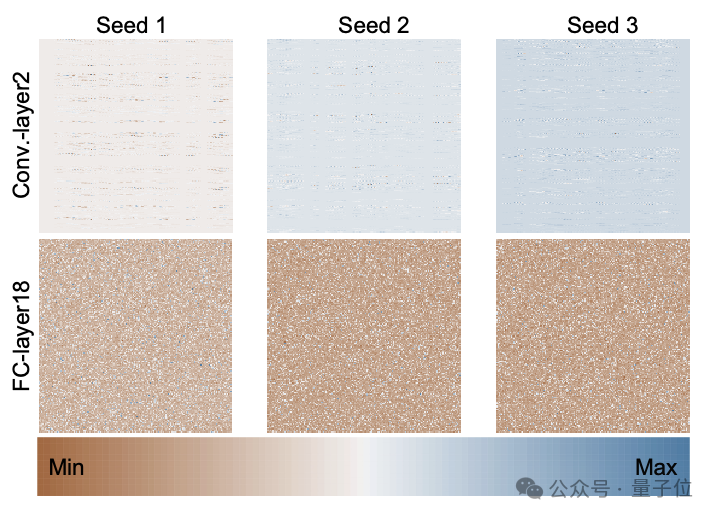

La figure suivante est la distribution des paramètres du modèle ResNet-18 formé à partir de zéro en utilisant 3 graines aléatoires via p-diff, montrant le modèle de distribution entre différentes couches et entre différents paramètres dans la même couche.

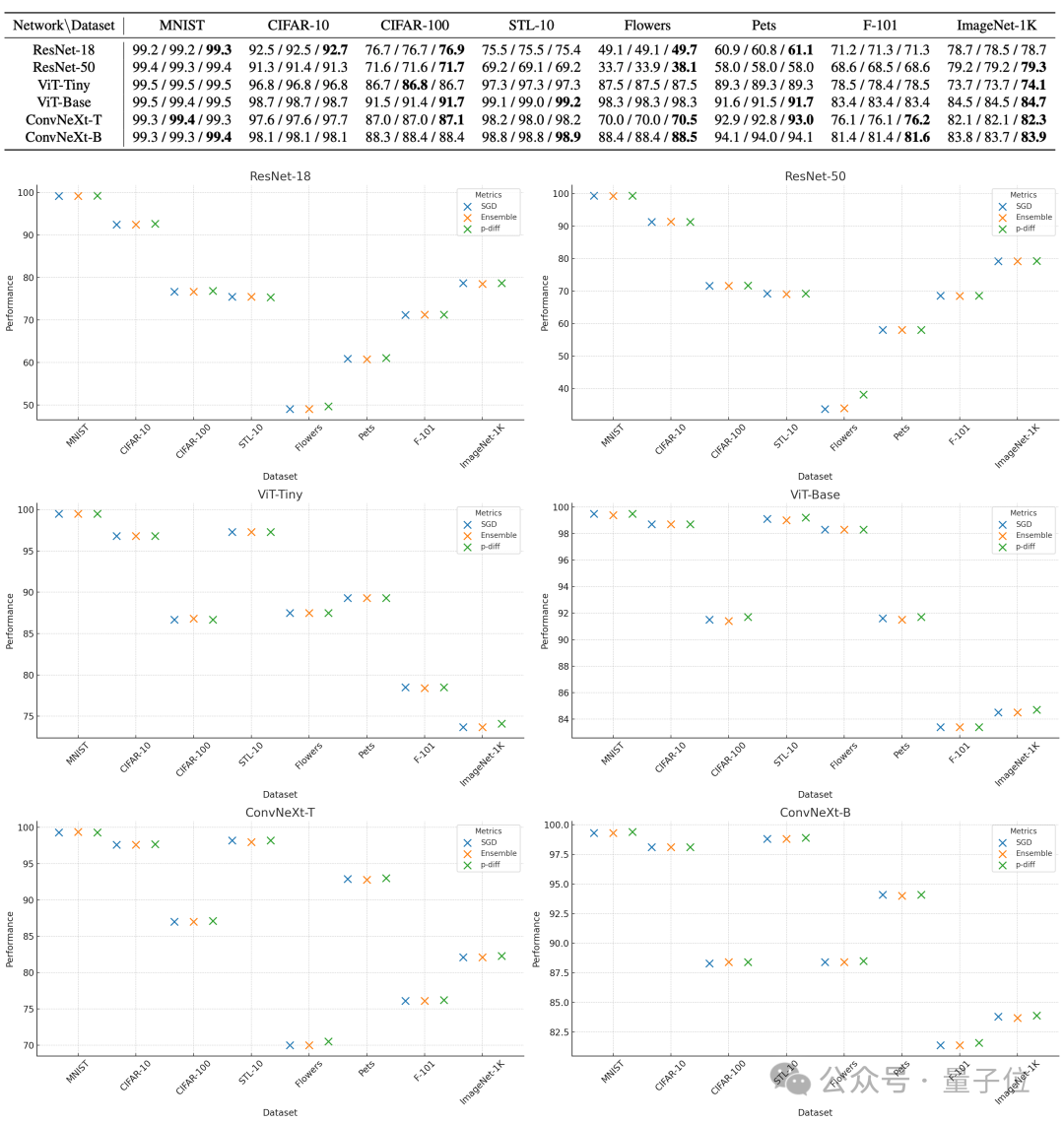

Pour évaluer la qualité des paramètres générés par p-diff, les chercheurs l'ont testé sur 8 ensembles de données utilisant 3 types de réseaux de neurones de deux tailles chacun.

Dans le tableau ci-dessous, les trois nombres de chaque groupe représentent les résultats d'évaluation du modèle original, du modèle intégré et du modèle généré avec p-diff.

Comme vous pouvez le voir sur les résultats, les performances du modèle généré avec p-diff sont fondamentalement proches, voire meilleures, que celles du modèle d'origine entraîné manuellement.

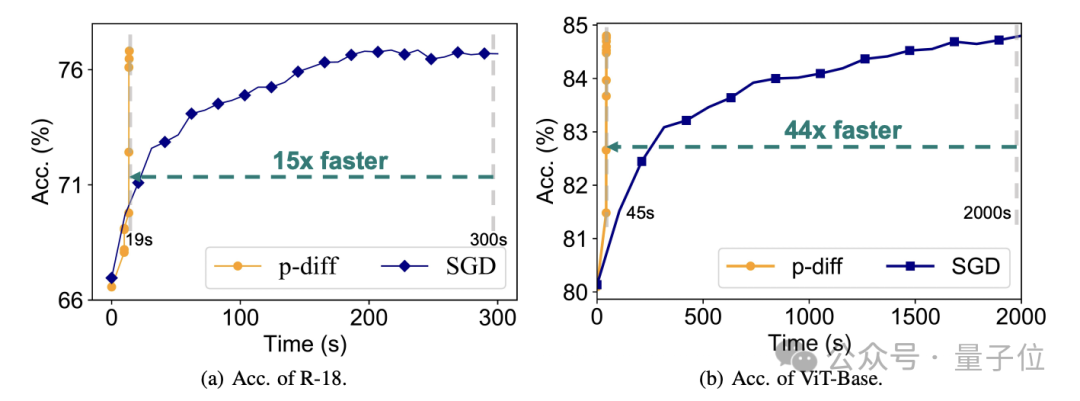

En termes d'efficacité, sans perdre en précision, p-diff génère le réseau ResNet-18 15 fois plus rapide que la formation traditionnelle, et génère Vit-Base 44 fois plus rapidement.

Des résultats de tests supplémentaires prouvent que le modèle généré par p-diff est significativement différent des données d'entraînement.

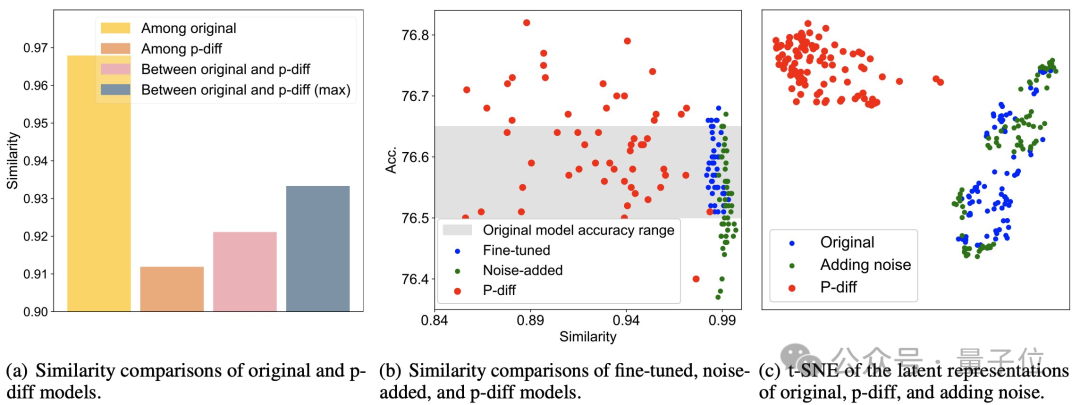

Comme vous pouvez le voir sur la figure (a) ci-dessous, la similarité entre les modèles générés par p-diff est inférieure à la similarité entre les modèles originaux, ainsi que la similarité entre p-diff et le modèle original.

Comme le montrent les points (b) et (c), par rapport aux méthodes de réglage fin et d'ajout de bruit, la similarité de p-diff est également plus faible.

Ces résultats montrent que p-diff génère en fait un nouveau modèle au lieu de simplement mémoriser des échantillons d'entraînement. Cela montre également qu'il a une bonne capacité de généralisation et peut générer de nouveaux modèles différents des données d'entraînement.

Actuellement, le code de p-diff est open source Si vous êtes intéressé, vous pouvez le consulter sur GitHub.

Adresse papier : https://arxiv.org/abs/2402.13144

GitHub : https://github.com/NUS-HPC-AI-Lab/Neural-Network-Diffusion

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment écrire un simulateur avec JS

- quel logiciel est ai

- En quelle année Google a-t-il lancé son système de traduction automatique sur réseau neuronal ?

- Comment définir l'émulateur de terminal par défaut pour Debian11

- Liste des recettes et effets de poisson bleu dans 'Demon Doll: Reincarnation Simulator'