Heim >Technologie-Peripheriegeräte >KI >Mit 35 Milliarden Parametern und offenen Gewichten brachte der Autor von Transformer nach der Gründung seines eigenen Unternehmens ein neues großes Modell auf den Markt.

Mit 35 Milliarden Parametern und offenen Gewichten brachte der Autor von Transformer nach der Gründung seines eigenen Unternehmens ein neues großes Modell auf den Markt.

- 王林nach vorne

- 2024-03-13 08:58:24547Durchsuche

Heute begrüßte Cohere, ein Startup für künstliche Intelligenz, das von Aidan Gomez, einem der Autoren von Transformer, mitbegründet wurde, die Veröffentlichung seines eigenen großen Modells.

Das neueste veröffentlichte Modell von Cohere trägt den Namen „Command-R“, verfügt über 35B Parameter und ist für die Bewältigung großer Produktionsauslastungen ausgelegt. Dieses Modell fällt in die Kategorie „skalierbar“ und bietet ein ausgewogenes Verhältnis zwischen hoher Effizienz und hoher Genauigkeit und hilft Unternehmensanwendern, über den Proof-of-Concept hinaus in die Produktion zu gelangen.

Command-R ist ein generatives Modell, das speziell für Retrieval Augmented Generation (RAG) und andere Aufgaben mit langem Kontext optimiert ist. Durch die Kombination externer APIs und Tools zielt dieses Modell darauf ab, die Leistung von RAG-Anwendungen zu verbessern. Es arbeitet mit branchenführenden Einbettungs- und Neuordnungsmodellen, um herausragende Leistung und erstklassige Integrationsfunktionen für Unternehmensanwendungsfälle bereitzustellen.

Command-R verwendet eine optimierte Transformatorarchitektur und ist ein autoregressives Sprachmodell. Nach Abschluss des Vortrainings wird durch überwachte Feinabstimmung (SFT) und Präferenztraining sichergestellt, dass das Modell mit den menschlichen Präferenzen übereinstimmt, um eine bessere Nützlichkeit und Sicherheit zu erreichen.

Im Einzelnen weist Command-R die folgenden Funktionsmerkmale auf:

- Hohe Genauigkeit bei RAG und Tool-Nutzung

- Geringe Latenz, hoher Durchsatz

- Längerer 128k-Kontext und niedrigerer Preis

- Leistungsstarke Funktionalität in 10 Hauptsprachen.

- Modellgewichte sind auf HuggingFace für Forschung und Evaluierung verfügbar.

Command-R ist derzeit auf der verwalteten API von Cohere verfügbar. Pläne für die baldige Verfügbarkeit bei großen Cloud-Anbietern. Diese Version ist die erste einer Reihe von Modellen, die darauf ausgelegt sind, Funktionen zu verbessern, die für die Masseneinführung in Unternehmen entscheidend sind.

Derzeit hat Cohere Modellgewichte auf Huggingface eröffnet.

Huggingface Adresse: https://huggingface.co/CohereForAI/c4ai-command-r-v01

High-performance Retrieval Enhancement Generation (RAG)

Retrieval Enhancement Generation. (RAG ) ist zu einem Schlüsselmuster bei der Bereitstellung großer Sprachmodelle geworden. Mit RAG können Unternehmen Modellen Zugriff auf privates Wissen gewähren, das andernfalls nicht verfügbar wäre, private Datenbanken durchsuchen und relevante Informationen zur Formulierung von Antworten verwenden, was die Genauigkeit und Nützlichkeit erheblich erhöht. Die Schlüsselkomponenten von RAG sind:

- Abruf: Durchsuchen Sie einen Korpus von Informationen, die für den Antwortbenutzer relevant sind.

- Augmented Generation: Verwenden Sie abgerufene Informationen, um fundiertere Antworten zu formulieren.

Beim Abruf verbessert das Embed-Modell von Cohere das kontextuelle und semantische Verständnis durch die Suche in Millionen oder sogar Milliarden von Dokumenten und erhöht so den Nutzen und die Genauigkeit des Abrufschritts erheblich. Gleichzeitig trägt das Rerank-Modell von Cohere dazu bei, den Wert der abgerufenen Informationen weiter zu steigern und die Ergebnisse für benutzerdefinierte Metriken wie Relevanz und Personalisierung zu optimieren.

Für die erweiterte Generierung kann Command-R durch die Identifizierung der relevantesten Informationen diese Informationen zusammenfassen, analysieren und verpacken und Mitarbeitern dabei helfen, die Arbeitseffizienz zu verbessern oder neue Produkterlebnisse zu schaffen. Command-R ist insofern einzigartig, als die Ausgabe des Modells klare Zitate enthält, wodurch das Risiko von Halluzinationen verringert und mehr Kontext aus dem Quellmaterial wiedergegeben wird.

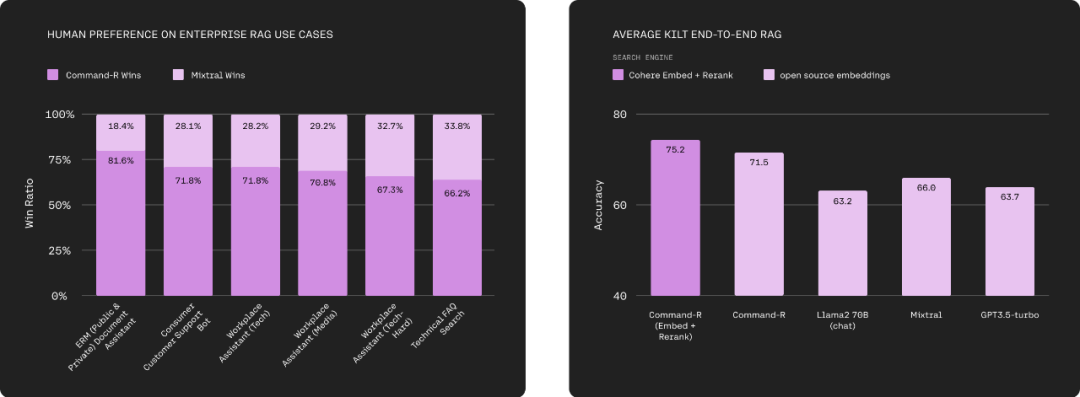

Auch ohne die Verwendung eigener Embed- und Rerank-Modelle übertrifft Command-R andere Modelle in der Kategorie der skalierbaren generativen Modelle. Bei gemeinsamer Verwendung vergrößert sich der Vorsprung jedoch erheblich und ermöglicht eine höhere Leistung in komplexeren Bereichen.

Das Bild unten links zeigt, wie Command-R und Mixtral eine umfassende direkte direkte Bewertung der menschlichen Präferenzen für eine Reihe unternehmensbezogener RAG-Anwendungen durchführen und dabei Sprachkompetenz, Praktikabilität der Antworten und Zitate berücksichtigen. Die rechte Seite der Abbildung zeigt die Vergleichsergebnisse von Command-R (Embed+Rerank), Command-R und Llama 2 70B (Chat), Mixtral, GPT3.5-Turbo und anderen Modellen bei Benchmarks wie Natural Questions, TriviaQA und HotpotQA. Das große Modell von Cohere übernimmt die Führung.

Leistungsstarke Werkzeugnutzung

Große Sprachmodelle sollten zentrale Inferenzmaschinen sein, die Aufgaben automatisieren und echte Aktionen ausführen können, und nicht nur Maschinen, die Text extrahieren und generieren. Command-R erreicht dieses Ziel durch den Einsatz von Tools (APIs) wie Code-Interpretern und anderen benutzerdefinierten Tools, die es Modellen ermöglichen, hochkomplexe Aufgaben zu automatisieren.

Die Funktion „Tool Use“ ermöglicht es Unternehmensentwicklern, Command-R in eine Engine zu verwandeln, um Aufgaben und Arbeitsabläufe zu unterstützen, die die Verwendung „interner Infrastruktur wie Datenbanken und Softwaretools“ sowie „externer Tools wie CRMs und Suchmaschinen“ erfordern „Automatisierung. Dadurch können wir zeitaufwändige manuelle Aufgaben automatisieren, die sich über mehrere Systeme erstrecken und komplexe Überlegungen und Entscheidungen erfordern.

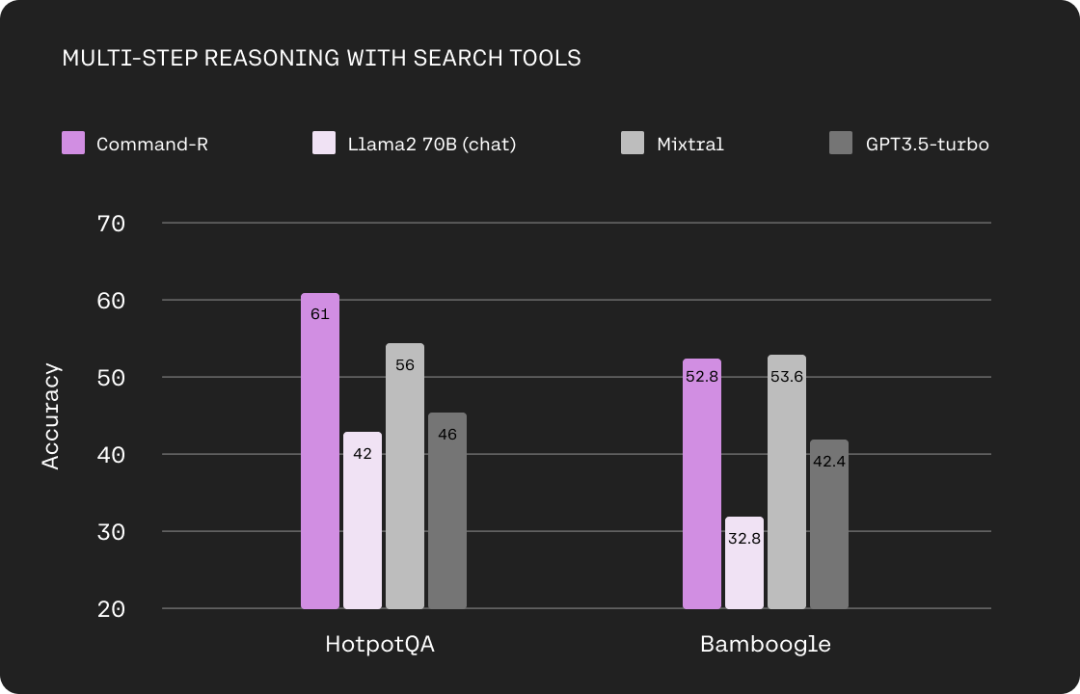

Das Bild unten zeigt den Vergleich der mehrstufigen Argumentationsfunktionen zwischen Command-R und Llama 2 70B (Chat), Mixtral und GPT3.5-turbo bei Verwendung von Suchtools. Die hier verwendeten Datensätze sind HotpotQA und Bamboogle.

Funktionen zur Generierung mehrerer Sprachen

Das Command-R-Modell beherrscht 10 wichtige Geschäftssprachen auf der ganzen Welt, darunter Englisch, Französisch, Spanisch, Italienisch, Deutsch, Portugiesisch, Japanisch, Koreanisch, Arabisch und Chinesisch.

Darüber hinaus unterstützen die Embed- und Rerank-Modelle von Cohere nativ über 100 Sprachen. Dies ermöglicht es Benutzern, Antworten aus einer Vielzahl von Datenquellen zu ziehen und unabhängig von der Sprache klare und genaue Gespräche in ihrer Muttersprache zu führen.

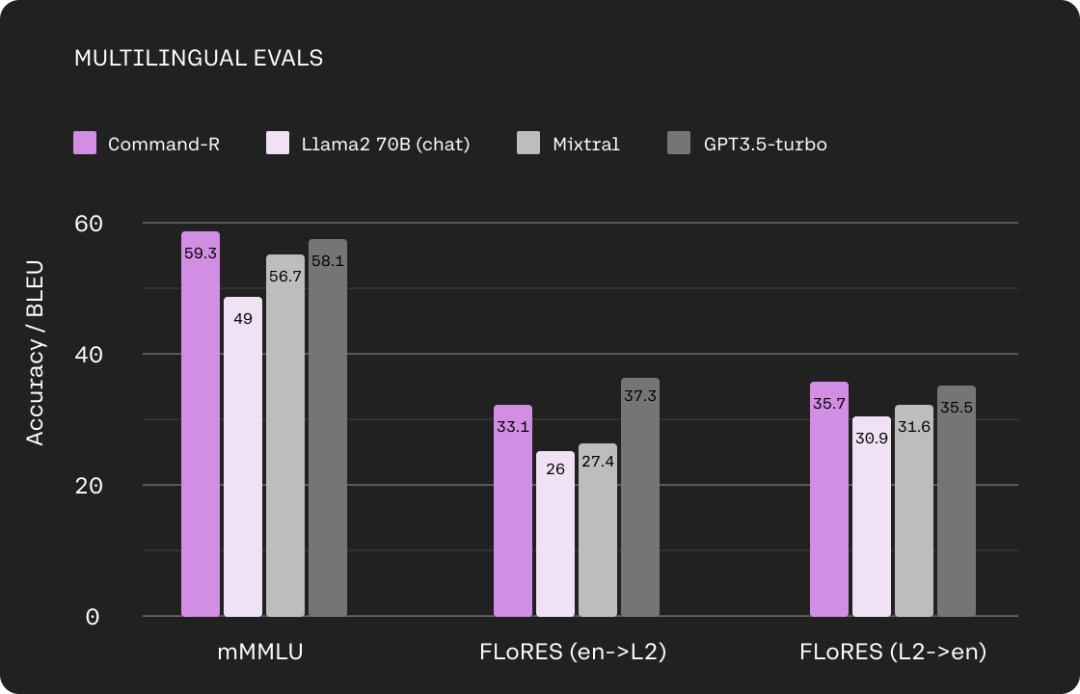

Das Bild unten zeigt den Vergleich zwischen Command-R und Llama 2 70B (Chat), Mixtral, GPT3.5-Turbo auf mehrsprachigem MMLU und FLORES.

Längerer Kontext und niedrigerer Preis

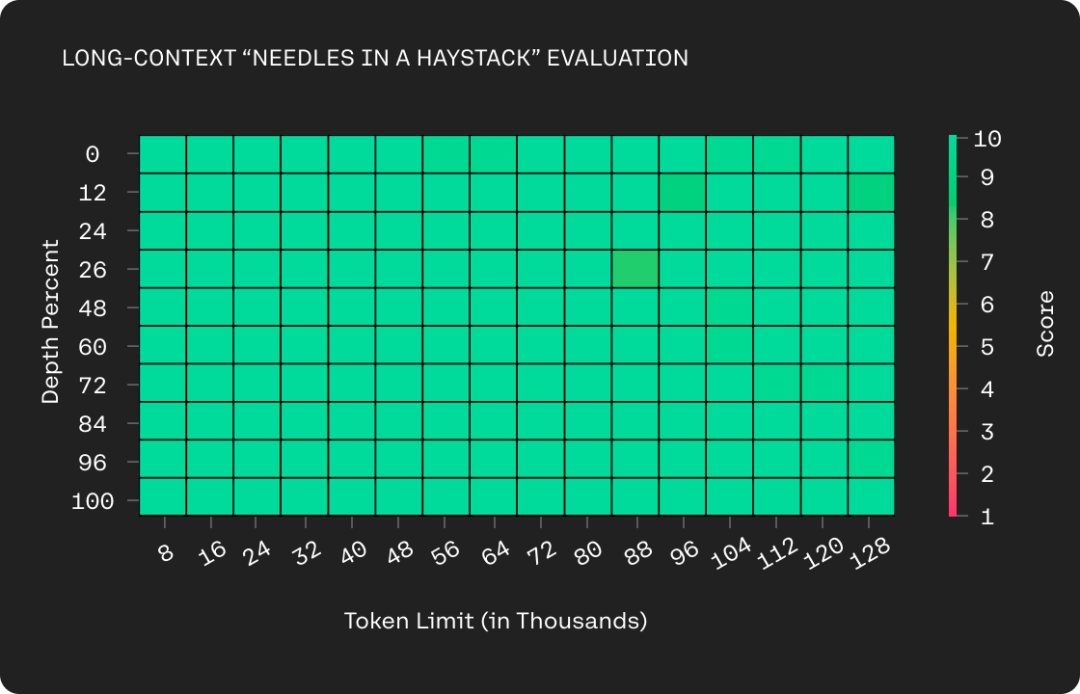

Command-R unterstützt längere Kontextfenster – 128.000 Token. Das Upgrade senkt außerdem den Preis der verwalteten APIs von Cohere und erhöht die Effizienz der privaten Cloud-Bereitstellungen von Cohere erheblich. Durch die Kombination eines längeren Kontextfensters mit günstigeren Preisen erschließt Command-R RAG-Anwendungsfälle, bei denen zusätzlicher Kontext die Leistung erheblich verbessern kann.

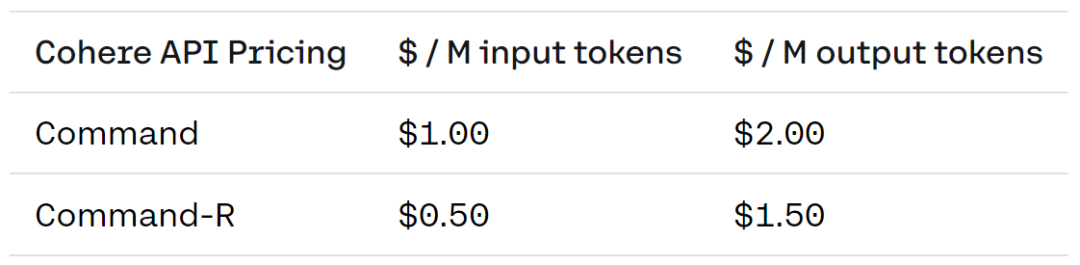

Die konkreten Preise sind wie folgt: Die Command-Version kostet 1 USD für 1 Million Eingabe-Tokens und 2 USD für 1 Million Ausgabe-Tokens; die Command-R-Version kostet 0,5 USD für 1 Million Eingabe-Tokens und 1,5 USD USD für 1 Million Ausgabetoken.

Bald wird Cohere auch einen kurzen technischen Bericht veröffentlichen, um weitere Modelldetails zu zeigen.

Blog-Adresse: https://txt.cohere.com/command-r/

Das obige ist der detaillierte Inhalt vonMit 35 Milliarden Parametern und offenen Gewichten brachte der Autor von Transformer nach der Gründung seines eigenen Unternehmens ein neues großes Modell auf den Markt.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was ist ein KI-Trainingscluster?

- Welche Datentypen gibt es?

- Welche Anwendungen gibt es von Big Data im Leben?

- Musk kündigt an, dass er Microsoft wegen der Verwendung von Twitter-Daten zum Trainieren künstlicher Intelligenz verklagen wird

- Yunshenchen und Shengteng CANN arbeiten zusammen, um ein ROS-Trainingslager für die Entwicklung vierbeiniger Roboterhunde zu eröffnen