Heim >Technologie-Peripheriegeräte >KI >Der Trainingseffekt von 40 % Rechenleistung ist vergleichbar mit dem von GPT-4, und die neuen Erfolge des gemeinsamen groß angelegten Modellunternehmertums von DeepMind wurden gemessen

Der Trainingseffekt von 40 % Rechenleistung ist vergleichbar mit dem von GPT-4, und die neuen Erfolge des gemeinsamen groß angelegten Modellunternehmertums von DeepMind wurden gemessen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-03-08 15:58:21591Durchsuche

Im großen Modellwettbewerb tauchte ein weiteres dunkles Pferd auf –

Inflection-2.5, erstellt von DeepMind und Mustafa Suleymans großem Modell-Startup.

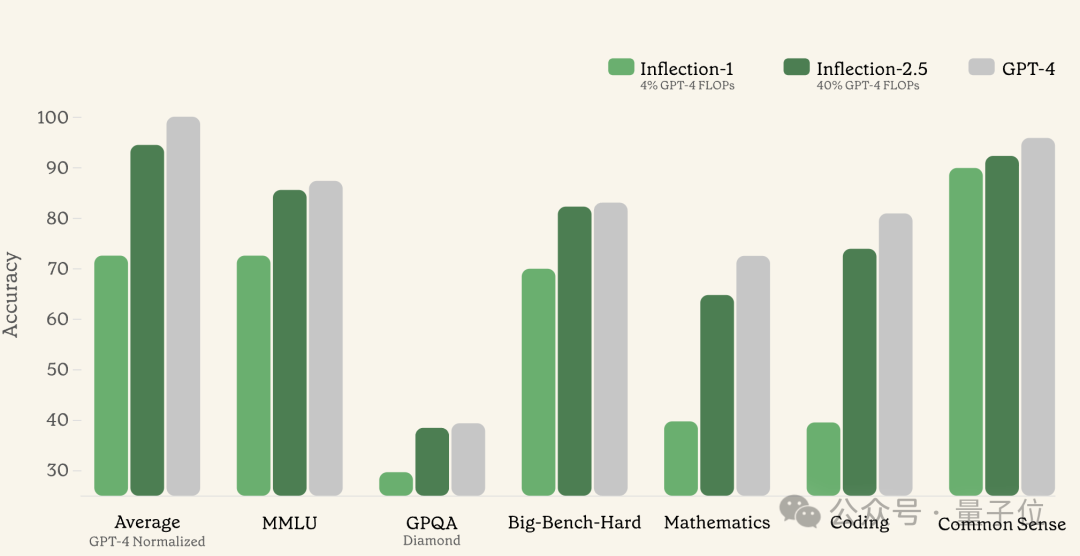

Mit nur 40 % der Rechenressourcen für das Training übersteigt die Leistung 90 % von GPT-4 und ist besonders gut in Codierung und Mathematik.

Das frühe Inflection-Modell verbrauchte während des Trainings nur 4 % der Rechenressourcen und erreichte 72 % der Leistung von GPT-4.

Basierend auf dem Inflection-Modell hat das Unternehmen außerdem den webbasierten Konversationsroboter Pi auf den Markt gebracht, der auf „hohe emotionale Intelligenz“ und „Personalisierung“ setzt und auch Chinesisch unterstützt.

Seit seiner Geburt hat Pi 1 Million täglich aktive Nutzer erreicht, insgesamt wurden 4 Milliarden Nachrichten generiert und die durchschnittliche Konversationslänge hat 33 Minuten erreicht.

Mit diesem Upgrade des Basismodells läutete Pi auch seine neue Version ein.

Bilder

Bilder

Ob Inflection oder Pi so stark ist, die Qubits haben einige tatsächliche Messungen durchgeführt.

Sie können es verwenden, ohne sich anzumelden.

Öffnen Sie die Pi-Seite und Sie sehen eine so minimalistische Benutzeroberfläche. Sie können direkt auf Weiter klicken, ohne sich anzumelden.

Bilder

Bilder

Geben Sie nach Weiter mehrmals hintereinander ein, wie Pi uns anrufen soll.

Bilder

Bilder

Wählen Sie danach die Stimme und die empfohlenen Themen aus, überspringen Sie sie einfach und rufen Sie dann die formelle Chat-Oberfläche auf.

Bilder

Bilder

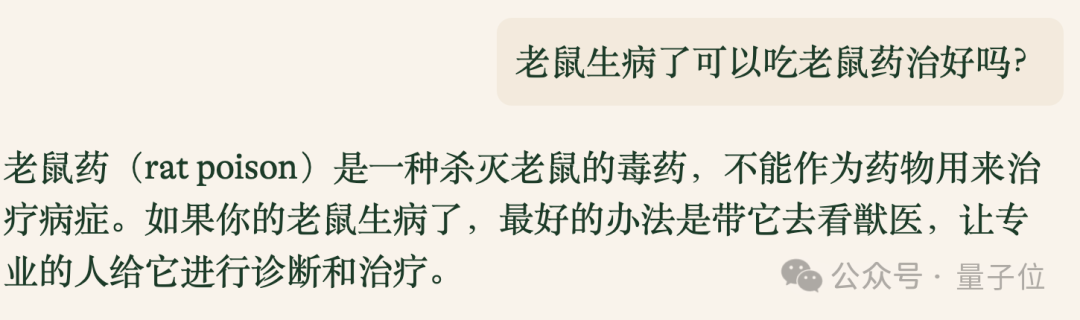

Ein einfacher Test hat ergeben, dass Pi den chinesischen Dialog unterstützt. Wenn dies der Fall ist, dann richten Sie zuerst den Benchmark für geistig Behinderte ein.

Die erste Frage: Kann eine kranke Maus durch die Einnahme von Rattengift geheilt werden? Pi hat sie erfolgreich beantwortet.

Bilder

Bilder

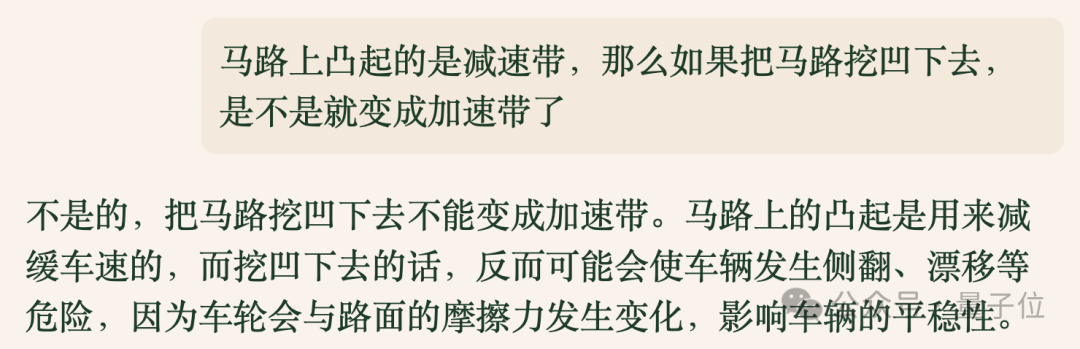

Noch eine „Falle“-Frage, aber diesmal bin ich trotzdem nicht darauf reingefallen.

Bilder

Bilder

Nach den beiden Fragen schien es, dass ich ein gewisses Chinesischverständnis hatte, obwohl es keinen dramatischen Effekt gab.

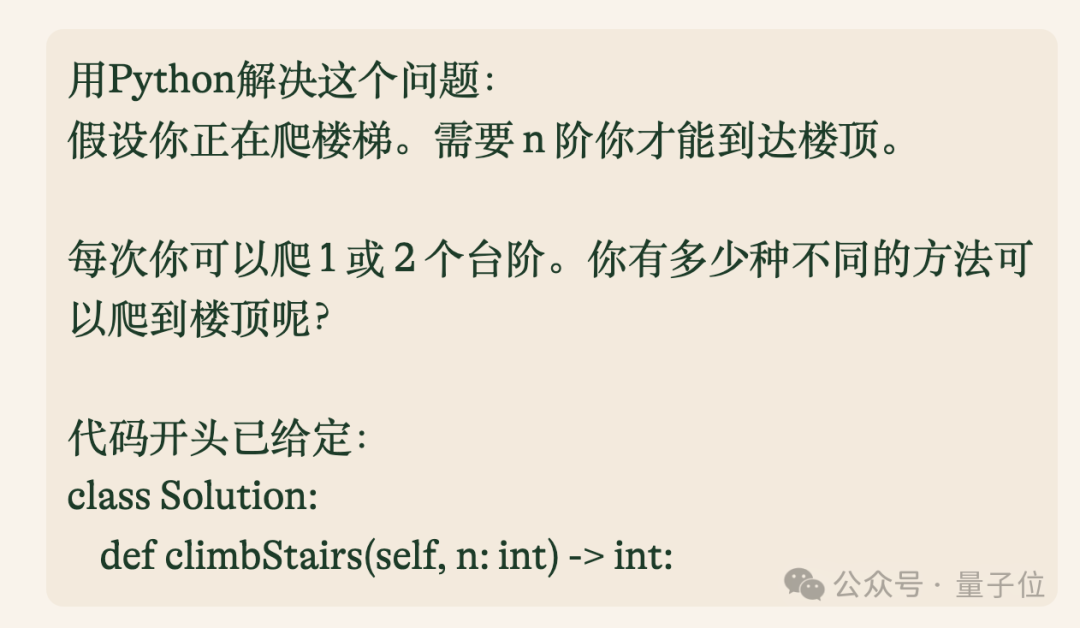

Als Nächstes konzentrieren wir uns auf die Mathematik- und Programmierfähigkeiten, die der Beamte als „besonders gut“ bezeichnet.

Die erste ist eine Programmierfrage, bei der es um dynamische Programmierung geht.

Bilder

Bilder

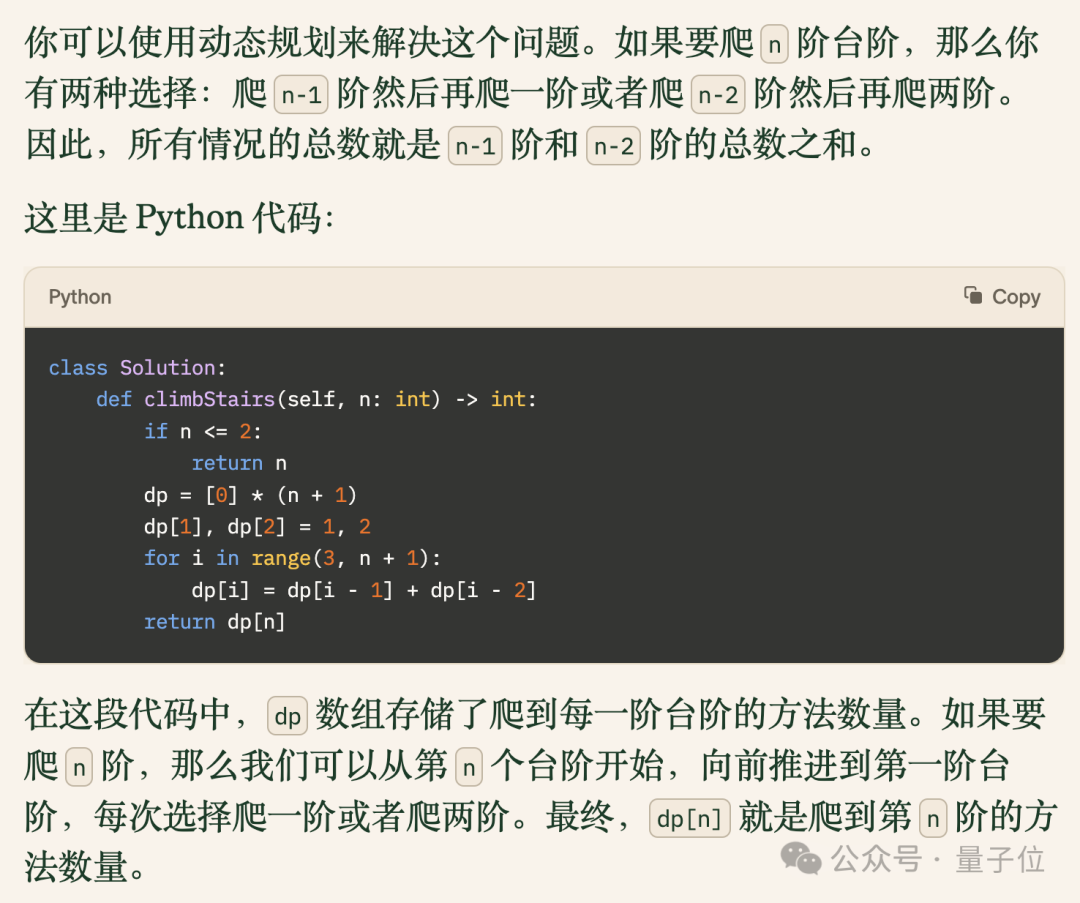

Der von Pi bereitgestellte Code löst dieses Problem erfolgreich und enthält klare Erklärungen.

Bilder

Bilder

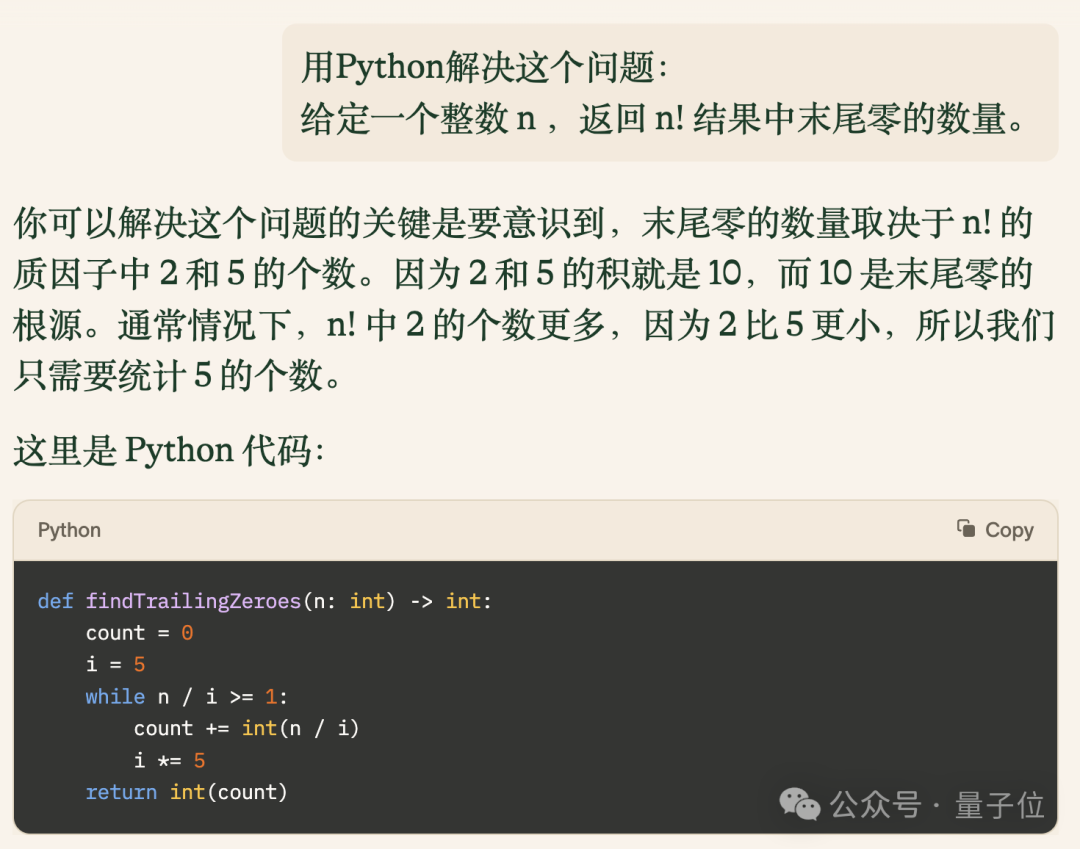

Als nächstes erhöhen wir den Schwierigkeitsgrad und analysieren, wie viele Nullen am Ende der Fakultät einer Zahl stehen.

Bilder

Bilder

Der von Pi bereitgestellte Code ist nicht nur korrekt, sondern auch prägnant und effizient und läuft schneller als 73,8 % der Benutzer von LeetCode.

Bilder

Bilder

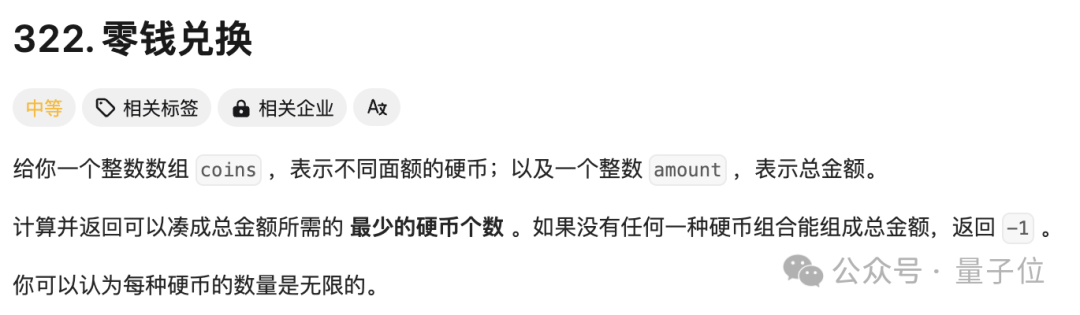

Zum Schluss erhöhen wir den Schwierigkeitsgrad und beenden den Code-Teil des Tests mit einer Frage mit einer Erfolgsquote von 47,5 %.

Bilder

Bilder

Nachdem wir den Code gelesen haben, testen wir Pis mathematische Fähigkeiten und lassen ihn Fragen zu Ableitungen stellen:

Finden Sie den Extrempunkt der Funktion f(x)=x³+2x²-1

Die Antwort ist völlig richtig und sehr detailliert.

Natürlich ist logisches Denken unerlässlich, wenn man gut in Mathematik sein will. Deshalb haben wir zusätzlich zu den regulären Mathematikfragen auch eine klassische Frage verwendet, um Pis logisches Denken zu testen, und die Ergebnisse waren nicht schlecht.

Anhand der Leistung von Pi können wir sehen, dass das Inflection-2.5-Modell dahinter tatsächlich bemerkenswert ist.

Nach den von ihm selbst veröffentlichten offiziellen Testdaten zu urteilen, liegt die Leistung von Inflection-2.5 hinsichtlich der Gesamtfähigkeiten und einzelner Unterpunkte dicht hinter GPT-4.

Am Beispiel von Mathematik und Codierung hat Inflection-2.5 in Tests wie MATH und HumanEval im Vergleich zu Version 1.0 einen deutlichen Sprung gemacht.

Zusätzlich zu diesen herkömmlichen Datensätzen hat Inflection auch die Mathematiktestfragen der ungarischen Hochschulaufnahmeprüfung und den GRE-Physiktest herausgefordert, und die Ergebnisse waren fast gleichauf mit GPT-4.

Noch schwieriger ist es, dass jemand einen BIG-Bench-Datensatz mit Problemen erstellt hat, die bei großen Modellen schwer zu verstehen sind, und Inflection-2.5 die harte Teilmenge davon in Frage gestellt hat, und der Unterschied zwischen den Ergebnissen und GPT-4 ist geringer als ein Punkt. .

Was für ein Unternehmen steckt also hinter Inflection-2.5?

DeepMind Lianchuang Large Model Venture

Dieses Unternehmen heißt Inflection AI. Es wurde 2022 von DeepMind Lianchuang Mustafa Suleyman gegründet. Derzeit gibt es mehr als 70 Personen.

Ebenfalls von DeepMind gibt es die leitende Forscherin Karen Simonyan, die jetzt leitende Wissenschaftlerin von Inflection AI ist.

Darüber hinaus war LinkedIn-Mitbegründer Reid Hoffman auch an der Gründung von Inflection AI beteiligt.

Seit seiner Gründung hat Inflection AI insgesamt 1,5 Milliarden US-Dollar an Finanzmitteln von Giganten wie NVIDIA, Microsoft und Bill Gates erhalten.

Derzeit ist Pi auf Inflection-Basis immer noch kostenlos, aber CEO Suleyman sagte auch, dass es unrealistisch sei, Liebe ständig zur Stromerzeugung zu nutzen, und dass auf lange Sicht immer noch Gebühren anfallen würden.

Freunde, die es erleben möchten, müssen sich vielleicht beeilen~

Portal: https://pi.ai

Das obige ist der detaillierte Inhalt vonDer Trainingseffekt von 40 % Rechenleistung ist vergleichbar mit dem von GPT-4, und die neuen Erfolge des gemeinsamen groß angelegten Modellunternehmertums von DeepMind wurden gemessen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- So importieren Sie das Layout eines CAD-Modells

- Schockiert! Nach 70.000 Trainingsstunden lernte das Modell von OpenAI, Holz in „Minecraft' zu planen

- Metaforscher unternehmen einen neuen Versuch der KI: Sie bringen Robotern das physische Navigieren bei, ohne Karten oder Training

- So verwenden Sie PyTorch für das Training neuronaler Netzwerke

- Die internen Tests von Kimi Chat beginnen, Volcano Engine bietet Beschleunigungslösungen und unterstützt das Training und die Inferenz des Moonshot AI-Großmodelldienstes