Heim >Technologie-Peripheriegeräte >KI >Die internen Tests von Kimi Chat beginnen, Volcano Engine bietet Beschleunigungslösungen und unterstützt das Training und die Inferenz des Moonshot AI-Großmodelldienstes

Die internen Tests von Kimi Chat beginnen, Volcano Engine bietet Beschleunigungslösungen und unterstützt das Training und die Inferenz des Moonshot AI-Großmodelldienstes

- PHPznach vorne

- 2023-10-11 13:45:082018Durchsuche

Am 9. Oktober gab Beijing Dark Side of the Moon Technology Co., Ltd. (Moonshot AI) einen Durchbruch im Bereich „Langtext“ bekannt und brachte Kimi Chat auf den Markt, das erste intelligente Assistentenprodukt, das die Eingabe von 200.000 chinesischen Schriftzeichen unterstützt. Dies ist die längste Kontexteingabelänge, die von einem großen Modelldienst unterstützt werden kann, der kommerziell auf dem Weltmarkt genutzt werden kann, was Moonshot AIs weltweit führendes Niveau in dieser wichtigen Technologie markiert.

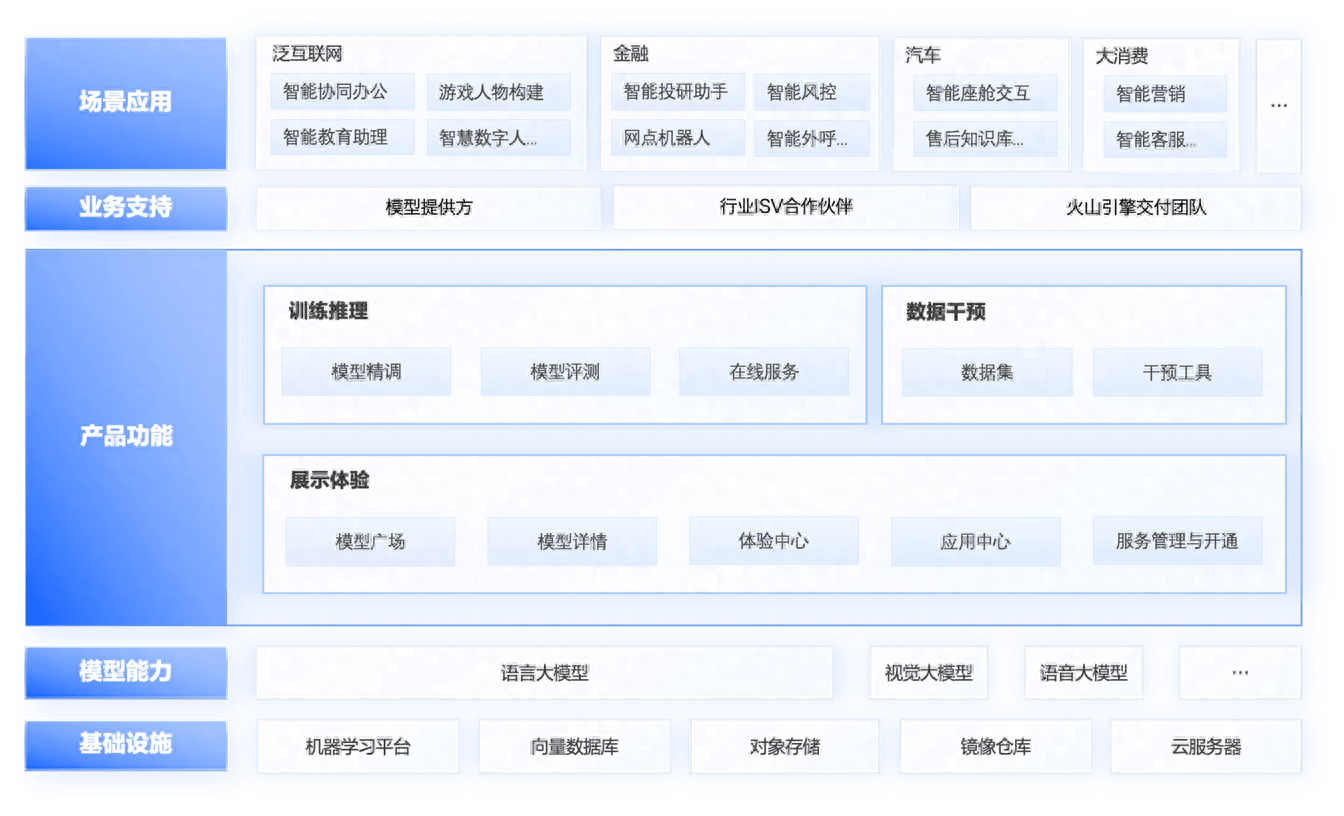

Die Volcano Engine arbeitet eng mit Moonshot AI zusammen, um ihr ausschließlich hochstabile und kostengünstige KI-Trainings- und Inferenzbeschleunigungslösungen bereitzustellen. Die beiden Parteien führen gemeinsam Technologieforschung und -entwicklung durch, um gemeinsam die Anwendung großer Sprachmodelle in der Vertikalen voranzutreiben Felder und allgemeine Szenarien. Gleichzeitig wird Kimi Chat bald der Serviceplattform für große Modelle von Volcano Engine – Volcano Ark – beitreten. Beide Parteien werden Unternehmen und Verbrauchern weiterhin umfassendere KI-Anwendungen im Bereich der Ökologie großer Modelle anbieten.

Im Vergleich zu den aktuellen großen Modelldiensten auf dem Markt, die auf Englisch geschult sind, verfügt Kimi Chat über starke Mehrsprachigkeitsfunktionen. Beispielsweise bietet Kimi Chat erhebliche Vorteile auf Chinesisch und der tatsächliche Nutzungseffekt kann den Kontext von etwa 200.000 unterstützen Chinesische Schriftzeichen. 2,5-mal so viel wie Claude-100k von Anthropic (tatsächlich etwa 80.000 Wörter gemessen) und 8-mal so viel wie GPT-4-32k von OpenAI (tatsächlich etwa 25.000 Wörter gemessen). Gleichzeitig kann Kimi Chat durch innovative Netzwerkstruktur und technische Optimierung einen verlustfreien Fernaufmerksamkeitsmechanismus unter Hunderten von Milliarden Parametern erreichen und ist nicht auf „Abkürzungs“-Lösungen wie Schiebefenster, Downsampling und kleine Modelle angewiesen kann die Leistung erheblich beeinträchtigen.

In einem früheren Interview sagte Yang Zhilin, der Gründer von Moonshot AI, einmal, dass durch die verlustfreie Komprimierung großer Datenmengen ein hohes Maß an Intelligenz erreicht werden kann, sei es Text, Sprache oder Video. Die Obergrenze der Fähigkeiten eines großen Modells (d. h. das verlustfreie Komprimierungsverhältnis) wird sowohl durch die Einzelschrittfähigkeit als auch durch die Anzahl der ausgeführten Schritte bestimmt. Ersteres hängt von der Anzahl der Parameter ab, und letzteres bezieht sich auf die Kontextlänge

Bewältigung der Herausforderungen bei der Implementierung großer Sprachmodelle und Förderung der Implementierung von IndustrieanwendungenMoonshot AI ist davon überzeugt, dass eine Erhöhung der Kontextlänge neue Entwicklungsmöglichkeiten für groß angelegte Modellanwendungen eröffnen kann, wodurch es von der LLM-Ära in die Long-LLM-Ära (LLLM) eintreten und eine genaue Anpassung an verschiedene Branchen erreichen kann. Bei der Erforschung effektiver Methoden zur Verarbeitung langer Textszenen müssen Großmodellanwendungen kontinuierlich nach neuen Mitteln suchen, um das Problem der Modellillusion zu lösen und die Steuerbarkeit generierter Inhalte zu verbessern, während gleichzeitig nach neuen Wegen für die Entwicklung personalisierter Großmodellfunktionen gesucht wird . Im Entwicklungsprozess großer Sprachmodelle müssen mehrere Schwellenwerte überwunden werden, z. B. die Ausweitung der Anforderungen an Rechenressourcen, die Instabilität des Task-Engineerings, hohe Projektkosten, Sicherheit und Vertrauen usw., um die Trainingseffizienz zu verbessern Modell

Um die oben genannten Probleme zu lösen, hat sich Moonshot AI mit Volcano Engine zusammengetan, um die KI-Technologie zu innovieren und AGI-Übungen auf der Volcano Engine-Plattform für maschinelles Lernen veMLP durchzuführen. Moonshot AI nutzt den GPU-Ressourcenpool voll aus und basiert auf groß angelegten Vortrainingsmodellen, um ein normales und stabiles Training auf einer Skala von Tausenden von Kalorien pro Tag zu erreichen. Innerhalb von sechs Monaten trainierte Kimi Chat mit einem großen Sprachmodell Eine Skala von Hunderten von Milliarden Parametern, die professionelles Szenenschreiben und ultralange Texte ermöglicht, kann komplexe Szenarien wie Analysen, personalisierte Dialoge mit ultralangem Gedächtnis und wissensbasierte Fragen und Antworten auf der Grundlage einer großen Anzahl von Dokumenten verstehen in vielen namhaften Unternehmen erfolgreich eingesetzt.

Moonshot AI-Mitgründer Zhou beide Parteien Wir werden in Bereichen wie der KI-Computing-Infrastruktur und der Erweiterung von Anwendungsszenarien weiter zusammenarbeiten, um gemeinsam die Entwicklung der Technologie der künstlichen Intelligenz voranzutreiben und den Benutzern ein stabiles, effizientes und intelligentes Serviceerlebnis zu bieten.“

Durch den Einsatz der maschinellen Lernplattform Volcano Engine kann das Training großer Modelle stabiler und schneller erfolgen

Die Volcano Engine bietet äußerst stabile und kostengünstige KI-Trainings- und Inferenzbeschleunigungslösungen für die Konstruktion und das Training großer Modelle. Die Plattform für maschinelles Lernen veMLP wird seit langem von großen Anwenderunternehmen wie Douyin verbessert und hat sich zu einem etablierten Unternehmen entwickelt Full-Stack-KI-Entwicklungsoptimierungslösungen und Best Practices wie Lösungen, Selbstheilung von Aufgabenfehlern und experimentelle Beobachtbarkeit bieten effiziente, stabile, sichere und gegenseitig vertrauenswürdige KI-Algorithmusentwicklungs- und Iterationsdienste aus einer Hand und beschleunigen das Training großer Modelle , stabiler und kostengünstiger. Moonshot AI basiert auf der ultragroß angelegten KI-Trainings- und Inferenzbeschleunigungslösung der Volcano Engine und hilft dem Team dabei, schnell, stabil und kostengünstig eine kontinuierliche Trainingsiteration, Feinabstimmung und Inferenz großer Sprachmodelle zu erreichen.

1. Skalierte Planung von IaaS-Rechenleistung und Speicherressourcen

Erstellen Sie einen Hochleistungs-Computing-Cluster, um ein großes Modelltraining auf 10.000-ka-Ebene, ein Verzögerungsnetzwerk auf Mikrosekundenebene und elastisches Computing zu erreichen. Mit der vePFS+TOS-Lösung für die Hot- und Cold-Tier-Beschleunigung können Sie 70 % der Rechenleistungskosten einsparen Hoher Durchsatz an Trainingsdaten bei gleichzeitiger Reduzierung der Gesamtspeicherkosten um 65 %. Für das Lese- und Schreibmuster des Dateisystems großer Modelle haben wir gemeinsam ein dediziertes Datei-Caching-System entwickelt, um die Grafikkartenauslastung erheblich zu verbessern.

2. Stellen Sie die Stabilität des PaaS-Computing-Clusters sicher

Optimieren Sie die Stabilität sehr großer Trainingscluster, bieten Sie eine Optimierung der Selbstheilung von Hardwarefehlern und unabhängige Diagnosefunktionen, ermöglichen Sie Benutzeraufgaben, das Training schnell erneut zu versuchen und fortzusetzen, erreichen Sie ein stabiles Training auf monatlicher Ebene und reduzieren Sie RingAllReduce durch Optimierung der Kommunikationsaffinität mehrerer Maschinen Schulungsaufgaben Kommunizieren Sie über Schalter hinweg.

3. Experimentieren Sie mit hoher Beobachtbarkeit

Experimentmanagement für mehrere Trainingsaufgaben und Vergleich der Trainingsergebnisse durch Visualisierung, um das Modell zu bestimmen, das iterativ gestartet werden soll. Verwenden Sie vollständige Überwachungsprotokolle, um das Unternehmen bei der Optimierung von 3D-Parallelparametern zu unterstützen und bei der Lokalisierung von Trainingsfehlern zu helfen

Sicherheits- und gegenseitige Vertrauenslösung für große Modeldienste

Kombiniert Trusted Privacy Computing mit LLM-Anwendungen, um Sicherheits-Sandbox-Funktionen bereitzustellen und die Kontrolle der Entwicklerberechtigungen zu verbessern. Die Volcano Engine arbeitet auch mit Moonshot AI zusammen, um einen Workflow zu entwerfen, der für die Entwicklungsgewohnheiten großer Modelle geeignet ist und einen hierarchischen Zugriff auf Daten und Datensicherheit gewährleistet und gleichzeitig die Arbeitseffizienz gewährleistet.

Wu Di, Leiter des intelligenten Algorithmus von Volcano Engine, sagte: „Volcano Engine hat immer an einer kooperativen Haltung festgehalten, die sich auf Technologie, die Stärkung von Partnern und die Symbiose von Werten konzentriert. Moonshot AI verfügt über das fortschrittlichste F&E-Team für große Modelle in der Welt.“ China verfügt über umfassende Kenntnisse und Anwendungserfahrungen der KI-Technologie. Die Zusammenarbeit zwischen den beiden Parteien wird Unternehmen und Verbrauchern umfassendere KI-Anwendungen im Bereich der ökologischen Multimodell-Dienstleistungen bieten.“

Derzeit hat Volcano Ark große Modelle von vielen KI-Technologieunternehmen und wissenschaftlichen Forschungsinstituten wie Zhipu AI, Minimax und ByteDance Skylark angezogen. Kimi Chat, der große Modeldienst von Moonshot AI, kommt ebenfalls zu Volcano Ark. Volcano Engine wird mit herausragenden inländischen großen Modelldienstleistern zusammenarbeiten, um eine umfassende Palette von Funktionen und Dienstleistungen wie Modellschulung, Inferenz, Bewertung und Feinabstimmung bereitzustellen, um allen Lebensbereichen dabei zu helfen, die Entwicklung von KI zu beschleunigen. Alle Unternehmen sind herzlich eingeladen, große Modelle in Volcano Ark zu erleben. Volcano Ark ist bereit, gemeinsam mit allen zu wachsen!

Das obige ist der detaillierte Inhalt vonDie internen Tests von Kimi Chat beginnen, Volcano Engine bietet Beschleunigungslösungen und unterstützt das Training und die Inferenz des Moonshot AI-Großmodelldienstes. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr