Heute hat Google die Einführung von Gemini 1.5 angekündigt.

Gemini 1.5 wurde auf der Grundlage der Forschung und technischen Innovationen von Google bei grundlegenden Modellen und Infrastruktur entwickelt. Diese Version führt eine neue Mix of Experts (MoE)-Architektur ein, um die Effizienz der Schulung und Bereitstellung von Gemini 1.5 zu verbessern.

Was Google herausgebracht hat, ist die erste Version von Gemini 1.5 für frühe Tests, nämlich Gemini 1.5 Pro. Es handelt sich um ein mittelgroßes multimodales Modell, das für eine Vielzahl von Aufgaben skaliert und optimiert ist. Im Vergleich zu Googles größtem Modell, 1.0 Ultra, bietet Gemini 1.5 Pro ein ähnliches Leistungsniveau und führt bahnbrechende experimentelle Funktionen ein, um lange Kontexte besser zu verstehen.

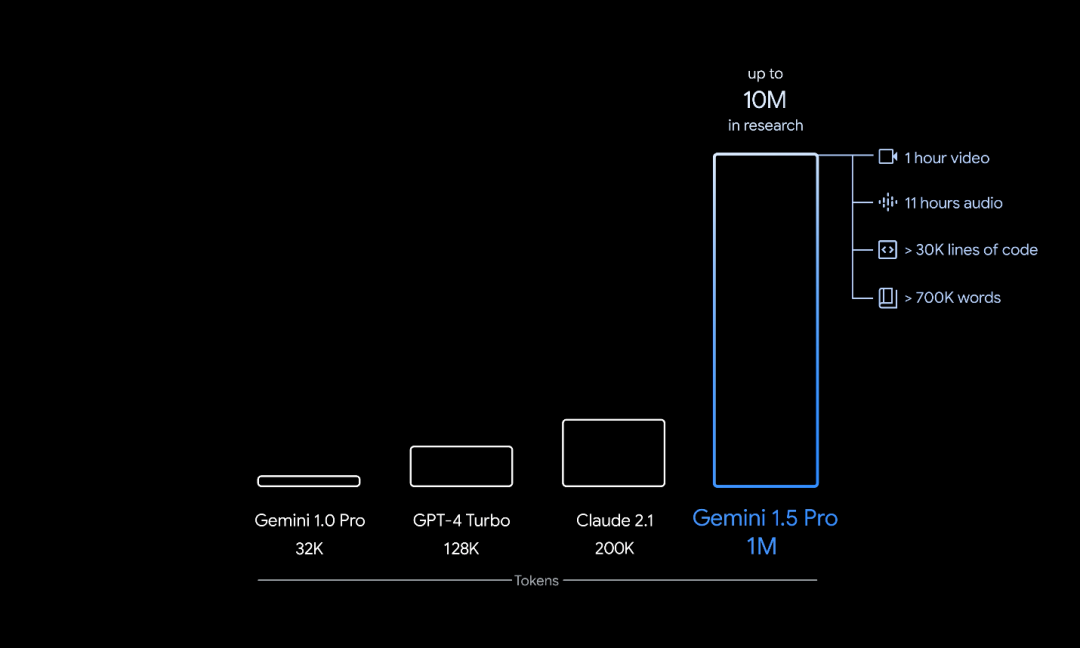

Die Anzahl der Token-Kontextfenster für Gemini 1.5 Pro beträgt 128.000. Allerdings bietet Google ab heute einer begrenzten Anzahl von Entwicklern und Unternehmenskunden eine private Vorschau von AI Studio und Vertex AI an, die es ihnen ermöglicht, es in einem kontextbezogenen Fenster mit bis zu 1.000.000 Token auszuprobieren. Darüber hinaus hat Google mehrere Optimierungen vorgenommen, die darauf abzielen, die Latenz zu verbessern, den Rechenaufwand zu reduzieren und das Benutzererlebnis zu verbessern.

Google CEO Sundar Pichai und Google DeepMind CEO Demis Hassabis gaben eine besondere Einführung in das neue Modell.

的 Die Kontextlänge des führenden Basismodells

Hocheffiziente Architektur Gemini 1.5 basiert auf Googles führender Forschung zur Transformer- und MOE-Architektur. Der traditionelle Transformer fungiert als ein großes neuronales Netzwerk, während das MoE-Modell in kleinere „Experten“-Neuronale Netzwerke unterteilt ist. Abhängig von der Art der gegebenen Eingabe lernt das MoE-Modell, selektiv nur die relevantesten Expertenpfade in seinem neuronalen Netzwerk zu aktivieren. Diese Spezialisierung erhöht die Effizienz des Modells erheblich. Google war ein früher Anwender und Pionier der Deep-Learning-MoE-Technologie durch Forschung zu Sparse-Gated-MoE, GShard-Transformer, Switch-Transformer, M4 und mehr.

Die neuesten Innovationen von Google in der Modellarchitektur ermöglichen es Gemini 1.5, komplexe Aufgaben schneller zu erlernen und die Qualität aufrechtzuerhalten, während gleichzeitig effizienter trainiert und bedient wird. Diese Effizienzsteigerungen helfen Google-Teams, schneller als je zuvor zu iterieren, zu trainieren und fortgeschrittenere Versionen von Gemini bereitzustellen, und arbeiten an weiteren Optimierungen.

Längerer Kontext, mehr nützliche FunktionenDas „Kontextfenster“ des Modells der künstlichen Intelligenz besteht aus Token, die die Bausteine für die Verarbeitung von Informationen sind. Ein Token kann ein ganzer oder untergeordneter Teil von Text, Bild, Video, Audio oder Code sein. Je größer das Kontextfenster des Modells ist, desto mehr Informationen kann es in einer bestimmten Eingabeaufforderung empfangen und verarbeiten, wodurch seine Ausgabe konsistenter, relevanter und nützlicher wird. Durch eine Reihe von Innovationen im Bereich maschinelles Lernen hat Google die Kontextfensterkapazität von 1.5 Pro deutlich über die anfänglichen 32.000 Token von Gemini 1.0 hinaus erhöht. Das große Modell kann jetzt mit bis zu 1 Million Token in Produktion gehen.

Das bedeutet, dass der 1.5 Pro viele Informationen auf einmal verarbeiten kann, darunter 1 Stunde Video, 11 Stunden Audio, über 30.000 Codezeilen oder eine Codebasis von über 700.000 Wörtern. Bei Googles Recherchen wurden zudem bis zu 10 Millionen Token erfolgreich getestet.

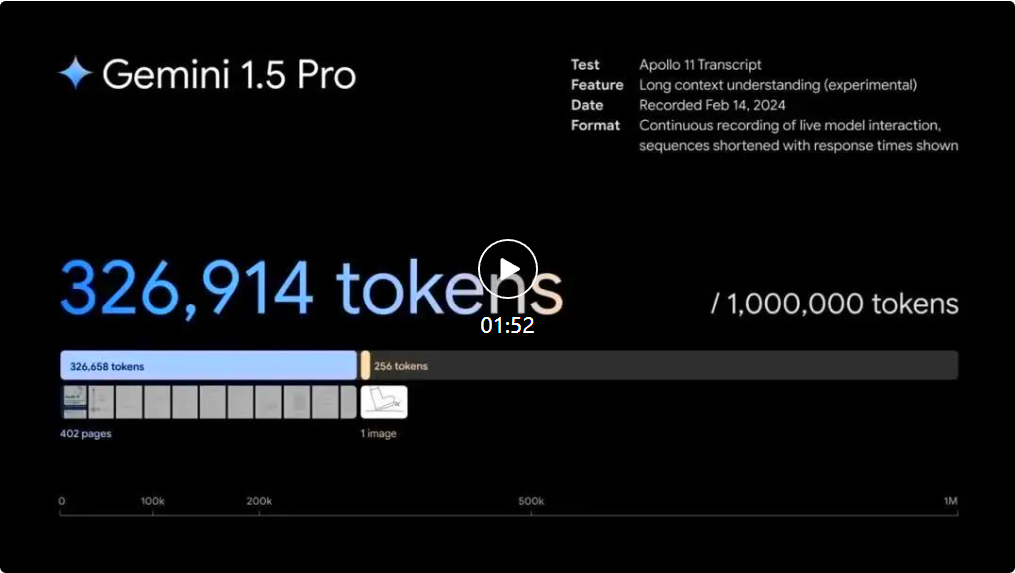

Komplexe Argumentation bei großen Informationsmengen1.5 Pro kann große Mengen an Inhalten innerhalb einer bestimmten Eingabeaufforderung nahtlos analysieren, klassifizieren und zusammenfassen. Wenn man beispielsweise ein 402-seitiges Transkript der Mondlandemission Apollo 11 erhält, könnte man über Dialoge, Ereignisse und Details im gesamten Dokument nachdenken. Gemini 1.5 Pro, um die merkwürdigen Details in den 402 Seiten mit Aufzeichnungen der Mondlandemission Apollo 11 zu verstehen, darüber nachzudenken und sie zu identifizieren.

Besseres Verständnis und Argumentation über verschiedene Modalitäten hinweg 1.5 Pro kann hochkomplexe Verständnis- und Argumentationsaufgaben für verschiedene Modalitäten, einschließlich Video, durchführen. Wenn das Modell beispielsweise einen 44-minütigen Stummfilm von Buster Keaton erhielt, konnte es verschiedene Handlungspunkte und Ereignisse genau analysieren und sogar über kleine Details im Film nachdenken, die leicht übersehen wurden. Gemini 1.5 Pro kann die 402-seitige Aufzeichnung der Mondlandemission Apollo 11 verstehen, darüber nachdenken und merkwürdige Details identifizieren.

Besseres Verständnis und Argumentation über verschiedene Modalitäten hinweg 1.5 Pro kann hochkomplexe Verständnis- und Argumentationsaufgaben für verschiedene Modalitäten, einschließlich Video, durchführen. Wenn das Modell beispielsweise einen 44-minütigen Stummfilm von Buster Keaton erhielt, konnte es verschiedene Handlungspunkte und Ereignisse genau analysieren und sogar über kleine Details im Film nachdenken, die leicht übersehen wurden. Gemini 1.5 Pro kann die 402-seitigen Aufzeichnungen der Mondlandemission Apollo 11 verstehen, darüber nachdenken und merkwürdige Details identifizieren.

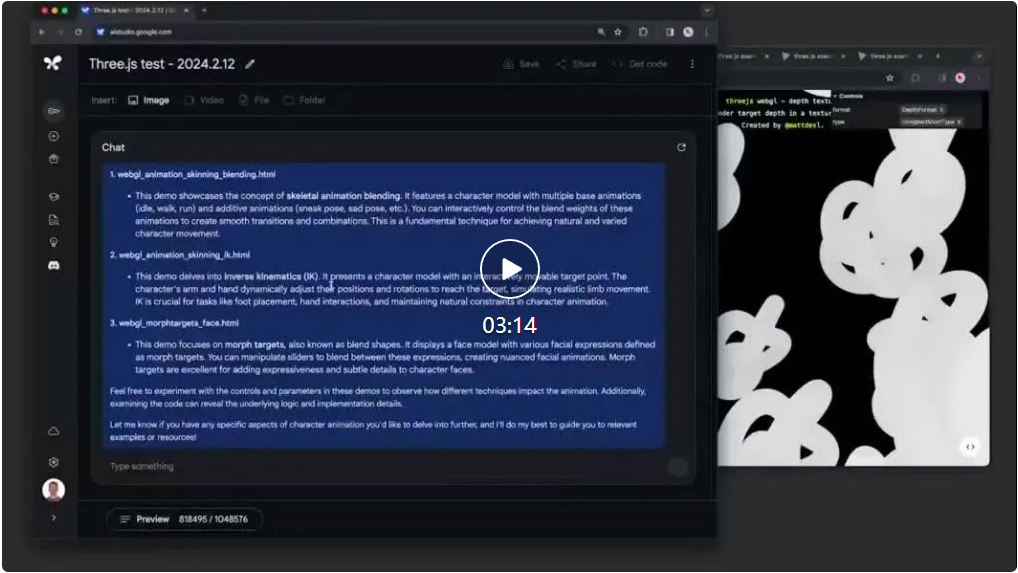

Besseres Verständnis und Argumentation über verschiedene Modalitäten hinweg 1.5 Pro kann hochkomplexe Verständnis- und Argumentationsaufgaben für verschiedene Modalitäten, einschließlich Video, durchführen. Wenn das Modell beispielsweise einen 44-minütigen Stummfilm von Buster Keaton erhielt, konnte es verschiedene Handlungspunkte und Ereignisse genau analysieren und sogar über kleine Details im Film nachdenken, die leicht übersehen wurden. Anhand einfacher Strichzeichnungen als Referenzmaterial für reale Objekte konnte Gemini 1.5 Pro 44 Minuten Szenen aus einem Stummfilm von Buster Keaton identifizieren. Verwenden Sie längere Codeblöcke, um verwandte Probleme zu lösen. 1.5 Pro kann relevantere Problemlösungsaufgaben über längere Codeblöcke hinweg ausführen. Wenn Hinweise zu mehr als 100.000 Codezeilen gegeben werden, kann es anhand von Beispielen besser argumentieren, nützliche Änderungen vorschlagen und erklären, wie verschiedene Teile des Codes funktionieren. . Gemini 1.5 Pro kann 100.000 Codezeilen verarbeiten und bietet nützliche Lösungen, Änderungen und Anmerkungen.  Verbesserte Leistung. Umfassendes Bedienfeld für Text, Code, Bild, Audio und Videoauswertung. Beim Testen Auf Windows Phone übertraf 1.5 Pro 1.0 Pro bei 87 % der Benchmarks, die zur Entwicklung großer Sprachmodelle (LLMs) verwendet wurden. Im Vergleich zum 1.0 Ultra in den gleichen Benchmarks schneidet es ungefähr ähnlich ab.

Verbesserte Leistung. Umfassendes Bedienfeld für Text, Code, Bild, Audio und Videoauswertung. Beim Testen Auf Windows Phone übertraf 1.5 Pro 1.0 Pro bei 87 % der Benchmarks, die zur Entwicklung großer Sprachmodelle (LLMs) verwendet wurden. Im Vergleich zum 1.0 Ultra in den gleichen Benchmarks schneidet es ungefähr ähnlich ab.

Auch wenn das Kontextfenster größer wird, behält Gemini 1.5 Pro ein hohes Leistungsniveau bei. Bei der NIAH-Bewertung wurde ein kleiner Textabschnitt, der eine bestimmte Tatsache oder Aussage enthielt, absichtlich in einen sehr langen Textblock eingefügt. 1.5 Pro fand den eingebetteten Text in 99 % der Fälle im Datenblock wie folgt: nur 100 Zehntausend Token. Gemini 1.5 Pro demonstriert außerdem beeindruckende Fähigkeiten zum „Lernen im Kontext“, was bedeutet, dass es neue Fähigkeiten aus Informationen erlernen kann, die in langen Eingabeaufforderungen gegeben werden, ohne dass zusätzliche Feinabstimmungen erforderlich sind. Google hat diese Fähigkeit im MTOB-Benchmark (Translation from One Book) getestet, der die Fähigkeit des Modells zeigt, aus nie zuvor gesehenen Informationen zu lernen. Wenn man ihm ein Grammatikhandbuch für Kalamang gibt, eine Sprache mit weniger als 200 Sprechern weltweit, kann das Modell lernen, Englisch ins Kalamang zu übersetzen, und zwar auf einem ähnlichen Niveau wie ein Mensch, der den gleichen Inhalt lernt. Da das lange Kontextfenster von 1.5 Pro ein Novum für ein großes Modell ist, entwickelt Google ständig neue Auswertungen und Benchmarks, um seine neuartigen Funktionen zu testen. Weitere Einzelheiten finden Sie im technischen Bericht zum Gemini 1.5 Pro. Adresse des technischen Berichts: https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdfErstellen und experimentieren Sie mit Gemini-Modellen

Google engagiert sich dafür Bringen Sie jede neue Generation von Gemini-Modellen verantwortungsbewusst Milliarden von Menschen, Entwicklern und Unternehmensbenutzern auf der ganzen Welt näher.

Ab heute stellt Google Entwicklern und Unternehmenskunden die Vorschau von 1.5 Pro über AI Studio und Vertex AI zur Verfügung. Wenn das Modell in Zukunft auf breiter Basis veröffentlicht wird, wird Google 1.5 Pro mit einem standardmäßigen 128.000-Token-Kontextfenster starten. Google plant bald die Einführung von Preisstufen, beginnend mit den standardmäßigen 128.000 Kontextfenstern und einer Skalierung auf bis zu 1 Million Token, wenn das Modell verbessert wird. Frühe Tester können während des Tests 1 Million Token-Kontextfenster kostenlos ausprobieren, und erhebliche Geschwindigkeitsverbesserungen sind in Kürze verfügbar. Entwickler, die 1.5 Pro testen möchten, können sich jetzt in AI Studio registrieren, während Unternehmenskunden ihr Vertex AI-Kontoteam kontaktieren können. Referenzlink: https://blog.google/technology/ai/google-gemini-next-generation-model-february-2024/#sundar-note

Das obige ist der detaillierte Inhalt vonGoogle Gemini 1.5 wird schnell veröffentlicht: MoE-Architektur, 1 Million Kontexte. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!