Heim >Technologie-Peripheriegeräte >KI >Meta ist ein multisensorisches Open-Source-Modell für künstliche Intelligenz, das sechs Datentypen integriert, darunter Text, Audio und Bild.

Meta ist ein multisensorisches Open-Source-Modell für künstliche Intelligenz, das sechs Datentypen integriert, darunter Text, Audio und Bild.

- 王林nach vorne

- 2023-05-16 09:43:051484Durchsuche

Meta Corporation hat mit ImageBind ein neues Open-Source-Modell für künstliche Intelligenz veröffentlicht, das mehrere Datenströme integriert, darunter Text, Audio, visuelle Daten, Temperatur- und Bewegungsmesswerte und mehr. Das Modell ist derzeit nur ein Forschungsprojekt und hat noch keine direkten Verbraucher- oder praktischen Anwendungen, aber es zeigt die Möglichkeiten für zukünftige generative KI-Systeme, die immersive, multisensorische Erlebnisse schaffen können. Gleichzeitig zeigt das Modell auch die offene Haltung von Meta im Bereich der Künstliche-Intelligenz-Forschung, während sich Konkurrenten wie OpenAI und Google zunehmend verschließen.

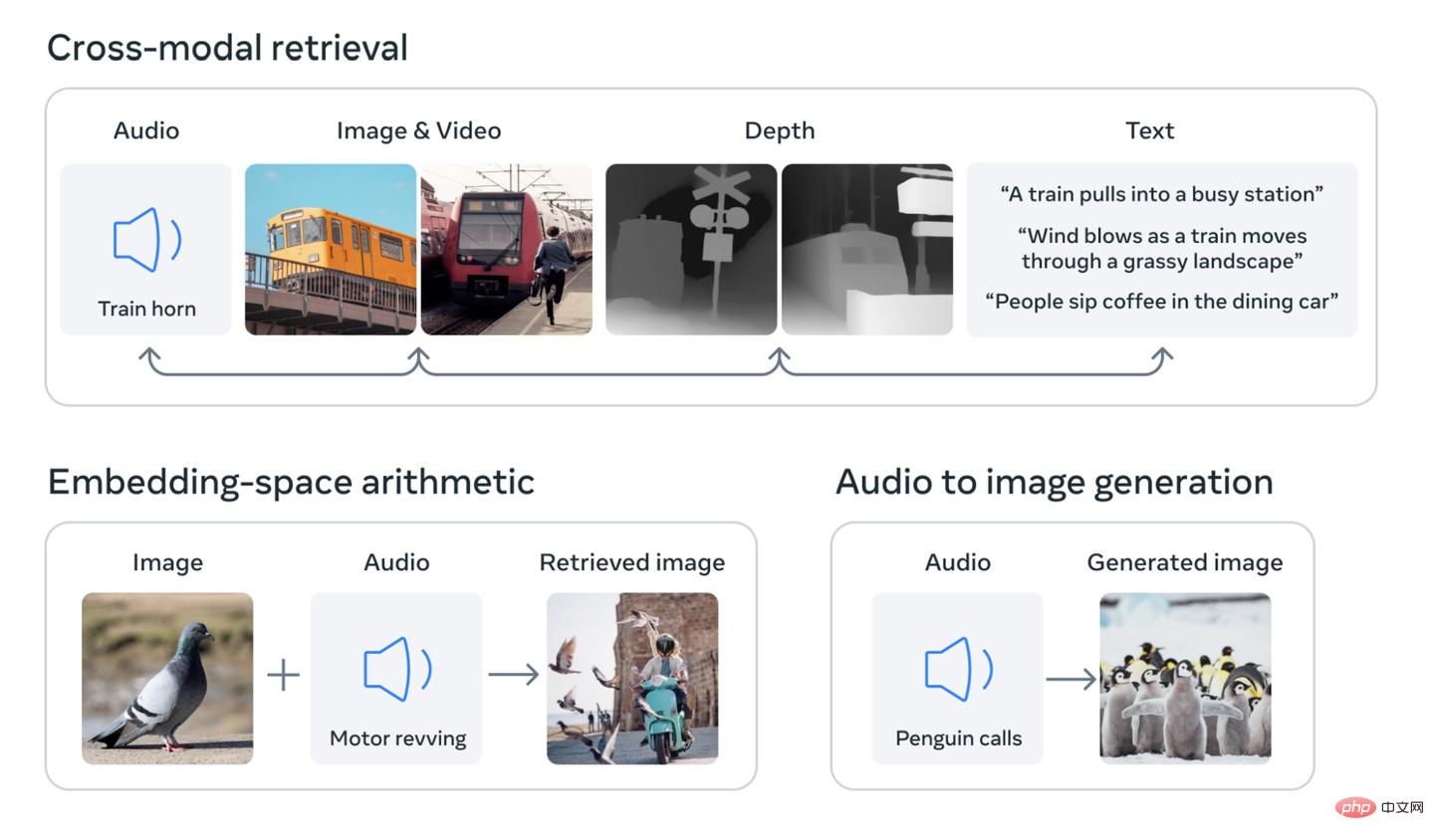

Das Kernkonzept der Forschung besteht darin, mehrere Arten von Daten in einen mehrdimensionalen Index zu integrieren (oder in der Terminologie der künstlichen Intelligenz „Einbettungsraum“). Das Konzept mag etwas abstrakt sein, aber es ist die Grundlage des jüngsten Booms der generativen künstlichen Intelligenz. Beispielsweise basieren KI-Bildgeneratoren wie DALL-E, Stable Diffusion und Midjourney auf Systemen, die während der Trainingsphase Text und Bilder miteinander verknüpfen. Sie suchen nach Mustern in visuellen Daten und verknüpfen diese Informationen mit der Beschreibung des Bildes. Aus diesem Grund sind diese Systeme in der Lage, Bilder basierend auf der Texteingabe des Benutzers zu generieren. Das Gleiche gilt für viele KI-Tools, die auf die gleiche Weise Video oder Audio erzeugen können.

Meta sagt, dass sein Modell ImageBind das erste ist, das sechs Datentypen in einem einzigen Einbettungsraum integriert. Zu den sechs Arten von Daten gehören: visuelle (einschließlich Bilder und Videos); (IMUs sind in Telefonen und Smartwatches zu finden und werden für eine Vielzahl von Aufgaben verwendet, vom Umschalten eines Telefons vom Quer- ins Hochformat bis hin zur Unterscheidung zwischen verschiedenen Bewegungsarten.)

Zukünftige KI-Systeme werden in der Lage sein, das zu tun, wofür wir derzeit tun Texteingabe Dasselbe System stellt Querverweise auf diese Daten her. Stellen Sie sich beispielsweise ein zukünftiges Virtual-Reality-Gerät vor, das nicht nur Audio- und visuelle Eingaben, sondern auch Bewegungen Ihrer Umgebung und physischen Plattform erzeugen kann. Sie können es eine lange Seereise simulieren lassen, und es versetzt Sie nicht nur auf ein Schiff mit dem Rauschen der Wellen im Hintergrund, sondern Sie spüren auch, wie die Decks unter Ihren Füßen schaukeln und die Meeresbrise weht.

Meta stellte in einem Blogbeitrag fest, dass zukünftige Modelle auch andere sensorische Eingabeströme hinzufügen könnten, darunter „taktile, Sprach-, Geruchs- und fMRT-Signale des Gehirns“. Das Unternehmen behauptet außerdem, dass diese Forschung „Maschinen näher an die menschliche Fähigkeit bringt, gleichzeitig, umfassend und direkt aus vielen verschiedenen Formen von Informationen zu lernen.“

Natürlich basiert vieles davon auf Vorhersagen, und es ist wahrscheinlich, dass dies der Fall ist Direkte Anwendungen der Forschung werden sehr begrenzt sein. Im vergangenen Jahr demonstrierte beispielsweise die Firma Meta ein KI-Modell, das auf Basis von Textbeschreibungen kurze, unscharfe Videos generieren kann. Untersuchungen wie ImageBind zeigen, wie zukünftige Versionen des Systems andere Datenströme integrieren können, beispielsweise die Erzeugung von Audio, das zur Videoausgabe passt.

Für Branchenbeobachter ist diese Untersuchung auch deshalb interessant, weil IT House festgestellt hat, dass Meta Company das zugrunde liegende Modell als Open Source bereitgestellt hat, eine Praxis, die im Bereich der künstlichen Intelligenz zunehmend Aufmerksamkeit erregt.

Das obige ist der detaillierte Inhalt vonMeta ist ein multisensorisches Open-Source-Modell für künstliche Intelligenz, das sechs Datentypen integriert, darunter Text, Audio und Bild.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr