Heim >Technologie-Peripheriegeräte >KI >Steuern Sie mehr als 100.000 KI-Modelle mit einem Klick. HuggingFace erstellt einen „APP Store' für ChatGPT-ähnliche Modelle

Steuern Sie mehr als 100.000 KI-Modelle mit einem Klick. HuggingFace erstellt einen „APP Store' für ChatGPT-ähnliche Modelle

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-16 09:40:061345Durchsuche

Vom Chatten über das Programmieren bis hin zur Unterstützung verschiedener Plug-Ins ist der leistungsstarke ChatGPT längst kein einfacher Konversationsassistent mehr, sondern bewegt sich in Richtung „Management“ der KI-Welt.

Am 23. März gab OpenAI bekannt, dass ChatGPT damit begonnen hat, verschiedene Plug-Ins von Drittanbietern zu unterstützen, beispielsweise das berühmte Wissenschafts- und Technikartefakt Wolfram Alpha. Mit Hilfe dieses Artefakts wurde ChatGPT, der ursprünglich ein Huhn und ein Kaninchen im selben Käfig war, zu einem Spitzenstudenten in Naturwissenschaften und Technik. Viele Leute auf Twitter kommentierten, dass die Einführung des ChatGPT-Plug-ins ein bisschen wie die Einführung des iPhone App Store im Jahr 2008 aussieht. Das bedeutet auch, dass KI-Chatbots in eine neue Evolutionsstufe eintreten – die „Meta-App“-Stufe.

Anfang April schlugen Forscher der Zhejiang-Universität und Microsoft Asia Research eine wichtige Methode namens „HuggingGPT“ vor, die als groß angelegte Demonstration der oben genannten Route angesehen werden kann. Mit HuggingGPT kann ChatGPT als Controller fungieren (kann als Verwaltungsschicht verstanden werden), der eine große Anzahl anderer KI-Modelle verwaltet, um einige komplexe KI-Aufgaben zu lösen. Insbesondere verwendet HuggingGPT ChatGPT für die Aufgabenplanung, wenn es eine Benutzeranfrage erhält, wählt ein Modell basierend auf der in HuggingFace verfügbaren Funktionsbeschreibung aus, führt jede Unteraufgabe mit dem ausgewählten KI-Modell aus und aggregiert die Antwort basierend auf den Ausführungsergebnissen.

Dieser Ansatz kann viele Mängel aktueller großer Modelle ausgleichen, wie z. B. begrenzte Modalitäten, die verarbeitet werden können, und ist in einigen Aspekten nicht so gut wie professionelle Modelle.

Obwohl das HuggingFace-Modell geplant ist, ist HuggingGPT schließlich kein offizielles Produkt von HuggingFace. Gerade hat HuggingFace endlich Maßnahmen ergriffen.

Ähnlich wie HuggingGPT haben sie eine neue API eingeführt – HuggingFace Transformers Agents. Über Transformers Agents können Sie mehr als 100.000 Hugging Face-Modelle steuern, um verschiedene multimodale Aufgaben zu erledigen.

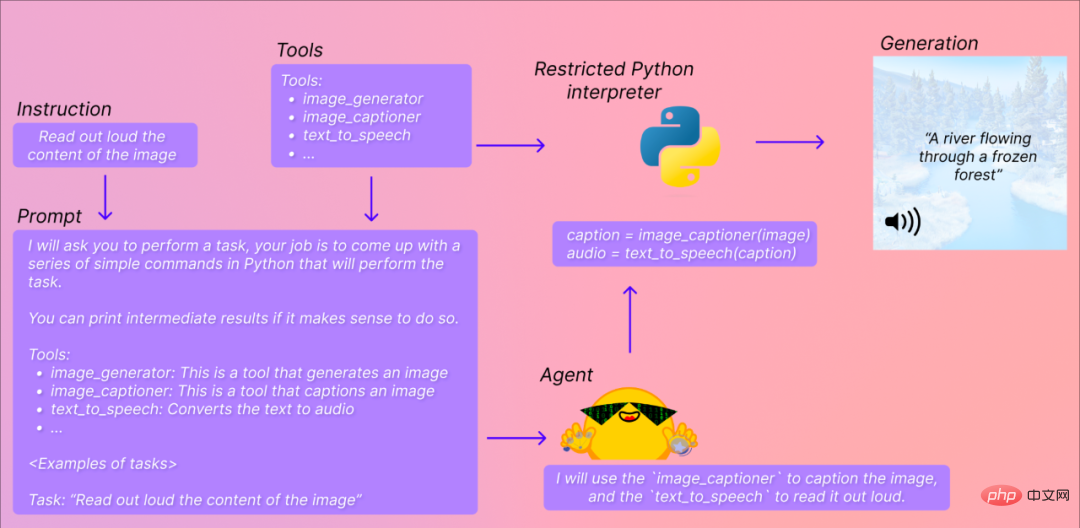

Im folgenden Beispiel möchten Sie beispielsweise, dass Transformers-Agenten laut erklären, was auf dem Bild dargestellt ist. Es wird versuchen, Ihre Anweisungen zu verstehen (den Inhalt des Bildes laut vorzulesen), sie dann in Eingabeaufforderungen umzuwandeln und die geeigneten Modelle und Werkzeuge auszuwählen, um die von Ihnen angegebenen Aufgaben auszuführen.

Der NVIDIA-KI-Wissenschaftler Jim Fan kommentierte: „Dieser Tag ist endlich gekommen und dies ist ein wichtiger Schritt in Richtung „Everything APP“.

Einige Leute sagen jedoch, dass dies nicht dasselbe ist wie die automatische Iteration von AutoGPT. Es geht eher darum, die Schritte zum Schreiben von Eingabeaufforderungen und zur manuellen Angabe von Tools zu eliminieren, und es ist noch zu früh dafür universelle APP.

Transformers Agents Adresse: https://huggingface.co/docs/transformers/transformers_agents

Transformers Agents Wie benutzt man?

Gleichzeitig mit der Veröffentlichung veröffentlichte HuggingFace die Colab-Adresse, jeder kann es ausprobieren:

https://huggingface.co/docs/transformers/en/transformers_agents

Simple In Kurz gesagt, es bietet eine API für natürliche Sprache zusätzlich zu Transformatoren: Definieren Sie zunächst eine Reihe kuratierter Tools und entwerfen Sie einen Agenten, um natürliche Sprache zu interpretieren und diese Tools zu verwenden.

Darüber hinaus sind Transformers Agents so konzipiert, dass sie erweiterbar sind.

Das Team hat eine Reihe von Tools identifiziert, die Agenten autorisiert werden können:

- #🎜🎜 # Fragen und Antworten zu Dokumenten: Beantworten Sie anhand eines Dokuments im Bildformat (z. B. PDF) Fragen zum Dokument (Donut). , beantworte die Frage im Text (Flan-T5)

- Unbedingte Bildunterschrift: Füge eine Bildunterschrift hinzu (BLIP) # 🎜 🎜# Bildfrage und -antwort: Beantworten Sie bei einem gegebenen Bild Fragen zu diesem Bild (VILT)

- Bildsegmentierung: Bei einem gegebenen Bild und einer Eingabeaufforderung Ausgabe die Segmentierungsmaske der Eingabeaufforderung (CLIPSeg)

- Sprache in Text: Transkribieren Sie die Rede anhand einer Aufzeichnung einer sprechenden Person in Text (Flüstern)

- # 🎜🎜#Text in Sprache: Text in Sprache umwandeln (SpeechT5)

- Zero-Shot-Textklassifizierung: gegebener Text und Tags Liste, Bestimmen Sie, welchem Tag der Text am meisten entspricht (BART) 🎜🎜#

- Übersetzung: Text in eine bestimmte Sprache übersetzen (NLLB)

- # 🎜🎜#Diese Tools sind in Transformatoren integriert oder können manuell verwendet werden:

<code>from transformers import load_tooltool = load_tool("text-to-speech")audio = tool("This is a text to speech tool")</code> - Benutzer können den Code des Tools auch an Hugging Face Space oder das Modell-Repository übertragen, um ihn zu nutzen das Tool direkt über den Agenten, zum Beispiel:

- Text-Downloader: Text von der Web-URL herunterladen

Text zu Bild: Bild entsprechend der Eingabeaufforderung generieren, Stable Diffusion verwenden

Bildkonvertierung: Ändern Sie das Bild anhand des ursprünglichen Bilds und der Eingabeaufforderung, verwenden Sie „instruct pix2pix Stable“. Verbreitung

- Text zu Video: Erstellen Sie ein kurzes Video basierend auf der Eingabeaufforderung, verwenden Sie damo-vilab

- # 🎜🎜#Für ein bestimmtes Gameplay schauen wir uns zunächst ein paar Beispiele von HuggingFace an:

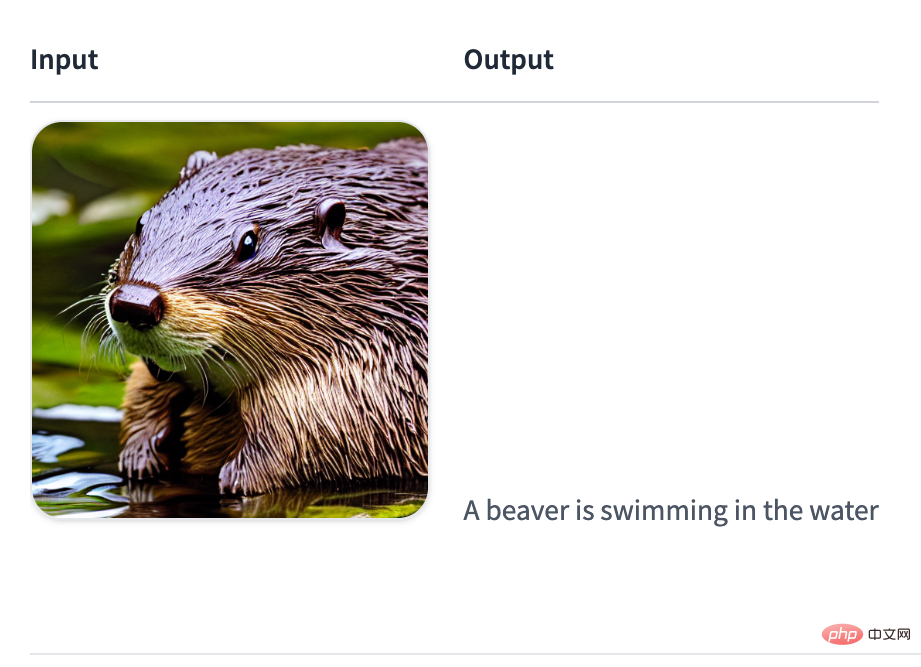

- Bildbeschreibung generieren:

-

<code>agent.run("Caption the following image", image=image)</code>

<code>agent.run("Read the following text out loud", text=text)</code>

# 🎜🎜#Ausgabe:

# 🎜 🎜#

00:0000:01

# 🎜🎜 ##🎜 🎜 #

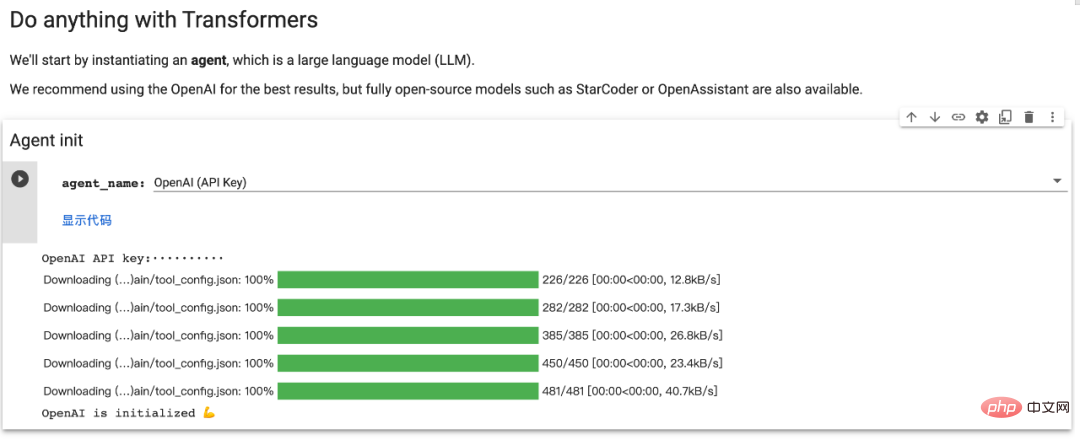

Datei lesen: #🎜 🎜## 🎜🎜#Bevor Sie agent.run ausführen, müssen Sie einen großen Sprachmodellagenten instanziieren. Es unterstützt OpenAI-Modelle und Open-Source-Modelle wie BigCode und OpenAssistant. Installieren Sie zunächst das Agenten-Add-on, um alle Standardabhängigkeiten zu installieren:

<code>pip install transformers[agents]</code>Um openAI zu verwenden Modell: Sie müssen nach der Installation der Abhängigkeiten ein „OpenAiAgent“-OpenAI instanziieren:

<code>pip install openaifrom transformers import OpenAiAgentagent = OpenAiAgent(model="text-davinci-003", api_key="<your_api_key>")</code>

Um BigCode oder OpenAssistant zu verwenden, melden Sie sich zunächst an, um auf die Inferenz-API zuzugreifen: #🎜 🎜# <code>from huggingface_hub import loginlogin("<YOUR_TOKEN>")</code>

<code>from transformers import HfAgentStarcoderagent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoder")StarcoderBaseagent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoderbase")OpenAssistantagent = HfAgent(url_endpoint="https://api-inference.huggingface.co/models/OpenAssistant/oasst-sft-4-pythia-12b-epoch-3.5")</code>

Wenn der Benutzer seinen eigenen für dieses Modell (oder ein anderes) hat Modell) Für Inferenzendpunkte können Sie die obige URL durch Ihren eigenen URL-Endpunkt ersetzen.

Wenn der Benutzer seinen eigenen für dieses Modell (oder ein anderes) hat Modell) Für Inferenzendpunkte können Sie die obige URL durch Ihren eigenen URL-Endpunkt ersetzen.

接下来,我们了解一下 Transformers Agents 提供的两个 API:

单次执行

单次执行是在使用智能体的 run () 方法时:

<code>agent.run("Draw me a picture of rivers and lakes.")</code>

它会自动选择适合要执行的任务的工具并适当地执行,可在同一指令中执行一项或多项任务(不过指令越复杂,智能体失败的可能性就越大)。

<code>agent.run("Draw me a picture of the sea then transform the picture to add an island")</code>

每个 run () 操作都是独立的,因此可以针对不同的任务连续运行多次。如果想在执行过程中保持状态或将非文本对象传递给智能体,用户可以通过指定希望智能体使用的变量来实现。例如,用户可以生成第一张河流和湖泊图像,并通过执行以下操作要求模型更新该图片以添加一个岛屿:

<code>picture = agent.run("Generate a picture of rivers and lakes.")updated_picture = agent.run("Transform the image in picture to add an island to it.", picture=picture)</code>

当模型无法理解用户的请求并混合使用工具时,这会很有帮助。一个例子是:

<code>agent.run("Draw me the picture of a capybara swimming in the sea")</code>

在这里,模型可以用两种方式解释:

- 让 text-to-image 水豚在海里游泳

- 或者,生成 text-to-image 水豚,然后使用 image-transformation 工具让它在海里游泳

如果用户想强制执行第一种情况,可以通过将 prompt 作为参数传递给它来实现:

<code>agent.run("Draw me a picture of the prompt", prompt="a capybara swimming in the sea")</code>

基于聊天的执行

智能体还有一种基于聊天的方法:

<code>agent.chat("Generate a picture of rivers and lakes")</code>

<code>agent.chat ("Transform the picture so that there is a rock in there")</code>

这是一种可以跨指令保持状态时。它更适合实验,但在单个指令上表现更好,而 run () 方法更擅长处理复杂指令。如果用户想传递非文本类型或特定 prompt,该方法也可以接受参数。

Das obige ist der detaillierte Inhalt vonSteuern Sie mehr als 100.000 KI-Modelle mit einem Klick. HuggingFace erstellt einen „APP Store' für ChatGPT-ähnliche Modelle. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr