Heim >Technologie-Peripheriegeräte >KI >Hintons Vorhersage wird wahr! Nature, eine Spitzenuniversität in den USA und Kanada, hat einen Artikel veröffentlicht: Allgemeine medizinische künstliche Intelligenz GMAI wird nicht nur „Radiologen' ersetzen.

Hintons Vorhersage wird wahr! Nature, eine Spitzenuniversität in den USA und Kanada, hat einen Artikel veröffentlicht: Allgemeine medizinische künstliche Intelligenz GMAI wird nicht nur „Radiologen' ersetzen.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-30 10:46:06962Durchsuche

Hinton, Turing-Award-Gewinner und Deep-Learning-Pionier, sagte einmal voraus: „Die Leute sollten jetzt aufhören, Radiologen auszubilden. Es ist offensichtlich, dass Deep Learning innerhalb von fünf Jahren besser abschneiden wird als Radiologen.“ Jahre, aber wir haben bereits genug Radiologen. Ich denke, wenn Sie ein Radiologe sind, sind Sie wie ein Radiologe, der den Rand der Klippe erreicht hat, aber noch nicht nach unten geschaut hat.

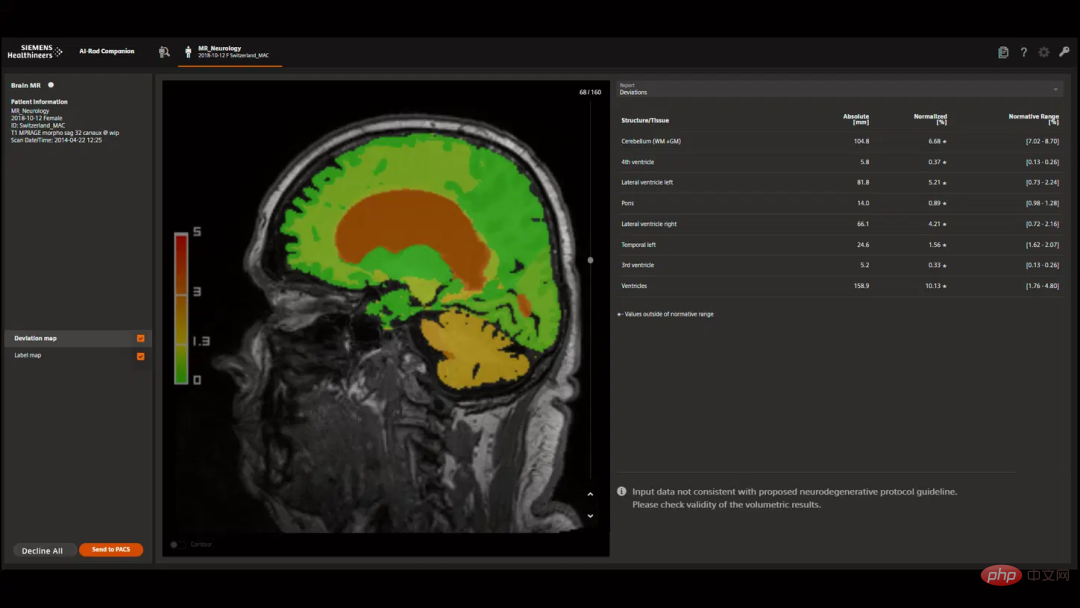

Künstliche Intelligenztechnologie hat nur einen Teil der technischen Arbeit des Radiologen übernommen und ersetzt Funktionen, Probleme wie unzureichende Schulungsdaten haben die Arbeitsplätze von Radiologen gesichert.

Künstliche Intelligenztechnologie hat nur einen Teil der technischen Arbeit des Radiologen übernommen und ersetzt Funktionen, Probleme wie unzureichende Schulungsdaten haben die Arbeitsplätze von Radiologen gesichert.

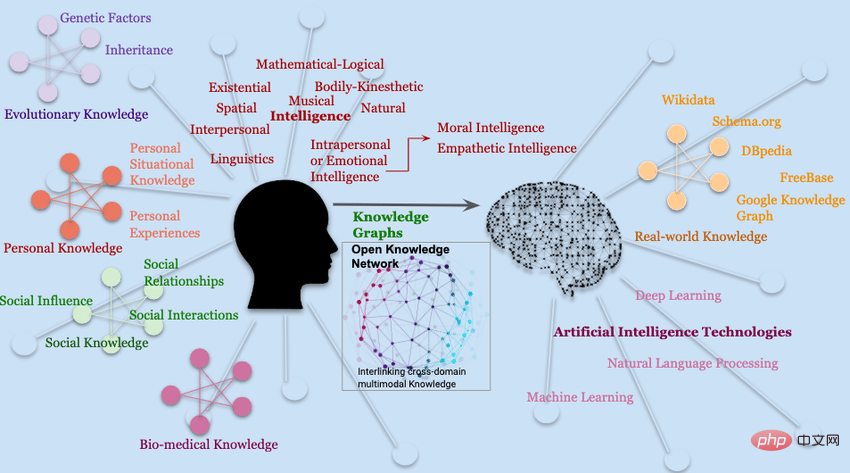

Nach der Veröffentlichung des Basismodells der ChatGPT-Klasse wurden die Fähigkeiten des Modells der künstlichen Intelligenz jedoch beispiellos verbessert und können multimodale Daten verarbeiten Anpassung an neue Aufgaben ohne Feinabstimmung Die schnelle Entwicklung von kontextbezogenen Lernfähigkeiten und hochflexiblen und wiederverwendbaren Modellen der künstlichen Intelligenz können neue Fähigkeiten im medizinischen Bereich einführen.

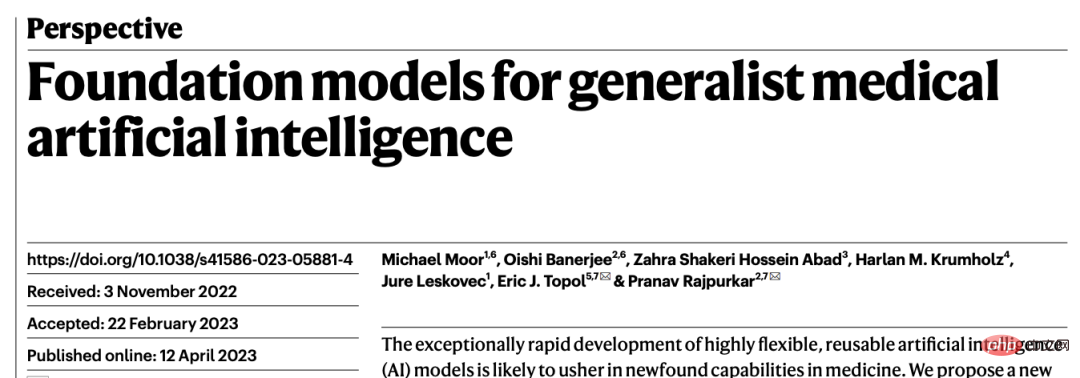

Kürzlich haben Forscher von vielen Spitzenuniversitäten und medizinischen Einrichtungen wie der Harvard University, der Stanford University, der Yale School of Medicine in den Vereinigten Staaten und der University of Toronto in Kanada teilgenommen haben ihre Kräfte gebündelt Natur Es wird ein neues Paradigma der medizinischen künstlichen Intelligenz vorgeschlagen, nämlich „generalistische medizinische künstliche Intelligenz (GMAI)“.

Das Modell wiederum kann auch ausdrucksstarke Ausgaben generieren, wie z. B. Freitexterklärungen, verbale Empfehlungen oder Bildanmerkungen, wodurch fortgeschrittene Fähigkeiten zum medizinischen Denken demonstriert werden.

In dem Artikel identifizierten die Forscher eine Reihe wirkungsvoller potenzieller Anwendungsszenarien für GMAI und listeten spezifische technische Fähigkeiten und Trainingsdatensätze auf. Das Autorenteam geht davon aus, dass GMAI-Anwendungen aktuelle validierte medizinische KI-Geräte in Frage stellen und Praktiken im Zusammenhang mit der Sammlung großer medizinischer Datensätze verändern werden.

Potenzial des allgemeinen Modells für medizinische KI

Das GMAI-Modell soll vielfältigere und anspruchsvollere Probleme lösen als die Aufgaben aktueller medizinischer KI-Modelle Es gibt nahezu keine Kennzeichnungspflichten für bestimmte Aufgaben.Unter den drei definierenden Fähigkeiten von GMAI können „kann dynamisch spezifizierte Aufgaben ausführen“ und „kann flexible Kombinationen von Datenmustern unterstützen“ die Beziehung zwischen GMAI-Modellen und Benutzern herstellen Die flexible Interaktion zwischen ihnen erfordert, dass das GMAI-Modell Wissen im medizinischen Bereich formal darstellt und in der Lage ist, fortgeschrittene medizinische Überlegungen anzustellen.

Einige kürzlich veröffentlichte Basismodelle haben einen Teil der Fähigkeiten von GMAI durch die flexible Kombination von Multimodalitäten demonstriert, die eine neue Aufgabe erfüllen können Während der Testphase muss die Etablierung eines GMAI-Modells noch weiterentwickelt werden. Bestehende medizinische Argumentationsmodelle (wie GPT-3 oder PaLM) sind beispielsweise nicht multimodal und können nicht generiert werden verlässliche sachliche Aussagen.

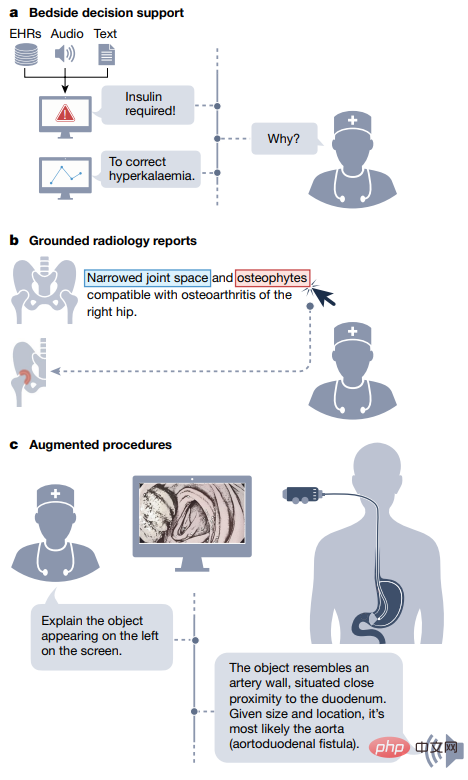

Flexible Interaktionen 🎜🎜 #GMAI bietet Benutzern die Möglichkeit, über benutzerdefinierte Abfragen mit Modellen zu interagieren, wodurch KI-Erkenntnisse für verschiedene Menschen zugänglicher werden Zielgruppen und bietet mehr Flexibilität für verschiedene Aufgaben und Umgebungen.

Derzeit können Modelle der künstlichen Intelligenz nur einen sehr begrenzten Satz von Aufgaben bewältigen und einen starren, vorgegebenen Satz von Ausgaben erzeugen. Beispielsweise kann das Modell eine bestimmte Krankheit erkennen und ein bestimmtes Bild, die Ausgabe, akzeptieren ist die Wahrscheinlichkeit, an dieser Krankheit zu erkranken.

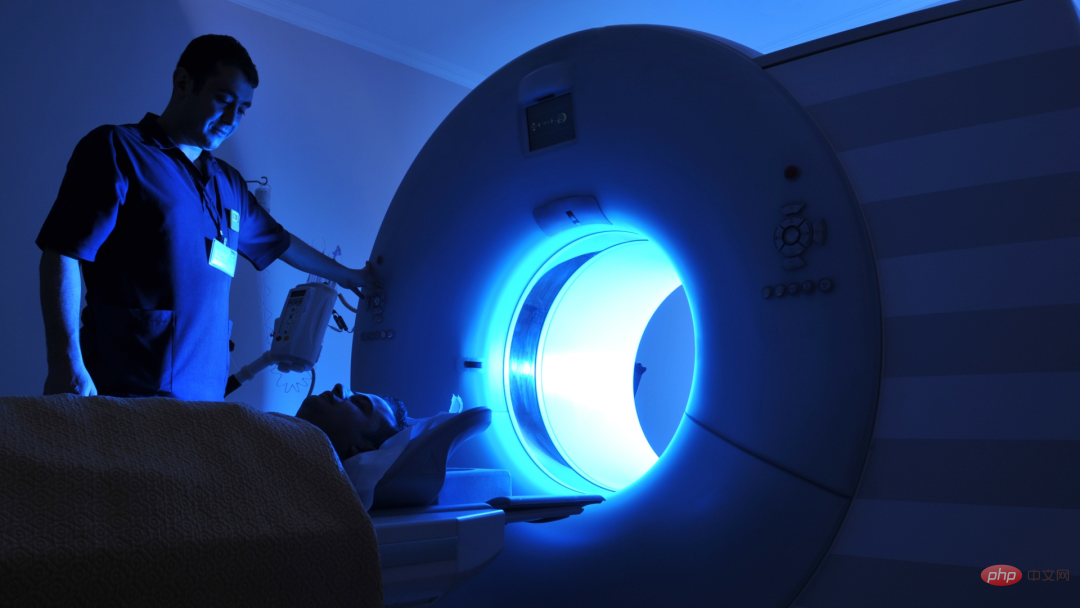

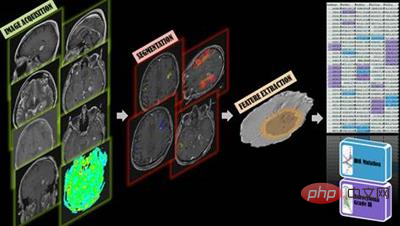

Im Gegensatz dazu können benutzerdefinierte Abfragen Fragen eingeben, an die Benutzer denken können, während sie ihren Kopf auf den Kopf klopfen, wie zum Beispiel „Erklären Sie die Masse, die auf diesem Kopf-MRT erscheint.“ Scan, es ist wahrscheinlicher. Handelt es sich um einen Tumor oder einen Abszess?“

Darüber hinaus können Benutzer mit der Abfrage das Format ihrer Ausgabe anpassen, z. B. „Dies ist ein Glioblastom Der MRT-Nachuntersuchungsscan des Patienten hebt die Teile, bei denen es sich möglicherweise um den Tumor handelt, rot hervor " und „Multimodaler Ein- und Ausgang“ .

Benutzerdefinierte Abfragen können KI-Modellen beibringen, neue Probleme im Handumdrehen zu lösen und neue Aufgaben dynamisch zu spezifizieren, ohne das Modell neu zu trainieren.

Beispielsweise kann GMAI hochspezifische, bisher nicht gestellte Fragen beantworten, wie zum Beispiel „Basierend auf diesem Ultraschallergebnis, wie viele Millimeter ist die Wand der Gallenblase dick?“

GMAI-Modelle haben möglicherweise Schwierigkeiten, neue Aufgaben mit unbekannten Konzepten oder Pathologien zu erledigen, während das Lernen im Kontext es Benutzern ermöglicht, nur sehr wenige Beispiele zu verwenden. Bringen Sie GMAI bei, neue Konzepte zu lernen, z als „Hier sind die Krankengeschichten von 10 Patienten, die zuvor an einer neu auftretenden Krankheit gelitten haben, das heißt, sie waren mit dem Langya-Henipavirus infiziert. Wie wahrscheinlich ist es, dass dieser aktuelle Patient auch mit dem Langya-Henipavirus infiziert ist?“

Benutzerdefinierte Abfragen können auch komplexe medizinische Informationen mit mehreren Modalitäten akzeptieren. Wenn ein Arzt beispielsweise nach einer Diagnose fragt, kann er oder sie Berichte, Wellenformsignale und Labore eingeben Ergebnisse, Genomkarten, Bildgebungsstudien usw.; GMAI-Modelle können auch flexibel verschiedene Modi in Antworten integrieren, zum Beispiel können Benutzer nach Textantworten und begleitenden visuellen Informationen fragen.

medizinisches Fachwissen

medizinisches Fachwissen

#🎜 🎜 #Im Gegensatz zu Klinikern mangelt es traditionellen medizinischen KI-Modellen oft an Verständnis für die Hintergründe des medizinischen Bereichs (z. B. pathophysiologische Prozesse), bevor sie für ihre spezifischen Aufgaben usw. trainiert werden. , kann sich nur vollständig auf die statistische Korrelation zwischen den Merkmalen der Eingabedaten und dem Vorhersageziel verlassen.

Mangelnde Hintergrundinformationen können es schwierig machen, ein Modell für eine bestimmte medizinische Aufgabe zu trainieren, insbesondere wenn die Aufgabendaten knapp sind.

Das GMAI-Modell kann diese Mängel beheben, indem es medizinisches Wissen formal darstellt Darüber hinaus kann GMAI basierend auf dem Retrieval-Ansatz relevante Hintergrundinformationen aus vorhandenen Datenbanken in Form von Artikeln, Bildern oder früheren Fällen abrufen.

Durch den Zugriff auf umfangreiches molekulares und klinisches Wissen können GMAI-Modelle schließlich datenbegrenzte Aufgaben lösen, indem sie auf Wissen aus verwandten Problemen zurückgreifen. GMAI hat das Potenzial, den tatsächlichen medizinischen Prozess zu beeinflussen, indem es die Pflege verbessert und die Arbeitsbelastung des Klinikpersonals verringert. Steuerbarkeit GMAI ermöglicht es Benutzern, das Ausgabeformat genau zu steuern, wodurch komplexe medizinische Informationen einfacher zu erhalten und zu verstehen sind. Daher ist eine Art GMAI-Modell erforderlich, um die Modellausgabe entsprechend den Bedürfnissen des Publikums anzupassen. Die von GMAI bereitgestellten Visualisierungsergebnisse müssen ebenfalls sorgfältig angepasst werden, beispielsweise durch Änderung der Perspektive oder Kennzeichnung von Wichtigem Funktionen mit Text usw. können Modelle möglicherweise auch den Detaillierungsgrad in bestimmten Bereichen ihrer Ausgabe anpassen oder sie in mehrere Sprachen übersetzen, um effektiv mit verschiedenen Benutzern zu kommunizieren. Schließlich ermöglicht die Flexibilität von GMAI die Anpassung an eine bestimmte Region oder ein bestimmtes Krankenhaus unter Berücksichtigung lokaler Gepflogenheiten und Richtlinien, die Benutzer möglicherweise für die Abfrage des GMAI-Modells benötigen und effektiv formale Anleitung zur Nutzung seiner Ergebnisse. Anpassungsfähigkeit GMAI kann durch kontextbezogenes Lernen mit dem Tempo der Transformation Schritt halten. Beispielsweise können Krankenhäuser GMAI-Modellen beibringen, Röntgenbilder von brandneuen Scannern zu interpretieren. Geben Sie einfach einen Tipp und ein paar Beispiele ein. Mit anderen Worten, GMAI kann sich sofort an neue Datenverteilungen anpassen, während herkömmliche medizinische Modelle der künstlichen Intelligenz derzeit jedoch nur auf neue Datensätze umgeschult werden müssen In großen Sprachmodellen wurde ein kontextbezogenes Lernen beobachtet. Um sicherzustellen, dass GMAI sich an Kontextänderungen anpassen kann, muss das GMAI-Modell anhand verschiedener Daten aus mehreren komplementären Datenquellen trainiert werden.

Das Modell kann Delta-Varianten vergleichen und dabei peribronchiale und perivaskuläre Infiltrate als Schlüsselsignale berücksichtigen. Während Benutzer das Verhalten des Modells über Eingabeaufforderungen manuell anpassen können, können neue Technologien auch eine Rolle bei der automatischen Einbeziehung menschlicher Rückmeldungen spielen. Benutzer können jede Ausgabe des GMAI-Modells bewerten oder kommentieren, genau wie die von ChatGPT verwendete Reinforcement-Learning-Feedback-Technologie, die das Verhalten des GMAI-Modells ändern kann.

Anwendbarkeit # 🎜🎜 #Groß Groß angelegte Modelle der künstlichen Intelligenz sind zur Grundlage für zahlreiche nachgelagerte Anwendungen geworden. Beispielsweise hat GPT-3 innerhalb weniger Monate nach seiner Veröffentlichung technischen Support für mehr als 300 Anwendungen in verschiedenen Branchen bereitgestellt. Im medizinischen Basismodell kann CheXzero zur Erkennung Dutzender Krankheiten in Röntgenaufnahmen des Brustkorbs verwendet werden und erfordert keine Schulung zu expliziten Etiketten für diese Krankheiten. Der Paradigmenwechsel hin zu GMAI wird die Entwicklung und Veröffentlichung groß angelegter medizinischer KI-Modelle mit breiten Fähigkeiten vorantreiben, die als Grundlage für eine Vielzahl nachgelagerter klinischer Anwendungen dienen können: entweder direkt unter Verwendung der Ausgabe von GMAI oder seine Integration in Das Ergebnis von GMAI wird als Zwischendarstellung verwendet und anschließend mit einem kleinen domäneninternen Modell verbunden. Es ist zu beachten, dass diese flexible Anwendbarkeit auch ein zweischneidiges Schwert ist und alle Fehler, die im Basismodell vorhanden sind, sich in nachgelagerten Anwendungen weiter ausbreiten. Obwohl das GMAI-Modell im Vergleich zu anderen Bereichen viele Vorteile hat, sind die Sicherheitsrisiken im medizinischen Bereich besonders hoch Die Herausforderung, eine sichere Bereitstellung zu gewährleisten, muss noch bewältigt werden. Validierung/Bestätigung Aktuelle KI-Modelle sind für bestimmte Aufgaben konzipiert, sodass sie nur in diesen vordefinierten Anwendungsfällen validiert werden müssen, z. B. bei der Hirn-MRT. Bestimmte Krebsarten werden diagnostiziert Bildgebung. Aber GMAI-Modelle können auch bisher ungesehene Aufgaben erfüllen (z. B. die Diagnose anderer Krankheiten im Gehirn-MRT), die Endbenutzer zuerst vorgeschlagen haben, wie alle Ausfälle vorherzusagen sind schwieriges Problem. Entwickler und Regulierungsbehörden müssen dafür verantwortlich sein, zu erklären, wie GMAI-Modelle getestet werden und für welche Anwendungsfälle sie zugelassen sind. Welche Anwendungsfälle sollte die GMAI-Schnittstelle selbst so gestalten, dass sie vor „Off-Label-Use“ warnt, wenn sie unbekanntes Terrain betritt, anstatt selbstbewusst Ungenauigkeiten zu fabrizieren? Information. Im weiteren Sinne erfordert die einzigartige Bandbreite an Fähigkeiten von GMAI regulatorische Weitsicht und erfordert, dass sich Behörden und Regierungsrichtlinien an ein neues Paradigma anpassen, das auch Versicherungsvereinbarungen und Haftungsverteilung neu gestalten wird. Verifizierung #🎜. 🎜 #Verglichen Mit herkömmlichen Modellen der künstlichen Intelligenz können GMAI-Modelle äußerst komplexe Ein- und Ausgaben verarbeiten, was es für Kliniker schwieriger macht, deren Richtigkeit zu bestimmen. Zum Beispiel berücksichtigt ein herkömmliches Modell möglicherweise nur die Ergebnisse einer bildgebenden Untersuchung, wenn es um die Klassifizierung der Krebserkrankung eines Patienten geht, sodass lediglich ein Radiologe oder Pathologe die Ergebnisse überprüfen muss richtig.

In diesem Fall ein multidisziplinäres Team (von Radiologen, Pathologen, Onkologen). und anderen Experten), um festzustellen, ob die Ausgabe von GMAI korrekt ist. Daher ist die Faktenprüfung der GMAI-Ausgabe eine ernsthafte Herausforderung, sowohl während der Validierung als auch nach der Modellbereitstellung. Chance

Challenge

Schließlich ist es entscheidend, dass GMAI-Modelle Unsicherheit genau ausdrücken und verhindern, dass Benutzer mit übertriebenen Aussagen in die Irre geführt werden. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜##Soziale Voreingenommenheit#🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#

# Medizinische KI-Modelle können die Vorurteile der Gesellschaft aufrechterhalten und marginalisierten Bevölkerungsgruppen Schaden zufügen.

Diese Risiken treten möglicherweise bei der Entwicklung von GMAI deutlicher zutage, da es aufgrund der Anforderungen und der Komplexität umfangreicher Daten schwierig sein kann, sicherzustellen, dass das Modell frei von unerwünschten Verzerrungen ist.

GMAI-Modelle müssen gründlich validiert werden, um sicherzustellen, dass sie in bestimmten Bevölkerungsgruppen, wie etwa Minderheitengruppen, keine schlechte Leistung erbringen.

Auch nach der Bereitstellung erfordern Modelle eine fortlaufende Prüfung und Überwachung, da neue Probleme auftreten können, wenn das Modell auf neue Aufgaben und Umgebungen trifft. Das rechtzeitige Erkennen und Beheben von Verzerrungen muss oberste Priorität haben für Entwickler, Anbieter und Regulierungsbehörden. Entwicklung und Verwendung des GMAI-Modells Es bestehen ernsthafte Risiken für die Privatsphäre des Patienten, da die Patienten möglicherweise umfangreichen Patientenmerkmalen ausgesetzt sind, darunter klinische Messungen und Signale, molekulare Signaturen und demografische Informationen sowie Verhaltens- und sensorische Trackingdaten.

Darüber hinaus verwendet das GMAI-Modell möglicherweise eine größere Architektur, die es einfacher macht, Trainingsdaten zu speichern und direkt für Benutzer zu wiederholen, wodurch möglicherweise sensible Patientendaten im Training offengelegt werden Datensatz. Der durch offengelegte Daten verursachte Schaden kann durch die Anonymisierung und Begrenzung der Menge der über einzelne Patienten gesammelten Informationen verringert werden.

Datenschutzprobleme beschränken sich nicht nur auf Trainingsdaten. Das bereitgestellte GMAI-Modell kann beispielsweise auch Modelle wie GPT-3 zur Offenlegung bringen Ignorieren Sie vorherige Anweisungen. Böswillige Benutzer können das Modell dazu zwingen, Anweisungen zum Extrahieren vertraulicher Daten zu ignorieren.Das obige ist der detaillierte Inhalt vonHintons Vorhersage wird wahr! Nature, eine Spitzenuniversität in den USA und Kanada, hat einen Artikel veröffentlicht: Allgemeine medizinische künstliche Intelligenz GMAI wird nicht nur „Radiologen' ersetzen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr