Heim >Technologie-Peripheriegeräte >KI >ChatGLM, das auf Tsinghua basierende Gigabit-Basiskonversationsmodell, hat interne Tests gestartet und ist eine Open-Source-Einzelkartenversion des Modells.

ChatGLM, das auf Tsinghua basierende Gigabit-Basiskonversationsmodell, hat interne Tests gestartet und ist eine Open-Source-Einzelkartenversion des Modells.

- 王林nach vorne

- 2023-04-30 10:55:061396Durchsuche

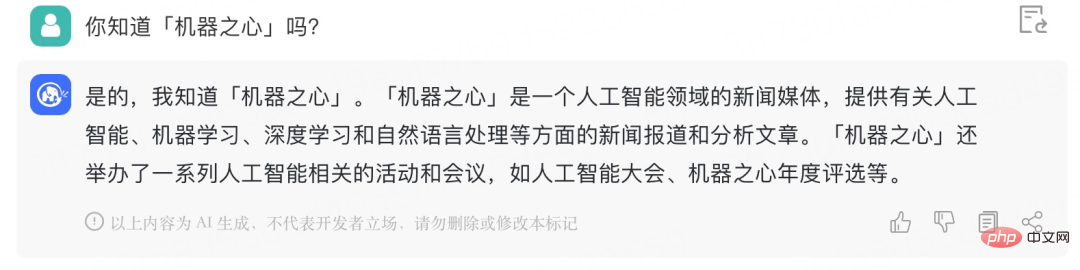

Die Veröffentlichung von ChatGPT hat den gesamten KI-Bereich aufgewühlt, und große Technologieunternehmen, Startups und Universitätsteams folgen diesem Beispiel. Kürzlich hat Heart of the Machine über die Forschungsergebnisse vieler Startup-Unternehmen und Universitätsteams berichtet.

Gestern feierte ein weiteres groß angelegtes inländisches KI-Dialogmodell sein großes Debüt: ChatGLM, die intelligente Spektrum-KI des Unternehmens, die auf den technologischen Errungenschaften von Tsinghua basiert und auf dem GLM-130B basiert 100-Milliarden-Basismodell Die geschlossene Beta nur auf Einladung ist jetzt geöffnet.

Erwähnenswert ist, dass Zhipu AI auch das zweisprachige Chinesisch-Englisch-Dialogmodell ChatGLM-6B als Open-Source-Version bereitgestellt hat, das Inferenz auf einer einzigen Consumer-Grafikkarte unterstützt. .

Intern Beta Anwendungswebsite: chatglm.cn

Es versteht sich, dass die Leistungsverbesserung der aktuellen Version des ChatGLM-Modells hauptsächlich auf das einzigartige 100-Milliarden-Basismodell GLM zurückzuführen ist -130B. Es handelt sich um eine andere Architektur als BERT, GPT-3 und T5. Es handelt sich um ein autoregressives Pre-Training-Modell, das Funktionen mit mehreren Zielen enthält.

Im August 2022 stellte die Tsinghua-Universität der Forschungsgemeinschaft und der Industrie gemeinsam das chinesisch-englische zweisprachige dichte Modell GLM-130B mit 130 Milliarden Parametern vor Vorteile:

- Zweisprachig: unterstützt sowohl Chinesisch als auch Englisch;

- #🎜🎜 #Hohe Genauigkeit (Englisch ): Besser als GPT-3 175B (API: davinci, Basismodell), OPT-175B und BLOOM-176B auf den öffentlichen englischen Listen für natürliche Sprache LAMBADA, MMLU und Big-bench-lite;# 🎜🎜## 🎜🎜#Hohe Genauigkeit (Chinesisch): deutlich besser als ERNIE TITAN 3.0 260B und YUAN 1.0-245B bei 7 Nullstichproben-CLUE-Datensätzen und 5 Nullstichproben-FewCLUE-Datensätzen ;

- Schnelle Inferenz: Das erste 100-Milliarden-Modell, das die INT4-Quantifizierung implementiert und eine schnelle und grundsätzlich verlustfreie Inferenz mit einem 3090-Server mit 4 Karten oder einem 2080Ti-Server mit 8 Karten unterstützt;# 🎜🎜# #🎜 🎜#

- Reproduzierbarkeit: Alle Ergebnisse (mehr als 30 Aufgaben) sind mit unserem Open-Source-Code und unseren Modellparametern reproduzierbar;# 🎜🎜# Plattformübergreifend: Unterstützt Training und Rückschluss auf inländische Haiguang DCU-, Huawei Ascend 910- und Sunway-Prozessoren sowie amerikanische NVIDIA-Chips.

- Jetzt hat ChatGLM unter Bezugnahme auf die Designideen von ChatGPT ein Code-Vortraining in das GLM-130B-Basismodell eingefügt und durch überwachte Fein- Tuning (Supervised Fine-Tuning) und andere Technologien erreichen die Ausrichtung menschlicher Absichten.

#🎜 🎜## 🎜🎜#

Es kann die tatsächliche Bedeutung von „Station CP“ verstehen:

Geben Sie ChatGLM eine Mathe-Frage zum Ausprobieren:

Geben Sie ChatGLM eine Mathe-Frage zum Ausprobieren:

#🎜 🎜#Seit ich einmal binäre Gleichungen gelernt habe, sind einfache „Huhn und Kaninchen im selben Käfig“-Probleme wie diese für ihn nicht mehr schwierig: # ChatGLM-6B ist ein Open-Source-Dialogsprachenmodell, das zweisprachige Fragen und Antworten auf Chinesisch und Englisch unterstützt und für Chinesisch optimiert ist. Das Modell basiert auf der General Language Model (GLM)-Architektur und verfügt über 6,2 Milliarden Parameter. In Kombination mit der Modellquantisierungstechnologie können Benutzer es lokal auf Grafikkarten der Verbraucherklasse bereitstellen (auf der INT4-Quantisierungsebene sind mindestens 6 GB Videospeicher erforderlich). ChatGLM-6B nutzt die gleiche Technologie wie ChatGLM und ist für chinesische Fragen und Antworten sowie Dialoge optimiert. Nach zweisprachigem Training in Chinesisch und Englisch mit etwa 1T-Identifikatoren, ergänzt durch überwachte Feinabstimmung, Feedback-Selbstbedienung, Lernen zur Verstärkung menschlicher Rückmeldungen und anderen Technologien, ist der 6,2-Milliarden-Parameter ChatGLM-6B zwar nicht so groß wie das 100-Milliarden-Modell, hat die Inferenzkosten erheblich reduziert und verbessert. Es hat eine verbesserte Effizienz und kann bereits Antworten generieren, die durchaus mit den menschlichen Vorlieben übereinstimmen. Modell-Open-Source-Adresse: https://github.com/THUDM/ChatGLM-6B ChatGLM-6B verfügt insbesondere über die folgenden Funktionen: Aufgrund der geringen Kapazität des ChatGLM-6B-Modells gibt es jedoch zwangsläufig einige Einschränkungen und Mängel, darunter: Das GLM-Team gab an, dass ChatGLM immer noch weit hinter der internationalen Spitzenforschung und den Produkten für große Modelle zurückbleibt. Es wird auch in Zukunft weiterhin aktualisierte Versionen von ChatGLM und verwandten Modellen entwickeln und veröffentlichen. Das GLM-Team heißt außerdem jeden herzlich willkommen, ChatGLM-6B herunterzuladen und darauf basierend Forschung und (nichtkommerzielle) Anwendungsentwicklung durchzuführen. Open Source ChatGLM-6B

Das obige ist der detaillierte Inhalt vonChatGLM, das auf Tsinghua basierende Gigabit-Basiskonversationsmodell, hat interne Tests gestartet und ist eine Open-Source-Einzelkartenversion des Modells.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr