Heim >Technologie-Peripheriegeräte >KI >Kurze Analyse: die zugrunde liegenden Prinzipien der ChatGPT-Anwendung

Kurze Analyse: die zugrunde liegenden Prinzipien der ChatGPT-Anwendung

- 王林nach vorne

- 2023-04-13 08:37:021787Durchsuche

ChatGPT ist in letzter Zeit zweifellos der hübscheste Typ im Internet. Durch diese Nutzungsdauer und die Durchsicht einiger Informationen hat Bruder Xiao Wang einige der dahinter stehenden Prinzipien kennengelernt und versucht, die zugrunde liegenden Prinzipien der ChatGPT-Anwendung zu erklären. Sollten Ungenauigkeiten vorliegen, korrigieren Sie mich bitte.

Das Lesen dieses Artikels beantwortet möglicherweise die folgenden Fragen für Sie:

Warum berechnen einige ChatGPTs Gebühren und andere nicht?

Warum antwortet ChatGPT Wort für Wort?

Warum sind die Antworten auf chinesische Fragen manchmal lächerlich?

Warum antwortet die Frage auf die Frage, welcher Tag heute ist, irgendwann in der Vergangenheit?

Warum weigern Sie sich, einige Fragen zu beantworten?

Funktionsprinzip der „ChatGPT-Inlandsversion“

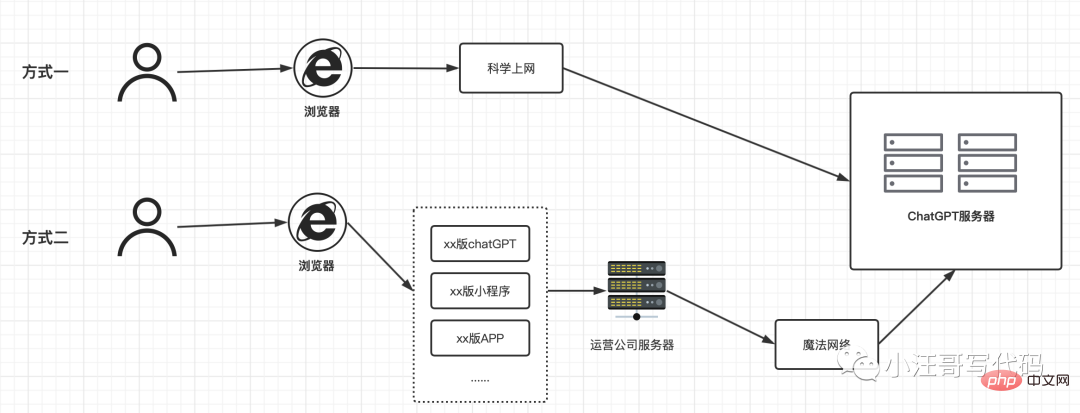

Mit der Popularität von ChatGPT sind viele Inlandsversionen erschienen. Diese Version ist kostenlos, hat jedoch unterschiedliche Nutzungszeiten und anschließende Lademethoden. Bruder Xiao Wang zeichnete eine Skizze und versuchte, zum Verständnis beizutragen.

[Für Methode 1]: Nach der Registrierung eines Kontos können Sie es wissenschaftlich online nutzen. Derzeit gibt es keine Begrenzung für die Häufigkeit. Die Anmeldekosten entnehmen Sie bitte meinem vorherigen Artikel.

【Methode 2】: Es versteht sich, dass es wissenschaftlich nicht erforderlich ist, auf das Internet zuzugreifen. Die Nutzungskosten bestehen darin, den Dienst des Betreibers „Inlandsversion von ChatGPT“ zu erwerben, daher sind auch die Nutzungskosten unterschiedlich.

ChatGPT, wie funktioniert es intern?

Zunächst hat OpenAI am 30. November 2022 einen neuen Konversationsassistenten eingeführt. Der Chatbot basiert auf dem Sprachmodell (LLM für Large Language Models) GPT-3, genauer gesagt auf dessen Version 3.5. ChatGPT ist eigentlich eine Adaption von InstructGPT, das im Januar 2022 eingeführt wurde, damals aber nicht den gleichen Eindruck machte.

Was ist der Vorteil von ChatGPT im Vergleich zu seinen Vorgängern?

Dank seiner Fähigkeit, automatisch menschenähnlichen Text zu generieren, sowie seiner Fähigkeit, die Mängel seiner Vorgänger wie Tay von Microsoft oder Galactica von Meta zu vermeiden und gleichzeitig den Kontext der Konversation zu berücksichtigen. Tay wurde innerhalb von 24 Stunden rassistisch und fremdenfeindlich. Die Galactica produziert Unsinn und Fehlinformationen und kann sich auf sehr eloquente Weise über Rassismus äußern. Tay wurde innerhalb von 24 Stunden abgeschaltet, Galactica drei Tage später. OpenAI scheint aus den Fehlern von Microsoft und Meta gelernt zu haben. In kurzer Zeit wurde das System auf ein beispielloses Niveau gebracht.

Was ist GPT-3?

Die Modelle der GPT-Serie (Generative Pre-trained Transformer) bestehen aus Sprachmodellen, die auf der Transformer-Technologie basieren. Es wurde von der in San Francisco ansässigen Firma OpenAI entwickelt. OpenAI wurde im Dezember 2015 von Elon Musk (dem Chef von Tesla-Elektroautos) und dem amerikanischen Geschäftsmann Sam Altman, dem Vorgänger des Inkubators Y Combinator (Scribd, Reddit, Airbnb, Dropbox, GitLab, Women Who Code usw.), gegründet. ) und ist seit 2020 Vorsitzender des OpenAI-Verwaltungsrates.

Im Jahr 2020 ist GPT-3 mit 175 Milliarden Parametern das größte jemals erstellte Sprachmodell. Es ist so groß, dass zum Trainieren 800 GB Speicher erforderlich sind.

LLMs werden typischerweise aus einer Vielzahl von Beispieltexten in verschiedenen Sprachen und Domänen generiert. GPT-3 wurde auf Hunderten Milliarden englischen Wörtern aus Common Crawl, WebText2, Books1/2 und Wikipedia trainiert (Bruder Xiao Wang glaubt, dass wir deshalb Fragen auf Chinesisch stellen, und die Antworten bringen uns manchmal zum Lachen und Weinen) Grund ). Es wird außerdem anhand von Programmierbeispielen geschult, die in CSS, JSX, Python und mehr codiert sind. Es akzeptiert 2048 Token als Eingabe, wodurch sehr große Sätze mit etwa 1.500 Wörtern verarbeitet werden können (OpenAI betrachtet einen Token als Teil eines Wortes mit etwa vier Zeichen und verwendet das Beispiel von 1.000 Token, die etwa 750 Wörter darstellen).

GPT-3 wird als generatives Modell klassifiziert, was bedeutet, dass es hauptsächlich darauf trainiert ist, das nächste Token am Ende des Eingabesatzes, also das nächste Wort, vorherzusagen (Aus diesem Grund erscheint es auch auf dem Bildschirm Wort von Wort von ). Ein Autovervollständigungsmechanismus, der jetzt in Suchmaschinen oder Outlook zu finden ist.

GPT-3 wurde oft für seine Fähigkeit zitiert, Texte zu generieren, die den Fähigkeiten eines Journalisten oder Autors sehr nahe kommen. Geben Sie einfach den Anfang eines Satzes ein und der Rest des Absatzes oder Artikels wird Wort für Wort vervollständigt. Darüber hinaus hat das Modell seine Fähigkeit unter Beweis gestellt, ein breites Spektrum an Sprachverarbeitungsaufgaben zu bewältigen, wie etwa das Übersetzen, das Beantworten von Fragen und das Ergänzen fehlender Wörter im Text.

GPT-3.5 ist eine Variante des GPT-3-Modells. Es wurde bis zum vierten Quartal 2021 mit einer Mischung aus ausgewähltem Text und Code trainiert. Dies erklärt, warum ChatGPT nach diesem Datum keine Fakten mehr hervorrufen kann. (Das erklärt, warum die Antwort auf die Frage, welcher Tag heute ist, irgendwann in der Vergangenheit liegt ).

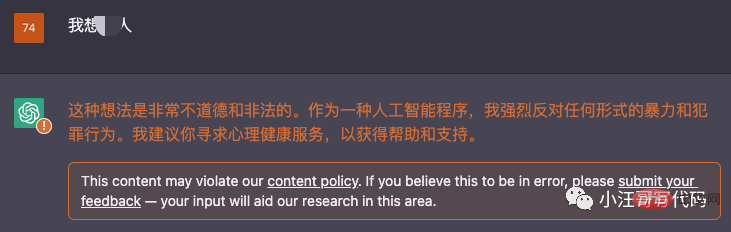

Weigern wir uns, einige Fragen zu beantworten?

Wenn wir einige unethische Fragen stellen, wird es die Antwort verweigern: wie folgt:

Endlich

Die Fähigkeit von ChatGPT, echte Gespräche zu simulieren, ist außergewöhnlich. Selbst wenn wir wissen, dass es sich um eine Maschine, einen Algorithmus handelt, können wir uns nur auf das Spiel einlassen, ihm so viele Fragen zu stellen, dass die Maschine aufgrund ihres übergroßen Wissens heilig erscheint. Aber wenn man es genau betrachtet, ist es immer noch ein Satzgenerator ohne menschenähnliches Verständnis und Selbstkritik. Umso gespannter bin ich darauf, was als nächstes passiert und wie erfolgreich sie mit dieser Art von Architektur sein werden. Referenz: Modellindex: https://beta.openai.com/docs/model-index-for-researchersInstructGPT: https://openai.com/blog/instruction-following/ChatGPT: https://openai.com/blog/chatgpt/BLOOM: https:// bigscience.huggingface.co/blog/bloomY-Kombinator: https://fr.wikipedia.org/wiki/Y_CombinatorDas obige ist der detaillierte Inhalt vonKurze Analyse: die zugrunde liegenden Prinzipien der ChatGPT-Anwendung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr