Heim >Technologie-Peripheriegeräte >KI >Das erste Diffusionsmodell zur Zielerkennung ist besser als Faster R-CNN und DETR und erkennt direkt anhand zufälliger Frames

Das erste Diffusionsmodell zur Zielerkennung ist besser als Faster R-CNN und DETR und erkennt direkt anhand zufälliger Frames

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-13 08:34:07958Durchsuche

Diffusionsmodell hat als neues SOTA in Deep-Generation-Modellen das ursprüngliche SOTA bei Bilderzeugungsaufgaben wie GAN übertroffen und weist in vielen Anwendungsbereichen wie Computer Vision, NLP und molekularer Grafikmodellierung eine hervorragende Leistung auf Serienmodellbau usw.

Kürzlich haben das Team von Luo Ping von der Universität Hongkong und Forscher vom Tencent AI Lab gemeinsam ein neues Framework DiffusionDet vorgeschlagen, das das Diffusionsmodell auf die Zielerkennung anwendet. Soweit wir wissen, gibt es keine Forschung, die das Diffusionsmodell erfolgreich auf die Zielerkennung anwenden kann. Man kann sagen, dass dies die erste Arbeit ist, die das Diffusionsmodell zur Zielerkennung verwendet.

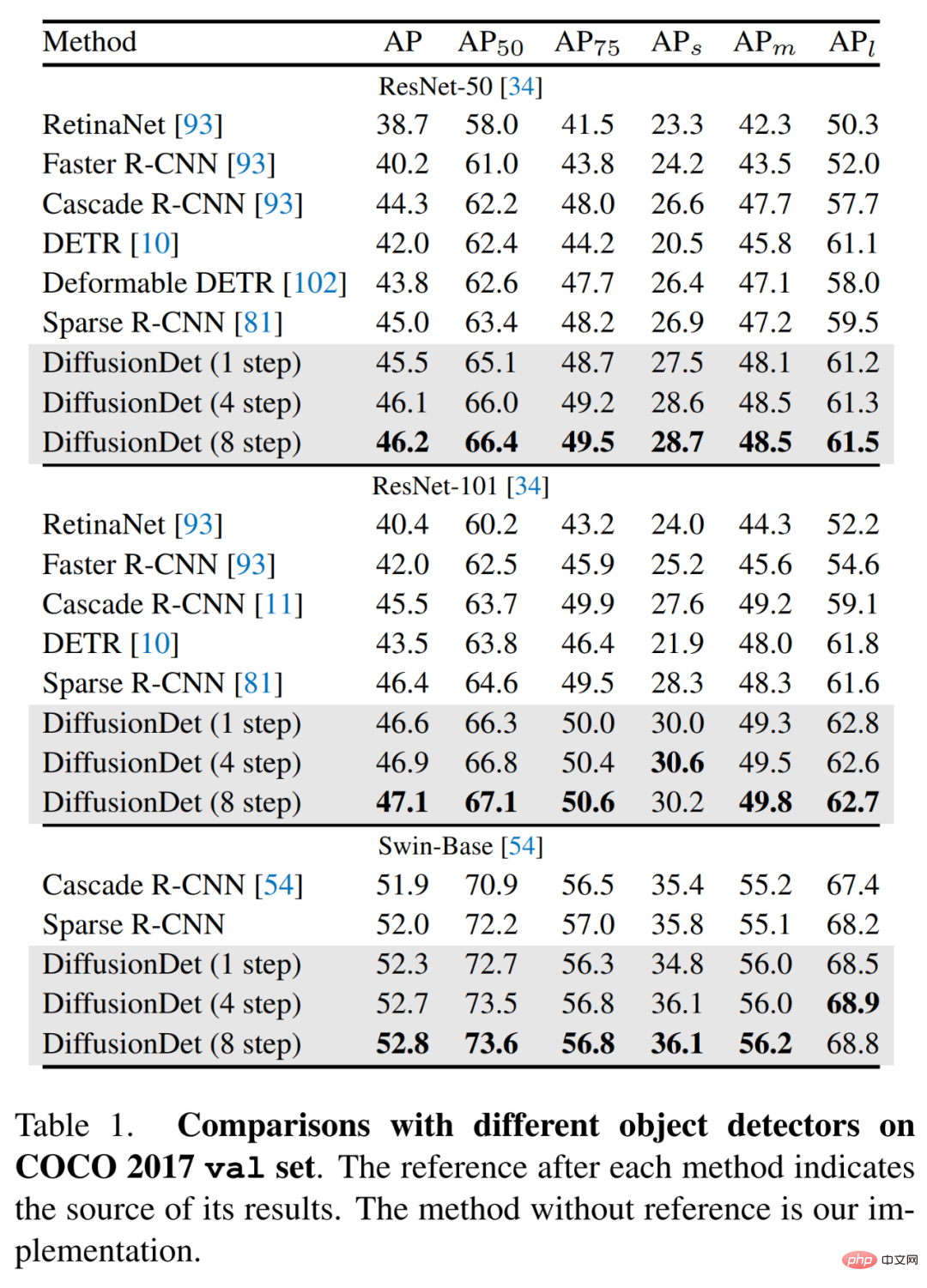

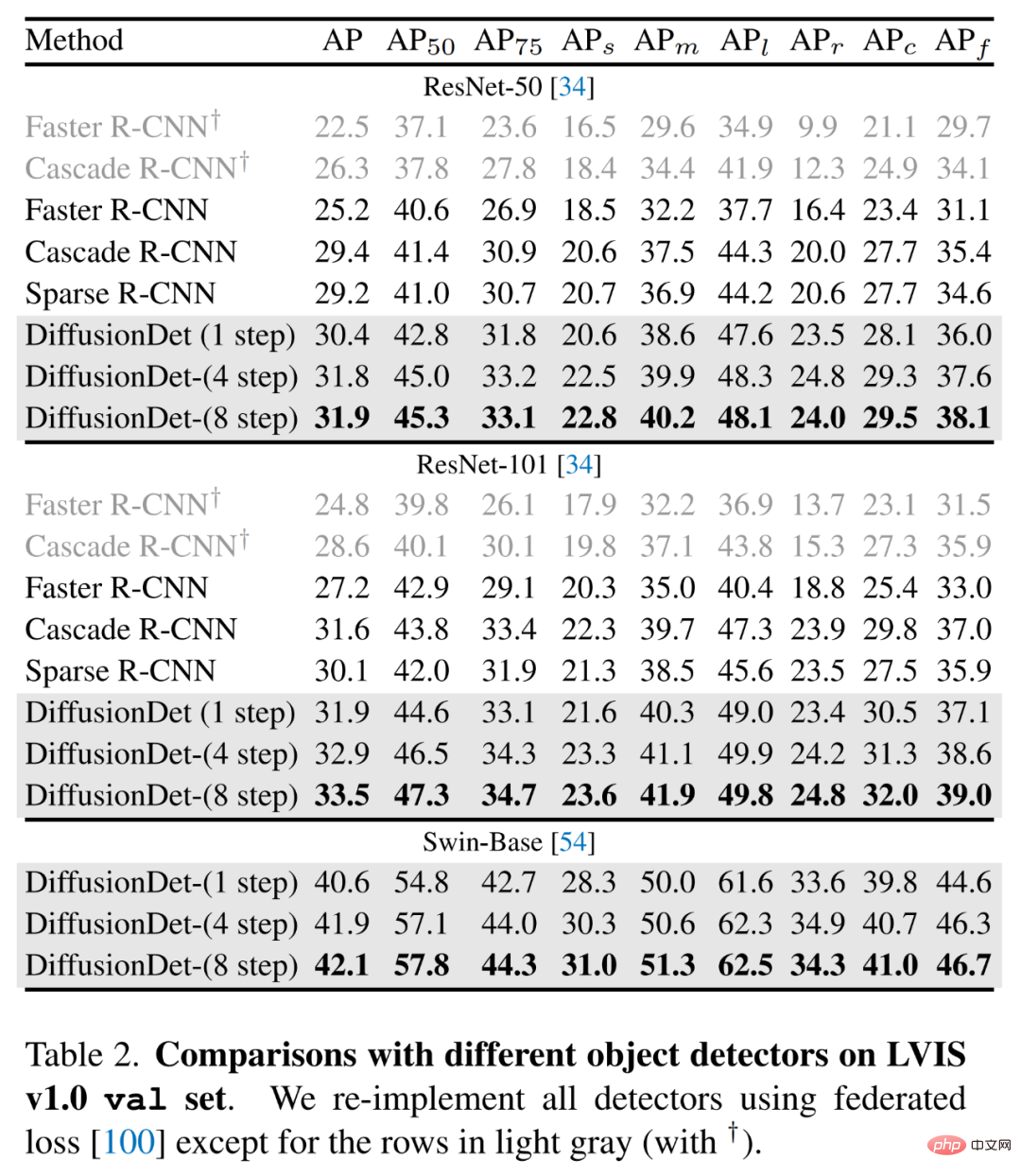

Wie ist die Leistung von DiffusionDet? Ausgewertet am MS-COCO-Datensatz unter Verwendung von ResNet-50 als Rückgrat und in einem einzigen Stichprobenschritt erreicht DiffusionDet 45,5 AP, deutlich besser als Faster R-CNN (40,2 AP), DETR (42,0 AP) und vergleichbar mit Sparse R-CNN (45,0 AP) ist gleichwertig. Durch die Erhöhung der Anzahl der Abtastschritte wird die DiffusionDet-Leistung weiter auf 46,2 AP verbessert. Darüber hinaus schnitt DiffusionDet auch beim LVIS-Datensatz gut ab und erreichte 42,1 AP mit Swing-Base als Rückgrat.

- Papieradresse: https://arxiv.org/pdf/2211.09788.pdf

- Projektadresse: https://github.com/ShoufaChen/DiffusionDet

Die Studie ergab, dass die herkömmliche Objekterkennung einen Fehler aufweist, der auf einem festen Satz lernbarer Abfragen beruht. Dann fragten sich die Forscher: Gibt es eine einfache Möglichkeit zur Objekterkennung, die nicht einmal lernbare Abfragen erfordert?

Um diese Frage zu beantworten, schlägt dieses Papier DiffusionDet vor, ein Framework, das Ziele direkt aus einer Reihe von Zufallsboxen erkennen kann. Es formuliert die Zielerkennung als einen Entrauschungsdiffusionsprozess von der Rauschbox zur Zielbox. Dieser Noise-to-Box-Ansatz erfordert weder heuristische Zielvorgaben noch lernbare Abfragen, was die Zielkandidaten weiter vereinfacht und die Erkennungspipelines verbessert.

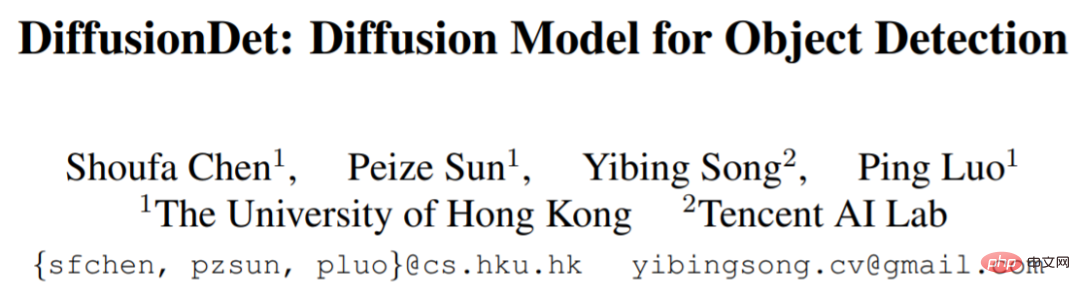

Wie in Abbildung 1 unten dargestellt, geht diese Studie davon aus, dass das Noise-to-Box-Paradigma dem Noise-to-Image-Prozess im Entrauschungsdiffusionsmodell ähnelt. Letzteres ist eine Art wahrscheinlichkeitsbasiertes Modell, das verwendet wird Das erlernte Rauschmodell entfernt nach und nach das Rauschen im Bild, um das Bild zu erzeugen.

DiffusionDet löst die Zielerkennungsaufgabe durch das Diffusionsmodell, das heißt, die Erkennung wird als Generierungsaufgabe in der Position (Mittelkoordinaten) und Größe (Breite und Höhe) des Begrenzungsrahmens im Bild betrachtet . In der Trainingsphase wird Gaußsches Rauschen, das durch die Varianztabelle (Zeitplan) gesteuert wird, zur Grundwahrheitsbox hinzugefügt, um die Rauschbox zu erhalten. Diese verrauschten Boxen werden dann verwendet, um Regionen von Interesse (RoI) aus den Ausgabe-Feature-Maps von Backbone-Encodern (wie ResNet, Swin Transformer) auszuschneiden. Schließlich werden diese RoI-Merkmale an den Erkennungsdecoder gesendet, der darauf trainiert ist, die Ground-Truth-Box ohne Rauschen vorherzusagen. In der Inferenzphase generiert DiffusionDet Begrenzungsrahmen durch Umkehrung des erlernten Diffusionsprozesses, wodurch die Rauschvorverteilung an die erlernte Verteilung auf dem Begrenzungsrahmen angepasst wird.

Methodenübersicht

Da das Diffusionsmodell iterativ Datenproben generiert, muss das Modell f_θ während der Inferenzphase mehrmals ausgeführt werden. Die direkte Anwendung von f_θ auf das Originalbild bei jedem Iterationsschritt ist jedoch rechentechnisch schwierig. Daher schlugen die Forscher vor, das gesamte Modell in zwei Teile zu unterteilen, nämlich den Bildcodierer und den Erkennungsdecoder. Ersterer wird nur einmal ausgeführt, um die Tiefenmerkmalsdarstellung aus dem ursprünglichen Eingabebild zu extrahieren und die Boxvorhersagen in z_t schrittweise zu verfeinern.

Der Bildencoder verwendet das Rohbild als Eingabe und extrahiert seine High-Level-Funktionen für den Erkennungsdecoder. Forscher verwenden Faltungs-Neuronale Netze wie ResNet und Transformer-basierte Modelle wie Swin, um DiffusionDet zu implementieren. Mittlerweile werden Feature-Pyramiden-Netzwerke verwendet, um Feature-Maps mit mehreren Maßstäben für ResNet- und Swin-Backbone-Netzwerke zu generieren.

Der Erkennungsdecoder lehnt sich an Sparse R-CNN an, nimmt eine Reihe von Vorschlagsboxen als Eingabe, schneidet RoI-Features aus der vom Bildencoder generierten Feature-Map aus und sendet sie an den Erkennungskopf, um Box-Regressions- und Klassifizierungsergebnisse zu erhalten. Darüber hinaus besteht der Detektionsdecoder aus 6 kaskadierten Stufen.

Training

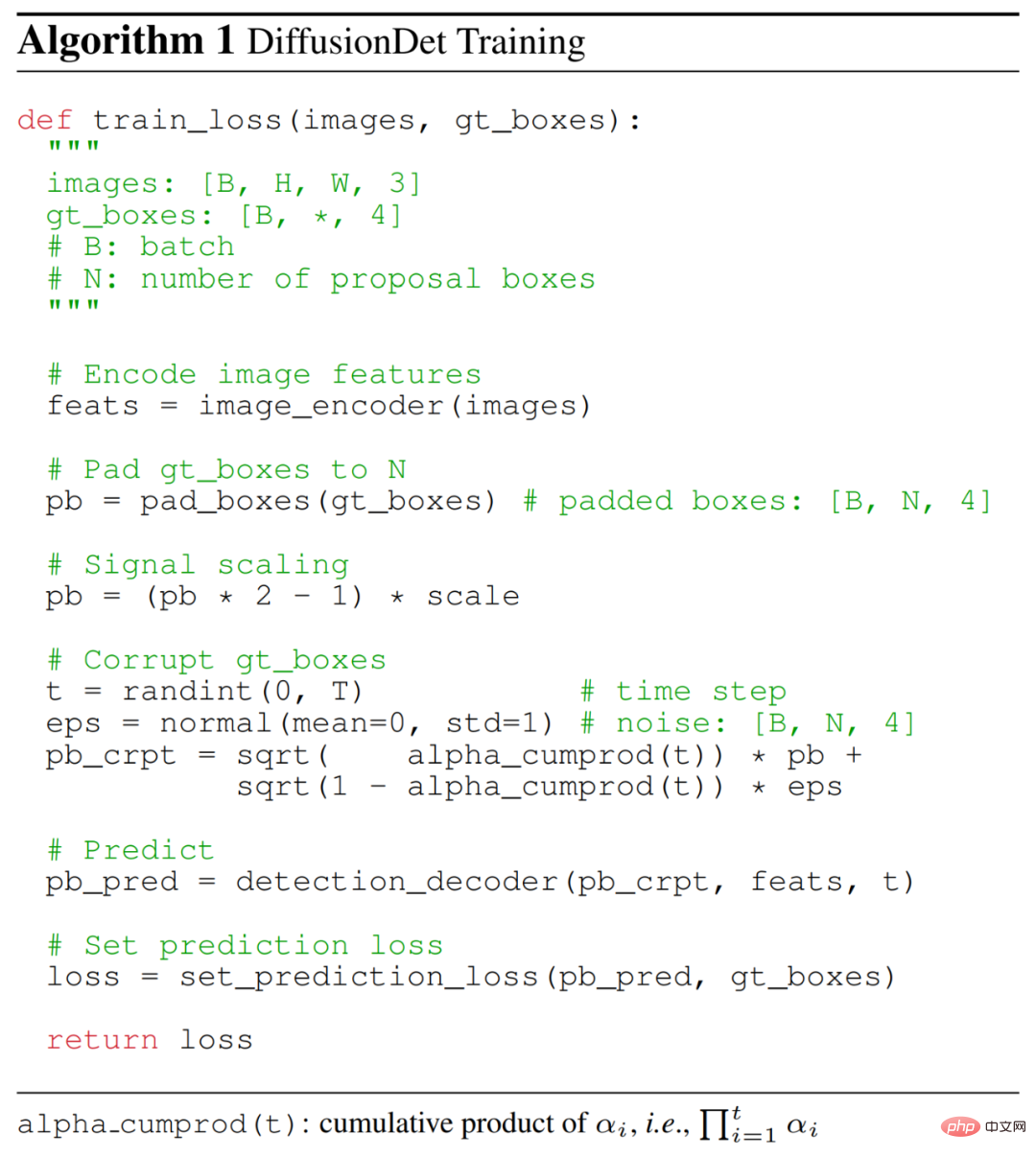

Während des Trainingsprozesses konstruierten die Forscher zunächst den Diffusionsprozess von der True-Value-Box zur Noise-Box und trainierten dann das Modell, um diesen Prozess umzukehren. Der folgende Algorithmus 1 stellt den Pseudocode des DiffusionDet-Trainingsprozesses bereit.

Wahrheitskastenfüllung. Bei modernen Objekterkennungs-Benchmarks variiert die Anzahl der interessierenden Instanzen oft von Bild zu Bild. Daher füllen wir zunächst einige zusätzliche Kästchen zu den ursprünglichen Grundwahrheitskästen, sodass alle Kästchen zu einer festen Zahl N_train summiert werden. Sie untersuchten verschiedene Füllstrategien, wie etwa die Wiederholung vorhandener Ground-Truth-Boxen, die Verkettung zufälliger Boxen oder Boxen in Bildgröße.

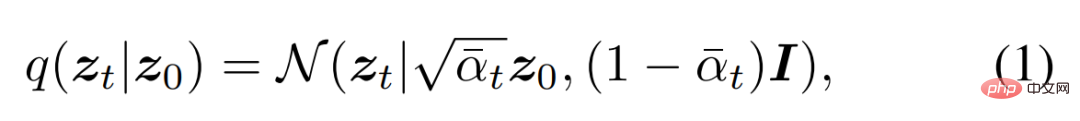

Rahmen beschädigt. Der Forscher fügt der gefüllten Ground-Truth-Box Gaußsches Rauschen hinzu. Die Rauschskala wird durch α_t in der folgenden Formel (1) gesteuert, die eine monoton abnehmende Kosinusplanung in verschiedenen Zeitschritten t anwendet.

Trainingsausfall. Der Erkennungsdecoder verwendet N_train-beschädigte Boxen als Eingabe und sagt N_train-Vorhersagen der Klassenklassifizierung und Boxkoordinaten voraus. Wenden Sie auch den Satzvorhersageverlust auf den N_train-Vorhersagesatz an.

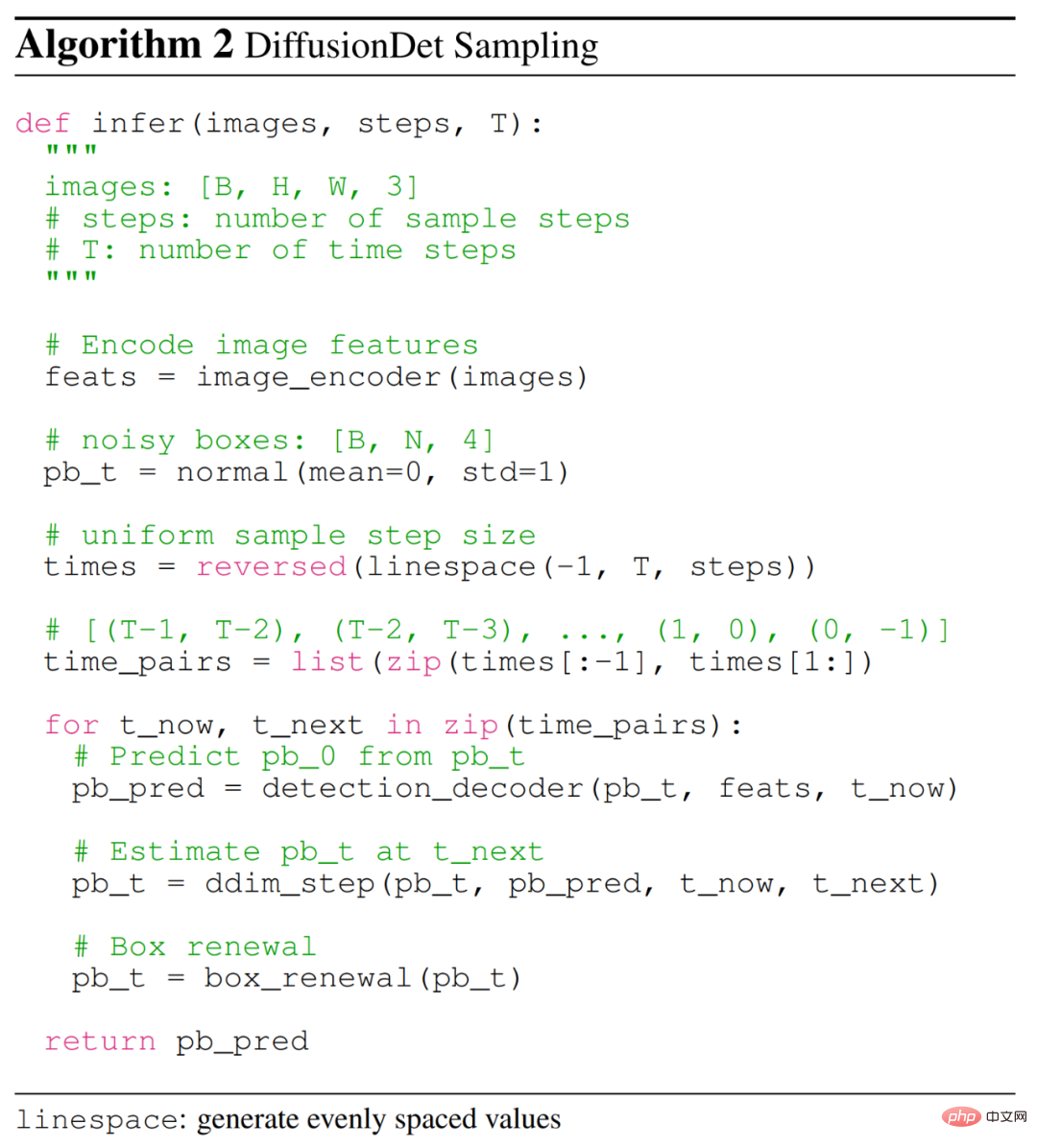

Inferenz

Der Inferenzprozess von DiffusionDet ist ein Entrauschungs-Abtastprozess vom Rauschen bis zum Zielrahmen. Ausgehend von einem Kasten, der anhand einer Gaußschen Verteilung abgetastet wurde, verfeinert das Modell schrittweise seine Vorhersagen, wie in Algorithmus 2 unten dargestellt.

Probenahmeschritte. Bei jedem Sampling-Schritt werden Zufallsboxen oder geschätzte Boxen aus dem vorherigen Sampling-Schritt an den Erkennungsdecoder gesendet, um die Klassenklassifizierung und die Boxkoordinaten vorherzusagen. Nachdem die Box des aktuellen Schritts ermittelt wurde, wird DDIM verwendet, um die Box des nächsten Schritts zu schätzen.

Box-Updates. Um die Inferenz besser mit dem Training in Einklang zu bringen, schlagen wir eine Box-Aktualisierungsstrategie vor, um unerwartete Boxen wiederherzustellen, indem sie durch zufällige Boxen ersetzt werden. Konkret filtern sie zunächst unerwartete Boxen mit Werten unter einem bestimmten Schwellenwert heraus und verketten dann die verbleibenden Boxen mit neuen Zufallsboxen, die aus einer Gaußschen Verteilung entnommen werden.

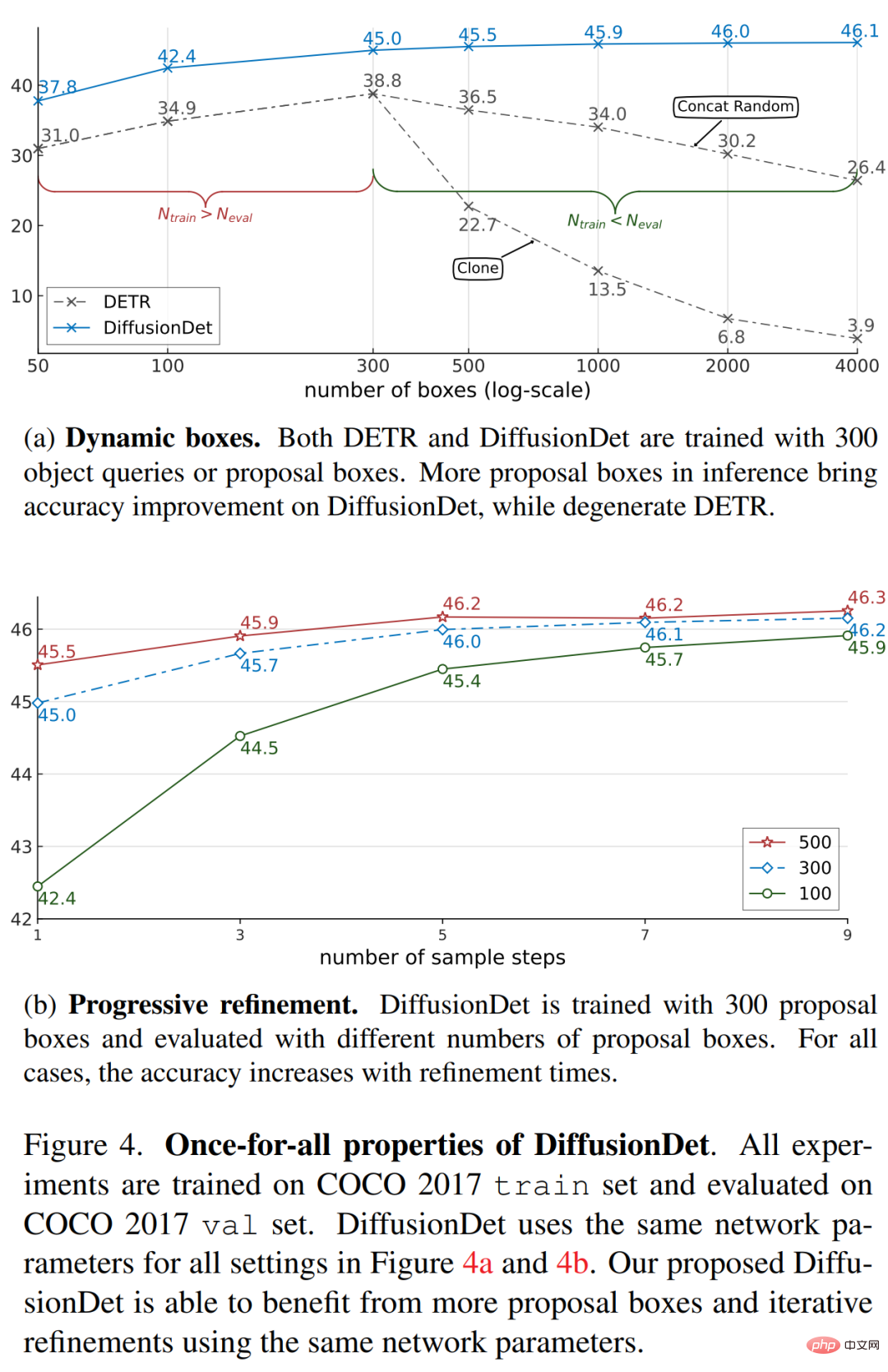

Ein für alle Mal. Dank des randomisierten Boxdesigns können Forscher DiffusionDet mithilfe einer beliebigen Anzahl von Zufallsboxen und Stichprobenschritten bewerten. Zum Vergleich: Frühere Methoden stützen sich während des Trainings und der Auswertung auf die gleiche Anzahl von Verarbeitungsboxen, und der Erkennungsdecoder wird im Vorwärtsdurchlauf nur einmal verwendet.

Experimentelle Ergebnisse

Im experimentellen Teil demonstrierten die Forscher zunächst die Once-for-all-Eigenschaft von DiffusionDet und verglichen DiffusionDet dann mit früheren ausgereiften Detektoren anhand der MS-COCO- und LVIS-Datensätze.

Die Hauptfunktion von DiffusionDet besteht darin, alle Inferenzinstanzen einmal zu trainieren. Sobald das Modell trainiert ist, kann es verwendet werden, um die Anzahl der Boxen und Beispielschritte in der Inferenz zu ändern, wie in Abbildung 4 unten dargestellt. DiffusionDet kann durch die Verwendung von mehr Boxen und/oder mehr Verfeinerungsschritten eine höhere Genauigkeit erreichen, jedoch auf Kosten einer höheren Latenz. Daher haben wir ein einzelnes DiffusionDet für mehrere Szenarien bereitgestellt und den gewünschten Kompromiss zwischen Geschwindigkeit und Genauigkeit erreicht, ohne das Netzwerk neu zu trainieren.

Die Forscher verglichen DiffusionDet mit früheren Detektoren auf den MS-COCO- und LVIS-Datensätzen, wie in Tabelle 1 unten gezeigt. Sie verglichen zunächst die Objekterkennungsleistung von DiffusionDet mit früheren Detektoren auf MS-COCO. Die Ergebnisse zeigen, dass DiffusionDet ohne den Verfeinerungsschritt mit dem ResNet-50-Backbone-Netzwerk 45,5 AP erreicht und damit frühere ausgereifte Methoden wie Faster R-CNN, RetinaNet, DETR und Sparse R-CNN bei weitem übertrifft. Und DiffusionDet zeigt eine stabile Verbesserung, wenn die Größe des Backbone-Netzwerks vergrößert wird.

Die Ergebnisse des anspruchsvolleren LVIS-Datensatzes sind in Tabelle 2 unten aufgeführt, die unter „DiffusionDet“ zu sehen ist kann mit weiteren Verfeinerungsschritten erhebliche Gewinne erzielen.

Weitere experimentelle Details finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonDas erste Diffusionsmodell zur Zielerkennung ist besser als Faster R-CNN und DETR und erkennt direkt anhand zufälliger Frames. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr