Heim >Technologie-Peripheriegeräte >KI >Neue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos

Neue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 22:01:011476Durchsuche

Quantenüberlegenheit, diesen Begriff gibt es schon seit fast 4 Jahren.

Im Jahr 2019 gaben Google-Physiker bekannt, dass sie mit einer 53-Qubit-Maschine erfolgreich die Quantenhegemonie erreicht hatten, was einen bedeutenden symbolischen Meilenstein darstellt.

In einem in Nature veröffentlichten Artikel wurde festgestellt, dass das Quantensystem nur 200 Sekunden brauchte, um eine Berechnung durchzuführen, während die gleiche Berechnung mit Summit, dem damals leistungsstärksten Supercomputer, etwa 10.000 Jahre dauerte.

Was ist Quantenüberlegenheit?

Die sogenannte „Quantenhegemonie“ oder „Quantenvorteil“ (im Folgenden „Quantenüberlegenheit“ genannt) bedeutet, dass die Aufgaben, die Quantencomputer erledigen können, über den Rahmen jedes möglichen klassischen Algorithmus hinausgehen.

Selbst wenn diese Aufgaben auf den fortschrittlichsten herkömmlichen Supercomputern ausgeführt werden, verliert der Algorithmus aufgrund der langen Berechnungszeit (oft Tausende von Jahren) seine praktische Bedeutung.

Interessanterweise heißt es in den Ergebnissen von Google im Jahr 2019 nur, dass die Quantenhegemonie erreicht wurde, erklärt aber nicht, in welchen konkreten Fällen Quantencomputer klassische Computer übertreffen.

Diese Frage ist schwer zu beantworten, da Quantencomputer derzeit von Fehlern geplagt werden, die sich ansammeln und die Leistung und Stabilität des Quantencomputings beeinträchtigen können.

Tatsächlich wollen Wissenschaftler im Vergleich zum Bereich der Verwirklichung der Quantenhegemonie eine andere Frage mehr wissen: Wenn Quantencomputer immer größer werden, ob klassische Algorithmen mithalten können.

Scott Aaronson, Informatiker an der University of Texas in Austin, sagte: „Wir hoffen, dass sich die Quantenseite irgendwann vollständig distanziert und diesen Wettbewerb vollständig beendet.“

Das spekulieren die meisten Forscher , Die Antwort ist nein.

Das heißt, klassische Algorithmen werden eines Tages überhaupt nicht mehr in der Lage sein, mit dem Tempo des Quantencomputings mitzuhalten, aber es ist ihnen nicht gelungen, dies genau und umfassend zu beweisen. Eine Möglichkeit, diese Schlussfolgerung endgültig zu beweisen, besteht darin, die Bedingungen zu finden, unter denen Quantencomputer einen „dauerhaften Vorteil“ gegenüber herkömmlichen Computern erzielen können.

Nun scheint es auf diese Frage eine vorläufige Antwort zu geben:

Zeitersparnis: Wenn die Fehlerkorrektur nicht mithalten kann, brechen solche Fehler die ideale „Quantenhegemonie“, die die Klassik ermöglicht Algorithmen, um mit Quantenalgorithmen Schritt zu halten.

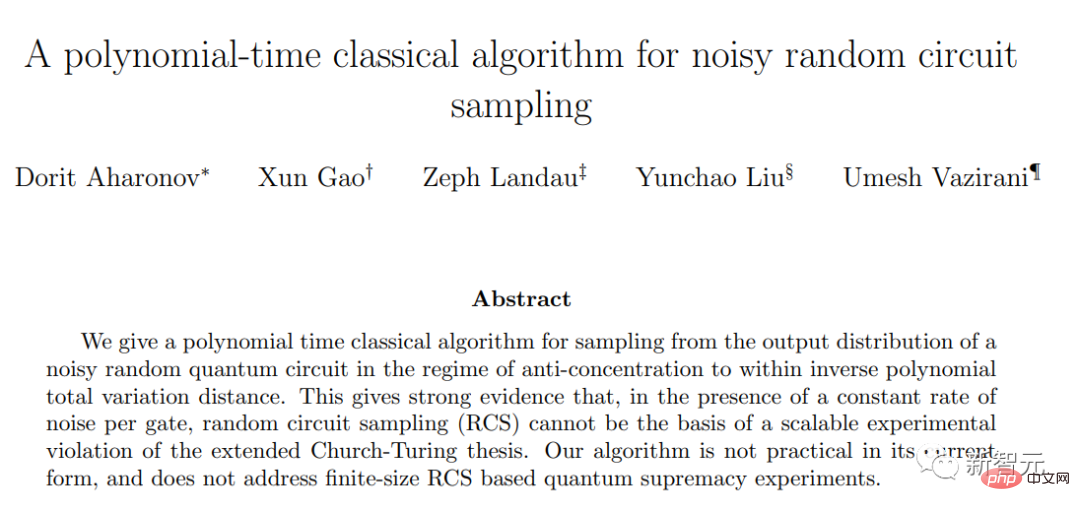

Kürzlich hat ein gemeinsames Team der Harvard University, der University of California, Berkeley und der Hebrew University in Israel in einem auf Arxiv veröffentlichten Preprint-Artikel einen großen Schritt unternommen, um diese Schlussfolgerung zu bestätigen.

Sie zeigten, dass eine gezielte Fehlerkorrektur eine notwendige Voraussetzung für eine dauerhafte Quantenüberlegenheit beim Zufallsschaltkreis-Sampling ist, und stützten damit die Schlussfolgerungen der Google-Forschung vor einigen Jahren. Auf dem aktuellen Niveau der Quantenfehlerkorrektur gibt es tatsächlich keine Quantenüberlegenheit.

Es gibt keine „goldene Zone“ mehr für die Quantenüberlegenheit

Die Forscher haben einen klassischen Algorithmus entwickelt, der Zufallsstichprobenexperimente simulieren kann, wenn Fehler vorliegen, um diese Schlussfolgerung zu beweisen.

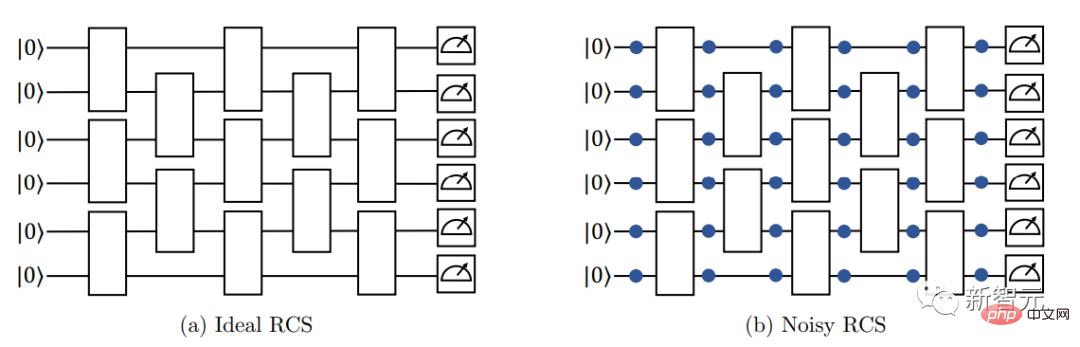

Beginnen Sie mit einer Reihe von Qubits und manipulieren Sie diese Qubits nach dem Zufallsprinzip mithilfe von Operationen, die „Quantengatter“ genannt werden. Einige Quantengatter führen dazu, dass Paare von Qubits miteinander verschränkt werden, was bedeutet, dass sie einen gemeinsamen Quantenzustand haben, der nicht einzeln beschrieben werden kann.

Das wiederholte Einrichten dieser Quantengatter in mehrschichtigen Schaltkreisen kann es Qubits ermöglichen, in komplexere verschränkte Zustände einzutreten.

Um diesen Quantenzustand zu verstehen, haben die Forscher alle Qubits im Array gemessen. Dieses Verhalten führt dazu, dass der kollektive Quantenzustand aller Qubits in eine zufällige Folge gewöhnlicher Bits, nämlich Nullen und Einsen, zusammenfällt.

Die Anzahl der möglichen Ergebnisse wächst schnell mit der Anzahl der Qubits im Array. Im Google-Experiment von 2019 enthielten 53 Qubits fast 10 Billionen Ergebnisse.

Darüber hinaus erfordert diese Methode mehrere wiederholte Messungen aus einem Zufallsschaltkreis, um eine Wahrscheinlichkeitsverteilungskarte der Ergebnisse zu erstellen.

Die Frage zur Quantenüberlegenheit ist, ist es schwierig oder sogar unmöglich, diese Wahrscheinlichkeitsverteilung mit einem klassischen Algorithmus zu imitieren, der keine Verschränkung verwendet?

Im Jahr 2019 haben Google-Forscher bewiesen, dass dieses Ziel für fehlerfreie Quantenschaltungen, die keine Fehler erzeugen, schwierig ist. Es ist in der Tat schwierig, ein zufälliges Schaltkreis-Sampling-Experiment mit klassischen Algorithmen fehlerfrei zu simulieren.

Aus der Perspektive der Rechenkomplexität nimmt die Rechenkomplexität herkömmlicher Klassifizierungsalgorithmen exponentiell zu, wenn die Anzahl der Qubits zunimmt, während die Rechenkomplexität von Quantenalgorithmen polynomial zunimmt.

Wenn n groß genug ansteigt, bleibt ein Algorithmus, der in n exponentiell ist, weit hinter jedem Algorithmus zurück, der in n polynomial ist.

Das ist der Unterschied, auf den wir uns beziehen, wenn wir über ein Problem sprechen, das für einen klassischen Computer schwierig, für einen Quantencomputer jedoch einfach ist. Die besten klassischen Algorithmen benötigen exponentielle Zeit, während Quantencomputer Probleme in polynomieller Zeit lösen können.

Allerdings wurden in der Arbeit von 2019 die Auswirkungen von Fehlern, die durch unvollständige Quantengatter verursacht werden, nicht berücksichtigt, und die Schlussfolgerung der Forschung hinterließ tatsächlich eine Lücke. Mit anderen Worten: Kann eine zufällige Schaltungsabtastung ohne Fehlerkorrektur immer noch eine Quantenhegemonie erreichen?

Wenn man die akkumulierten Fehler berücksichtigt, die bei der Quantenverschränkung entstehen, wird sich tatsächlich die Schwierigkeit der Simulation von Experimenten mit Zufallsschaltungsabtastung mit klassischen Algorithmen erheblich verringern. Und wenn die Rechenkomplexität der klassischen Algorithmussimulation auf das gleiche Polynomniveau wie bei Quantenalgorithmen reduziert wird, wird es keine Quantenhegemonie mehr geben.

Diese neue Arbeit zeigt, dass es unter der Annahme, dass die Schaltkreistiefe konstant gehalten wird, sagen wir, sehr flache 3 Schichten, mit zunehmender Anzahl von Qubits nicht zu viel Quantenverschränkung gibt und die Ausgabe immer noch klassisch simuliert werden kann.

Wenn andererseits die Schaltungstiefe erhöht wird, um mit der zunehmenden Anzahl von Qubits Schritt zu halten, dann wird der kumulative Effekt von Quantengatterfehlern die durch die Verschränkung verursachte Komplexität verwässern und es wird immer noch einfacher, sie zu simulieren Ausgabe mit klassischen Algorithmen.

Zwischen den beiden gibt es eine „goldene Zone“, also das Fenster, in dem die Quantenhegemonie weiterhin überleben kann, also den Bereich, in dem herkömmliche Algorithmussimulationen mit der Quantenverschränkung nicht mithalten können.

Vor der Veröffentlichung dieses Artikels bestand die Quantenüberlegenheit immer noch, wenn die Anzahl der Qubits einen bestimmten Zwischenbereich erreichte, selbst als die Anzahl der Qubits zunahm.

Bei dieser Schaltungstiefe ist es schwierig, den klassischen Algorithmus bei jedem Schritt zu simulieren, auch wenn die Ausgabe aufgrund von Quantenalgorithmusfehlern stetig abnimmt.

Dieses neue Papier beseitigt diese „goldene Zone“ fast.

In der Arbeit wird ein klassischer Algorithmus zur Simulation zufälliger Schaltkreisabtastung abgeleitet und bewiesen, dass seine Laufzeit eine

Polynomfunktionder Zeit ist, die zum Ausführen des entsprechenden Quantenexperiments erforderlich ist, und nicht eine Exponentialfunktion. Dieses Ergebnis stellt einen engen theoretischen Zusammenhang zwischen der Geschwindigkeit der klassischen Methode der Zufallsschaltungsabtastung und der Quantenmethode her, das heißt, es erklärt, dass die in der Theorie erreichte Quantenhegemonie in der Praxis fast nicht existiert.

Der Grund, warum ich „fast“ sage, liegt darin, dass die Grundannahmen des neuen Algorithmus für einige flachere Schaltkreise ungültig sind und eine unbekannte „kleine Lücke“ hinterlässt.

Allerdings hegen nur wenige Forscher noch die Hoffnung, in dieser Lücke die Quantenüberlegenheit zu erreichen. Sogar Bill Fefferman, Informatiker an der University of Chicago und einer der Autoren des Google-Artikels von 2019, sagte: „Ich denke, die Chance ist ziemlich gering.“

Man kann sagen, dass nach den strengen Standards der rechnerischen Komplexitätstheorie die Zufallsschaltungsabtastung keine Quantenüberlegenheit mehr erzeugen wird.

Angesichts dieser Schlussfolgerung sind sich alle Forscher außerdem darüber einig, wie entscheidend die Quantenfehlerkorrektur für den langfristigen Erfolg des Quantencomputings sein wird. Fefferman sagte: „Am Ende haben wir herausgefunden, dass die Quantenfehlerkorrektur die Lösung ist.“

Das obige ist der detaillierte Inhalt vonNeue Forschungsergebnisse aus Stanford und Berkeley stürzen Googles „Quantenüberlegenheit'! In der Theorie schön, in der Praxis jedoch nutzlos. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr