Heim >Technologie-Peripheriegeräte >KI >Kavita Bala, Dekanin der Cornell School of Computing: Was ist das „Metaversum'? Gottes Auge kann durch KI geboren werden

Kavita Bala, Dekanin der Cornell School of Computing: Was ist das „Metaversum'? Gottes Auge kann durch KI geboren werden

- 王林nach vorne

- 2023-04-12 21:58:06807Durchsuche

Dieser Artikel wurde von Lei Feng.com reproduziert. Wenn Sie einen Nachdruck benötigen, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Genehmigung zu beantragen.

Meine Forschung in den letzten Jahren konzentrierte sich hauptsächlich auf das visuelle Erscheinungsbild und das Verständnis, von der Mikrometerauflösung bis zur Weltklasse. Bevor ich mit meiner Rede beginne, möchte ich Ihnen ein sehr interessantes Beispiel zeigen. Die visuelle Schnittstelle zwischen dem Protagonisten und der Welt in diesem Film ist sehr interessant.

Sie können sehen, dass, wenn diese Person in der realen Welt geht, eine Reihe von Texten auf ihrer visuellen Oberfläche erscheint. Der Protagonist ist ein Autofan, daher zeigt ihm die visuelle Oberfläche zahlreiche Informationen über das Auto:

Mit nur einem Foto kann Ihnen die visuelle Oberfläche alle Informationen über das Auto liefern. Wir brauchen Forschung in den Bereichen Computer Vision und visuelles Verständnis, um diese Technologie voranzutreiben.

Der Protagonist geht weiter und wenn man sich diesen Modellen nähert, wird man feststellen, dass es sich nicht um echte Menschen handelt, obwohl sie sehr realistisch aussehen. Um eine solche Technologie zu erreichen, müssen wir das „realistische Erscheinungsbild“ studieren.

inverse Grafiken“, um alle Attribute des Produkts zu digitalisieren und mit interaktiven Elementen abzugleichen.

Ich zeige Ihnen die verschiedenen Technologien, die wir entwickeln. Sie haben sicher schon viel über Augmented Reality/Mixed Reality gehört. Was ich gerade erwähnt habe, sind die Technologien, die derzeit die Entwicklung von Augmented Reality vorantreiben. Heute werde ich mich auf die visuelle Technologie konzentrieren.Ein Modell sieht so echt aus, dass man nicht erkennen kann, ob es echt oder gefälscht ist. Das ist die realistische Erscheinung im Bereich der Computergrafik. Es gibt eine andere Richtung in diesem Bereich, nämlich das Fotografieren eines Objektfotos, wie verstehen wir alle Eigenschaften der Objekte auf diesem Foto? Dann können wir uns auf dieser Grundlage weiterentwickeln, um die Eigenschaften dieser Welt zu verstehen.

Das sind die drei Hauptinhalte, über die ich heute sprechen werde:

- Physikbasierte visuelle Erscheinungsmodelle(Physikbasierte visuelle Erscheinungsmodelle)

- Inverse Grafiken(Inverse Grafiken )

- Visuelle Entdeckung im Weltmaßstab

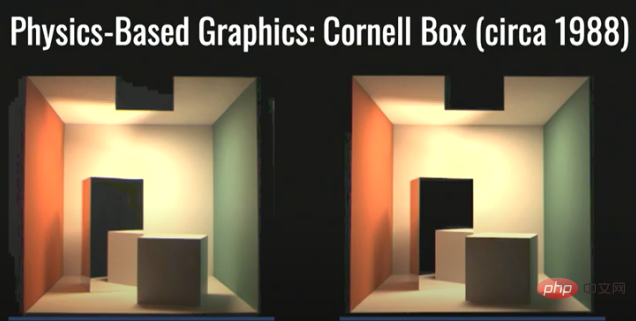

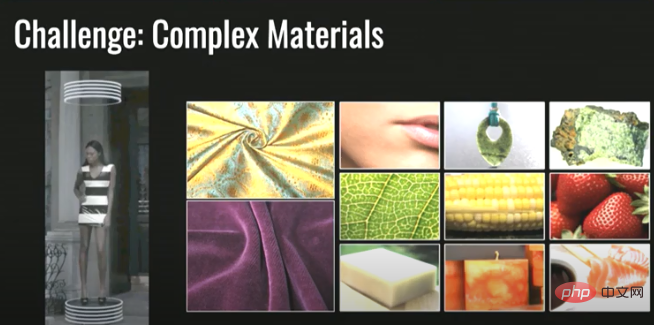

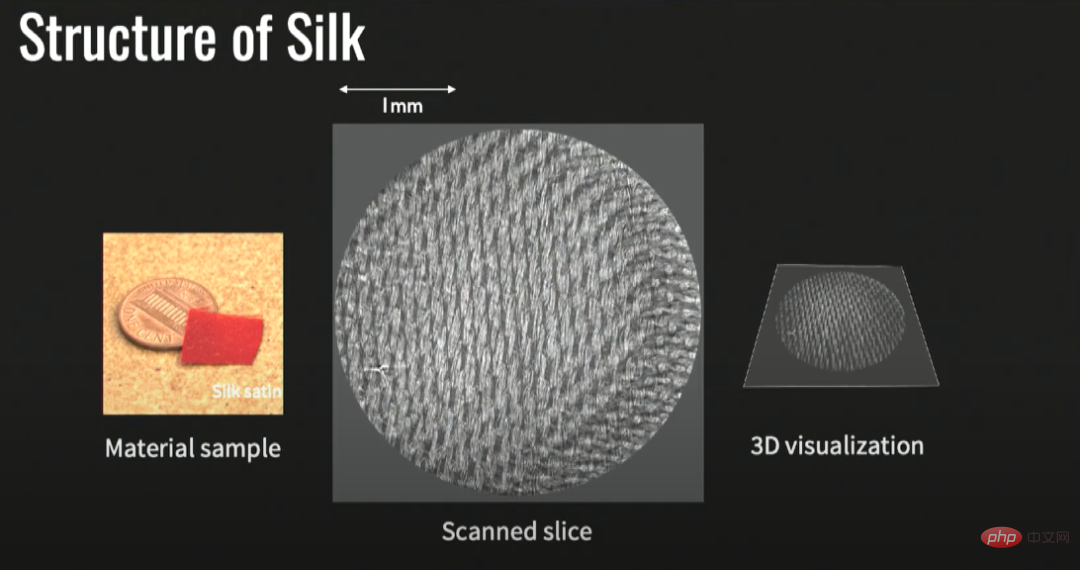

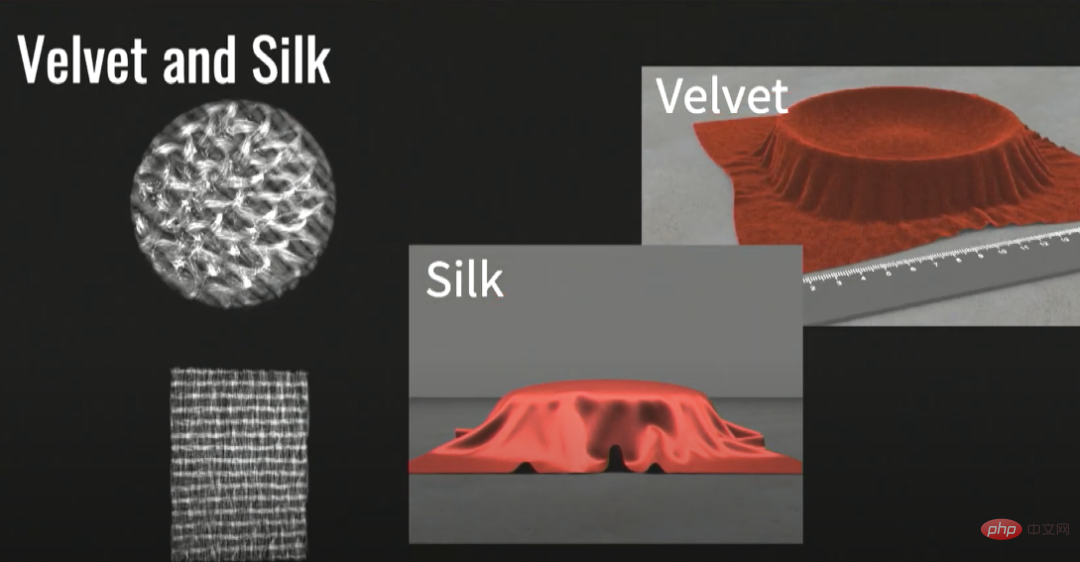

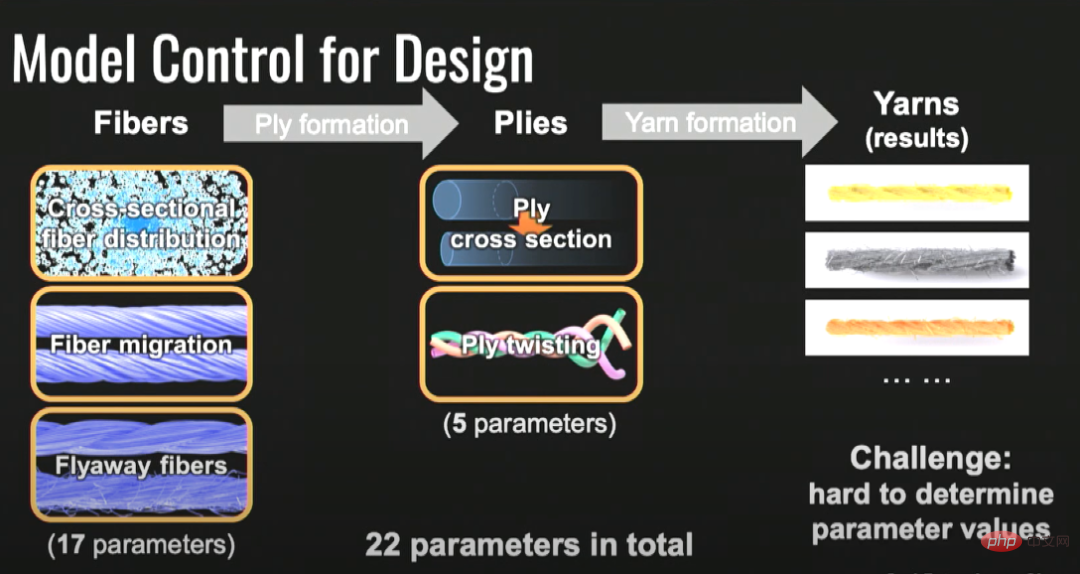

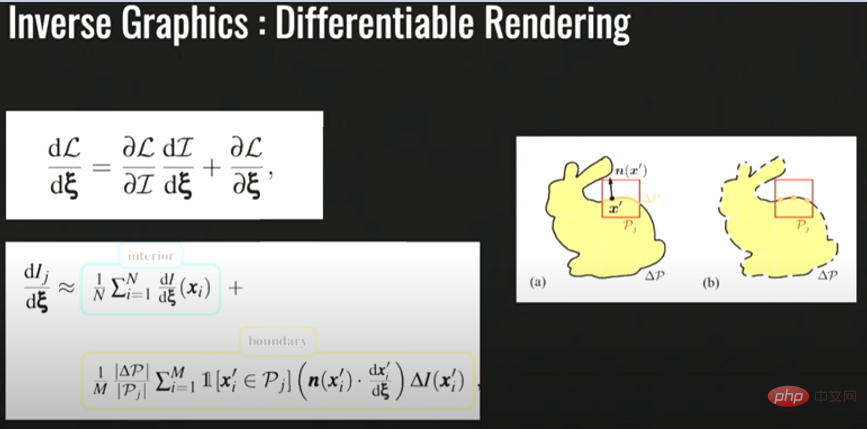

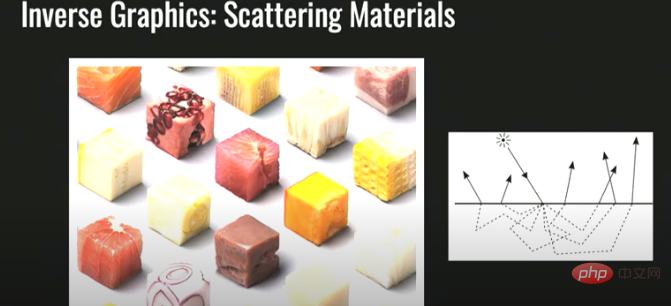

Physikalisch basiertes visuelles Erscheinungsbildmodell

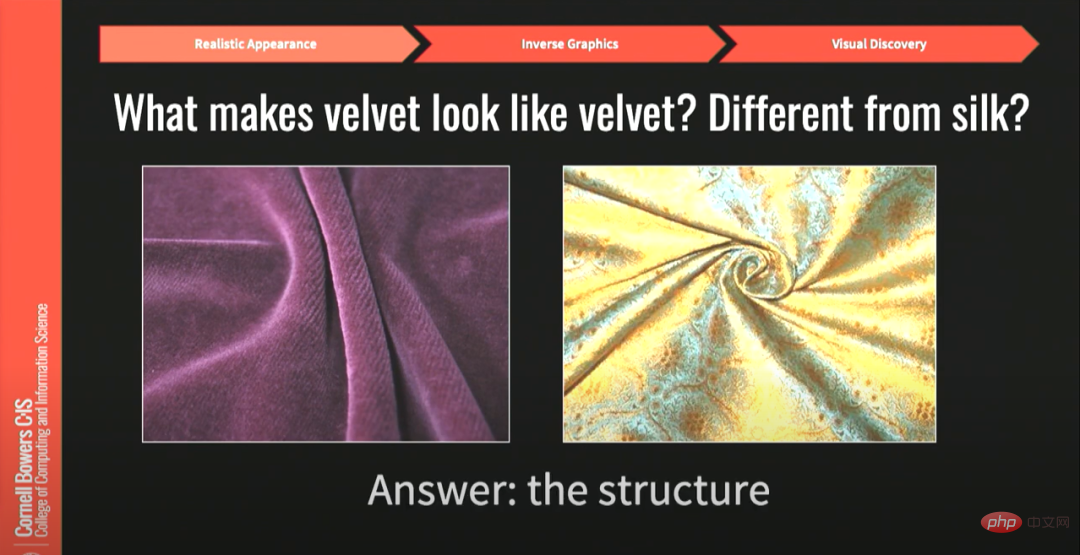

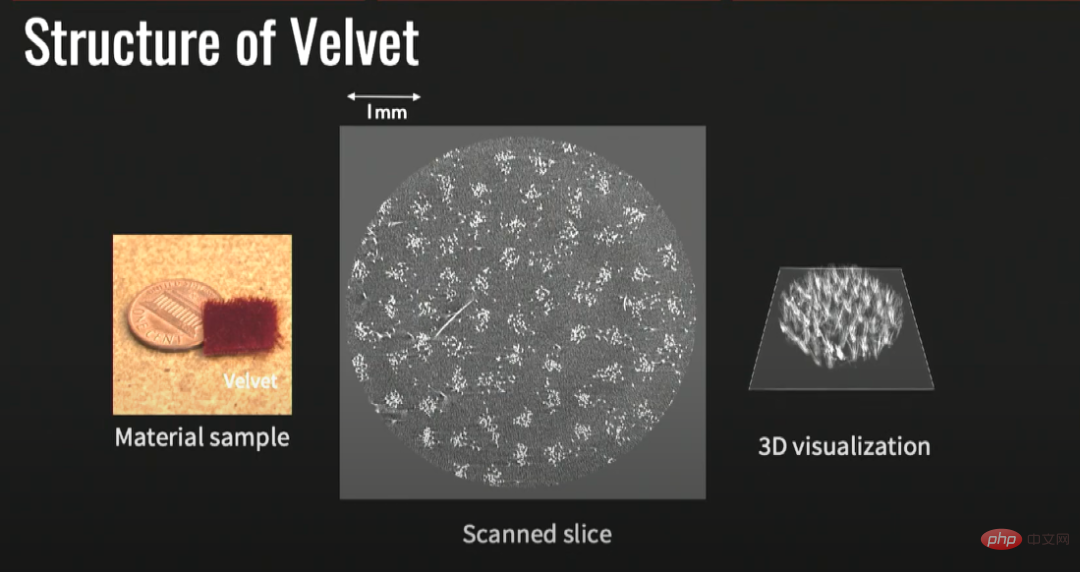

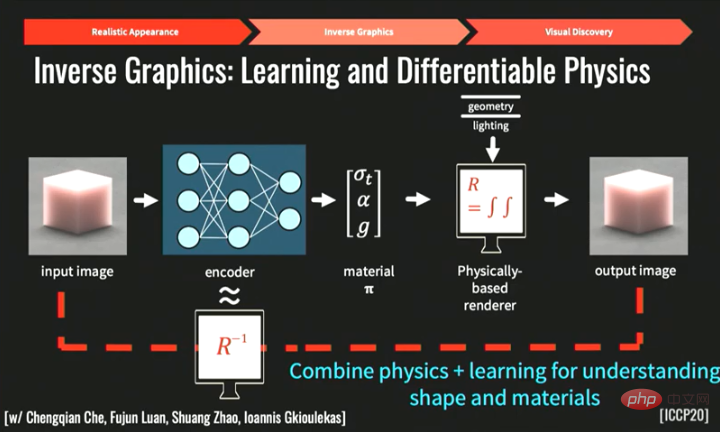

Beginnen wir mit physikbasierten Grafiken.Zuerst möchte ich einen berühmten Test vorstellen: den Cornell-Box-Test, der darauf ausgelegt ist, die Genauigkeit von Rendering-Software durch Vergleich der gerenderten Szene mit einem tatsächlichen Foto derselben Szene zu bestimmen. Die beiden Bilder, die ich Ihnen zeige, eines ist künstlich gerendert und das andere ist real – tatsächlich ist das linke eine reale Szene und das rechte ein virtuelles Bild. Seit Jahren wird hart daran gearbeitet, Bilder zu erstellen, die dieser Test nicht als echt oder gefälscht erkennen kann. Aber die reale Welt ist nicht so einfach wie das Bild in Cornells Box. In der realen Welt gibt es viele Arten von Materialien, wie zum Beispiel Stoffe, Häute, Blätter, Lebensmittel usw., die auf diesem Bild gezeigt werden. Menschen interagieren ständig mit der Welt und beurteilen, ob das, was sie sehen, real ist. Wenn wir die realistischen visuellen Effekte des Modells unten links simulieren möchten, ist die Darstellung dieser komplexen Materialien eine große Herausforderung. Dies ist auch ein Problem, mit dem ich mich seit vielen Jahren beschäftigt habe. Also werde ich darüber sprechen, wie man das Aussehen von Stoffen und Stoffen richtig einfängt. Stellen wir zunächst eine Frage. Als Mensch erkennen Sie sofort, dass das linke aus Samt besteht und das rechte aus glänzendem, seidenartigem Material. Was lässt Samt wie Samt aussehen und warum sieht Seide anders aus als Samt, sieht aber wie Seide aus? Die Antwort lautet: Struktur. Die beiden Stoffe unterscheiden sich nicht nur im Aussehen, sondern im Wesentlichen sind aufgrund ihrer unterschiedlichen Strukturen auch die optischen Effekte unterschiedlich. Wenn wir diese Struktur erfassen, erfassen wir ihr visuelles Wesen. Was wir also im ursprünglichen Projekt gemacht haben, war: Schauen Sie sich Mikro-CT-Scans dieser Materialien an. Im Mikro-CT-Scan von Samt können wir erkennen, dass Samt ein pelziges Material ist. Die Struktur von Seide ist völlig anders. Die Kett- und Schussfäden bilden ein bestimmtes Muster, das der Seide einen glänzenden Effekt verleiht . An diesem Punkt werden wir feststellen, dass wir, solange wir die Mikrostruktur des Materials verstehen, grundsätzlich das Erscheinungsmodell des Materials erfassen können. Auch wenn das Material sehr komplex ist, bleibt es dennoch unverändert. Sobald wir die Struktur erfasst haben, können wir die Informationen erfassen, die die optischen Eigenschaften anzeigen, wie z. B. Farbe usw. Diese Informationen reichten aus, um uns ein vollständiges Modell zu liefern, mit dem wir die realistischen visuellen Effekte dieses Materials nachbilden konnten. Wie im Bild gezeigt, konnten wir durch die Beherrschung der strukturellen Eigenschaften der beiden Stoffe die visuellen Effekte von Samt und Seide erfolgreich wiederherstellen. Wir haben viel recherchiert, um diese Modelle tatsächlich zu fördern und darüber nachzudenken, welche realen Anwendungen dieses Modell haben kann. Wir glauben nun, dass dieses Tool das digitale Prototyping für Industriedesigner, Textildesigner usw. erleichtern wird, indem es Designern die Möglichkeit gibt, das Aussehen echter gewebter Stoffe zu simulieren. In einem Industriewebstuhl wird echtes Garn auf der Spule verwendet, und nach dem Hinzufügen eines Webmusters erzeugt der Industriewebstuhl einen Stoff wie den unten rechts gezeigten. Und wir möchten ein modernes visuelles Turing schaffen Testen Sie im Wesentlichen eine vollständig digitale Pipeline, die eine Kombination aus CT-Scans und Fotos verwendet, um den gleichen Effekt wie ein industrieller Webstuhl zu erzielen. Dieser virtuelle und dennoch realistische visuelle Effekt ermöglicht es Designern, wichtige Entscheidungen zu treffen, ohne den Stoff tatsächlich herzustellen. Wir haben tatsächlich ein niedrigdimensionales Modell und 22 Parameter erstellt, die die Materialstruktur intuitiver darstellen. Designer werden leistungsfähiger, wenn sie dieses Tool verwenden können. Und diese 22 Parameter führen zum zweiten Thema, über das ich sprechen werde: inverse Grafiken. Das zweite Problem, auf das wir gestoßen sind, ist, wie wir uns an diese Modelle anpassen können, nachdem wir diese Modelle hatten. Dies ist auch ein wichtiges Thema in der Computergrafikforschung. Beginnen wir mit der Beziehung zwischen Licht und der Oberfläche von Objekten. Wenn Licht auf eine Metalloberfläche trifft, wird das Licht reflektiert. Wenn Licht auf andere Materialien wie Haut, Lebensmittel, Stoffe usw. trifft, dringt es in die Oberfläche ein und interagiert bis zu einem gewissen Grad mit dem Objekt. Dies wird als Streuung unter der Oberfläche bezeichnet. Wie im Bild oben gezeigt, lässt sich beurteilen, ob Sushi köstlich ist, indem man den Glanz und die Frische seines Aussehens beurteilt. Wenn Sie daher den visuellen Effekt eines bestimmten Objekts simulieren möchten, müssen Sie verstehen, was passiert, wenn Licht auf die Oberfläche eines solchen Objekts trifft. Bildunterschrift: End-to-End-Pipeline In einer idealen Welt haben wir eine Art erlernte Darstellung, und nachdem wir ein Foto aufgenommen haben, können wir erkennen, dass die Objekte auf dem Foto vorhanden sind Alle Materialeigenschaften und Materialparameter sowie drei Parameter im Zusammenhang mit unterschiedlicher Streuung können ebenfalls bekannt sein: Wie weit wandert das Licht im Medium, wie stark wird es gestreut, wie hoch ist die Albedo des Materials bei Streuung usw. Und jetzt, da wir sehr gute physikalisch basierte Renderer haben, die den gesamten physikalischen Prozess des Auftreffens von Licht auf die Oberfläche eines Objekts simulieren können, sind wir meiner Meinung nach bereits in der Lage, diese Art von Pipeline zu erstellen. Wenn wir den physikalisch basierten Renderer und die erlernte Darstellung kombinieren, um diese End-to-End-Pipeline zu erhalten, und dann das Ausgabebild mit dem Eingabebild abgleichen und den Verlust minimieren, können wir die Materialeigenschaften (d. h. die oben genannten) erhalten Material π in der Bildmitte). Um dies effektiv zu tun, müssen wir Lernen und Physik effektiv kombinieren, den physischen Darstellungsprozess der Welt auf den Kopf stellen und hart daran arbeiten, die umgekehrten Parameter zu erhalten. Die Wiederherstellung von Form und Material ist jedoch sehr schwierig. Der obige Prozess erfordert, dass die Rendering-Engine R differenzierbar ist. Um die visuellen Effekte eines Produkts wie einer Szene in einem Film wiederherzustellen, benötigen wir eine differenzierbare Rendering-Pipeline, was bedeutet, dass wir in der Lage sein müssen, den Verlust des Attributs, das wir wiederherstellen möchten, zu differenzieren. Hier ist ein Beispiel für die Wiederherstellung von Material und Geometrie. Mit der Kettenmethode können wir einfach Proben an den Kanten der Oberfläche abtasten, um die benötigten Informationen zu erhalten. Dann können wir einen Prozess zur Wiederherstellung der visuellen Effekte von Objekten entwickeln, wie unten gezeigt. Zuerst können wir mit einem Mobiltelefon eine Reihe von Bildern des Objekts aufnehmen, das wir wiederherstellen möchten, dann die Bilder initialisieren, das Material und die Form optimieren und dann durch differenzierbares Rendering erneut optimieren. Schließlich kann das Objekt eine realistische Simulation darstellen Wirkung: Kann in Augmented Reality/Virtual Reality und anderen Anwendungen eingesetzt werden. In der visuellen Simulation ist die Streuung unter der Oberfläche ein sehr wichtiges Phänomen. Das Bild unten ist ein Werk mehrerer Künstler mit dem Namen Cubes. Dabei handelt es sich eigentlich um Quadrate mit einer Seitenlänge von 2,5 cm, die aus 98 Lebensmittelsorten hergestellt werden. Die Oberfläche jedes der 98 Lebensmittel ist unterschiedlich und komplex, was unser Interesse an der Erkundung geweckt hat. Da die Oberfläche von Lebensmitteln sehr komplex ist, muss bei der Wiederherstellung der Eigenschaften von Rohstoffen die Streuung unter der Oberfläche berücksichtigt werden. Der spezifische Inhalt dieses Aspekts wird in einem Artikel vorgestellt, den wir später veröffentlichen werden entwickelte eine vollständig differenzielle Rendering-Pipeline. Was wir mit dieser Pipeline zurückgewinnen, sind Materialeigenschaften, die auf der Streuung unter der Oberfläche basieren. Schließlich haben wir die unterschiedlichen Materialien und Formen der beiden Früchte wiederhergestellt und die visuellen Effekte von Kiwi- und Drachenfruchtwürfeln erfolgreich präsentiert. Abbildung: Der Prozess der Wiederherstellung von Kiwi- und Drachenfruchtwürfeln In der obigen Untersuchung haben wir eine Kombination aus Lernen und Physik verwendet und die folgenden drei wichtigen Punkte zusammengefasst. 3 Dies ist Feinkörnige Objekterkennung

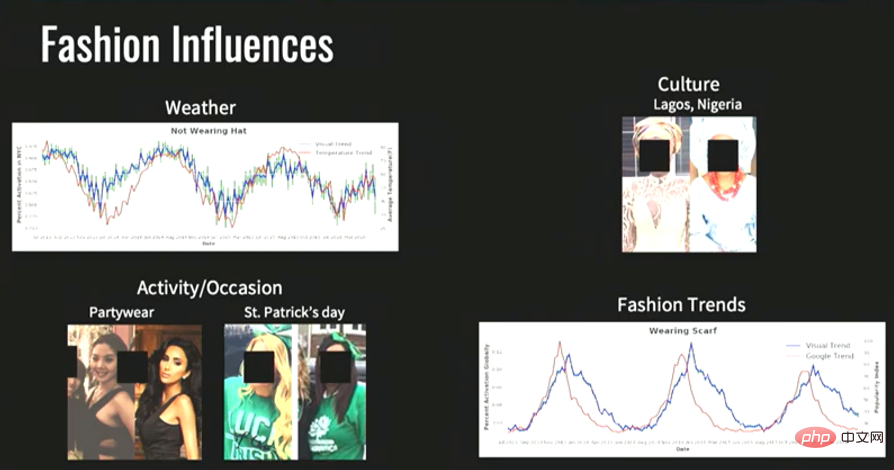

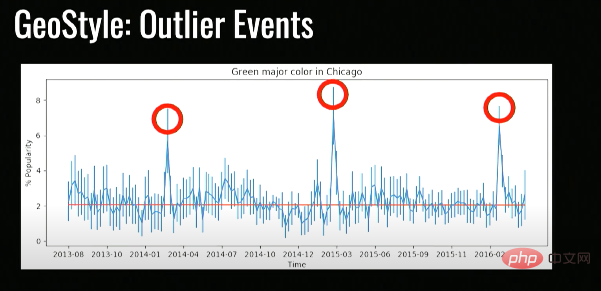

In diesem Bild kann beispielsweise die feinkörnige Objekterkennung erkennen, dass diese Person ein x trägt, und dieses x bezieht sich nicht auf eine Handtasche (die meisten Leute können das erkennen). ), wobei sich x auf eine bestimmte Handtaschenmarke bezieht. Eine solche genaue Kenntnis liegt außerhalb der Reichweite der meisten normalen Menschen. Im Wesentlichen können wir durch visuelle Erkennung Informationen auf Expertenebene oder sogar Informationen auf Expertenebene in mehr als einem Bereich bereitstellen, und ich denke, die Forschung in diesem Bereich ist dies sehr spannend. Dieses Bild zeigt einen Lagerfeuerofen, der den Zweck nicht allein beurteilen kann. 🎜🎜# und eine feinkörnige Objekterkennung können uns nicht nur sagen, dass es sich um einen Lagerfeuerofen handelt, sondern auch den Namen des Kunstwerks, wo es gekauft werden kann und Informationen über den Künstler, der es entworfen hat. Hinweis: IKEA APP # 🎜 🎜# Die Recherche im Bild oben ist tatsächlich Teil von Metas Shopping-KI „GrokNet“. Der Slogan von GrokNet besteht darin, jedes Bild dazu zu bringen, Menschen zum Einkaufen zu verleiten (einkaufbar), und das Ziel meines Forschungsteams und mir ist es, jedes Bild verständlich (verständlich) zu machen. Was ich oben gesagt habe, ist eine relativ grundlegende Forschung, und was wir jetzt tun, ist, visuelle Informationen in einem beispiellosen Ausmaß zu sammeln, einschließlich Fotos und Videos und sogar Satellitenbilder. Die Anzahl unserer Satelliten ist im Laufe der Jahre erheblich gestiegen. Mittlerweile sind es etwa 1.500 Satelliten, die jeden Tag 100 Terabyte an Daten hochladen Die ganze Welt. Und zu wissen, was in der Welt passiert ist eine sehr spannende Forschungsrichtung. Bildunterschrift: Können wir Bilder im Weltmaßstab verstehen? Wenn wir das Bild von der Weltebene aus verstehen können, dann können wir diese Fragen auf dem Bild beantworten: Was sollen wir im Leben tun? ? Was tragen wir? Was essen? Wie verändert sich unser Verhalten im Laufe der Zeit? Wie hat sich die Erde im Laufe der Zeit verändert? Es fehlt einfach ein leistungsstarkes Tool zur Durchführung von Recherchen. Einer der Anthropologen, mit denen wir zusammengearbeitet haben, war sehr daran interessiert, wie sich Kleidung auf der ganzen Welt veränderte, und wir stellten fest, dass diese Frage viele Zusammenhänge hatte. Warum kleiden sich Menschen in verschiedenen Regionen der Erde unterschiedlich? Wir glauben, dass es dafür mehrere Gründe gibt: Wir kleiden uns im Sommer anders als die Menschen in Kalifornien, denn hier ist das Wetter cooler als in Kalifornien; Wir können beispielsweise bestimmte Muster in der oberen rechten Ecke erkennen Kleidung im Trend, während die Leute in der unteren linken Ecke eher Rot tragen. Durch die Analyse von Big Data haben wir festgestellt, dass einige Daten mit unseren Vorgaben übereinstimmen. Beispielsweise beeinflusst das Wetter die Kleidung der Menschen und ihre Kleidung Im Winter ist es logisch, kühle Kleidung zu tragen, aber in mancher Hinsicht gibt es in Chicago in den letzten Jahren einige seltsame Datenphänomene waren der Höhepunkt der Menschen, die sich dafür entschieden, Grün zu tragen. Diese Zeitpunkte liegen jedes Jahr im März. Nach einer Untersuchung stellt sich heraus, dass diese Zeitpunkte der St. Patrick's Day in Chicago sind: #🎜 🎜# Dies ist ein sehr wichtiges lokales Fest, und die Menschen in Chicago werden sich an diesem Tag dafür entscheiden, Grün zu tragen. Wenn Sie kein Einheimischer sind, wissen Sie möglicherweise nichts über dieses kulturelle Ereignis. Illustration: Bei kulturellen Veranstaltungen, die auf der ganzen Welt einen hohen Stellenwert haben, werden Menschen bei diesen Veranstaltungen unterschiedliche Farben tragen Kleidung Durch die Identifizierung der Kleidungsänderungen von Menschen in Big Data können wir lokale kulturelle/politische Aktivitäten verstehen und so verschiedene Kulturen auf der ganzen Welt regionale Kultur verstehen. Das Obige zeigt, wie wir die Bedeutung von Bildinformationen aus einer Weltperspektive verstehen. Original-Videolink: https://www.youtube.com/watch?v=kaQSc4iFaxc#🎜🎜 #

2 Inverses Diagramm

Visuelle Entdeckung im Weltmaßstab

Visuelle Entdeckung im Weltmaßstab Erinnern Sie sich noch an die Szene im Film, in der der Protagonist auf der Straße geht, die Produkte im Schaufenster betrachtet und ihm dann über die visuelle Schnittstelle alle Informationen über die Objekte, die er sieht, mitgeteilt werden?

Illustration: Präzise Informationen durch feinkörnige Objekterkennung

Illustration: Präzise Informationen durch feinkörnige Objekterkennung

Der Besuch von Partys oder Sportveranstaltungen, verschiedene Aktivitäten oder Anlässe erfordern auch das Tragen bestimmter Kleidung; #

Das obige ist der detaillierte Inhalt vonKavita Bala, Dekanin der Cornell School of Computing: Was ist das „Metaversum'? Gottes Auge kann durch KI geboren werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr