Heim >Technologie-Peripheriegeräte >KI >Anwendung von KI-Algorithmen in der Big Data Governance

Anwendung von KI-Algorithmen in der Big Data Governance

- PHPznach vorne

- 2023-04-12 13:37:032007Durchsuche

In diesem Artikel werden hauptsächlich die Erfahrungen von Datacake bei der Anwendung von KI-Algorithmen in der Big-Data-Governance beschrieben. Dieser Austausch ist in fünf Teile gegliedert: Der erste Teil verdeutlicht die Beziehung zwischen Big Data und KI. Big Data kann KI auch zur Optimierung ihrer eigenen Dienste nutzen stellt die Anwendungspraxis des KI-Modells vor, um den Zustand von Big-Data-Aufgaben umfassend zu bewerten und eine quantitative Grundlage für die anschließende Datenverwaltung bereitzustellen. Der dritte Teil stellt die Anwendungspraxis der Verwendung des KI-Modells vor, um die Konfiguration von Spark-Aufgaben intelligent zu empfehlen und das Ziel zu erreichen der Verbesserung der Cloud-Ressourcennutzung; der vierte Teil stellt die Praxis der intelligenten Empfehlung von Aufgabenausführungs-Engines durch Modelle in SQL-Abfrageszenarien vor; der fünfte Teil befasst sich mit den Anwendungsszenarien von KI im gesamten Lebenszyklus von Big Data.

1. Big Data und KI

Das allgemeine Konzept besteht darin, dass Cloud Computing riesige Datenmengen sammelt und speichert, um dann durch das Mining und Lernen von Big Data KI-Modelle zu bilden werden weiter geformt. Dieses Konzept geht stillschweigend davon aus, dass Big Data der KI dient, ignoriert jedoch die Tatsache, dass KI-Algorithmen auch auf Big Data zurückwirken können. Zwischen ihnen besteht eine wechselseitige, sich gegenseitig unterstützende und abhängige Beziehung.

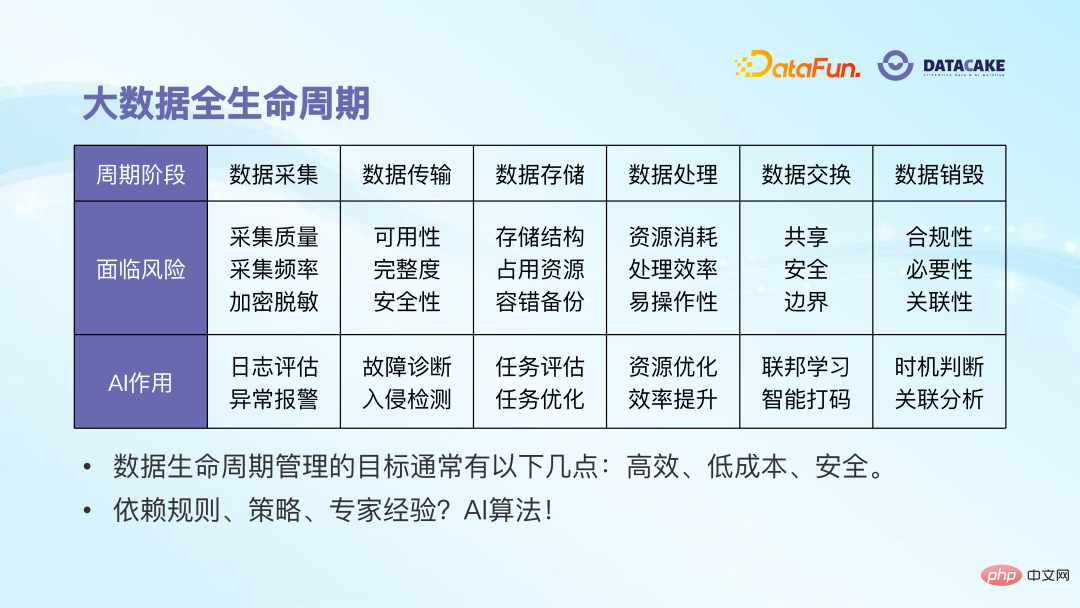

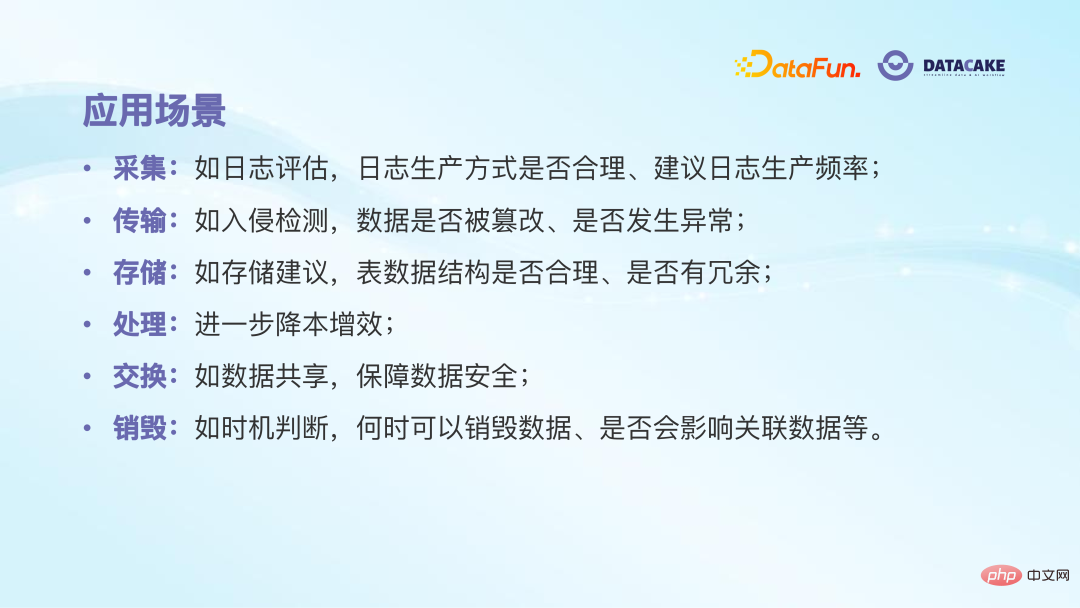

Der gesamte Lebenszyklus von Big Data kann in sechs Phasen unterteilt werden. Der richtige Einsatz von KI-Algorithmen kann zur Lösung dieser Probleme beitragen.

Datenerfassung: In dieser Phase werden wir der Qualität, Häufigkeit und Sicherheit der Datenerfassung mehr Aufmerksamkeit schenken, z. B. ob die erfassten Daten vollständig sind und ob die Geschwindigkeit der Datenerfassung zu hoch ist schnell oder zu langsam, und ob die Datenerfassungsgeschwindigkeit zu schnell oder zu langsam ist, ob die Daten desensibilisiert oder verschlüsselt wurden usw. Zu diesem Zeitpunkt kann KI einige Rollen spielen, beispielsweise die Bewertung der Rationalität der Protokollsammlung auf der Grundlage ähnlicher Anwendungen und die Verwendung von Anomalieerkennungsalgorithmen, um plötzliche Anstiege oder Rückgänge im Datenvolumen zu erkennen.

Datenübertragung: Diese Phase legt mehr Wert auf die Verfügbarkeit, Integrität und Sicherheit der Daten. KI-Algorithmen können zur Fehlerdiagnose und Einbrucherkennung verwendet werden.

Datenspeicherung: In dieser Phase achten wir mehr darauf, ob die Speicherstruktur der Daten angemessen ist, ob die Ressourcennutzung niedrig genug ist, ob sie sicher genug ist usw. KI-Algorithmen kann auch für einige Auswertungen und Optimierungen verwendet werden.

Datenverarbeitung: Diese Phase ist diejenige mit den offensichtlichsten Auswirkungen und Optimierungsvorteilen. Ihr Kernproblem besteht darin, die Effizienz der Datenverarbeitung zu verbessern und den Ressourcenverbrauch zu reduzieren.

Datenaustausch: Es gibt immer mehr Kooperationen zwischen Unternehmen, die Fragen der Datensicherheit mit sich bringen. Auch in diesem Bereich können Algorithmen eingesetzt werden. Beispielsweise kann das beliebte Federated Learning dabei helfen, Daten besser und sicherer auszutauschen.

Datenvernichtung: Es ist unmöglich, Daten einfach zu speichern, ohne sie zu löschen. Daher müssen Sie überlegen, wann Sie die Daten löschen können und ob Risiken bestehen. Basierend auf Geschäftsregeln können KI-Algorithmen dabei helfen, den Zeitpunkt und die damit verbundenen Auswirkungen der Datenlöschung zu bestimmen.

Insgesamt verfolgt das Datenlebenszyklusmanagement drei Hauptziele: hohe Effizienz, niedrige Kosten und Sicherheit. Der frühere Ansatz bestand darin, sich bei der Formulierung einiger Regeln und Strategien auf die Erfahrung von Experten zu verlassen, was ganz offensichtliche Nachteile wie hohe Kosten und geringe Effizienz hatte. Der richtige Einsatz von KI-Algorithmen kann diese Nachteile vermeiden und in den Aufbau von Big-Data-Basisdiensten einfließen. In Qingzi Technology wurden mehrere Anwendungsszenarien implementiert Zunächst geht es um die Bewertung des Zustands von Big-Data-Aufgaben. 2. Gesundheitsbewertung von Big-Data-Aufgaben

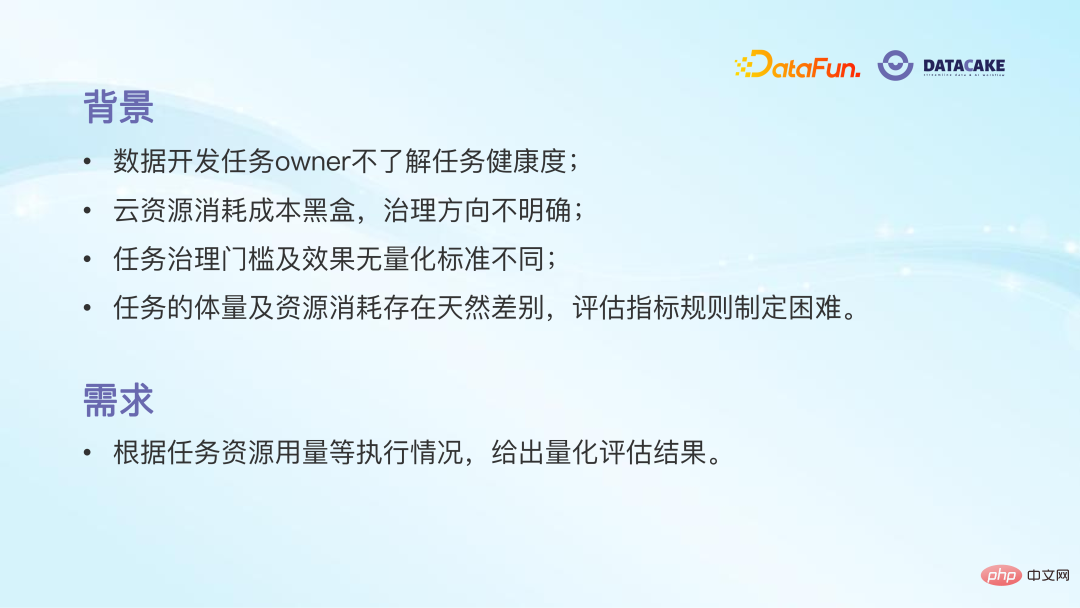

Auf der Big-Data-Plattform, Täglich werden Tausende von Aufgaben ausgeführt. Viele Aufgaben verbleiben jedoch nur in der Phase der Erzeugung korrekter Zahlen, und der Laufzeit der Aufgabe, dem Ressourcenverbrauch usw. wird keine Aufmerksamkeit geschenkt, was bei vielen Aufgaben zu geringer Effizienz und Ressourcenverschwendung führt.

Selbst wenn Datenentwickler anfangen, auf den Zustand der Aufgabe zu achten, ist es schwierig, genau zu beurteilen, ob die Aufgabe gesund ist oder nicht. Da es viele aufgabenbezogene Indikatoren wie Ausfallrate, Zeitaufwand, Ressourcenverbrauch usw. gibt und es natürliche Unterschiede in der Komplexität verschiedener Aufgaben und der verarbeiteten Datenmenge gibt, ist es offensichtlich unvernünftig, diese einfach auszuwählen Absolutwert eines bestimmten Indikators als Bewertungskriterium.

Ohne quantifizierte Aufgabengesundheit ist es schwierig festzustellen, welche Aufgaben ungesund sind und verwaltet werden müssen, geschweige denn, wo das Problem liegt und wo es beginnt, Sie wissen immer noch nicht, welche Auswirkungen es haben wird, selbst wenn die Governance abgeschlossen ist. Es kann sogar Situationen geben, in denen sich ein Indikator verbessert, andere jedoch sich verschlechtern.

Nachfrage: Angesichts der oben genannten Probleme brauchen wir dringend one Ein quantitativer Indikator, der den Gesamtzustand der Aufgabe genau widerspiegelt. Das manuelle Formulieren von Regeln ist ineffizient und unvollständig. Erwägen Sie daher, die Leistungsfähigkeit maschineller Lernmodelle zu nutzen. Das Ziel besteht darin, dass das Modell eine quantitative Bewertung der Aufgabe und ihrer Position in der globalen Verteilung liefern sowie die Hauptprobleme und Lösungen der Aufgabe angeben kann.

Für diese Anforderung besteht unsere Funktionsmodullösung darin, Schlüsselinformationen aller Aufgaben unter dem Namen des Eigentümers auf der Verwaltungsoberfläche anzuzeigen, z B. Bewertungen, Aufgabenkosten, CPU-Auslastung, Speicherauslastung usw. Auf diese Weise ist der Zustand der Aufgabe auf einen Blick ersichtlich, was es dem Aufgabeneigentümer erleichtert, die Aufgabe später zu verwalten.

Zweitens betrachten wir die Modelllösung der Scoring-Funktion als ein to sich mit Klassifizierungsproblemen befassen. Intuitiv ist die Aufgabenbewertung offensichtlich ein Regressionsproblem und sollte mit einer reellen Zahl zwischen 0 und 100 versehen werden. Hierzu ist jedoch eine ausreichende Anzahl bewerteter Proben erforderlich, und die manuelle Etikettierung ist teuer und unzuverlässig.

Daher erwägen wir, das Problem in ein Klassifizierungsproblem umzuwandeln, und die durch das Klassifizierungsmodell gegebene Klassenwahrscheinlichkeit kann weiter abgebildet werden eine echte Wertung. Wir unterteilen Aufgaben in zwei Kategorien: gute Aufgabe 1 und schlechte Aufgabe 0, die von Big-Data-Ingenieuren gekennzeichnet werden. Die sogenannten guten Aufgaben beziehen sich in der Regel auf Aufgaben, die bei gleichem Aufgabenvolumen und gleicher Komplexität eine kurze Zeit in Anspruch nehmen und weniger Ressourcen verbrauchen.

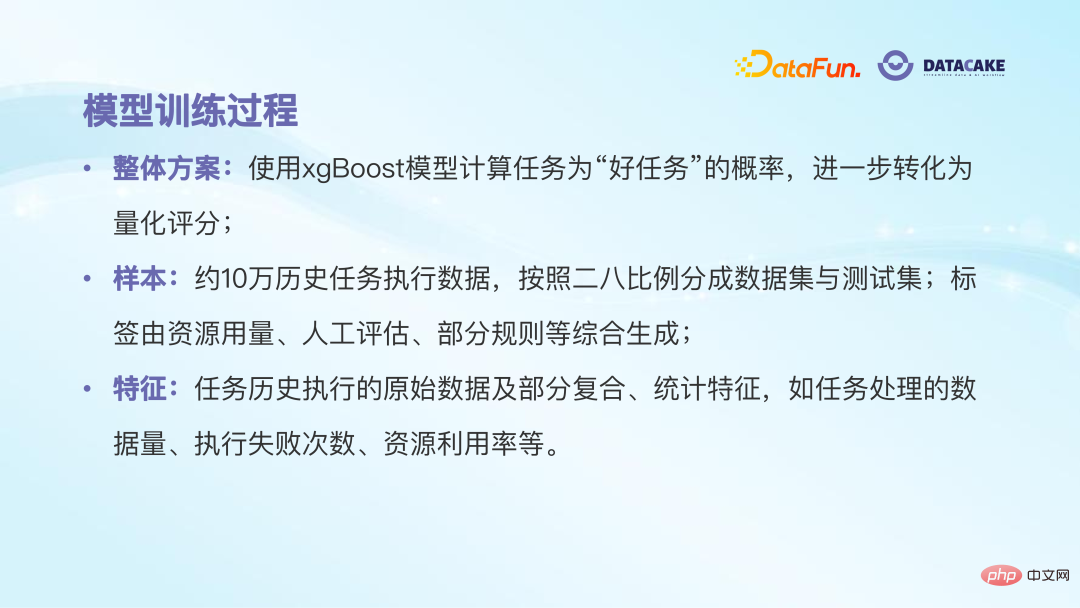

Der Modelltrainingsprozess ist:

# 🎜🎜#Die erste ist die Beispielvorbereitung. Zu den Beispielmerkmalen gehören die Laufzeit, die verwendeten Ressourcen, ob die Ausführung fehlschlägt usw. Die Beispielbezeichnungen werden von Big-Data-Ingenieuren auf der Grundlage von Regeln generiert Markieren Sie sie in zwei Kategorien: gut und schlecht. Dann kann das Modell nacheinander trainiert werden. Sowohl Theorie als auch Praxis haben bewiesen, dass XGboost bessere Klassifizierungsergebnisse liefert. Das Modell gibt schließlich die Wahrscheinlichkeit aus, dass es sich bei der Aufgabe um eine „gute Aufgabe“ handelt. Je größer die Wahrscheinlichkeit, desto höher ist die endgültige Punktzahl der zugeordneten Aufgabe.

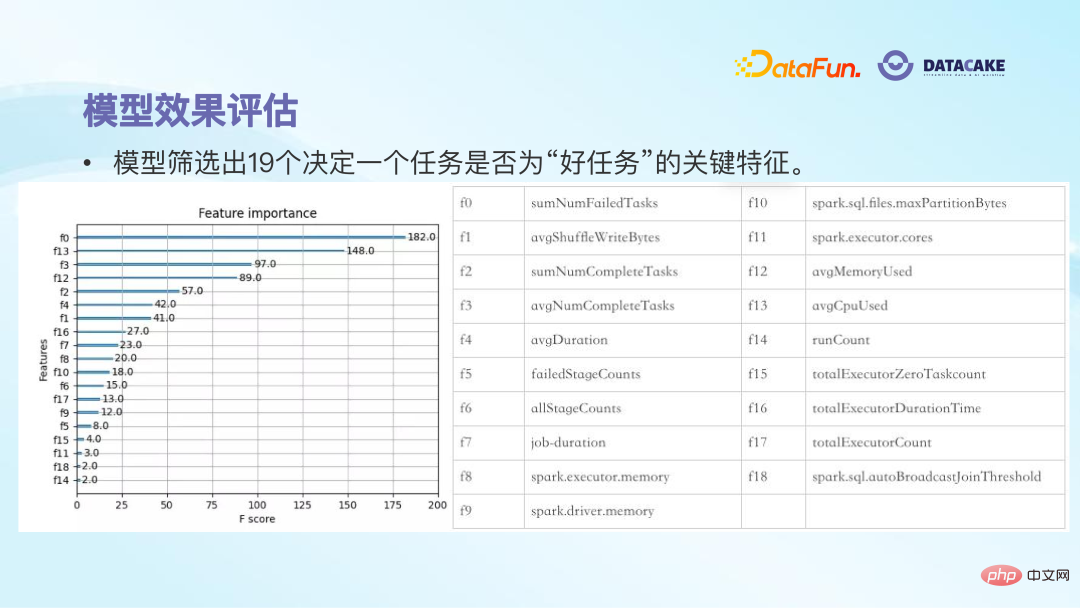

Nach dem Training wurden 19 Funktionen aus den ursprünglichen fast 50 Originalfunktionen herausgefiltert. Diese 19 Funktionen können grundsätzlich bestimmen, ob eine Aufgabe eine gute Aufgabe ist. Beispielsweise werden die meisten Aufgaben mit einer hohen Anzahl von Fehlern und einer geringen Ressourcenauslastung nicht zu hoch bewertet, was grundsätzlich mit den subjektiven Gefühlen des Menschen übereinstimmt.

Nachdem Sie das Modell zur Bewertung von Aufgaben verwendet haben, können Sie erkennen, dass Aufgaben unter 0 bis 30 ungesund sind und dringend verwaltet werden müssen. Aufgaben zwischen 30 und 60 sind Aufgaben mit akzeptablem Gesundheitszustand mit relativ gutem Gesundheitszustand und der Notwendigkeit, den Status quo aufrechtzuerhalten. Auf diese Weise kann der Aufgabenverantwortliche mit quantitativen Indikatoren dazu angeleitet werden, einige Aufgaben aktiv zu verwalten und so das Ziel der Kostensenkung und Effizienzsteigerung zu erreichen.

Die Anwendung des Modells hat uns folgende Vorteile gebracht:

① Erstens kann sich der Aufgabeneigentümer über den Zustand der Aufgaben unter seinem Namen im Klaren sein und anhand von Bewertungen erkennen, ob die Aufgabe verwaltet werden muss Rankings;

② Quantitative Indikatoren bieten eine Grundlage für die spätere Aufgabenverwaltung;

③ Wie viel Nutzen und Verbesserung nach Abschluss der Aufgabenverwaltung erzielt wurde, kann auch quantitativ durch Bewertungen angezeigt werden.

3. Intelligente Parameteranpassung für Spark-Aufgaben

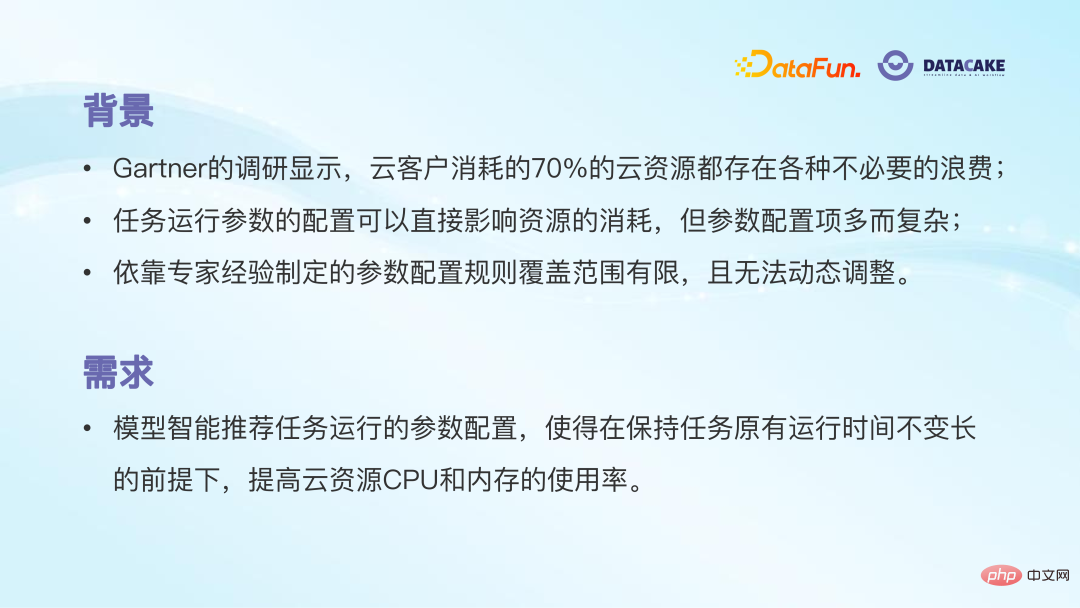

Das zweite Anwendungsszenario ist die intelligente Parameteranpassung für Spark-Aufgaben. Eine Gartner-Umfrage ergab, dass 70 % der von Cloud-Benutzern verbrauchten Cloud-Ressourcen unnötig verschwendet werden. Bei der Beantragung von Cloud-Ressourcen beantragen viele Personen möglicherweise mehr Ressourcen, um die erfolgreiche Ausführung von Aufgaben sicherzustellen, was zu unnötiger Verschwendung führt. Es gibt auch viele Leute, die beim Erstellen von Aufgaben die Standardkonfiguration verwenden, aber tatsächlich ist dies nicht die optimale Konfiguration. Wenn Sie es sorgfältig konfigurieren, können Sie sehr gute Ergebnisse erzielen, was nicht nur die Betriebseffizienz und den Erfolg gewährleistet, sondern auch viele Ressourcen spart. Die Konfiguration von Aufgabenparametern stellt jedoch hohe Anforderungen an den Benutzer. Neben dem Verständnis der Bedeutung von Konfigurationselementen müssen auch die Auswirkungen von Assoziationen zwischen Konfigurationselementen berücksichtigt werden. Selbst wenn man sich auf die Erfahrung von Experten verlässt, ist es schwierig, optimale Ergebnisse zu erzielen, und regelbasierte Strategien lassen sich nur schwer dynamisch anpassen.

Dies stellt eine Anforderung dar. Es besteht die Hoffnung, dass das Modell die optimale Parameterkonfiguration für den Aufgabenbetrieb intelligent empfehlen kann, um die Nutzung der Aufgaben-Cloud-Ressourcen zu verbessern und gleichzeitig die ursprüngliche Laufzeit der Aufgabe beizubehalten.

Für das Funktionsmodul zur Anpassung der Aufgabenparameter umfasst die von uns entworfene Lösung zwei Situationen: Die erste gilt für Aufgaben, die über einen bestimmten Zeitraum online ausgeführt wurden, und das Modell muss in der Lage sein, basierend auf Empfehlungen zu arbeiten Die am besten geeigneten Konfigurationsparameter gelten für Aufgaben, die der Benutzer noch nicht online gestellt hat. Durch die Analyse der Aufgaben muss das Modell eine sinnvolle Konfiguration liefern können.

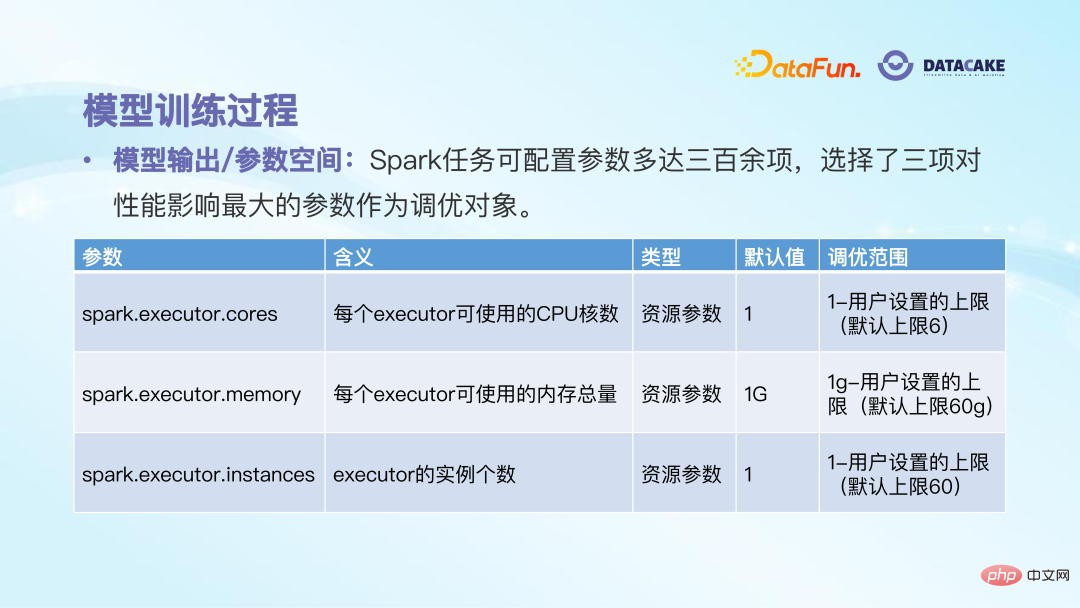

Der nächste Schritt besteht darin, das Modell zu trainieren. Bestimmen Sie zunächst das Ausgabeziel des Modells. Es gibt mehr als 300 konfigurierbare Elemente, und es ist unmöglich, sie alle im Modell bereitzustellen. Nach Tests und Recherchen haben wir drei Parameter ausgewählt, die den größten Einfluss auf die Ausführungsleistung von Aufgaben haben, nämlich die Anzahl der Kerne des Executors, die Gesamtspeichermenge und die Anzahl der Instanzen. Jedes Konfigurationselement hat seinen Standardwert und seinen einstellbaren Bereich. Tatsächlich ist ein Parameterraum gegeben, und das Modell muss nur die optimale Lösung in diesem Raum finden.

Für die Trainingsphase gibt es zwei Möglichkeiten. Die erste Möglichkeit besteht darin, empirische Regeln zu lernen: Verwenden Sie Regeln, um Parameter in einem frühen Stadium zu empfehlen, und die Ergebnisse sind gut, nachdem Sie online gegangen sind. Lassen Sie das Modell daher zuerst diesen Regelsatz lernen, um das Ziel einer schnellen Online-Bereitstellung zu erreichen . Bei den Modelltrainingsbeispielen handelt es sich um mehr als 70.000 Aufgabenkonfigurationen, die zuvor auf der Grundlage von Regeln berechnet wurden. Die Beispielmerkmale sind die historischen Laufdaten der Aufgabe (z. B. die von der Aufgabe verarbeitete Datenmenge, die Ressourcennutzung und die von der Aufgabe benötigte Zeit). usw.) und einige statistische Informationen (z. B. Durchschnittsverbrauch, Maximalverbrauch usw. in den letzten sieben Tagen).

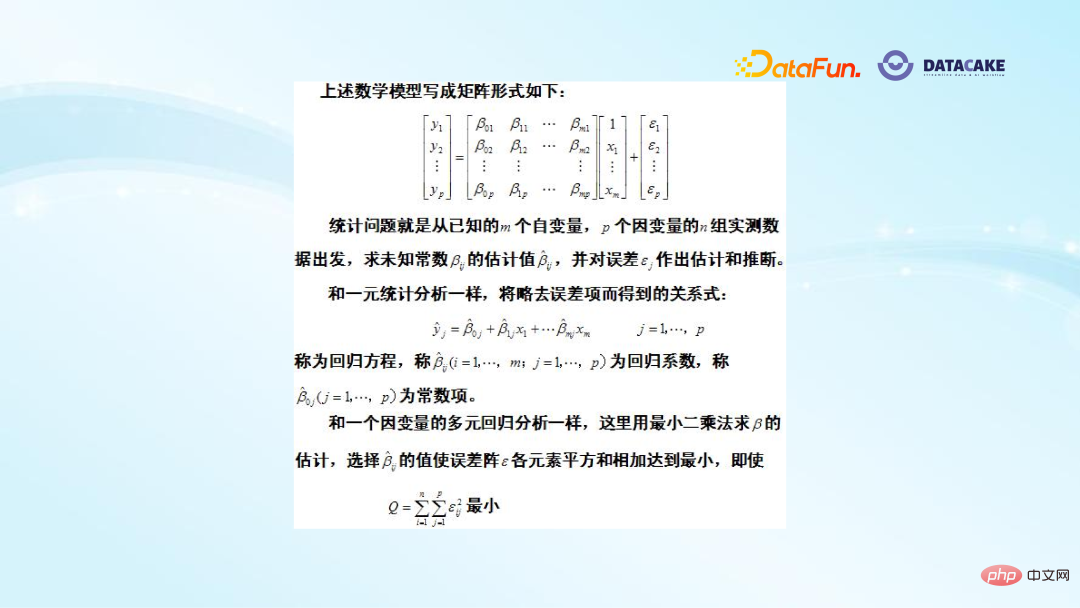

Basismodell Wir haben ein multiples Regressionsmodell mit mehreren abhängigen Variablen gewählt. Gängige Regressionsmodelle sind Single-Output-Modelle mit vielen unabhängigen Variablen, aber nur einer abhängigen Variablen. Hier hoffen wir, drei Parameter auszugeben, daher verwenden wir ein multiples Regressionsmodell mit mehreren abhängigen Variablen, bei dem es sich im Wesentlichen um ein LR-Modell handelt.

Das obige Bild zeigt die theoretischen Grundlagen dieses Modells. Auf der linken Seite befindet sich eine Mehrfachbezeichnung, bei der es sich um drei Konfigurationselemente handelt. β ist der Koeffizient jedes Merkmals und Σ ist der Fehler. Die Trainingsmethode ist die gleiche wie bei der unären Regression, wobei die Methode der kleinsten Quadrate verwendet wird, um die Summe der Quadrate jedes Elements in Σ auf das Minimum zu schätzen.

Der Vorteil von Option eins besteht darin, dass Sie schnell Regeln und Erfahrungen lernen können und die Kosten relativ gering sind. Der Nachteil besteht darin, dass die Optimierungsobergrenze höchstens eine ebenso gute Wirkung wie die Regeln erzielen kann, es jedoch schwieriger sein wird, diese zu überschreiten.

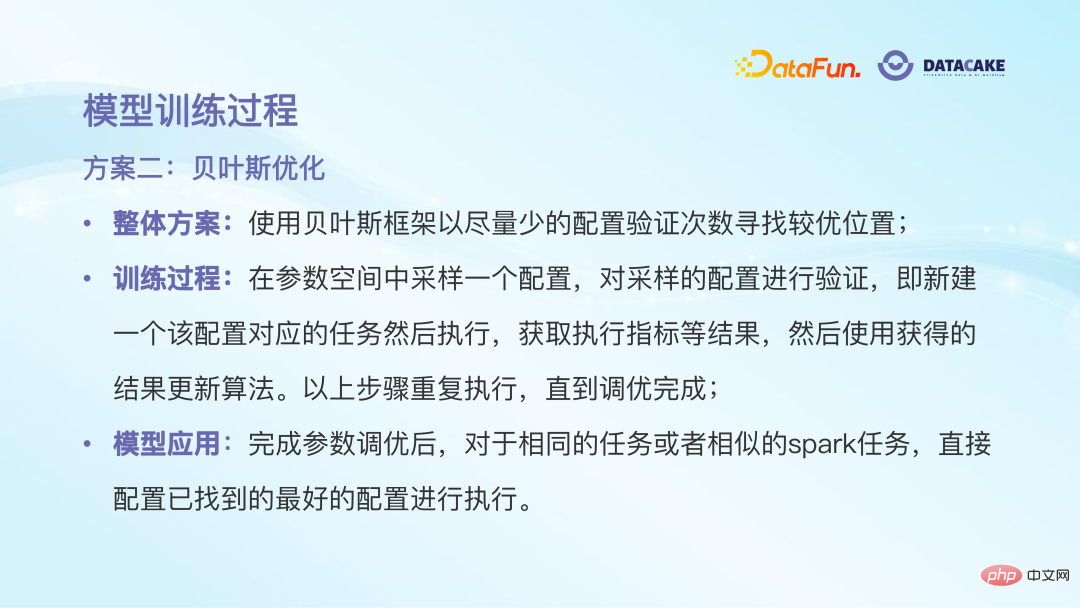

Die zweite Option ist die Bayes'sche Optimierung. Ihre Idee ähnelt dem verstärkenden Lernen. Sie versucht, die optimale Konfiguration durch Ausprobieren im Parameterraum zu finden. Das Bayes'sche Framework wird hier verwendet, da es die Grundlage des vorherigen Versuchs nutzen und beim nächsten Versuch über einige Vorerfahrungen verfügen kann, um schnell eine bessere Position zu finden. Der gesamte Trainingsprozess wird in einem Parameterraum durchgeführt, wobei eine Konfiguration zur Überprüfung zufällig ausgewählt und nach der Ausführung ausgeführt wird. Dabei werden einige Indikatoren wie Nutzung, Kosten usw. berücksichtigt, um festzustellen, ob dies der Fall ist optimal; dann wiederholen Sie die oben genannten Schritte, bis die Abstimmung abgeschlossen ist. Nachdem das Modell trainiert wurde, gibt es während der Verwendung auch einen Trick-or-Treating-Prozess. Wenn die neue Aufgabe einen gewissen Grad an Ähnlichkeit mit der historischen Aufgabe aufweist, muss die Konfiguration nicht erneut berechnet werden, sondern die vorherige optimale Konfiguration direkt genutzt werden.

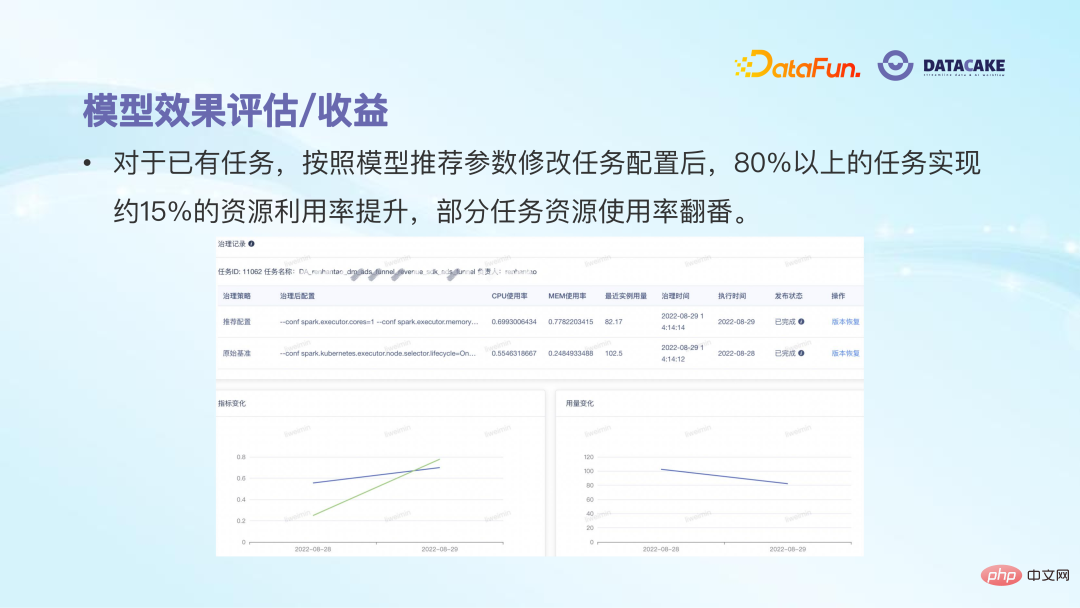

Nachdem wir diese beiden Lösungen ausprobiert und geübt haben, können wir sehen, dass bestimmte Ergebnisse erzielt wurden. Bei vorhandenen Aufgaben können nach Änderungen gemäß den vom Modell empfohlenen Konfigurationsparametern mehr als 80 % der Aufgaben eine Verbesserung der Ressourcenauslastung um etwa 15 % erreichen, und die Ressourcenauslastung einiger Aufgaben wird sogar verdoppelt. Allerdings weisen beide Lösungen tatsächlich Mängel auf: Das Regressionsmodell der Lernregeln weist eine niedrige Optimierungsobergrenze auf; der Nachteil des Bayes'schen Optimierungsmodells der globalen Optimierung besteht darin, dass es verschiedene Versuche erfordert und die Kosten zu hoch sind.

Die zukünftigen Explorationsanweisungen sind wie folgt:

Semantische Analyse: Spark Semantics ist relativ reich, einschließlich verschiedener Codestrukturen und Bedienerfunktionen. zur Aufgabenparameterkonfiguration und zum Ressourcenverbrauch. Derzeit verwenden wir jedoch nur den historischen Ausführungsstatus der Aufgabe und ignorieren die Spark-Semantik selbst. Dies ist eine Informationsverschwendung. Der nächste Schritt besteht darin, in die Codeebene einzudringen, die in der Spark-Aufgabe enthaltenen Operatorfunktionen zu analysieren und entsprechend eine feinkörnigere Abstimmung vorzunehmen.

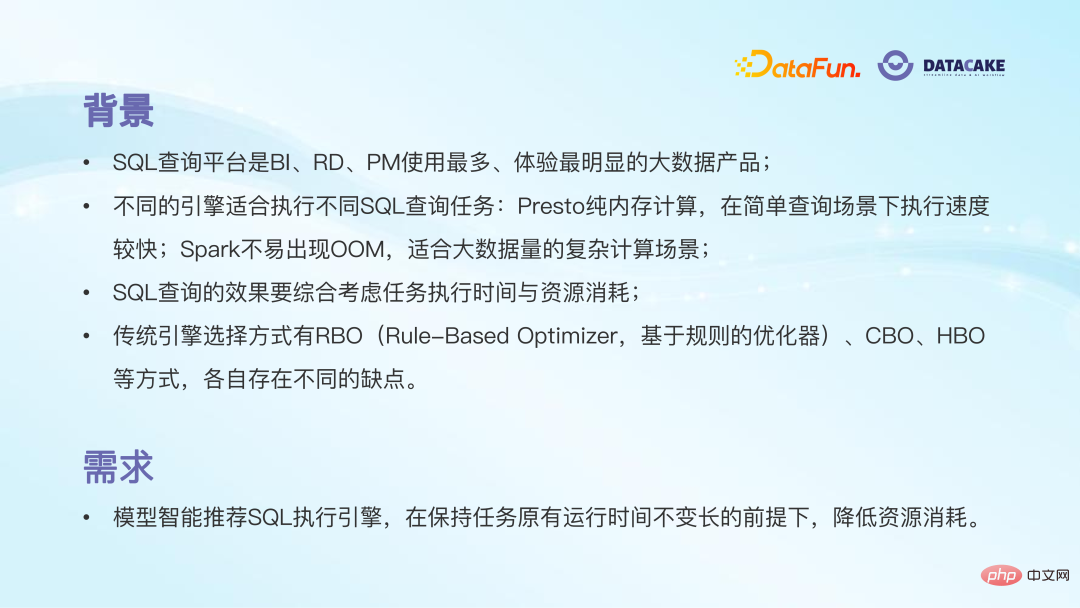

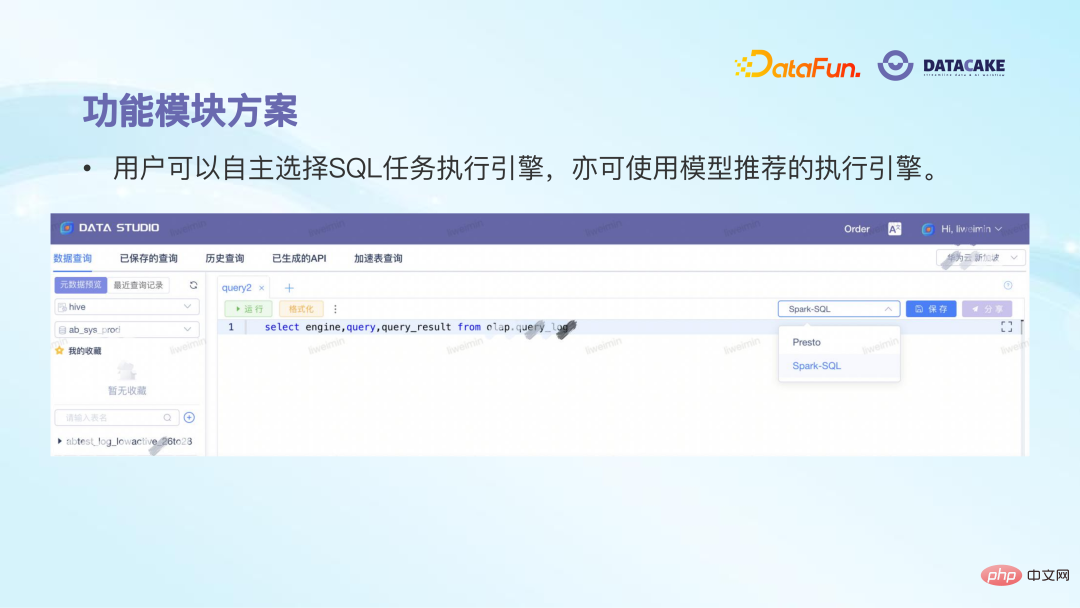

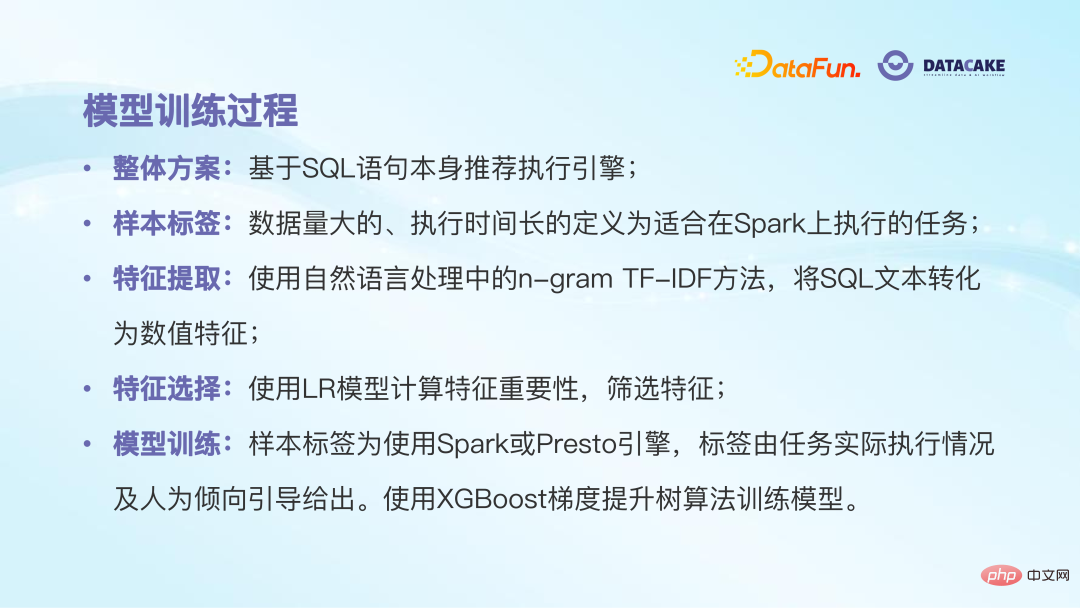

Klassifizierungsoptimierung: Spark verfügt über viele Anwendungsszenarien, z. B. für reine Analyse, Entwicklung, Verarbeitung usw. Der Optimierungsraum und die Ziele verschiedener Szenarien sind ebenfalls unterschiedlich, sodass eine Klassifizierungsoptimierung erforderlich ist . Projektoptimierung: Eine der in der Praxis auftretenden Schwierigkeiten ist die geringe Anzahl von Proben und die hohen Prüfkosten, die die Zusammenarbeit relevanter Parteien zur Optimierung des Projekts oder Prozesses erfordern. Das dritte Anwendungsszenario ist die intelligente Auswahl der SQL-Abfrage-Aufgabenausführungs-Engine. Hintergrund: (1) Die SQL-Abfrageplattform ist das Big-Data-Produkt, mit dem die meisten Benutzer am meisten Kontakt haben und die offensichtlichste Erfahrung machen, unabhängig davon, ob sie Datenanalysten oder F&E sind , oder Produktmanager schreiben jeden Tag eine Menge SQL, um die gewünschten Daten zu erhalten. (2) Viele Leute achten beim Ausführen von SQL-Aufgaben nicht auf die zugrunde liegende Ausführungs-Engine Beim reinen Speicher-Computing besteht der Vorteil in einigen einfachen Abfrageszenarien darin, dass die Ausführungsgeschwindigkeit schneller ist. Der Nachteil besteht jedoch darin, dass es im Gegensatz zu Spark direkt aufhängt, wenn die Speicherkapazität nicht ausreicht Für die Ausführung komplexer Aufgaben mit großen Datenmengen wird in diesem Szenario Festplattenspeicher verwendet, um Aufgabenfehler zu vermeiden. Daher eignen sich unterschiedliche Motoren für unterschiedliche Aufgabenszenarien. (3) Der SQL-Abfrageeffekt muss die Ausführungszeit der Aufgabe und den Ressourcenverbrauch umfassend berücksichtigen. Sie können die Abfragegeschwindigkeit weder übermäßig verfolgen, noch den Ressourcenverbrauch berücksichtigen, noch die Abfrageeffizienz beeinträchtigen Ressourcen sparen. (4) In der Branche gibt es hauptsächlich drei traditionelle Methoden zur Motorenauswahl: RBO, CBO und HBO. RBO ist ein regelbasierter Optimierer und die Aktualisierungshäufigkeit ist gering. Ein zu starkes Streben nach Kostenoptimierung kann dazu führen, dass die Ausführung von Aufgaben fehlschlägt . Relativ beschränkt auf historische Daten. wird auf dem Funktionsmodul entworfen. Nachdem der Benutzer die SQL-Anweisung geschrieben und zur Ausführung übermittelt hat, bestimmt das Modell automatisch, welche Engine verwendet werden soll, und zeigt letztendlich eine Fensteraufforderung an Empfohlener Motor für die Ausführung. Die Gesamtlösung des Modells besteht darin, Ausführungs-Engines basierend auf der SQL-Anweisung selbst zu empfehlen. Da Sie in SQL selbst sehen können, welche Tabellen und Funktionen verwendet werden, bestimmen diese Informationen direkt die Komplexität von SQL und wirken sich somit auf die Wahl der Ausführungs-Engine aus. Modelltrainingsbeispiele stammen aus historisch ausgeführten SQL-Anweisungen, und Modellbezeichnungen werden basierend auf historischen Ausführungsbedingungen markiert. Beispielsweise werden Aufgaben, deren Ausführung lange dauert und eine große Datenmenge umfasst, als für die Ausführung auf Spark geeignet markiert Der Rest ist für die Ausführung unter Presto Running SQL geeignet. Bei der Beispielmerkmalsextraktion werden die NLP-Technologie und die TF-IDF-Methode verwendet. Das allgemeine Prinzip besteht darin, Phrasen zu extrahieren, um zu sehen, wie oft sie in Sätzen vorkommen, damit Schlüsselphrasen extrahiert werden können. Die nach dieser Operation generierten Vektormerkmale sind sehr groß. Wir verwenden zunächst ein lineares Modell, um 3000 Merkmale herauszufiltern, und trainieren und generieren dann das XGBoost-Modell als endgültiges Vorhersagemodell. 4. Intelligente Auswahl der SQL-Aufgabenausführungs-Engine

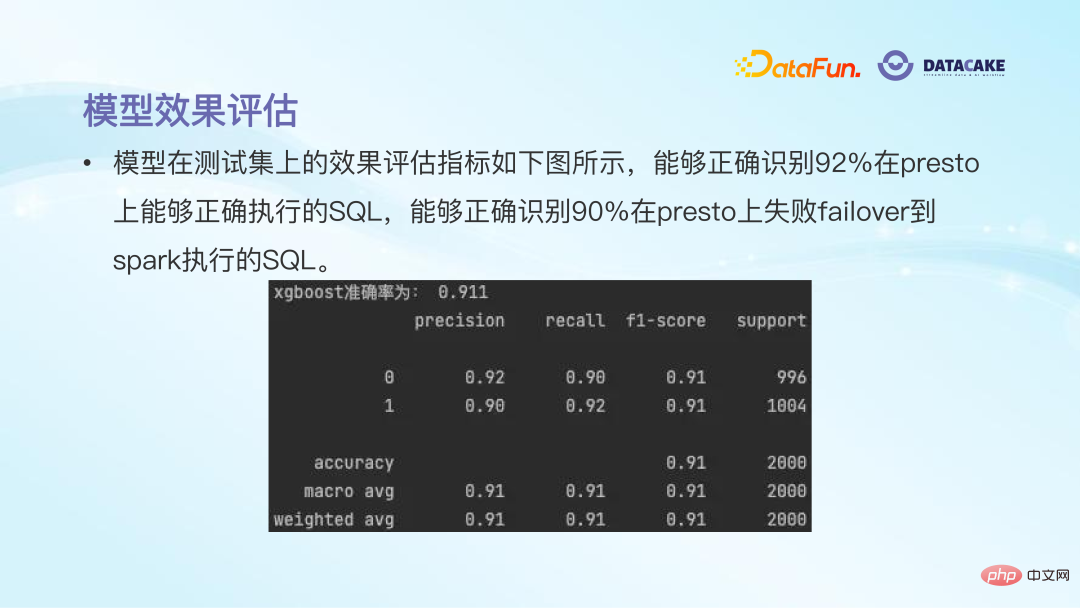

Nach dem Training können Sie sehen, dass die Genauigkeit der Modellvorhersage immer noch relativ hoch ist, etwa 90 % oder mehr.

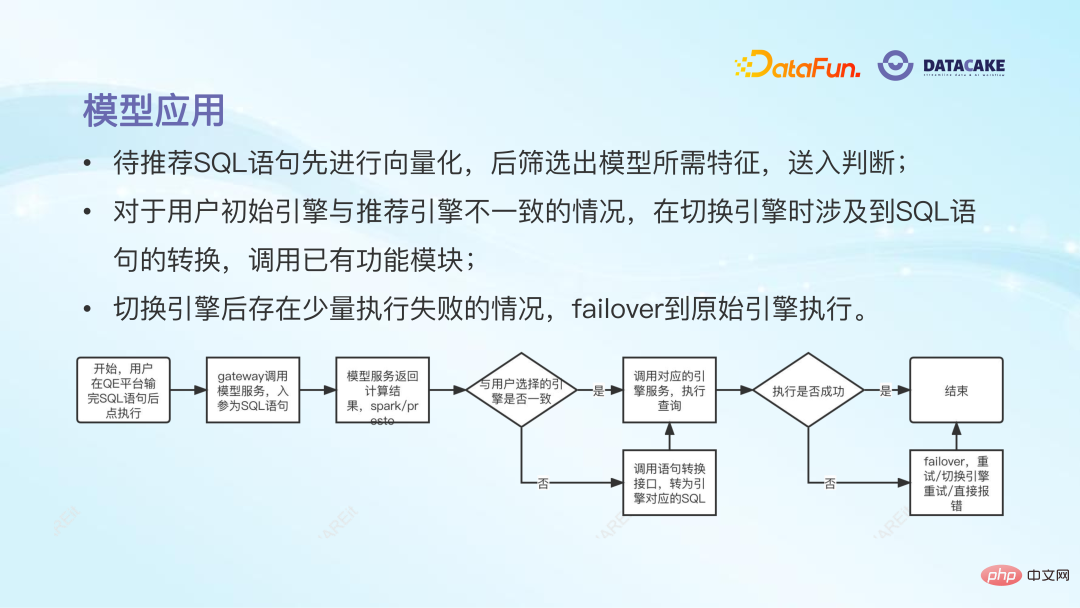

Der endgültige Online-Bewerbungsprozess des Modells ist: Nachdem der Benutzer die SQL übermittelt hat, empfiehlt das Modell eine Ausführungs-Engine. Wenn diese sich von der ursprünglich vom Benutzer ausgewählten Engine unterscheidet, wird die Das Sprachkonvertierungsmodul wird aufgerufen, um die SQL-Anweisung abzuschließen. Wenn die Ausführung nach dem Wechseln der Engine fehlschlägt, verfügen wir über einen Failover-Mechanismus, um zur Ausführung zur ursprünglichen Engine des Benutzers zurückzukehren und so eine erfolgreiche Aufgabenausführung sicherzustellen. Die Vorteile dieser Praxis sind Modell Es kann automatisch die am besten geeignete Ausführungs-Engine auswählen und die anschließende Anweisungskonvertierung abschließen, ohne dass der Benutzer zusätzliches Lernen leisten muss.

Darüber hinaus kann die Modellempfehlungs-Engine grundsätzlich die ursprüngliche Ausführungseffizienz beibehalten und gleichzeitig die Fehlerrate reduzieren, sodass sich die Benutzererfahrung insgesamt verbessert .

Darüber hinaus kann die Modellempfehlungs-Engine grundsätzlich die ursprüngliche Ausführungseffizienz beibehalten und gleichzeitig die Fehlerrate reduzieren, sodass sich die Benutzererfahrung insgesamt verbessert .

Aufgrund der Reduzierung des Einsatzes unnötiger kostenintensiver Engines und der Reduzierung der Fehlerraten bei der Aufgabenausführung ist schließlich das Gesamtergebnis Ressourcenkostenverbrauch gesunken.

Vom zweiten bis zum vierten Teil haben wir drei Anwendungen von KI-Algorithmen auf Big-Data-Plattformen geteilt. Eines seiner erkennbaren Merkmale ist, dass der von verwendete Algorithmus nicht besonders komplex ist, der Effekt jedoch sehr offensichtlich sein wird.

Dies inspiriert uns dazu, die Initiative zu ergreifen, um die Schwachstellen oder den Optimierungsraum während des Betriebs der Big-Data-Plattform zu verstehen. Nachdem wir die Anwendungsszenarien ermittelt haben, können wir versuchen, diese Probleme mithilfe verschiedener Methoden des maschinellen Lernens zu lösen und so zu erkennen die Richtung von KI-Algorithmen. Feedback aus Big Data.5. Perspektiven für den Einsatz von KI-Algorithmen in der Big Data Governance

# 🎜 🎜#Abschließend freuen wir uns auf die Anwendungsszenarien von KI-Algorithmen in der Big Data Governance.

Die drei oben vorgestellten Anwendungsszenarien konzentrieren sich stärker auf die Datenverarbeitungsphase . . Tatsächlich kann KI in Anlehnung an die in Kapitel 1 diskutierte Beziehung zwischen KI und Big Data eine relativ gute Rolle im gesamten Datenlebenszyklus spielen.

In der Datenerfassungsphase kann beispielsweise beurteilt werden, ob das Protokoll während der Übertragung angemessen ist Während der Verarbeitung können auch einige Arbeiten zur Gewährleistung der Datensicherheit beim Vernichten durchgeführt werden, um den Zeitpunkt und die damit verbundenen Auswirkungen der Vernichtung beurteilen zu können. Es gibt viele Anwendungsszenarien für KI in Big-Data-Plattformen, und dies ist nur eine Einführung. Es wird davon ausgegangen, dass die sich gegenseitig unterstützende Beziehung zwischen KI und Big Data in Zukunft stärker in den Vordergrund treten wird. KI-gestützte Big-Data-Plattformen können Daten besser sammeln und verarbeiten, und eine bessere Datenqualität kann anschließend dazu beitragen, bessere KI-Modelle zu trainieren und so einen positiven Effekt zu erzielen Zyklus.

6. Frage- und Antwortsitzung

F1: Was für eine Regelmaschine ist das? Wird es verwendet? Ist es Open Source?A1: Die sogenannten Parameter-Tuning-Regeln hier wurden von unseren Big-Data-Kollegen in der frühen Phase basierend auf manuellen Tuning-Erfahrungen formuliert, z. B. wie wie viele Minuten die Ausführungszeit der Aufgabe überschreitet oder wie viel die zu verarbeitende Datenmenge überschreitet, wie viele Kerne oder wie viel Arbeitsspeicher für die Aufgabe empfohlen werden usw. Hierbei handelt es sich um einen über einen langen Zeitraum gesammelten Regelsatz, dessen Ergebnisse nach der Online-Veröffentlichung relativ gut sind. Daher verwenden wir diesen Regelsatz, um unser Parameterempfehlungsmodell zu trainieren.

F2: Ist die abhängige Variable nur die Anpassung von Parametern? Haben Sie die Auswirkungen der Leistungsinstabilität der Big-Data-Plattform auf die Berechnungsergebnisse berücksichtigt?

A2: Bei Parameterempfehlungen streben wir nicht nur nach niedrigen Kosten, da sonst die empfohlenen Ressourcen niedrig sind und die Aufgabe scheitert. Die abhängige Variable verfügt zwar nur über Parameteranpassungen, wir fügen jedoch zusätzliche Einschränkungen hinzu, um Instabilität zu verhindern. Erstens wählen wir den Durchschnittswert über einen bestimmten Zeitraum und nicht den Wert an einem einzelnen Tag. Zweitens vergleichen wir für die vom Modell empfohlenen Parameter die Differenz mit dem tatsächlichen Konfigurationswert Wenn der Unterschied zu groß ist, verwenden wir eine Verlangsamungs- und Verlangsamungsstrategie, um Missionsfehlschläge aufgrund übermäßiger einmaliger Anpassungen zu vermeiden.

F3: Können Regressionsmodell und Bayesianisches Modell gleichzeitig verwendet werden?

A3: Nein. Wie gerade erwähnt, haben wir zwei Lösungen für die Parameterempfehlung verwendet: Das Regressionsmodell wird für Lernregeln verwendet und das Bayes'sche Optimierungsframework wird später verwendet. Sie werden nicht gleichzeitig verwendet. Wir haben zwei Versuche unternommen. Der Vorteil der ersteren Lernregel besteht darin, dass sie schnell historische Erfahrungen nutzen kann; das zweite Modell kann basierend auf dem vorherigen Modell eine bessere oder sogar optimale Konfiguration finden. Die beiden gehören zu einer sequentiellen oder fortschreitenden Beziehung und werden nicht gleichzeitig verwendet.

F4: Wird die Einführung der semantischen Analyse in Betracht gezogen, um weitere Funktionen zu erweitern?

A4: Ja. Wie gerade erwähnt, ist die einzige Information, die wir bei der Anpassung der Spark-Parameter verwenden, der historische Ausführungsstatus, wir haben uns jedoch noch nicht um die Spark-Aufgabe selbst gekümmert. Spark selbst enthält tatsächlich viele Informationen, einschließlich verschiedener Operatoren, Phasen usw. Wenn Sie die Semantik nicht analysieren, gehen viele Informationen verloren. Unser nächster Plan besteht also darin, die Semantik von Spark-Aufgaben zu analysieren und weitere Funktionen zur Unterstützung der Parameterberechnung zu erweitern.

F5: Wird die Parameterempfehlung unangemessen sein und zu Aufgabenanomalien oder sogar zum Scheitern führen? Wie können dann ungewöhnliche Aufgabenfehler und Aufgabenschwankungen in einem solchen Szenario reduziert werden?

A5: Wenn es vollständig auf das Modell angewiesen ist, strebt es möglicherweise die höchstmögliche Ressourcenauslastung an. In diesem Fall können die empfohlenen Parameter radikaler sein, z. B. die Reduzierung des Speichers von 30 g auf 5 g. Daher werden wir zusätzlich zur Modellempfehlung zusätzliche Einschränkungen hinzufügen, z. B. wie viele g die Parameteranpassungsspanne nicht überschreiten darf usw., dh eine Verlangsamungs- und Verlangsamungsstrategie.

F6: Es gibt einige Artikel zum Parametertuning in Sigmoid 2022. Haben Sie eine Referenz?

A6: Die intelligente Anpassung von Aufgabenparametern ist immer noch eine beliebte Forschungsrichtung, und Teams in verschiedenen Bereichen haben unterschiedliche Methodenmodelle übernommen. Wir haben viele Branchenmethoden untersucht, bevor wir damit begonnen haben, einschließlich des von Ihnen erwähnten Sigmoid 2022-Papiers. Nach Vergleich und Übung haben wir schließlich die beiden von uns geteilten Lösungen ausprobiert. Wir werden auch in Zukunft die neuesten Entwicklungen in dieser Richtung im Auge behalten und weitere Methoden ausprobieren, um den Empfehlungseffekt zu verbessern.

Das war's für das heutige Teilen, vielen Dank an alle.

Das obige ist der detaillierte Inhalt vonAnwendung von KI-Algorithmen in der Big Data Governance. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr