Heim >Technologie-Peripheriegeräte >KI >Das Nanyang Polytechnic schlug die Aufgabe vor, PSG aus dem vollständigen Szenendiagramm zu generieren, Objekte auf Pixelebene zu lokalisieren und 56 Beziehungen vorherzusagen.

Das Nanyang Polytechnic schlug die Aufgabe vor, PSG aus dem vollständigen Szenendiagramm zu generieren, Objekte auf Pixelebene zu lokalisieren und 56 Beziehungen vorherzusagen.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 13:16:211083Durchsuche

Wir schreiben bereits das Jahr 2022, aber die meisten aktuellen Computer-Vision-Aufgaben konzentrieren sich immer noch nur auf die Bildwahrnehmung. Beispielsweise erfordert die Bildklassifizierungsaufgabe nur, dass das Modell die Objektkategorien im Bild identifiziert. Obwohl Aufgaben wie Zielerkennung und Bildsegmentierung darüber hinaus das Auffinden der Position von Objekten erfordern, reichen solche Aufgaben immer noch nicht aus, um zu zeigen, dass das Modell ein umfassendes und tiefgreifendes Verständnis der Szene erlangt hat.

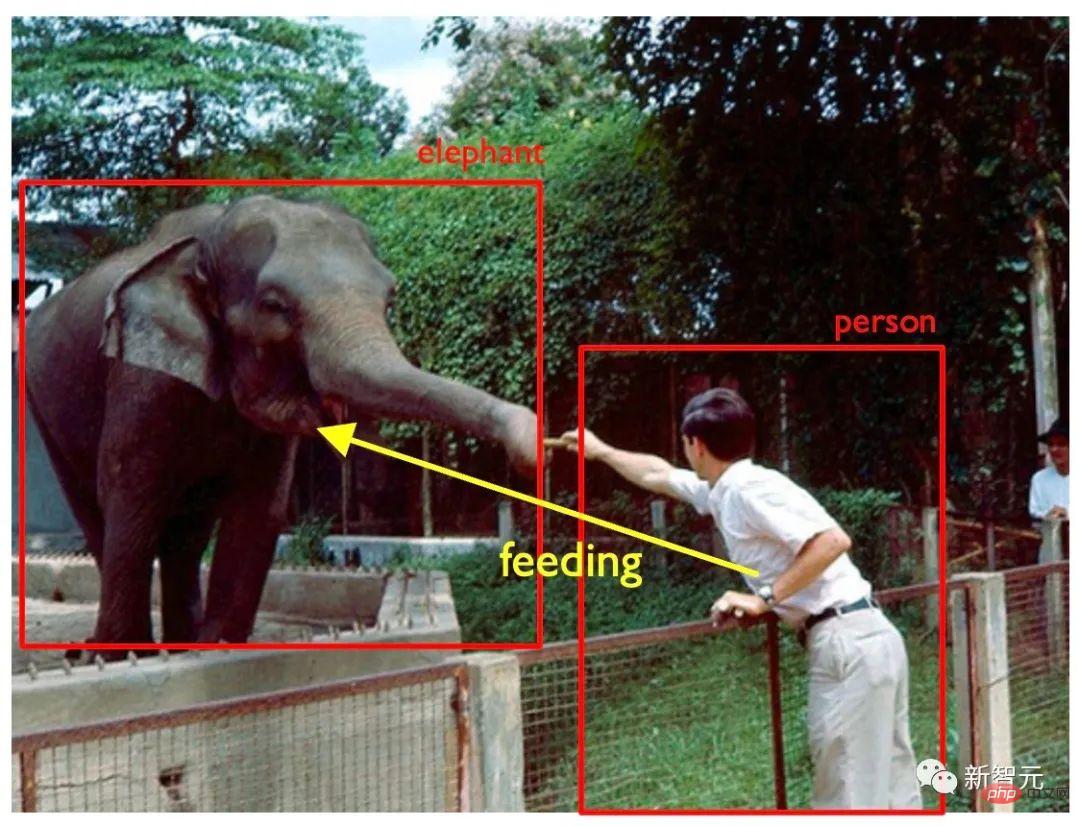

Nehmen Sie Abbildung 1 als Beispiel. Wenn das Computer-Vision-Modell auf dem Bild nur Menschen, Elefanten, Zäune, Bäume usw. erkennt, denken wir normalerweise nicht Das Modell hat die Bilder verstanden und ist nicht in der Lage, auf der Grundlage des Verständnisses Entscheidungen auf höherer Ebene zu treffen, z. B. die Ausgabe einer „Keine Fütterung“-Warnung.

Abbildung 1: Original-Beispielbild

Tatsächlich erwarten wir in vielen realen KI-Szenarien wie Smart Cities, autonomes Fahren und Smart Manufacturing zusätzlich zur Positionierung von Zielen in der Szene normalerweise auch, dass das Modell die verschiedenen Themen lokalisiert Machen Sie im Bild Rückschlüsse und Vorhersagen über die Beziehungen zwischen ihnen. Bei autonomen Fahranwendungen müssen autonome Fahrzeuge beispielsweise analysieren, ob Fußgänger am Straßenrand einen Karren schieben oder Fahrrad fahren. Je nach Situation können die entsprechenden Folgeentscheidungen unterschiedlich ausfallen.

In einem Smart-Factory-Szenario erfordert die Beurteilung, ob der Bediener sicher und korrekt arbeitet, auch, dass das überwachungsseitige Modell in der Lage ist, die Beziehung zwischen den Subjekten zu verstehen. Die meisten vorhandenen Methoden legen manuell einige fest codierte Regeln fest. Dadurch mangelt es dem Modell an Generalisierung und es ist schwierig, es an andere spezifische Situationen anzupassen.

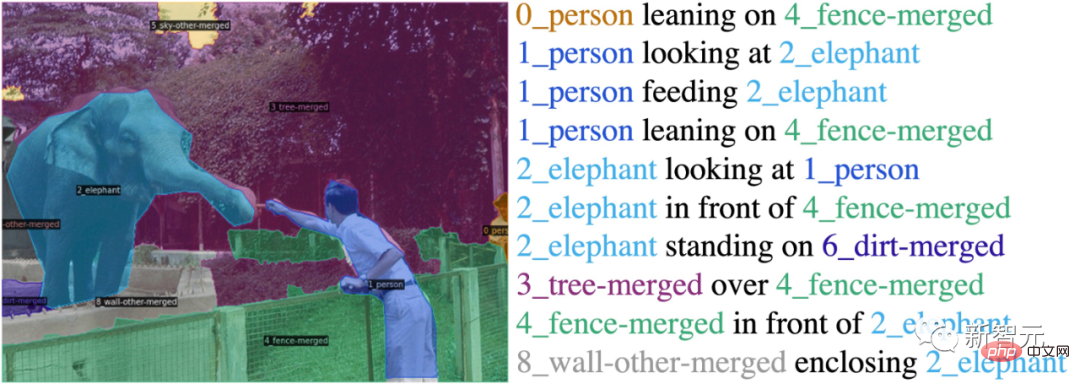

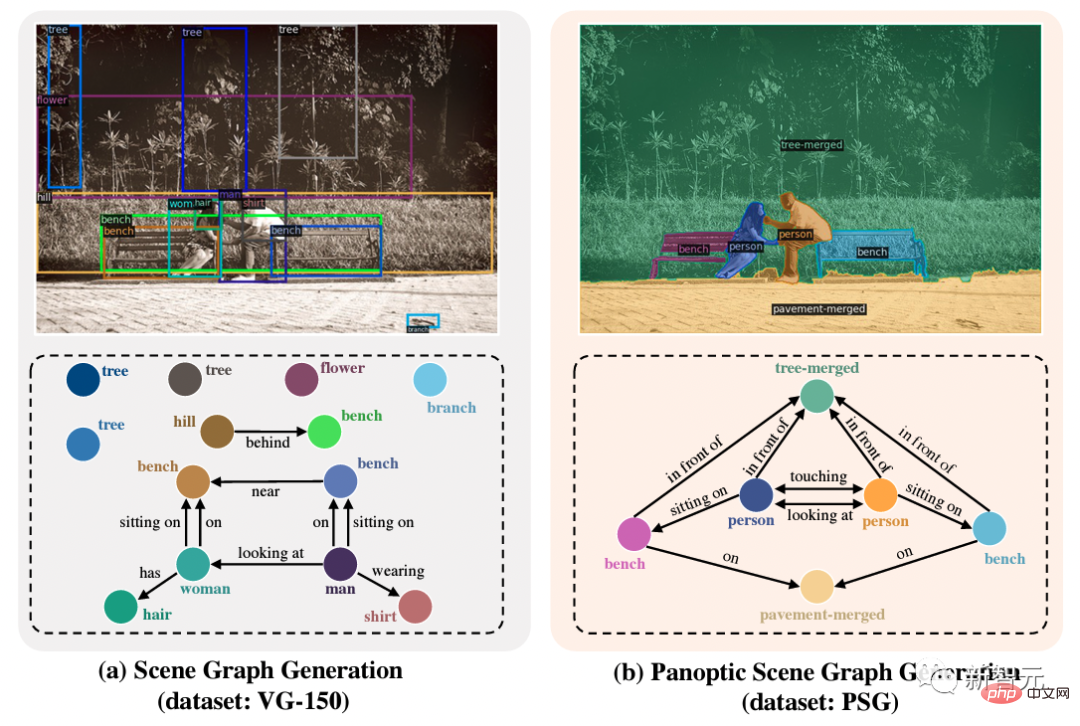

Die Aufgabe zur Szenendiagrammgenerierung (Szenendiagrammgenerierung oder SGG) soll die oben genannten Probleme lösen. Zusätzlich zu den Anforderungen zur Klassifizierung und Lokalisierung von Zielobjekten erfordert die SGG-Aufgabe auch, dass das Modell die Beziehung zwischen Objekten vorhersagt (siehe Abbildung 2).

Abbildung 2: Generierung von Szenendiagrammen Datensätze für traditionelle Szenen Diagrammgenerierungsaufgaben verfügen normalerweise über Begrenzungsrahmenanmerkungen von Objekten und Anmerkungen zu Beziehungen zwischen Begrenzungsrahmen. Diese Einstellung weist jedoch mehrere inhärente Mängel auf:

(1) Der Begrenzungsrahmen kann Objekte nicht genau lokalisieren: Wie in Abbildung 2 gezeigt, kann der Begrenzungsrahmen Objekte nicht genau lokalisieren, wenn Kennzeichnung von Personen. Es werden zwangsläufig Objekte in der Nähe von Personen einbezogen Ein Begrenzungsrahmen, der fast das gesamte Bild abdeckt, sodass die Beziehung zum Hintergrund nicht genau markiert werden kann. Dadurch kann das Szenendiagramm das Bild nicht vollständig abdecken und kein umfassendes Szenenverständnis erreichen.

Daher schlägt der Autor die vollständige Szenendiagrammgenerierungsaufgabe (PSG) mit einem fein annotierten PSG-Datensatz in großem Maßstab vor.

Abbildung 3: Vollständige Szenendiagrammgenerierung  Wie in Abbildung 3 gezeigt, ist die Die Aufgabe nutzt die Panoramasegmentierung, um Objekte und Hintergründe umfassend und genau zu lokalisieren, wodurch die inhärenten Mängel der Aufgabe zur Szenendiagrammgenerierung behoben und dadurch das Feld in Richtung eines umfassenden und tiefgreifenden Szenenverständnisses vorangetrieben wird.

Wie in Abbildung 3 gezeigt, ist die Die Aufgabe nutzt die Panoramasegmentierung, um Objekte und Hintergründe umfassend und genau zu lokalisieren, wodurch die inhärenten Mängel der Aufgabe zur Szenendiagrammgenerierung behoben und dadurch das Feld in Richtung eines umfassenden und tiefgreifenden Szenenverständnisses vorangetrieben wird.

Papierinformationen

Papierlink: https://arxiv .org/abs/2207.11247Projektseite: https://psgdataset.org/OpenPSG Codebasis: https://github.com/Jingkang50/OpenPSGWettbewerbslink: https://www.cvmart.net/race/10349/baseECCV'22 SenseHuman-Workshop-Link: https://sense-human.github.io/HuggingFace Demo-Link: https://huggingface.co/spaces/ECCV2022/PSG

Der vom Autor vorgeschlagene PSG-Datensatz enthält fast 50.000 Bilder von Coco. Basierend auf der vorhandenen Panorama-Segmentierungsannotation von Coco wird die Beziehung zwischen segmentierten Blöcken annotiert. Der Autor definiert sorgfältig 56 Arten von Beziehungen, darunter Positionsbeziehungen (über, vor usw.), allgemeine Beziehungen zwischen Objekten (hängen an usw.), allgemeine biologische Handlungen (darauf gehen, darauf stehen usw.) und menschliche Beziehungen Verhaltensweisen (Kochen usw.), Beziehungen in Verkehrsszenen (Fahren, Reiten usw.), Beziehungen in Bewegungsszenen (Treten usw.) und Beziehungen zwischen Hintergründen (Einschließen usw.). Der Autor verlangt von Annotatoren, dass sie präzisere Verbausdrücke statt vagerer Ausdrücke verwenden und die Beziehungen im Diagramm so vollständig wie möglich annotieren.

PSG -Modelleffekt Display

Task Vorteile Das linke Bild stammt aus Visual Genome (VG-150), einem traditionellen Datensatz für die SGG-Aufgabe. Es ist ersichtlich, dass auf Erkennungsfeldern basierende Anmerkungen normalerweise ungenau sind und die von den Erkennungsfeldern abgedeckten Pixel Objekte, insbesondere Hintergründe wie Stühle und Bäume, nicht genau lokalisieren können. Gleichzeitig neigt die auf Erkennungsrahmen basierende Beziehungsanmerkung dazu, einige langweilige Beziehungen zu kennzeichnen, z. B. „Menschen haben Köpfe“ und „Menschen tragen Kleidung“.

Im Gegensatz dazu bietet die im rechten Bild vorgeschlagene PSG-Aufgabe eine umfassendere (einschließlich der Interaktion von Vorder- und Hintergrund), klarere (angemessene Objektgranularität) und genauere (pixelgenaue) Szenendiagrammdarstellung die Entwicklung des Szenenverständnisfeldes.

Zwei Haupttypen von PSG-Modellen

Zwei Haupttypen von PSG-Modellen

Um die vorgeschlagenen PSG-Aufgaben zu unterstützen, hat der Autor eine Open-Source-Code-Plattform OpenPSG erstellt, die vier zweistufige Methoden und zwei einstufige Methoden implementiert, um die Entwicklung und Nutzung durch alle zu erleichtern , analysieren.

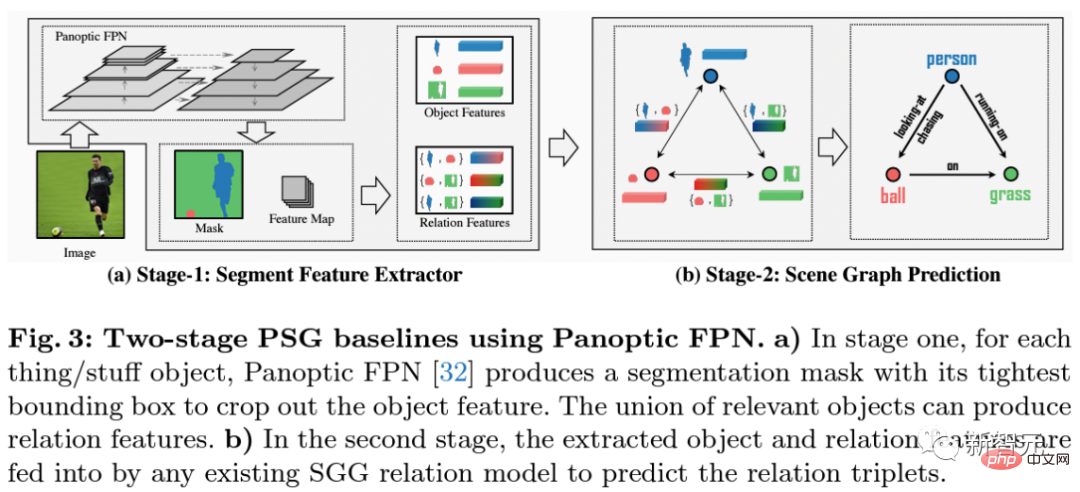

Die zweistufige Methode verwendet Panoptic-FPN, um in der ersten Stufe eine Panoramasegmentierung des Bildes durchzuführen.

Als nächstes extrahiert der Autor die Merkmale der durch Panoramasegmentierung erhaltenen Objekte und die Beziehungsmerkmale jedes Paars von Objektfusionen und sendet sie an die nächste Stufe der Beziehungsvorhersage. Das Framework hat die klassischen Methoden der traditionellen Szenendiagrammgenerierung IMP, VCTree, Motifs und GPSNet integriert und reproduziert.

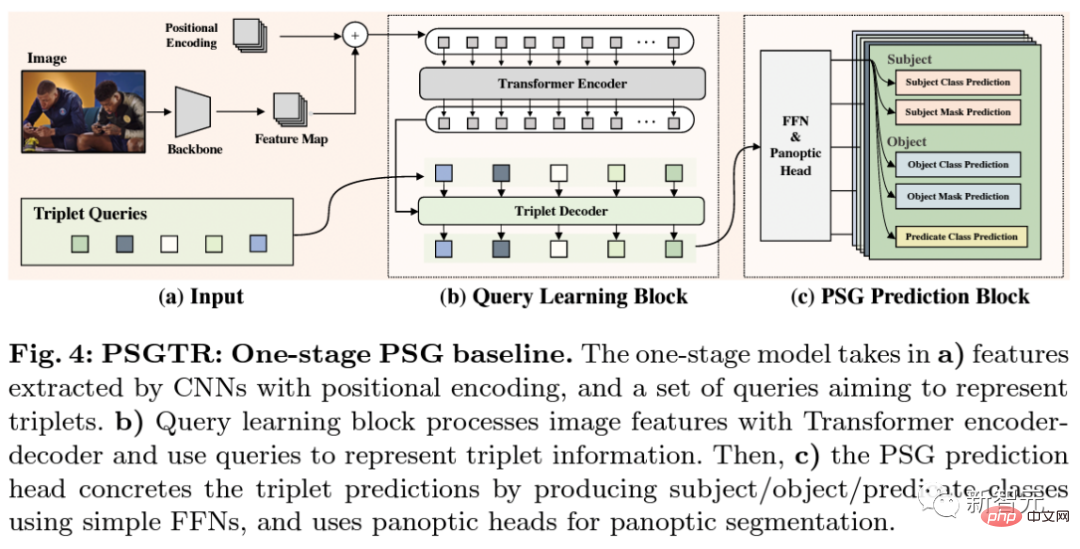

PSGFormer ist eine einstufige Methode, die auf dem Dual-Decoder-DETR basiert. Das Modell extrahiert zunächst Bildmerkmale über das Rückgrat des Faltungs-Neuronalen Netzwerks und fügt Positionscodierungsinformationen als Eingabe des Encoders hinzu. Gleichzeitig wird eine Reihe von Abfragen initialisiert, um Tripel darzustellen. Ähnlich wie bei DETR gibt das Modell in b) die Ausgabe des Encoders als Schlüssel und Wert zusammen mit den Abfragen, die Tripel darstellen, in den Decoder für den Cross-Attention-Betrieb ein. Anschließend gibt das Modell jede dekodierte Abfrage in das Vorhersagemodul ein, das dem Subjekt-Verb-Objekt-Triplett in c) entspricht, und erhält schließlich das entsprechende Triplett-Vorhersageergebnis.

PSGFormer ist eine einstufige DETR-Methode, die auf Dual-Dekodierung basiert. Das Modell a) extrahiert Bildmerkmale über CNN, gibt Informationen zur Positionskodierung in den Encoder ein und initialisiert zwei Sätze von Abfragen, um Objekte bzw. Beziehungen darzustellen. Dann lernt das Modell in Schritt b) basierend auf den vom Encoder codierten Bildinformationen die Objektabfrage und die Beziehungsabfrage durch Kreuzaufmerksamkeitsdecodierung im Objektdecoder bzw. Relationsencoder.

PSGFormer ist eine einstufige DETR-Methode, die auf Dual-Dekodierung basiert. Das Modell a) extrahiert Bildmerkmale über CNN, gibt Informationen zur Positionskodierung in den Encoder ein und initialisiert zwei Sätze von Abfragen, um Objekte bzw. Beziehungen darzustellen. Dann lernt das Modell in Schritt b) basierend auf den vom Encoder codierten Bildinformationen die Objektabfrage und die Beziehungsabfrage durch Kreuzaufmerksamkeitsdecodierung im Objektdecoder bzw. Relationsencoder.

Nachdem beide Arten von Abfragen gelernt wurden, werden die gepaarten Dreifachabfragen durch Zuordnung und Abgleich in c) erhalten. Schließlich werden in d) Vorhersagen über die Objektabfrage und die Beziehungsabfrage über den Vorhersagekopf abgeschlossen und das endgültige Ergebnis der dreifachen Vorhersage wird basierend auf den Übereinstimmungsergebnissen in c) erhalten.

PSGTR und PSGFormer sind beide erweiterte und verbesserte Modelle, die auf DETR basieren. Der Unterschied besteht darin, dass PSGTR einen Satz von Abfragen verwendet, um Tripel direkt zu modellieren, während PSGFormer zwei Sätze von Abfragen verwendet, um Objekte bzw. Beziehungen zu modellieren Einzelheiten finden Sie in den experimentellen Ergebnissen im Artikel.

Zusammenfassung der Schlussfolgerungen

Die meisten Methoden, die bei SGG-Aufgaben wirksam sind, sind bei PSG-Aufgaben immer noch wirksam. Einige Methoden, die starke statistische Prioritäten für den Datensatz oder Prioritäten für die Prädikatsrichtung in Subjekt, Prädikat und Objekt verwenden, sind jedoch möglicherweise nicht so effektiv. Dies kann auf die Tatsache zurückzuführen sein, dass die Verzerrung des PSG-Datensatzes im Vergleich zum herkömmlichen VG-Datensatz nicht so schwerwiegend ist und die Definition von Prädikatsverben klarer und lernbarer ist. Daher hoffen die Autoren, dass sich die nachfolgenden Methoden auf die Extraktion visueller Informationen und das Verständnis des Bildes selbst konzentrieren werden. Statistische Prioritäten können beim Brushing von Datensätzen effektiv sein, sie sind jedoch nicht unbedingt erforderlich.

Im Vergleich zum zweistufigen Modell können mit dem einstufigen Modell derzeit bessere Ergebnisse erzielt werden. Dies kann auf die Tatsache zurückzuführen sein, dass das Überwachungssignal über die Beziehung im einstufigen Modell direkt auf die Feature-Map-Seite übertragen werden kann, sodass das Beziehungssignal an mehr Modelllernen beteiligt ist, was sich positiv auf die Erfassung von Beziehungen auswirkt. Da dieser Artikel jedoch nur mehrere Basismodelle vorschlägt und keine einstufigen oder zweistufigen Modelle optimiert, kann nicht gesagt werden, dass das einstufige Modell notwendigerweise stärker ist als das zweistufige Modell. Dies hofft auch, dass die Teilnehmer weiterhin forschen.

Im Vergleich zur herkömmlichen SGG-Aufgabe führt die PSG-Aufgabe einen Beziehungsabgleich basierend auf der Panorama-Segmentierungskarte durch und erfordert eine Bestätigung der ID der Subjekt- und Objektobjekte in jeder Beziehung. Im Vergleich zur zweistufigen direkten Vorhersage der Panorama-Segmentierungskarte zur Vervollständigung der Aufteilung der Objekt-IDs muss das einstufige Modell diesen Schritt durch eine Reihe von Nachbearbeitungen abschließen. Wenn das bestehende einstufige Modell weiter verbessert und aktualisiert wird, ist es immer noch ein Thema, das untersucht werden sollte, wie die Bestätigung von Objekt-IDs im einstufigen Modell effektiver abgeschlossen und bessere Panorama-Segmentierungsbilder generiert werden können.

Endlich ist jeder herzlich willkommen, HuggingFace auszuprobieren:

Demo: https://huggingface.co/spaces/ECCV2022/PSG

Prospects about image.generation

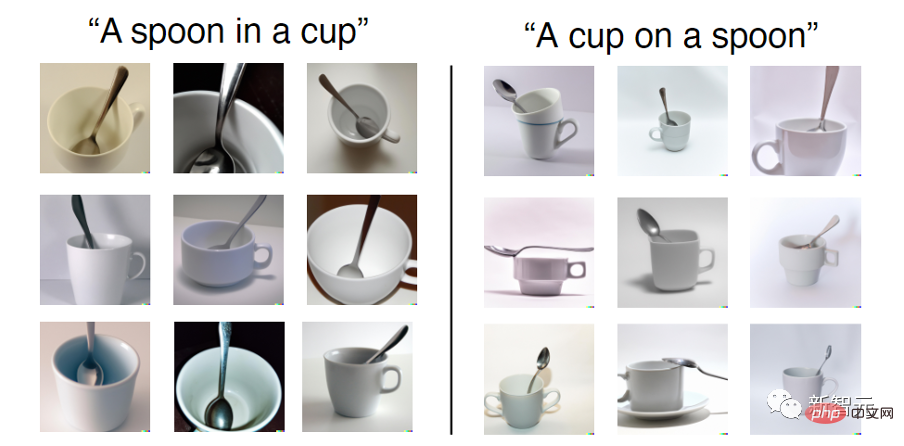

Basierend auf der Aktuelle generative Modelle für die Texteingabe (wie DALL-E 2) sind wirklich erstaunlich, aber einige Untersuchungen zeigen, dass diese generativen Modelle möglicherweise nur mehrere Entitäten im Text zusammenkleben, ohne die im Text ausgedrückten räumlichen Beziehungen überhaupt zu verstehen. Wie im Bild unten gezeigt, sind die generierten Bilder immer noch „Löffel auf Tasse“, obwohl die Eingabe „Tasse auf Löffel“ lautet.

Zufällig ist der PSG-Datensatz mit einer maskenbasierten Szenendiagrammbeziehung gekennzeichnet. Der Autor kann Szenendiagramm und Panorama-Segmentierungsmaske als Trainingspaar verwenden, um ein Text2Mask-Modell zu erhalten und detailliertere Bilder basierend auf der Maske zu generieren. Daher ist es möglich, dass der PSG-Datensatz auch eine potenzielle Lösung für die beziehungsorientierte Bilderzeugung bietet.

P.S. Die „PSG Challenge“, die das Feld dazu anregen soll, gemeinsam die umfassende Szeneerkennung zu erkunden, ist in vollem Gange. Wettbewerbslink: https://www.cvmart.net/race/10349/base

Das obige ist der detaillierte Inhalt vonDas Nanyang Polytechnic schlug die Aufgabe vor, PSG aus dem vollständigen Szenendiagramm zu generieren, Objekte auf Pixelebene zu lokalisieren und 56 Beziehungen vorherzusagen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr