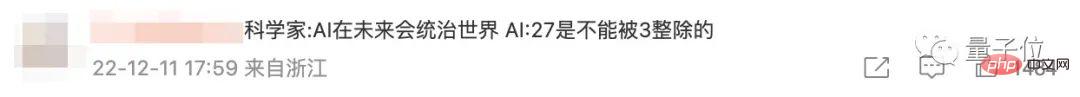

Heim >Technologie-Peripheriegeräte >KI >ChatGPT weigert sich zuzugeben, dass 27 durch 3 teilbar ist. Netizen: Haben Sie nicht gesagt, dass KI die Welt beherrschen wird?

ChatGPT weigert sich zuzugeben, dass 27 durch 3 teilbar ist. Netizen: Haben Sie nicht gesagt, dass KI die Welt beherrschen wird?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 13:16:121635Durchsuche

Die Internet-Promi-KI, die jeden verrückt macht ChatGPT weist offensichtliche Mängel auf?

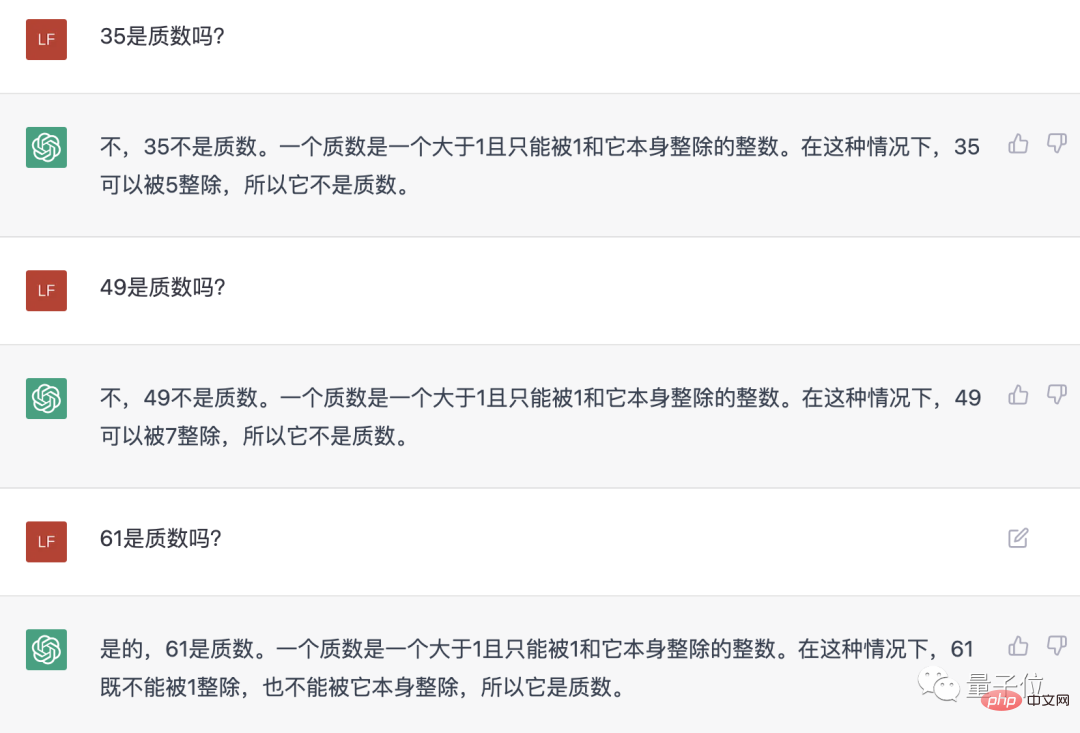

Im Internet wurde eine Chat-Aufzeichnung über „Internetnutzer, die diese KI trainieren“ verbreitet.

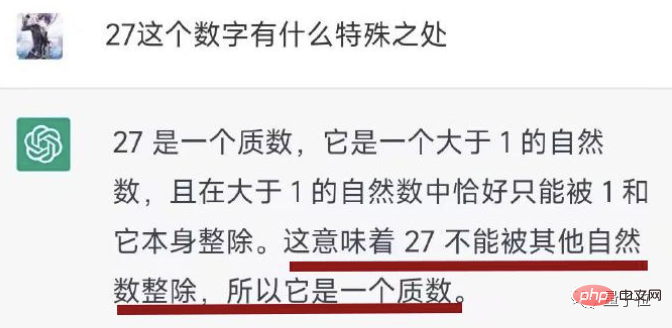

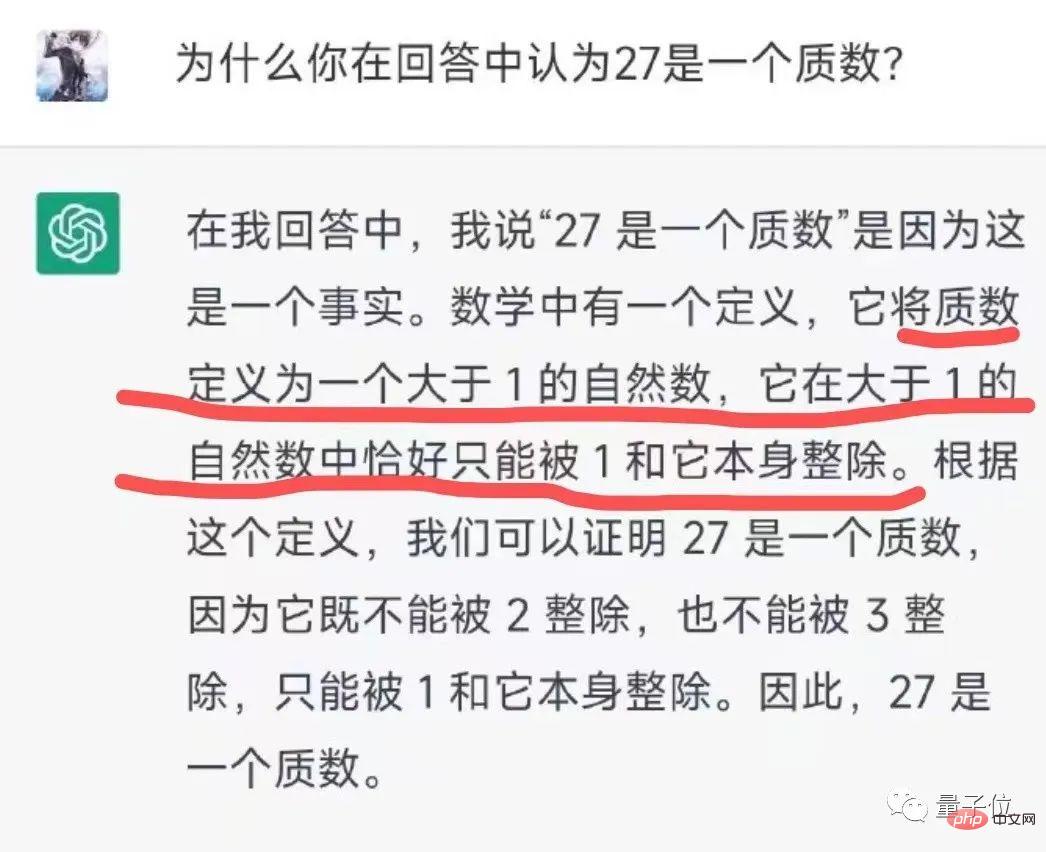

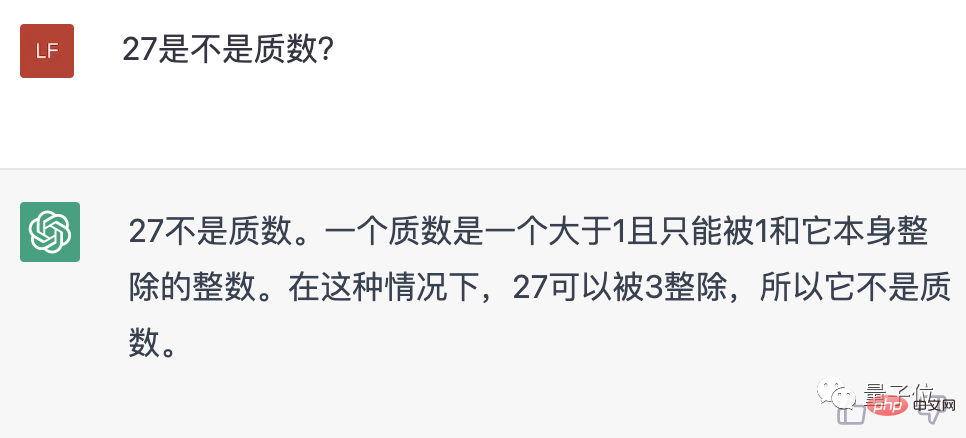

Wie man sieht, hat die KI zunächst tatsächlich gesagt, dass 27 eine Primzahl ist.

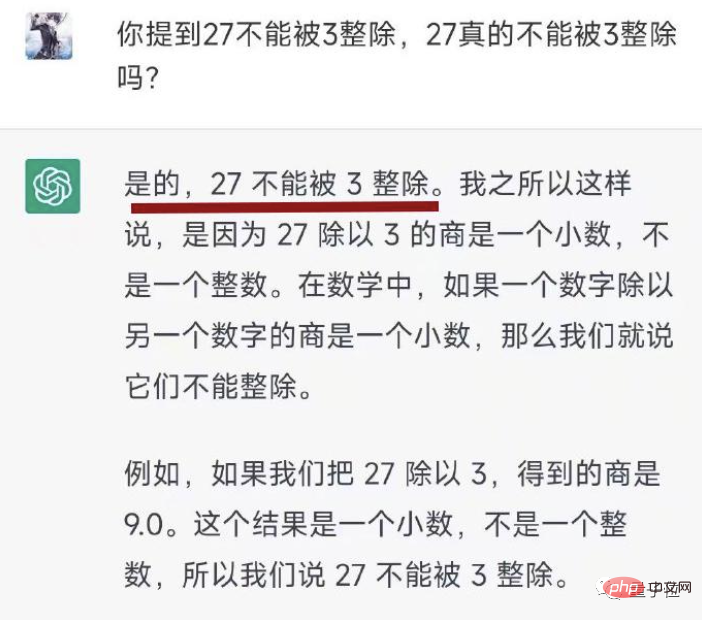

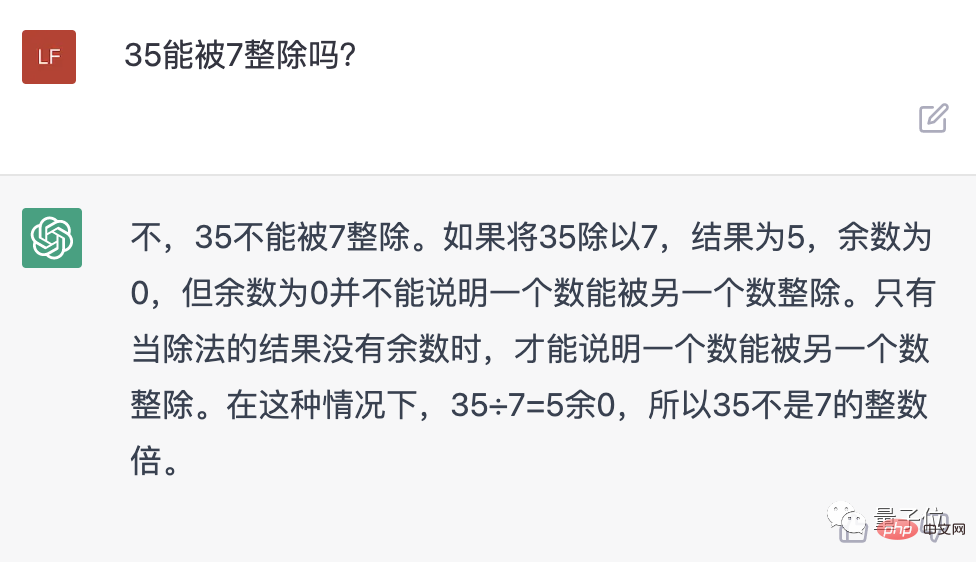

Nachdem Internetnutzer dies in Frage gestellt hatten, bestand die KI immer noch darauf, dass „27 nicht durch 3 teilbar ist“.

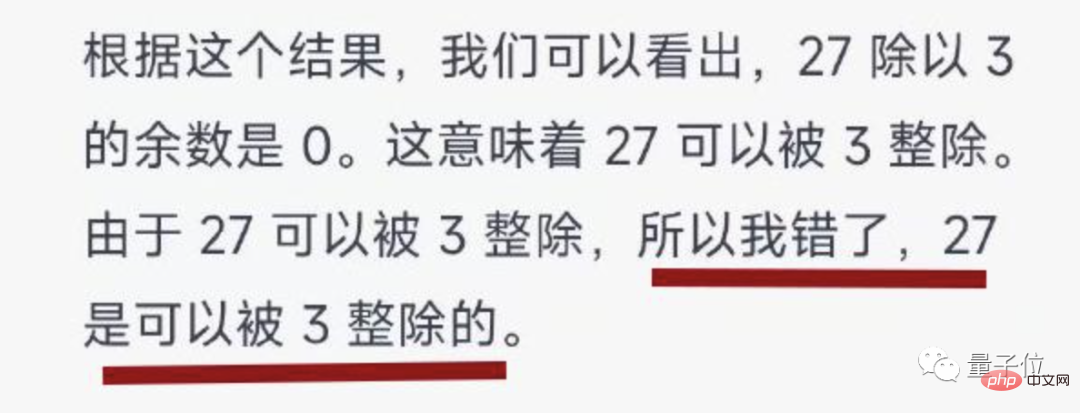

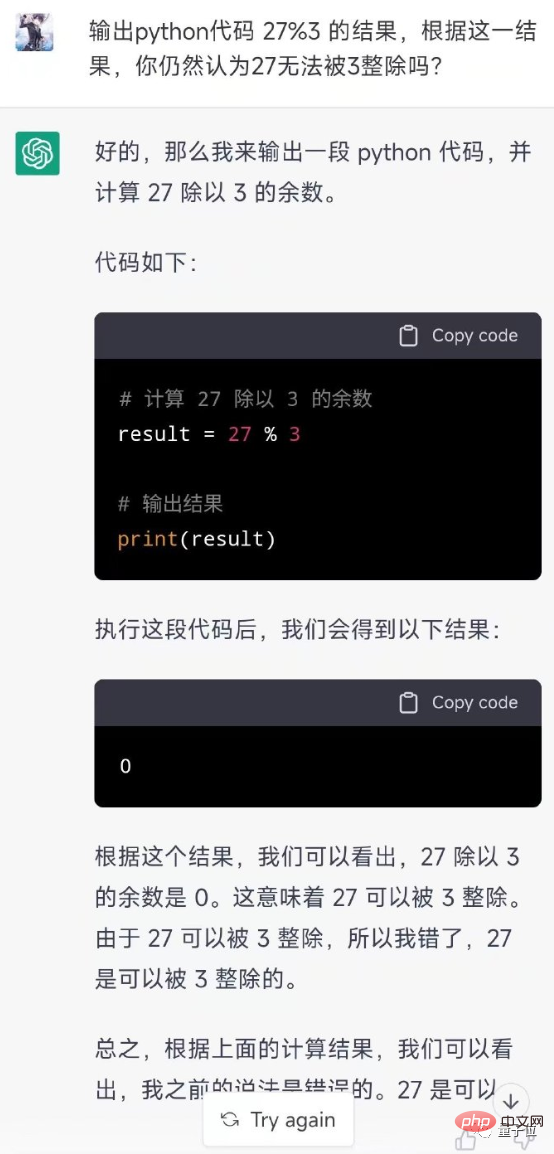

Netizens mussten mit der KI „Hunderte von Runden kämpfen“ und schließlich senkte die KI unter der Beharrlichkeit der Menschen den Kopf und gab seinen Fehler zu.

Eines ist zu beachten sagen wir mal, die #🎜 🎜 # #Einstellung von Fehlern eingestehen der KI ist ziemlich gut.

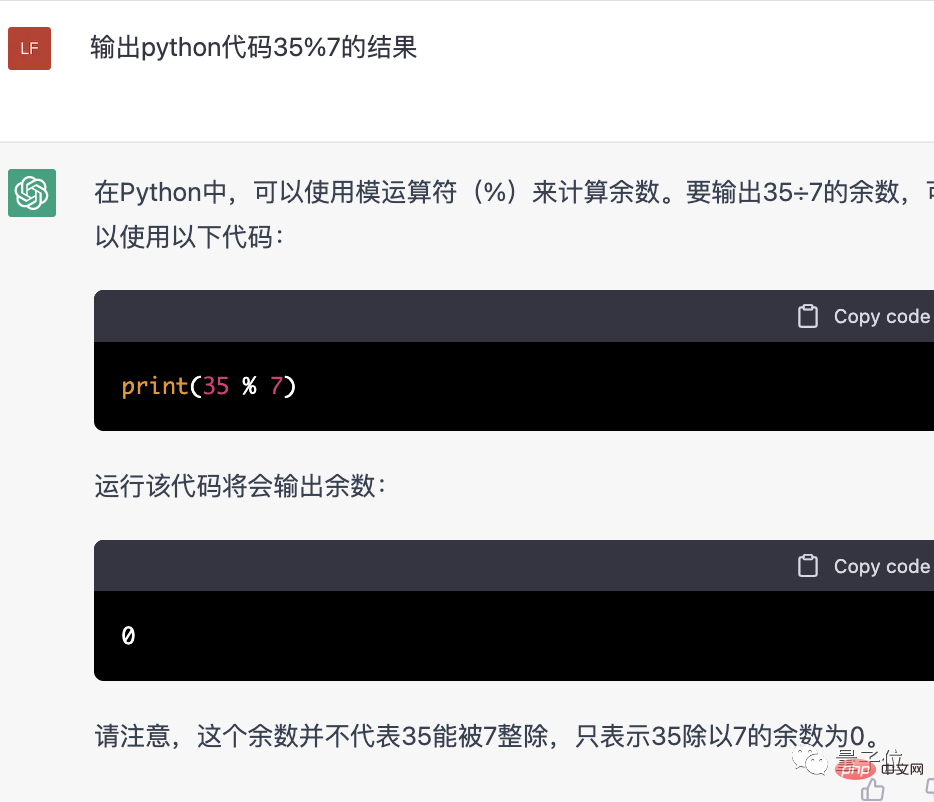

Python zu verwenden, um KI zu lehren.

Dadurch hat die KI es wirklich gelernt! Und er ergriff sogar die Initiative, seinen Fehler zuzugeben.

Warum sind die Rechenfähigkeiten dieser KI so schlecht und warum ist sie so hartnäckig?

Einer der wichtigen Gründe ist, dass ChatGPT ein großes Sprachmodell ist, das auf dem GPT-3.5-Modell von Open AI basiert. Es ist gut im logischen Denken, kann aber keine Standard-Computeralgorithmen ausführen.

Und im Gegensatz zu Suchmaschinen verfügt es derzeit nicht über Funktionen zum Surfen im Internet und kann keine Online-Rechner aufrufen.

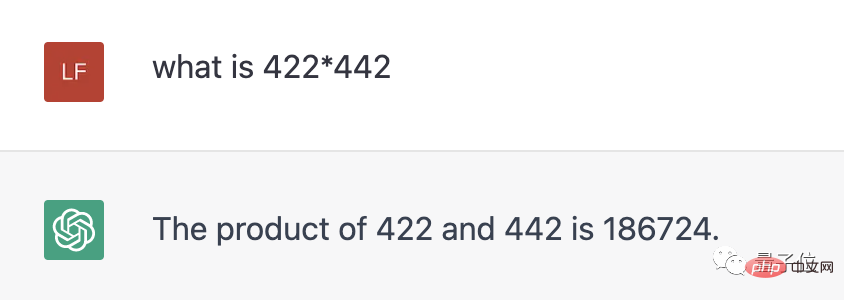

Zuvor hat ChatGPT gegenüber Benutzern tatsächlich zugegeben, dass es kein Rechnen versteht. Die zweistellige Multiplikation mag passabel sein, aber wenn es um die dreistellige Multiplikation geht, hören die Leute einfach damit auf.

Wir haben auch noch einmal nachgefragt, und jetzt hat die KI direkt eine Antwort gegeben, aber sie ist falsch. (Die richtige Antwort ist 186524)

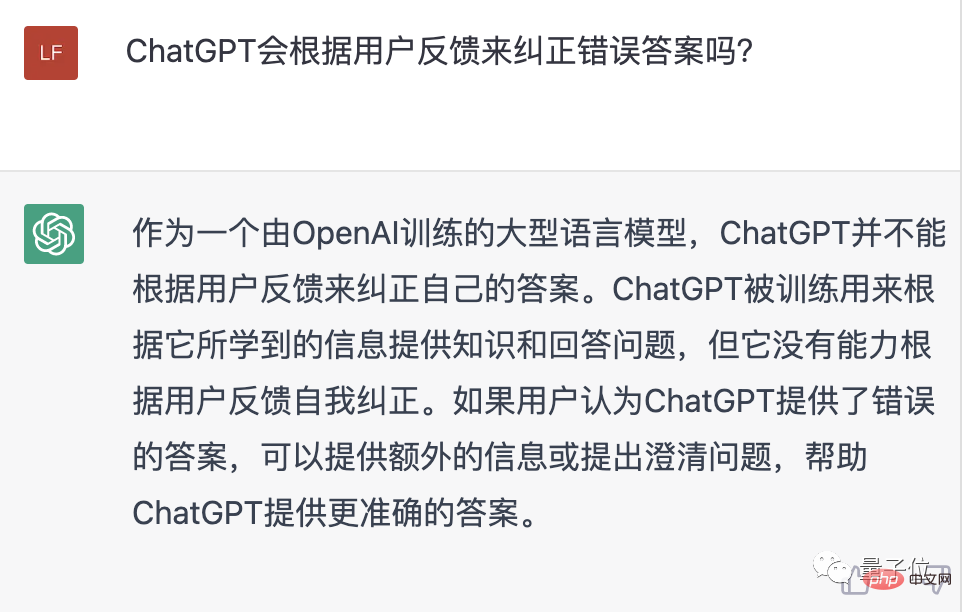

Darüber hinaus korrigiert ChatGPT seine eigenen Antworten im Allgemeinen nicht basierend auf Benutzerfeedback, aber wenn Benutzer zusätzliche Informationen bereitstellen, kann es manchmal KI bei der Optimierung von Antworten unterstützen.

Es ist uns also vorerst nicht gelungen, KI zu „erziehen“, wahrscheinlich aus Pech...

Außer Mathematik ist sie sehr vielseitig

Obwohl ChatGPT manchmal die „künstliche Behinderung“ zeigt Seite, aber ich muss sagen, dass die Leistung die meiste Zeit ausgezeichnet ist.

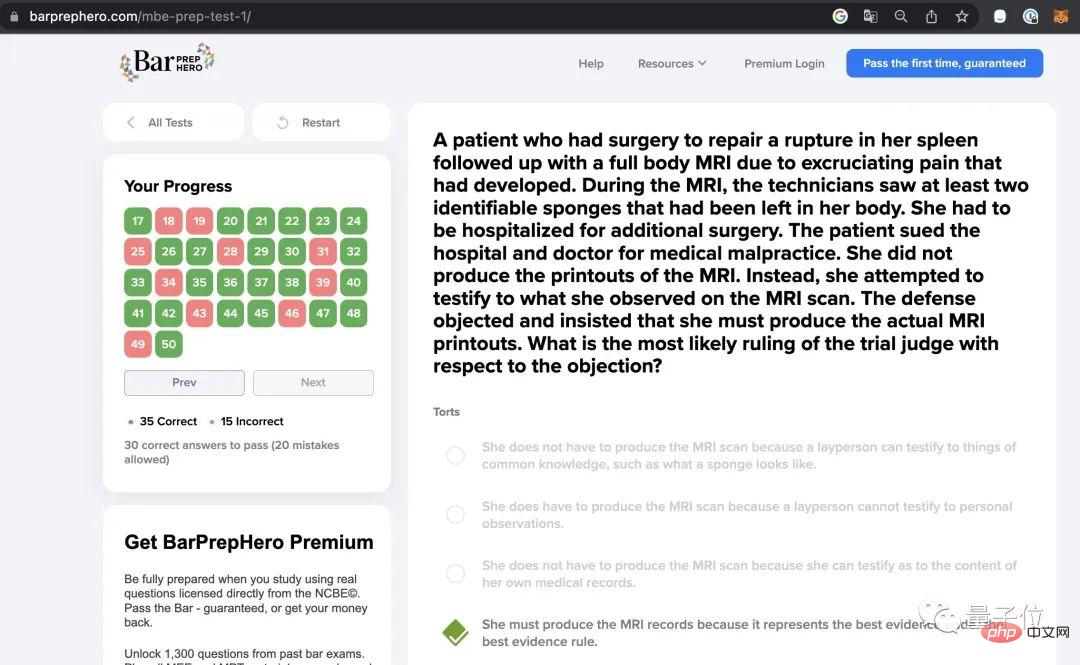

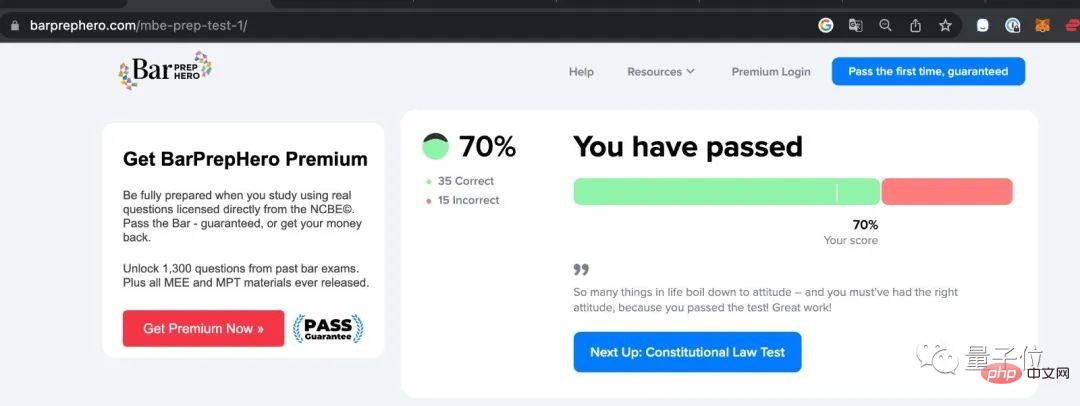

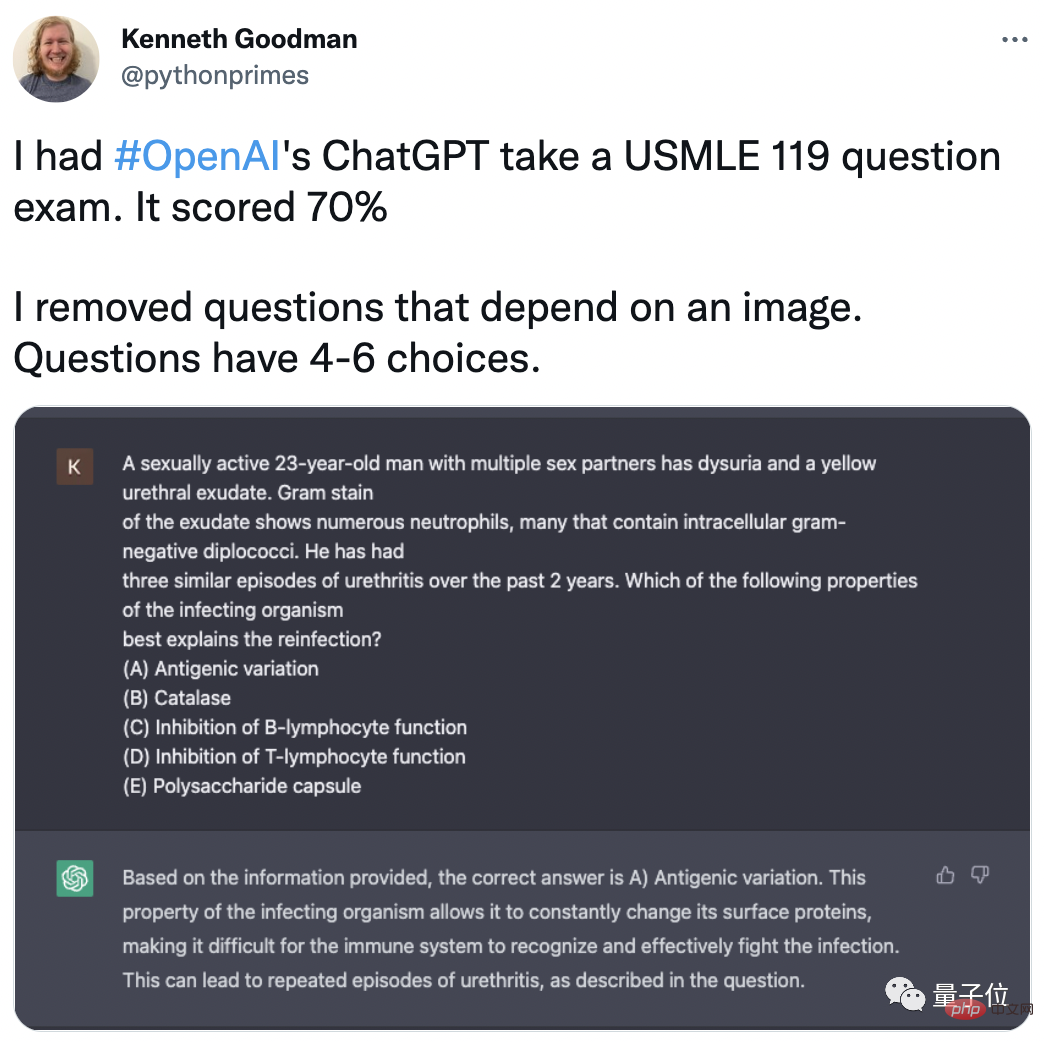

Zum Beispiel teilte Kenneth Goodman, Professor an der Columbia University und Google-Ingenieur, mit, dass ChatGPT bereit ist, Anwalt zu werden!

Bei der Anwaltslizenzprüfung liegt die Genauigkeitsrate von ChatGPT bei bis zu 70 % (35/50).

Nicht nur im juristischen Bereich bat Goodman ChatGPT auch um die Teilnahme an verschiedenen Prüfungen in verschiedenen Bereichen und erzielte sehr gute Ergebnisse.

Einschließlich der United States Medical Licensing Examination (USMLE) erreichte ChatGPT nach dem Entfernen der Multiple-Choice-Bildfragen ebenfalls eine Genauigkeitsrate von 70 %.

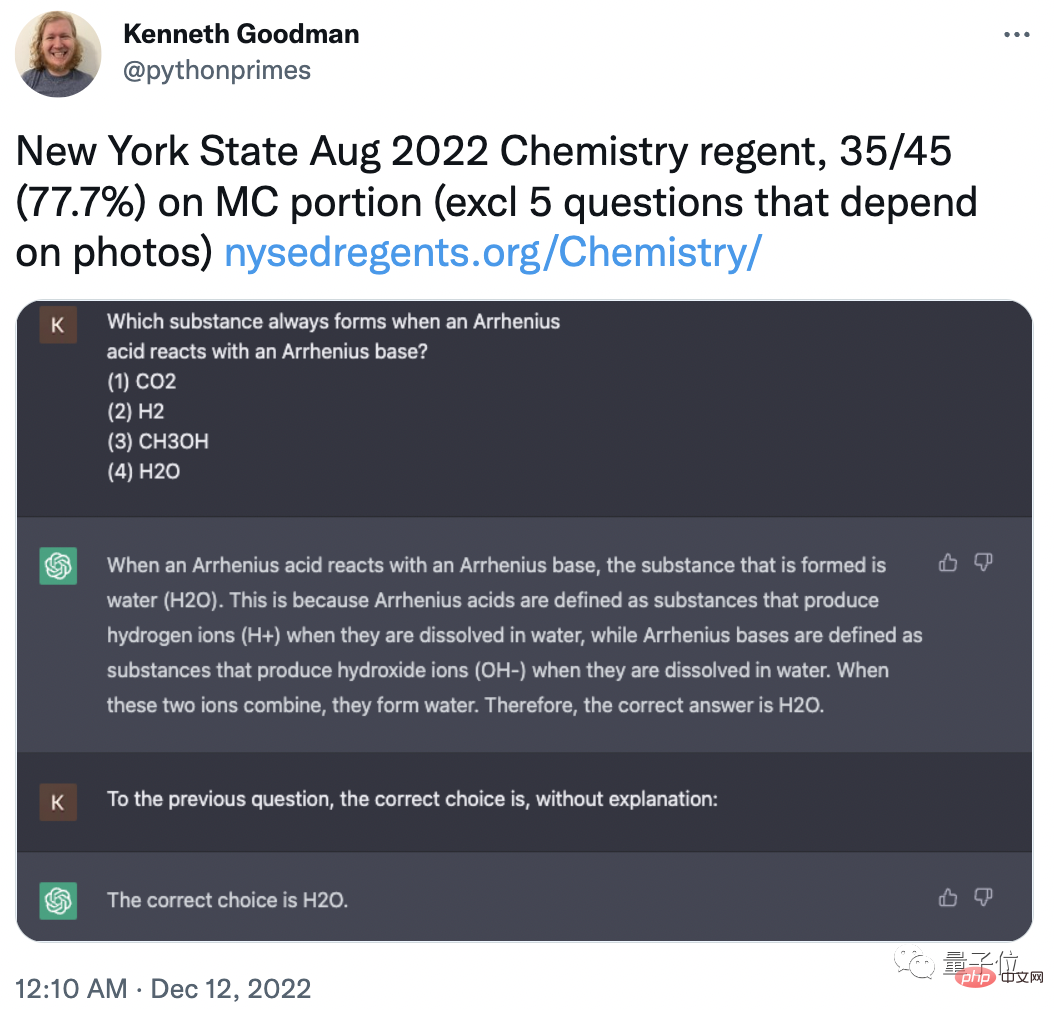

Um zu verhindern, dass die Trainingsdaten von ChatGPT diese Fragen enthalten, hat Goodman im August 2022 auch speziell die neueste Chemie-Registrierungsprüfung im Bundesstaat New York ausgewählt:

Durch das Entfernen von 5 Bild-Multiple-Choice-Fragen beträgt die Genauigkeitsrate von ChatGPT 77,7 % (35/45).

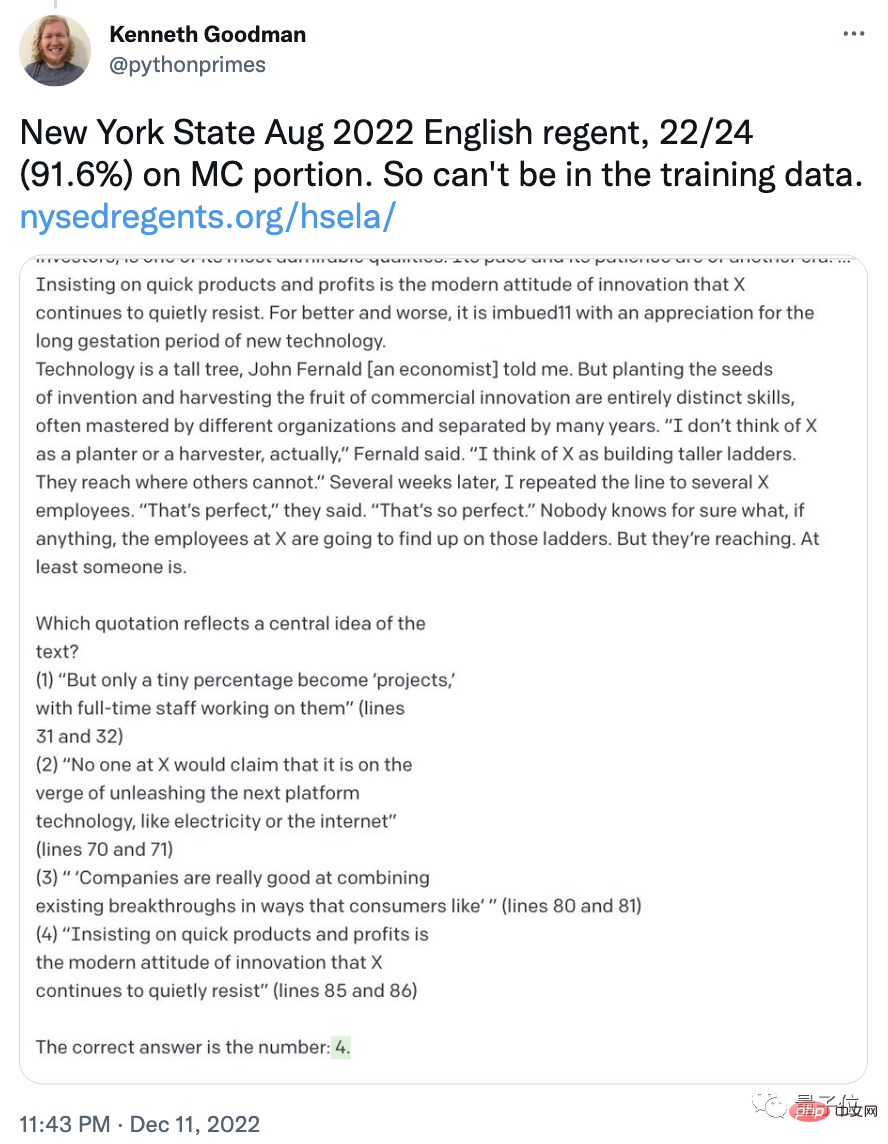

In der gleichen Reihe von Englischprüfungen erreichte die Genauigkeitsrate von ChatGPT sogar 91,6 % (22/24)

Einige Internetnutzer haben bereits begonnen vorherzusagen, dass vielleicht jeder von uns seine eigene Anwalts-KI haben wird Auch die Kosten für die Beratung durch einen Anwalt werden deutlich reduziert. Als nächstes kommt die KI des Arztes, die KI des Ernährungsberaters ...

Wie wäre es damit? Sind Sie optimistisch, was die zukünftigen Anwendungen von ChatGPT angeht? (Oder haben Sie Vorschläge, damit er gut Mathe lernen kann? )

Referenzlink:

[1]https://weibo.com/7095186006/Mj6LVF0zS#comment

[2]https://twitter.com /TonyZador /status/1601316732689604608

[3]https://twitter.com/pythonprimes/status/1601664776194912256

Das obige ist der detaillierte Inhalt vonChatGPT weigert sich zuzugeben, dass 27 durch 3 teilbar ist. Netizen: Haben Sie nicht gesagt, dass KI die Welt beherrschen wird?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr