Heim >Technologie-Peripheriegeräte >KI >Die Vergangenheit und Gegenwart von ChatGPT: Die technische „Sturheit' und das „große Wagnis' von OpenAI

Die Vergangenheit und Gegenwart von ChatGPT: Die technische „Sturheit' und das „große Wagnis' von OpenAI

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 12:16:031165Durchsuche

1. ChatGPT, künstliche Intelligenz, die nicht mehr „dumm“ ist

ChatGPT-bezogene Themen sollten als der beliebteste Hotspot für künstliche Intelligenz seit AlphaGo angesehen werden. Um es einfach auszudrücken: Es handelt sich um einen Roboter, der in natürlicher Sprache sprechen kann. Sie können ihm jede Frage stellen (natürlich kann er falsch antworten, aber Sie können ihn anleiten und korrigieren), und er wird in einer sehr glatten und natürlichen Sprache antworten Sprache. Darüber hinaus können damit auch Codierungsfragen, Mathematikfragen usw. beantwortet werden, und Sie können damit ein großartiges Gespräch über jedes Thema führen.

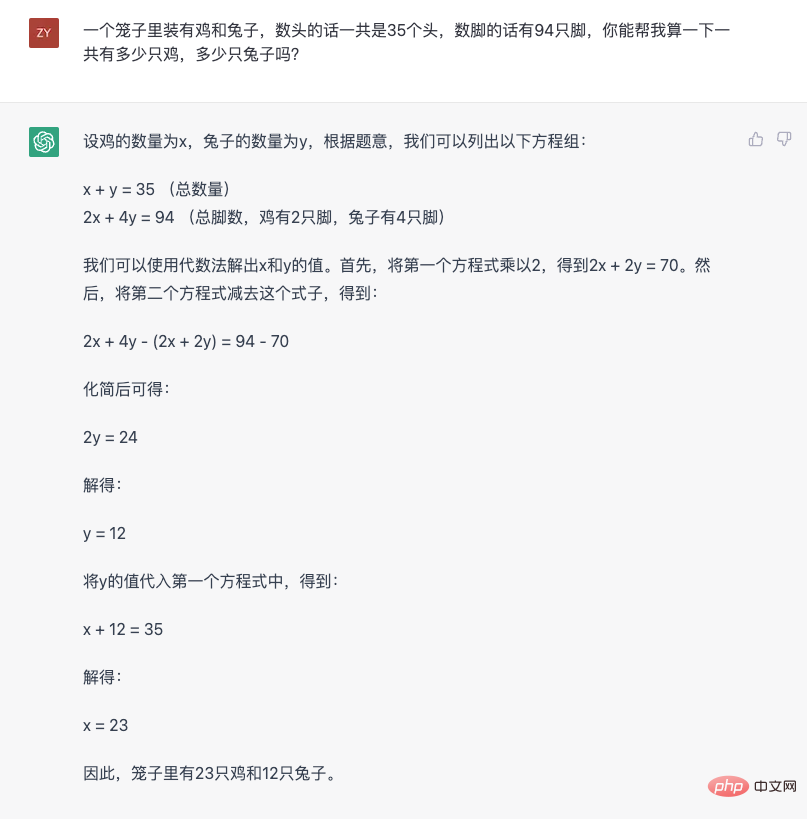

Wir können ein klassisches Problem mit Hühnern und Kaninchen im selben Käfig verwenden, um die Fähigkeiten von ChatGPT wahrnehmungsmäßig zu verstehen:

Aus dieser Antwort können mehrere Merkmale beobachtet werden. Das erste ist die Fähigkeit, natürliche Sprache zu verstehen und in mathematische Probleme umzuwandeln. Zweitens wird ein komplexeres Argumentationsproblem Schritt für Schritt aufgeschlüsselt, um Schritt für Schritt die endgültige Antwort zu erhalten. Diese Fähigkeit wird in der Branche als „Denkkette“ bezeichnet. Ändern Sie als Nächstes die Frage und sehen Sie, wie sie reagiert.

Auf diesem Bild ist zu erkennen, dass ChatGPT weiß, was es sagt, und Gründe dafür nennen kann. Darüber hinaus kann auch festgestellt werden, dass es Fehler macht (das erste Mal, als ich die Anzahl der Ohren berechnet habe, war falsch. Hier ist eine triviale Tatsache, dass Hühner funktionelle Organe haben, die „Ohren“ ähneln), aber es kann eine Anleitung gegeben werden. Geben Sie die richtige Antwort und erklären Sie, warum Sie falsch liegen.

Wenn ich Ihnen nicht im Voraus sage, dass es sich um ein Modell der künstlichen Intelligenz handelt, fühlt sich ChatGPT wie eine echte Person mit echten logischen Denk- und Sprachkommunikationsfähigkeiten an. Durch sein Erscheinen hat jeder das Gefühl, dass künstliche Intelligenz endlich normal mit Menschen kommunizieren kann, aber es gibt zumindest keine sprachlichen und logischen Barrieren im Kommunikationsprozess worüber Sie sprechen, und geben Ihnen Feedback gemäß menschlichen Denkmustern und Sprachnormen. Diese sehr intelligente Erfahrung ist der Grund dafür, dass sie die kleinen Kreise der Branche durchbricht und der Öffentlichkeit ein Gefühl der Wirkung vermittelt.

Dieses Thema der Erfahrung möchte ich auch noch einmal betonen, denn vielleicht hat die Industrie in der Vergangenheit aufgrund technischer Einschränkungen darauf verzichtet, um bestimmte Aufgaben in der Szene zu erledigen. Das heutige Aufkommen von ChatGPT bedeutet, dass künstliche Intelligenz nicht mehr die „nützliche, aber dumme“ Form der Vergangenheit ist.

Um besser zu verstehen, wie das sehr intelligente Gefühl von ChatGPT zustande kommt, ist es unumgänglich, mit der „dummen“ künstlichen Intelligenz der Vergangenheit zu beginnen. Um genau zu sein, verwendet ChatGPT immer noch die NLP-Technologie (Natural Language Processing), bricht jedoch mit dem ursprünglichen Paradigma.

Um das zu verstehen, kann man zunächst einen Blick auf die aktuelle Mainstream-Praxis werfen. Menschliche Kommunikation basiert auf Sprache, und viele Menschen glauben sogar, dass menschliches Denken auch auf Sprache basiert. Daher war das Verstehen und Verwenden natürlicher Sprache schon immer ein wichtiges Thema in der künstlichen Intelligenz. Aber Sprache ist zu komplex. Damit Computer Sprache verstehen und verwenden können, ist dieser Prozess normalerweise in viele Unterteilungen unterteilt. Dies wird im technischen Bereich häufig als „Aufgabe“ bezeichnet. Hier ein paar Beispiele:

- Die Sentimentanalyse-Aufgabe zielt darauf ab, die in der Sprache enthaltenen emotionalen Tendenzen zu verstehen.

- Die Syntaxanalyse-Aufgabe zielt auf die Analyse der sprachlichen Struktur des Textes ab.

- Die Entitätserkennungsaufgabe zielt auf die Extraktion von Informationen ab aus dem Text Entitätsfragmente wie Adressen, Namen usw. lokalisieren;

- Entitätsverbindungsaufgaben zielen darauf ab, Beziehungen zwischen Entitäten aus Text zu extrahieren; Verarbeiten Sie natürliche Sprache von der unterteilten Seite. Dies bietet viele Vorteile. Mit diesen Aufteilungen können Sie beispielsweise die Segmentierungsfähigkeiten eines Systems zur Verarbeitung natürlicher Sprache aus verschiedenen Dimensionen untersuchen. Sie können auch ein System oder Modell speziell für ein bestimmtes segmentiertes Element entwerfen. Aus technischer Sicht ist die Aufteilung einer komplexen Aufgabe (Verstehen und Verwenden natürlicher Sprache) in viele einfache Aufgaben (verschiedene NLP-Aufgaben) tatsächlich eine typische Methode zur Lösung komplexer Probleme. Dies ist auch gängige Praxis. Nach dem Aufkommen von ChatGPT ist diese Aufteilung im Nachhinein jedoch möglicherweise nicht die effektivste Möglichkeit, Computern das Verstehen und Verwenden natürlicher Sprache zu ermöglichen.

Denn eine hervorragende Leistung bei einer einzelnen Aufgabe bedeutet nicht, dass das System die natürliche Sprache beherrscht. Der „Intelligenzsinn“ des Menschen gegenüber künstlicher Intelligenz basiert auf seiner allgemeinen Fähigkeit, natürliche Sprache darauf anzuwenden, was sich deutlich in ChatGPT widerspiegelt

. Obwohl OpenAI den API-Dienst von ChatGPT nicht geöffnet hat und die Außenwelt seine spezifischen Auswirkungen auf verschiedene unterteilte NLP-Aufgaben nicht bewerten konnte, haben frühere externe Tests seiner Vorgängermodelle GPT-3, InstructGPT und anderer Modelle dies für einige spezifische gezeigt Bei Aufgaben kann ein kleines Modell, das mit speziellen Daten verfeinert wird, tatsächlich bessere Ergebnisse erzielen (eine detaillierte Analyse finden Sie unter „Vertiefendes Verständnis der Emergent Capability of Language Models“). Aber diese kleinen Modelle, die bei einer einzelnen Aufgabe eine bessere Leistung erbringen, verursachen keinen großen, aus dem Kreis geratenden Effekt. Letztendlich liegt es daran, dass sie nur eine einzige Fähigkeit haben. Eine einzelne herausragende Fähigkeit bedeutet nicht, dass sie die Fähigkeit haben, natürliche Sprache zu verstehen und zu verwenden, und daher nicht allein in tatsächlichen Anwendungsszenarien eine Rolle spielen können. Aus diesem Grund werden in einem realen Anwendungsszenario normalerweise mehrere Module mit Einzelpunktfunktionen künstlich entworfen und zusammengesetzt. Diese künstliche Art des Patchworks führt dazu, dass sich frühere Systeme der künstlichen Intelligenz unintelligent anfühlen. Aus der Perspektive des Menschen, der natürliche Sprache versteht und verwendet, ist dieses Phänomen eigentlich leicht zu verstehen. Wenn normale Menschen natürliche Sprache verstehen und verwenden, teilen sie sie nicht in viele verschiedene Aufgaben auf, analysieren jede Aufgabe einzeln und fassen sie dann zusammen. Dies ist nicht die Art und Weise, wie Menschen natürliche Sprache verwenden. So wie eine Person einen Satz hört, analysiert er nicht einzeln dessen syntaktische Struktur, den Inhalt und die Beziehung der Entität, die emotionale Tendenz usw. und setzt dann die Bedeutung des Satzes zusammen. Der Prozess des Sprachverständnisses der Menschen ist ein ganzheitlicher Prozess. Darüber hinaus wird das Gesamtverständnis der Menschen für diesen Satz durch Antworten vollständig in Form natürlicher Sprache zum Ausdruck gebracht. Dieser Prozess ist nicht mit einem künstlichen Intelligenzsystem zu vergleichen, das eine einzelne Aufgabe aufteilt und dann nacheinander Stimmungsanalyseetiketten, Fragmente von Entitätsinformationen oder die Ergebnisse einer anderen einzelnen Aufgabe ausgibt und diese Dinge dann verwendet, um eine Antwort zusammenzusetzen.

UndVertreten durch ChatGPT kommen die Modelle der GPT-Serie der menschlichen Fähigkeit, Sprache zu verstehen und zu verwenden, wirklich nahe – natürliche Sprache direkt zu empfangen, dann direkt auf natürliche Sprache zu antworten und die Sprachgewandtheit sicherzustellen Und Logik

. Dies ist eine Art der Kommunikation, daher wird es von allen als „sehr intelligentes“ Erlebnis angesehen. Vielleicht denken viele Leute, dass es großartig wäre, wenn es wie ChatGPT möglich wäre. Die Aufteilung von Aufgaben war in der Vergangenheit aufgrund technischer Einschränkungen ein letzter Ausweg. Aus Sicht der technischen Anwendung ist ein solcher Umwegansatz natürlich notwendig. Diese Methode wird seit langem angewendet und kann tatsächlich Probleme in vielen praktischen Szenarien lösen. Wenn Sie jedoch auf den Entwicklungsprozess der Modelle der GPT-Serie zurückblicken, werden Sie feststellen, dass OpenAI einen anderen Weg eingeschlagen hat, und sie haben „gezockt“ und gewonnen. 2. OpenAIs „Gamble“

Die erste Generation von GPT, wo alles begannBereits im Jahr 2018 veröffentlichte OpenAI die erste Version des GPT-Modells. Aus dem öffentlichen Artikel von OpenAI (Improving Language Understanding by Generative Pre-Training) können wir lernen, dass dieses Modell eine 12-schichtige Transformer-Decoder-Struktur verwendet und etwa 5 GB benötigt von unbeaufsichtigten Textdaten zum Trainieren von Sprachmodellaufgaben. Obwohl das GPT-Modell der ersten Generation bereits generatives Vortraining verwendet (was auch der Ursprung des Namens GPT, Generative Pre-Training, also generatives Vortraining) ist, verwendet es das Paradigma des unbeaufsichtigten Vortrainings + nachgelagerte Aufgaben-Feinabstimmung . Dieses Paradigma ist eigentlich keine neue Erfindung, es wurde jedoch aufgrund der herausragenden Leistung des ELMo-Modells in diesem Jahr wieder in den Bereich des NLP eingeführt.

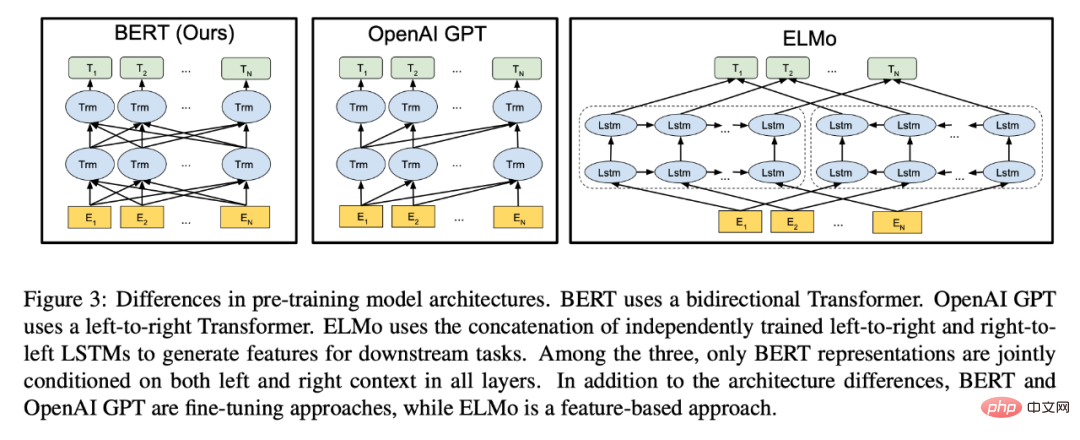

Das Aufkommen des GPT-Modells erregte in diesem Jahr zwar einige Aufmerksamkeit in der Branche, aber es war in diesem Jahr nicht der C-Protagonist. Denn im selben Jahr kam das BERT-Modell von Google heraus, das mit seinen hervorragenden Ergebnissen fast die ganze Aufmerksamkeit auf sich zog (diese Szene ähnelt ein bisschen dem aktuellen ChatGPT, ich kann nicht anders, als zu seufzen, dass es wirklich „Missstände“ zwischen Google und OpenAI gibt Reinkarnation).

Das Bild stammt aus dem BERT-Papier. Aus der Abbildung können Sie ersehen, dass BERT mit GPT verglichen wurde und stolz auf die bidirektionale Kodierungsfunktion hingewiesen wurde.

Obwohl das BERT-Modell auch die gleiche Transformer-Modellstruktur wie GPT verwendet, handelt es sich fast um ein Modell, das auf das Paradigma „unüberwachtes Vortraining + Feinabstimmung von nachgelagerten Aufgaben“ zugeschnitten ist. Im Vergleich zu GPT verliert das von BERT verwendete maskierte Sprachmodell zwar die Fähigkeit, Text direkt zu generieren, erhält jedoch die Fähigkeit zur bidirektionalen Codierung, was dem Modell eine stärkere Textcodierung verleiht. Die Leistung spiegelt sich direkt in der erheblichen Verbesserung der nachgelagerten Aufgabeneffekte wider. Um die Fähigkeit zur Textgenerierung beizubehalten, kann GPT nur eine Einwegkodierung verwenden.

Aus der Perspektive dieses Jahres ist BERT definitiv ein besseres Modell. Da sowohl BERT als auch GPT das Paradigma „Vortraining + Feinabstimmung“ übernehmen und die nachgelagerten Aufgaben immer noch „klassische“ NLP-Aufgabenformen wie Klassifizierung, Matching, Sequenzkennzeichnung usw. sind, schenkt das BERT-Modell mehr Aufmerksamkeit Feature-Codierung Für Downstream-Aufgaben ist die Auswahl einer geeigneten Verlustfunktion, die zur Feinabstimmungsaufgabe passt, offensichtlich direkter als GPT, das die Textgenerierung verwendet, um diese Aufgaben „umzudrehen“.

Nachdem das BERT-Modell auf den Markt kam, etablierte sich das Paradigma „unüberwachtes Training + nachgelagerte Aufgabenoptimierung“ als Vorherrschaft. Verschiedene Methoden folgten den Ideen von BERT und überlegten, „wie man eine bessere Codierung von Textfunktionen erreichen kann“. Es gibt so viele, dass GPT , ein Modell, das auf generative Aufgaben abzielt, scheint ein „Alien“ zu sein. Im Nachhinein betrachtet hätten wir möglicherweise länger warten müssen, um Modelle wie ChatGPT zu sehen, wenn OpenAI „dem Trend gefolgt“ wäre und den Weg des generativen Vortrainings aufgegeben hätte.

Die Hoffnung, die GPT-2 mit sich bringt

Natürlich haben wir jetzt ChatGPT gesehen, sodass OpenAI den Weg des generativen Vortrainings nicht aufgegeben hat. Tatsächlich zeichnete sich die „Belohnung“ der Beharrlichkeit bereits im zweiten Jahr, also 2019, ab. OpenAI hat das GPT-2-Modell mit einer 48-schichtigen Transformer-Struktur veröffentlicht. In der veröffentlichten Arbeit (Language Models are Unsupervised Multitask Learners) stellten sie fest, dass GPT durch unüberwachte Daten und generatives Training Zero-Shot-Multitasking-Fähigkeiten demonstrierte. Das Erstaunliche ist, dass diese Multitasking-Fähigkeiten nicht explizit oder künstlich zu den Trainingsdaten hinzugefügt werden. Um ein Laienbeispiel zu nennen: Eine der von GPT-2 demonstrierten Fähigkeiten ist die Übersetzung, aber überraschenderweise erfordern Modelle, die normalerweise speziell für die Übersetzung verwendet werden, eine große Menge paralleler Korpus (d. h. gepaarte Daten zwischen zwei verschiedenen Sprachen) zur Überwachung Training, aber GPT-2 verwendet diese Art von Daten nicht, sondern führt nur generatives Training für eine große Menge Korpus durch und kann dann „plötzlich“ übersetzen. Diese Entdeckung ist mehr oder weniger subversiv. Sie zeigt den Menschen drei wichtige Phänomene:

- Wenn Sie möchten, dass das Modell eine NLP-Aufgabe erledigt, benötigen Sie möglicherweise keine gekennzeichneten Daten, die zur Aufgabe passen . Beispielsweise verwendet GPT-2 beim Training keine annotierten Übersetzungsdaten, führt jedoch eine Übersetzung durch

- Wenn Sie möchten, dass das Modell eine NLP-Aufgabe erledigt, benötigen Sie möglicherweise kein Trainingsziel, das zur Aufgabe passt . Beispielsweise hat GPT-2 während des Trainings keine Übersetzungsaufgaben und zugehörigen Verlustfunktionen entworfen, sondern nur Sprachmodellaufgaben ausgeführt.

- Ein Modell, das nur mit Sprachmodellaufgaben (also generativen Aufgaben) trainiert wurde, kann auch Multitasking-Fähigkeiten haben. GPT-2 hat beispielsweise Fähigkeiten in den Bereichen Übersetzung, Beantwortung von Fragen, Leseverständnis usw. unter Beweis gestellt.

Obwohl aus heutiger Sicht die verschiedenen Fähigkeiten, die GPT-2 damals demonstrierte, noch relativ rudimentär waren und die Ergebnisse sich immer noch erheblich von einigen anderen Modellen unterschieden, die mithilfe überwachter Daten verfeinert wurden, war dies bei OpenAI nicht der Fall ist voller Erwartungen hinsichtlich der potenziellen Fähigkeiten, die darin enthalten sind, so sehr, dass sie im letzten Satz der Zusammenfassung des Papiers ihre Erwartungen für die Zukunft der GPT-Modellreihe darlegen:

„Diese Ergebnisse deuten auf eine vielversprechende Entwicklung hin.“ „Der Weg zum Aufbau von Sprachverarbeitungssystemen, die lernen, Aufgaben aus ihren natürlich vorkommenden Demonstrationen auszuführen.“

Die Entwicklung einer Reihe von Ereignissen bewies später, dass sie sich tatsächlich in Richtung dieses vielversprechenden Weges bewegt hatten. Wenn im Jahr 2018, als das GPT-Modell der ersten Generation herauskam, das generative Vortraining von GPT noch in allen Aspekten von Vortrainingsmodellen wie BERT zum Zwecke der „Extrahierung von Merkmalen“ zerschlagen wurde, dann in GPT-2 Es Es wurde festgestellt, dass das generative Vortraining einen potenziellen Vorteil bietet, der nicht durch BERT-Modelle ersetzt werden kann, nämlich die Multitask-Fähigkeit, die durch die Sprachmodellaufgabe entsteht, und diese Multitask-Fähigkeit keine Kennzeichnungsdaten erfordert.

Natürlich ist der Weg der generativen Technologie zu diesem Zeitpunkt noch mit Risiken und Herausforderungen verbunden. Schließlich war die Leistung von GPT-2 zu diesem Zeitpunkt bei verschiedenen Aufgaben immer noch schlechter als das fein abgestimmte Modell. Dies führte dazu, dass GPT-2 zwar über Übersetzungs-, Zusammenfassungsfunktionen usw. verfügte, der Effekt jedoch zu gering war, um tatsächlich zu sein gebraucht. Wenn Sie also zu diesem Zeitpunkt ein verwendbares Übersetzungsmodell wünschen, besteht die beste Option immer noch darin, die annotierten Daten zu verwenden, um ein Modell speziell für die Übersetzung zu trainieren.

GPT-3, der Beginn des Datenschwungrads

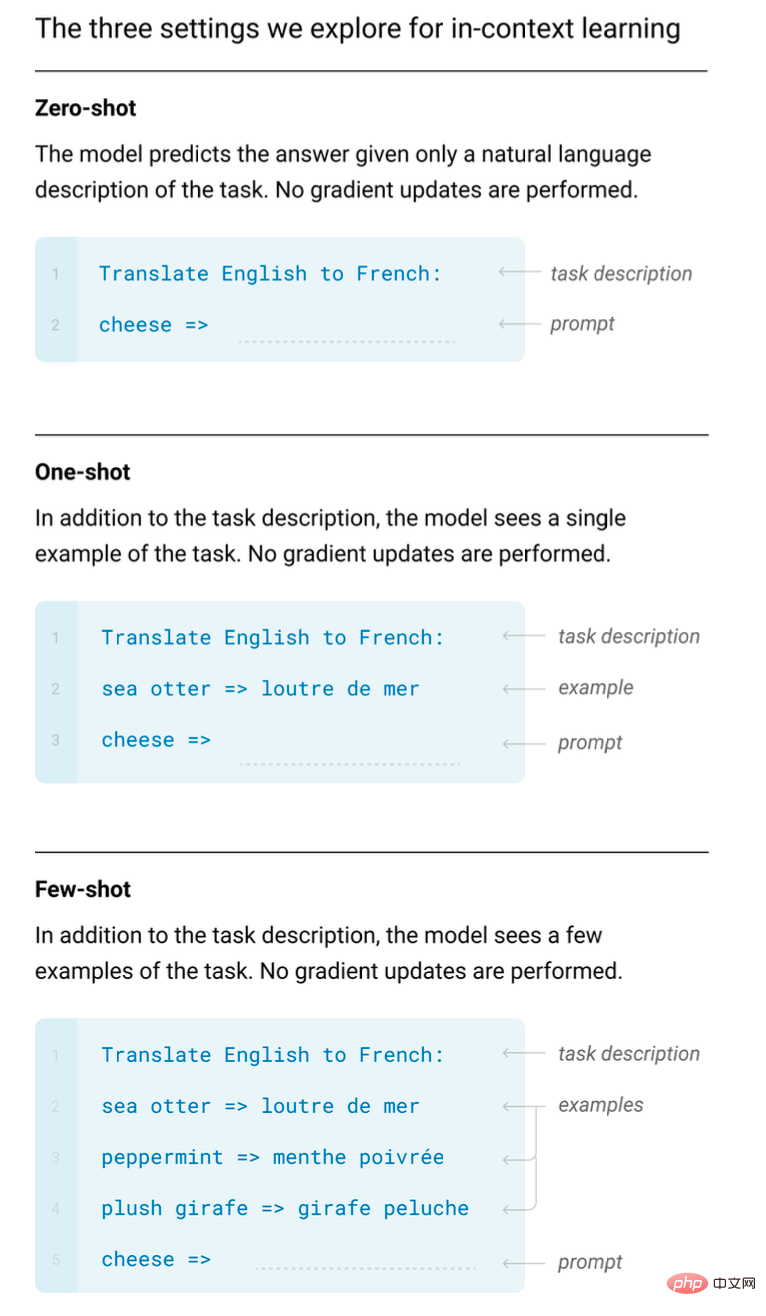

Rückblickend auf die ChatGPT-Ära hat die Entdeckung von OpenAI in GPT-2 ihr Vertrauen in die GPT-Modellreihe vielleicht wirklich gestärkt und beschlossen, die Forschung und Forschung zu intensivieren Entwicklung Geben Sie sich Mühe. Denn im Jahr 2020 veröffentlichten sie GPT-3 mit 175 Milliarden Parametern, ein selbst aus heutiger Sicht erstaunlich großes Modell. Obwohl OpenAI die Kosten für das Training dieses Modells nicht offenlegte, schätzten alle, dass es damals 12 Millionen US-Dollar kostete. Außerdem wurde ein mehr als 60-seitiges Papier veröffentlicht (Language Models are Few-Shot Learners), in dem die neuen Fähigkeiten dieses neuen Giganten detailliert beschrieben werden. Die wichtigste Entdeckung ist, was im Titel des Aufsatzes heißt, dass das Sprachmodell die Fähigkeit besitzt, mit kleinen Stichproben (wenige Stichproben) zu lernen.

Kleines Beispiellernen ist ein Fachbegriff im Bereich des maschinellen Lernens, hat aber ein sehr einfaches Konzept: „Menschen können anhand einer kleinen Anzahl von Beispielen eine neue Sprachaufgabe lernen.“ Stellen Sie sich vor, Sie lernen in einem Chinesischunterricht, wie man das Wort „put“ durch das Wort „be“ ersetzt (die Kleidung wurde durch den Regen nass – die Kleidung wurde durch den Regen nass). Der Lehrer wird einige Beispiele nennen, und die Schüler werden es tun Seien Sie in der Lage, diese Fähigkeit zu beherrschen.

Aber für Deep-Learning-Modelle müssen normalerweise Tausende von Beispielen gelernt (trainiert) werden, um eine neue Fähigkeit zu beherrschen, aber alle haben festgestellt, dass GPT-3 ähnliche Fähigkeiten wie Menschen hat. Und der entscheidende Punkt ist, dass Sie ihm nur ein paar Beispiele zeigen müssen und es die durch die Beispiele gegebenen Aufgaben „imitieren“ wird, ohne dass zusätzliches Training erforderlich ist (d. h. ohne dass eine Gradienten-Backpropagation und eine herkömmliche Trainingsparameteraktualisierung erforderlich sind). Spätere Untersuchungen zeigten, dass diese Fähigkeit nur bei Riesenmodellen möglich ist und in der Branche als „In-Context-Lernen“ bezeichnet wird.

Die kontextbezogene Lernfähigkeit des Englischen ins Französische wurde im GPT-3-Artikel demonstriert.

Eigentlich ist die Fähigkeit, mit kleinen Stichproben zu lernen, an sich keine erstaunliche Entdeckung. Schließlich hat die Branche Forschung zum Lernen kleiner Stichproben durchgeführt, und viele Modelle, die sich auf das Lernen kleiner Stichproben spezialisiert haben, verfügen über hervorragende Lernfähigkeiten für kleine Stichproben. Die von GPT-3 demonstrierte Fähigkeit zum „Lernen im Kontext“ bei kleinen Stichproben ist jedoch sehr unerwartet. Der Grund ist der gleiche wie die von GPT-2 demonstrierte Multitasking-Fähigkeit:

- GPT-3 ist nicht beabsichtigt Die Fähigkeit, kleine Stichproben zu erhalten, ist speziell auf Trainingsdaten und Trainingsmethoden ausgelegt. Es handelt sich immer noch nur um ein generatives Modell, das mit Sprachmodellaufgaben trainiert wird. Die Fähigkeit kleiner Stichproben von GPT-3 basiert auf „Lernen im Kontext“. in gewisser Weise angezeigt. Mit anderen Worten: Wenn Sie möchten, dass es neue Fähigkeiten erwirbt, müssen Sie es nicht umschulen, sondern ihm nur ein paar Demonstrationsbeispiele zeigen.

- Zusätzlich zu dieser Fähigkeit weist GPT-3 auch hervorragende Textgenerierungsfunktionen auf. Im Vergleich zu GPT-2 ist der generierte Inhalt flüssiger und kann sehr lange Inhalte generieren. Diese Fähigkeiten spiegelten sich umfassend in einem Modell wider, was GPT-3 zu dieser Zeit in den Mittelpunkt aller Aufmerksamkeit rückte. Es wurde auch zum Modell für OpenAI, um offiziell Dienste für die Außenwelt bereitzustellen.

Aber mit der Eröffnung dieses Modeldienstes versuchen immer mehr Menschen, dieses Modell zu nutzen. Seitdem sammelt OpenAI auch vielfältigere Daten, indem es sie der Öffentlichkeit zugänglich macht (die von Benutzern eingegebenen Inhalte können für das Modelltraining verwendet werden, das in den Benutzerbedingungen verfasst ist). Diese Daten spielen auch in nachfolgenden Modelliterationen eine wichtige Rolle .

Seitdem dreht sich das Datenschwungrad der GPT-Modellreihe. Je mehr qualitativ hochwertige Benutzerdaten vorhanden sind, desto besser wird das Modell iteriert.Im Gegensatz zu ChatGPT ist GTP-3 kein Konversationsinteraktionsmodell, sondern ein Textfortsetzungsmodell (d. h. Schreiben nach dem von Ihnen eingegebenen Text), sodass es nicht über die Mehrrunden-Konversationsfunktion des heutigen ChatGPT verfügt hat. Aber es kann bereits viele Dinge, wie zum Beispiel Geschichten schreiben, E-Mails automatisch vervollständigen usw. Aber gleichzeitig hat jeder nach und nach einige Probleme entdeckt, zum Beispiel werden Inhalte ausgegeben, die nicht den Tatsachen entsprechen, und es werden einige schädliche Bemerkungen ausgegeben usw. Dies ist der größte Nachteil dieses Textgenerierungsmodells. Obwohl es viele Iterationen durchlaufen hat, steht ChatGPT auch heute noch vor ähnlichen Problemen.

CodeX, lass den Computer seinen eigenen Code schreiben

OpenAI hat bei seiner Forschung zu GPT-3 auch eine unerwartete Entdeckung gemacht. Es kann basierend auf einigen Kommentaren sehr einfachen Code generieren. Daher investierten sie im Jahr 2021 gezielte Forschungsinvestitionen in die Generierung von Code und veröffentlichten das CodeX-Modell. Es kann als GPT-Modell mit Codespezialisierungsfunktionen angesehen werden, das komplexere Codes basierend auf der Eingabe natürlicher Sprache generieren kann

.Aus externer Sicht können wir nicht sagen, ob die Forschung zur Codegenerierung und die Entwicklung der GPT-Serienmodelle gleichzeitig durchgeführt werden. Aus praktischer Sicht war es damals jedoch tatsächlich sinnvoller, dem Modell die Möglichkeit zu geben, Code zu generieren. Schließlich verfügte GPT-3 heute noch nicht über die leistungsstarken Funktionen von ChatGPT. Andererseits wird dadurch, dass das Modell Code generiert, auch das Risiko vermieden, dass es schädliche Textinhalte generiert.

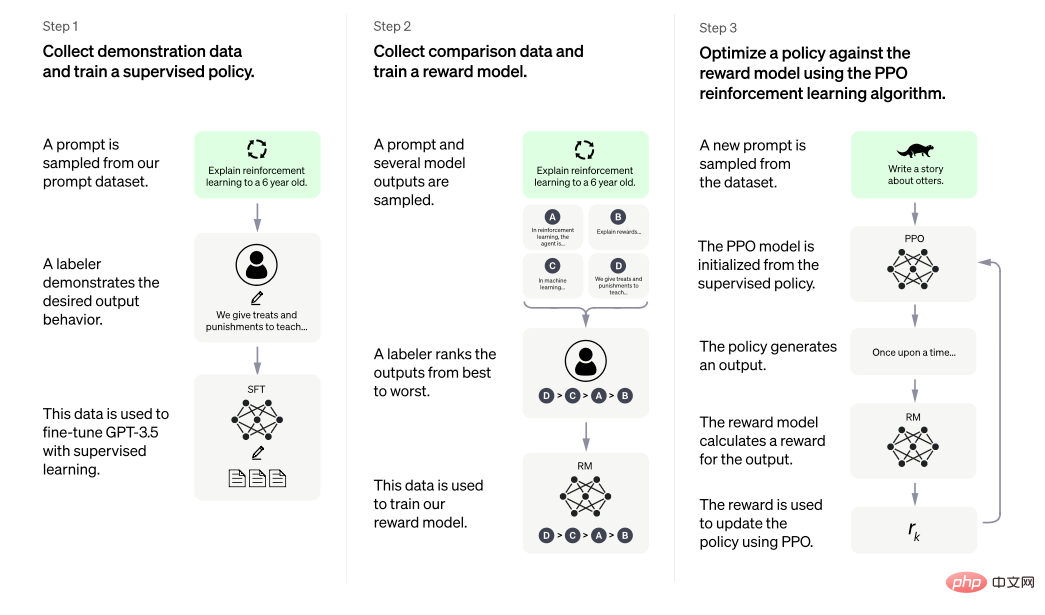

Im CodeX-Artikel wurden mehrere wichtige Punkte erwähnt. Der erste ist, dass das Training des GPT-Modells, das auf Textdaten vorab trainiert wurde, auf spezialisierte Codedaten (die Daten stammen aus dem Open-Source-Code von Github, insgesamt 159G) tatsächlich erheblich sein kann Verbessern Sie die Genauigkeit des Codeverständnisses und der Ausgabefunktionen. Zweitens verwendet das Papier ein „kleines“ Modell mit 12 Milliarden Parametern. Diese Informationen spiegeln von der Seite wider, dass es neben dem 175 Milliarden Parameter großen GPT-3-Modell mit offener Schnittstelle weitere Modellversionen unterschiedlicher Größe innerhalb von OpenAI gibt.Die ursprüngliche Absicht, Code-Training hinzuzufügen, damit das Modell Code-Entscheidungen verstehen und generieren kann, besteht möglicherweise nur darin, ein weiteres Anwendungsszenario für GPT zu haben. Es scheint keinen großen Zusammenhang mit der Fähigkeit der Modelle der GPT-Serie zu haben, natürliche Sprache zu verstehen und zu verwenden, aber nach späteren Untersuchungen (für eine detaillierte Analyse lesen Sie bitte den Artikel „Disassembly verfolgt den Ursprung verschiedener Fähigkeiten von GPT-3.5 》), wird ein zunehmendes Training an Codedaten wahrscheinlich die Fähigkeit des späteren GPT-Modells auslösen, komplexe Argumentations- und Denkketten in natürlicher Sprache durchzuführen. Vielleicht hatte OpenAI nicht mit einem solchen Ergebnis gerechnet, als sie zum ersten Mal mit der Arbeit an CodeX begannen, aber es ist, als hätten sie Textgenerierungsaufgaben verwendet, um GPT-Modelle zu erstellen, und diese dann in GPT-2 und GPT-3 „freigeschaltet“. „Die Fähigkeit zum Multitasking“ und „die Fähigkeit, im Kontext zu lernen“ brachte ihnen die Einführung von Codedaten erneut unerwartete Vorteile. Auch wenn es etwas zufällig erscheint, sind ein vorausschauendes Verständnis des technischen Weges gepaart mit Beharrlichkeit und kontinuierlichen Investitionen offensichtlich ein entscheidender Faktor. „InstructGPT, lassen Sie GPT für sich selbst sprechen.“ Ernsthafte sollten darin bestehen, „ernsthaft Unsinn zu reden“ und „schädigende Inhalte zu veröffentlichen“. Während sich OpenAI im Jahr 2021 vorübergehend darauf zu konzentrieren scheint, Modelle dazu zu bringen, Code zu verstehen und zu generieren, hätten sie versuchen sollen, diese Probleme mit GPT-3 zu lösen. Anfang 2022 veröffentlichte OpenAI das InstructGPT-Papier (Trainieren von Sprachmodellen zum Befolgen von Anweisungen mit menschlichem Feedback), aus dem wir einen Einblick in die Lösung dieser Probleme erhalten können. Die Kernidee der Arbeit besteht darin, dem Modell die Akzeptanz menschlicher Lehren (Feedback) zu ermöglichen, was im Titel klar zum Ausdruck kommt Der Grund, warum GPT-3 Probleme wie „ernsthaft Unsinn reden“ und „Schädliche Inhalte ausgeben“ hat, liegt in den verwendeten Trainingsdaten. Ein Gigant wie GPT-3 erfordert riesige Datenmengen. Die Datenquellen finden wir in GPT-3-Artikeln, die grob in drei Kategorien unterteilt werden können: Webinhalte, Enzyklopädieinhalte und Bücher. Obwohl die Menge an Webinhalten sehr groß ist, sind sie auch sehr „schmutzig, chaotisch und schlecht“ und enthalten natürlich viele unwahre und schädliche Inhalte. GPT-3 trainiert anhand dieser Daten und lernt diese Dinge auf natürliche Weise. Aber als Produkt, das externe Dienste bereitstellt, sollte GPT-3 bei seinen Antworten vorsichtiger sein. Um dieses Problem zu lösen, besteht eine der Schwierigkeiten darin, zu definieren, wie das Modell sprechen soll. Denn der Ausgabeinhalt des generativen Modells ist die natürliche Sprache selbst und kein klarer, objektiver richtiger oder falscher Inhalt wie eine Klassifizierungsbezeichnung oder ein Entitätssubstantiv. Es gibt kein klares richtig oder falsch, was es unmöglich macht, Trainingsaufgaben direkt auf das Ziel auszurichten, wie das Training klassischer NLP-Modelle. Konkret schlägt InstructGPT einen zweistufigen Weg vor, der es GPT ermöglicht, „hervorragende Beispiele“ von Menschen zu lernen. Die erste Stufe ist überwachtes Lernen und die zweite Stufe ist verstärkendes Lernen. Lassen Sie in der ersten Phase (entsprechend Schritt 1 ganz links in der Abbildung unten) die reale Person verschiedenen Anweisungen folgen (grob gesagt kann man sich das als den Text vorstellen, den wir bei der Verwendung von ChatGPT in das Dialogfeld eingeben. In der Branche gilt: (dieses Ding wird als Befehl bezeichnet) Schreiben Sie Antworten, die wahrheitsgemäß, harmlos und hilfreich sind. Um die Qualität dieses Inhalts sicherzustellen, werden im tatsächlichen Betriebsprozess den Annotatoren, die die Antworten schreiben, einige normative Richtlinien gegeben. Anschließend wird das vorab trainierte GPT-Modell weiterhin anhand dieser von Menschen bearbeiteten Daten trainiert. Diese Phase kann als eine Art „Disziplin“ für das Modell angesehen werden. Um es grob auszudrücken: Es ist so, als ob der Chinesischlehrer Sie auffordert, im Stillen hervorragende Aufsätze zu schreiben.

Das Bild stammt aus dem InstructGPT-Papier, das verstärkendes Lernen durch überwachte Feinabstimmung des Unterrichts vorschlägt + menschliches Feedback, um die Modellausgabe angemessen zu gestalten.

Die zweite Stufe ist das Reinforcement Learning, das technisch in zwei Schritte unterteilt ist. Der erste Schritt (entspricht Schritt 2 in der Mitte der Abbildung oben) besteht darin, das „trainierte“ Modell basierend auf unterschiedlichen Eingabeaufforderungen mehrere unterschiedliche Antworten generieren zu lassen und den Menschen diese Antworten nach guten oder schlechten Standards sortieren zu lassen. Verwenden Sie diese gekennzeichneten Daten dann, um ein Bewertungsmodell zu trainieren, damit es automatisch mehr Daten sortieren und bewerten kann. Der zweite Schritt der Verstärkungslernphase (entsprechend Schritt 3 rechts in der obigen Abbildung) besteht darin, dieses Bewertungsmodell als Umgebungsfeedback beim Verstärkungslernen zu verwenden und den Richtliniengradienten (Policy Gradient, genauer gesagt den PPO-Algorithmus) zu verwenden ), um das bereits „regulierte“ auszuwerten. Das trainierte GPT-Modell wird trainiert. Der gesamte Prozess der zweiten Stufe kann als eine „Stärkung“ des Modells angesehen werden. Um eine lockere Analogie zu verwenden, ist es so, als würde ein chinesischer Lehrer Ihnen Noten für Ihre Aufsätze geben und Sie bitten, anhand der Ergebnisse zu unterscheiden, was gut und was gut ist . Nicht gut, und dann wird es immer besser.

Deshalb In einer sehr lockeren Art und Weise, aber normale Leute können es vielleicht auch verstehen, lässt InstructGPT zunächst ein „GPT, das frei spricht, lernt zunächst „gut zu sprechen“, indem es „hervorragende menschliche Aufsätze diktiert“, und gibt dann „dem, was es alleine schreibt, eine Bewertung, damit es zurückgehen und es verstehen und weiterhin Fortschritte machen kann“ #🎜🎜 # . Natürlich werden die Dinge technisch komplizierter sein, etwa Datenfragen wie die spezifischen Spezifikationen und die Menge „exzellenter Aufsätze“ sowie algorithmische Fragen wie die Auswahl von Bewertungsmodellen beim Reinforcement Learning und die Einstellung von Algorithmusparametern wird sich alles auf das Endergebnis auswirken. Die Endergebnisse zeigen jedoch, dass diese Methode sehr effektiv ist. Das Papier weist auch darauf hin, dass ein kleines Modell von 1,3 Milliarden, das mit der oben genannten Methode trainiert wurde, ein größeres Modell, das nicht auf diese Weise trainiert wurde, übertreffen kann.

Darüber hinaus gibt es in der Arbeit einige Inhalte, die es wert sind, erwähnt zu werden. Zunächst einige Erkenntnisse zu Prompt. Die während des InstructGPT-Trainings verwendete Eingabeaufforderung besteht hauptsächlich aus zwei Teilen, die von einem spezialisierten KI-Trainer geschrieben wurden, und der andere Teil stammt aus den Inhalten, die von Benutzern während des Online-Dienstes des OpenAI-Modells geschrieben wurden Das Datenschwungrad wird reflektiert. Es lässt sich feststellen, dass diese Aufforderungen unabhängig von der Art der Aufforderungen von echten Menschen verfasst wurden. Obwohl der Artikel keine detaillierte Analyse der spezifischen Berichterstattung, Verteilung und Befragungsmethode dieser Aufforderungen durchführt, kann dies durchaus vermutet werden Diese Eingabeaufforderungen zeichnen sich durch gewisse Vielfalt und hohe Qualität aus. Tatsächlich verglich der Artikel das Modell, das mithilfe dieser von echten Menschen geschriebenen Eingabeaufforderungen trainiert wurde, und das Modell, das mithilfe von Eingabeaufforderungen trainiert wurde, die in einigen Open-Source-NLP-Aufgabendatensätzen (z. B. T0-Datensatz, FLAN-Datensatz) erstellt wurden. Die Schlussfolgerung ist, dass das Modell trainiert wurde Wenn echte Menschen Eingabeaufforderungen schreiben, sind die Antworten für die Rezensenten akzeptabler.

Ein weiterer Punkt betrifft die Generalisierungsfähigkeit des trainierten Modells für neue Eingabeaufforderungen. Es ist denkbar, dass die Generalisierungsfähigkeit von ChatGPT hoch ist, wenn das trainierte Modell keine Eingabeaufforderungen generieren kann ist es unwahrscheinlich, dass die Fähigkeit erreicht wird, fast jede von ChatGPT angezeigte Frage zu beantworten. Denn in der Feinabstimmungsphase des Modells ist es unabhängig von der Datenmenge unmöglich, alle von Menschen eingegebenen Inhalte vollständig abzudecken. Das InstrctGPT-Papier weist darauf hin, dass die in dem Papier verwendete Methode die Generalisierungsfähigkeit von Prompt erzeugen kann.

Der Grund, warum ich mehr Worte für die Einführung von InstructGPT aufgewendet habe, liegt darin, dass laut der Einführung auf der offiziellen ChatGPT-Seite die Methode in InstructGPT genau die Methode ist, die zum Trainieren von ChatGPT verwendet wird. Der einzige Unterschied besteht darin, dass ChatGPT eine Konversationsdatenorganisationsmethode verwendet.

GPT-3.5-Ära und die Geburt von ChatGPT

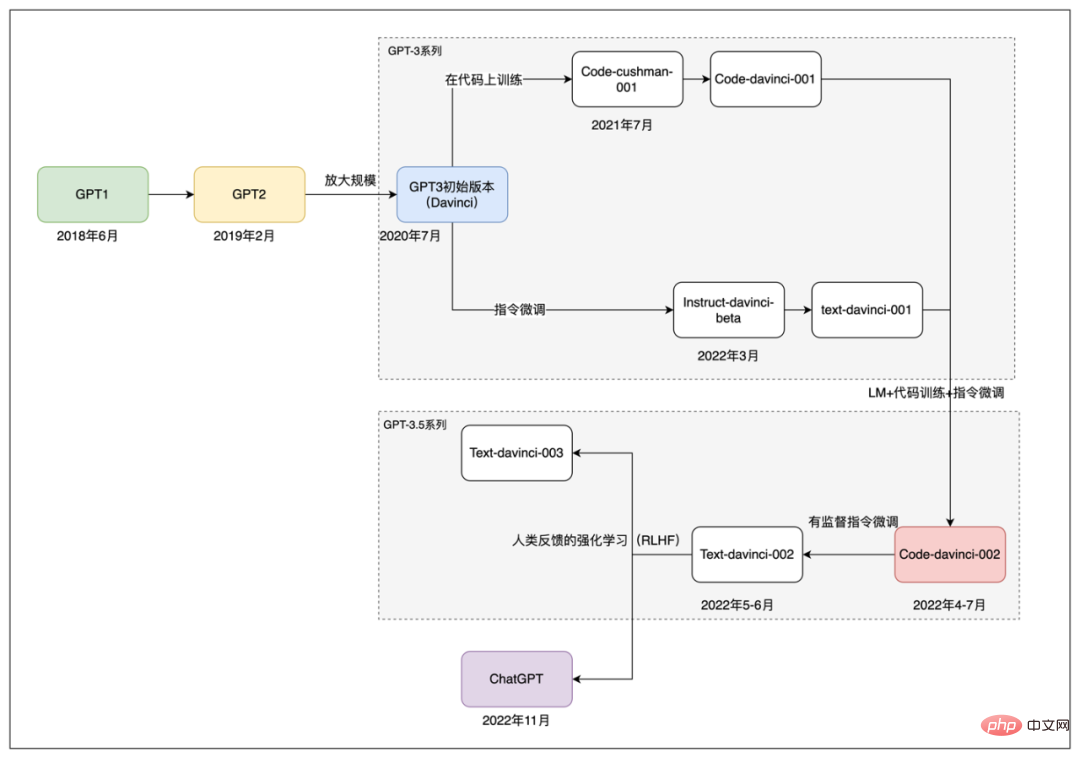

In der Folgezeit veröffentlichte OpenAI mehrere Modelle namens GPT-3.5-Serie, obwohl zu diesen Modellen laut #🎜 🎜# keine entsprechenden Artikel veröffentlicht wurden. Dieser Artikel Analyse, Die GPT-3.5-Serie sollte eine Fusion der OpenAI-Ansammlungen in der GPT-3-Ära sein. Entwickelt mit Technologie, Daten und Erfahrung . Da es keine detaillierten offiziellen öffentlichen Informationsreferenzen gibt, spekuliert die Außenwelt hauptsächlich über die spezifischen Informationen dieser Modelle, indem sie die Nutzungserfahrungen, zugehörige technische Dokumente und die Einführung der API-Dokumentation von OpenAI analysiert.

Der Analyse zufolge ist die GPT-3.5-Modellreihe möglicherweise nicht weiterhin auf GPT-3 abgestimmt, es handelt sich jedoch wahrscheinlich um Code und Daten in natürlicher Sprache Zusammengefügt wurde ein Grundmodell von Grund auf neu trainiert. Dieses Modell, das möglicherweise größer als die 175 Milliarden Parameter von GPT-3 ist, wird in der API von OpenAI als codex-davinci-002 bezeichnet. Basierend auf diesem Grundmodell wurde dann durch Feinabstimmung der Anweisungen und menschliches Feedback eine Reihe nachfolgender Modelle erhalten, einschließlich ChatGPT.

Der Entwicklungspfad der Modelle der GPT-Serie.

Kurz gesagt, ausgehend vom Code-Davince-002-Modell wird Text-Davinci-002 durch überwachte Feinabstimmung der Anweisungen erhalten. Und die nachfolgenden text-davinci-003 und ChatGPT wurden ebenfalls durch Feinabstimmung der Anweisungen und Feedback zum menschlichen Verstärkungslernen an einem Modell der GPT-3.5-Serie erhalten. Und text-davinci-003 und ChatGPT wurden beide im November 2022 veröffentlicht. Der Unterschied besteht darin, dass text-davinci-003 wie GPT-3 ein Textvervollständigungsmodell ist. Laut der offiziellen Einführung von ChatGPT wird es trainiert, indem vergangene Daten in Form einer Konversationsinteraktion verarbeitet und neue Konversationsdaten hinzugefügt werden.

Bisher haben wir den Entwicklungs- und Iterationsprozess der Modelle der OpenAI GPT-Serie vom GPT der ersten Generation im Jahr 2018 bis zum aktuellen ChatGPT grob überprüft. In diesem Prozess hat OpenAI stets seine „Beharrlichkeit“ auf dem technischen Weg generativer Pre-Training-Modelle beibehalten und auch von der sich weiterentwickelnden NLP-Technologie gelernt. Die Aufnahme neuer Methoden, von der anfänglichen Transformer-Modellstruktur bis hin zum späteren Aufkommen von Technologien wie der Befehlsfeinabstimmung (Prompt Tuning), diese Faktoren haben gemeinsam zum heutigen Erfolg von ChatGPT beigetragen. Mit einem Verständnis der Entwicklung der Modelle der GPT-Serie können wir einen Blick zurück auf das heutige ChatGPT werfen.

3. Schauen Sie sich ChatGPT genauer anIm ersten Kapitel haben wir erklärt, dass der Hauptgrund, warum ChatGPT außerhalb des Kreises liegt : „Es gibt die natürlichen Spracheingaben des Menschen in flüssiger und logischer natürlicher Sprache zurück und verleiht den Menschen, die damit kommunizieren, ein starkes Gefühl der Intelligenz.“ In Kapitel 2 erfahren wir mehr über den Weg von ChatGPT zum Erfolg, indem wir die Entwicklungsgeschichte der Modelle der GPT-Serie Revue passieren lassen. In diesem Kapitel wird versucht, auf eine für Außenstehende möglichst verständliche Weise etwas tiefer in die technischen Inhalte einzusteigen und zu untersuchen, warum einige der aktuellen groß angelegten Modelle zur Textgenerierung nicht den gleichen Effekt erzielen. Die Hauptreferenzen für diesen Teil stammen aus den beiden Artikeln „Vertiefendes Verständnis der aufkommenden Fähigkeiten von Sprachmodellen“ und „Dismantling and Tracing the Origins of GPT-3.5 Capabilities“ sowie einigen verwandten Artikeln Möchten Sie mehr über die Details erfahren?

Obwohl im ersten Kapitel darauf hingewiesen wurde, dass die erstaunlichen Auswirkungen von ChatGPT sich umfassend in vielen verschiedenen NLP-Aufgaben widerspiegeln, analysiert die Analyse der dahinter stehenden Technologie zu diesem Zeitpunkt , es wird klarer, wenn man seine Fähigkeiten zerlegt. Insgesamt können die von ChatGPT verkörperten Fähigkeiten grob in die folgenden Dimensionen unterteilt werden:

- Textgenerierungsfunktionen: Alle Ausgaben von ChatGPT Es handelt sich sogar um generierten Text Daher ist die Fähigkeit, Text zu generieren, die grundlegendste Voraussetzung.

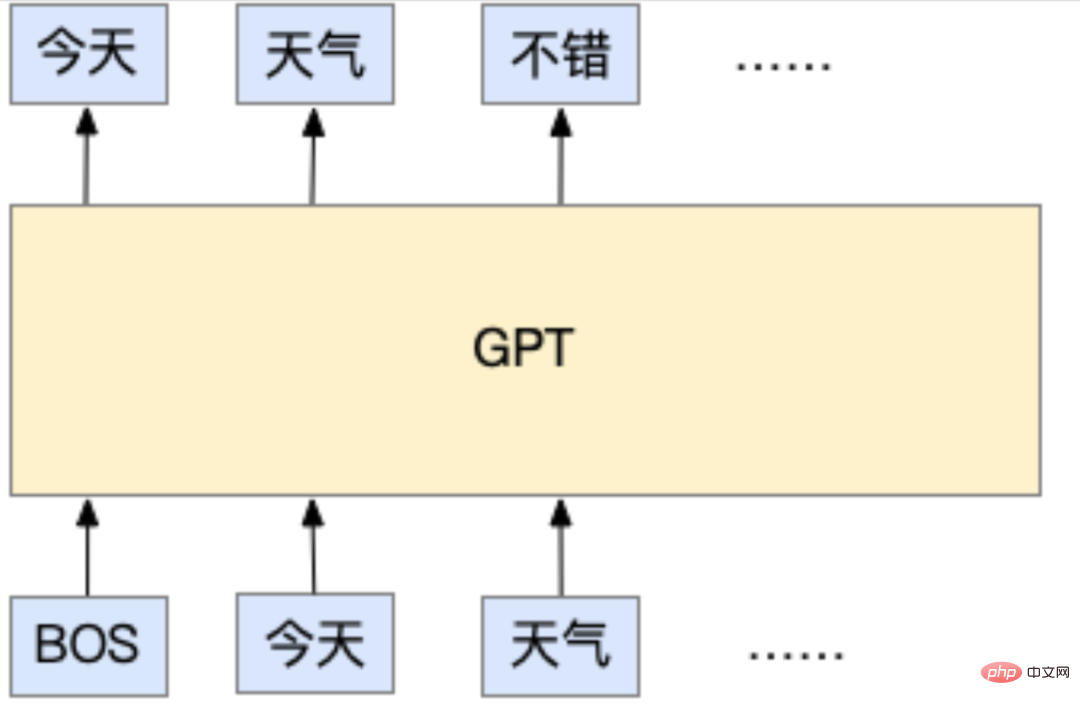

Diese Fähigkeit ergibt sich tatsächlich aus der Trainingsmethode. Wenn ChatGPT vorab trainiert wird, handelt es sich um eine standardmäßige autoregressive Sprachmodellaufgabe, die die Grundlage für alle Modelle der OpenAI-GPT-Serie bildet. Die sogenannte autoregressive Sprachmodellaufgabe ist nach allgemeiner Auffassung folgende: Sie kann anhand des eingegebenen Textes vorhersagen, wie das nächste Token aussehen soll. Das hier erwähnte Token stellt die kleinste Einheit von Zeichenfragmenten dar, die vom Modell verwendet werden. Es kann ein Zeichen (im Chinesischen werden häufig Zeichen verwendet) oder ein Wort (jedes Wort wird im Englischen natürlich durch Leerzeichen getrennt) sein werden oft Wörter verwendet) oder sogar Buchstaben. Aktuelle Methoden verwenden jedoch normalerweise Unterwörter (Unterwörter zwischen Buchstaben und Wörtern, deren Hauptzweck darin besteht, die Anzahl der Wörter zu reduzieren). Aber egal um welches es sich handelt, die Grundidee der autoregressiven Sprachmodellaufgabe besteht darin, den nächsten auszugebenden Text basierend auf dem eingegebenen Text vorherzusagen, genau wie im folgenden Beispiel:

In diesem Beispiel stellt BOS den Anfang der Eingabe dar und jedes Token ist ein Wort. Das GPT-Modell sagt basierend auf den Eingabewörtern „heute“ und „Wetter“ voraus, dass die nächste Ausgabe „gut“ ist.

Während des Trainings werden viele Textdaten vorbereitet, z. B. Artikel auf Webseiten, verschiedene Bücher usw. Solange es sich um normale Textinhalte handelt, können sie für das Training verwendet werden. Es ist erwähnenswert, dass für diese Art von Daten keine zusätzlichen manuellen Anmerkungen erforderlich sind, da diese Art von Daten ursprünglich von Personen geschrieben wurden. Das Modell muss „anhand des vorherigen Textes“ lernen, basierend auf dem von diesen Personen verfassten Text , Dann die Frage „Was soll dieser Ort hinter diesen Worten sein?“ Dies nennt die Branche „unüberwachtes Training“. Tatsächlich ist das Modell nicht wirklich unbeaufsichtigt (was würde das Modell sonst lernen?), aber seine Daten erfordern keine zusätzliche manuelle Annotation. Gerade weil für diese Aufgabe keine zusätzlichen Anmerkungen erforderlich sind, können große Datenmengen „kostenlos“ abgerufen werden. Dank der Beliebtheit des Internets können große Mengen an von echten Menschen verfassten Textinhalten „einfach“ für das Training abgerufen werden. Dies ist auch eines der Merkmale der Modelle der GPT-Serie. Für das Training großer Modelle werden riesige Datenmengen verwendet.

Wie funktioniert es also, wenn wir ChatGPT verwenden? Tatsächlich ist es dasselbe wie seine Trainingsmethode. Das Modell wird das nächste Token basierend auf dem Inhalt, den wir in das Dialogfeld eingeben, vorhersagen. Nachdem es dieses Token erhalten hat, wird es mit dem vorherigen Inhalt verbunden neuer Text wird dem Modell übergeben und das Modell sagt das nächste Token voraus usw., bis eine bestimmte Bedingung erfüllt ist und stoppt. Es gibt viele verschiedene Möglichkeiten, diese Stoppbedingung zu entwerfen. Beispielsweise kann es sein, dass der Ausgabetext eine bestimmte Länge erreicht oder das Modell ein spezielles Token vorhersagt, das zur Darstellung des Stopps verwendet wird. Erwähnenswert ist auch, dass es sich bei der Vorhersage des nächsten Tokens durch das Modell tatsächlich um einen Stichprobenprozess hinter den Kulissen handelt. Mit anderen Worten: Wenn das Modell einen Token vorhersagt, gibt es tatsächlich die Wahrscheinlichkeit aller möglichen Token aus und tastet dann einen Token aus dieser Wahrscheinlichkeitsverteilung ab. Wenn Sie ChatGPT verwenden, werden Sie daher feststellen, dass selbst bei derselben Eingabe die Ausgabe jedes Mal unterschiedlich ist, da heimlich verschiedene Token als Ausgabe abgetastet werden.

Nachdem Sie dies verstanden haben, können Sie zurückgehen und darüber nachdenken, was das Modell lernt. Lernt es, Fragen und Antworten zu beantworten? Oder geht es darum, zu lernen, wie man die in natürlicher Sprache enthaltenen Informationen, Logik und Emotionen versteht? Oder lernt man eine riesige Menge an Wissen? Dem Design der Trainingsaufgabe nach zu urteilen, scheint es so etwas nicht zu geben. Sie lernt nur aus den umfangreichen Textdaten, „was ein Mensch als nächstes auf der Grundlage des Eingabetextes schreiben wird“. Aber es ist diese Art von Modell, das, wenn es sich zu ChatGPT „entwickelt“, umfassendes Wissen, komplexes logisches Denken usw. beherrscht. Es scheint fast alle Fähigkeiten zu beherrschen, die ein Mensch für den Gebrauch von Sprache benötigt. Dies ist eine sehr magische Sache, und der Prozess der „Evolution“ wird im nächsten Kapitel ausführlicher vorgestellt.

- Umfangreicher Wissensvorrat: ChatGPT kann viele Fragen richtig beantworten, darunter Geschichte, Literatur, Mathematik, Physik, Programmierung usw. Da die aktuelle Version von ChatGPT kein externes Wissen nutzt, wird der Inhalt dieses Wissens im Modell „gespeichert“.

Die umfangreiche Wissensbasis vonChatGPT basiert auf den Trainingsdaten und ist groß genug, um diese Inhalte zu erlernen. Obwohl der Beamte die spezifischen Details der von ChatGPT verwendeten Trainingsdaten nicht offengelegt hat, lässt sich aus dem Papier des Vorgängers GPT-3 ableiten, dass die Daten grob in drei große Kategorien unterteilt werden können: Webinhalte, Buchinhalte und Enzyklopädien Inhalt. Es ist denkbar, dass diese Inhalte natürlich eine große Menge an Wissen enthalten, ganz zu schweigen von Enzyklopädien und Büchern, aber der Webinhalt enthält auch viele Nachrichten, Kommentare, Meinungen usw. und die Webseiten enthalten auch viele spezialisierte vertikale Q&A-Websites . Dies sind die Wissensquellen von ChatGPT. In der offiziellen Einleitung wird darauf hingewiesen, dass ChatGPT nicht beantworten kann, was nach 2021 passiert ist. Daher kann man davon ausgehen, dass die Trainingsdatenerfassung im Jahr 2021 endet.

Aber die Datenmenge ist nur ein Aspekt. Damit das Modell diese Daten „beherrschen“ kann, darf sein eigenes Volumen nicht klein sein. Nehmen Sie als Beispiel GPT-3. Es verfügt über 175 Milliarden Parameter. Es kann grob verstanden werden, dass der Inhalt dieser Daten und die verschiedenen Funktionen des Modells in Form spezifischer Werte jedes Parameters festgelegt sind. . Das Wahrnehmungsverständnis besagt, dass ein Modell, wenn es nur einen Parameter hat, nichts tun kann. Für eine gründlichere Analyse und einen genaueren Vergleich können Sie sich auf die Auswertung dieses Artikels „Ganzheitliche Bewertung von Sprachmodellen“ beziehen. Die richtungsweisende Schlussfolgerung lautet: Je größer das Modell, desto besser funktioniert es bei Aufgaben, für deren Ausführung Wissen erforderlich ist.

Papieradresse: https://arxiv.org/pdf/2211.09110.pdf

- Die Fähigkeit des logischen Denkens und der Denkkette: am Beispiel von Huhn und Kaninchen im selben Käfig in der Im ersten Kapitel können Sie sehen, dass ChatGPT über starke logische Denkfähigkeiten verfügt. Und es kann komplexe Inhalte in mehrere kleine Schritte zerlegen, Schritt für Schritt argumentieren und die endgültige Antwort erhalten. Diese Fähigkeit wird als Denkkette bezeichnet.

Aus der vorherigen Einführung wissen wir, dass das Modell nicht speziell für logisches Denken und Denkketten während des Trainings konzipiert ist. Die aktuelle Mainstream-Ansicht ist, dass logische Argumentations- und Denkketten wahrscheinlich mit zwei Faktoren zusammenhängen. Der erste ist die Größe des Modells und der zweite ist, ob das Modell anhand von Codedaten trainiert wurde.

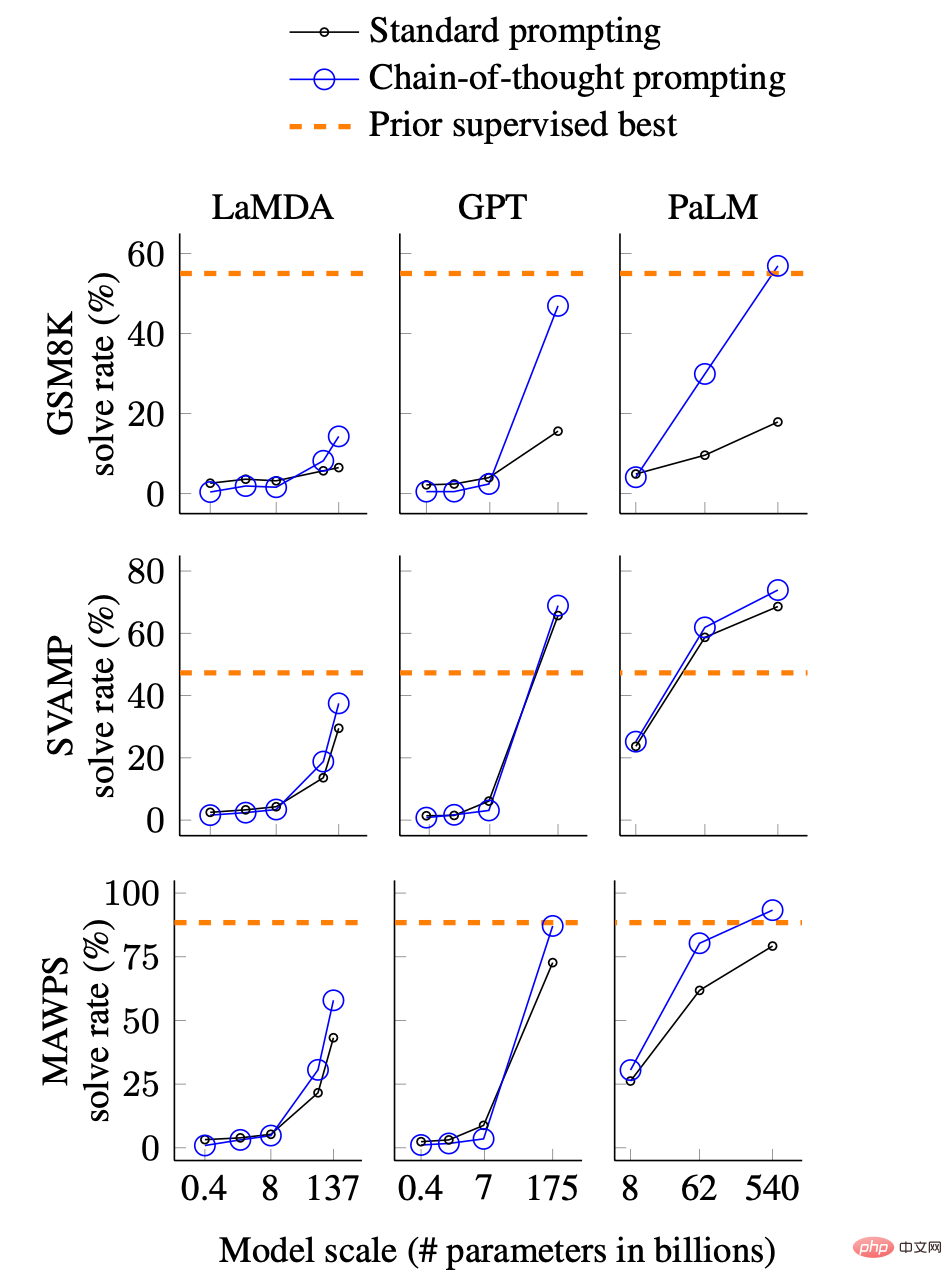

Zum Zusammenhang zwischen Modellgröße und Argumentations- und Denkkettenfähigkeiten gibt es eine entsprechende Einführung in „Vertiefendes Verständnis der Emergent Capability von Sprachmodellen“. Das Bild unten zeigt die Beziehung zwischen den Fähigkeiten der Denkkette und der Modellgröße.

Vergleich der Denkketteneffekte verschiedener Modelle und unterschiedlicher Größen, das Bild stammt aus dem Papier. GSM8K, SVAMP und MAWPS sind drei mathematische Textaufgaben-Datensätze, die logisches Denken erfordern, und LaMDA, GPT und PaLM sind jeweils drei verschiedene Modelle.

Kurz gesagt zeigt das Diagramm die richtigen Antwortraten von drei verschiedenen Modellen für drei Datensätze zu mathematischen Wortaufgaben. Was Aufmerksamkeit verdient, sind die folgenden Aspekte:

- Die Fähigkeit der Denkkette (blaue durchgezogene Linie) ändert sich plötzlich, wenn die Modellgröße groß genug ist.

- Die Fähigkeit der Denkkette ändert sich Das Modell Wenn das Modell groß genug ist, übertrifft der Effekt die Standard-Prompting-Methode (schwarze durchgezogene Linie).

- Die Fähigkeit der Denkkette kann sich der überwachten Methode (orange gepunktete Linie) annähern oder diese sogar übertreffen genug. .

Laienhaft ausgedrückt: Wenn das Modell groß genug ist, zeigt sich plötzlich die Fähigkeit der Denkkette und kann die Modelle erreichen oder sogar übertreffen, die speziell für überwachtes Training an Inferenzdatensätzen trainiert wurden. Diese Zahl erklärt möglicherweise teilweise die hervorragenden Argumentations- und Denkkettenfähigkeiten von ChatGPT, die wir jetzt sehen.

Ein weiterer Faktor in Bezug auf die Fähigkeiten des Denkens und der Denkkette hängt damit zusammen, ob das Modell anhand von Codedaten trainiert wurde. Derzeit ist dies nur eine Schlussfolgerung. Die Analyse in „Dismantling and Tracing the Origin of GPT-3.5's Capabilities“ zeigt, dass große Modelle ähnlicher Größe über eine sehr schwache oder fast keine Denkkette und Argumentation verfügen, wenn sie nicht trainiert wurden die Codefähigkeit. Und ChatGPT ist tatsächlich auf Codedaten trainiert, was sich auch an seiner Fähigkeit zeigt, Code zu verstehen und zu generieren. Wie in der Überprüfung des Entwicklungsprozesses in Kapitel 2 erwähnt, veröffentlichte OpenAI das CodeX-Modell speziell für Code im Jahr 2021. Die Hinzufügung von Codedaten zu den Trainingsdaten von GPT hätte von da an beginnen sollen.

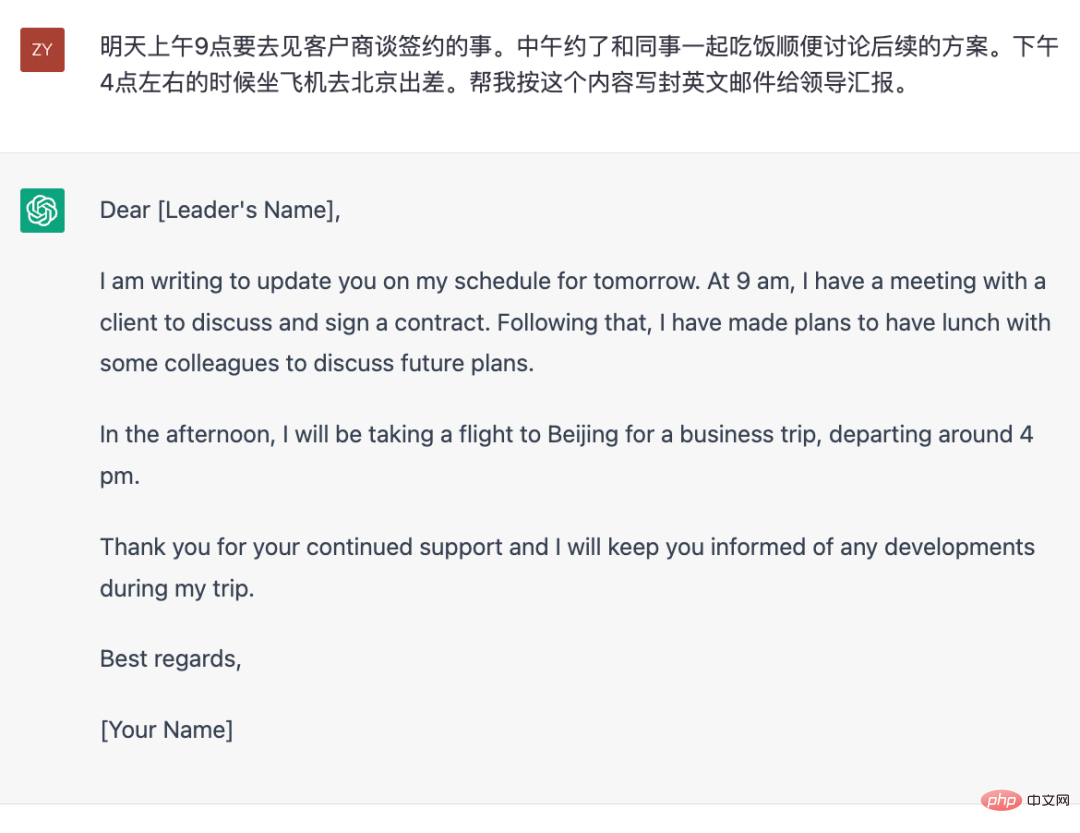

- Die Fähigkeit, auf Fragen oder Anweisungen von Personen zu reagieren: Zusätzlich zur engen „Frage-und-Antwort“-Interaktion kann ChatGPT auch auf Eingabeanforderungen reagieren. Beispielsweise hat es auch hervorragende Fähigkeiten bei der Beantwortung befehlsartiger Anfragen wie „Schreibe einen Brief für mich“ unter Beweis gestellt. Diese Fähigkeit macht es nicht nur zu einer „erweiterten Suchmaschine“, die Antworten liefert, sondern auch zu einem Textverarbeitungstool, das mit natürlicher Sprache interagieren kann.

Obwohl ChatGPT derzeit in der Öffentlichkeit als suchmaschinenähnliches Tool im Fokus steht, ist der Zugriff auf relevantes Wissen und das Geben von Antworten nicht seine einzige Fähigkeit. Tatsächlich ist die Beantwortung von Wissensfragen für ChatGPT selbst nicht seine Stärke. Schließlich sind die eigenen Trainingsdaten im Jahr 2021 festgelegt. Selbst wenn es mit aktualisierten Daten trainiert wird, kann es nicht mit den Änderungen im aktuellen Geschehen Schritt halten. Um es als Wissens-Frage- und Antworttool zu verwenden, muss es dennoch mit externen Wissensquellen wie Suchmaschinen kombiniert werden Bing tut es jetzt.

Aber aus einer anderen Perspektive ist ChatGPT wie ein „sprachkomplettes“ Texttool, das heißt, es kann den spezifizierten Inhalt vervollständigen, der gemäß den von Ihnen gegebenen Anforderungen in Textform ausgedrückt werden kann, wie im folgenden Beispiel .

Generieren Sie englische E-Mails für die Berichterstattung gemäß dem vorgegebenen Planinhalt.

Die hier erwähnte „Sprachvollständigkeit“ bezieht sich auf die Fähigkeit, Sprache zu verwenden. Es ist ersichtlich, dass es sich im obigen Beispiel tatsächlich um keinen intellektuellen Inhalt handelt, da ihm der zum Schreiben erforderliche Inhalt bereits zur Verfügung gestellt wurde. Das Schreiben dieser E-Mail erfordert jedoch die Fähigkeit, Sprache zu verwenden, z. B. Wörter und Sätze auszuwählen, die Sprache zu wechseln, das E-Mail-Format usw.

Jetzt gehen wir zurück und versuchen zu analysieren, wie es seine Fähigkeit erlangt hat, „Aufgaben gemäß den Anweisungen zu erledigen“. In der Wissenschaft wird diese Art von Anweisung als Eingabeaufforderung bezeichnet. Tatsächlich sind Benutzereingaben in Gesprächen und Fragen in Fragen und Antworten auch Eingabeaufforderungen. Wenn Sie verstehen, was wir im ersten Abschnitt dieses Kapitels in das Sprachmodell eingeführt haben, sollte eine strengere Aussage lauten, dass „die oben genannten Eingaben in das Modell“ allesamt Eingabeaufforderungen sind.

Die Fähigkeit von ChatGPT, entsprechend dem Eingabebefehl (Eingabeaufforderung) zu antworten, beruht auf einer Modelltrainingsmethode namens Befehlsfeinabstimmung (Eingabeaufforderung). Tatsächlich ist das Prinzip immer noch „die Vorhersage des nächsten Tokens basierend auf dem Eingabeinhalt“. In der Feinabstimmungsphase der Anweisung wird der Eingabeinhalt jedoch durch diese vorab geschriebenen Eingabeaufforderungen ersetzt Das muss nach der Eingabeaufforderung generiert werden. Dies ist die im Voraus geschriebene Antwort. Daher liegt der größte Unterschied zwischen dieser Stufe und dem eingangs erwähnten unbeaufsichtigten autoregressiven Sprachmodelltraining in den Daten. Die Daten hier, also die Eingabeaufforderungen und die entsprechenden Antworten, werden alle von Menschen geschrieben. Mit anderen Worten: In dieser Phase wird überwachtes Training mit manuell gekennzeichneten Daten verwendet.

Wenn es um manuell beschriftete Daten geht, kommt es natürlich auf die erforderliche Datenmenge an, da für jedes beschriftete Datenelement Kosten anfallen. Wenn keine Kennzeichnung erforderlich ist (genau wie in der ersten Trainingsphase), steht natürlich eine riesige Menge an Textdaten für das Training zur Verfügung. Wenn jedoch eine Kennzeichnung erforderlich ist, wie viele dieser Daten werden benötigt? Wissen Sie, die Kosten für den Kommentator sind sehr hoch, wenn er eine Eingabeaufforderung handschriftlich verfassen und dann handschriftlich eine wahrheitsgetreue und detaillierte Antwort mit mehreren hundert Wörtern verfassen muss. Laut dem Artikel „Sprachmodelle trainieren, um Anweisungen mit menschlichem Feedback zu befolgen“ sind für die erforderlichen Daten eigentlich nicht viele Daten erforderlich (im Vergleich zu den Daten, die in der unbeaufsichtigten Phase verwendet werden). Obwohl keine genauen Informationen darüber veröffentlicht werden, wie viel ChatGPT verwendet wird, ist es sicher, dass es viel kleiner sein muss als die Datensätze, die aus Webseiten, Enzyklopädien und Büchern bestehen, die für unbeaufsichtigte Schulungen verwendet werden.

Papieradresse: https://arxiv.org/pdf/2203.02155.pdf

Nur eine relativ kleine Menge manuell kommentierter Eingabeaufforderungsdaten ist erforderlich, um den Zweck zu erreichen, dem Modell eine entsprechende Reaktion zu ermöglichen Hinter diesem Punkt verbirgt sich tatsächlich ein Phänomen, das in der akademischen Welt als Verallgemeinerungsfähigkeit bezeichnet wird. Wie Sie sich vorstellen können, stellen Menschen auf der ganzen Welt ständig ChatGPT-Fragen, und die Fragen, die sie stellen, müssen alle möglichen seltsamen sein. Diese Fragen sind eigentlich Aufforderungen. Es werden jedoch definitiv nicht so viele Eingabeaufforderungen zur Feinabstimmung der Anweisungen von ChatGPT verwendet. Dies zeigt, dass das Modell, nachdem es eine bestimmte Anzahl von Eingabeaufforderungen und entsprechenden Antworten gelernt hat, Rückschlüsse auf Eingabeaufforderungen ziehen kann, die es zuvor noch nicht gesehen hat ist die Verallgemeinerungsfähigkeit von Prompt. Die Analyse des Artikels „Dismantling and Tracing the Origins of GPT-3.5's Different Capabilities“ weist darauf hin, dass diese Generalisierungsfähigkeit mit der Menge und Vielfalt der annotierten Daten des Modells zusammenhängt lernt während der Feinabstimmungsphase des Unterrichts.

Darüber hinaus kann eine kleine Menge an Eingabeaufforderungsdaten zur Feinabstimmung eines Modells mit leistungsstarken Funktionen wie ChatGPT verwendet werden. Dahinter steckt eine weitere Vermutung: Die verschiedenen vom Modell angezeigten Funktionen können durch unbeaufsichtigtes Verhalten beeinträchtigt werden Training. Die Stufen sind bereits im Modell vorhanden. Tatsächlich ist dies leicht zu verstehen, denn im Vergleich zu unbeaufsichtigten Daten ist die Anzahl dieser manuell gekennzeichneten Eingabeaufforderungen zu gering. Es ist schwer vorstellbar, dass das Modell durch das Lernen aus diesen nur gekennzeichneten Daten verschiedene Fähigkeiten entwickelt hat. Aus dieser Perspektive geht es beim Prozess der Feinabstimmung von Anweisungen eher darum, das Modell lernen zu lassen, gemäß bestimmten Spezifikationen zu reagieren, und sein Wissen, seine Logik und andere Fähigkeiten sind bereits vorhanden.

- „Objektive und unparteiische“ Fähigkeit: Wenn Sie ChatGPT einige schädliche oder kontroverse Fragen stellen, werden Sie feststellen, dass die Antworten von ChatGPT sehr „vorsichtig“ sind, ähnlich wie die Antworten eines geschulten Nachrichtensprechers. Obwohl es immer noch nicht gut genug ist, ist diese Fähigkeit der Kernfaktor, der OpenAI dazu bringt, es öffentlich als Produkt zu nutzen.

Die Ausgabe des Modells mit menschlichen Werten in Einklang zu bringen, ist das, was OpenAI getan hat. Bereits bei GPT-3 im Jahr 2020 entdeckte OpenAI, dass dieses durch Online-Daten trainierte Modell diskriminierende, gefährliche und kontroverse Inhalte generieren würde. Da es sich um ein Produkt handelt, das externe Dienste anbietet, sind diese schädlichen Inhalte offensichtlich unangemessen. Das aktuelle ChatGPT hat sich in diesem Punkt erheblich verbessert, um diese „Verhaltensänderung“ herbeizuführen. Genauer gesagt erfolgt dies durch überwachte Anweisungen und menschliches Feedback gemeinsam mit Reinforcement Learning, das ebenfalls in Kapitel 2 vorgestellt wurde.

Durch die obige Analyse können wir feststellen, dass aus technischer Sicht alle Inhalte im Zusammenhang mit ChatGPT bekannt sind, aber warum ist es derzeit der einzige mit einer so erstaunlichen Leistung? Tatsächlich hat die NLP-Community seit der Einführung von ChatGPT die Gründe analysiert. Obwohl viele Schlussfolgerungen spekulativ sind, bringen sie auch einige Aufschlüsse für die Lokalisierung ähnlicher Modelle.

Faktoren der Modellgröße

Die Voraussetzung für die Entstehung von Fähigkeiten ist, dass die Modellgröße einen bestimmten Maßstab erreicht, obwohl es nach der aktuellen Sachlage keine spezifischen Indikatorrichtlinien gibt die Denkkette usw. Relativ „fortgeschrittene“ Fähigkeiten müssen in Modellen mit Dutzenden Milliarden oder mehr Parametern gut genug funktionieren.

Datenvolumenfaktor

Die Größe des Modells ist nicht der einzige Faktor. DeepMind liefert in diesem Artikel „Training Compute-Optimal Large Language Models“ einige analytische Schlussfolgerungen und weist darauf hin, dass die Menge der Trainingsdaten mit der Größe des Modells entsprechend zunehmen muss Die Anzahl der Token muss mit der Größe des Modells steigen.

Papieradresse: https://arxiv.org/pdf/2203.15556.pdf

Faktoren der Datenqualität

Bei unbeaufsichtigten Daten ist die Datenmenge relativ nicht sehr groß Hürde, aber die Datenqualität wird oft übersehen. Tatsächlich gibt es im GPT-3-Papier spezielle Inhalte zur Datenverarbeitung. Um die Trainingsdaten von GPT-3 zu bereinigen, hat OpenAI speziell ein Datenfiltermodell trainiert, um aus massiven Webseitendaten qualitativ hochwertigere Daten zu erhalten. Im Vergleich dazu scheinen einige Open-Source-Modelle mit einer vergleichbaren Größe wie GPT-3, wie Opt von Meta und Bloom von BigScience, diesen Reinigungsschritt nicht durchlaufen zu haben. Dies könnte einer der Gründe sein, warum diese beiden Open-Source-Modelle schlechter sind als GPT-3.

Darüber hinaus ist die Messdimension der Datenqualität kein einzelner Faktor. Faktoren wie Datenvielfalt, Inhaltsduplizierung und Datenverteilung müssen berücksichtigt werden. Obwohl beispielsweise die Gesamtmenge an Webseitendaten die größte unter den drei von GPT-3 verwendeten Datenkategorien ist: Webseiten, Enzyklopädien und Bücher, basiert die Stichprobe dieser drei Datentypen während des Trainings nicht auf der Menge der tatsächlichen Daten.

Erwähnenswert ist auch, dass in der Phase der Feinabstimmung von Anweisungen die manuelle Erstellung von Anweisungen ein wichtiger Einflussfaktor sein kann. Das InstructGPT-Papier weist deutlich darauf hin, dass Modelle, die mit manuell geschriebenen Anweisungen trainiert wurden, während des Bewertungsprozesses bessere Ergebnisse erzielen als Modelle, die mit vorhandenen NLP-Datensätzen trainiert wurden, um Anweisungen anhand von Vorlagen zu erstellen. Dies könnte erklären, warum Modelle, die auf Befehlsdatensätzen trainiert wurden, die aus NLP-Datensätzen wie T0 und FLAN bestehen, weniger effektiv sind.

Die Auswirkungen des Trainingsprozesses

Diese Art von Riesenmodell wird während des Trainings durch den Cluster trainiert, wobei Datenparallelität, Modellparallelität und ZeRO-Optimierer (eine Methode zur Reduzierung der Speichernutzung des Trainings) verwendet werden Diese Methode führt mehr Variablen zur Stabilität des Trainings ein. Die folgende Analyse zeigt, dass selbst die Verwendung der Bfloat16-Präzision des Modells einen erheblichen Einfluss auf die Ergebnisse hat.

Analyselink: https://jingfengyang.github.io/gpt

Ich glaube, dass jeder nach dem Verständnis des oben genannten Inhalts eine allgemeine Vorstellung davon haben wird, wie man eine ChatGPT-ähnliche Methode schmiedet und die Probleme, denen man sich stellen muss. Glücklicherweise hat OpenAI bewiesen, dass dieser technische Weg machbar ist, und das Aufkommen von ChatGPT verändert tatsächlich den Entwicklungstrend der NLP-Technologie.

4. Zukunftsausblick

ChatGPT hat seit seiner Einführung im November 2022 große Aufmerksamkeit erregt. Ich glaube, dass selbst Laien und sogar Gruppen, die wenig Kontakt mit Computern haben, sich seiner Existenz mehr oder weniger bewusst sind. Dieses Phänomen selbst spiegelt bereits wider, dass sein Erscheinungsbild etwas ungewöhnlich ist. Das Publikum außerhalb des Kreises nimmt seine Erscheinung eher wahrnehmungsmäßig mit Neugier, Überraschung oder Bewunderung wahr. Für Praktiker geht es bei seiner Entstehung eher darum, über zukünftige Technologietrends nachzudenken.

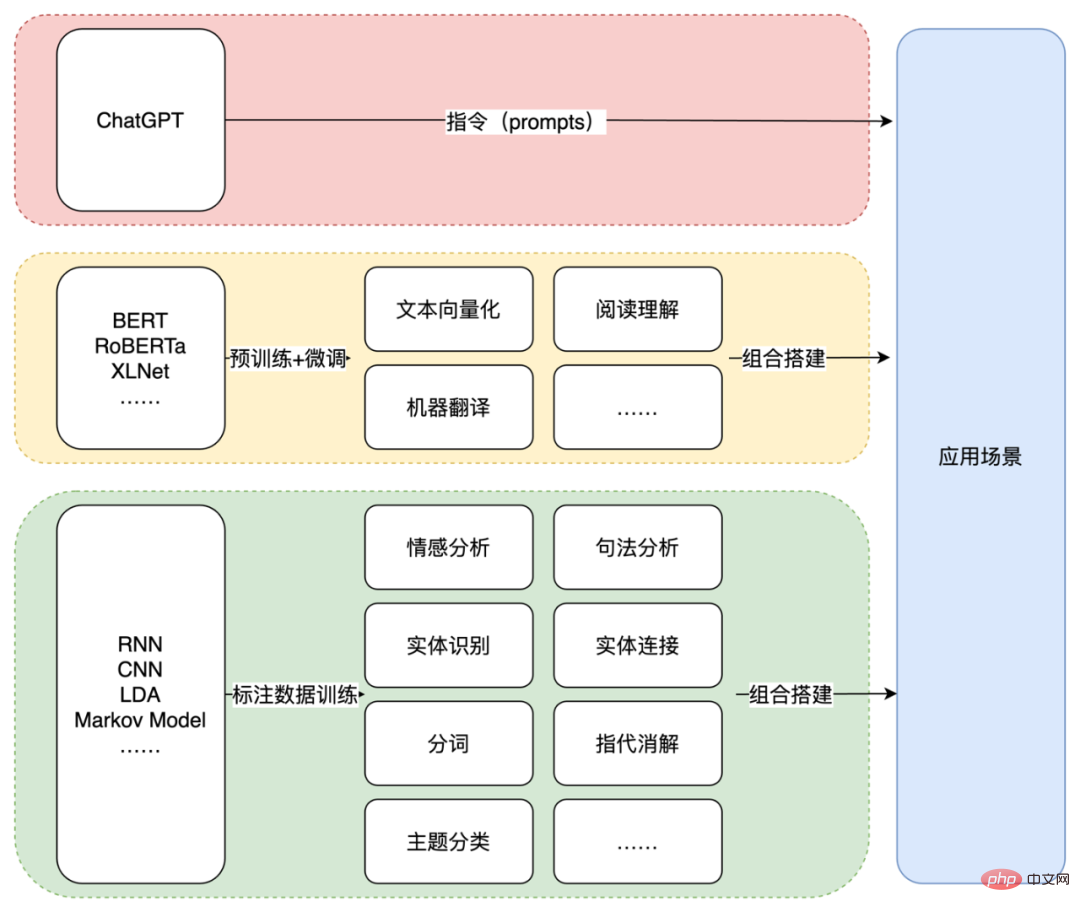

Aus technischer Sicht markiert die Entstehung von ChatGPT einen weiteren Paradigmenwechsel im Bereich NLP. Der Grund, warum es „wieder“ heißt, liegt darin, dass im Jahr 2018, dem Jahr, in dem die erste Generation von GPT veröffentlicht wurde, das im selben Jahr veröffentlichte BERT-Modell das „Vortraining + Feinabstimmung“-Paradigma von NLP schuf seine hervorragende Leistung Der spezifische Inhalt der Ära wurde in Kapitel 2 vorgestellt. Hier stellen wir hauptsächlich das Paradigma der „Textgenerierung + Anweisungen“ vor, das durch ChatGPT ermöglicht wird. Konkret geht es darum, das trainierte ChatGPT oder ein ähnliches Textgenerierungsmodell zu verwenden, um ein bestimmtes Szenario durch Eingabe geeigneter Anweisungen (Eingabeaufforderung) abzuschließen.

Dieses Paradigma unterscheidet sich stark von früheren NLP-Technologieanwendungen. Ob es sich um die frühe Ära der Verwendung statistischer Modelle wie LDA und RNN oder kleiner Deep-Learning-Modelle handelt oder um die spätere Ära der Verwendung von Pre-Training und Feinabstimmung wie BERT, die von der Technologie bereitgestellten Funktionen sind relativ atomisiert und weit entfernt von tatsächlichen Anwendungsszenarien entfernt.

Nehmen Sie das obige Beispiel, in dem Sie ChatGPT bitten, eine englische E-Mail gemäß den Anforderungen zu schreiben. Gemäß der vorherigen Praxis müssen Sie möglicherweise Entitäten, Ereignisse und andere Inhalte (wie Zeit, Ort, Ereignisse) extrahieren , usw.) zuerst und verwenden Sie dann die Vorlage Oder das Modell bildet das Format der E-Mail, das dann durch ein Übersetzungsmodell ins Englische konvertiert wird. Wenn die Datenmenge ausreicht, um das End-to-End-Modell zu trainieren, können Sie natürlich auch einige Zwischenschritte überspringen. Unabhängig davon, welche Methode verwendet wird, muss entweder die endgültige Szene in atomare NLP-Aufgaben zerlegt werden oder es werden entsprechende Anmerkungsdaten benötigt. Für ChatGPT genügt ein passender Befehl. Drei Stufen des NLP-Technologieparadigmas.

. Unter diesem Paradigma wird der technische Weg zu vollständigen Terminalanwendungen nicht länger eine Kombination von Einzelpunkt-NLP-Fähigkeitsmodulen durch Bausteine sein.

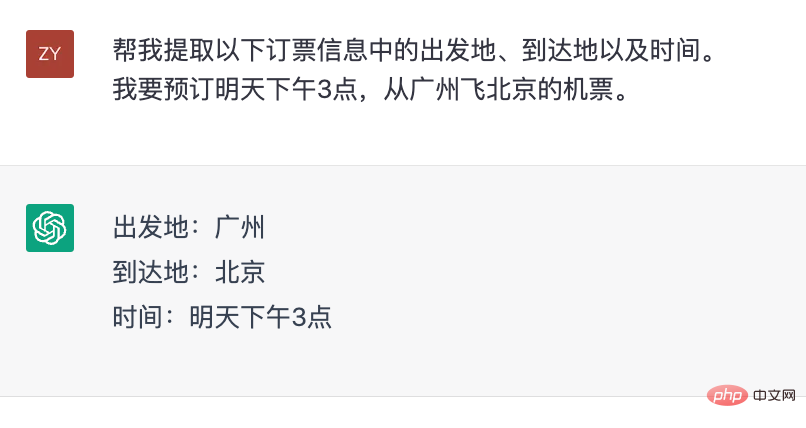

Natürlich wird dieser Prozess nicht über Nacht erreicht und bedeutet auch nicht, dass die Einzelpunktfähigkeit von NLP unwichtig wird. Aus Bewertungssicht kann die Qualität jedes einzelnen Fähigkeitspunkts dennoch als Indikator für die Bewertung der Wirksamkeit des Modells herangezogen werden. Darüber hinaus besteht in einigen Szenarien immer noch ein starker Bedarf an Single-Point-Fähigkeiten. Im Ticketbuchungssystem ist es beispielsweise erforderlich, Zeit und Ort zu extrahieren. Doch anders als bisher kann ChatGPT selbst auch Single-Point-Fähigkeiten absolvieren, ohne zusätzliche Funktionsmodule zu verwenden.

ChatGPT zur Informationsextraktion.

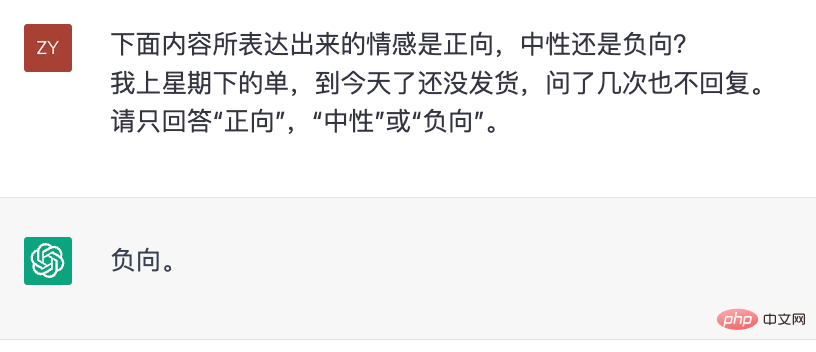

ChatGPT trifft emotionale Urteile.

Aus dieser Perspektive kann ChatGPT als ein NLP-Tool betrachtet werden, das natürliche Sprache als interaktives Medium verwendet. Wenn wir in der Vergangenheit eine bestimmte NLP-Fähigkeit durch Modell-, Daten- und Design-Trainingsaufgaben erreicht haben, vervollständigt ChatGPT diese Fähigkeiten durch Designanweisungen.

Aus dieser Perspektive kann ChatGPT als ein NLP-Tool betrachtet werden, das natürliche Sprache als interaktives Medium verwendet. Wenn wir in der Vergangenheit eine bestimmte NLP-Fähigkeit durch Modell-, Daten- und Design-Trainingsaufgaben erreicht haben, vervollständigt ChatGPT diese Fähigkeiten durch Designanweisungen.

Wie Sie sich vorstellen können, hat das Aufkommen von ChatGPT die Anwendungsschwelle der NLP-Technologie erheblich gesenkt. Aber es ist noch nicht allmächtig. Der wichtigste Punkt ist, dass es an genauen und zuverlässigen vertikalen Domänenkenntnissen mangelt. Um seine Antworten zuverlässig zu machen, besteht der direkteste Weg darin, externe Wissensquellen bereitzustellen, so wie Microsoft die Suchergebnisse von Bing als Informationsquelle verwendet seine Antworten.

Daher wird die „traditionelle“ NLP-Technologie nicht vollständig aussterben, sondern eine „Hilfs“-Rolle spielen, um die aktuellen Mängel von ChatGPT zu ergänzen ein neues Paradigma für die Anwendung der NLP-Technologie in der Zukunft sein.Das obige ist der detaillierte Inhalt vonDie Vergangenheit und Gegenwart von ChatGPT: Die technische „Sturheit' und das „große Wagnis' von OpenAI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr