Heim >Technologie-Peripheriegeräte >KI >Topologische Ästhetik im Deep Learning: GNN-Grundlage und Anwendung

Topologische Ästhetik im Deep Learning: GNN-Grundlage und Anwendung

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 19:31:041639Durchsuche

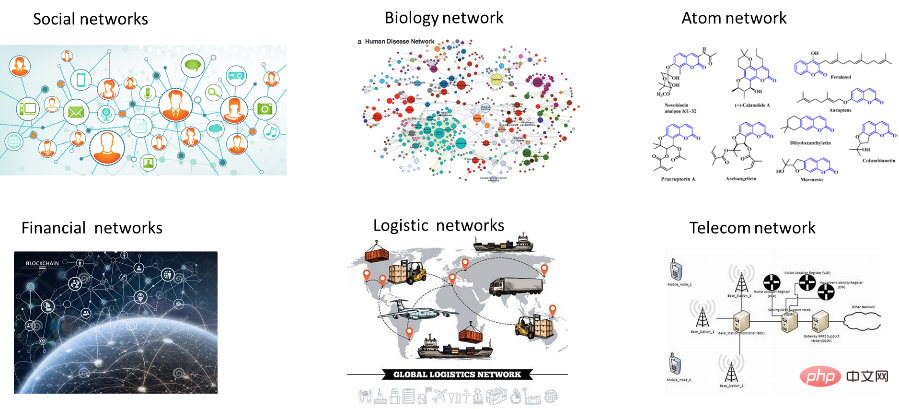

Einführung: In der realen Welt erscheinen viele Daten häufig in Form von Diagrammen, z. B. soziale Netzwerke, E-Commerce-Einkäufe, Proteininteraktionsbeziehungen usw. In den letzten Jahren wurde die Analyse von Diagrammdaten durchgeführt und auf neuronalen Netzen basierende Mining-Methoden wurden entwickelt. Seine hervorragende Leistung hat breite Aufmerksamkeit erregt und ist nicht nur zu einem Forschungs-Hotspot in der Wissenschaft geworden, sondern glänzt auch in einer Vielzahl von Anwendungen. Dieser Artikel kombiniert hauptsächlich relevante Literatur, den Austausch von Experten auf diesem Gebiet und die oberflächliche Erfahrung des Autors, um eine grobe Zusammenfassung und Einführung zu erstellen. Obwohl es sich um eine Wissensvermittlung handelt, ist sie auch mit persönlicher subjektiver Beurteilung verbunden. Voreingenommenheit und Auslassungen sind unvermeidlich, daher ist beim Lesen Vorsicht geboten. Der Heiligabend fällt mit dem Reparieren und Aufhören des Schreibens zusammen und ich wünsche allen, dass alles, was sie sich für das neue Jahr wünschen, in Erfüllung geht und dass sie sicher und glücklich sind.

1. Überblick über die Entwicklung graphischer neuronaler Netze

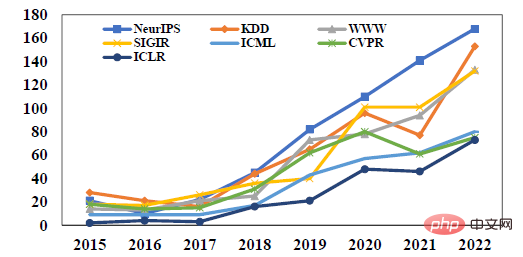

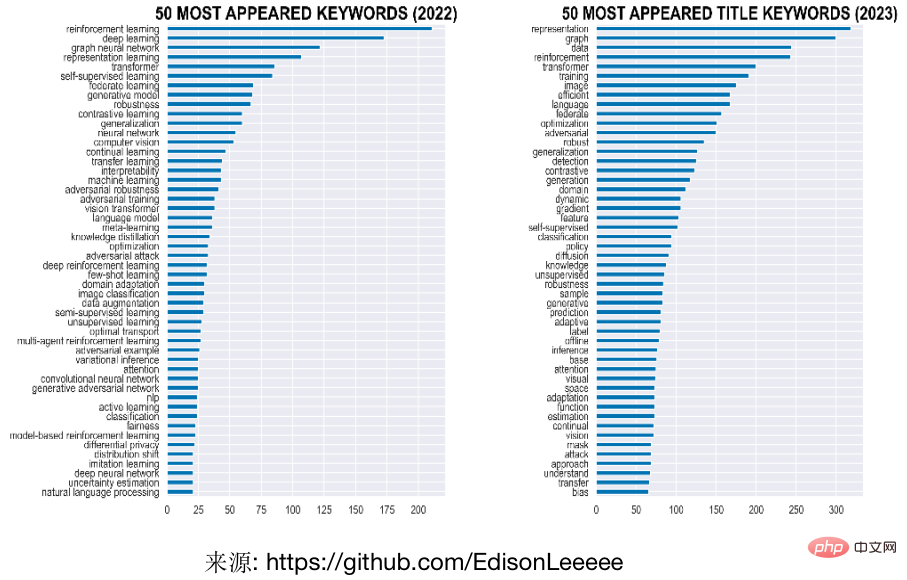

In den letzten Jahren hat die Forschung zur Verwendung von Modellen zur Analyse von Graphstrukturen aufgrund seiner hervorragenden Leistung immer mehr Aufmerksamkeit auf sich gezogen zu einem der Forschungs-Hotspots in der Wissenschaft werden. Wie in der folgenden Abbildung dargestellt, steigt beispielsweise die Zahl der Beiträge zu graphischen neuronalen Netzen auf Top-Konferenzen zum Thema maschinelles Lernen weiter an. Die Verwendung von Graphen als Titel oder Schlüsselwörter war eines der beliebtesten Wörter bei ICLR, der Top-Konferenz zum Thema Repräsentationslernen in den letzten zwei Jahren. Darüber hinaus wurden graphische neuronale Netze in diesem Jahr auf vielen Konferenzen mit den Best Paper Awards ausgezeichnet. So gingen beispielsweise der erste und zweite Platz für die beste Doktorarbeit der KDD, der führenden Data-Mining-Konferenz, an zwei junge Wissenschaftler mit Bezug zu Graphen In den besten Forschungs- und Anwendungspapieren geht es auch um kausales Lernen auf Hypergraphen bzw. föderiertes Graphenlernen. Andererseits haben graphische neuronale Netze auch viele praktische Anwendungen in den Bereichen E-Commerce-Suche, Empfehlung, Online-Werbung, Finanzrisikokontrolle, Verkehrsvorhersage und anderen Bereichen. Große Unternehmen arbeiten ebenfalls intensiv an der Entwicklung von Plattformen oder Funktionen für das Lernen von Graphen.

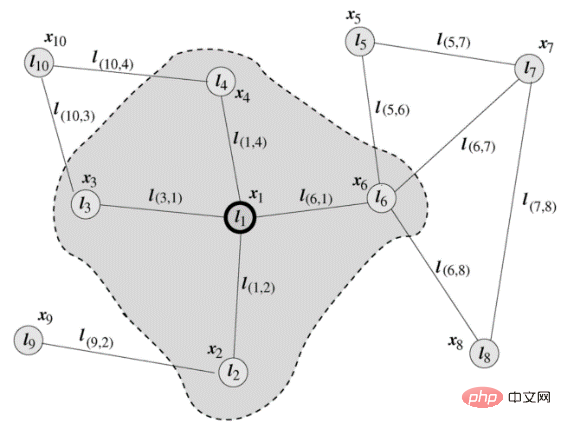

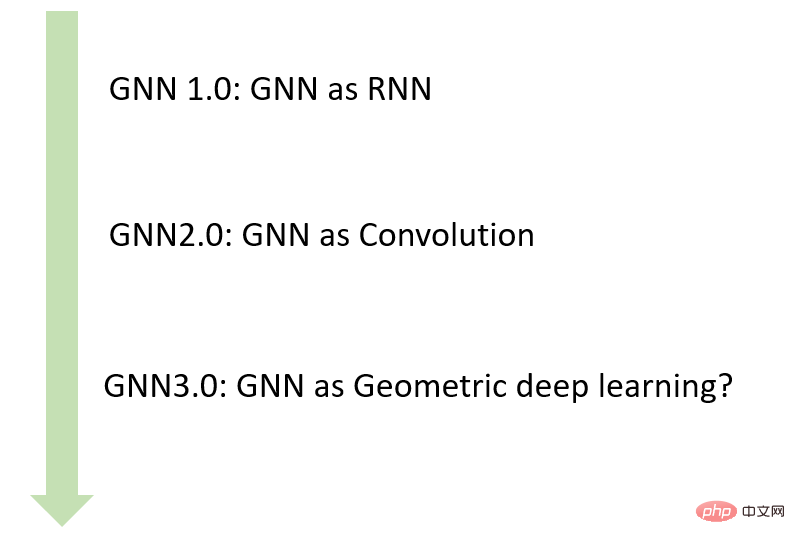

Obwohl graphische neuronale Netze erst in den letzten fünf Jahren zu einem Forschungsschwerpunkt geworden sind, wurde die entsprechende Definition 2005 von den italienischen Wissenschaftlern Marco Gori und Franco Scarselli vorgeschlagen. Ein typisches Diagramm in Scarsellis Artikel ist unten dargestellt. Die frühe Phase von GNN verwendet hauptsächlich RNN als Hauptrahmen, gibt Knotennachbarninformationen ein, um den Knotenstatus zu aktualisieren, und definiert die lokale Übertragungsfunktion als zirkuläre rekursive Funktion. Jeder Knoten verwendet umgebende Nachbarknoten und verbundene Kanten als Quellinformationen, um seinen zu aktualisieren eigener Express.

LeCuns Studentin Bruna und andere schlugen 2014 vor, CNN auf Diagramme anzuwenden. Durch geschickte Konvertierung von Faltungsoperatoren schlugen sie zwei Methoden zur Informationsaggregation vor, die auf frequenzdomänen- und räumlichen domänenbasierten Graphfaltungsnetzwerken basieren. Spektrumbasierte Methoden führen Filter aus der Perspektive der Graphsignalverarbeitung ein, um die Graphfaltung zu definieren, wobei die Graphfaltungsoperation als Entfernen von Rauschen aus dem Graphsignal interpretiert wird. Raumbasierte Methoden entsprechen eher dem CNN-Paradigma und stellen die Graphenfaltung als Aggregation von Merkmalsinformationen aus Nachbarschaften dar. Obwohl in den folgenden Jahren sporadisch einige neue Modelle vorgeschlagen wurden, handelte es sich immer noch um relativ Nischenforschungsrichtungen. Erst 2017 wurde eine Reihe von Forschungsarbeiten vorgeschlagen, die von den drei Musketieren der Graphenmodelle GCN, GAT und GraphSage vertreten wurden und die rechnerischen Barrieren zwischen Graphendaten und Faltungs-Neuronalen Netzen öffneten, wodurch sich Graphen-Neuronale Netze nach und nach entwickelten ein Forschungs-Hotspot und legte den Grundstein für das aktuelle Grundparadigma des graphischen neuronalen Netzwerkmodells basierend auf dem Message-Passing-Mechanismus (MPNN).

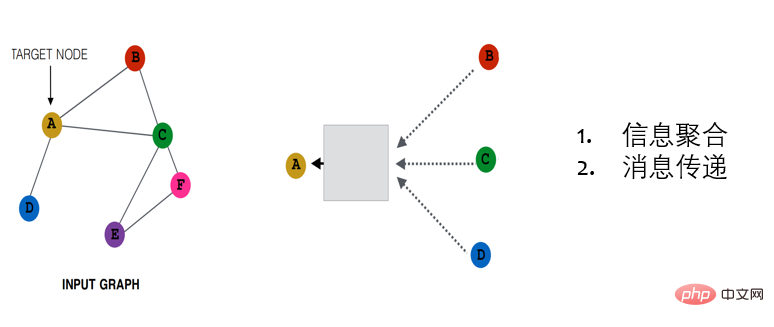

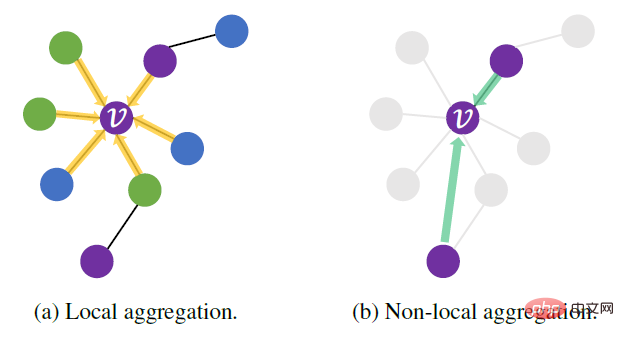

Eine typische MPNN-Architektur besteht aus mehreren Ausbreitungsschichten, die jeden Knoten basierend auf einer Aggregationsfunktion von Nachbarmerkmalen aktualisieren. Gemäß verschiedenen Aggregationsfunktionen kann MPNN unterteilt werden in: Informationsaggregation (lineare Kombination benachbarter Merkmale, deren Gewicht nur von der Struktur des Diagramms abhängt, z. B. GCN), Aufmerksamkeit (lineare Kombination, das Gewicht hängt von der Struktur des Diagramms ab). Funktionen wie GAT) und Nachrichtenübermittlung (verallgemeinerte nichtlineare Funktionen wie GraphSAGE), dargestellt von links nach rechts in der folgenden Abbildung.

Aus Sicht des Denkens kann es auch in transduktive (wie GCN) und induktive (wie GraphSage) unterteilt werden. Die direkte Push-Methode erlernt eine eindeutige Darstellung für jeden Knoten, aber die Einschränkungen dieses Modells sind sehr offensichtlich. In den meisten Geschäftsszenarien in der Branche können die Struktur und die Knoten im Diagramm nicht geändert werden Benutzer werden weiterhin in der Benutzersammlung angezeigt, die Aufmerksamkeitsbeziehungssammlung des Benutzers wird ebenfalls weiter wachsen und täglich wird eine große Anzahl neuer Artikel auf der Inhaltsplattform hinzugefügt. In einem solchen Szenario erfordert direktes Push-Lernen eine ständige Neuschulung, um Darstellungen für neue Knoten zu lernen. Die induktive Methode besteht darin, die „Aggregationsfunktion“ der Eigenschaften von Knotennachbarn zu erlernen, die auf flexiblere Szenarien angewendet werden kann, z. B. auf die Darstellung neuer Knoten oder Änderungen in der Struktur des Diagramms usw., sodass sie anwendbar ist Verschiedene Diagramme in tatsächlichen Szenarien. Dynamisch wechselnde Szenen.

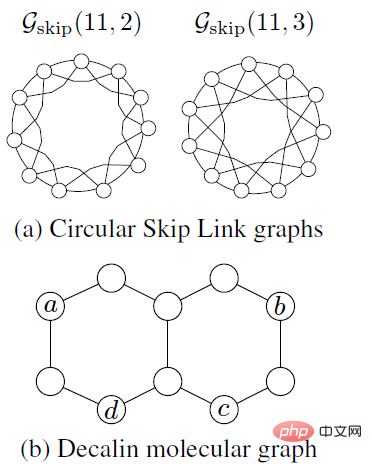

Im Entwicklungsprozess graphischer neuronaler Netze werden von Generation zu Generation ständig neue Modelle vorgeschlagen, um das Problem der Genauigkeit und Skalierbarkeit der Graphnetzberechnung zu lösen. Obwohl die Fähigkeit graphischer neuronaler Netze zur Darstellung von Graphendaten unbestritten ist, basiert das neue Modelldesign hauptsächlich auf empirischer Intuition, heuristischen Methoden und experimentellen Versuch-und-Irrtum-Methoden. Die verwandte Arbeit GIN (Graph Isomorphism Networks) der Gruppe von Jure Leskovec aus dem Jahr 2019 stellte eine Verbindung zwischen GNN und dem klassischen heuristischen Algorithmus Weisfeiler Lehman (WL) zur Erkennung von Graphisomorphismus her und bewies theoretisch, dass die Obergrenze der Ausdrucksfähigkeit von GNN bei 1-WL liegt (Jure ist). derzeit außerordentlicher Professor an der School of Computer Science der Stanford University. Das von ihm geleitete SNAP-Labor ist derzeit eines der bekanntesten Labore auf dem Gebiet des Graphennetzwerks. Das von ihm unterrichtete CS224W „Graph Machine Learning“ ist ein sehr empfehlenswertes Lernprogramm Material). Allerdings verfügt der WL-Algorithmus für viele Datenszenarien, wie beispielsweise die beiden Beispiele in der Abbildung unten, über sehr begrenzte Ausdrucksfähigkeiten. Für die Circular Skip Link (CSL)-Diagramme in (a) markiert 1-WL jeden Knoten in den beiden Diagrammen mit der gleichen Farbe. Mit anderen Worten, es handelt sich offensichtlich um zwei Diagramme mit völlig unterschiedlichen Strukturen Wir werden das gleiche Etikett bekommen. Das zweite Beispiel ist das in (b) gezeigte Decalin-Molekül, das a und b in derselben Farbe und c und d in derselben Farbe färbt, sodass bei der Aufgabe der Verknüpfungsvorhersage (a, d) und (b) , d) sind nicht unterscheidbar.

Der WL-Test schneidet bei vielen Daten mit dreieckigen oder zyklischen Strukturen nicht zufriedenstellend ab. In Bereichen wie der Biochemie sind zyklische Strukturen jedoch sehr verbreitet und sehr wichtig. Sie bestimmen auch die entsprechenden Eigenschaften von Molekülen, wodurch die Anwendbarkeit des Graphen beeinträchtigt wird Netzwerk in relevanten Szenarien ist stark begrenzt. Micheal Bostein und andere schlugen vor, dass die derzeitige „knoten- und kantenzentrierte“ Denkweise bei Graph-Deep-Learning-Methoden große Einschränkungen aufweist. Auf dieser Grundlage schlugen sie vor, die Entwicklung des Graph-Lernens und mögliche neue Ansätze aus der Perspektive der Geometrie zu überdenken Deep-Learning-Paradigma (Micheal ist derzeit DeepMind-Professor für Künstliche Intelligenz an der Universität Oxford und Chefwissenschaftler der Twitter Graph Learning Research Group und einer der Förderer des geometrischen Deep Learning). Viele Wissenschaftler haben auch mit der Erforschung einer Reihe neuer Werkzeuge aus den Bereichen Differentialgeometrie, algebraische Topologie und Differentialgleichungen begonnen und eine Reihe von Arbeiten wie äquivariantes graphisches neuronales Netzwerk, topologisches graphisches neuronales Netzwerk, subgraphisches neuronales Netzwerk usw. vorgeschlagen. und haben viele Probleme gelöst. In Kombination mit dem Entwicklungskontext graphischer neuronaler Netze können wir eine einfache Zusammenfassung erstellen, wie unten gezeigt.

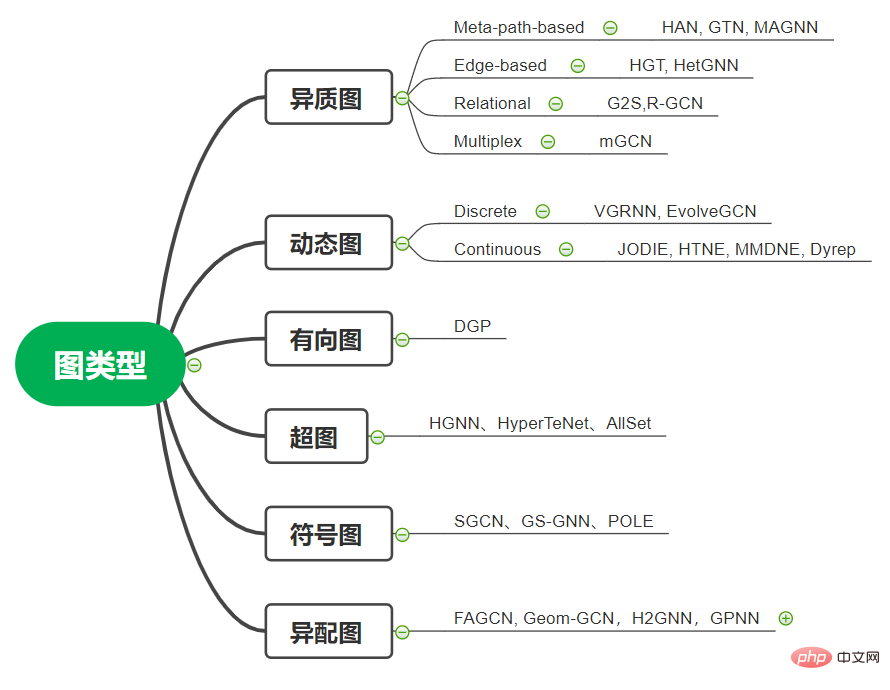

2. Komplexes Graphenmodell

Im vorherigen Abschnitt haben wir einen Überblick über den Entwicklungsprozess von graphischen neuronalen Netzen gegeben Allerdings sind Graphen in der realen Welt oft komplex. Als nächstes werden wir diese Szenarien analysieren Diagrammdatenformen und zugehörige Modelle:

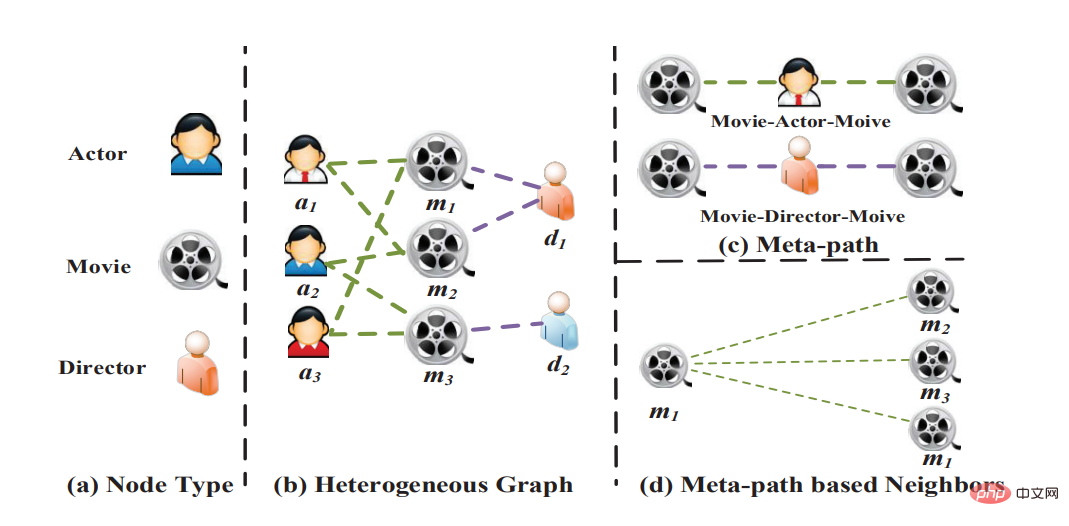

1. Heterogenes Diagramm: Heterogenes Diagramm bedeutet, dass Knoten und Kanten mehrere Kategorien haben und es mehrere Zustandsmodelle gibt. In einem E-Commerce-Szenario können Knoten beispielsweise Produkte, Geschäfte, Benutzer usw. sein und Kantentypen können Klicks, Sammlungen, Transaktionen usw. sein. Insbesondere trägt in heterogenen Diagrammen jeder Knoten Typinformationen und jede Kante trägt auch Typinformationen. Das allgemeine GNN-Modell kann die entsprechenden heterogenen Informationen nicht modellieren. Einerseits können die Einbettungsdimensionen verschiedener Knotentypen nicht ausgerichtet werden, andererseits befinden sich die Einbettungen verschiedener Knotentypen in unterschiedlichen semantischen Räumen. Die am weitesten verbreitete Lernmethode für heterogene Diagramme ist die Metapfad-basierte Methode. Der Metapfad gibt den Knotentyp an jeder Stelle im Pfad an. Während des Trainings werden Metapfade als Knotensequenzen instanziiert, und wir erfassen die Ähnlichkeit zweier Knoten, die möglicherweise nicht direkt verbunden sind, indem wir die Knoten an beiden Enden einer Metapfadinstanz verknüpfen. Auf diese Weise kann ein heterogener Graph auf mehrere isomorphe Graphen reduziert werden, und wir können Algorithmen zum Lernen von Graphen auf diese isomorphen Graphen anwenden. Darüber hinaus wurden in einigen Arbeiten kantenbasierte Methoden zum Umgang mit heterogenen Graphen vorgeschlagen, die unterschiedliche Abtastfunktionen und Aggregationsfunktionen für verschiedene Nachbarknoten und Kanten verwenden. Zu den repräsentativen Werken gehören HetGNN, HGT usw. Manchmal müssen wir uns auch mit Beziehungsdiagrammen befassen. Die Kanten in diesen Diagrammen enthalten möglicherweise andere Informationen als Kategorien, oder die Anzahl der Kantenkategorien ist sehr groß, was die Verwendung von Methoden, die auf Metapfaden oder Metabeziehungen basieren, erschwert. Freunde, die sich für heterogene Graphen interessieren, können die Arbeitsreihe der Lehrer Ishikawa und Wang Xiao von der Peking-Universität verfolgen.

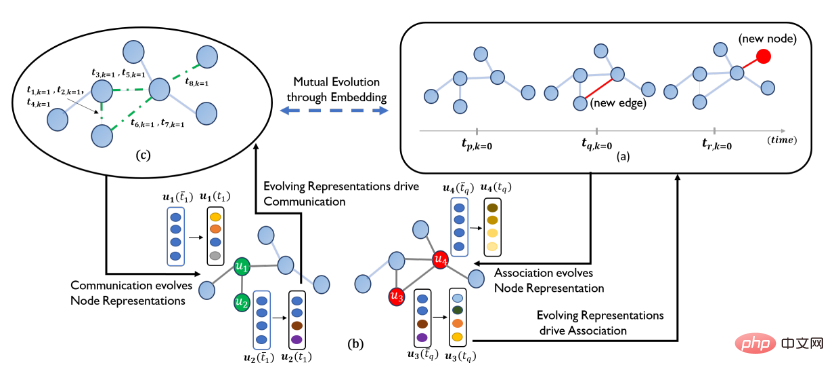

2. Dynamisches Diagramm: Dynamisches Diagramm bezieht sich auf Diagrammdaten, in denen sich Knoten und topologische Strukturen im Laufe der Zeit entwickeln, und wird auch häufig in tatsächlichen Szenarien verwendet. Beispielsweise wird sich das akademische Zitationsnetzwerk im Laufe der Zeit weiter ausdehnen, das Interaktionsdiagramm zwischen Benutzern und Produkten wird sich mit den Benutzerinteressen ändern und das Transportnetz und der Verkehrsfluss werden sich im Laufe der Zeit weiterhin ändern. GNN-Modelle auf dynamischen Graphen zielen darauf ab, Knotendarstellungen zu einem bestimmten Zeitpunkt zu generieren. Entsprechend der Dicke der Zeitgranularität können dynamische Diagramme in zeitdiskrete dynamische Diagramme (auch Snapshot-basiert genannt) und zeitkontinuierliche dynamische Diagramme (ereignisbasiert) unterteilt werden Slices (Zum Beispiel in Tage/Stunden unterteilt), entspricht jedes Zeitslice einem statischen Bild. Das GNN-Modell zeitdiskreter dynamischer Graphen wendet das GNN-Modell normalerweise separat auf jede Zeitscheibe an und verwendet dann RNN, um die Darstellung von Knoten zu verschiedenen Zeiten zu aggregieren. Zu den repräsentativen Werken gehören DCRNN, STGCN, DGNN, EvolveGCN usw. In einem zeitkontinuierlichen dynamischen Diagramm ist jede Kante mit einem Zeitstempel versehen, der den Zeitpunkt angibt, zu dem ein Interaktionsereignis auftritt. Im Vergleich zu statischen Diagrammen hängt die Nachrichtenfunktion in zeitkontinuierlichen dynamischen Diagrammen auch vom Zeitstempel einer bestimmten Stichprobe und dem Zeitstempel der Kante ab. Darüber hinaus müssen Nachbarknoten mit der Zeit verknüpft sein. Beispielsweise können Knoten, die nach einer bestimmten Zeit erscheinen, nicht in Nachbarknoten erscheinen. Aus Modellsicht werden Punktprozesse häufig zur Modellierung kontinuierlicher dynamischer Diagramme verwendet, und die Ankunftsrate der Sequenz wird durch Optimierung der bedingten Intensitätsfunktion der in der Nachbarschaft generierten Sequenz generiert. Diese Methode kann auch den spezifischen Zeitpunkt des Auftretens eines Ereignisses weiter vorhersagen (z. B. ein Netzwerk, die Todeszeit eines bestimmten Links). Zu den repräsentativen Arbeiten zur Modellierung kontinuierlicher dynamischer Graphen gehören JODIE, HTNE, MMDNE und Dyrep.

Quelle: Dyrep

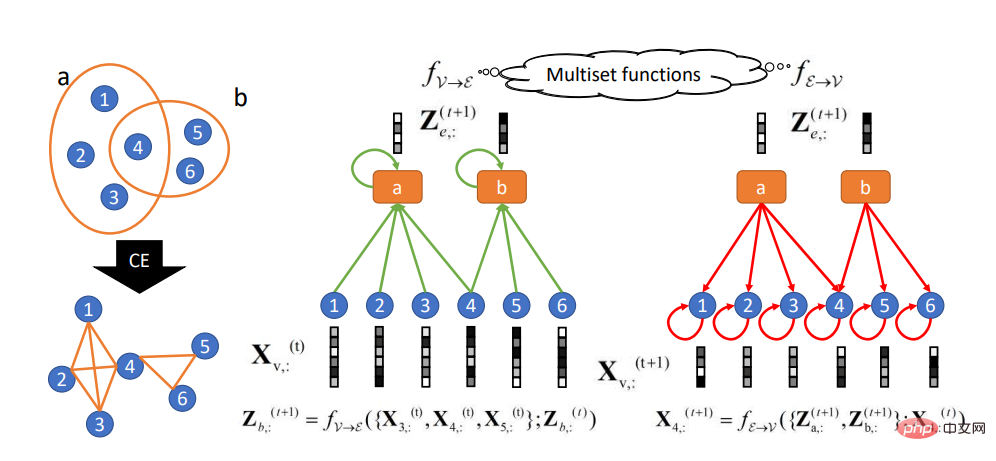

3. Hypergraph: Ein Hypergraph ist ein Graph im weitesten Sinne, und eine seiner Kanten kann jeden Scheitelpunkt von verbinden Menge. In den Anfängen der Forschung zu Hypergraphen bezog es sich hauptsächlich auf Anwendungen in Computer-Vision-Szenarien. Zu den Hauptanwendungsgebieten und -szenarien gehören beispielsweise Empfehlungssysteme Die Anzahl der Knoten im Diagramm kann durch verschiedene Arten von mehreren Kanten verknüpft werden. Durch die Verwendung verschiedener Kantentypen können wir das Diagramm in mehrere Ebenen organisieren, wobei jede Ebene eine Art Beziehung darstellt. Zu den repräsentativen Werken gehören HGNN, AllSet usw.

Quelle: AllSet

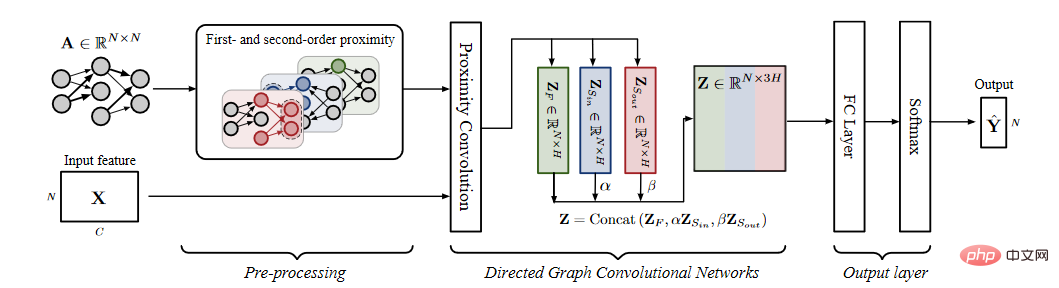

4. Gerichteter Graph: Gerichteter Graph bedeutet, dass die Verbindungsbeziehung von Knoten gerichtet ist und gerichtete Kanten oft kleiner sind als ungerichtete Kanten, die mehr Informationen enthalten. Wenn beispielsweise in einem Wissensgraphen die Kopfentität die übergeordnete Klasse der Schwanzentität ist, liefert die Richtung der Kante Informationen über diese Teilordnungsbeziehung. Für gerichtete Diagrammszenarien können Sie neben der einfachen Verwendung einer asymmetrischen Adjazenzmatrix in der Faltungsoperation auch die beiden Richtungen der Kante separat modellieren, um eine bessere Darstellung zu erhalten. Repräsentative Arbeiten umfassen DGP usw.

Quelle: DGP

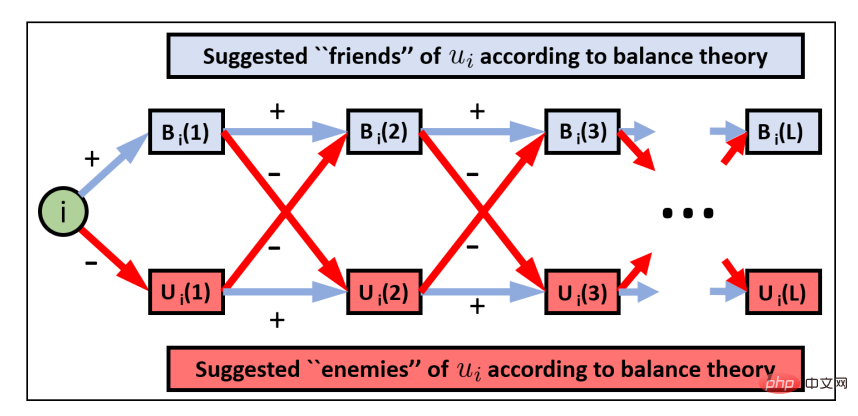

5. Vorzeichenbehaftetes Diagramm: Vorzeichenbehaftetes Diagramm bezieht sich auf die Beziehung zwischen Knoten im Diagramm, einschließlich Vorwärts- und Rückwärtsbeziehungen, wie z Dazu gehören positive Beziehungen wie Freundschaft, Zustimmung und Unterstützung sowie negative Beziehungen wie Feinde, Meinungsverschiedenheiten, Widerstand usw. Im Vergleich zu gewöhnlichen Diagrammen enthalten symbolische Diagramme umfangreichere interaktive Knotenbeziehungen. Das Hauptproblem bei der Modellierung symbolischer Graphen besteht darin, wie negative Kanten modelliert werden und wie die Informationen der beiden Kantentypen aggregiert werden. SGCN basiert auf den Annahmen der Gleichgewichtstheorie (Freunde von Freunden sind Freunde und Freunde von Feinden). Der entsprechende Gleichgewichtspfad wird definiert, um eine entsprechende Modellierung durchzuführen. Zu den repräsentativen Arbeiten gehören außerdem das Polarisationseinbettungsmodell POLE mit symbolischem Netzwerk, das bipartite symbolische graphische neuronale Netzwerkmodell SBGNN und das symbolische graphische neuronale Netzwerk GS-GNN basierend auf der k-Gruppen-Theorie.

6. Eigenwilliges Bild:

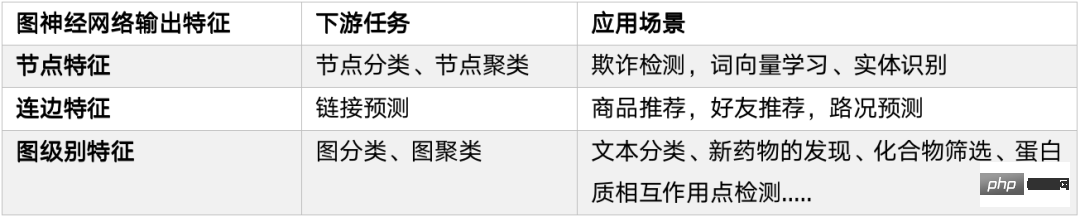

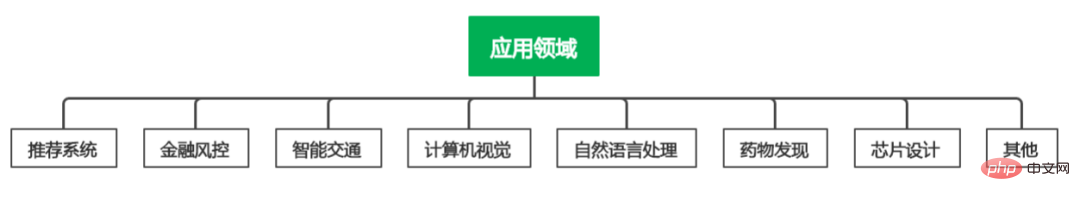

3. Graph Neural Network ApplicationDa Graph Neural Network die Eigenschaften von graphstrukturierten Daten besser lernen kann, wurde es in vielen graphbezogenen Bereichen verwendet Bereiche Umfangreiche Anwendung und Erkundung. In diesem Abschnitt ordnen und fassen wir entsprechend aus der Perspektive nachgelagerter Aufgaben und Anwendungen ein.

1. Nachgelagerte Aufgaben

# 🎜🎜#

# 🎜🎜#

Knotenklassifizierung:#🎜 🎜 # Basierend auf Knotenattributen (kann kategorisch oder numerisch sein), Kanteninformationen, Kantenattributen (falls vorhanden) und bekannten Knotenvorhersageetiketten werden Knoten mit unbekannten Etiketten vorhergesagt. Der OGB-Produktdatensatz ist beispielsweise ein ungerichtetes Produktkaufnetzwerk. Die Knoten stellen im E-Commerce verkaufte Produkte dar. Die Attribute der Knoten werden durch die Produkte bestimmt Aus der Beschreibung werden Bag-of-Word-Merkmale extrahiert und anschließend eine Hauptkomponentenanalyse durchgeführt, um eine Dimensionsreduktion zu erzeugen. Die entsprechende Aufgabe besteht darin, die fehlenden Kategorieinformationen des Produkts vorherzusagen.

Link-Vorhersage:

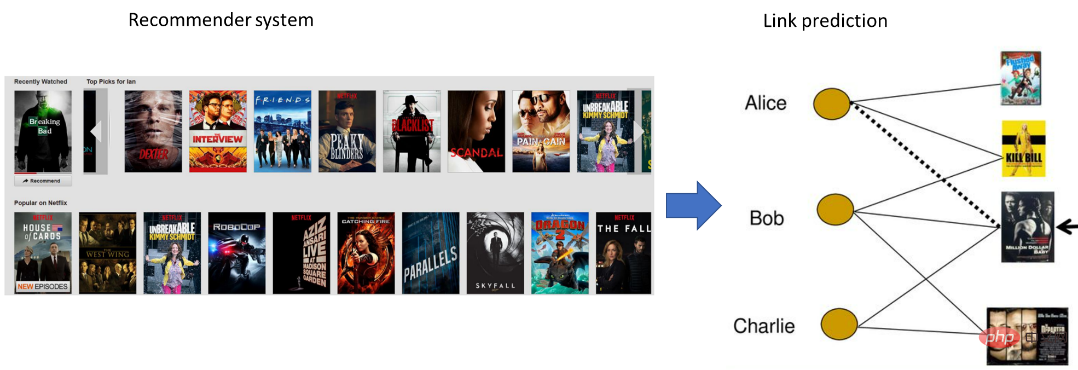

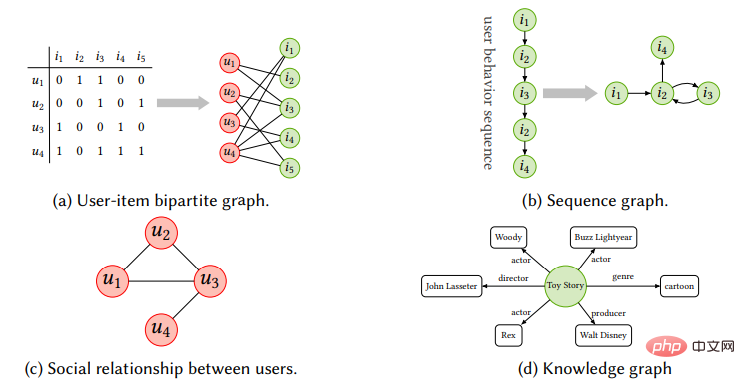

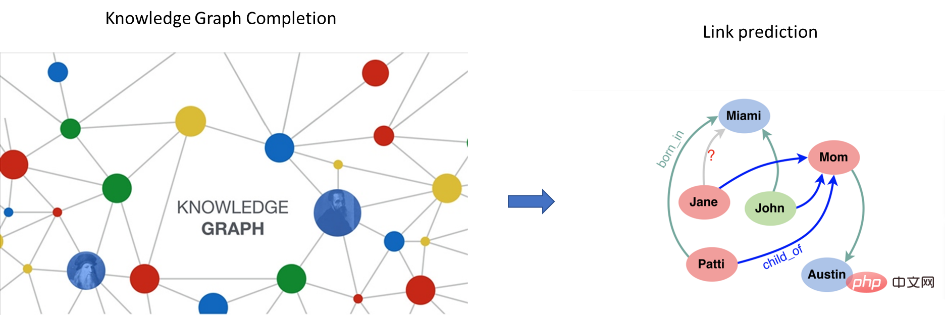

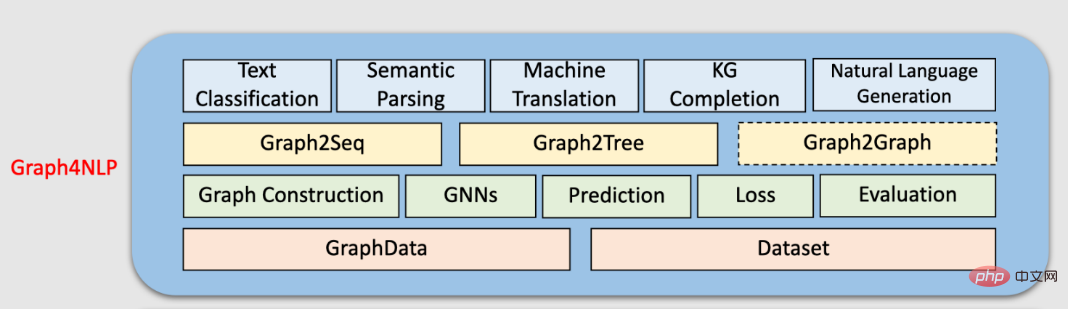

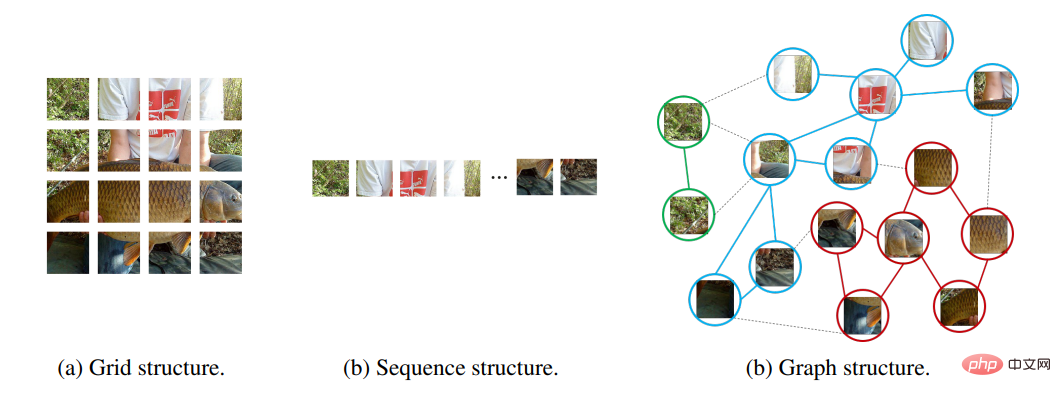

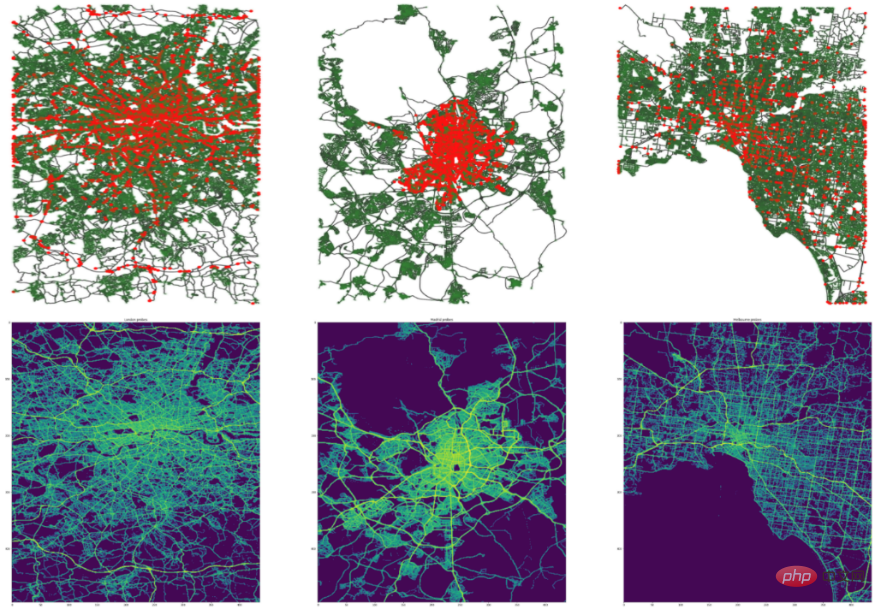

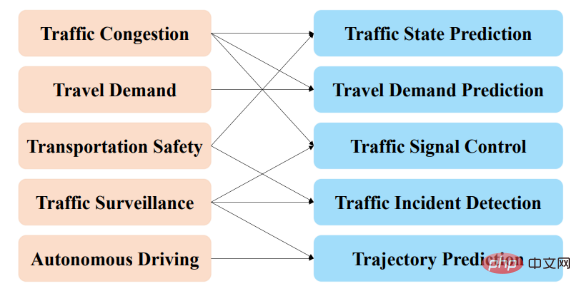

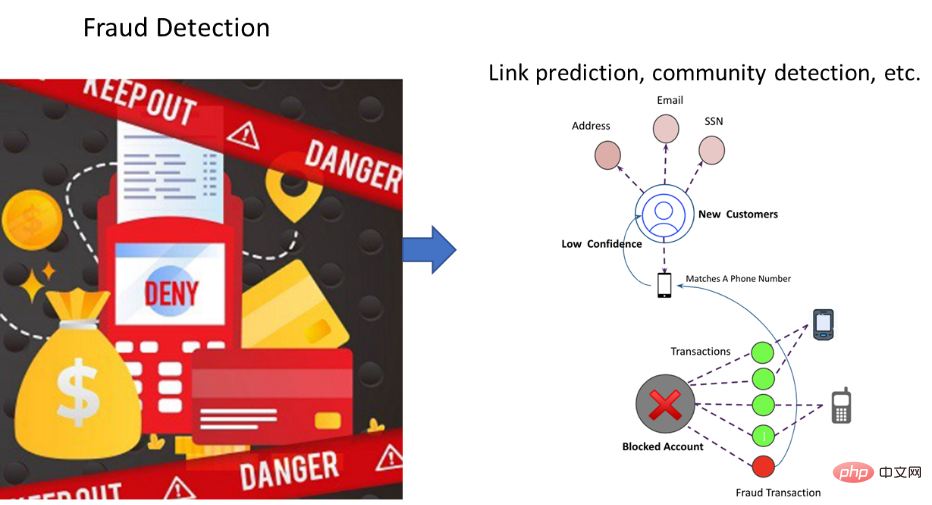

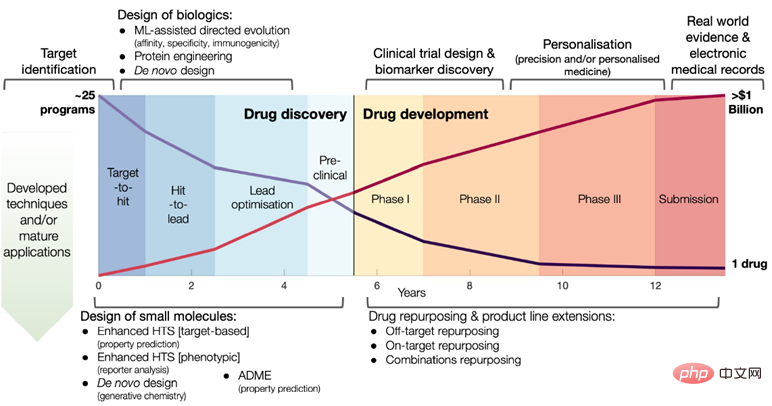

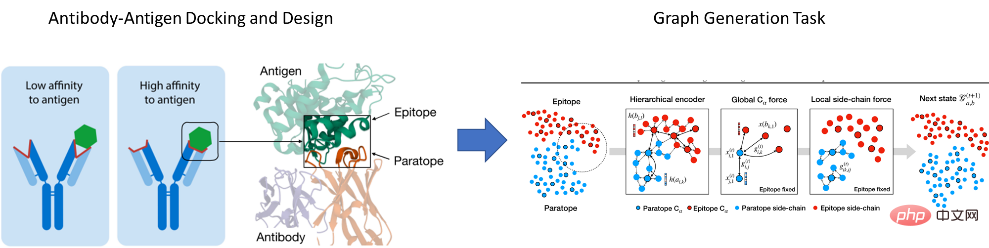

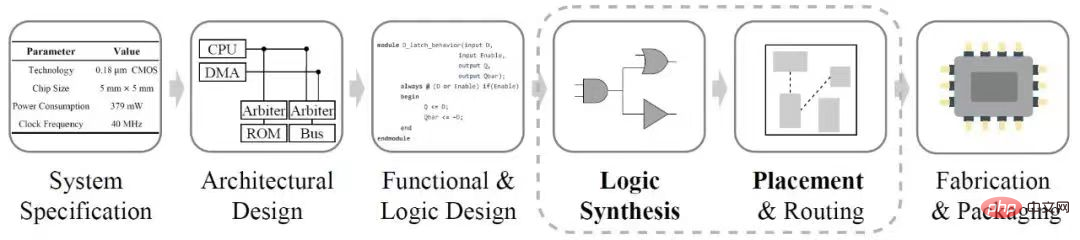

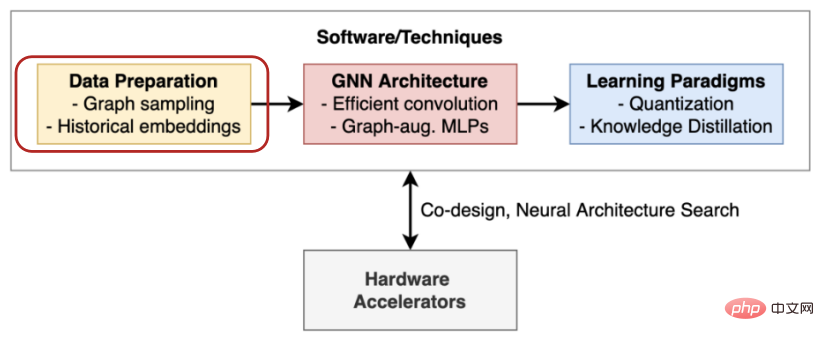

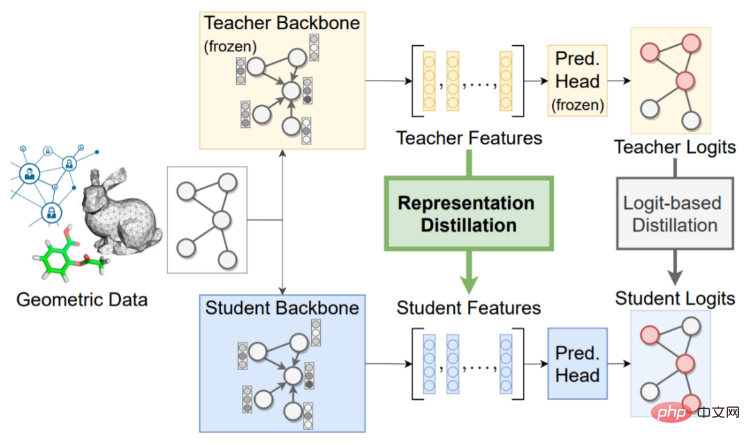

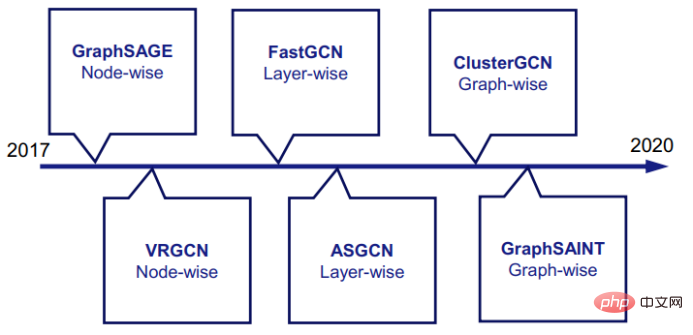

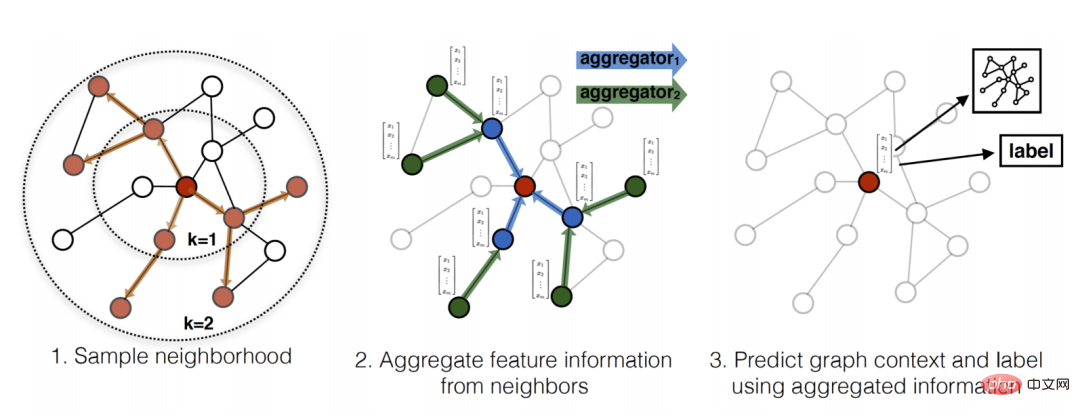

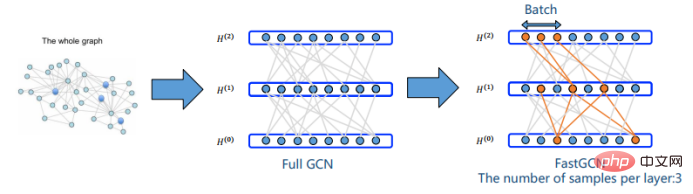

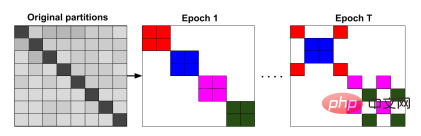

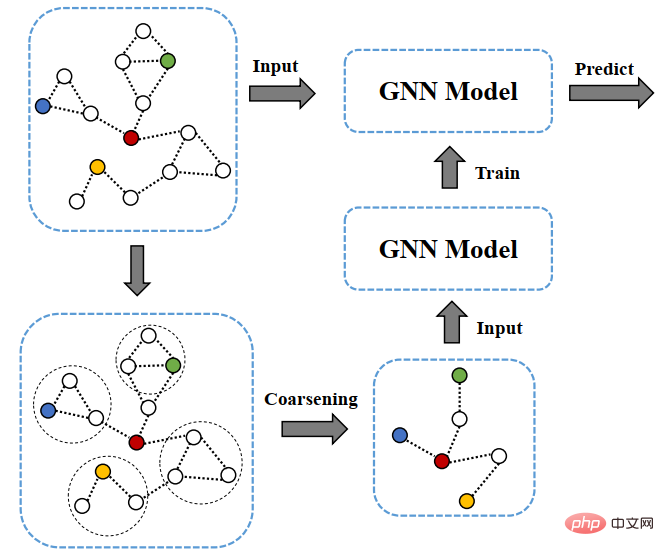

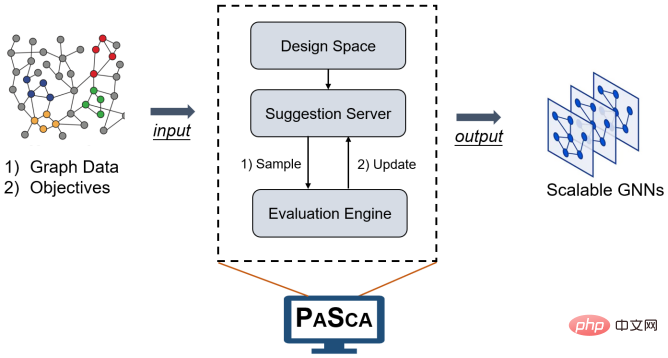

Grafikklassifizierung: Die Grafikklassifizierung ähnelt tatsächlich der Knotenklassifizierung. Das Wesentliche besteht darin, die Beschriftung des Diagramms vorherzusagen. Basierend auf den Eigenschaften des Diagramms (z. B. Diagrammdichte, Informationen zur Diagrammtopologie usw.) und der Bezeichnung des bekannten Diagramms kann die Erstellung von Kategorievorhersagen für Diagramme mit unbekannten Bezeichnungen in der Bioinformatik und der chemischen Informatik gefunden werden, beispielsweise beim Training neuronaler Diagramme Netzwerke zur Vorhersage der Proteinstruktur. Graphgenerierung: Das Ziel der Graphgenerierung besteht darin, anhand einer Reihe beobachteter Graphen neue Graphen zu generieren, z. B. in biologischen Informationen auf der Grundlage der Generierung neuer molekularer Strukturen oder bei der Verarbeitung natürlicher Sprache. Erzeugen Sie einen semantischen Graphen oder Wissensgraph basierend auf einem bestimmten Satz. 2. Anwendungsfelder Wir werden entsprechend verschiedene Anwendungsszenarien vorstellen. Empfehlungssystem: Die Entwicklung des mobilen Internets hat die rasante Entwicklung des Informationsabrufs erheblich gefördert. Empfehlungssysteme als wichtigste Richtung haben große Beachtung gefunden. Der Hauptzweck des Empfehlungssystems besteht darin, effektive Benutzer- und Artikeldarstellungen aus historischen Interaktionen und Nebeninformationen zu lernen, um Artikel (Waren, Musik) zu empfehlen, die der Benutzer mit größerer Wahrscheinlichkeit bevorzugt (Videos, Filme usw.). Daher ist es naheliegend, die Erstellung eines zweiteiligen Diagramms mit Elementen und Benutzern als Knoten in Betracht zu ziehen, damit das neuronale Netzwerk des Diagramms auf das Empfehlungssystem angewendet werden kann, um den Empfehlungseffekt zu verbessern. Basierend auf GraphSAGE schlug Pinterest PinSage vor, das erste auf GCN basierende Empfehlungssystem auf industrieller Ebene, das umfangreiche Bildempfehlungsszenarien mit 3 Milliarden Knoten und 18 Milliarden Kanten unterstützt. Tatsächlich stiegen die Shop- und Look-Produktaufrufe von Pinterest, nachdem es online ging um 25 %. Darüber hinaus nutzen Alibaba, Amazon und viele andere E-Commerce-Plattformen GNN, um entsprechende Empfehlungsalgorithmen zu erstellen. Zusätzlich zum zweiteiligen Diagramm, das aus der Benutzer-Element-Interaktion besteht, liegen die sozialen Beziehungen im Empfehlungssystem und das Elementübertragungsdiagramm in der Wissensdiagrammsequenz alle in Form von Diagrammdaten vor Andererseits werden Heterogenitätsstrukturdaten auch häufig in E-Commerce-Szenarien in Empfehlungssystemen verwendet. Knoten können Abfrage, Artikel, Shop, Benutzer usw. sein, und Kantentypen können Klicks, Sammlungen, Transaktionen usw. sein. Durch die Nutzung der Beziehungs- und Inhaltsinformationen zwischen Projekten, Benutzern und Benutzern, Benutzern und Projekten und basierend auf heterogenen und multimodalen Diagrammmodellen aus mehreren Quellen werden kontinuierlich auch höherwertige Empfehlungseffekte untersucht. Darüber hinaus haben serialisierte Empfehlungen, die auf Änderungen des Benutzerverhaltens im Laufe der Zeit im tatsächlichen Geschäft basieren, und inkrementelles Lernen, das durch die Hinzufügung neuer Benutzer und Produkte verursacht wird, auch neue Herausforderungen und Möglichkeiten für die Entwicklung von GNN-Modellen mit sich gebracht. Verarbeitung natürlicher Sprache: Viele Probleme und Szenarien in der Verarbeitung natürlicher Sprache beschreiben Assoziationsbeziehungen, sodass sie auf natürliche Weise in Diagrammdatenstrukturen modelliert werden können. Das erste direkte Anwendungsszenario ist die Vervollständigung und Begründung des Wissensgraphen (KG). Forscher von Mila schlugen beispielsweise vor, das Problem des Single-Hop-Argumentation in ein Pfaddarstellungs-Lernproblem umzuwandeln und so den Wissensgraphen zu realisieren . Graphische neuronale Netze verwenden tiefe neuronale Netze, um topologische Strukturinformationen und Attributmerkmalsinformationen in Diagrammdaten zu integrieren, wodurch eine verfeinerte Merkmalsdarstellung von Knoten oder Unterstrukturen bereitgestellt wird, und können problemlos entkoppelt oder durchgängig mit Downstream-Aufgaben kommunizieren erfüllt die Anforderungen von Wissensgraphen in verschiedenen Anwendungsszenarien zum Erlernen von Attributmerkmalen und Strukturmerkmalen von Entitäten und Beziehungen. Darüber hinaus werden graphische neuronale Netze bei vielen Problemen in der Verarbeitung natürlicher Sprache verwendet, wie z. B. Textklassifizierung, semantische Analyse, maschinelle Übersetzung, Vervollständigung von Wissensgraphen, Erkennung benannter Entitäten, maschinelle Klassifizierung usw Für weitere Inhalte empfehlen wir Ihnen die entsprechenden Tutorials und Rezensionen von Graph4NLP. Quelle: (https://github.com/graph4ai/graph4nlp ) Computer Vision: Computer Vision ist eines der größten Anwendungsszenarien im Maschinenbereich Lernen und Deep Learning Erstens sind graphische neuronale Netze im Vergleich zu den Bereichen Empfehlungssysteme und Verarbeitung natürlicher Sprache kein Mainstream in der Computer Vision. Der Grund dafür ist, dass der Vorteil von GNN in der Modellierung und dem Lernen von Beziehungen liegt und die meisten Datenformate in der Bildverarbeitung reguläre Bilddaten sind. Bei der Verwendung von GNN in CV-Szenarien liegt der Schlüssel in der Konstruktion des Diagramms: Was sind die Scheitelpunkte und Scheitelpunktmerkmale? Wie definiere ich die Verbindungsbeziehung von Scheitelpunkten? Die anfängliche Arbeit wird hauptsächlich für einige Szenen verwendet, die intuitiv sind und die Diagrammstruktur leicht abstrahieren. Beispielsweise kann bei der für dynamische Skelette verwendeten Aktionserkennungsmethode ST-GCN das natürliche Skelett des menschlichen Körpers natürlich als Diagrammstruktur betrachtet werden, um ein räumliches Diagramm zu erstellen. Bei der Generierung von Szenendiagrammen helfen die semantischen Beziehungen zwischen Objekten, die semantische Bedeutung hinter der visuellen Szene zu verstehen. Anhand eines Bildes erkennen und identifizieren Modelle zur Generierung von Szenengraphen Objekte und sagen semantische Beziehungen zwischen Objektpaaren voraus. Bei der Punktwolkenklassifizierung und -segmentierung werden Punktwolken in k-nächste Nachbardiagramme oder Überlagerungsdiagramme umgewandelt, um Diagrammnetzwerke zum Erlernen verwandter Aufgaben zu verwenden. In letzter Zeit nimmt auch die Anwendungsrichtung graphischer neuronaler Netze in der Computer Vision zu. Einige Forscher haben entsprechende Untersuchungen und Versuche zu allgemeinen Computer-Vision-Aufgaben wie der Objekterkennung durchgeführt. Huawei hat beispielsweise eine neue allgemeine visuelle Architektur vorgeschlagen, die auf der Diagrammdarstellung basiert. Die Forscher haben das Eingabebild in viele kleine Blöcke unterteilt und entsprechende Knotendiagramme erstellt. Experimentelle Ergebnisse zeigen, dass Diagrammstrukturen im Vergleich zu Matrizen oder Gittern Objektkomponenten besser darstellen können Flexibilität, um optimalere Ergebnisse zu erzielen. # 🎜🎜#Quelle: Vision GNN@NeurIPS 2022 Intelligenter Transport: Das intelligente Transportmanagement ist ein heißes Thema in modernen Städten. Eine genaue Vorhersage der Verkehrsgeschwindigkeit, des Verkehrsaufkommens oder der Straßendichte in einem Verkehrsnetz ist für die Routenplanung und Verkehrsflusskontrolle von entscheidender Bedeutung. Aufgrund der hochgradig nichtlinearen und komplexen Natur des Verkehrsflusses ist es für herkömmliche Methoden des maschinellen Lernens schwierig, räumliche und zeitliche Abhängigkeiten gleichzeitig zu lernen. Die boomende Entwicklung von Online-Reiseplattformen und Logistikdiensten hat umfangreiche Datenszenarien für den intelligenten Transport bereitgestellt. Wie man mithilfe neuronaler Netze automatisch die räumlich-zeitliche Korrelation in Verkehrsdaten erlernen kann, um eine bessere Analyse und Verwaltung des Verkehrsflusses zu erreichen, ist zu einem heißen Forschungsthema geworden. Da der Stadtverkehr (wie in der folgenden Abbildung dargestellt) von Natur aus in Form unregelmäßiger Gitter vorliegt, ist es eine sehr natürliche Untersuchung, graphische neuronale Netze für ein intelligentes Verkehrsmanagement zu verwenden. # 🎜🎜#Quelle: Traffic4Cast@NeurIPS 2022 Das klassische räumlich-zeitliche Netzwerk STGCN verwendet beispielsweise GCN, um räumliche Merkmale für jede Verkehrsflusskarte zu jedem Zeitpunkt zu erfassen. Für jeden Knoten werden zeitliche Merkmale durch Faltung in der Zeitdimension erfasst um ein durchgängiges Lernen von Merkmalen in beiden räumlich-zeitlichen Dimensionen zu erreichen. Es gibt auch entsprechende Arbeiten, die Informationen aus mehreren Quellen verwenden, um Knotenassoziationsdiagramme aus verschiedenen Perspektiven zu erstellen und Informationen zu aggregieren, um genauere Vorhersageeffekte zu erzielen. Neben der Verkehrsvorhersage werden graphische neuronale Netze auch in vielen Aspekten eingesetzt, beispielsweise bei der Ampelsteuerung, der Erkennung von Verkehrsereignissen, der Vorhersage der Fahrzeugbahn und der Vorhersage von Verkehrsstaus. In den letzten Jahren haben relevante Wettbewerbe auf Top-Konferenzen wie KDD und NeurIPS auch entsprechende Fragen zur Verkehrsvorhersage aufgestellt, und die Gewinnerlösungen umfassen im Wesentlichen graphische neuronale Netze. Aufgrund der gleichzeitigen Existenz räumlich-zeitlicher Dynamik kann man ohne Übertreibung sagen, dass relevante Anwendungsanforderungen im Bereich des intelligenten Transportwesens der wichtigste Treiber für die Entwicklung räumlich-zeitlicher graphischer neuronaler Netze sind. Finanzielle Risikokontrolle: Mit der Entwicklung der Marktwirtschaft und dem Prozess der Digitalisierung der Industrie sind zwar viele traditionelle Unternehmen online migriert, aber auch verschiedene neue Online-Produkte und -Dienstleistungen nehmen täglich zu Tag für Tag mit einer enormen Menge an Daten und komplexen Zusammenhängen stellen Finanztransaktionen und damit verbundene Prüfungen vor große Herausforderungen. Das Bankkreditmanagement und das Risikomanagement börsennotierter Unternehmen spielen eine wichtige Rolle für die Aufrechterhaltung der Ordnung auf dem Finanzmarkt. Mit der Förderung neuer globaler Zahlungsmanagementsysteme wie Alipay und Paypal spielt das Zahlungsrisikokontrollsystem, das sie schützt, eine entscheidende Rolle beim Schutz der Sicherheit von Benutzergeldern, bei der Verhinderung von Kartendiebstahl und Kontodiebstahl sowie bei der Reduzierung von Plattformverlusten. Herkömmliche Algorithmen reichen jedoch nicht aus, um die Analyse von Graphnetzwerkdaten mit zugehörigen Informationen zu lösen. Dank der Fähigkeit des Graphneuronalen Netzwerks, Graphdaten zu verarbeiten, sind eine Reihe von Praktiken in verschiedenen Szenarien der Finanzrisikokontrolle entstanden. Zum Beispiel Risikobewertung vor und nach der Kreditvergabe während des Transaktionsprozesses, virtuelles Konto/Betrug/Betrugserkennung usw. Obwohl sich die Anwendung der Graph-Deep-Learning-Technologie im Bereich der Risikokontrolle als effektiv und notwendig erwiesen hat, ist die Entwicklungszeit kurz und der Gesamtprozess befindet sich noch im Anfangsstadium der Entwicklung Technologische Innovationen basieren immer noch auf den entsprechenden Unternehmen. Unter ihnen sind Ant Financial und Amazon die bekanntesten. Beispielsweise wird der von Ant Financial vorgeschlagene GeniePath-Algorithmus als binäres Klassifizierungsproblem für ein Konto definiert. Der erste von Ant Financial vorgeschlagene GEM-Algorithmus zur Verwendung der Diagrammfaltung zur Identifizierung bösartiger Konten wird hauptsächlich in Kontoanmelde-/Registrierungsszenarien verwendet. Der Datenschutz und die Vielfalt der Szenarien führen auch dazu, dass es in der Branche keine einheitlichen Standards für den Vergleich und die Überprüfung von Modellen gibt. Kürzlich haben Xinye Technology und die Zhejiang-Universität gemeinsam einen umfangreichen dynamischen Diagrammdatensatz DGraph veröffentlicht, der umfangreiche Daten eines realen Szenarios zur Überprüfung von Betrug und anderen Anomalieerkennungsszenarien bereitstellt. Die Knoten repräsentieren die von Xinye bedienten Finanzkreditbenutzer Die Technologie ist an den Rand gerichtet und stellt die Notfallkontaktbeziehung dar. Jeder Knoten enthält desensibilisierte Attributmerkmale und eine Kennzeichnung, die angibt, ob der Benutzer ein Finanzbetrugsbenutzer ist. Obwohl es Probleme wie Datenbarrieren gibt, haben das vorherrschende Datenungleichgewicht in Szenarien zur finanziellen Risikokontrolle, die Schwierigkeit bei der Erlangung von Bezeichnungen und die Forderung nach Modellinterpretierbarkeit auch neue Denkweisen und Möglichkeiten für die Entwicklung graphischer neuronaler Netze mit sich gebracht. Arzneimittelentwicklung: Die Arzneimittelentwicklung ist ein großes Projekt mit einem langen Zyklus, hohen Kosten und hohem Risiko, vom ersten Arzneimitteldesign und molekularen Screening bis hin zu späteren Sicherheitstests, klinischen Studien und der Erforschung neuer Arzneimittel und Entwicklung Der Zyklus dauert etwa 10–15 Jahre und die durchschnittlichen Forschungs- und Entwicklungskosten für jedes Medikament betragen fast 3 Milliarden US-Dollar. Während dieses Prozesses wird 1/3 der Zeit und der Kosten in der Phase der Medikamentenentwicklung aufgewendet. Insbesondere angesichts des Ausbruchs von Epidemien wie COVID-19 hat die Frage, wie Deep-Learning-Modelle effektiv eingesetzt werden können, um mögliche und vielfältige Kandidatenmoleküle schnell zu entdecken und den Entwicklungsprozess neuer Medikamente zu beschleunigen, das Nachdenken und die Beteiligung vieler Forscher geweckt. Molekulare Verbindungen, Proteine und andere Substanzen, die an der Arzneimittelforschung und -entwicklung beteiligt sind, existieren natürlicherweise in Graphenstrukturen. Am Beispiel von Molekülen könnten die Kanten des Diagramms Bindungen zwischen Atomen in einem Molekül oder Wechselwirkungen zwischen Aminosäureresten in einem Protein sein. Und in einem größeren Maßstab können Diagramme Wechselwirkungen zwischen komplexeren Strukturen wie Proteinen, mRNA oder Metaboliten darstellen. In einem Zellnetzwerk können Knoten Zellen, Tumoren und Lymphozyten darstellen und Kanten die räumliche Nähe zwischen ihnen darstellen. Daher haben graphische neuronale Netze breite Anwendungsaussichten in der Vorhersage molekularer Eigenschaften, beim Hochdurchsatz-Screening, beim Design neuer Arzneimittel, beim Protein-Engineering und bei der Wiederverwendung von Arzneimitteln. Beispielsweise veröffentlichten Forscher des MIT CSIAL und ihre Mitarbeiter in Cell (2020) eine Arbeit, in der sie graphische neuronale Netze nutzten, um vorherzusagen, ob Moleküle antibiotische Eigenschaften haben. In diesem Jahr schlugen Mitglieder derselben Gruppe eine Reihe von Arbeiten vor, beispielsweise den Aufbau eines auf Antigenen basierenden bedingten Generierungsmodells, das auf Graphgenerierungsmethoden basiert, um Antikörper zu entwerfen, die in hohem Maße mit spezifischen Antigenen übereinstimmen. Mila Labs ist auch ein Pionier bei der Anwendung von Graph-Learning in der Arzneimittelforschung und hat kürzlich die auf PyTorch basierende maschinelle Lernplattform TorchDrug für die Arzneimittelforschung als Open-Source-Lösung auf der Grundlage entsprechender Untersuchungen bereitgestellt. Darüber hinaus haben große Technologieunternehmen in den letzten Jahren auch Pläne und Erkundungen im Bereich KI-Arzneimittel gemacht und entsprechende herausragende Ergebnisse erzielt. Die „Yunshen“-Plattform von Tencent AI Lab hat das branchenweit erste groß angelegte Out-of-Distribution-Forschungsrahmenwerk für Arzneimittel-KI veröffentlicht , DrugOOD, zur Förderung der Forschung zum Verteilungsverschiebungsproblem in pharmazeutisch-chemischen Szenarien, um die Entwicklung der Arzneimittelforschungs- und -entwicklungsbranche zu unterstützen. Baidu Biotechnology wurde vom Baidu-Gründer Robin Li gegründet und hat es sich zum Ziel gesetzt, fortschrittliche KI-Technologie mit modernster Biotechnologie zu kombinieren, um einzigartige Zielforschungs- und Arzneimitteldesigns zu schaffen. Chip Design: Chip ist die Seele des digitalen Zeitalters und eines der drei Elemente der Informationsindustrie. Graphenstrukturierte Daten durchlaufen mehrere Phasen des Chip-Designs. In der Phase der Logiksynthese werden digitale Schaltkreise beispielsweise durch NAND-Graphen dargestellt Vervollständigen Sie das Layout und Routing des Chips gemäß bestimmten Anforderungen an Dichte und Überlastungsgrenzen. # 🎜🎜# Da der Umfang und die Komplexität von Schaltkreisen weiter zunehmen, ist die Designeffizienz und -genauigkeit von EDA-Tools (Electronic Design Automation) zu einem entscheidenden Thema geworden, was Forscher dazu veranlasst hat, Deep-Learning-Technologie zur Unterstützung des Schaltkreisdesignprozesses einzusetzen. Wenn die Qualität und Benutzerfreundlichkeit der Schaltung bereits in den frühen Phasen des Chip-Designs vorhergesagt werden kann, kann die Effizienz von Chip-Iterationen verbessert und die Designkosten gesenkt werden. Beispielsweise kann die Vorhersage der Überlastung eines Schaltkreises in der Phase des physischen Entwurfs dazu beitragen, dessen Defekte zu erkennen und die Produktion fehlerhafter Chips zu vermeiden. Wenn solche Vorhersagen in der Phase der Logiksynthese getroffen werden können, kann der Entwurfs- und Produktionszyklus des Chips weiter eingespart werden. Die Teams von Google und der Stanford University setzten GNN erfolgreich im Hardware-Design ein, kombiniert mit verstärkendem Lernen, beispielsweise zur Optimierung des Stromverbrauchs, der Fläche und der Leistung von Google-TPU-Chipblöcken. Angesichts der verschiedenen heterogenen Informationen in der Chip-Netzlistendarstellung kann der von Huawei und der Peking-Universität vorgeschlagene Circuit GNN die Karte durch Integration topologischer und geometrischer Informationen zusammenstellen, um die Leistung verschiedener EDA-Aufgaben für die Vorhersage von Zell- und Netzattributen zu verbessern. #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#außer auf Zusätzlich zu mehreren Bereichen wurden graphische neuronale Netze auch erforscht und auf viele andere Probleme angewendet, wie z. B. Programmverifizierung, Vorhersage sozialer Auswirkungen, Gehirnnetzwerke, Ereigniserkennung, Modellsimulation und Problemlösung durch kombinatorische Optimierung. Es ist ersichtlich, dass Daten in vielen Bereichen der Wissenschaft und des Lebens als Diagrammstruktur dargestellt werden können. Durch die effektive Erfassung von Strukturinformationen und Diagrammattributinformationen haben grafische neuronale Netze eine hohe Genauigkeit bei verschiedenen Diagrammaufgaben erreicht und sind zu einem wirksamen Mittel zur Lösung von Diagrammproblemen geworden eines graphischen neuronalen Netzwerks. Im vorherigen Inhalt haben wir einige grundlegende Paradigmen von graphischen Modellen und entsprechenden Anwendungsszenarien vorgestellt. Wir können sehen, dass graphische neuronale Netzwerke als neue Deep-Learning-Architektur große Anwendungsmöglichkeiten in sozialen Netzwerken haben. , Empfehlungssysteme, biomedizinische Entdeckungen und andere Bereiche erstrahlen in strahlendem Glanz. In tatsächlichen Anwendungen stehen die Skalierbarkeit und Benutzerfreundlichkeit von Diagrammmodellen jedoch immer noch vor vielen theoretischen und technischen Herausforderungen. Das erste sind Speicherbeschränkungen. Zu Beginn des Entwurfs wurde die Faltungsoperation von GCN für das gesamte Diagramm ausgeführt, dh die Faltungsoperation jeder Schicht durchläuft das gesamte Diagramm. In praktischen Anwendungen sind der erforderliche Speicher- und Zeitaufwand inakzeptabel. Darüber hinaus kann im herkömmlichen Framework für maschinelles Lernen die Verlustfunktion des Modells in die Summe der Verluste einzelner Stichproben zerlegt werden, sodass Mini-Batch- und stochastische Optimierung zur Verarbeitung von Trainingssätzen verwendet werden können, die viel größer als der GPU-Speicher sind. Beim Training von GNN führt die relationale Struktur von Netzwerkdaten jedoch im Gegensatz zu Standarddatensätzen für maschinelles Lernen, bei denen die Stichproben unabhängig sind, zu statistischen Abhängigkeiten zwischen den Stichproben. Die direkte Durchführung eines Mini-Batch-Trainings durch Zufallsstichproben führt oft zu einem stark reduzierten Modelleffekt. Es ist jedoch nicht einfach sicherzustellen, dass der Untergraph die Semantik des gesamten Graphen beibehält und zuverlässige Gradienten für das Training von GNN bereitstellt. Der zweite Grund sind Hardwareeinschränkungen. Im Vergleich zu Bilddaten und Textdaten handelt es sich bei Diagrammen im Wesentlichen um eine spärliche Struktur, sodass ihre Spärlichkeit für effiziente und skalierbare Berechnungen genutzt werden muss. Das aktuelle Design entsprechender Deep-Learning-Prozessoren und zugehöriger Hardware ist jedoch auf die Verarbeitung intensiver Operationen ausgerichtet. In diesem Abschnitt fassen wir hauptsächlich die Skalierbarkeit des Diagrammmodells zusammen. Unter Bezugnahme auf die Zusammenfassung von Chaitanya K. Joshi, einem Doktoranden an der Universität Cambridge, können verwandte Arbeiten in vier Aspekte zusammengefasst werden: Datenvorverarbeitung, effiziente Modellarchitektur, neue Lernparadigmen und Hardwarebeschleunigung (wie in der folgenden Abbildung dargestellt). . Die Datenvorverarbeitung implementiert im Allgemeinen die Berechnung umfangreicher Diagrammdaten durch Abtasten oder Vereinfachen der Originaldaten (wir werden dies weiter unten näher erläutern). Die neue Architektur schlägt einige neue, effizientere und prägnantere Architekturen aus der Perspektive einiger spezifischer Aufgaben oder Daten vor. LightGCN eliminiert beispielsweise den inneren Produktteil zwischen benachbarten Knoten, um die Laufgeschwindigkeit zu beschleunigen. Einige Arbeiten haben auch herausgefunden, dass die Verwendung von Label-Propagation-Methoden nach der Ausführung von MLP auf Knoten-Features ebenfalls gute Ergebnisse erzielen kann. Darüber hinaus können wir die Leistung von GNN verbessern und die Latenz durch einige leichtgewichtige Lernparadigmen wie Wissensdestillation oder quantisierungsbewusstes Training reduzieren. Zu erwähnen ist, dass die oben genannten Methoden zur Beschleunigung des Trainings graphischer neuronaler Netze voneinander entkoppelt sind, was bedeutet, dass in tatsächlichen Szenarien mehrere Methoden gleichzeitig verwendet werden können. Quelle: G-CRD@TNLS Im Vergleich zur Modelloptimierung und neuen Lernparadigmen ist die Datenvorverarbeitung eine allgemeinere und anwendbarere Methode, was derzeit auch relativ gesehen ist. Wir werden die Analyse und Einführung hier etwas erweitern. Im Allgemeinen reduzieren Datenvorverarbeitungsmethoden die Größe des Originalbilds durch einige Stichproben oder eine Diagrammvereinfachung, um Speicherbeschränkungen zu erfüllen. Sampling-basierte Methoden können in drei Unterkategorien unterteilt werden: Node-Wise Sampling, Layer-Sampling und Graph-Wise Sampling. Node-Wise Sampling: wurde zuerst von GraphSage vorgeschlagen und ist eine relativ häufige, effektive und am weitesten verbreitete Methode. Eine Schicht von GraphSAGE aggregiert Informationen von 1-Hop-Nachbarn. Durch Überlagern von k Schichten von GraphSAGE kann das durch K-Hop-Nachbarn induzierte Empfangsfeld erhöht werden. Gleichzeitig werden die Nachbarn gleichmäßig abgetastet, wodurch die Geschwindigkeit gesteuert werden kann Aggregationsvorgang und reduzieren die Anzahl der Nachbarn, was weniger Berechnungen bedeutet. Es ist jedoch zu beachten, dass mit zunehmender Anzahl von Schichten auch die Anzahl der abgetasteten Nachbarn exponentiell zunimmt. Am Ende entspricht dies immer noch der durch K-Hop-Nachbarn induzierten Nachrichtenaggregation, und die Zeitkomplexität ist höher nicht wesentlich verbessern. Lag -Wise Sampling: wurde zuerst von Fast GCN vorgeschlagen. Im Gegensatz zu GraphSAGE wird der Nachbar-Sampling-Bereich direkt begrenzt und die Wichtigkeits-Sampling-Probenahme aus allen Knoten verwendet Jeder Stichprobenknoten von GraphSAGE ist unabhängig, während alle Stichprobenknoten von Fast GCN denselben Nachbarsatz verwenden, sodass die Rechenkomplexität direkt auf der linearen Ebene gesteuert werden kann, dies muss jedoch beim Diagramm beachtet werden Die von uns verarbeiteten Daten sind groß und spärlich. Die mit dieser Methode erfassten Proben aus benachbarten Schichten sind möglicherweise überhaupt nicht miteinander verknüpft, was zu Lernunfähigkeit führt. Grafische Abtastung: mit Die Nachbar-Sampling-Methoden sind unterschiedlich. Die Graph-Sampling-Technik besteht darin, Teilgraphen aus dem Originalbild abzutasten. Cluster-GCN verwendet beispielsweise die Idee des Clusterings, um den Graphen für das Training in kleine Blöcke zu unterteilen. Graph-Clustering-Algorithmen (wie METIS) gruppieren ähnliche Knoten, was dazu führt, dass die Knotenverteilung innerhalb einer Klasse von der Knotenverteilung im ursprünglichen Diagramm abweicht. Um die durch Diagrammstichproben verursachten Probleme zu lösen, extrahiert Cluster GCN gleichzeitig mehrere Kategorien als Stapel, um am Training zum Ausgleich der Knotenverteilung teilzunehmen. Der Informationsverlust der strukturbasierten Abtastmethode ist jedoch relativ groß, und die meisten Datenergebnisse sind größer als die des Vollstapel-GNN. Jede Epoche muss abgetastet werden, und der Zeitaufwand ist nicht gering. Zusätzlich zum Sampling ist es auch eine mögliche Richtung, die Größe des Originalbilds durch einige Methoden zur Diagrammreduzierung zu reduzieren und gleichzeitig wichtige Attribute für die anschließende Verarbeitung und Analyse beizubehalten. Die Vereinfachung von Diagrammen umfasst hauptsächlich die Sparsifizierung des Diagramms: Reduzieren der Anzahl der Kanten im Diagramm und die Vergröberung des Diagramms: Reduzieren der Anzahl der Scheitelpunkte im Diagramm. Die Vergröberung des Diagramms erfolgt durch „Einklemmpunkte“. Es ist geeignet Framework zum Zusammenfassen einiger Untergraphen in einem Superknoten, um eine Vereinfachung der ursprünglichen Diagrammskala zu erreichen. Der Algorithmus zur Verwendung der Graphvergröberung für das GNN-beschleunigte Training wurde erstmals in der Arbeit von KDD 2021 vorgeschlagen. Der Prozess ist in der folgenden Abbildung dargestellt: #🎜🎜 # Verwenden Sie zunächst einen Graphvergröberungsalgorithmus (z. B. spektrale Clustering-Vergröberung), um den ursprünglichen Graphen zu vergröbern, und führen Sie ein Modelltraining für den vergröberten Graphen G′ durch, um die für neuronale Parameter erforderlichen Diagramme zu erhalten Das Netzwerktraining sowie die Trainingszeit und der laufende Speicheraufwand werden reduziert. Die Methode ist allgemein einfach und verfügt über lineare Trainingszeit und -raum. Die theoretische Analyse des Autors zeigt auch, dass das APPNP-Training auf einem durch Spektralclusterung vergröberten Diagramm einem eingeschränkten APPNP-Training auf dem Originaldiagramm entspricht. Wie die Graph-Sampling-Methode erfordert jedoch auch die auf der Graph-Vergröberung basierende Methode eine Datenvorverarbeitung, und der Zeitaufwand hängt von den experimentellen Ergebnissen und der Wahl des Vergröberungsalgorithmus ab. In ähnlicher Weise sind auch die oben vorgestellten verschiedenen Methoden zur Erweiterung von Diagrammmodellen, die auf Stichproben oder Vereinfachungen basieren, voneinander entkoppelt, was bedeutet, dass mehrere Methoden gleichzeitig zusammen verwendet werden können, wie z. B. Cluster GCN + GraphSAGE. Im Wesentlichen ist das Aggregieren von Nachrichten in einem durch K-Hop-Nachbarn induzierten Vorgang eine exponentielle Operation. Es ist schwierig, die zeitliche Komplexität des Algorithmus basierend auf der Knotenabtastung auf linearer Ebene zu steuern, ohne dass dabei Informationen verloren gehen ist eine gute Lösung, denn wenn das gesamte Bild zur Berechnung in den Speicher gestellt werden kann, ist die zeitliche Komplexität von GCN linear, die Kosten der Vorverarbeitung können jedoch nicht ignoriert werden. Es gibt kein kostenloses Mittagessen auf der Welt. Die Trainingsbeschleunigung von graphischen neuronalen Netzwerken erfordert immer noch einen Kompromiss zwischen Informationsverlust und Vorverarbeitungsaufwand. Für die Analyse müssen je nach tatsächlicher Situation unterschiedliche Methoden verwendet werden. Darüber hinaus ist das Diagramm im Wesentlichen ein spärliches Objekt. Wenn es um Designeffizienz und Skalierbarkeit geht, sollten wir daher mehr aus der Perspektive der Datensparsität denken. Dies ist jedoch leichter gesagt als getan, da moderne GPUs für die Bewältigung intensiver Operationen auf Matrizen ausgelegt sind. Obwohl maßgeschneiderte Hardwarebeschleuniger für spärliche Matrizen die Aktualität und Skalierbarkeit von GNNs erheblich verbessern können, befinden sich entsprechende Arbeiten noch in einem frühen Entwicklungsstadium. Darüber hinaus ist auch die Gestaltung von Kommunikationsstrategien für das Graph Computing eine Richtung, die in letzter Zeit große Aufmerksamkeit erregt hat. Beispielsweise wurden die Auszeichnungen „Best Research Paper“ und „Best Student Paper“ von VLDB2022 und Webconf 2022 an Systeme oder Algorithmen vergeben, die die Verarbeitung von Graphmodellen beschleunigen. Unter anderem schlug SANCUS@VLDB2022 eine Reihe verteilter Trainingsrahmen (SANCUS) vor, mit dem Ziel, das Kommunikationsvolumen zu reduzieren und einen dezentralen Mechanismus zu verwenden, um das verteilte Training graphischer neuronaler Netze zu beschleunigen. Der Artikel beweist nicht nur theoretisch, dass die Konvergenzgeschwindigkeit von SANCUS nahe an der des Volldiagrammtrainings liegt, sondern überprüft auch die Trainingseffizienz und -genauigkeit von SANCUS durch Experimente an einer großen Anzahl realer Szenendiagramme. Die Arbeit von PASCA@Webconf2022 versucht, den Nachrichtenaggregationsvorgang und den Aktualisierungsvorgang im Message-Passing-Framework zu trennen und definiert ein neues Paradigma der Vorverarbeitung, des Trainings und der Nachverarbeitung, um einen Kommunikationsaufwand in verteilten Szenarien zu erzielen. Source: pasca@webconf2022

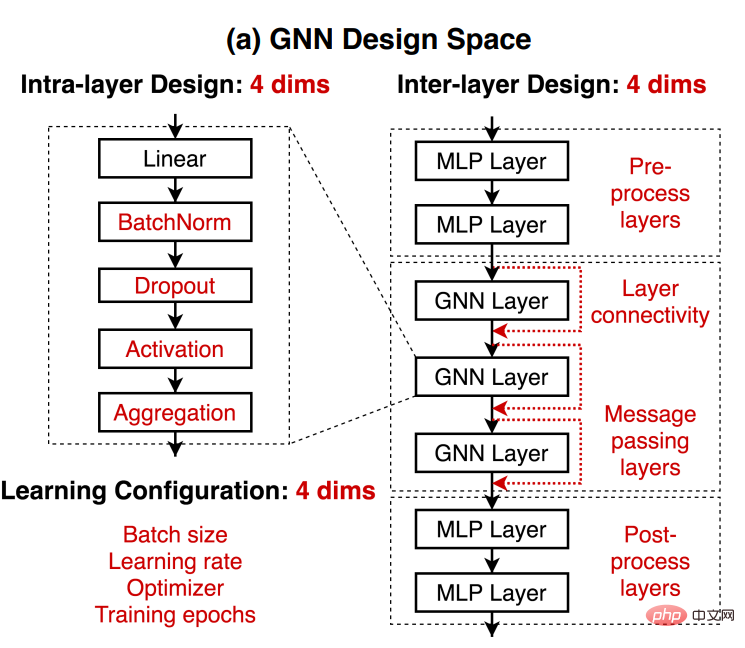

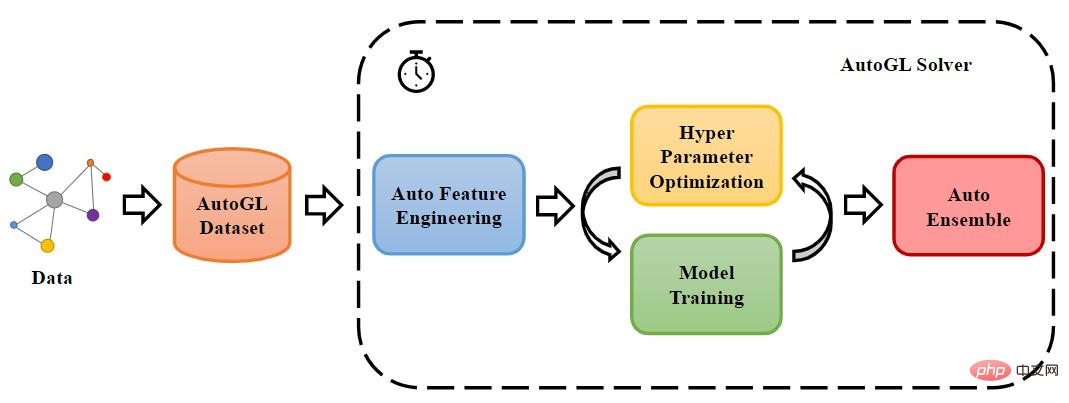

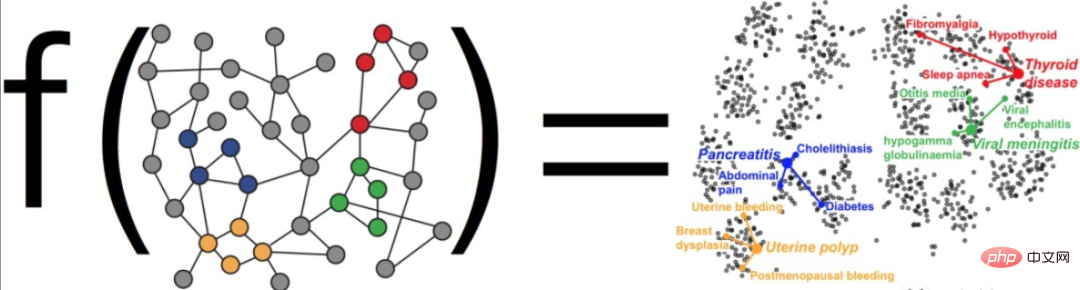

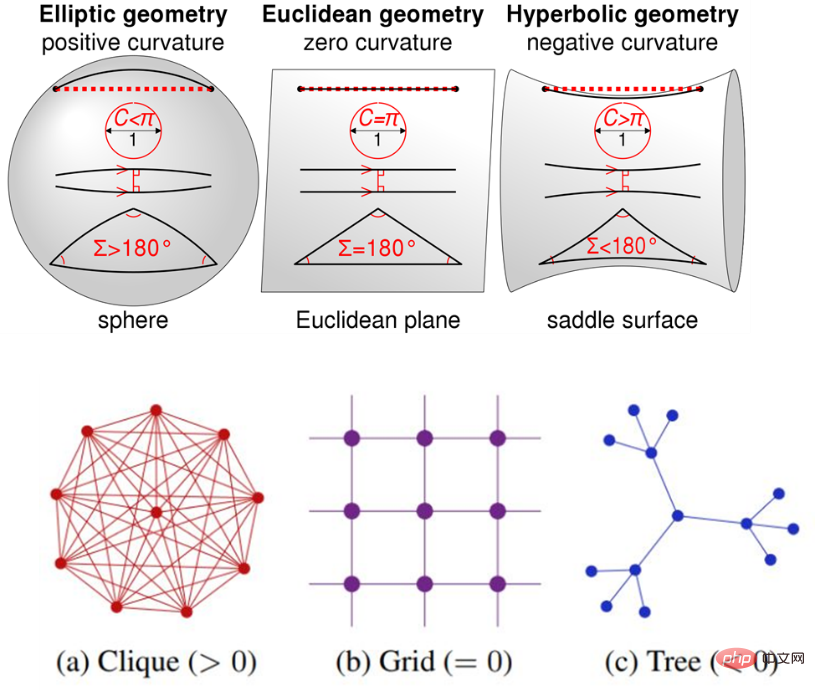

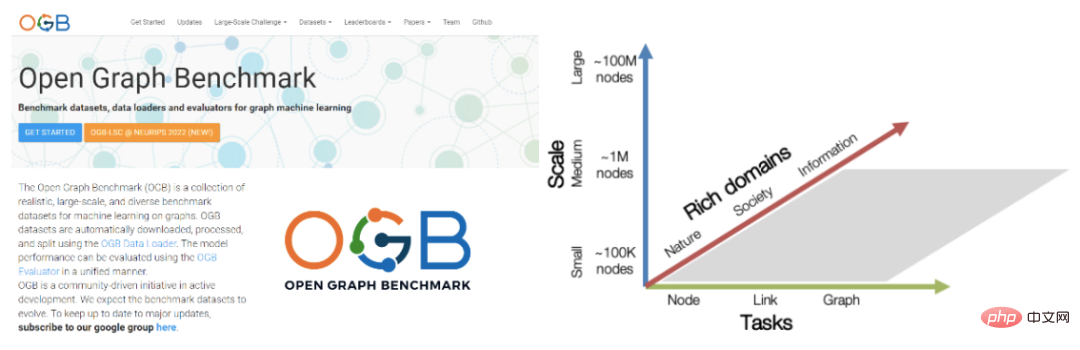

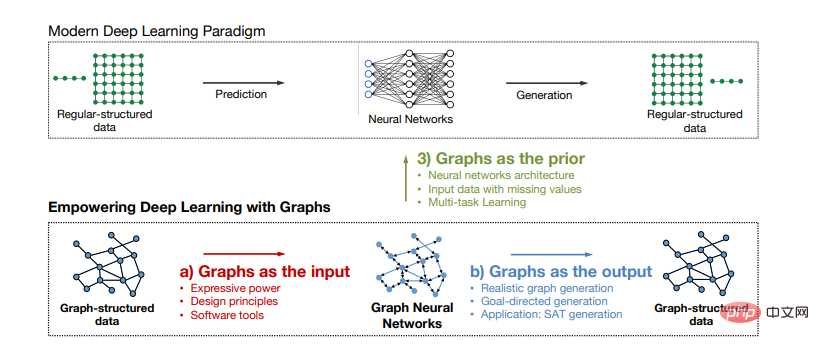

(1) In-Layer-Design: das Design einer einzelnen GNN-Schicht. (2) Zwischenschichtdesign: So verbinden Sie GNN-Schichten. (3) Lernkonfiguration: So legen Sie Parameter für maschinelles Lernen fest. Konstruieren Sie den entsprechenden GNN-Entwurfsraum in drei Richtungen. Indem Sie dann die Modelle in eine Rangfolge bringen, um ihre Leistungsunterschiede bei bestimmten Aufgaben zu quantifizieren, können Sie den optimalen Modellentwurf unter gegebenen Daten verstehen. Darüber hinaus können wir für neue Aufgaben und Daten auch schnell die ähnlichsten Aufgaben identifizieren, indem wir einfach die Ähnlichkeit zwischen dem neuen Datensatz und der vorhandenen Sammlung im Aufgabenbereich berechnen und das beste Modell auf die neuen Daten migrieren Satz. Auf diese Weise kann schnell ein besseres Modell für Datensätze erhalten werden, die noch nie zuvor verwendet wurden. Natürlich sind automatisches maschinelles Lernen auf Graphen und die Übertragbarkeit von Graphmodellen sehr wichtige Themen in der akademischen Forschung und in industriellen Anwendungen. Ich werde hier nicht näher darauf eingehen Für weitere Arbeiten zum automatischen maschinellen Lernen in Diagrammen empfehle ich Ihnen, die entsprechende Rezension der akademischen Gruppe des Lehrers Zhu Wenwu der Tsinghua-Universität und ihres Open-Source-Toolkits für automatisches Lernen AutoGL sowie die damit verbundene Arbeit des vierten Paradigmas zu beachten die Branche. Quelle: AutoGL Der oben erwähnte Modelldesignraum konzentriert sich hauptsächlich auf die Modellstrukturebene, aber es gibt noch eine weitere sehr wichtige Dimension, nämlich den Darstellungs- oder Lernraum des Modells. was auch sehr nützlich ist. Das maschinelle Lernen von Graphen ist ein Mittel zum Repräsentationslernen von Graphdaten. Das Ziel besteht nicht darin, ein Beobachtungsergebnis durch Lernen der Originaldaten vorherzusagen, sondern die zugrunde liegende Struktur der Daten zu lernen, damit das entsprechende Merkmalslernen der Originaldaten erfolgen kann bessere Leistung und Ausdruck, um bessere Ergebnisse bei nachgelagerten Aufgaben zu erzielen. Das meiste aktuelle Repräsentationslernen wird im euklidischen Raum durchgeführt, da der euklidische Raum eine natürliche Verallgemeinerung unseres intuitionsfreundlichen visuellen Raums ist und gleichzeitig rechenfreundlich ist und Rechenvorteile bietet. Aber wie wir alle wissen, haben Graphen nichteuklidische Strukturen. Untersuchungen im Bereich komplexer Netzwerke zeigen beispielsweise, dass es in realen Netzwerkdaten (soziale Netzwerke, Warennetzwerke, Telekommunikationsnetzwerke, Krankheiten) eine große Anzahl skalenfreier Eigenschaften gibt Netzwerke, semantische Netzwerke usw.) (skalenfrei), was bedeutet, dass baumartige/hierarchische Strukturen in der Realität allgegenwärtig sind. Die Verwendung des euklidischen Raums als Vorraum für das Repräsentationslernen zur Durchführung einer entsprechenden Modellierung führt unweigerlich zu entsprechenden Fehlern (Verzerrungen). Daher hat das auf verschiedenen Krümmungsräumen basierende Repräsentationslernen in letzter Zeit die Aufmerksamkeit aller auf sich gezogen. Die Krümmung ist ein Maß für die Krümmung des Raumes. Je näher die Krümmung bei Null liegt, desto flacher ist der Raum. Im Science-Fiction-Roman „Das Drei-Körper-Problem“ nutzen Menschen die Veränderungen der Raumkrümmung, um ein Raumschiff mit Krümmung zu bauen. Wie in der folgenden Abbildung dargestellt, ist der euklidische Raum überall gleichmäßig und flach und weist Isotropie und Translationsinvarianz auf, sodass er für die Modellierung von Gitterdaten geeignet ist. Das sphärische räumliche Abstandsmaß mit positiver Krümmung entspricht dem Winkelmaß und weist Rotationsinvarianz auf, sodass es für die Modellierung von Ringdaten oder dichten und gleichmäßigen Diagrammdatenstrukturen geeignet ist. Die hyperbolische Raumdistanzmetrik mit negativer Krümmung entspricht einer Potenzgesetzverteilung und eignet sich zur Modellierung skalenfreier Netzwerke oder Baumstrukturen. Aufgrund der Skalenfreiheit (Skalenfreiheit), die in einer großen Menge realer Netzwerkdaten vorhanden ist, bedeutet dies, dass baumartige/hierarchische Strukturen in der Realität allgegenwärtig sind . Unter ihnen gilt der hyperbolische Raum als kontinuierlicher Ausdruck der Baum-/Hierarchiestruktur im Bereich der traditionellen Netzwerkwissenschaft. Daher sind in letzter Zeit viele hervorragende Arbeiten entstanden. Darüber hinaus nimmt das Volumen des hyperbolischen Raums im Vergleich zum euklidischen Raum exponentiell mit dem Radius zu, sodass er einen größeren eingebetteten Raum aufweist. Im Gegensatz zum euklidischen Raum gibt es im hyperbolischen Raum mehrere Modelle, die wir am Beispiel von Poincaré Ball kurz vorstellen können. Die Poincaré-Scheibe ist ein hyperbolisches Modell, indem sie den Einbettungsraum auf eine Einheitskugel begrenzt. Im hyperbolischen Modell der Poincaré-Kugel sind alle hellen und dunklen Dreiecke oben gleich groß, aber aus unserer euklidischen Perspektive sind die Dreiecke in Randnähe relativ klein. Anders ausgedrückt: Wenn wir es aus europäischer Sicht betrachten und den Mittelpunkt des Kreises oben als Ursprung nehmen, wird die Anzahl der Dreiecke mit zunehmendem Radius immer größer. Wir können uns das vorstellen Das Modellieren mit hyperbolischen Räumen ist wie das „Aufblasen eines Ballons“. Angenommen, ein entleerter Ballon hätte eine Milliarde Knoten auf seiner Oberfläche. Dies wäre ein sehr dichter Zustand. Wenn sich der Ballon allmählich aufbläst und größer wird, wird die Oberfläche des Ballons immer mehr „gekrümmt“ und die Knoten geraten immer weiter auseinander. Das technische Team von Alimama wandte Curvature Space (Curvlearn) auf Taobao-basierte Suchmaschinenwerbungsszenarien an. Nach der vollständigen Einführung des Systems wurde der Speicherverbrauch um 80 % reduziert und die Genauigkeit der benutzerseitigen Anfragezuordnung um 15 % erhöht. Zusätzlich zu Empfehlungssystemen hat das hyperbolische Graphenmodell in einer Vielzahl unterschiedlicher Szenarien hervorragende Ergebnisse gezeigt. Studierende, die sich für verwandte Inhalte interessieren, können dieses Jahr auch auf unsere entsprechenden Tutorials zum Erlernen der Darstellung hyperbolischer Graphen auf ECML-PKDD zurückgreifen (Homepage-Portal: https://hyperbolicgraphlearning.github.io/ ) oder Tutorials zu hyperbolischen neuronalen Netzen auf der WebConf von Wissenschaftlern wie Virginia Tech und Amazon. 6. Graph-Neuronales Netzwerk-Trainingssystem, Framework, Benchmark-Plattform Der Graph-Neuronale-Netzwerk-Algorithmus kombiniert die Operationen tiefer neuronaler Netzwerke (wie Faltung, Gradientenberechnung) mit iterativer Graph-Ausbreitung: Jeder Scheitelpunkt wird berechnet aus den Merkmalen seiner Nachbarscheitelpunkte kombiniert mit einer Reihe tiefer neuronaler Netze. Bestehende Deep-Learning-Frameworks können jedoch keine Graphausbreitungsmodelle erweitern und ausführen und sind daher nicht in der Lage, graphische neuronale Netze effizient zu trainieren. Darüber hinaus ist der Umfang der Diagrammdaten in der realen Welt riesig und es bestehen komplexe Abhängigkeiten zwischen den Eckpunkten. Beispielsweise enthält der Graph des sozialen Netzwerks mehr als 2 Milliarden Eckpunkte und 1 Billion Kanten. Ein Diagramm dieser Größe kann 100 TB erzeugen Im Gegensatz zu herkömmlichen Diagrammalgorithmen hängt die Partitionierung von ausgewogenen Diagrammen nicht nur von der Anzahl der Scheitelpunkte innerhalb der Partition ab, sondern auch von der Anzahl der Nachbarn verschiedener Scheitelpunkte in einer Partition Die Unterschiede im neuronalen Netzwerkmodell mit mehreren Ebenen sind enorm und es ist ein häufiger Datenaustausch zwischen diesen Partitionen erforderlich. Die sinnvolle Partitionierung von Diagrammdaten stellt eine große Herausforderung für verteilte Systeme dar. Darüber hinaus sind die Diagrammdaten sehr spärlich, was bei der verteilten Verarbeitung zu häufigen knotenübergreifenden Zugriffen führt, was zu einem hohen Overhead bei der Nachrichtenübermittlung führt. Daher ist die Reduzierung des Systemaufwands basierend auf den besonderen Eigenschaften von Diagrammen eine große Herausforderung zur Verbesserung der Systemleistung. Wenn ein Arbeiter seine Arbeit gut machen will, muss er zuerst seine Werkzeuge schärfen. Um die Anwendung graphischer neuronaler Netze auf groß angelegte Graphen und die Erforschung komplexerer graphischer neuronaler Netzstrukturen zu unterstützen, ist es notwendig, ein Trainingssystem für graphische neuronale Netze zu entwickeln. Als erstes sind die beiden bekanntesten Open-Source-Frameworks PyG (PyTorch Geometric) und DGL (Deep Graph Library) zu nennen. Ersteres ist eine PyTorch-basierte Bibliothek für graphische neuronale Netzwerke, die gemeinsam von der Stanford University und der TU Dortmund entwickelt wurde Enthält viele GNNs und häufig verwendete Datensätze sowie einfache und benutzerfreundliche Schnittstellen. Letzteres ist ein gemeinsam von der New York University und dem Amazon Research Institute entwickeltes Framework Open-Source-Framework in akademischen und industriellen Kreisen. Beide werden von der Community aktiv unterstützt. Darüber hinaus haben viele Unternehmen auch ihre eigenen graphischen neuronalen Netzwerk-Frameworks und Datenbanken basierend auf ihren eigenen Geschäftsmerkmalen erstellt, wie zum Beispiel: NeuGraph, EnGN, PSGraph, AliGraph, Roc, AGL, PGL, Galileo , TuGraph, Winkeldiagramm usw. Unter ihnen ist AliGraph eine graphische neuronale Netzwerkplattform, die Stichprobenmodellierung und Training integriert und von der Alibaba Computing Platform und dem DAMO Academy Intelligent Computing Laboratory entwickelt wurde. PGL (Paddle Graph Learning) ist ein entsprechendes Graph-Learning-Framework, das auf PaddlePaddle basiert und von Baidu entwickelt wurde. Angle Graph ist eine groß angelegte Hochleistungs-Graph-Computing-Plattform, die von der Tencent TEG-Datenplattform eingeführt wurde. Lassen Sie uns noch einmal über die Benchmark-Plattform sprechen. In den Kernforschungs- oder Anwendungsbereichen des Deep Machine Learning helfen Benchmark-Datensätze und Plattformen dabei, zu identifizieren und zu quantifizieren, welche Arten von Architekturen, Prinzipien oder Mechanismen universell sind und auf reale Aufgaben und große Datensätze verallgemeinert werden können. Die jüngste Revolution bei neuronalen Netzwerkmodellen wurde beispielsweise durch den groß angelegten Benchmark-Bilddatensatz ImageNet ausgelöst. Im Vergleich zu Raster- oder Sequenzdaten befindet sich die Entwicklung von Diagrammdatenmodellen noch in einem relativ freien Wachstumsstadium. Erstens sind Datensätze oft zu klein, um reale Szenarien abzubilden, was bedeutet, dass es schwierig ist, Algorithmen zuverlässig und genau zu bewerten. Zweitens sind die Schemata zur Bewertung von Algorithmen nicht einheitlich. Grundsätzlich verwendet jede Forschungsarbeit ihre eigene Datenpartitionierungsmethode „Trainingssatz/Testsatz“ und Leistungsbewertungsindikatoren. Dies bedeutet, dass es schwierig ist, Leistungsvergleiche zwischen Papieren und Architekturen durchzuführen. Darüber hinaus verwenden verschiedene Forscher bei der Partitionierung von Datensätzen häufig traditionelle Zufallspartitionierungsmethoden. Um das Problem inkonsistenter Daten- und Aufgabendatenaufteilungsmethoden und Bewertungsschemata in der Graph-Lerngemeinschaft zu lösen, startete das Jure-Leskovec-Team der Stanford University im Jahr 2020 den Open Graph Benchmark (OGB), eine grundlegende Arbeit für die Benchmark-Plattform für graphische neuronale Netze . OGB enthält einige gebrauchsfertige Datensätze für wichtige Aufgaben in Diagrammen (Knotenklassifizierung, Linkvorhersage, Diagrammklassifizierung usw.) sowie eine gemeinsame Codebibliothek und Leistungsbewertung. Der Implementierungscode des Indikators ermöglicht eine schnelle Modellbewertung und einen schnellen Modellvergleich. Darüber hinaus verfügt OGB auch über eine Rangliste für die Modellleistung (Bestenliste), die es jedem ermöglichen kann, den entsprechenden Forschungsfortschritt schnell zu verfolgen. Darüber hinaus veranstaltete OGB im Jahr 2021 gemeinsam mit KDD CUP den ersten OGB-LSC-Wettbewerb (OGB Large-Scale Challenge), bei dem extrem große Diagrammdaten aus der realen Welt bereitgestellt wurden, um die Knotenklassifizierung, Kantenvorhersage und das Diagrammlernen in der Welt zu vervollständigen Zurück zu den drei Hauptaufgaben: Es hat die Beteiligung vieler Top-Universitäten und Technologieunternehmen angezogen, darunter Microsoft, Deepmind, Facebook, Alibaba, Baidu, ByteDance, Stanford, MIT, Peking University usw. In diesem Jahr wurden im NeurIPS2022-Wettbewerb, basierend auf den Erfahrungen des KDD Cups, die entsprechenden Datensätze aktualisiert und der zweite OGB-LSC-Wettbewerb organisiert Eine gute Möglichkeit, sich schnell mit einem Fachgebiet vertraut zu machen. Es handelt sich um die Doktorarbeit eines Studenten, der gerade das Leseniveau-Labor abgeschlossen hat. Rex YING und You Jiaxuan vom SNAP-Labor müssen mit der Durchführung von Forschungen im Zusammenhang mit dem Graphenlernen begonnen haben Unter der Leitung von Jure Leskovec in den Jahren 2016 und 2017 wurden viele Errungenschaften zu Meilensteinen in der Entwicklung des Graphenlernens und wurden in ihren jeweiligen Doktorarbeiten „Towards Expressive and Scalable Deep Representation Learning for Graphs“ und „Empowering Deep Learning with Graphs“ zusammengefasst ") . 7. Zusammenfassung und Ausblick Nach mehr als zehn Jahren der Entwicklung und jüngsten industriellen Anwendungen in verschiedenen Branchen und der kontinuierlichen Iteration der Theorie im Labor haben sich graphische neuronale Netze als die beste Wahl erwiesen für graphstrukturierte Daten in Theorie und Praxis. Eine effektive Methode und ein Rahmenwerk für die Verarbeitung. Als universelle, prägnante und leistungsstarke Datenstruktur können Diagramme nicht nur als Ein- und Ausgabe von Diagrammmodellen zur Gewinnung und zum Lernen nichteuklidischer strukturierter Daten verwendet werden, sondern können auch als A-priori-Struktur zur Modellierung europäischer Daten (Text und Daten) verwendet werden Bilder). In der Anwendung. Langfristig glauben wir, dass sich Graphendaten und neuronale Netze von einem aufstrebenden Forschungsfeld in ein Standardparadigma für Daten und Modelle für Forschung und Anwendungen im Bereich maschinelles Lernen verwandeln werden, wodurch mehr Branchen und Szenarien gefördert werden. Neue Szenarien und neue Paradigmen graphischer neuronaler Netze: In der realen Welt, von der Schwerkraft der Planeten bis hin zu molekularen Wechselwirkungen, kann fast alles als in irgendeiner Beziehung verbunden angesehen werden, und dann kann alles als Graph betrachtet werden. Von der Analyse sozialer Netzwerke über Empfehlungssysteme bis hin zu Naturwissenschaften haben wir verwandte Anwendungsstudien für graphische neuronale Netze in verschiedenen Bereichen und die Modellentwicklung gesehen, die sich aus Anwendungsproblemen ergeben, wie z. B. räumlich-zeitliche Interaktion im intelligenten Transportwesen und verschiedene Kategorien in Szenarien zur finanziellen Risikokontrolle. Gleichgewicht, analytische Strukturdiskriminierungsprobleme im Bereich der Biochemie usw. Daher ist das adaptive Lernen szenenbezogener Merkmale in verschiedenen Szenen immer noch eine wichtige Richtung. Darüber hinaus basiert das aktuelle GNN einerseits hauptsächlich auf dem Message-Passing-Paradigma und nutzt die drei Schritte Informationsübertragung, Informationsaggregation und Informationsaktualisierung, um die Informationsübertragung, -aggregation und -aktualisierung sinnvoller und effizienter zu gestalten Derzeit wichtiger für die GNN-Arbeit. Andererseits werden das durch das Message-Passing-Framework und die assortative Annahme verursachte Informationsüberglättungsproblem auch seine Wirkung bei komplexeren Daten und Szenarien einschränken. Insgesamt leihen sich die meisten GNNs immer einige Ideen aus der Computervision und der Verarbeitung natürlicher Sprache, aber wie kann man die Regeln des Ausleihens brechen, ein leistungsfähigeres Modell basierend auf den induktiven Präferenzen von Diagrammdaten entwerfen und dem neuronalen Netzwerk des Graphen einzigartige Merkmale hinzufügen? Seele wird auch die Richtung sein, in die Forscher auf diesem Gebiet weiterhin hart denken und arbeiten. Graphstrukturlernen: Der Hauptunterschied zwischen graphischen neuronalen Netzen und herkömmlichen neuronalen Netzen besteht darin, dass sie die Struktur des Graphen als Leitfaden verwenden und Knotendarstellungen durch Aggregation von Nachbarinformationen lernen. Der Anwendung liegt tatsächlich eine Annahme zugrunde: Die Diagrammstruktur ist korrekt, das heißt, die Verbindungen im Diagramm sind real und vertrauenswürdig. Kanten in einem sozialen Diagramm implizieren beispielsweise echte Freundschaften. Tatsächlich ist die Struktur des Diagramms jedoch nicht so zuverlässig, und es kommt häufig zu verrauschten Verbindungen und zufälligen Verbindungen. Die falsche Diagrammstruktur und der Diffusionsprozess von GNN verringern die Knotendarstellung und die Leistung nachgelagerter Aufgaben (Garbage In, Garbage Out) erheblich. Daher ist es eine wichtige Richtung, Diagrammstrukturen besser zu lernen und glaubwürdigere Diagrammstrukturen in verschiedenen Datenszenarien aufzubauen. Vertrauenswürdiges graphisches neuronales Netzwerk: Aufgrund des Informationsübertragungsmechanismus und der Nicht-IID-Eigenschaften von Diagrammdaten sind GNNs sehr anfällig für gegnerische Angriffe und werden leicht durch gegnerische Störungen der Knoteneigenschaften und der Diagrammstruktur beeinträchtigt. . Betrüger können beispielsweise die GNNs-basierte Betrugserkennung umgehen, indem sie Transaktionen mit bestimmten Benutzern mit hoher Bonität erstellen. Daher ist es für einige Bereiche mit hohen Sicherheitsrisiken dringend erforderlich, robuste graphische neuronale Netze zu entwickeln. Da andererseits die gesamte Gesellschaft dem Schutz der Privatsphäre zunehmend Aufmerksamkeit schenkt, sind die Fairness graphischer neuronaler Netze und der Datenschutz ebenfalls wichtige Themen in der jüngsten Forschung. Beispielsweise gewann FederatedScope-GNN, die Open-Source-Plattform für föderiertes Lernen der Alibaba DAMO Academy für Diagrammdaten im Jahr 2022, dieses Jahr auch den besten Bewerbungsbeitrag im KDD 2022. Darüber hinaus ist es auch eine diskussionswürdige Richtung, wie man das trainierte Diagrammmodell dazu bringt, bestimmte Datentrainingseffekte/spezifische Parameter zu vergessen, um den Zweck des Schutzes der verborgenen Daten im Modell zu erreichen. Interpretierbarkeit: Obwohl Deep-Learning-Modelle bei vielen Aufgaben eine Leistung erreicht haben, die herkömmliche Methoden nicht erreichen können, führt die Komplexität des Modells dazu, dass seine Interpretierbarkeit oft eingeschränkt ist. In vielen hochsensiblen Bereichen wie Bioinformatik, Gesundheit und finanzieller Risikokontrolle ist die Interpretierbarkeit jedoch wichtig, wenn es um die Bewertung von Rechenmodellen und ein besseres Verständnis der zugrunde liegenden Mechanismen geht. Daher hat das Entwerfen von Modellen/Architekturen, die interpretierbar sind oder komplexe Zusammenhänge besser visualisieren können, in letzter Zeit mehr Aufmerksamkeit auf sich gezogen. Die vorliegende Arbeit bezieht sich hauptsächlich auf die Interpretierbarkeitsverarbeitungsmethoden in Texten und Bildern. Zum Beispiel Methoden, die auf Gradientenänderungen oder Eingabestörungen basieren (z. B. GNNExplainer). Kürzlich haben einige Forscher versucht, den Erklärbarkeitsmessrahmen mithilfe kausaler Screening-Methoden zu untersuchen, um die intrinsische Erklärbarkeit graphischer neuronaler Netze basierend auf invariantem Lernen besser abzuleiten und auch Einblicke in die Erklärbarkeit von Graphenmodellen zu liefern. Verallgemeinerung außerhalb der Verteilung: Allgemeine Lernprobleme bestehen darin, das Modelltraining für einen Trainingssatz abzuschließen, und dann muss das Modell Ergebnisse für einen neuen Testsatz liefern, wenn sich die Testdatenverteilung erheblich vom Training unterscheidet Verteilung: Der Generalisierungsfehler des Modells ist schwer zu kontrollieren. Die meisten aktuellen Methoden des Graph Neural Network (GNN) berücksichtigen nicht die nicht erkennbare Abweichung zwischen Trainingsgraphen und Testgraphen, was zu einer schlechten Generalisierungsleistung von GNN bei Out-of-Distribution (OOD)-Graphen führt. In der Realität erfordern viele Szenarien jedoch, dass das Modell mit einer offenen und dynamischen Umgebung interagiert. Während der Trainingsphase muss das Modell neue Entitäten oder Stichproben aus unbekannten Verteilungen in der Zukunft berücksichtigen, z. B. neue Benutzer/Elemente in Empfehlungssystemen Produkte in Online-Werbesystemen usw. Benutzerporträts/Verhaltensmerkmale der Plattform, neue Knoten oder Randbeziehungen im dynamischen Netzwerk usw. Daher ist es auch eine wichtige Forschungsrichtung, wie begrenzte Beobachtungsdaten verwendet werden können, um ein stabiles GNN-Modell zu erlernen, das auf neue Umgebungen mit unbekannten oder begrenzten Daten verallgemeinert werden kann. Grafikdaten-Vortraining und allgemeines Modell: Das Vortrainingsparadigma hat revolutionäre Erfolge in den Bereichen Computer Vision und Verarbeitung natürlicher Sprache erzielt und seine leistungsstarken Fähigkeiten bei vielen Aufgaben unter Beweis gestellt. Obwohl GNN bereits über einige relativ ausgereifte Modelle und erfolgreiche Anwendungen verfügt, beschränkt es sich immer noch auf Deep Learning, das eine große Menge an gekennzeichneten Daten verwendet, um Modelle für bestimmte Aufgaben zu trainieren. Wenn sich die Aufgabe ändert oder die Bezeichnungen nicht ausreichen, sind die Ergebnisse oft unbefriedigend. Daher regt es natürlich jeden dazu an, allgemeine Modelle in Diagrammdatenszenarien zu erforschen und darüber nachzudenken. Der Schlüssel zum Pre-Training liegt in reichlich Trainingsdaten, übertragbarem Wissen, leistungsstarken Backbone-Modellen und effektiven Trainingsmethoden. Im Vergleich zu den klaren semantischen Informationen in Computer Vision und natürlicher Sprachverarbeitung ist die Frage, welches Wissen in Diagrammen übertragbar ist, immer noch eine relativ offene Frage, da sich die Datenstrukturen verschiedener Diagramme stark unterscheiden. Obwohl tiefe und allgemeine GNN-Modelle untersucht wurden, haben sie noch keine revolutionären Verbesserungen gebracht. Glücklicherweise hat die Community des maschinellen Lernens von Graphen umfangreiche Diagrammdaten gesammelt und selbstüberwachte Trainingsmethoden wie die Diagrammrekonstruktion entwickelt. Mit der weiteren Erforschung nachfolgender Forschungen zu tiefem GNN, GNN mit ausdrucksstärkeren Fähigkeiten und neuen Paradigmen der Graph-Selbstüberwachung wird davon ausgegangen, dass irgendwann ein universelles Modell mit großer Vielseitigkeit verwirklicht wird. Software- und Hardware-Zusammenarbeit: Da die Anwendung und Forschungsentwicklung des Graphenlernens voranschreitet, wird GNN definitiv tiefer in Standard-Frameworks und -Plattformen wie PyTorch, TensorFlow, Mindpsore usw. integriert. Um die Skalierbarkeit von Graphmodellen weiter zu verbessern, sind hardwarefreundlichere Algorithmus-Frameworks und softwarekoordinierte Hardwarebeschleunigungslösungen der allgemeine Trend. Obwohl dedizierte Beschleunigungsstrukturen für graphneuronale Netzwerkanwendungen langsam entstehen, die Anpassung von Computerhardwareeinheiten und On-Chip-Speicherhierarchien für graphneuronale Netzwerke sowie dedizierte Chips, die das Rechen- und Speicherzugriffsverhalten optimieren, einige Erfolge erzielt haben, stecken diese Technologien noch in den Kinderschuhen Wir stellen uns großen Herausforderungen und bieten dementsprechend viele Chancen.  Link-Vorhersage (Link-Vorhersage) im Netzwerk bezieht sich darauf, wie das Netzwerk übergeben wird Die bekannten Netzwerkknoten und Netzwerkstrukturinformationen sagen die Möglichkeit einer Verbindung zwischen zwei Knoten im Netzwerk voraus, die noch nicht verbunden sind. Diese Vorhersage umfasst sowohl die Vorhersage unbekannter Links als auch die Vorhersage zukünftiger Links. Die Linkvorhersage wird häufig in Empfehlungssystemen, biochemischen Experimenten und anderen Szenarien verwendet. Wenn ein Benutzer beispielsweise in der zweiteiligen Grafik von Benutzern und Produkten ein Produkt kauft, besteht eine Verbindung zwischen dem Benutzer und dem Produkt Ähnliche Benutzer haben möglicherweise die gleiche Nachfrage nach dem Produkt. Daher wird vorhergesagt, ob Links wie „Kauf“ und „Klick“ zwischen dem Benutzer und dem Produkt wahrscheinlich sind, um Benutzern gezielt Produkte zu empfehlen , kann die Kaufrate des Produkts erhöhen. Darüber hinaus können die Vervollständigung von Wissensgraphen bei der Verarbeitung natürlicher Sprache und die Verkehrsvorhersage im intelligenten Transportwesen als Verbindungsvorhersageprobleme modelliert werden.

Link-Vorhersage (Link-Vorhersage) im Netzwerk bezieht sich darauf, wie das Netzwerk übergeben wird Die bekannten Netzwerkknoten und Netzwerkstrukturinformationen sagen die Möglichkeit einer Verbindung zwischen zwei Knoten im Netzwerk voraus, die noch nicht verbunden sind. Diese Vorhersage umfasst sowohl die Vorhersage unbekannter Links als auch die Vorhersage zukünftiger Links. Die Linkvorhersage wird häufig in Empfehlungssystemen, biochemischen Experimenten und anderen Szenarien verwendet. Wenn ein Benutzer beispielsweise in der zweiteiligen Grafik von Benutzern und Produkten ein Produkt kauft, besteht eine Verbindung zwischen dem Benutzer und dem Produkt Ähnliche Benutzer haben möglicherweise die gleiche Nachfrage nach dem Produkt. Daher wird vorhergesagt, ob Links wie „Kauf“ und „Klick“ zwischen dem Benutzer und dem Produkt wahrscheinlich sind, um Benutzern gezielt Produkte zu empfehlen , kann die Kaufrate des Produkts erhöhen. Darüber hinaus können die Vervollständigung von Wissensgraphen bei der Verarbeitung natürlicher Sprache und die Verkehrsvorhersage im intelligenten Transportwesen als Verbindungsvorhersageprobleme modelliert werden.

4. Skalierbarkeit von graphischen neuronalen Netzwerken

1. Sampling-basierte Datenverarbeitung

2. Vereinfachung anhand der Grafik

#🎜🎜 #

5. Netzwerke Mit der Repräsentationsfähigkeit ist Deep Learning zu einem wichtigen Werkzeug für die Wissensgewinnung geworden. Diagramme sind eine vielseitige und leistungsstarke Datenstruktur, die Entitäten und ihre Beziehungen in prägnanter Form darstellt und in Anwendungen in den Natur- und Sozialwissenschaften allgegenwärtig ist. Allerdings variieren Diagrammdaten in der realen Welt stark in Struktur, Inhalt und Aufgaben. Das leistungsstärkste GNN-Netzwerk- und Architekturdesign für eine Aufgabe ist möglicherweise nicht für eine andere Aufgabe geeignet. Für einen bestimmten Datensatz und eine bestimmte Vorhersageaufgabe ist es für Forscher oder Ingenieure von Anwendungsalgorithmen sehr wichtig, schnell ein Modell mit guten Ergebnissen zu erhalten. Welche neuronale Netzwerkarchitektur ist für einen bestimmten Datensatz und eine bestimmte Vorhersageaufgabe effektiv? Können wir ein System aufbauen, das automatisch gute GNN-Designs vorhersagt? Mit diesen Gedanken definierte die Gruppe von Jure Leskovec in ihrer 2020 veröffentlichten Arbeit zum Entwurfsraum für grafische neuronale Netze den Entwurfsraum von GNN aus drei Ebenen. Diese Arbeit bietet auch eine Grundlage für die anschließende Migration von grafischen Automaten und grafischen Lernmodellen das Fundament.

Angesichts einer bestimmten Aufgabe und eines bestimmten Datensatzes können wir zunächst Folgendes bestehen:

Angesichts einer bestimmten Aufgabe und eines bestimmten Datensatzes können wir zunächst Folgendes bestehen:

(Ich komme nicht umhin, einen Ausblick zu geben) Obwohl GNN in den letzten Jahren in vielen Bereichen große Erfolge erzielt hat, mit der Erweiterung von Anwendungsszenarien und tatsächlichen dynamischen Veränderungen und unbekannten offenen Umgebungen, in Zusätzlich zu den vielen Problemen und Herausforderungen, die im vorherigen Artikel erwähnt wurden, gibt es noch viele Richtungen, die einer weiteren Erkundung wert sind:

(Ich komme nicht umhin, einen Ausblick zu geben) Obwohl GNN in den letzten Jahren in vielen Bereichen große Erfolge erzielt hat, mit der Erweiterung von Anwendungsszenarien und tatsächlichen dynamischen Veränderungen und unbekannten offenen Umgebungen, in Zusätzlich zu den vielen Problemen und Herausforderungen, die im vorherigen Artikel erwähnt wurden, gibt es noch viele Richtungen, die einer weiteren Erkundung wert sind:

Das obige ist der detaillierte Inhalt vonTopologische Ästhetik im Deep Learning: GNN-Grundlage und Anwendung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr