Heim >Technologie-Peripheriegeräte >KI >DeepFake war noch nie so real! Wie stark ist Nvidias neueste „implizite Verzerrung'?

DeepFake war noch nie so real! Wie stark ist Nvidias neueste „implizite Verzerrung'?

- PHPznach vorne

- 2023-04-11 19:31:171508Durchsuche

In den letzten Jahren ist die Generierungstechnologie im Bereich Computer Vision immer leistungsfähiger geworden und die entsprechende „Fälschungs“-Technologie ist immer ausgereifter geworden. Von DeepFake-Gesichtsveränderung bis hin zu Action-Simulationen ist es schwierig das Echte vom Fake.

Vor kurzem hat NVIDIA einen weiteren großen Schritt gemacht und auf der NeurIPS 2022-Konferenz ein neues „Implicit Warping“-Framework (Implicit Warping) veröffentlicht, das „eine Reihe von Quellbildern“ und „gesteuerte Videobewegungen“ verwendet Zielanimation. Link zum Papier: https://arxiv.org/pdf/2210.01794.pdf

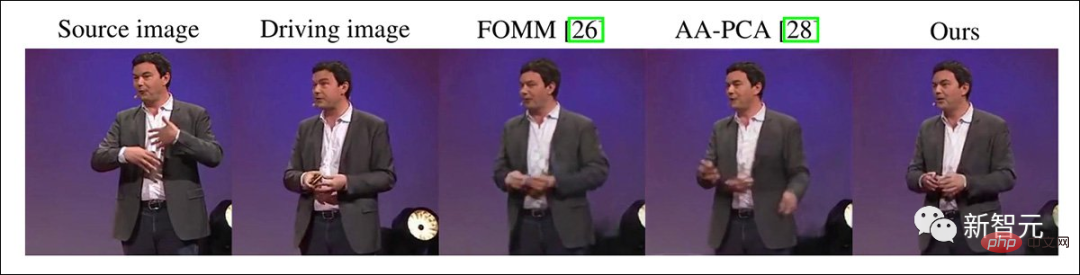

Aus Sicht des Effekts ist das erzeugte Bild realistischer, die Charaktere bewegen sich im Video, Hintergrund Es wird keine Änderung geben.

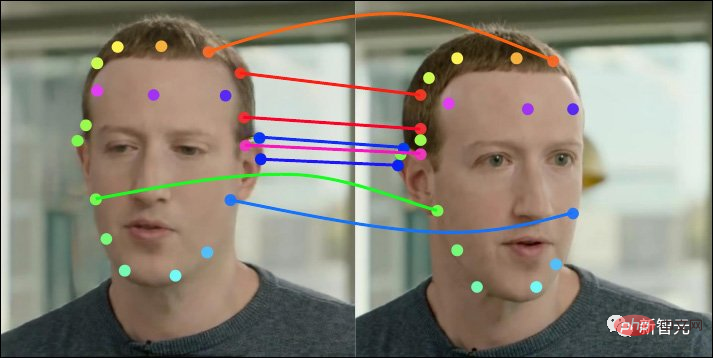

Die Eingabe mehrerer Quellbilder liefert normalerweise unterschiedliche Darstellungsinformationen, wodurch der „Fantasie“-Raum des Generators

reduziert wird, wie beispielsweise die folgenden beiden als Modelleingaben.Es kann festgestellt werden, dass die implizite Verzerrung im Vergleich zu anderen Modellen keine „Raumverzerrung“ ähnlich dem Schönheitseffekt erzeugt. Aufgrund der Verdeckung von Personen können mehrere Quellbilder auch

einen vollständigeren Hintergrundliefern.

Wie Sie im Video unten sehen können, ist es schwierig zu erraten, ob es sich hinter dem Hintergrund um „BD“ oder „ED“ handelt, wenn links nur ein Bild zu sehen ist, was dazu führen wird Verzerrung des Hintergrunds und zwei Bilder erzeugen ein stabileres Bild.

Magische implizite Verzerrung

Videoimitation in der Wissenschaft lässt sich bis ins Jahr 2005 zurückverfolgen. Viele Projekte umfassen Echtzeit-Ausdrucksübertragung der Gesichtsreproduktion, Face2Face, synthetisches Obama, Recycle-GAN, ReenactGAN, dynamisches neuronales Strahlungsfeld und so diversifizierten sie die damals begrenzten Technologien wie Generative Adversarial Networks (GAN), Neural Radiation Fields (NeRF) und Autoencoder.

Da das DeepFake-Modell jedoch weniger Informationen erfasst, muss diese Methode für jeden Videoclip trainiert werden, und die Leistung ist im Vergleich zu den Open-Source-Methoden von DeepFaceLab oder FaceSwap, die jedem eine Identität aufzwingen können, geringer Anzahl der Videoclips.

Das 2019 veröffentlichte FOMM-Modell ermöglicht es den Charakteren, sich mit dem Video zu bewegen, was der Aufgabe der Videoimitation eine weitere Chance gibt.

Später versuchten andere Forscher, mehrere Posen und Ausdrücke aus einem einzigen Gesichtsbild oder einer Ganzkörperdarstellung zu erhalten. Diese Methode funktioniert jedoch normalerweise nur bei relativ ausdruckslosen und unbeweglichen Probanden, beispielsweise bei relativ stillen „sprechenden“ Probanden. denn es gibt keine „plötzlichen Verhaltensänderungen“ in Mimik oder Gestik, die das Netzwerk interpretieren muss.

Obwohl einige dieser Technologien und Methoden öffentliche Aufmerksamkeit erlangten, bevor Deepfake-Technologie und potenzielle Diffusionsbildsynthesemethoden populär wurden, ist ihr Anwendungsbereich begrenzt und ihre Vielseitigkeit wird in Frage gestellt.

Die implizite Verzerrung, auf die sich NVIDIA dieses Mal konzentriert, besteht darin, Informationen zwischen mehreren Frames oder sogar nur zwischen zwei Frames zu erhalten, anstatt alle erforderlichen Haltungsinformationen aus einem Frame zu erhalten. Diese Einstellung ist in anderen Modellen nicht vorhanden oder extrem schlecht gehandhabt wird.

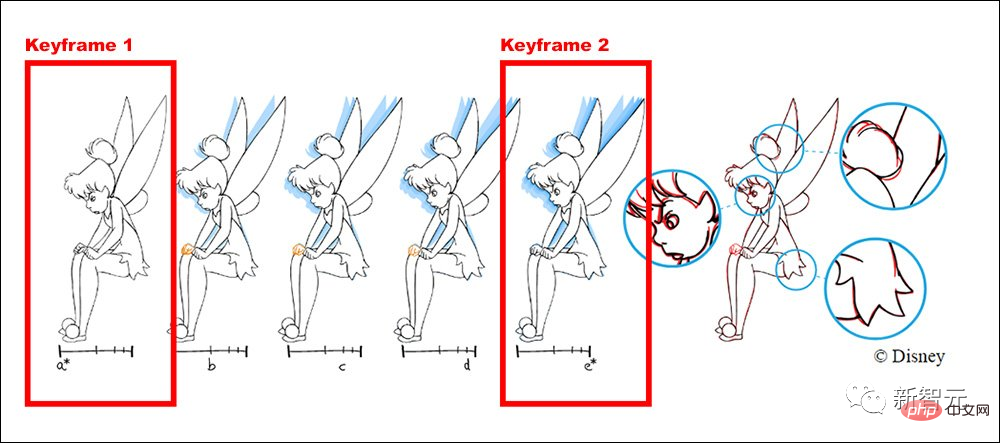

Zum Beispiel sieht der Arbeitsablauf bei Disney vor, dass ältere Animatoren die Hauptbilder und Schlüsselbilder zeichnen und andere jüngere Animatoren für das Zeichnen von Zwischenbildern verantwortlich sind.

Durch Tests früherer Versionen stellten Nvidia-Forscher fest, dass sich die Ergebnisqualität der vorherigen Methode durch zusätzliche „Keyframes“ verschlechterte, während die neue Methode mit der Logik von übereinstimmte Die Animationsproduktion ist konsistent und mit zunehmender Anzahl von Keyframes verbessert sich die Leistung linear.

Wenn in der Mitte des Clips plötzliche Änderungen auftreten, z. B. ein Ereignis oder ein Ausdruck, der nicht im Startbild oder Endbild angezeigt wird, kann dies zu einer impliziten Verzerrung führen Wenn Sie an dieser Stelle einen Frame hinzufügen, werden die zusätzlichen Informationen an den Aufmerksamkeitsmechanismus des gesamten Clips zurückgegeben.

Modellstruktur

Frühere Methoden wie FOMM, Monkey-Net und Face - vid2vid et al. verwenden explizite Verzerrung, um eine Zeitreihe zu zeichnen, zu der die aus der Quellfläche und der Kontrollbewegung extrahierten Informationen passen und übereinstimmen müssen.

Unter diesem Modelldesign ist die endgültige Zuordnung der Schlüsselpunkte ziemlich streng.

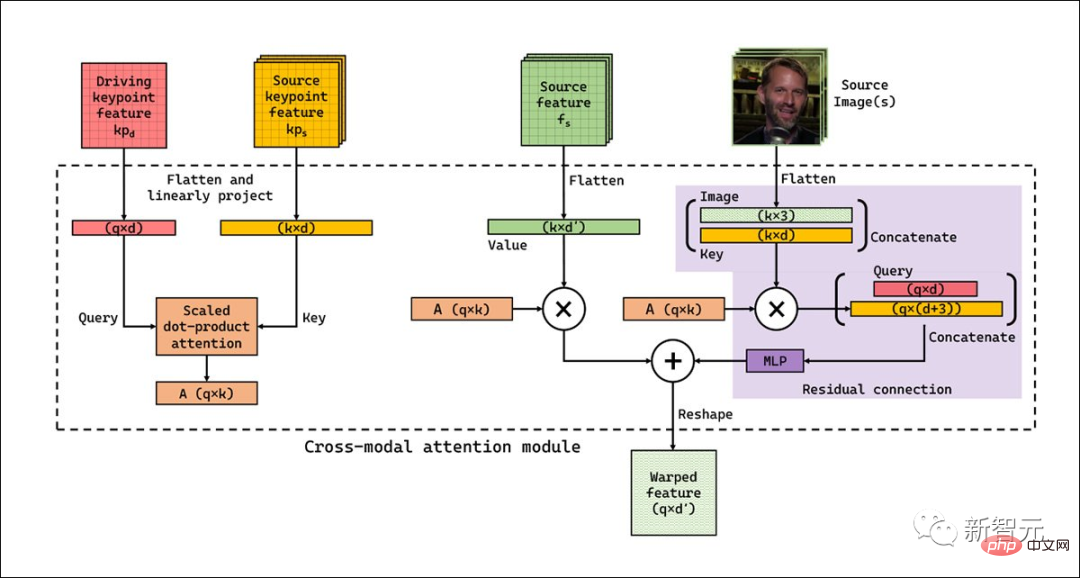

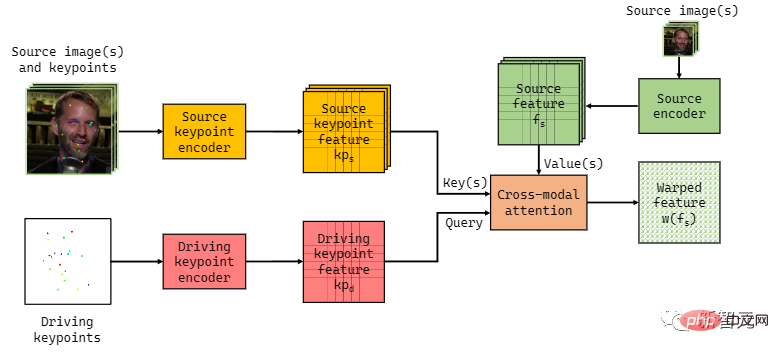

Im Gegensatz dazu verwendet Implicit Warp eine modalübergreifende Aufmerksamkeitsschicht, hat weniger vordefiniertes Bootstrapping in seinem Workflow und kann sich aus mehreren Framework-Eingaben anpassen.

Der Workflow erfordert auch keine Verzerrung pro Taste, das System kann die am besten geeigneten Funktionen aus einer Reihe von Bildern auswählen.

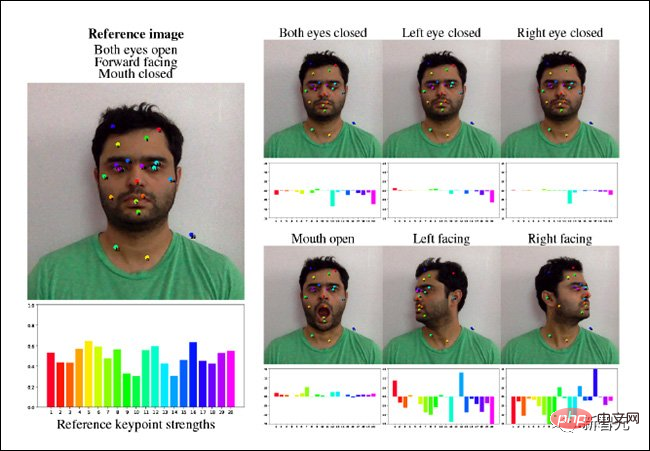

Implicit Twist verwendet auch einige Schlüsselpunktvorhersagekomponenten im FOMM-Framework wieder und verwendet schließlich ein einfaches U-Netz kodiert abgeleitete räumlich gesteuerte Schlüsselpunktdarstellungen. Ein separates U-Netz wird verwendet, um das Quellbild zusammen mit der abgeleiteten räumlichen Darstellung zu kodieren. Beide Netzwerke können mit Auflösungen von 64 Pixel (256 Pixel im Quadrat) bis 384 x 384 Pixel arbeiten.

Da dieser Mechanismus nicht automatisch alle möglichen Änderungen in Posen und Bewegungen in einem bestimmten Video berücksichtigen kann, sind zusätzliche Keyframes erforderlich erforderlich und können vorübergehend hinzugefügt werden. Ohne diese Eingriffsmöglichkeit werden Schlüssel, die dem Zielbewegungspunkt nicht ähnlich genug sind, automatisch aktualisiert, was zu einer Verschlechterung der Ausgabequalität führt.

Die Erklärung der Forscher hierfür ist, dass es zwar der Schlüssel ist, der der Abfrage in einem bestimmten Satz von Keyframes am ähnlichsten ist, er aber möglicherweise nicht ausreicht, um ein Gut zu erzeugen Ausgabe.

Angenommen, das Quellbild zeigt ein Gesicht mit geschlossenen Lippen und das Fahrerbild zeigt ein Gesicht mit offenen Lippen und freiliegenden Zähnen. In diesem Fall gibt es im Quellbild keinen geeigneten Schlüssel (und Wert), um den Mundbereich des Bildes zu steuern.

Diese Methode überwindet dieses Problem, indem sie zusätzliche bildunabhängige Schlüssel-Wert-Paare lernt, die den Informationsmangel im Quellbild bewältigen können.

Obwohl die aktuelle Implementierung recht schnell ist, etwa 10 FPS auf einem 512x512px-Bild, glauben die Forscher, dass die Pipeline in einer zukünftigen Version durch eine faktorisierte I-D geleitet werden kann Aufmerksamkeitsschicht oder SRA-Schicht (Spatial Reduction Attention) (d. h. Pyramid Visual Transformer) zur Optimierung.

Da implizites Warping globale Aufmerksamkeit anstelle lokaler Aufmerksamkeit verwendet, kann es im vorherigen Modell unvorhersehbare Faktoren vorhersagen.

Experimentelle Ergebnisse

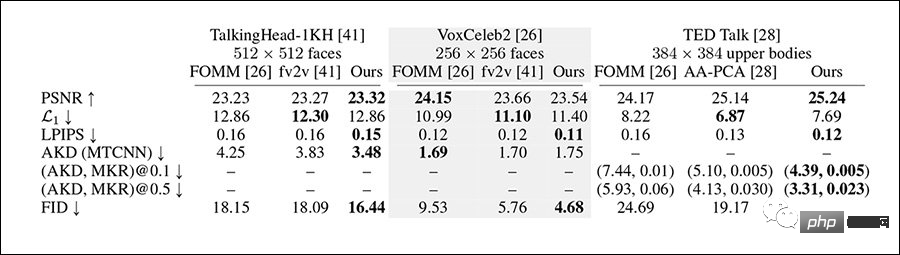

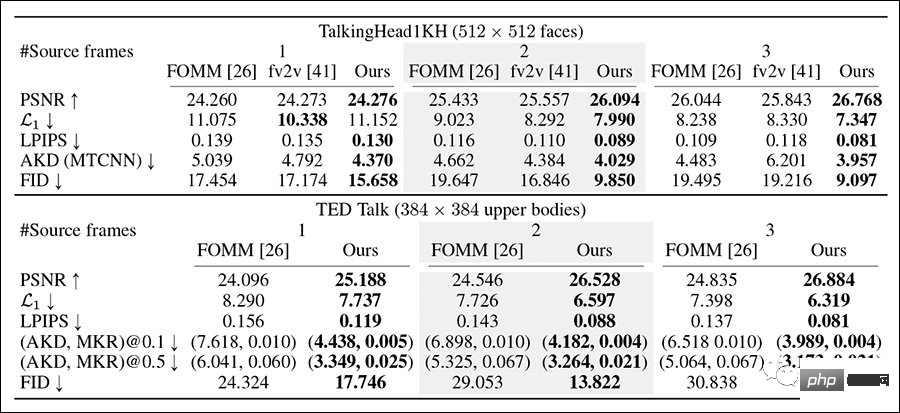

Die Forscher testeten den VoxCeleb2-Datensatz, den anspruchsvolleren TED Talk-Datensatz und den TalkingHead-1KH-Datensatz Das System wurde mit einer Basisauflösung zwischen 256 x 256 Pixel und der vollen Auflösung von 512 x 512 Pixel verglichen, wobei Metriken wie FID, AlexNet-basiertes LPIPS und maximales Signal-Rausch-Verhältnis (pSNR) zum Einsatz kamen.

Zu den zum Testen verwendeten Vergleichsframeworks gehören FOMM und face-vid2vid sowie AA-PCA. Da frühere Methoden kaum oder gar nicht in der Lage sind, mehrere Keyframes zu verwenden, ist dies auch die Hauptinnovation der impliziten Verzerrung. Die Forscher haben auch Ähnliches entwickelt Testmethoden.

Implizites Warping übertrifft die meisten Kontrastmethoden bei den meisten Metriken.

Im Multi-Keyframe-Rekonstruktionstest, bei dem die Forscher Sequenzen von bis zu 180 Frames und ausgewählte Gap-Frames verwendeten, gewann die implizite Verzerrung dieses Mal insgesamt.

Mit zunehmender Anzahl der Quellbilder können mit der Methode bessere Rekonstruktionsergebnisse erzielt werden und die Scores aller Indikatoren verbessern sich.

Und mit zunehmender Anzahl der Quellbilder wird der Rekonstruktionseffekt der vorherigen Arbeit wider Erwarten schlechter.

Nach der Durchführung qualitativer Untersuchungen durch AMT-Mitarbeiter wird auch angenommen, dass die Generierungsergebnisse der impliziten Verformung stärker sind als bei anderen Methoden.

Durch den Zugriff auf dieses Framework wären Benutzer in der Lage, kohärentere und längere Videosimulationen und Ganzkörper-Deepfake-Videos zu erstellen, die alle eine bessere Leistung als jedes Framework zeigen könnten, mit dem das System experimentiert hat mit. Viel größere Bewegungsfreiheit.

Die Erforschung einer realistischeren Bildsynthese wirft jedoch auch Bedenken auf, da diese Techniken leicht für Fälschungen genutzt werden können und das Papier einen Standard-Haftungsausschluss enthält.

Wenn unsere Methode zur Erstellung von DeepFake-Produkten verwendet wird, kann dies negative Auswirkungen haben. Bösartige Sprachsynthese erzeugt falsche Bilder von Menschen, indem sie falsche Informationen über Identitäten hinweg überträgt und übermittelt, was zu Identitätsdiebstahl oder der Verbreitung falscher Nachrichten führt. Aber in kontrollierten Umgebungen kann die gleiche Technologie auch zu Unterhaltungszwecken eingesetzt werden.

Der Artikel weist auch auf das Potenzial dieses Systems für die neuronale Videorekonstruktion hin, wie beispielsweise Googles Project Starline, bei dem sich die Rekonstruktionsbemühungen hauptsächlich auf die Clientseite konzentrieren und spärliche Bewegungsinformationen der Person am anderen Ende nutzen.

Diese Lösung weckt zunehmend das Interesse der Forschungsgemeinschaft, und es gibt auch Unternehmen, die beabsichtigen, Konferenzgespräche mit geringer Bandbreite zu implementieren, indem sie reine Bewegungsdaten oder Keyframes mit geringem Abstand senden, die beim Eintreffen beim Zielclient interpretiert werden . und in Full-HD-Video eingefügt.

Das obige ist der detaillierte Inhalt vonDeepFake war noch nie so real! Wie stark ist Nvidias neueste „implizite Verzerrung'?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr