Heim >Technologie-Peripheriegeräte >KI >Meta und CMU schließen sich zusammen, um ein episches VR-Upgrade zu starten! Das neueste HyperReel-Modell ermöglicht eine hochauflösende Videowiedergabe mit 6 Freiheitsgraden

Meta und CMU schließen sich zusammen, um ein episches VR-Upgrade zu starten! Das neueste HyperReel-Modell ermöglicht eine hochauflösende Videowiedergabe mit 6 Freiheitsgraden

- PHPznach vorne

- 2023-04-11 13:10:031435Durchsuche

Kürzlich könnte das von Meta und der Carnegie Mellon University vorgeschlagene 6-DoF-Videodarstellungsmodell HyperReel darauf hinweisen, dass eine neue VR-„Killer“-Anwendung kurz vor der Geburt steht!

Das sogenannte „Six Degrees of Freedom Video“ (6-DoF) ist einfach eine ultrahochauflösende 4D-Erlebniswiedergabe.

Unter anderem können Benutzer vollständig in dynamische Szenen „eintauchen“ und sich frei bewegen. Und wenn sie ihre Kopfposition (3 DoF) und Richtung (3 DoF) willkürlich ändern, werden auch die entsprechenden Ansichten entsprechend generiert.

Papieradresse: https://arxiv.org/abs/2301.02238

Im Vergleich zu früheren Arbeiten liegt der größte Vorteil von HyperReel im Speicher und der Recheneffizienz, die beide für tragbare VR-Headsets von entscheidender Bedeutung sind.

Und allein mit Vanilla PyTorch kann HyperReel auf einer einzelnen NVIDIA RTX 3090 eine Wiedergabe mit Megapixelauflösung bei 18 Bildern pro Sekunde erreichen.

zu lang zum Ansehen der Version: #🎜🎜 #

1. Schlagen Sie ein Netzwerk zur Vorhersage von Lichtbedingungen vor, das eine hochauflösende Wiedergabe mit hoher Bildrate und eine kompakte und speichereffiziente dynamische Volumencharakterisierung erreichen kann.

2. Die 6-DoF-Videocharakterisierungsmethode HyperReel kombiniert die beiden oben genannten Kernteile und kann dabei Millionen von Pixeln in Echtzeit rendern Erreichen eines idealen Gleichgewichts zwischen Geschwindigkeit, Qualität und Speicher. Es ist anderen Methoden in vielen Aspekten überlegen, beispielsweise in Bezug auf die Geschwindigkeit. Die volumetrische Szenendarstellung kann eine realistische Ansichtssynthese für statische Szenen ermöglichen und bildet die Grundlage der bestehenden 6-DoF-Videotechnologie.

Allerdings erfordern die Volumen-Rendering-Programme, die diese Darstellungen steuern, sorgfältige Kompromisse in Bezug auf Qualität, Rendering-Geschwindigkeit und Speichereffizienz.Die vorhandenen Methoden haben einen Nachteil: Sie können nicht gleichzeitig Echtzeitleistung, geringen Speicherbedarf und qualitativ hochwertiges Rendering erzielen Szenarien. Diese sind äußerst wichtig.

Um diese Probleme zu lösen, schlugen Forscher HyperReel vor, eine 6-DoF-Videocharakterisierungsmethode basierend auf der NeRF-Technologie (Neural Radiation Field).Dazu gehören die beiden Kernbestandteile von HyperReel:

1 Vorhersagenetzwerk mit hoher Wiedergabetreue und hoher Bildrate;

2. Eine kompakte und speichereffiziente dynamische Volumendarstellung.

Im Vergleich zu anderen Methoden schneidet die 6-DoF-Videopipeline von HyperReel nicht nur hinsichtlich der visuellen Qualität hervorragend ab, sondern benötigt auch sehr wenig Speicher.

Gleichzeitig kann HyperReel eine Rendering-Geschwindigkeit von 18 Bildern/Sekunde bei Megapixel-Auflösung ohne benutzerdefinierten CUDA-Code erreichen.

Insbesondere erreicht HypeReel dies durch die Kombination eines Beispielvorhersagenetzwerks und einer Keyframe-basierten Volumendarstellungsmethode zwischen hoher Rendering-Qualität, Geschwindigkeit und Speichereffizienz.

Das Beispielvorhersagenetzwerk kann sowohl das Volumenrendering beschleunigen als auch die Renderingqualität verbessern, insbesondere für Szenen mit anspruchsvollen Ansichtsabhängigkeiten.

Für die Keyframe-basierte Volumendarstellung nutzen Forscher eine Erweiterung von TensoRF.

Diese Methode kann eine vollständige Videosequenz genau darstellen und verbraucht dabei ungefähr den gleichen Speicher wie ein einzelner statischer Frame TensoRF.

Echtzeitdemonstration

Als nächstes werden wir in Echtzeit demonstrieren, HypeReel bei 512x512 Rendering dynamischer und statischer Szenen mit Pixelauflösung.

Es ist erwähnenswert, dass die Forscher in den Technicolor- und Shiny-Szenen kleinere Modelle verwendeten, sodass die Bildrate des Renderings mehr als 40 FPS betrug. Für die übrigen Datensätze wird das vollständige Modell verwendet, HypeReel ist jedoch weiterhin in der Lage, Echtzeit-Inferenzen bereitzustellen.

Technicolor

Technicolor

# ?? 🎜## 🎜🎜#Immersive

# ?? 🎜## 🎜🎜#Immersive

DoNeRF#🎜 🎜 ## 🎜🎜#

DoNeRF#🎜 🎜 ## 🎜🎜#

Implementierungsmethode Um HeperReel zu implementieren, muss zunächst die Volumendarstellung der statischen Ansichtssynthese optimiert werden.

Um HeperReel zu implementieren, muss zunächst die Volumendarstellung der statischen Ansichtssynthese optimiert werden.

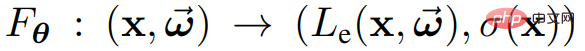

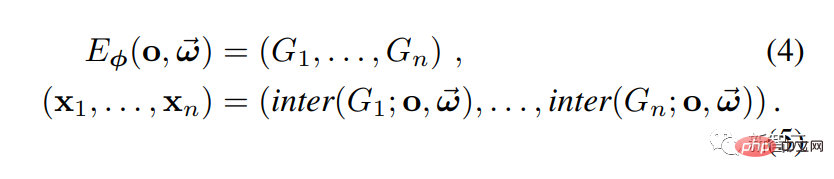

Die Volumendarstellung wie NeRF dient dazu, die Dichte und das Erscheinungsbild jedes Punktes einer statischen Szene im 3D-Raum zu modellieren. #?? und Dichte σ(x). Der trainierbare Parameter θ kann hier eine Gewichtung eines neuronalen Netzwerks, ein N-dimensionaler Array-Eintrag oder eine Kombination aus beidem sein.

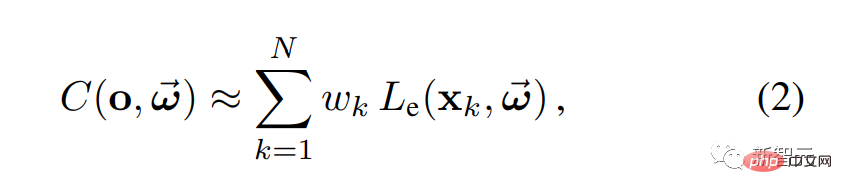

Dann können Sie eine neue Ansicht der statischen Szene rendern

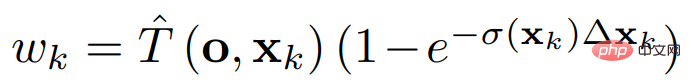

#🎜 🎜# wobei

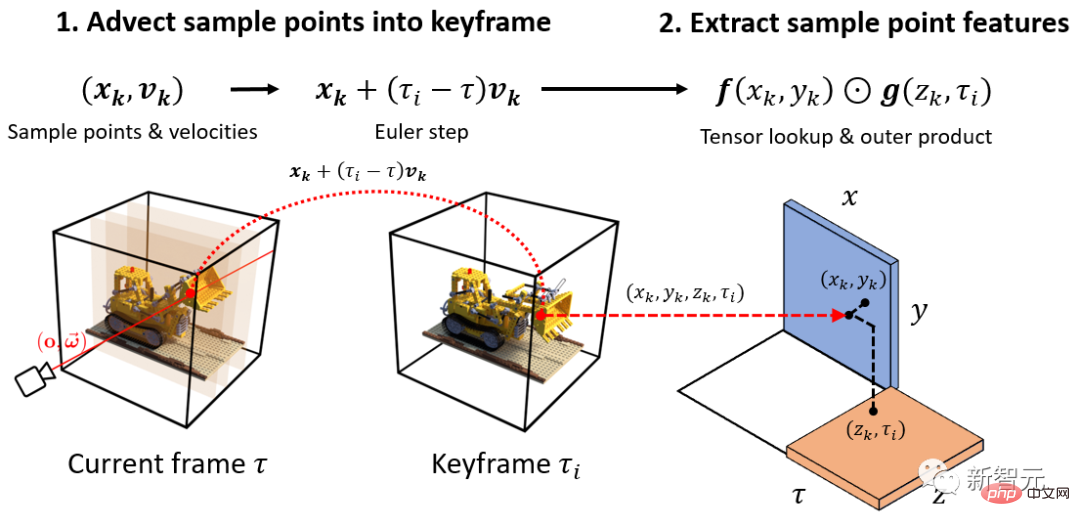

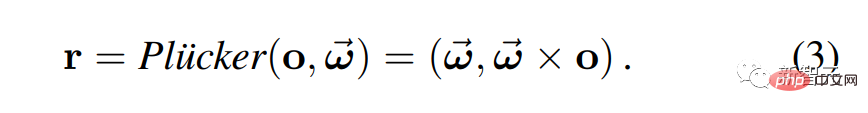

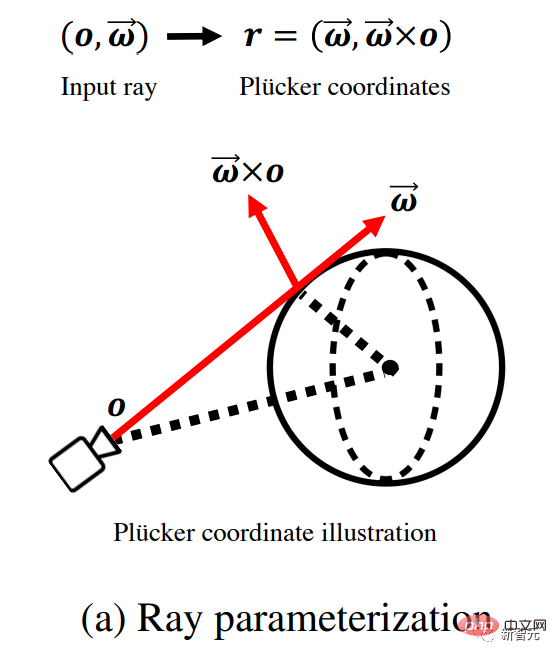

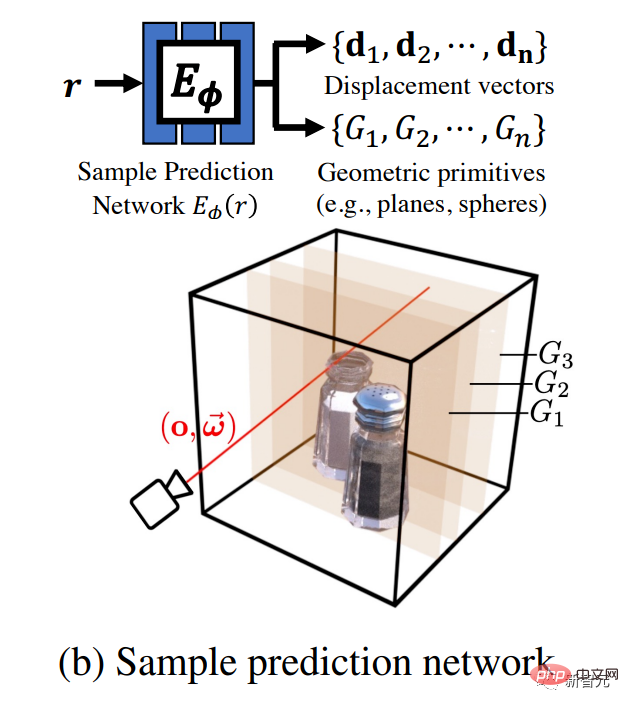

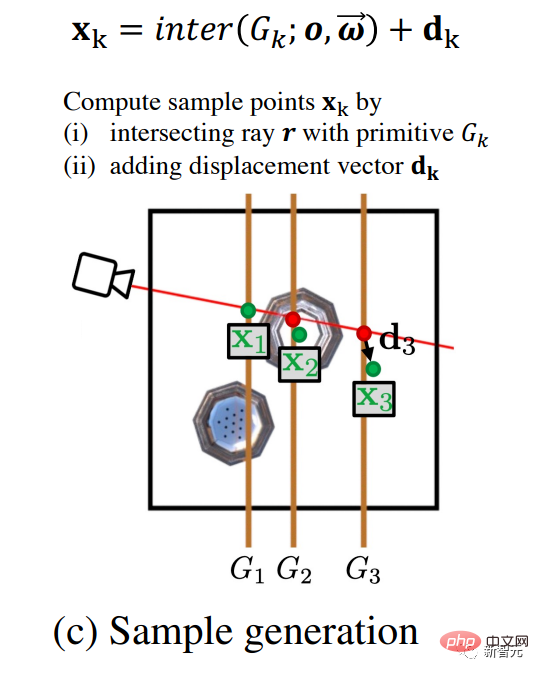

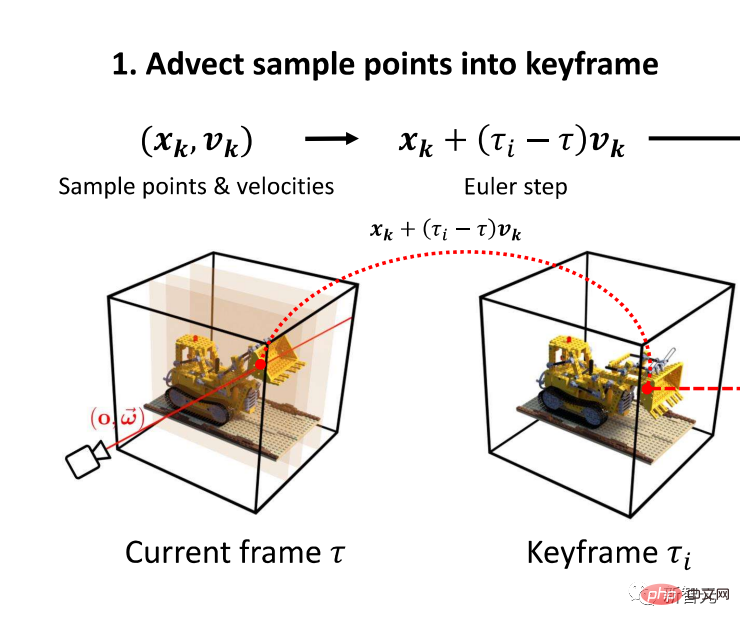

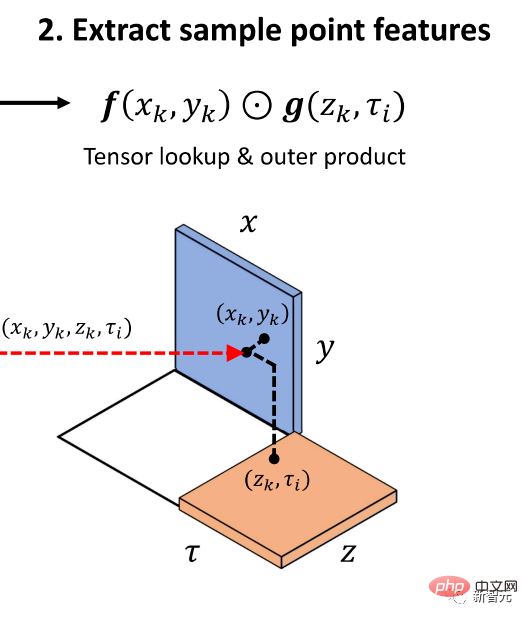

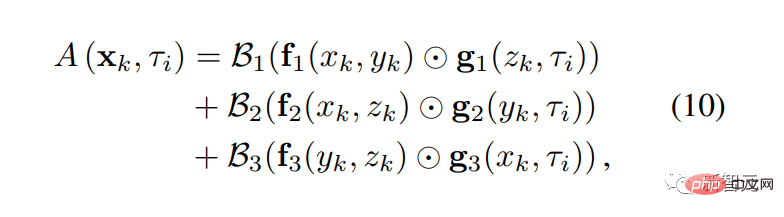

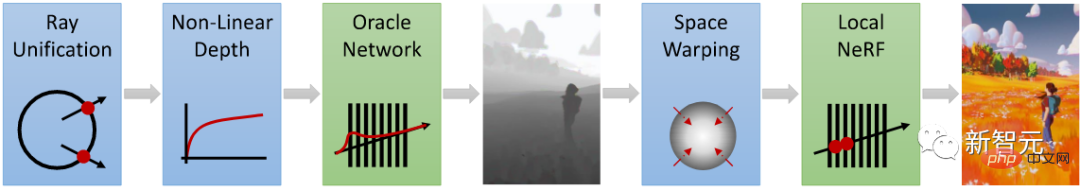

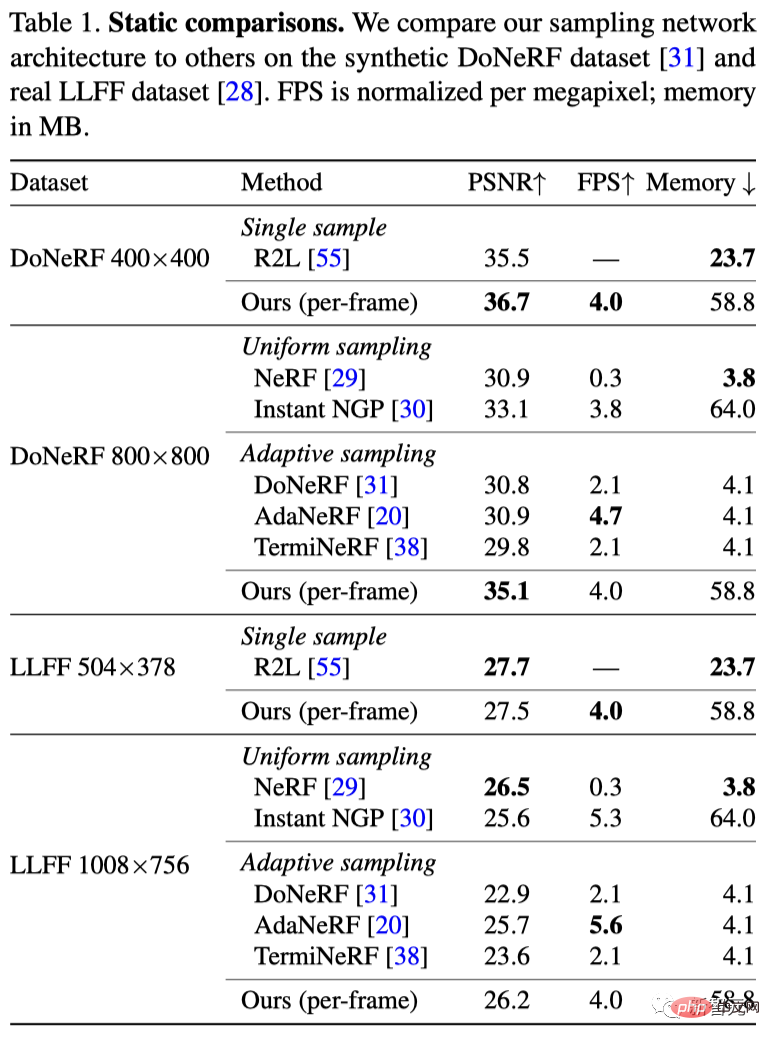

die Durchlässigkeit von o nach wobei das Gewicht Mesh-Beispiel für Volumenrendering In HyperReel besteht das Trainingsziel für eine statische Szene mit einer Reihe von Bildern und Kameraposen darin, die gemessene Farbe zu rekonstruieren, die jedem Strahl zugeordnet ist. Die meisten Szenen bestehen aus festen Objekten, deren Oberflächen auf einer 2D-Mannigfaltigkeit innerhalb des 3D-Szenenvolumens liegen. In diesem Fall beeinflusst nur eine kleine Anzahl von Abtastpunkten die gerenderte Farbe jedes Strahls. Um das Volumenrendering zu beschleunigen, wollen die Forscher die Farbe und Deckkraft also nur für Punkte ungleich Null Wie in der Abbildung unten gezeigt, verwenden Forscher ein Feedforward-Netzwerk, um eine Reihe von Probenorten vorherzusagen Hier verwenden Forscher die Parametrisierung von Plucker, um Licht zu charakterisieren. Aber es gibt ein Problem: Eine zu große Flexibilität des Netzwerks kann sich negativ auf die Qualität der Ansichtssynthese auswirken. Wenn beispielsweise (x1, . . , xn) völlig beliebige Punkte sind, sieht die Darstellung möglicherweise über mehrere Ansichten hinweg nicht konsistent aus. Um dieses Problem zu lösen, entschieden sich die Forscher für die Verwendung eines Mustervorhersagenetzwerks, um die Parameter eines Satzes geometrischer Grundelemente G1, ..., Gn vorherzusagen, wobei sich die Parameter der Grundelemente je nach unterschiedlicher Eingabe ändern können Strahlen. Um Beispielpunkte zu erhalten, wird mit jedem Grundelement ein Strahl geschnitten. Wie in Abbildung a gezeigt, verwendeten die Forscher angesichts des Eingangslichts, das vom Kameraursprung o stammte und sich entlang der Richtung ω ausbreitete, zunächst Plucker-Koordinaten, um das Licht neu zu parametrisieren. Wie in Abbildung b gezeigt, nimmt ein Netzwerk diesen Strahl als Eingabe und gibt einen Satz geometrischer Grundelemente {} (z. B. achsenausgerichtete Ebenen und Kugeln) und Verschiebungsvektoren aus { } Parameter. Wie in Abbildung c gezeigt, berechneten die Forscher zur Generierung von Beispielpunkten { Verschiebungsvektoren bieten zusätzliche Flexibilität bei den Abtastpunkten und ermöglichen so eine bessere Erfassung komplexer, von der Sichtlinie abhängiger Erscheinungen. Wie in Abbildung d gezeigt, führten die Forscher schließlich ein Volumenrendering über Formel 2 durch, um eine Pixelfarbe zu erzeugen, und führten darauf basierend auf den entsprechenden Beobachtungsergebnissen ein überwachtes Training durch. Mit der oben genannten Methode kann das Volumen der 3D-Szene effektiv abgetastet werden. Wie charakterisiert man die Lautstärke? Im statischen Fall verwendeten die Forscher die Methode des speichereffizienten Tensorstrahlungsfeldes (TensoRF); im dynamischen Fall wurde TensoRF auf eine Keyframe-basierte dynamische Volumendarstellung erweitert. Die folgende Abbildung erläutert den Prozess des Extrahierens einer dynamischen Beispielpunktdarstellung aus einer Keyframe-basierten Darstellung. Wie in Abbildung 1 gezeigt, verwendeten die Forscher zunächst die Geschwindigkeit {}, um die Netzwerkausgabe aus der Probe vorherzusagen, indem sie den Probenpunkt {} zum Zeitpunkt übersetzten bis zum aktuellsten Keyframe . Dann haben die Forscher, wie in Abbildung 2 gezeigt, das äußere Produkt der raumzeitlichen Textur abgefragt, um die Erscheinungsmerkmale jedes Probenpunkts zu erzeugen, die dann über Gleichung 10 in Farben umgewandelt wurden. Durch diesen Prozess ermittelten die Forscher die Opazität jeder Probe. Ergebnisvergleich Hier verglichen die Forscher HyperReel mit bestehenden statischen Ansichtssynthesemethoden (einschließlich NeRF, InstantNGP und drei netzwerkbasierten Stichprobenmethoden). Der DoNeRF-Datensatz enthält sechs synthetische Sequenzen mit einer Bildauflösung von 800×800 Pixeln. Wie in Tabelle 1 gezeigt, übertrifft die Methode von HyperReel qualitativ alle Basislinien und verbessert die Leistung anderer Sampling-Netzwerkschemata erheblich. Mittlerweile ist HyperReel mit Vanilla PyTorch implementiert und kann ein 800×800 Pixel großes Bild mit 6,5 FPS auf einer einzelnen RTX 3090 GPU (oder 29 FPS mit dem Tiny-Modell) rendern. Darüber hinaus weist das von den Forschern vorgeschlagene 6-schichtige Netzwerk mit 256 versteckten Einheiten und dem volumetrischen TensoRF-Backbone im Vergleich zu R2Ls tiefem MLP mit 88 Schichten und 256 versteckten Einheiten eine schnellere Inferenzgeschwindigkeit auf Die Forscher verglichen HyperReel und Neural 3D Video bei voller Bildauflösung an fünf Sequenzen dieses Datensatzes (Geburtstag, Fabien, Maler, Theater, Züge), jede Sequenz ist 50 Bilder lang. Wie in Tabelle 2 gezeigt, übertrifft die Qualität von HyperReel die von Neural 3D Video, während die Trainingszeit pro Sequenz nur 1,5 Stunden beträgt (anstelle von über 1000 Stunden bei Neural 3D) und die Rendering-Geschwindigkeit schneller ist. Neuronaler 3D-Videodatensatz Darüber hinaus verbraucht HyperReel im Durchschnitt viel weniger Speicher pro Frame als StreamRF und NeRFPlayer.

Google Immersive Dataset

Leider hat HyperReel noch nicht die für VR erforderliche Rendergeschwindigkeit erreicht (idealerweise 72FPS, Stereo). Da diese Methode jedoch in Vanilla PyTorch implementiert ist, kann die Leistung durch Arbeiten wie einen benutzerdefinierten CUDA-Kernel weiter optimiert werden. Vorstellung des Autors darstellt.

darstellt.  In der Praxis kann Gleichung 1 berechnet werden, indem mehrere Abtastpunkte entlang eines bestimmten Strahls genommen und dann numerische Quadratur verwendet werden: #

In der Praxis kann Gleichung 1 berechnet werden, indem mehrere Abtastpunkte entlang eines bestimmten Strahls genommen und dann numerische Quadratur verwendet werden: #

den Beitrag der Farbe jedes Abtastpunkts zur Ausgabe angibt.

den Beitrag der Farbe jedes Abtastpunkts zur Ausgabe angibt.  abfragen.

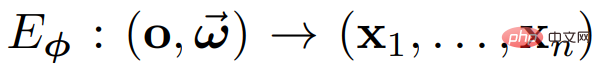

abfragen.  . Insbesondere wird ein Beispielvorhersagenetzwerk

. Insbesondere wird ein Beispielvorhersagenetzwerk  verwendet, , um Strahlen

verwendet, , um Strahlen  auf Abtastpunkte

auf Abtastpunkte  abzubilden, um die Darstellung in Volumengleichung 2 zu erhalten.

abzubilden, um die Darstellung in Volumengleichung 2 zu erhalten.

} für die Volumenwiedergabe die Schnittpunkte zwischen Strahlen und geometrischen Grundelementen und fügten den Ergebnissen Verschiebungsvektoren hinzu. Der Vorteil der Vorhersage geometrischer Grundelemente besteht darin, dass das abgetastete Signal glatt und leicht zu interpolieren ist.

} für die Volumenwiedergabe die Schnittpunkte zwischen Strahlen und geometrischen Grundelementen und fügten den Ergebnissen Verschiebungsvektoren hinzu. Der Vorteil der Vorhersage geometrischer Grundelemente besteht darin, dass das abgetastete Signal glatt und leicht zu interpolieren ist.

Dynamisches Volumen basierend auf Schlüsselbildern

Vergleich statischer Szenen

Wie in Tabelle 1 gezeigt, ist die Methode von HyperReel besser als DoNeRF, AdaNeRF, TermiNeRF und InstantNGP, aber die erreichte Qualität ist etwas schlechter als die von NeRF.

Neuronaler 3D-Videodatensatz enthält 6 Indoor-Multiview-Videosequenzen, aufgenommen von 20 Kameras mit einer Auflösung von 2704×2028 Pixeln.

Das obige ist der detaillierte Inhalt vonMeta und CMU schließen sich zusammen, um ein episches VR-Upgrade zu starten! Das neueste HyperReel-Modell ermöglicht eine hochauflösende Videowiedergabe mit 6 Freiheitsgraden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr