Heim >Technologie-Peripheriegeräte >KI >Google Recorder implementiert die automatische Sprecheranmerkung und seine Funktionalität sowie iOS-Sprachnotizen werden noch einmal erweitert

Google Recorder implementiert die automatische Sprecheranmerkung und seine Funktionalität sowie iOS-Sprachnotizen werden noch einmal erweitert

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-10 19:31:021252Durchsuche

Google hat 2019 für seine Pixel-Handys die Aufnahmesoftware Recorder unter Android-System auf den Markt gebracht, die mit Sprachnotizen unter iOS kompatibel ist und die Aufnahme, Verwaltung und Bearbeitung von Audiodateien unterstützt. Seitdem hat Google Recorder sukzessive um zahlreiche auf maschinellem Lernen basierende Funktionen erweitert, darunter Spracherkennung, Erkennung von Audioereignissen, automatische Titelgenerierung und intelligentes Browsing.

Wenn die Aufnahmedatei jedoch lang ist und mehrere Lautsprecher enthält, werden sich einige Recorder-Benutzer bei der Verwendung unwohl fühlen. Denn der durch Spracherkennung gewonnene Text allein kann nicht bestimmen, wer den jeweiligen Satz gesagt hat. Auf der diesjährigen Made By Google-Konferenz kündigte Google die automatische Sprecheranmerkungsfunktion der Recorder-App an. Diese Funktion fügt in Echtzeit anonyme Sprecher-Tags (z. B. „Sprecher 1“ oder „Sprecher 2“) zum spracherkannten Text hinzu. Diese Funktion wird die Lesbarkeit und Praktikabilität aufgezeichneter Texte erheblich verbessern. Die Technologie hinter dieser Funktion wird als Sprecherdiagnose bezeichnet. Google stellte erstmals auf der ICASSP-Konferenz 2022 sein Voiceprint-Segmentierungs- und Clustering-System namens Turn-to-Diarize vor.

Linkes Bild: Der Aufnahmetext mit ausgeschalteter Sprecheranmerkung. Rechts: Der Aufnahmetext mit aktivierter Sprecheranmerkung.

Systemarchitektur

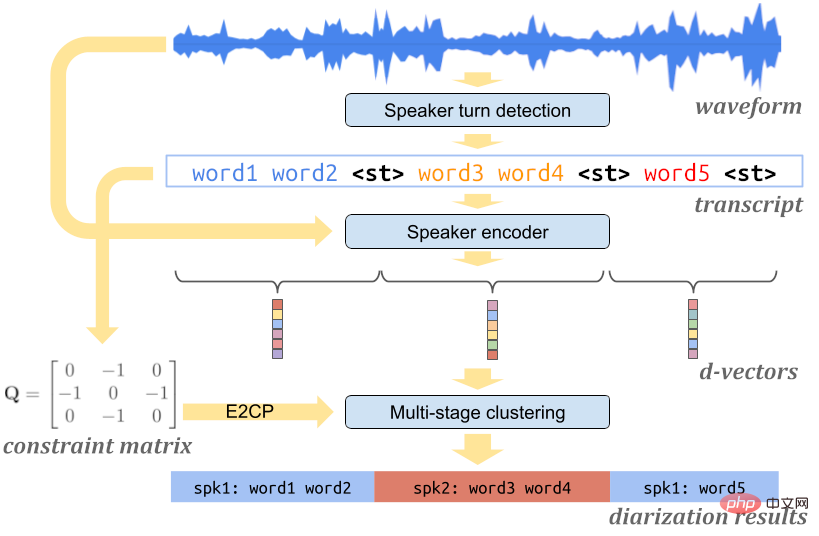

Das Turn-to-Diarize-System von Google enthält mehrere hochoptimierte Modelle und Algorithmen Echtzeit-Stimmabdrucksegmentierung und Clustering-Verarbeitung stundenlanger Audiodaten auf Mobilgeräten mit sehr wenigen Rechenressourcen. Das System besteht im Wesentlichen aus drei Komponenten: einem Sprecherwechselerkennungsmodell zur Erkennung des Sprecheridentitätswechsels, einem Stimmabdruck-Encodermodell zum Extrahieren der Stimmmerkmale jedes Sprechers und einem mehrstufigen System, das den Sprecheranmerkungsalgorithmus effizient vervollständigen kann. Alle Komponenten laufen vollständig auf dem Gerät des Benutzers und sind nicht auf eine Serververbindung angewiesen.

Turn-to-Diarize Architekturdiagramm des Systems.

Lautsprecherkonvertierungserkennung

Die erste Komponente des Systems ist ein Transformer Transducer (T-T)-Lautsprecherschalter Erkennungsmodell. Das Modell ist in der Lage, die akustische Feature-Sequenz in eine Textsequenz umzuwandeln, die das Sonderzeichen enthält. Das Sonderzeichen weist auf ein Sprecherwechselereignis hin. In früheren von Google veröffentlichten Artikeln wurden Sonderzeichen wie oder verwendet, um die Identität eines bestimmten Sprechers darzustellen. Da das -Zeichen im neuesten System nicht auf bestimmte Identitäten beschränkt ist, ist seine Anwendung auch weiter verbreitet.

Bei den meisten Anwendungen wird die Ausgabe des Stimmabdruck-Segmentierungs- und Clustering-Systems im Allgemeinen nicht direkt dem Benutzer präsentiert, sondern mit der Ausgabe des Spracherkennungsmodells kombiniert. Da das Spracherkennungsmodell während des Trainingsprozesses für die Wortfehlerrate optimiert wurde, ist das Sprecherwechselerkennungsmodell toleranter gegenüber der Wortfehlerrate, achtet jedoch stärker auf die Genauigkeit der Sonderzeichen . Auf dieser Grundlage schlug Google eine neue zeichenbasierte Verlustfunktion vor, die eine genaue Erkennung von Sprecherwechselereignissen mit nur einem kleineren Modell ermöglicht.

Voiceprint-Funktionen extrahieren

Wenn das Audiosignal nach Sprecherkonvertierungsereignissen segmentiert wird, verwendet das System das Voiceprint-Encoder-Modell für ein Sprechersegment extrahiert einen Einbettungscode, der Stimmabdruckinformationen enthält, also einen D-Vektor. In früheren von Google veröffentlichten Artikeln wurden Sprachabdruck-Einbettungscodes im Allgemeinen aus Audiodaten fester Länge extrahiert. Im Gegensatz dazu bietet dieses neue System viele Verbesserungen. Erstens vermeidet das neue System das Extrahieren von Sprachabdruck-Einbettungscodes aus Segmenten, die mehrere Sprecherinformationen enthalten, wodurch die Gesamtqualität der Einbettungscodes verbessert wird. Zweitens ist das Sprachfragment, das jedem Stimmabdruck-Einbettungscode entspricht, relativ lang, sodass es mehr Stimmabdruckinformationen enthält, die dem Sprecher entsprechen. Schließlich ist die endgültige Voiceprint-Einbettungscodesequenz, die mit dieser Methode erhalten wird, kürzer, wodurch der nachfolgende Clustering-Algorithmus weniger rechenintensiv wird.

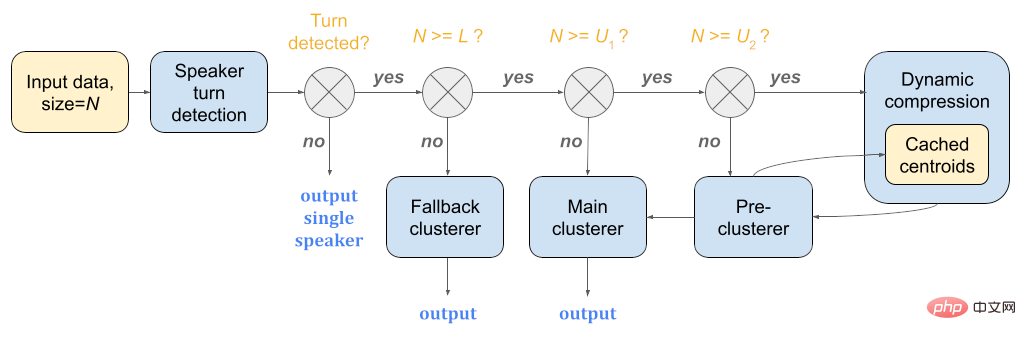

Mehrstufiges Clustering

Der letzte Schritt der Sprachabdrucksegmentierung und -clusterung besteht darin, die in den vorherigen Schritten erhaltenen Sprachabdruck-Einbettungscodesequenzen zu gruppieren. Da die Aufzeichnungen, die Benutzer mit der Recorder-App erstellen, zwischen wenigen Sekunden und bis zu 18 Stunden liegen können, besteht eine zentrale Herausforderung für Clustering-Algorithmen darin, Sprachabdruck-Einbettungssequenzen unterschiedlicher Länge verarbeiten zu können.

Dazu kombiniert Googles mehrstufige Clustering-Strategie geschickt die jeweiligen Vorteile mehrerer unterschiedlicher Clustering-Algorithmen. Für kürzere Sequenzen verwendet die Strategie Aggregate Hierarchical Clustering (AHC). Für Sequenzen mittlerer Länge verwendet diese Methode spektrales Clustering und nutzt die Maximum-Marge-Methode der Eigenwerte, um die Anzahl der Sprecher genau abzuschätzen. Bei längeren Sequenzen verwendet diese Methode zunächst aggregiertes hierarchisches Clustering zur Vorverarbeitung der Sequenz und ruft dann spektrales Clustering auf, wodurch der Rechenaufwand des Clustering-Schritts reduziert wird. Während des gesamten Streaming-Verarbeitungsprozesses kann durch dynamisches Zwischenspeichern und Wiederverwenden der vorherigen Clustering-Ergebnisse die Obergrenze der zeitlichen und räumlichen Komplexität jedes Aufrufs des Clustering-Algorithmus auf eine Konstante festgelegt werden.

Die mehrstufige Clustering-Strategie ist eine wichtige Optimierung für geräteseitige Anwendungen. Denn auf Geräteseite sind Ressourcen wie CPU, Speicher und Akku meist knapp. Diese Strategie kann auch nach mehrstündiger Audioverarbeitung im Energiesparmodus noch funktionieren. Die Obergrenze der konstanten Komplexität dieser Strategie kann in der Regel je nach Gerätemodell angepasst werden, um ein Gleichgewicht zwischen Genauigkeit und Leistung zu erreichen.

Schematische Darstellung der mehrstufigen Clustering-Strategie.

Echtzeitkorrektur und Benutzeranmerkung

Weil Turn-to-Diarize in Echtzeit erfolgt Je mehr Audio das Modell verarbeitet, desto genauer werden die vorhergesagten Lautsprecherbezeichnungen. Zu diesem Zweck korrigiert die Recorder-Anwendung während des Aufnahmevorgangs des Benutzers kontinuierlich die zuvor vorhergesagten Sprecherbezeichnungen, um sicherzustellen, dass die Sprecherbezeichnungen, die der Benutzer auf dem aktuellen Bildschirm sieht, immer genauere Bezeichnungen sind.

Gleichzeitig ermöglicht die Benutzeroberfläche der Recorder-Anwendung Benutzern auch, das Lautsprecher-Tag in jeder Aufnahme umzubenennen, beispielsweise „Lautsprecher 2“ in „ Autohändler“ und erleichtert so das Lesen und Merken für Benutzer.

Recorder ermöglicht Benutzern das Umbenennen von Sprecher-Tags und verbessert so die Zugänglichkeit und Lesbarkeit.

Future Work

Google hat den selbst entwickelten Chip Google Tensor auf den neuesten Pixel-Handys eingeführt. Das aktuelle Voiceprint-Segmentierungs- und Clustering-System läuft hauptsächlich auf dem CPU-Modul von Google Tensor. In Zukunft plant Google, das Voiceprint-Segmentierungs- und Clustering-System auf dem TPU-Modul von Google Tensor auszuführen, um den Energieverbrauch weiter zu senken. Darüber hinaus hofft Google, diese Funktion mithilfe mehrsprachiger Stimmabdruck-Encoder und Spracherkennungsmodelle neben Englisch auch auf andere Sprachen auszuweiten.

Das obige ist der detaillierte Inhalt vonGoogle Recorder implementiert die automatische Sprecheranmerkung und seine Funktionalität sowie iOS-Sprachnotizen werden noch einmal erweitert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr