Heim >Technologie-Peripheriegeräte >KI >AIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?

AIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?

- 王林nach vorne

- 2023-04-08 11:21:15898Durchsuche

KI-Generierungsmodelle haben in der vergangenen Zeit enorme Fortschritte gemacht, was den Bildbereich betrifft. Benutzer können Bilder durch Eingabe natürlicher Spracheingaben (wie DALL-E 2, Stable Diffusion) oder in der Zeitdimension erzeugen . Erweitern Sie, um kontinuierliche Videos zu generieren (z. B. Phenaki), oder erweitern Sie die räumliche Dimension, um direkt 3D-Modelle zu generieren (z. B. Dreamfusion).

Aber bisher befinden sich diese Aufgaben noch in einem isolierten Forschungsstadium, und es gibt keine technische Überschneidung untereinander.

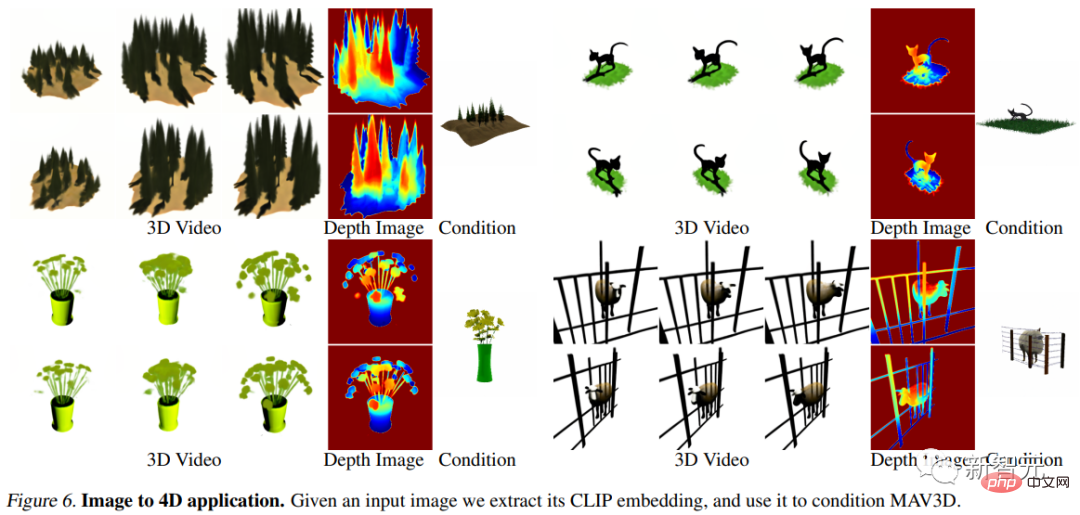

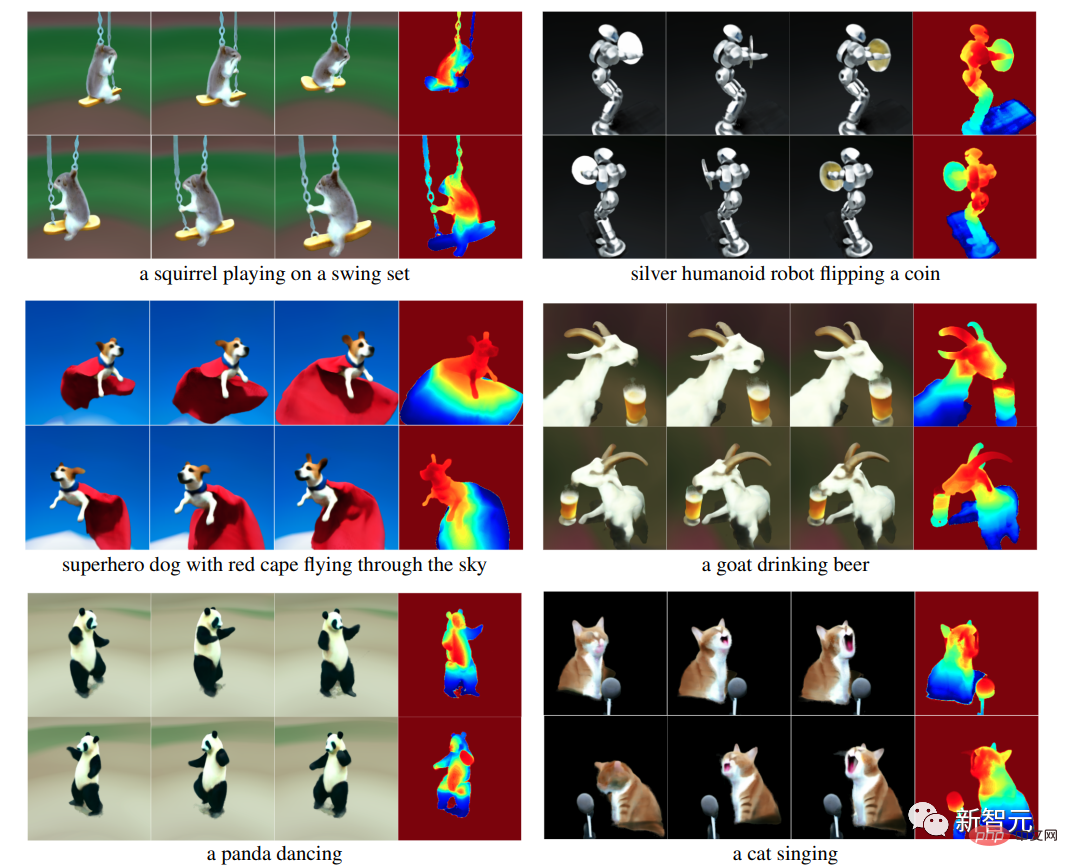

Kürzlich kombinierten Meta-KI-Forscher die Vorteile von Video- und generativen 3D-Modellen und schlugen ein brandneues Text-zu-vierdimensionales (3D + Zeit)-Generierungssystem MAV3D (MakeA-Video3D) vor, das eine Beschreibung in natürlicher Sprache übernimmt input und gibt eine dynamische dreidimensionale Szenendarstellung aus, die aus jeder Perspektive gerendert werden kann.

Papierlink: https://arxiv.org/abs/2301.11280

Projektlink: https://make-a-video3d.github.io/

MAV3D ist außerdem das erste Modell, das dreidimensionale dynamische Szenen basierend auf vorgegebenen Textbeschreibungen generieren kann.

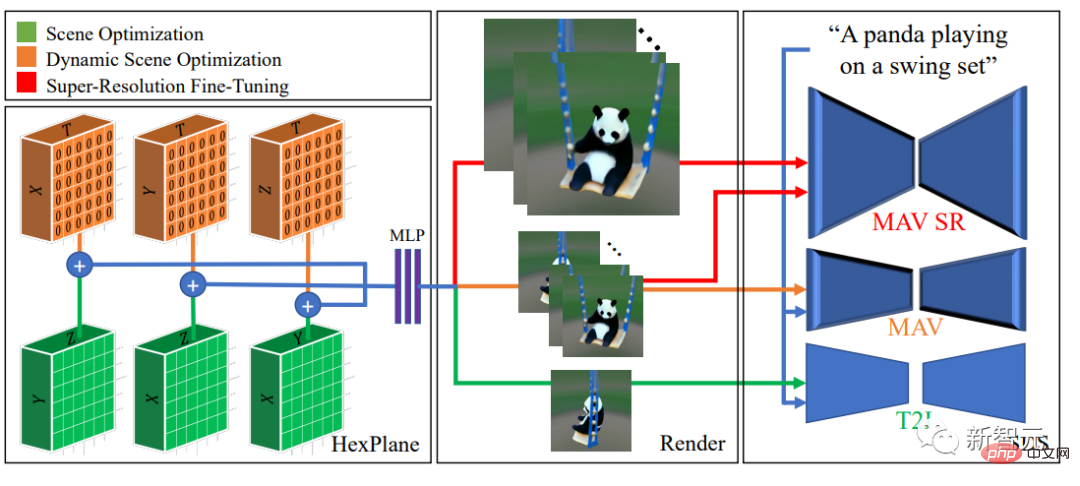

Die in diesem Artikel vorgeschlagene Methode verwendet ein dynamisches 4D-Neuronales Strahlungsfeld (NeRF), um die Szenendarstellung, Dichte und Bewegungskonsistenz zu optimieren, indem ein auf Text-zu-Video (T2V) basierendes Diffusionsmodell und die dadurch erzeugte Dynamik abgefragt werden Der bereitgestellte Text Die Videoausgabe kann aus jeder Kameraposition und aus jedem Winkel betrachtet und in jede 3D-Umgebung zusammengesetzt werden.Mit dieser Methode können 3D-Assets für Videospiele, visuelle Effekte oder Augmented und Virtual Reality generiert werden.

eine vorgefertigte 4D-Modellsammlung.

Corgi spielt Ball

MAV3DsTraining erfordert keine 3D- oder 4D-Daten, das T2V-Modell muss nur auf Text-Bild-Paare und unbeschriftete Videos trainiert werden.

Im experimentellen Teil führten die Forscher umfangreiche quantitative und qualitative Experimente durch, um die Wirksamkeit der Methode nachzuweisen, wodurch die zuvor festgelegte interne Basislinie deutlich verbessert wurde.Text zur dynamischen 4D-Szene

Aufgrund des Mangels an Trainingsdaten haben Forscher mehrere Ideen zur Lösung dieser Aufgabe entwickelt.Ein Ansatz könnte darin bestehen, einen vorab trainierten 2D-Videogenerator zu finden und eine 4D-Rekonstruktion aus dem generierten Video zu extrahieren. Allerdings ist die Rekonstruktion der Form verformbarer Objekte aus Videos immer noch ein sehr anspruchsvolles Problem, nämlich

Non-Rigid Structure from Motion (NRSfM).

Wenn Sie mehrere gleichzeitige Blickwinkel auf ein Objekt erhalten, wird die Aufgabe einfacher. Obwohl Multikamera-Setups in realen Daten selten sind, glauben die Forscher, dass vorhandene Videogeneratoren implizit Modelle der Szene aus beliebigen Blickwinkeln generieren.

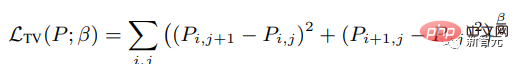

Der MAV3D-Algorithmus erreicht dies durch die Optimierung des dynamischen Neural Radiation Field (NeRF) und die Dekodierung von Eingabetext in Video, wobei zufällige Blickwinkel um das Objekt herum abgetastet werden. Der direkte Einsatz des Videogenerators zur Optimierung des dynamischen NeRF hat zu keinen zufriedenstellenden Ergebnissen geführt. Es gibt noch einige Probleme, die während des Implementierungsprozesses überwunden werden müssen: 1 Ein effektiver, durchgängig erlernbarer Algorithmus Es wird eine dynamische 3D-Szenendarstellung benötigt im Raum sein und die Auflösung der Ausgabe in der Zeitdimension erweitern, da die 4D-Ausgabe viel Speicher und Rechenleistung erfordert MAV3D-Modell Um diese Darstellung ohne entsprechende (Text-, 4D-)Daten zu überwachen, schlagen die Forscher eine mehrstufige Trainingspipeline für dynamisches Szenenrendering vor und demonstrieren die Wirksamkeit jeder Komponente für die Erzielung qualitativ hochwertiger Ergebnisse.

Eine wichtige Beobachtung ist, dass die direkte Optimierung dynamischer Szenen mithilfe von Score Distillation Sampling (SDS) unter Verwendung von Text-to-Video (T2V)-Modellen zu visuellen Artefakten und suboptimaler Konvergenz führen kann. Daher entschieden sich die Forscher, zunächst das Text-to-Image (T2I)-Modell zu verwenden, um die statische 3D-Szene mit Textaufforderungen abzugleichen, und dann das 3D-Szenenmodell dynamisch zu verbessern. Darüber hinaus wird ein neuer temporaler SDS-Verlust- und Bewegungsregularisierungsterm in das Modell eingeführt, der sich experimentell als entscheidend für realistische und anspruchsvolle Bewegungen erwiesen hat.

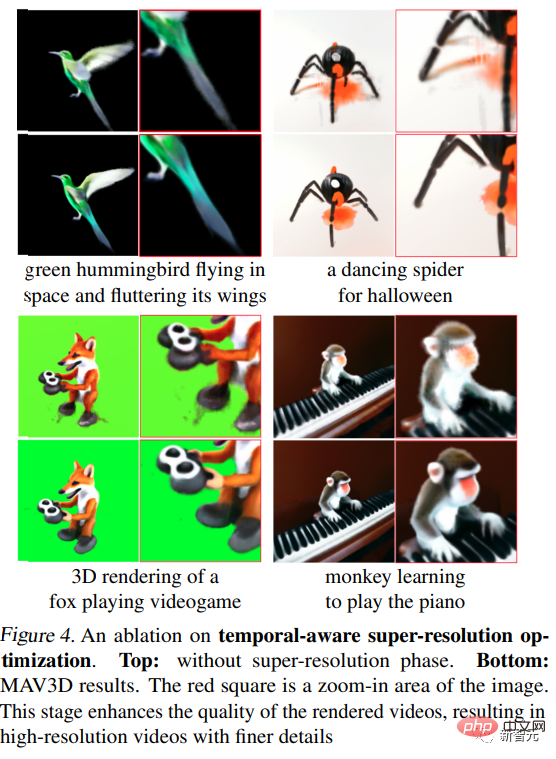

und mit einer zusätzlichen zeitbewussten Superauflösungs-Feinabstimmungsstufe auf eine Ausgabe mit höherer Auflösung skaliert. Schließlich wird das SDS des Super-Resolution-Moduls des T2V-Modells verwendet, um hochauflösende Gradienteninformationen für das überwachte Lernen des 3D-Szenenmodells zu erhalten, wodurch seine visuelle Wiedergabetreue erhöht und die Verarbeitung von Bildern mit höherer Auflösung währenddessen ermöglicht wird der Inferenzprozess. Die Ausgabe wird abgetastet. Experimenteller Teil Bewertungsmetriken Darüber hinaus werden vier qualitative Metriken verwendet, die abgeleitet werden können, indem menschliche Kommentatoren nach ihren Präferenzen unter den beiden generierten Videos gefragt werden: (i) Videoqualität; (iii) Menge der Übung; und (iv) Authentizität der Übung .

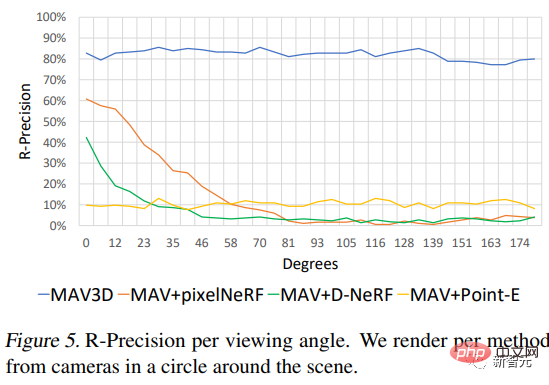

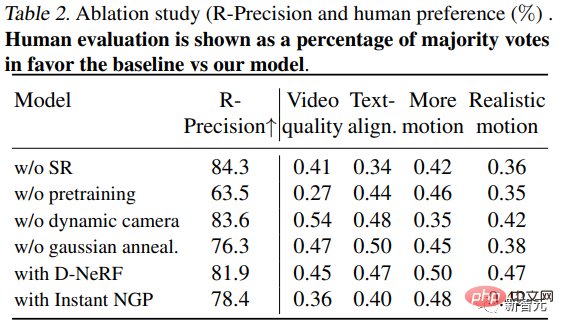

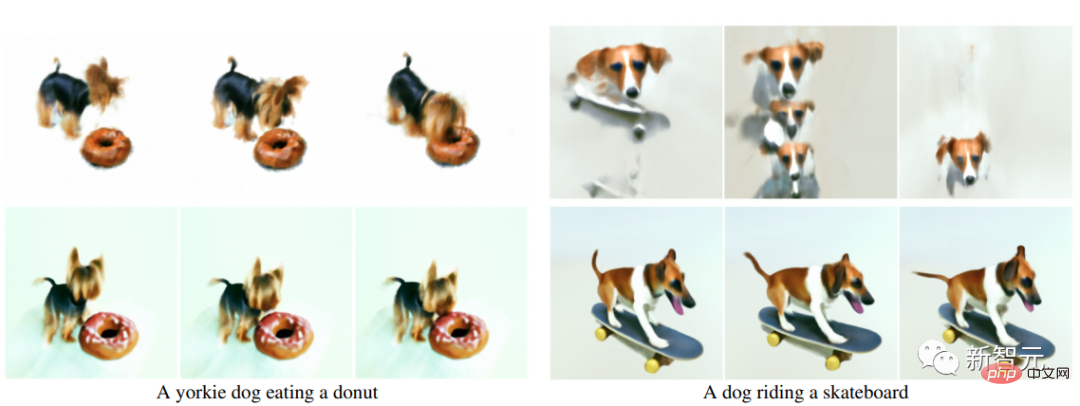

Text-zu-4D-Vergleich Da es zuvor keine Methode zur Konvertierung von Text in 4D gab, erstellten die Forscher zum Vergleich drei Basislinien auf der Grundlage der T2V-Generierungsmethode Um Sequenzen in dreidimensionale Szenendarstellungen umzuwandeln, kommen drei unterschiedliche Methoden zum Einsatz. Die erste Sequenz wird durch den One-Shot-Renderer für neuronale Szenen (Point-E) erhalten; die zweite wird durch die unabhängige Anwendung von pixelNeRF auf jedes Bild generiert; die dritte wird durch die Anwendung von D-NeRF in Kombination mit der COLMAP-Extracted-Kamera generiert Position. Es ist ersichtlich, dass die Methode das Basismodell hinsichtlich der objektiven R-Genauigkeitsmetrik übertrifft und von menschlichen Kommentatoren bei allen Metriken höher bewertet wird. Darüber hinaus untersuchten die Forscher auch die Leistung der Methode unter verschiedenen Kamerawinkeln. Ablationsexperiment 1. Modell ohne Feinabstimmung der Szenen-Superauflösung (SR) trainiert, mit der gleichen Anzahl von Schritten wie MAV3D (Stufe 3). Menschliche Annotatoren bevorzugen Modelle mit SR in Bezug auf Qualität, Textausrichtung und Bewegung geschult. Darüber hinaus verbessert die Super-Resolution-Feinabstimmung die Qualität gerenderter Videos, wodurch hochauflösende Videos mit feineren Details und weniger Rauschen erstellt werden. 2. Kein Vortraining: Wenn die Schritte zur direkten Optimierung dynamischer Szenen (ohne statisches Szenen-Vortraining) mit MAV3D identisch sind, ist das Ergebnis eine viel geringere Szenenqualität oder eine schlechte Konvergenz: bei In 73 % und 65 % der Fälle werden mit statischer Aufladung vorab trainierte Modelle hinsichtlich der Videoqualität und realistischen Bewegung bevorzugt.

Das obige ist der detaillierte Inhalt vonAIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr