Heim >Technologie-Peripheriegeräte >KI >Ein Versuch, die ChatGPT-Technologie zu lokalisieren

Ein Versuch, die ChatGPT-Technologie zu lokalisieren

- 王林nach vorne

- 2023-04-08 11:31:031931Durchsuche

Das Thema dieses Teilens ist die ChatGPT-Technologie, Lokalisierungsversuche und Open-Source-Modelle. Der Austausch besteht aus drei Teilen: Der erste Teil gibt eine umfassende Einführung in die ChatGPT-Technologie: die Entwicklung der ChatGPT-Technologie, aktuelle Probleme, die drei Phasen des Lernens der ChatGPT-Technologie, die Datenorganisation und die Wirkungsbewertung Unsere Versuche zur Technologielokalisierung umfassen die Probleme, auf die wir während des Experiments gestoßen sind, unsere Gedanken sowie die Auswirkungen und Anwendungen des Modells. Der dritte Teil stellt das von uns veröffentlichte chinesische Open-Source-Großmodell vor und zeigt, wie wir unsere eigenen Daten zum Trainieren verwenden Lokales Modell Während des Betriebs können Probleme auftreten, die während des Experiments auftreten können, die Lücken zwischen ihm und den erweiterten Open-Source-Modellen und wie die Wirkung des Modells weiter verbessert werden kann.

1. ChatGPT-bezogene Technologien

ChatGPT ist ein allgemeiner Funktionsassistent. Am 5. Dezember 2022 veröffentlichte Sam Altman, CEO von OpenAI, in den sozialen Medien, dass ChatGPT fünf Tage nach seiner Einführung die Marke von 1 Million Nutzern überschritten habe. Der KI-Chatbot ChatGPT erfreute sich rasanter Beliebtheit und ist zu einem Meilenstein geworden. Microsoft ist in Gesprächen, seinen Anteil um 10 Milliarden US-Dollar zu erhöhen und ihn bald in die Microsoft Cloud zu integrieren.

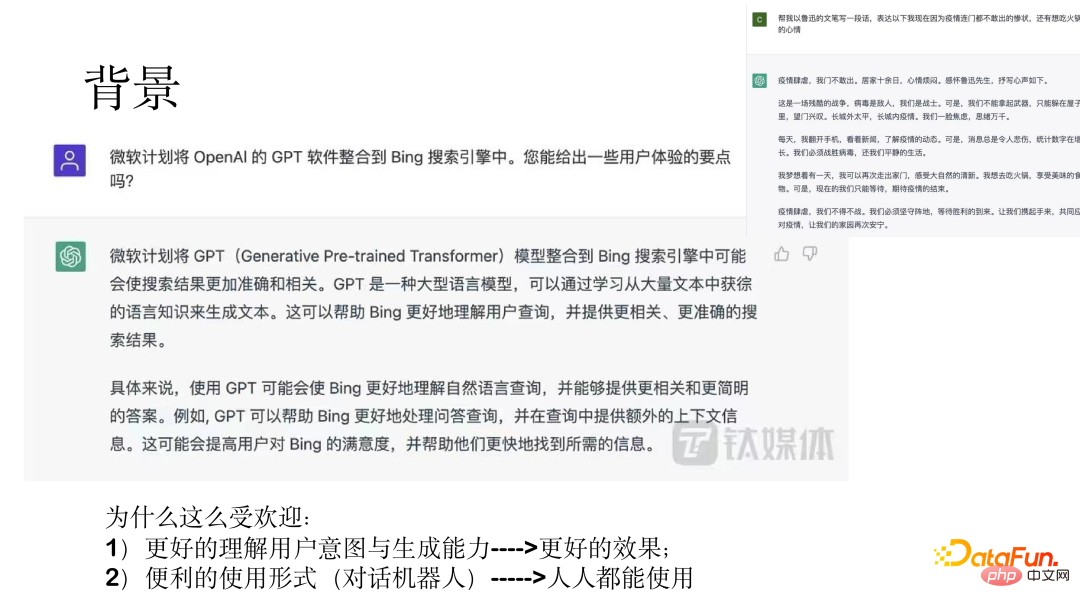

Das obige Bild zeigt zwei Beispiele, die erstaunliche Ergebnisse zeigen.

Der Grund, warum ChatGPT so beliebt ist, ist einerseits seine Fähigkeit, Benutzerabsichten zu verstehen und andererseits durch die Form eines Konversationsroboters, den es nutzen kann; alle.

Im Folgenden werden die Entwicklung des Modells, Probleme mit dem anfänglichen Modell, die drei Phasen des ChatGPT-Modelllernens sowie die Datenorganisation und die Auswirkungen des Trainings des ChatGPT-Modells vorgestellt.

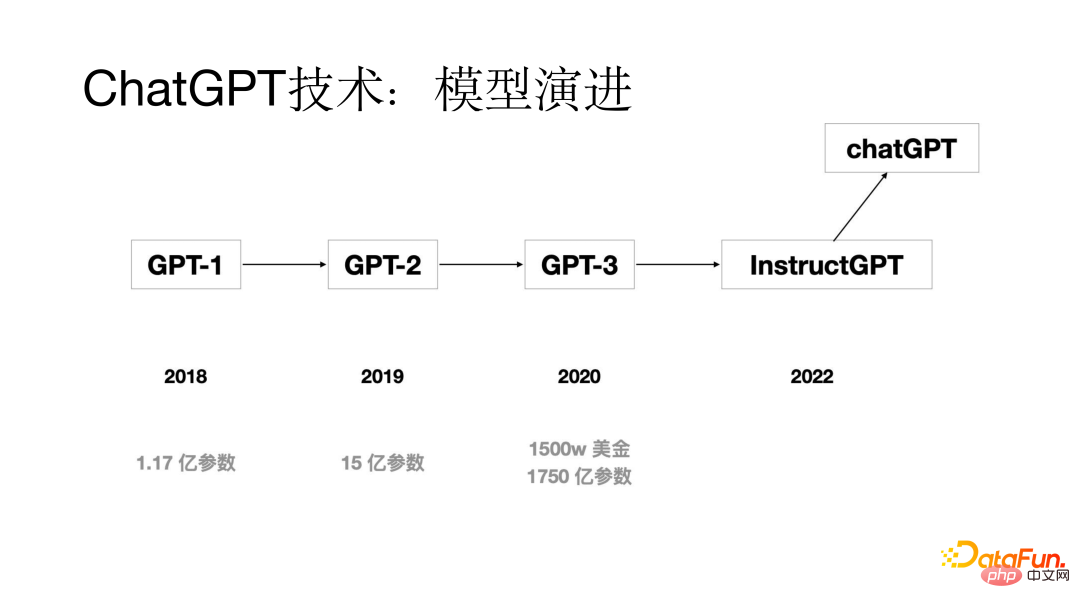

1. Die Modellentwicklung

Das ursprüngliche GPT-Modell wurde 2018 mit nur 117 Millionen Modellparametern weiterentwickelt sind 1,5 Milliarden; bis 2020 haben die GPT-3-Modellparameter durch mehrere Generationen von Modellaktualisierungsiterationen 175 Milliarden erreicht; das ChatGPT-Modell wird 2022 erscheinen.

2. Welche Probleme hatte das Vorgängermodell?

Welche Probleme hatte das Modell, bevor das ChatGPT-Modell herauskam? Durch die Analyse wurde festgestellt, dass eines der offensichtlicheren Probleme das Ausrichtungsproblem ist. Obwohl die Generierungsfähigkeit großer Modelle relativ stark ist, entsprechen die generierten Antworten manchmal nicht den Absichten des Benutzers. Durch Untersuchungen wurde festgestellt, dass der Hauptgrund für das Ausrichtungsproblem darin besteht, dass das Trainingsziel des Sprachmodelltrainings darin besteht, das nächste Wort vorherzusagen, anstatt es gemäß der Absicht des Benutzers zu generieren. Um das Ausrichtungsproblem zu lösen, wird der Reinforcement Learning from Human Feedback (RLHF)-Prozess zum Trainingsprozess des ChatGPT-Modells hinzugefügt.

3. Drei Lernphasen

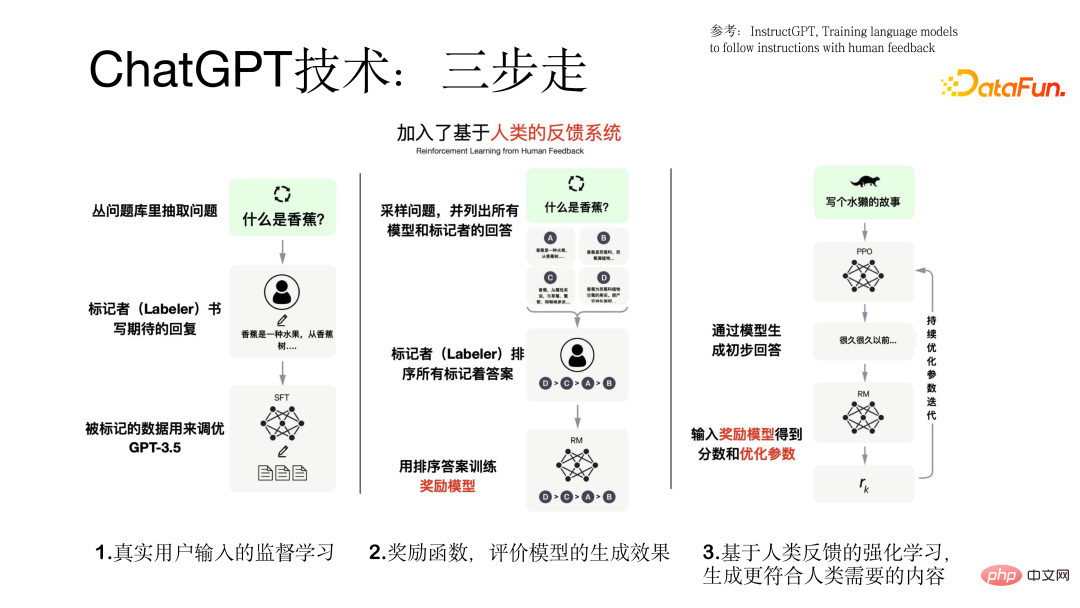

Der Trainingsprozess des ChatGPT-Modells erfolgt in drei Schritten.

Der erste Schritt besteht darin, echte Benutzereingaben für überwachtes Lernen basierend auf dem GPT-Modell zu verwenden. Dabei stammen die Daten von echten Benutzern und die Datenqualität ist relativ hoch und wertvoll.

Der zweite Schritt besteht darin, Für eine Abfrage erzeugen verschiedene Modelle unterschiedliche Ausgabeergebnisse aller Modelle und verwenden diese sortierten Daten, um das Belohnungsmodell zu trainieren.

Der dritte Schritt besteht darin, die vom Modell generierte vorläufige Antwort in das Belohnungsmodell einzugeben. Wenn die generierte Antwort der Absicht des Benutzers entspricht, gibt es andernfalls ein positives Feedback Geben Sie einfach ein negatives Feedback, um das Modell immer besser zu machen. Dies ist der Zweck der Einführung von Verstärkungslernen, um die generierten Ergebnisse besser an die menschlichen Bedürfnisse anzupassen. Der dreistufige Prozess zum Trainieren des ChatGPT-Modells ist in der folgenden Abbildung dargestellt.

4. Datenorganisation und Effektbewertung

Bevor wir das Modell trainieren, müssen wir den verwendeten Datensatz vorbereiten , kann durch die folgenden drei Aspekte gelöst werden :

(1) Sammeln Sie Datensätze, die von Benutzern des alten Systems verwendet werden

(2) Lassen Sie Annotatoren einige Fragen basierend auf vorherigen Eingaben kommentieren von echten Benutzern Ähnliche Eingabeaufforderungen und Ausgaben

(3) Datenannotatoren erstellen einige Eingabeaufforderungen aus Fragen und Antworten, Schreiben von Geschichten, Generierung usw.

Die Daten zum Training des ChatGPT-Modells enthalten drei Teile des Datensatzes (77.000 reale Daten):(1) Überwachte Lerndaten basierend auf echten Benutzeraufforderungen, Benutzeraufforderungen, Modellantwort und Datenmenge ist 13k.

(2) Der zum Trainieren des Belohnungsmodells verwendete Datensatz dient der Sortierung mehrerer Antworten, die einer Eingabeaufforderung entsprechen, und das Datenvolumen beträgt 33.000.

(3) Ein Datensatz, der auf dem Belohnungsmodell basiert und die Reinforcement-Learning-Technologie für das Modelltraining verwendet. Es sind nur Benutzeraufforderungen erforderlich, das Datenvolumen beträgt 31.000 und die Qualitätsanforderungen sind hoch.

Nach Abschluss des ChatGPT-Modelltrainings ist die Bewertung des Modells relativ ausreichend, hauptsächlich unter folgenden Aspekten:(1) Ob die vom Modell generierten Ergebnisse der Absicht des Benutzers entsprechen

(2) Ob die generierten Ergebnisse die vom Benutzer genannten Einschränkungen erfüllen können. (3) Ob das Modell im Bereich Kundenservice gute Ergebnisse erzielen kann. Detaillierte experimentelle Ergebnisse durch Vergleich mit GPT-Basismodell Wie unten gezeigt.

2. Lokalisierung der ChatGPT-Technologie

Im Folgenden wird unsere Lokalisierung der ChatGPT-Technologie unter drei Gesichtspunkten vorgestellt: Hintergrund und Probleme, Lösungsideen, Auswirkungen und Praxis. 1. Hintergrund und Probleme Die Wirkung ist relativ gut, es werden jedoch keine Dienstleistungen für das chinesische Festland angeboten.(2) Es ist möglicherweise nicht in der Lage, die Bedürfnisse inländischer Unternehmenskunden zu erfüllen und kann keinen lokalisierten technischen Support und keine Dienstleistungen anbieten.

(3) Der Preis wird in Europa und den Vereinigten Staaten als Hauptmärkten angegeben. Der Preis ist relativ hoch und die meisten inländischen Benutzer können ihn sich möglicherweise nicht leisten. Durch Tests wurde festgestellt, dass jedes Datenelement etwa 0,5 Yuan kostet und eine Kommerzialisierung für Kunden mit großen Datenmengen unmöglich ist.

Aufgrund der oben genannten drei Probleme haben wir versucht, die ChatGPT-Technologie zu lokalisieren.

2. Lösungsidee

Wir haben bei der Lokalisierung der ChatGPT-Technologie eine verteilte Strategie übernommen.

Zuerst wurde ein chinesisches Vortrainingsmodell mit Dutzenden von Milliarden Parametern trainiert; zweitens wurde aufgabenüberwachtes Lernen mit Prompt auf Aufgabendaten auf Milliardenebene durchgeführt, und dann wurde das Modell konversiert, d. h. in der Form des Dialogs oder der Mensch-Computer-Interaktion. Schließlich stellen wir die RLHF-Technologie des Verstärkungslernens des Belohnungsmodells und des Benutzerfeedbacks vor.

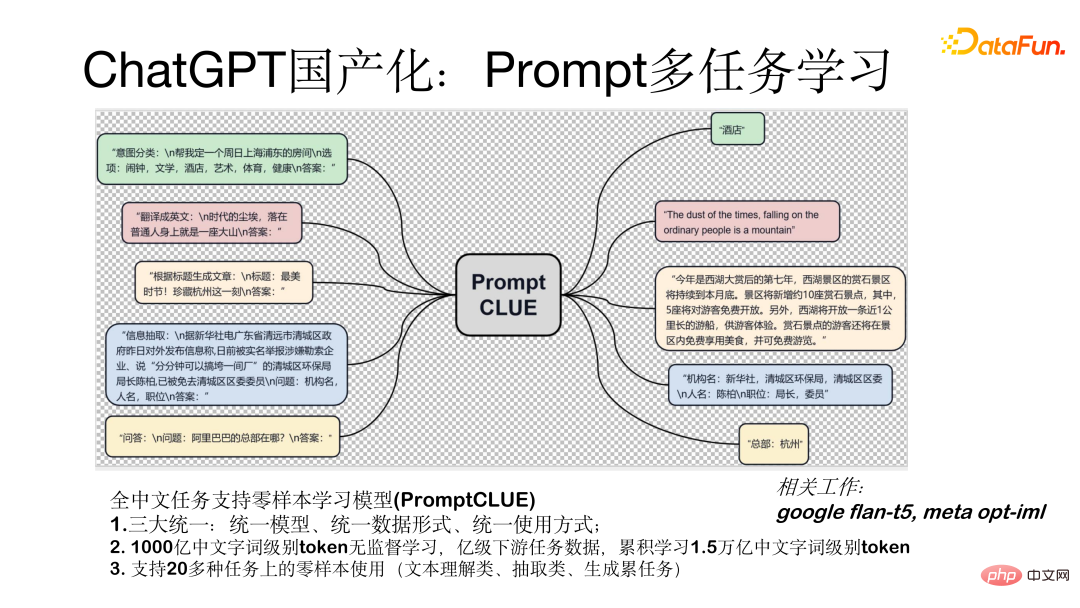

Prompt Multi-Task-Lernmodell (PromptCLUE) ist ein Modell, das Zero-Shot-Lernen für alle chinesischen Aufgaben unterstützt. Dieses Modell erreicht drei Hauptvereinheitlichungen: ein einheitliches Modell, eine einheitliche Datenform (alle Aufgaben werden in eine Eingabeaufforderungsform umgewandelt) und eine einheitliche Verwendungsmethode (wird in einer Nullstichprobenform verwendet). Das Modell basiert auf dem unbeaufsichtigten Lernen von 100 Milliarden chinesischen Token auf Wortebene. Es wird auf nachgelagerten Aufgabendaten auf Milliardenebene trainiert und hat 1,5 Billionen chinesische Token auf Wortebene angesammelt. Unterstützt die Verwendung von Nullproben bei mehr als 20 Aufgaben (Aufgaben zum Verstehen, Extrahieren und Generieren von Texten).

Wie kann man das Modell konversationsfähig machen, das heißt, es in ein Modell in Form einer Mensch-Computer-Interaktion umwandeln:

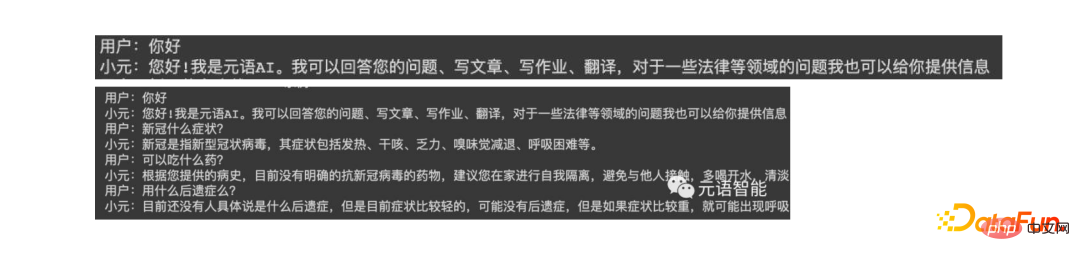

Zunächst der Reihe nach Um dem Modell einen besseren Generierungseffekt zu verleihen, haben wir Textverständnis- und Extraktionsaufgaben entfernt und so das Lernen von Frage- und Antwort-, Dialog- und Generierungsaufgaben gestärkt. Zweitens werden die Generierungsergebnisse nach der Konvertierung in ein Dialogmodell durch den Kontext beeinträchtigt Um dieses Problem anzugehen, haben wir Anti-Interferenz-Daten hinzugefügt, die es dem Modell ermöglichen, bei Bedarf irrelevante Kontexte zu ignorieren. Schließlich fügen wir einen Lernprozess hinzu, der auf echten Benutzer-Feedback-Daten basiert, damit das Modell die Absichten des Benutzers besser verstehen kann. Die folgende Abbildung zeigt die Form des Ein- und Mehrrundentests mit dem Modell.

3. Auswirkungen und Praxis

Das Folgende ist die Auswirkung des Testens des Modells mit dem ChatGPT-Modell, es gibt jedoch noch eine Lücke von 1 bis 2 Jahren Diese Lücke kann nach und nach geschlossen werden. Derzeit haben wir einige nützliche Versuche unternommen und bestimmte Ergebnisse erzielt. Derzeit können wir einige Interaktionen durchführen, z. B. Dialoge, Fragen und Antworten sowie Schreiben. Das Bild unten zeigt die Testergebnisse. 3. Inländisches Open-Source-Großmodell ist ein Modell mit 10 Milliarden Parametern und wurde auf mehreren Plattformen eingeführt, darunter Huggingface, ModelScope, Github und Paddlepaddle. Modelle können lokal heruntergeladen und anhand Ihres eigenen Benutzerdatensatzes verfeinert werden. Es wird weiter trainiert, basierend auf PromptCLUE-large, kombiniert mit Hunderten Millionen funktionaler Dialog-Mehrrunden-Dialogdaten.

Oben wird die Huggingface-Plattform als Beispiel verwendet, um zu zeigen, wie das Modell lokal verwendet wird. Durchsuchen Sie ChatYuan auf der Plattform, laden Sie das Modell und führen Sie eine einfache Verpackung durch. Es werden einige wichtige Parameter verwendet, z. B. ob Proben entnommen werden sollen. Wenn Sie verschiedene Proben generieren müssen, müssen Sie Proben erstellen.

2. Um ein lokales Modell basierend auf Ihren eigenen Daten zu trainieren

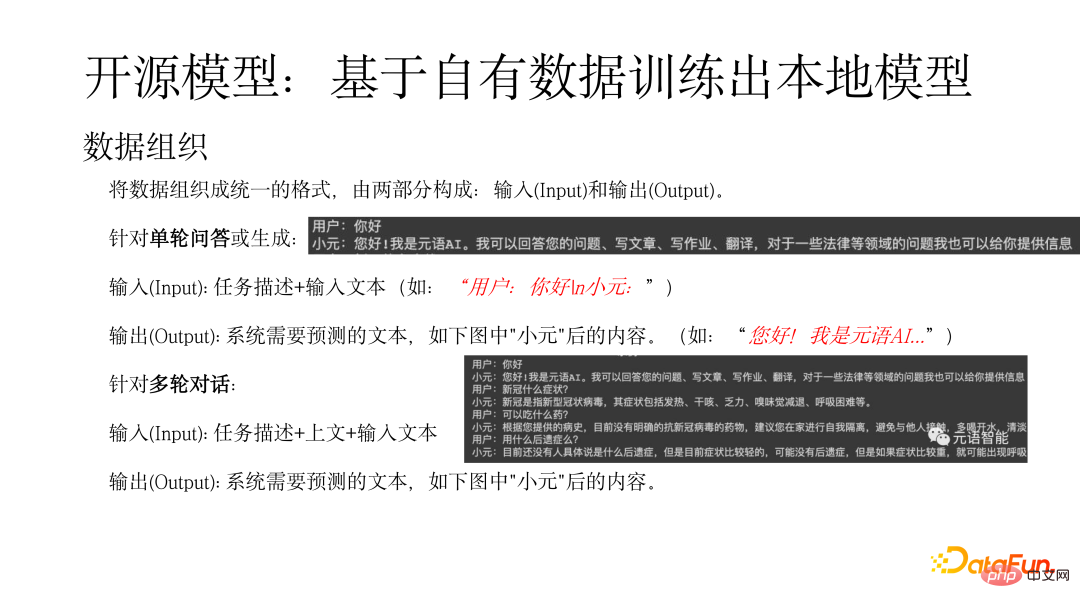

Zuerst müssen Sie die Daten in einer einheitlichen Form organisieren, die aus zwei Teilen besteht: Eingabe (Eingabe) und Ausgabe (Ausgabe). Für eine einzelne Frage- und Antwortrunde oder eine generierte Eingabe (Eingabe): Aufgabenbeschreibung + Eingabetext (z. B. „Benutzer: Hallo n Xiaoyuan:“) bezieht sich die Ausgabe (Ausgabe) auf den Text, den das System vorhersagen muss (z. B als: „Hallo! Es ist Metasprachen-KI ...“). Bei der Mehrrunden-Dialogeingabe (Eingabe): Aufgabenbeschreibung + oben + Eingabetext. Die Ausgabe bezieht sich auf den Text, den das System vorhersagen muss, z. B. den Inhalt nach „Xiaoyuan“ in der folgenden Abbildung.

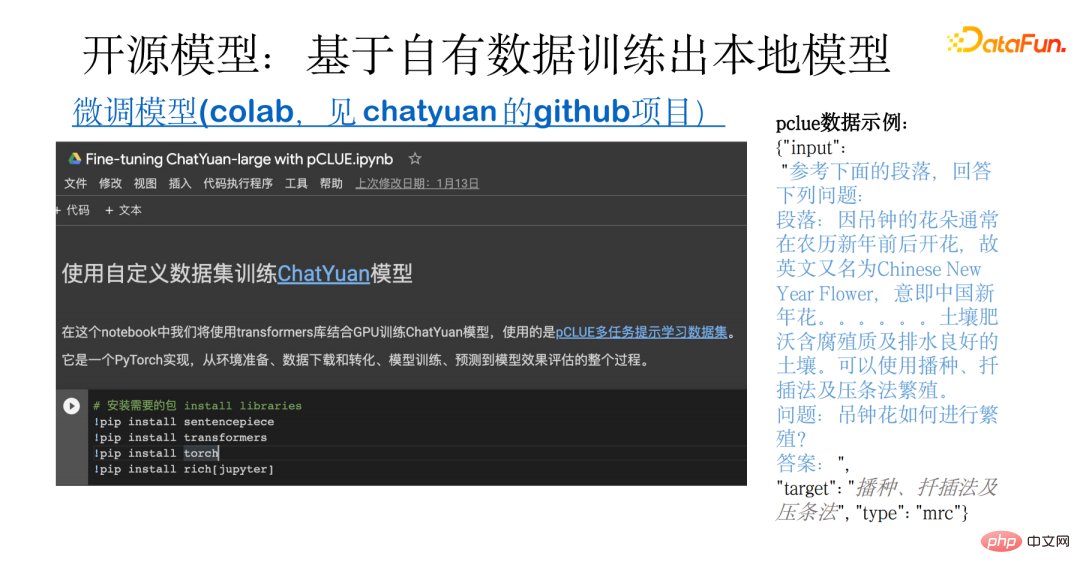

Die folgende Abbildung zeigt ein Beispiel für das Training eines lokalen Modells basierend auf Ihren eigenen Daten. Dieses Beispiel deckt den gesamten Prozess ab, von der Datenvorbereitung über das Herunterladen und Konvertieren von Open-Source-Daten bis hin zum Modelltraining, der Vorhersage und der Auswertung. Grundlage ist der pCLUE-Multitask-Datensatz. Benutzer können ihre eigenen Daten für das Training verwenden oder pCLUE für ein vorläufiges Training verwenden, um die Wirkung zu testen. 3. Mögliche Probleme, Lücken und wie man die Wirkung weiter verbessern kann wie Recht und Medizin, Interaktion und Generierung. Im Vergleich zum ChatGPT-Modell besteht immer noch eine gewisse Lücke, die sich hauptsächlich in den folgenden Aspekten widerspiegelt: Der Wert von ChatYuan liegt im zweistelligen Milliardenbereich.

Während der Verwendung des Modells können Probleme mit dem Generierungseffekt und der Textlänge auftreten. Dies hängt davon ab, ob das Datenformat korrekt ist, ob während des Generierungsprozesses Stichproben abgetastet werden und wie lang das Ausgabeergebnis ist gesteuert durch max_length usw.

- Um den Modelleffekt weiter zu verbessern, können Sie von folgenden Aspekten ausgehen: (1) Kombinieren Sie mit Branchendaten für weiteres Training, einschließlich unbeaufsichtigtem Vortraining, und verwenden Sie eine große Menge von hochwertigen Daten Überwachtes Lernen.

- (2) Durch Lernen anhand realer Benutzer-Feedback-Daten können Verteilungsunterschiede ausgeglichen werden.

- (3) Führen Sie verstärkendes Lernen ein, um die Absichten der Benutzer aufeinander abzustimmen.

(4) Wählen Sie ein größeres Modell. Generell gilt: Je größer das Modell, desto stärker ist die Modellfähigkeit.

Die neuen Technologien und Nutzungsszenarien von ChatGPT haben es den Menschen ermöglicht, das enorme Potenzial von KI zu erkennen. Weitere Anwendungen werden aktualisiert, wodurch Möglichkeiten für einige neue Anwendungen entstehen.

Yuanyu Intelligence ist als großer Model-as-a-Service-Dienstleister auch in diesem Bereich ständig auf der Suche. Interessierte Partner sind herzlich eingeladen, unsere Website und unseren offiziellen Account zu besuchen. Das war's für das heutige Teilen, vielen Dank an alle.

Das obige ist der detaillierte Inhalt vonEin Versuch, die ChatGPT-Technologie zu lokalisieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr