Heim >Technologie-Peripheriegeräte >KI >Anleitung zur Verwendung des ChatGPT-Plug-ins, um ein neues Interneterlebnis freizuschalten

Anleitung zur Verwendung des ChatGPT-Plug-ins, um ein neues Interneterlebnis freizuschalten

- PHPznach vorne

- 2023-04-01 22:07:373714Durchsuche

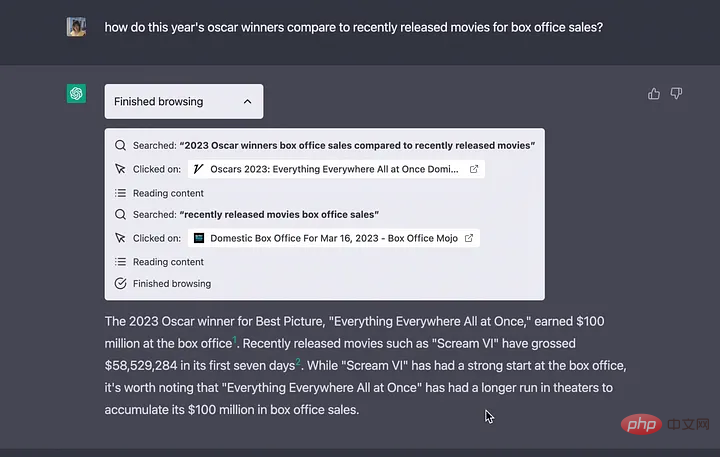

Die Wissensdatenbank von ChatGPT wurde mit Daten vom September 2021 trainiert, aber durch die Verwendung dieser Plugins ist ChatGPT nun in der Lage, das Web nach den neuesten Antworten zu durchsuchen, wodurch die Einschränkungen aufgehoben werden, die durch die alleinige Abhängigkeit von seiner Wissensdatenbank entstehen.

Vor Kurzem hat OpenAI eine neue Funktion von ChatGPT veröffentlicht: das Plug-in-System. ChatGPT kann jetzt um Funktionen erweitert werden und neue Aufgaben ausführen, wie zum Beispiel:

- Echtzeitinformationen abrufen: zum Beispiel Sportergebnisse, Aktienkurse, aktuelle Nachrichten usw.

- Wissensdatenbankinformationen abrufen: zum Beispiel Firmendokumente, persönliche Notizen usw.

- Aktionen im Namen des Benutzers ausführen: zum Beispiel einen Flug buchen, Essen bestellen usw.

Die Wissensdatenbank von ChatGPT wurde mit Daten vom September 2021 trainiert, aber durch die Verwendung dieser Plugins ist ChatGPT nun in der Lage, das Web nach den neuesten Antworten zu durchsuchen, wodurch die Einschränkungen aufgehoben werden, die sich aus der ausschließlichen Verwendung seiner Wissensdatenbank ergeben.

Benutzerdefinierte Plugins erstellen

OpenAI ermöglicht es jedem Entwickler auch, eigene Plugins zu erstellen. Obwohl sich Entwickler derzeit auf eine Warteliste setzen müssen (https://openai.com/waitlist/plugins), sind die Dateien zum Erstellen von Plugins bereits verfügbar.

Weitere Informationen zum Plug-in-Prozess finden Sie auf dieser Seite (https://platform.openai.com/docs/plugins/introduction).

Beispielcode finden Sie auf dieser Seite (https://platform.openai.com/docs/plugins/examples).

Die Dokumentation zeigt nur, wie die Integration zwischen der Drittanbieter-API und ChatGPT funktioniert. Der folgende Artikel untersucht das Innenleben dieser Integration:

„Wie führen große Sprachmodelle Operationen ohne entsprechendes Training durch?“

Einführung in LangChain

LangChain ist ein Framework zum Erstellen von Chatbots, generative Frage Beantwortung, Zusammenfassung und mehr

LangChain ist ein Tool, das 2022 von Harrison Chase (hwchase17) entwickelt wurde, um Entwickler bei der Integration von Anwendungen von Drittanbietern in die Mitte großer Sprachmodelle (LLM) zu unterstützen.

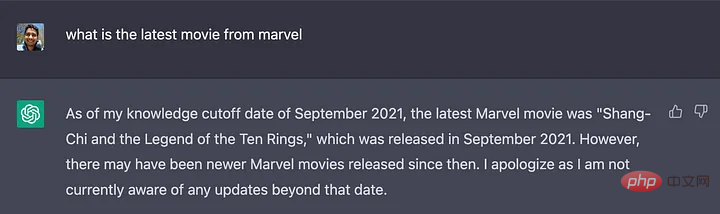

Leihen Sie sich das unten gezeigte Beispiel aus, um den Arbeitsmodus zu erklären:

import os

os.environ["SERPAPI_API_KEY"] = "

os.environ["OPENAI_API_KEY"] = "

von langchain.agents import load_tools

von langchain.agents import initialize_agent

von langchain.llms import OpenAI

# Laden Sie zunächst das Sprachmodell, das zur Steuerung des Agenten verwendet werden soll

llm = OpenAI(temperature=0)

# Weiter Kommen Sie vorbei und laden Sie einige Werkzeuge zur Verwendung ein. Bitte beachten Sie, dass das Tool llm-math LLM verwendet, daher müssen Sie es übergeben

tools = load_tools(["serpapi", "llm-math"], llm=llm)

# Verwenden Sie abschließend die Tools, das Sprachmodell und möchte den Agententyp verwenden, um den Agenten zu initialisieren

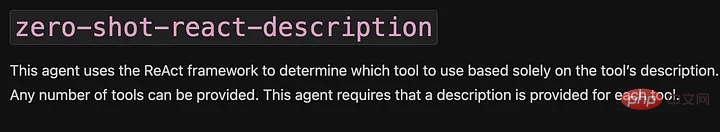

agent = initialize_agent(tools, llm, agent="zero-shot-react-description", verbose=True)

# Jetzt testen

agent.run("Wer ist Olivia Wildes Freund? Wie alt ist er derzeit hoch 0,23?")

Drei Hauptteile sind aus diesem Beispiel ersichtlich:

- LLM: LLM ist eine Kernkomponente von LangChain, die dem Agenten hilft, natürliche Sprache zu verstehen. In diesem Beispiel wird das Standardmodell von OpenAI verwendet. Laut Quellcode (https://github.com/hwchase17/langchain/blob/master/langchain/llms/openai.py#L133) ist das Standardmodell text-davinci-003.

- Agent: Der Agent entscheidet mithilfe von LLM, welche Aktionen er in welcher Reihenfolge durchführt. Eine Aktion kann darin bestehen, ein Tool zu verwenden und seine Ausgabe zu beobachten, oder eine Antwort an den Benutzer zurückzugeben.

Hier wird die 0-Shot-React-Beschreibung verwendet. In der Dokumentation können Sie nachlesen, dass „dieser Agent das ReAct-Framework verwendet und ausschließlich auf der Grundlage der Beschreibung des Tools entscheidet, welches Tool verwendet werden soll.“

- Tools: Funktionen, mit denen Agenten mit der Welt interagieren können. In diesem Beispiel werden zwei Tools verwendet:

serpapi: ein Wrapper um die https://serpapi.com/ API. Es wird zum Surfen im Internet verwendet.

llm-math: Ermöglicht dem Agenten die Beantwortung mathematischer Fragen in Eingabeaufforderungen, z. B. „Wie alt ist er derzeit hoch 0,23?“

Wenn das Skript ausgeführt wird, führt der Agent verschiedene Dinge aus, wie z. B. herauszufinden, wer Olivia Wildes Freund ist, seinen Namen extrahieren, Harry Styles Alter erfragen, eine Suche durchführen und 29^0,23 mit dem llm-math-Tool berechnen, das ist 2,16.

Der größte Vorteil von LangChain besteht darin, dass es nicht auf einen einzelnen Anbieter angewiesen ist, wie in der Dokumentation beschrieben (https://python.langchain.com/en/latest/modules/llms/integrations.html).

Warum kann LangChain leistungsstarke Funktionen für das ChatGPT-Plug-in-System bereitstellen?

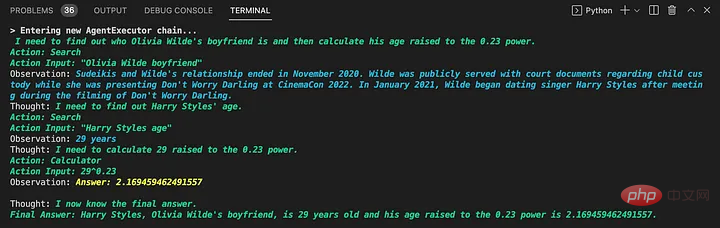

Am 21. März veröffentlichte Microsoft, OpenAIs stärkster Partner, MM-REACT und enthüllte die multimodalen Überlegungen und Aktionen von ChatGPT (https://github.com/microsoft/MM-REACT).

Wenn man sich die Fähigkeiten dieses „Systemparadigmas“ ansieht, erkennt man, dass jedes Beispiel eine Interaktion zwischen einem Sprachmodell und einer externen Anwendung beinhaltet.

Anhand des bereitgestellten Beispielcodes (https://github.com/microsoft/MM-REACT/blob/main/sample.py) können wir erkennen, dass die Implementierung der Interaktion zwischen Modell und Tools erfolgt Hergestellt von LangChain. In der Datei README.md (https://github.com/microsoft/MM-REACT/blob/main/README.md) heißt es außerdem, dass „der Code von MM-REACT auf Langchain basiert“.

Kombiniert man diese Beweise und die Tatsache, dass in der ChatGPT-Plugin-Dokumentation erwähnt wird, dass „Plugin-Beschreibungen, API-Anfragen und API-Antworten alle in Konversationen mit ChatGPT eingefügt werden“, kann man davon ausgehen, dass das Plugin-System verschiedene Plugins als Proxy-Tools hinzufügt. in diesem Fall ist es ChatGPT.

Es ist auch möglich, dass OpenAI ChatGPT in einen Proxy vom Typ Zero-Shot-React-Description umgewandelt hat, um diese Plug-Ins zu unterstützen (den Typ, den wir im vorherigen Beispiel gesehen haben). Da die Beschreibung der API in die Konversation eingefügt wird, entspricht dies den Erwartungen des Agenten, wie im folgenden Dokumentationsauszug zu sehen ist.

LangChain

Fazit

Obwohl das Plug-in-System noch nicht für Benutzer geöffnet ist, können Sie die veröffentlichten Dokumente und MM-REACT verwenden, um die leistungsstarken Funktionen des ChatGPT-Plug-in-Systems zu erleben.

Das obige ist der detaillierte Inhalt vonAnleitung zur Verwendung des ChatGPT-Plug-ins, um ein neues Interneterlebnis freizuschalten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr