Heim >Technologie-Peripheriegeräte >KI >„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum

„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum

- PHPznach vorne

- 2023-04-01 11:48:262084Durchsuche

ChatGPT versteht auch menschliche Tricks, wenn es um die Generierung von Zufallszahlen geht.

ChatGPT ist vielleicht ein Bullshit-Künstler und ein Verbreiter von Fehlinformationen, aber es ist kein „Mathematiker“!

Kürzlich hat Colin Fraser, ein Datenwissenschaftler bei Meta, herausgefunden, dass ChatGPT keine echten Zufallszahlen generieren kann, sondern eher „menschlichen Zufallszahlen“ ähnelt.

Durch Experimente kam Fraser zu dem Schluss: „ChatGPT mag die Zahlen 42 und 7 sehr.“

Netizens sagten, dass dies bedeutet, dass Menschen diese Zahlen sehr mögen.

ChatGPT liebt auch „Die ultimative Antwort auf das Universum“

In seinem Test gab Fraser die Eingabeaufforderung wie folgt ein:

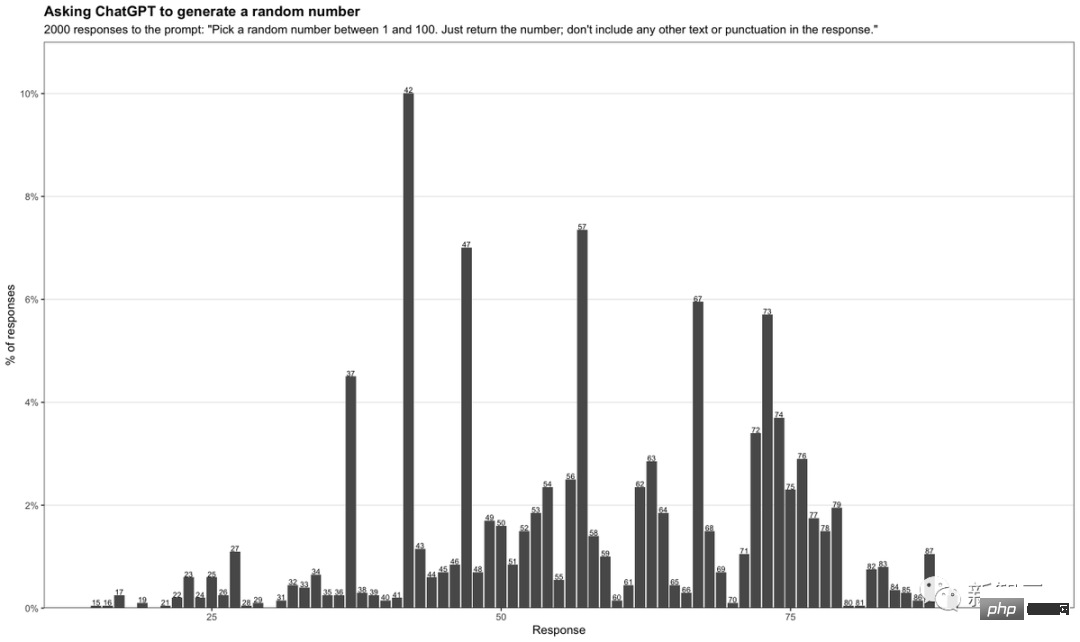

「Wählen Sie eine Zufallszahl zwischen 1 und 100. Geben Sie die Zahl einfach zurück Indem er ChatGPT jedes Mal aufforderte, eine Zufallszahl zwischen 1 und 100 zu generieren, sammelte Fraser 2.000 verschiedene Antworten und stellte sie in einer Tabelle zusammen.

Sie sehen, dass die Zahl 42 mit bis zu 10 % am häufigsten vorkommt. Darüber hinaus kommen Zahlen mit 7 sehr häufig vor.

Besonders die Zahlen zwischen 71-79 haben eine höhere Häufigkeit. Bei Zahlen außerhalb dieses Bereichs erscheint häufig auch die 7 als zweite Ziffer.

Was bedeutet 42?

Was bedeutet 42?

Jeder, der Douglas Adams‘ Blockbuster-Science-Fiction-Roman „Per Anhalter durch die Galaxis“ gelesen hat, weiß, dass 42 „die ultimative Antwort auf das Leben, das Universum und alles“ ist.

Vereinfacht ausgedrückt sind 42 und 69 Meme-Nummern im Internet. Dies zeigt, dass ChatGPT eigentlich kein Zufallszahlengenerator ist, sondern lediglich beliebte Zahlen im Leben aus riesigen online gesammelten Datensätzen auswählt.

Vereinfacht ausgedrückt sind 42 und 69 Meme-Nummern im Internet. Dies zeigt, dass ChatGPT eigentlich kein Zufallszahlengenerator ist, sondern lediglich beliebte Zahlen im Leben aus riesigen online gesammelten Datensätzen auswählt.

Außerdem erscheint 7 häufig, was genau widerspiegelt, dass ChatGPT auf menschliche Vorlieben eingeht.

In der westlichen Kultur gilt die 7 allgemein als Glückszahl, und es gibt ein Sprichwort von der Glückszahl 7. Genauso wie wir von der Zahl 8 besessen sind.

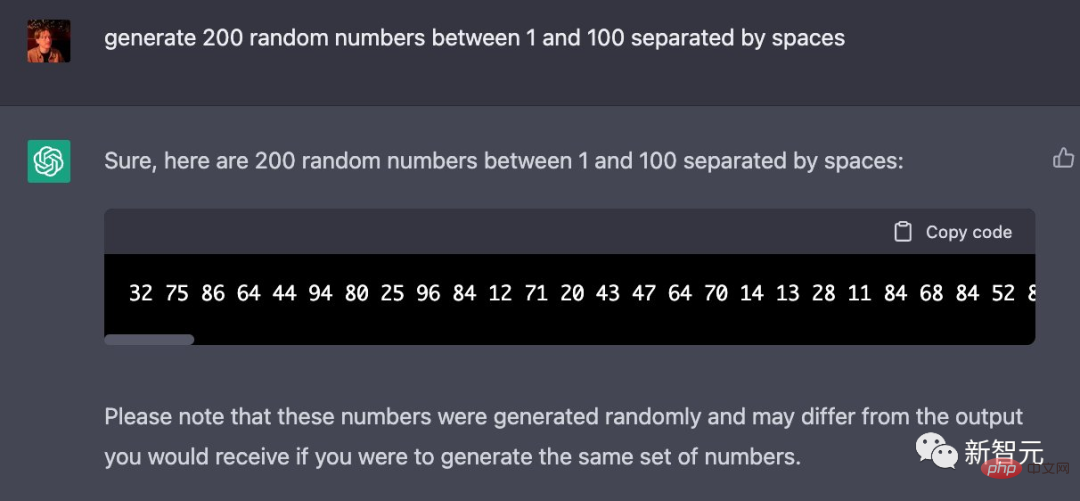

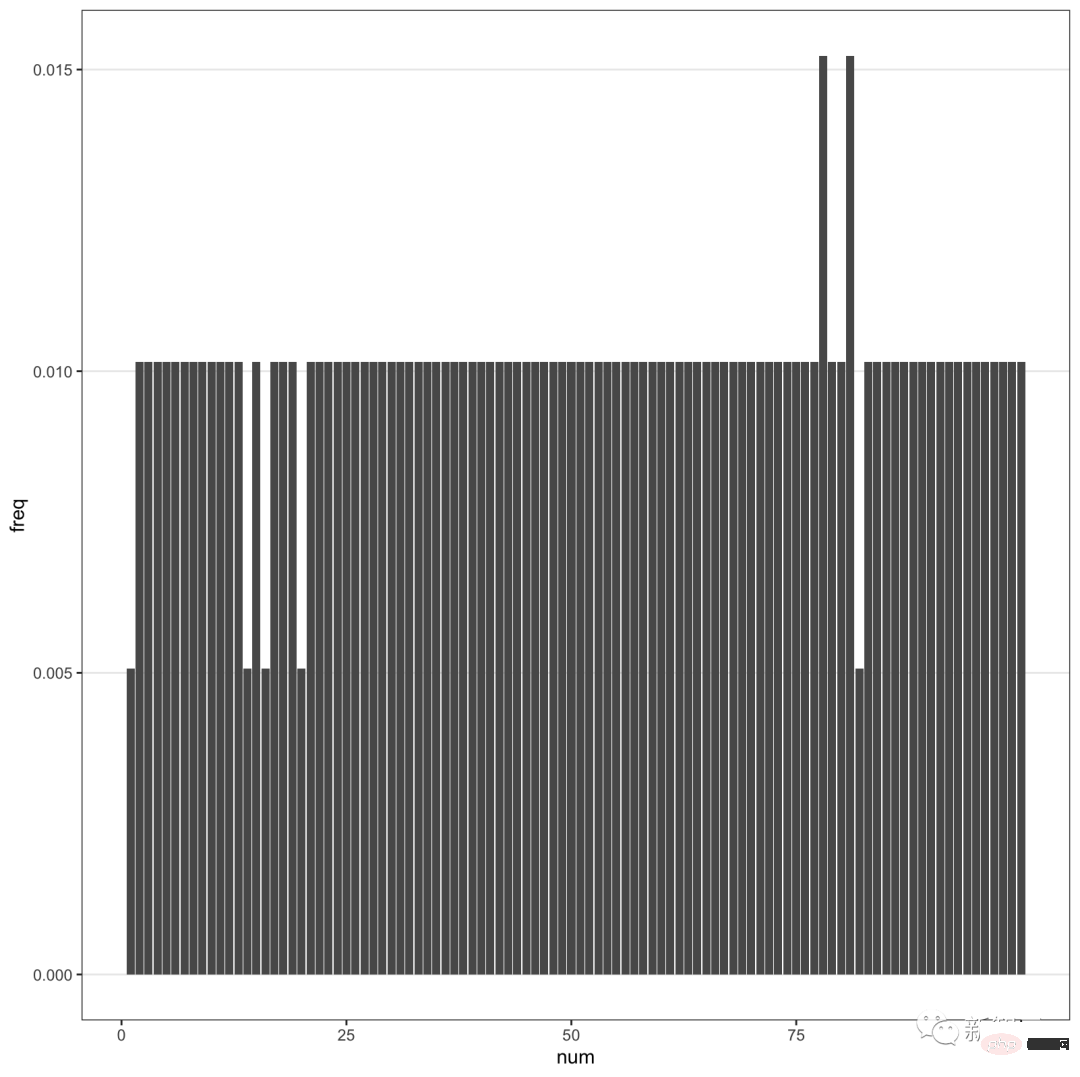

Interessanterweise hat Fraser auch herausgefunden, dass GPT-4 dies zu kompensieren scheint.

Wenn GPT-4 nach mehr Zahlen gefragt wird, sind die zurückgegebenen Zufallszahlen zu gleichmäßig verteilt.

Wenn GPT-4 nach mehr Zahlen gefragt wird, sind die zurückgegebenen Zufallszahlen zu gleichmäßig verteilt.

Kurz gesagt, ChatGPT gibt eine Antwort grundsätzlich durch Vorhersage, anstatt tatsächlich zu „denken“, um eine Antwort zu finden.

Kurz gesagt, ChatGPT gibt eine Antwort grundsätzlich durch Vorhersage, anstatt tatsächlich zu „denken“, um eine Antwort zu finden.

Man sieht, dass ein Chatbot, der als nahezu allmächtig angepriesen wird, immer noch etwas albern ist.

Lassen Sie es einen Roadtrip für Sie planen und Sie werden in einer Stadt Halt machen, die es gar nicht gibt. Oder lassen Sie es eine Zufallszahl ausgeben und treffen Sie höchstwahrscheinlich eine Entscheidung auf der Grundlage eines beliebten Memes.

Einige Internetnutzer haben es selbst ausprobiert und festgestellt, dass GPT-4 42 mag.

Wenn ChatGPT am Ende nur Online-Klischees wiederholt, welchen Sinn hat es dann?

GPT-4 verstößt gegen die Regeln des maschinellen Lernens

Die Geburt von GPT-4 ist aufregend, aber auch enttäuschend.

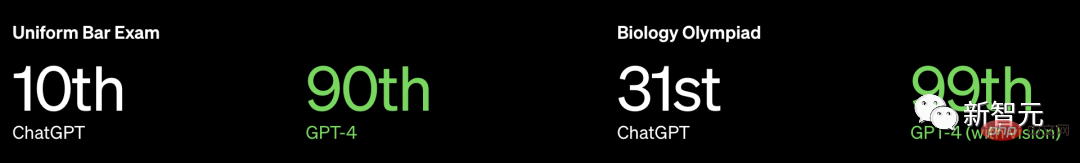

OpenAI hat nicht nur keine weiteren Informationen zu GPT-4 veröffentlicht, es hat nicht einmal die Größe des Modells bekannt gegeben, sondern auch betont, dass seine Leistung Menschen in vielen professionellen und standardisierten Untersuchungen überfordert.

Nehmen Sie als Beispiel die einheitliche Prüfung zur Anwaltslizenz in den USA, GPT3.5 kann das 10-Prozent-Niveau erreichen, und GPT4 kann das 90-Prozent-Niveau erreichen.

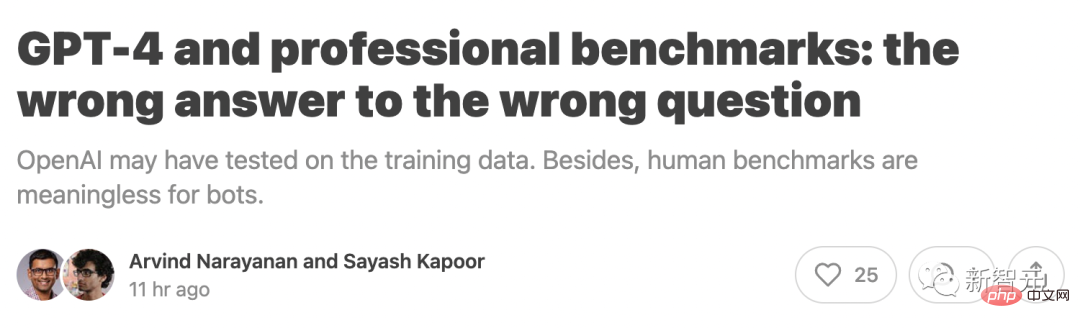

Professor Arvind Narayanan und Doktorand Sayash Kapoor vom Fachbereich Informatik der Princeton University schrieben jedoch, dass

Professor Arvind Narayanan und Doktorand Sayash Kapoor vom Fachbereich Informatik der Princeton University schrieben jedoch, dass

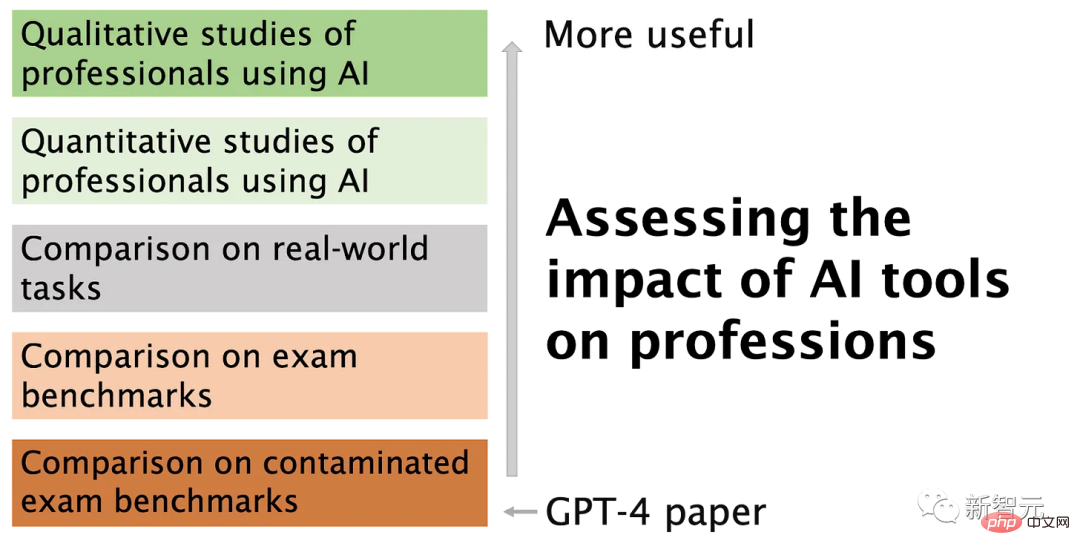

OpenAI möglicherweise anhand der Trainingsdaten getestet wurde. Darüber hinaus sind menschliche Benchmarks für Chatbots bedeutungslos.

Insbesondere verstößt OpenAI möglicherweise gegen eine Grundregel des maschinellen Lernens: Testen Sie nicht anhand von Trainingsdaten. Sie müssen wissen, dass Testdaten und Trainingsdaten getrennt werden müssen, da sonst Überanpassungsprobleme auftreten.

Insbesondere verstößt OpenAI möglicherweise gegen eine Grundregel des maschinellen Lernens: Testen Sie nicht anhand von Trainingsdaten. Sie müssen wissen, dass Testdaten und Trainingsdaten getrennt werden müssen, da sonst Überanpassungsprobleme auftreten.

Abgesehen von diesem Problem gibt es noch ein größeres Problem.

Sprachmodelle lösen Probleme anders als Menschen, daher haben diese Ergebnisse wenig Aussagekraft darüber, wie gut ein Roboter bei realen Problemen von Profis abschneiden wird. Die Aufgabe eines Anwalts besteht nicht darin, den ganzen Tag Fragen zu Anwaltsprüfungen zu beantworten.

Problem 1: Kontamination von Trainingsdaten

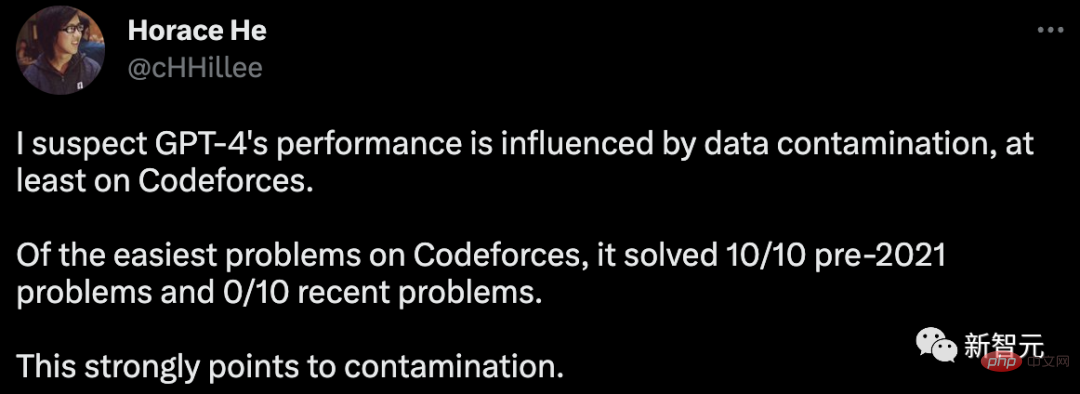

Um die Programmierfähigkeiten von GPT-4 zu bewerten, wurde OpenAI auf Codeforces, einer Website für russische Programmierwettbewerbe, evaluiert.

Überraschenderweise hat Horace online darauf hingewiesen, dass GPT-4 in der einfachen Klassifizierung 10 Probleme vor 2021 gelöst hat, aber keines der 10 jüngsten Probleme gelöst wurde.

Die Trainingsdatenfrist für GPT-4 endet im September 2021.

Dies impliziert stark, dass das Modell in der Lage ist, sich die Lösungen in seinem Trainingssatz zu merken oder sich zumindest teilweise an sie zu erinnern, und zwar ausreichend, um das auszufüllen, woran es sich nicht erinnern kann.

Um weitere Beweise für diese Hypothese zu liefern, testete Arvind Narayanan GPT-4 zu verschiedenen Zeitpunkten im Jahr 2021 auf Codeforces-Wettbewerbsprobleme.

Es wurde festgestellt, dass GPT-4 einfache Klassifizierungsprobleme vor dem 5. September lösen kann, aber keines der Probleme nach dem 12. September gelöst wurde.

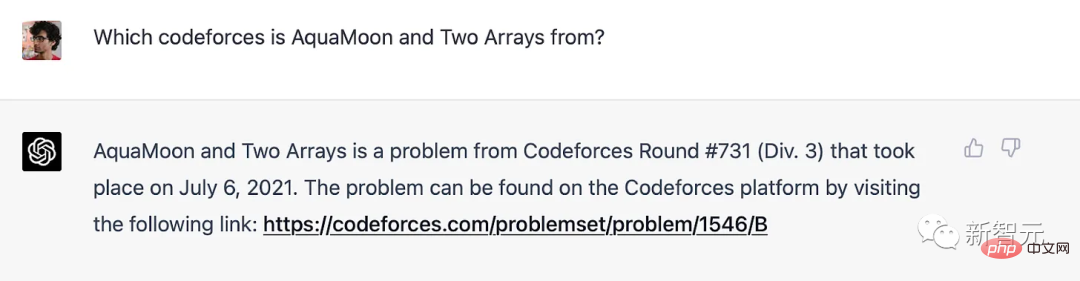

Tatsächlich können wir deutlich zeigen, dass Probleme im Trainingssatz gespeichert wurden: Wenn GPT-4 mit dem Titel eines Codeforces-Problems aufgefordert wird, enthält es einen Link zu der genauen Übereinstimmung, bei der das Problem aufgetreten ist. Es ist erwähnenswert, dass GPT-4 keinen Zugang zum Internet hat, daher ist der Speicher die einzige Erklärung.

GPT-4 merkt sich Codeforce-Probleme vor der Schulungsfrist

Für andere Benchmarks als die Programmierung sagte Professor Narayanan: „Wir wissen nicht, wie wir Probleme klar nach Zeiträumen trennen können, daher ist OpenAI schwer zu vermeiden.“ Aus dem gleichen Grund können wir keine Experimente durchführen, um zu testen, wie sich die Leistung mit Daten ändert. Wenn es sich um das Gedächtnis handelt, muss GPT sehr empfindlich auf die Formulierung von Fragen reagieren.

Im Februar gab Melanie Mitchell, Professorin am Santa Fe Institute, ein Beispiel für eine MBA-Prüfungsfrage. Eine geringfügige Änderung einiger Details reicht aus, um ChatGPT (GPT-3.5) zu täuschen, und diese Methode ist für eine Person nicht effektiv. Getäuscht werden.

Detailliertere Experimente wie dieses wären wertvoll.

Aufgrund der mangelnden Transparenz von OpenAI kann Professor Narayanan nicht mit Sicherheit sagen, dass es sich um ein Problem der Datenverschmutzung handelt. Sicher ist jedoch, dass der Ansatz von OpenAI zur Erkennung von Kontaminationen schlampig ist:

„Wir verwenden eine Teilstring-Matching-Methode, um Kreuzkontaminationen zwischen dem Bewertungsdatensatz und den Vortrainingsdaten zu messen, um alle zu entfernen.“ Leerzeichen und Symbole, nur Zeichen (einschließlich Zahlen) werden beibehalten. Für jedes Bewertungsbeispiel wählen wir zufällig drei Teilzeichenfolgen mit einer Länge von 50 Zeichen aus (wenn das Beispiel weniger als 50 Zeichen lang ist, wird das gesamte Beispiel verwendet). Die Bewertungsteilzeichenfolge ist eine Teilzeichenfolge des verarbeiteten Trainingsbeispiels. Wir verwerfen diese Beispiele und führen sie erneut aus, um eine makellose Bewertung zu erhalten.

Wenn das Testproblem im Trainingssatz vorhanden ist, Name und Nummer jedoch geändert wurden, kann es nicht erkannt werden. Jetzt ist eine zuverlässigere Methode verfügbar, beispielsweise der Einbettungsabstand.

Wenn OpenAI die Einbettungsdistanzmethode verwenden möchte, wie viel Ähnlichkeit wird dann als zu ähnlich angesehen? Auf diese Frage gibt es keine objektive Antwort.

Auch wenn die Durchführung eines standardisierten Multiple-Choice-Tests einfach erscheint, ist eine Menge Subjektivität im Spiel.

Problem 2: Professionelle Prüfungen sind keine effektive Möglichkeit, die Fähigkeiten von Menschen und Robotern zu vergleichen.Das Gedächtnis ist wie ein Spektrum, auch wenn das Sprachmodell keine genaue Frage im Trainingssatz gesehen hat, ist dies aufgrund der unvermeidlichen riesiger Trainingskorpus Habe viele sehr ähnliche Beispiele gesehen. Das bedeutet, dass es einer tieferen Überlegung entgehen kann. Daher liefern uns die Benchmark-Ergebnisse keinen Beweis dafür, dass das Sprachmodell die tiefen Denkfähigkeiten erwirbt, die menschliche Testteilnehmer benötigen.

Bei manchen praktischen Aufgaben mag GPT-4 für flaches Denken kompetent sein, aber das ist nicht immer der Fall. Benchmarks werden häufig in großen Modellvergleichen verwendet und von vielen dafür kritisiert, dass sie mehrdimensionale Bewertungen auf eine einzige Zahl reduzieren.

Benchmarks werden häufig in großen Modellvergleichen verwendet und von vielen dafür kritisiert, dass sie mehrdimensionale Bewertungen auf eine einzige Zahl reduzieren.

Leider hat sich OpenAI für die Verwendung einer so großen Anzahl dieser Tests bei der Bewertung von GPT-4 entschieden, gepaart mit unzureichenden Maßnahmen zur Datenverschmutzungsbehandlung, was sehr bedauerlich ist.

Das obige ist der detaillierte Inhalt von„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr