Heim >Technologie-Peripheriegeräte >KI >Das Weltmodell verbreitet sich auch! Der ausgebildete Agent erweist sich als ziemlich gut

Das Weltmodell verbreitet sich auch! Der ausgebildete Agent erweist sich als ziemlich gut

- PHPzOriginal

- 2024-06-13 10:12:24427Durchsuche

Weltmodelle bieten eine Möglichkeit, Reinforcement-Learning-Agenten auf sichere und probeneffiziente Weise zu trainieren. In letzter Zeit operieren Weltmodelle hauptsächlich mit diskreten latenten Variablensequenzen, um die Umweltdynamik zu simulieren.

Diese Methode der Komprimierung in kompakte diskrete Darstellungen ignoriert jedoch möglicherweise visuelle Details, die für das verstärkende Lernen wichtig sind. Andererseits sind Diffusionsmodelle zur vorherrschenden Methode zur Bilderzeugung geworden, was diskrete latente Modelle vor Herausforderungen stellt.

Angetrieben durch diesen Paradigmenwechsel schlugen Forscher der Universität Genf, der Universität Edinburgh und Microsoft Research gemeinsam einen Reinforcement-Learning-Agenten vor, der in einem Diffusionsweltmodell trainiert wurde – DIAMOND (DIffusion As a Model Of eNvironment Dreams).

- Papieradresse: https://arxiv.org/abs/2405.12399

- Projektadresse: https://github.com/eloialonso/ Diamant

- Papiertitel: Diffusion for World Modeling: Visual Details Matter in Atari

Auf dem Atari 100k-Benchmark erreichte DIAMOND+ einen durchschnittlichen Human Normalized Score (HNS) von 1,46. Dies bedeutet, dass ein im Weltmodell geschulter Agent vollständig auf der SOTA-Ebene eines im Weltmodell geschulten Agenten trainiert werden kann. Diese Studie liefert eine Stabilitätsanalyse, um zu veranschaulichen, dass DIAMOND-Designentscheidungen notwendig sind, um die langfristige effiziente Stabilität des diffusiven Weltmodells sicherzustellen.

Zusätzlich zu den Vorteilen der Arbeit im Bildraum ermöglicht es, dass das diffuse Weltmodell zu einer direkten Darstellung der Umgebung wird und so ein tieferes Verständnis des Weltmodells und des Agentenverhaltens ermöglicht. Die Studie ergab insbesondere, dass Leistungsverbesserungen in bestimmten Spielen auf eine bessere Modellierung wichtiger visueller Details zurückzuführen sind.

Einführung in die Methode

Als nächstes stellt dieser Artikel DIAMOND vor, einen Reinforcement-Learning-Agenten, der in einem Diffusionsweltmodell trainiert wurde. Konkret stützen wir uns dabei auf die in Abschnitt 2.2 eingeführten Drift- und Diffusionskoeffizienten f und g, die einer bestimmten Wahl des Diffusionsparadigmas entsprechen. Darüber hinaus wurde in dieser Studie auch die EDM-Formulierung basierend auf Karras et al. gewählt.

Definieren Sie zunächst einen Störungskern  , wobei

, wobei  eine reellwertige Funktion in Bezug auf die Diffusionszeit ist, die als Rauschplan bezeichnet wird. Dies entspricht der Einstellung der Drift- und Diffusionskoeffizienten auf

eine reellwertige Funktion in Bezug auf die Diffusionszeit ist, die als Rauschplan bezeichnet wird. Dies entspricht der Einstellung der Drift- und Diffusionskoeffizienten auf  und

und  .

.

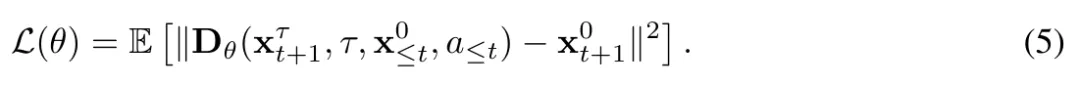

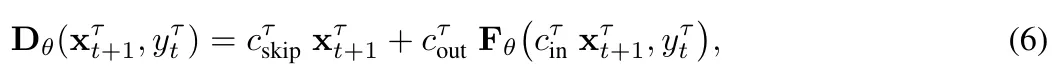

Verwenden Sie dann die von Karras et al. (2022) eingeführte Netzwerkvorverarbeitung und parametrisieren Sie  in Gleichung (5) als gewichtete Summe aus verrauschten Beobachtungen und vorhergesagten Werten des neuronalen Netzwerks:

in Gleichung (5) als gewichtete Summe aus verrauschten Beobachtungen und vorhergesagten Werten des neuronalen Netzwerks:

Formel erhalten (6)

wobei der prägnanten Definition halber alle Bedingungsvariablen einschließt.

Präprozessorauswahl. Die Präprozessoren  und

und  werden ausgewählt, um die Einheitsvarianz des Netzwerkeingangs und -ausgangs bei jedem Rauschpegel

werden ausgewählt, um die Einheitsvarianz des Netzwerkeingangs und -ausgangs bei jedem Rauschpegel  aufrechtzuerhalten.

aufrechtzuerhalten.  ist die empirische Umrechnung des Geräuschpegels,

ist die empirische Umrechnung des Geräuschpegels,  ergibt sich aus

ergibt sich aus  und der Standardabweichung der Datenverteilung

und der Standardabweichung der Datenverteilung  und die Formel lautet

und die Formel lautet

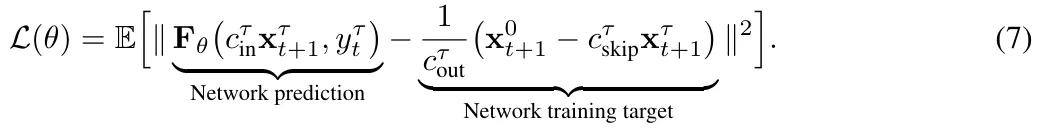

Durch die Kombination der Formeln 5 und 6 erhalten wir das  Trainingsziel:

Trainingsziel:

Diese Studie konditioniert das Modell, indem sie Standard-U-Net 2D verwendet, um das Vektorfeld zu erstellen  und einen Puffer mit den letzten L Beobachtungen und Aktionen beibehält. Als nächstes verketteten sie diese vergangenen Beobachtungen kanalweise mit der nächsten verrauschten Beobachtung und speisten die Aktionen über eine adaptive Gruppennormalisierungsschicht in den Restblock von U-Net ein. Wie in Abschnitt 2.3 und Anhang A erläutert, gibt es viele mögliche Stichprobenmethoden, um die nächste Beobachtung aus einem trainierten Diffusionsmodell zu generieren. Während die von der Studie veröffentlichte Codebasis mehrere Stichprobenschemata unterstützt, ergab die Studie, dass Euler-Methoden effektiv sind, ohne dass zusätzliche NFE (Anzahl der Funktionsauswertungen) erforderlich sind und die unnötige Komplexität von Samplern höherer Ordnung oder Zufallsstichproben vermieden wird.

und einen Puffer mit den letzten L Beobachtungen und Aktionen beibehält. Als nächstes verketteten sie diese vergangenen Beobachtungen kanalweise mit der nächsten verrauschten Beobachtung und speisten die Aktionen über eine adaptive Gruppennormalisierungsschicht in den Restblock von U-Net ein. Wie in Abschnitt 2.3 und Anhang A erläutert, gibt es viele mögliche Stichprobenmethoden, um die nächste Beobachtung aus einem trainierten Diffusionsmodell zu generieren. Während die von der Studie veröffentlichte Codebasis mehrere Stichprobenschemata unterstützt, ergab die Studie, dass Euler-Methoden effektiv sind, ohne dass zusätzliche NFE (Anzahl der Funktionsauswertungen) erforderlich sind und die unnötige Komplexität von Samplern höherer Ordnung oder Zufallsstichproben vermieden wird.

Experimente

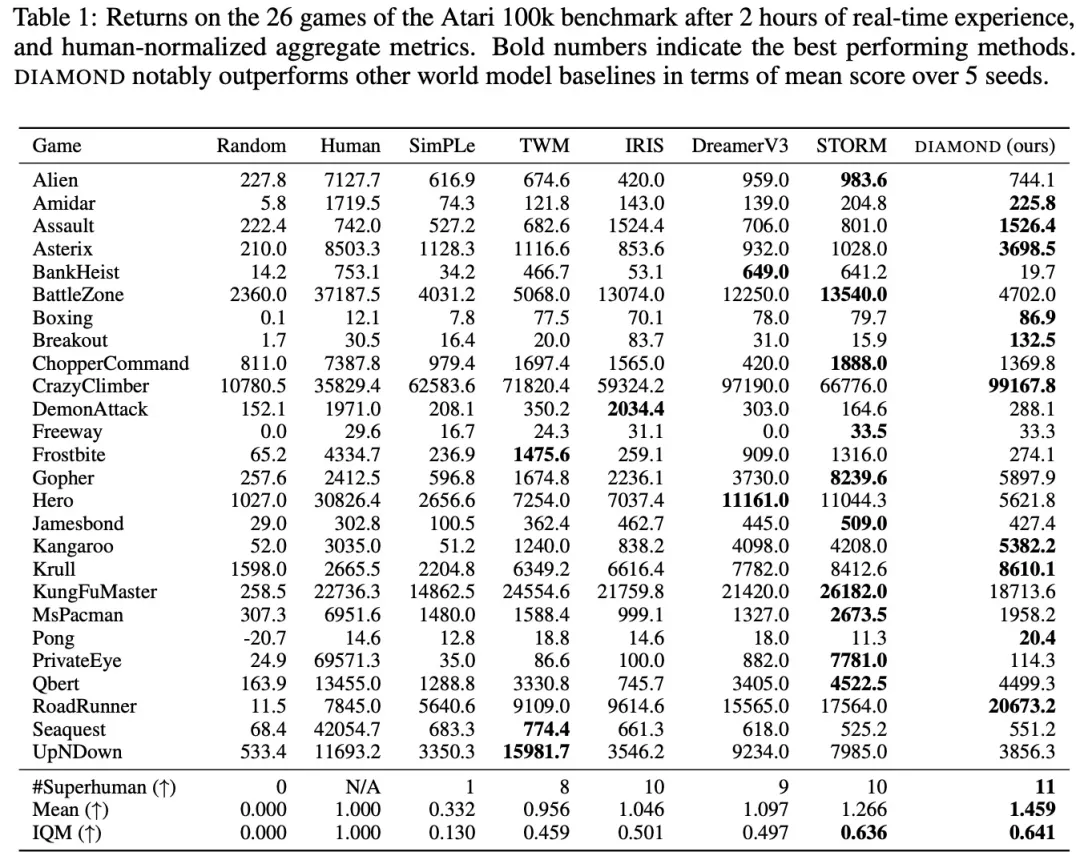

Um DIAMOND vollständig zu bewerten, verwendete die Studie den etablierten Atari 100k-Benchmark, der 26 Spiele umfasst, um die breiten Fähigkeiten des Agenten zu testen. Für jedes Spiel durfte der Agent nur 100.000 Aktionen in der Umgebung ausführen, was in etwa 2 Stunden menschlicher Spielzeit entspricht, um zu lernen, wie man das Spiel spielt, bevor es bewertet wird. Als Referenz: Ein Atari-Agent ohne Einschränkungen wird typischerweise für 50 Millionen Schritte trainiert, was einer 500-fachen Steigerung der Erfahrung entspricht. Die Forscher trainierten DIAMOND bei jedem Spiel von Grund auf mit 5 zufälligen Samen. Jeder Lauf verbrauchte etwa 12 GB VRAM und dauerte etwa 2,9 Tage auf einer einzelnen Nvidia RTX 4090 (insgesamt 1,03 GPU-Jahre).

Tabelle 1 vergleicht verschiedene Ergebnisse für die Schulung eines Agenten im Weltmodell:

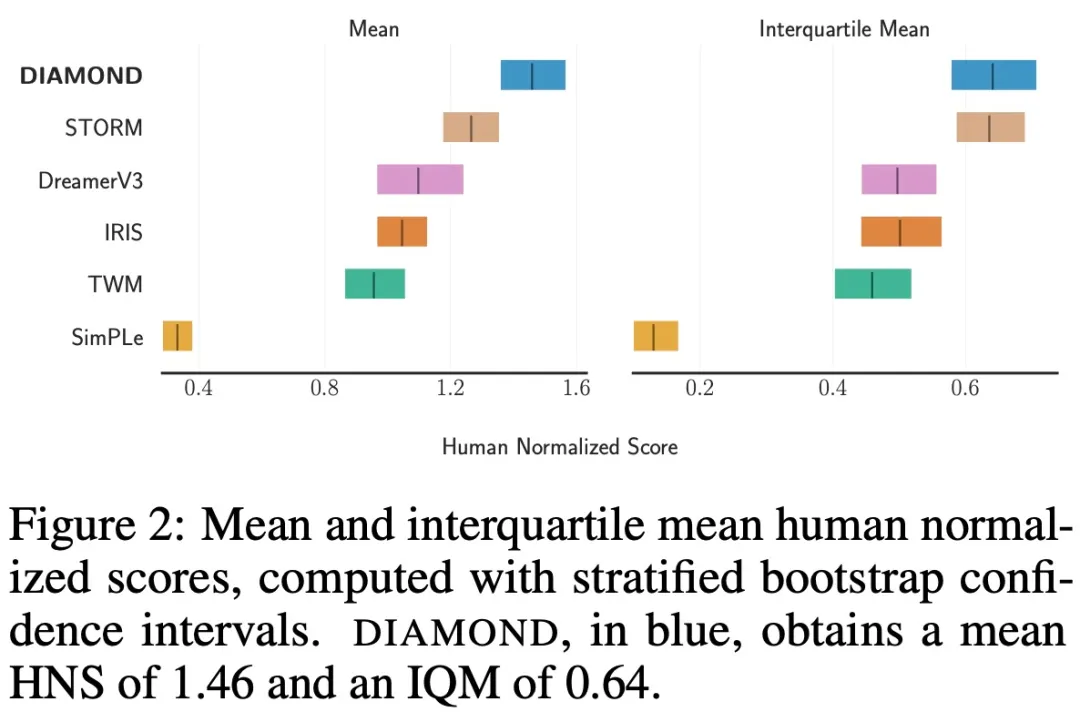

Der Mittelwert und die IQM-Konfidenzintervalle (Interquartilmittel) sind in Abbildung 2 dargestellt:

Die Ergebnisse zeigen, dass DIAMOND bei Benchmarks stark abschneidet, menschliche Spieler in 11 Spielen übertrifft und einen HNS-Wert von 1,46 erreicht, ein neuer Rekord für einen Agenten, der vollständig nach einem Weltmodell ausgebildet wurde. Die Studie ergab außerdem, dass DIAMOND besonders gut in Umgebungen funktioniert, in denen die Erfassung von Details erforderlich ist, wie z. B. Asterix, Breakout und Road Runner.

Um die Stabilität der Diffusionsvariablen zu untersuchen, analysierte diese Studie die durch Autoregression erzeugte imaginäre Flugbahn, wie in Abbildung 3 unten dargestellt:

Die Studie ergab, dass es Situationen gibt, in denen iterative Löser erforderlich sind, um den Stichprobenprozess in bestimmte Modi zu lenken, wie zum Beispiel das in Abbildung 4 dargestellte Boxspiel:

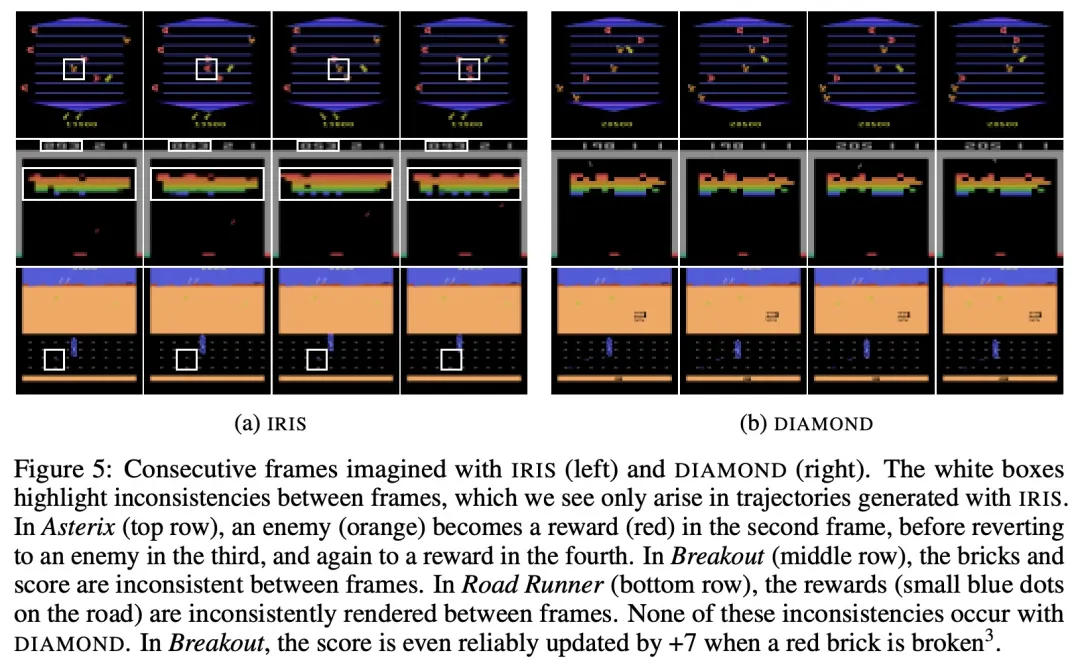

dargestellt in Abbildung 5 im Vergleich zur Flugbahn Die von IRIS vorgestellten Flugbahnen haben im Allgemeinen eine höhere visuelle Qualität und stimmen besser mit der realen Umgebung überein.

Interessierte Leser können den Originaltext des Artikels lesen, um mehr über den Forschungsinhalt zu erfahren.

Das obige ist der detaillierte Inhalt vonDas Weltmodell verbreitet sich auch! Der ausgebildete Agent erweist sich als ziemlich gut. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Neue Methode der 3D-Modellsegmentierung macht Ihre Hände frei! Es ist keine manuelle Kennzeichnung erforderlich, es ist nur eine Schulung erforderlich, und auch nicht gekennzeichnete Kategorien können HKU und Byte erkennen

- Metaforscher unternehmen einen neuen Versuch der KI: Sie bringen Robotern das physische Navigieren bei, ohne Karten oder Training

- Verwendung großer Modelle zur Schaffung eines neuen Paradigmas für das Textzusammenfassungstraining

- Mit der neuen aufgabenübergreifenden Selbstentwicklungsstrategie der Tsinghua-Universität und der HKU kommen wir der völligen Autonomie einen Schritt näher und ermöglichen es Agenten, „aus Erfahrungen zu lernen'.

- Wie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren