Heim >Technologie-Peripheriegeräte >KI >Wie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren

Wie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren

- 王林nach vorne

- 2024-03-11 13:01:151152Durchsuche

Stellen Sie sich vor, Sie stehen im Raum und bereiten sich darauf vor, zur Tür zu gehen. Planen Sie dann schrittweise den Weg durch Autoregression? Tatsächlich wird Ihr Pfad als Ganzes auf einmal generiert.

Die neuesten Forschungsergebnisse zeigen, dass das Planungsmodul, das das Diffusionsmodell verwendet, gleichzeitig eine Trajektorienplanung mit langer Sequenz generieren kann, was eher der menschlichen Entscheidungsfindung entspricht. Darüber hinaus kann das Diffusionsmodell auch optimiertere Lösungen für bestehende Entscheidungsintelligenzalgorithmen in Bezug auf Richtliniendarstellung und Datensynthese bereitstellen.

Der von einem Team der Shanghai Jiao Tong University verfasste Übersichtsartikel „Diffusion Models for Reinforcement Learning: A Survey“ fasst die Anwendung von Diffusionsmodellen in Bereichen zusammen, die mit Reinforcement Learning zusammenhängen. In der Überprüfung wird darauf hingewiesen, dass bestehende Algorithmen für das Reinforcement-Learning mit Herausforderungen konfrontiert sind, wie z. B. der Anhäufung von Fehlern bei der Planung über lange Zeiträume, begrenzten Fähigkeiten zum Ausdrücken von Richtlinien und unzureichenden interaktiven Daten. Das Diffusionsmodell hat sich bei der Lösung von Reinforcement-Learning-Problemen als vorteilhaft erwiesen und wurde zur Bewältigung der oben genannten Probleme eingesetzt. Langjährige Herausforderungen bringen neue Ideen. Papierlink: https://arxiv.org/abs/2311.01223

Projektadresse: https://github.com/apexrl/Diff4RLSurvey

Projektadresse: https://github.com/apexrl/Diff4RLSurvey

In dieser Rezension geht es um die Stärkung der Verbreitung Modell Die Rollen beim Lernen werden klassifiziert und erfolgreiche Fälle von Diffusionsmodellen in verschiedenen Szenarien des verstärkenden Lernens zusammengefasst. Abschließend blickt die Überprüfung auf die zukünftige Entwicklungsrichtung der Verwendung von Diffusionsmodellen zur Lösung von Problemen des verstärkenden Lernens.

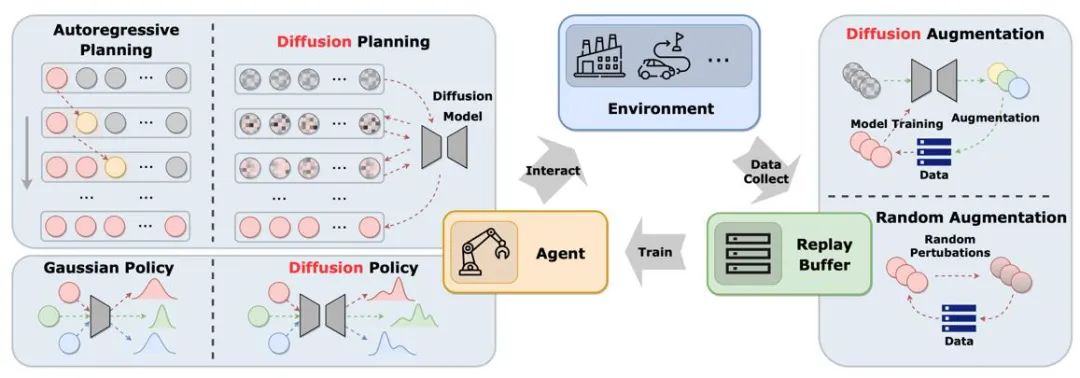

Die Abbildung zeigt die Rolle des Diffusionsmodells im klassischen Replay-Pool-Zyklus zwischen Agent, Umgebung und Erfahrung. Im Vergleich zu herkömmlichen Lösungen führt das Diffusionsmodell neue Elemente in das System ein und bietet umfassendere Informationsinteraktions- und Lernmöglichkeiten. Auf diese Weise kann sich der Agent besser an Umweltveränderungen anpassen und seine Entscheidungsfindung optimieren. Die Rolle des Diffusionsmodells beim verstärkenden Lernen Anwendungsmethoden und Eigenschaften von Diffusionsmodellen werden verglichen.

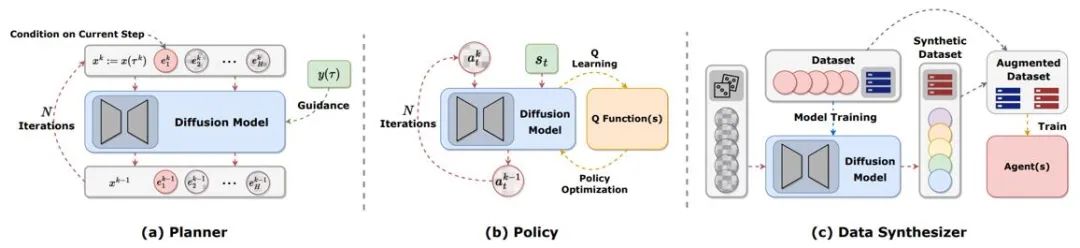

Abbildung 2: Die verschiedenen Rollen, die Diffusionsmodelle beim verstärkenden Lernen spielen.

Trajektorienplanung

Planung beim Reinforcement Learning bezieht sich auf das Treffen von Entscheidungen in der Fantasie mithilfe dynamischer Modelle und die anschließende Auswahl geeigneter Aktionen, um die kumulativen Belohnungen zu maximieren. Der Planungsprozess untersucht häufig Handlungsabfolgen und Zustände, um die langfristige Wirksamkeit von Entscheidungen zu verbessern. In MBRL-Frameworks (Model-Based Reinforcement Learning) werden Planungssequenzen häufig autoregressiv simuliert, was zu akkumulierten Fehlern führt. Diffusionsmodelle können mehrstufige Planungssequenzen gleichzeitig generieren. Die durch vorhandene Artikel unter Verwendung von Diffusionsmodellen generierten Ziele sind sehr vielfältig, einschließlich (s,a,r), (s,a), nur s, nur a usw. Um während der Online-Bewertung Trajektorien mit hoher Belohnung zu generieren, verwenden viele Arbeiten geführte Stichprobenverfahren mit oder ohne Klassifikatoren.

Richtliniendarstellung

Diffusionsplaner ähnelt eher MBRL beim traditionellen verstärkenden Lernen. Im Gegensatz dazu ähnelt die Verwendung des Diffusionsmodells als Richtlinie eher dem modellfreien verstärkenden Lernen. Diffusion-QL kombiniert zunächst die Diffusionsstrategie mit dem Q-Learning-Framework. Da Diffusionsmodelle weitaus besser in der Lage sind, multimodale Verteilungen anzupassen als herkömmliche Modelle, funktionieren Diffusionsstrategien gut in multimodalen Datensätzen, die von mehreren Verhaltensstrategien erfasst wurden. Die Diffusionsstrategie ist die gleiche wie die gewöhnliche Strategie, wobei normalerweise der Zustand als Bedingung für die Generierung von Aktionen verwendet wird und gleichzeitig die Maximierung der Funktion Q (s,a) in Betracht gezogen wird. Methoden wie Diffusion-QL fügen beim Training des Diffusionsmodells einen gewichteten Wertfunktionsterm hinzu, während CEP ein gewichtetes Regressionsziel aus Energieperspektive erstellt und die Wertfunktion als Faktor verwendet, um die vom Diffusionsmodell gelernte Aktionsverteilung anzupassen.

Datensynthese

Das Diffusionsmodell kann als Datensynthesizer verwendet werden, um das Problem spärlicher Daten beim Offline- oder Online-Verstärkungslernen zu lindern. Herkömmliche Methoden zur Datenverbesserung durch Reinforcement Learning können die Originaldaten normalerweise nur geringfügig stören, während die leistungsstarken Verteilungsanpassungsfähigkeiten des Diffusionsmodells es ermöglichen, die Verteilung des gesamten Datensatzes direkt zu lernen und dann neue, qualitativ hochwertige Daten abzutasten.

Andere Arten

Zusätzlich zu den oben genannten Kategorien gibt es auch einige verstreute Arbeiten, die Diffusionsmodelle auf andere Weise nutzen. DVF schätzt beispielsweise eine Wertfunktion mithilfe eines Diffusionsmodells. LDCQ kodiert zunächst die Flugbahn in den latenten Raum und wendet dann das Diffusionsmodell auf den latenten Raum an. PolyGRAD verwendet ein Diffusionsmodell, um die Lernumgebung dynamisch zu übertragen und so die Interaktion von Richtlinien und Modellen zu ermöglichen, um die Effizienz des politischen Lernens zu verbessern.

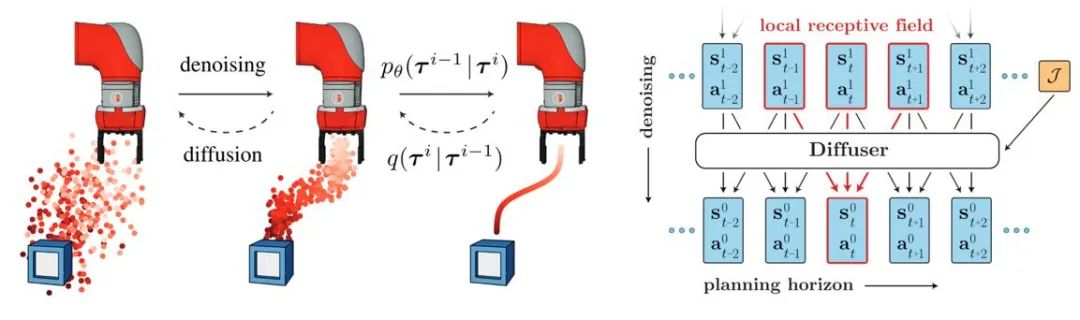

... Fähigkeit. Diffuser schlug zunächst einen Algorithmus zur Trajektoriengenerierung mit hoher Belohnung vor, der auf Klassifiziererführung basierte, und inspirierte viele weitere Arbeiten. Gleichzeitig kann das Diffusionsmodell auch in Multitasking- und Multiagenten-Lernszenarien zur Verstärkung angewendet werden. Abbildung 3: Schematische Darstellung des Prozesses und Modells zur Generierung der Diffusor-Trajektorie Online-Lernen zur Verstärkung. DIPO beschriftet beispielsweise Aktionsdaten neu und verwendet Diffusionsmodelltraining, um die Instabilität wertorientierten Trainings zu vermeiden. CPQL hat bestätigt, dass das einstufige Sampling-Diffusionsmodell als Strategie die Erforschung und Nutzung während der Interaktion ausgleichen kann.Imitationslernen

Imitationslernen rekonstruiert Expertenverhalten, indem es aus Expertendemonstrationsdaten lernt. Die Anwendung des Diffusionsmodells trägt dazu bei, die Fähigkeiten zur politischen Repräsentation zu verbessern und vielfältige Aufgabenkompetenzen zu erlernen. Im Bereich der Robotersteuerung hat die Forschung herausgefunden, dass Diffusionsmodelle geschlossene Aktionssequenzen vorhersagen und gleichzeitig die zeitliche Stabilität aufrechterhalten können. Diffusion Policy verwendet ein Diffusionsmodell der Bildeingabe, um Roboteraktionssequenzen zu generieren. Experimente zeigen, dass das Diffusionsmodell effektive Aktionssequenzen mit geschlossenem Regelkreis erzeugen und gleichzeitig die Konsistenz des Timings gewährleisten kann. Abbildung 4: Schematische Darstellung des Modells der Diffusionspolitik . Durch Diffusionsmodelle generierte Aktionsdaten oder Videodaten werden zum Aufbau von Simulationssimulatoren oder zum Training nachgelagerter Entscheidungsmodelle verwendet. UniPi trainiert ein Diffusionsmodell zur Videoerzeugung als allgemeine Strategie und erreicht eine körperübergreifende Robotersteuerung durch Zugriff auf verschiedene inverse Dynamikmodelle, um zugrunde liegende Steuerbefehle zu erhalten.

Datenverbesserung

Das Diffusionsmodell kann auch direkt an die ursprüngliche Datenverteilung angepasst werden und bietet eine Vielzahl dynamisch erweiterter Daten unter Beibehaltung der Authentizität. Beispielsweise generieren SynthER und MTDiff-s über das Diffusionsmodell vollständige Umgebungsübertragungsinformationen der Trainingsaufgabe und wenden diese auf Richtlinienverbesserungen an. Die Ergebnisse zeigen, dass die Vielfalt und Genauigkeit der generierten Daten besser ist als bei historischen Methoden.

... Hauptsächlich Forschung Diffusionsmodelle werden verwendet, um die Einschränkungen von Agenten und Erfahrungswiedergabepools zu überwinden, und es gibt relativ wenige Studien zur Verwendung von Diffusionsmodellen zur Verbesserung von Simulationsumgebungen. Gen2Sim nutzt das Vincentian-Graph-Diffusionsmodell, um verschiedene manipulierbare Objekte in der Simulationsumgebung zu generieren und so die Generalisierungsfähigkeit der Präzisionsoperationen des Roboters zu verbessern. Diffusionsmodelle haben auch das Potenzial, Zustandsübergangsfunktionen, Belohnungsfunktionen oder gegnerisches Verhalten in Multi-Agenten-Interaktionen in einer Simulationsumgebung zu generieren.

Sicherheitseinschränkungen hinzufügen

Durch die Verwendung von Sicherheitsbeschränkungen als Stichprobenbedingungen des Modells können Agenten, die auf dem Diffusionsmodell basieren, Entscheidungen treffen, die bestimmte Einschränkungen erfüllen. Durch das geführte Sampling des Diffusionsmodells können durch das Erlernen zusätzlicher Klassifikatoren kontinuierlich neue Sicherheitsbeschränkungen hinzugefügt werden, während die Parameter des ursprünglichen Modells unverändert bleiben, wodurch zusätzlicher Trainingsaufwand eingespart wird.

Retrieval-Enhanced-Generierung

Retrieval-Enhanced-Generierungstechnologie kann die Modellfunktionen durch Zugriff auf externe Datensätze verbessern und wird häufig in großen Sprachmodellen verwendet. Die Leistung diffusionsbasierter Entscheidungsmodelle in diesen Zuständen kann auch verbessert werden, indem Trajektorien im Zusammenhang mit dem aktuellen Zustand des Agenten abgerufen und in das Modell eingespeist werden. Wenn der Abrufdatensatz ständig aktualisiert wird, ist es möglich, dass der Agent neue Verhaltensweisen zeigt, ohne dass er neu trainiert werden muss.

Kombinieren Sie mehrere Fähigkeiten.

In Kombination mit oder ohne Klassifikatorführung kann das Diffusionsmodell mehrere einfache Fähigkeiten kombinieren, um komplexe Aufgaben zu erledigen. Frühe Ergebnisse des Offline-Lernens zur Verstärkung deuten auch darauf hin, dass Diffusionsmodelle Wissen zwischen verschiedenen Fähigkeiten teilen können, was es ermöglicht, durch die Kombination verschiedener Fähigkeiten einen Zero-Shot-Transfer oder kontinuierliches Lernen zu erreichen.

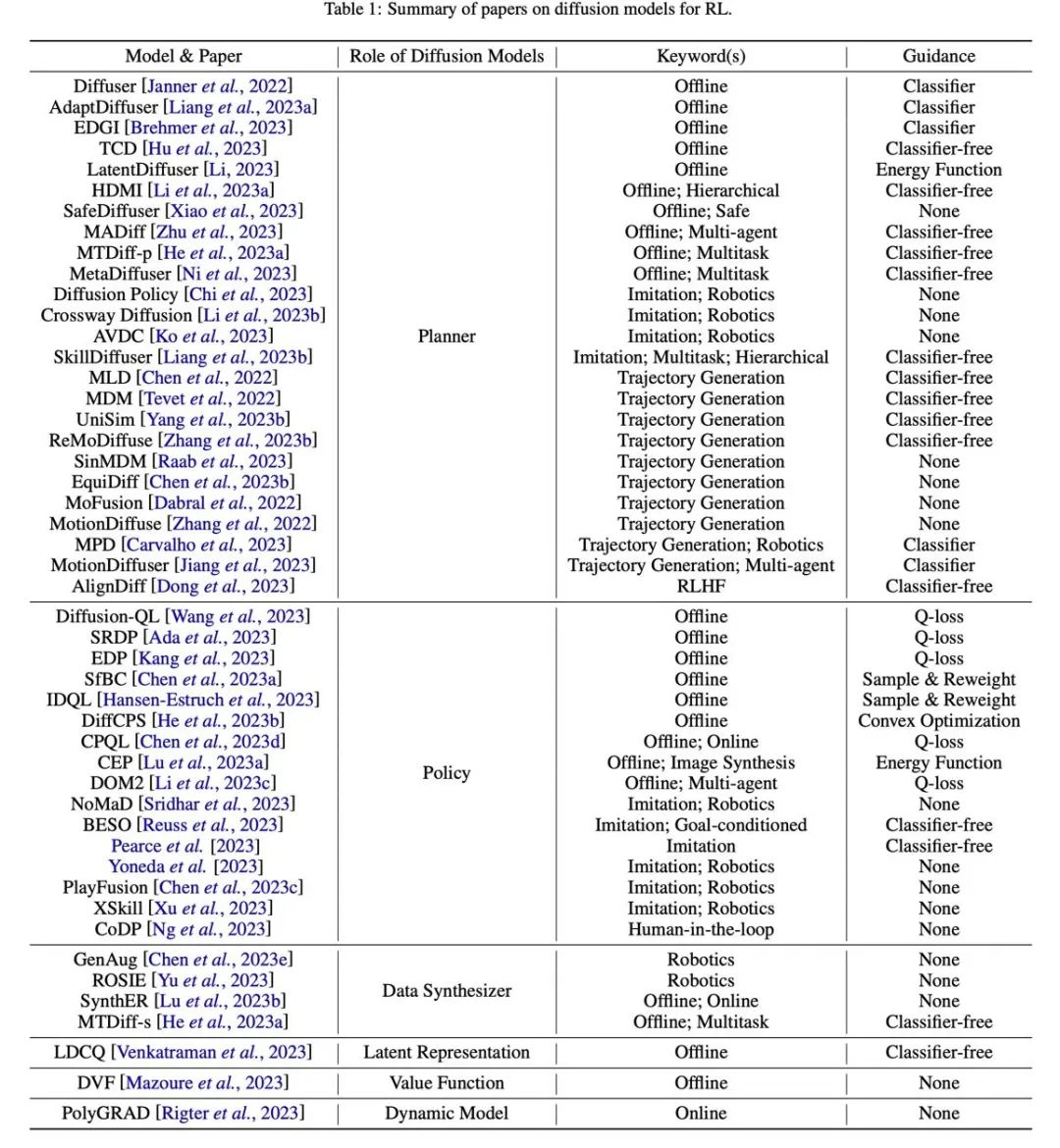

Tabelle

Abbildung 7: Zusammenfassung und Klassifizierungstabelle verwandter Arbeiten.

Das obige ist der detaillierte Inhalt vonWie baut das Diffusionsmodell eine neue Generation von Entscheidungsträgern auf? Über die Autoregression hinaus können Sie gleichzeitig lange Sequenzplanungspfade generieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Welche Protokolle gehören zur Anwendungsschicht im TCP-IP-Referenzmodell?

- Fudan veröffentlicht den „News Recommendation Ecosystem Simulator' SimuLine: Eine einzige Maschine unterstützt 10.000 Leser, 1.000 Ersteller und mehr als 100 Empfehlungsrunden

- So blenden Sie Schaltflächen auf dem Thunderbolt-Simulator-Bildschirm aus

- Wie man Spiele auf dem Yuzu-Emulator ausführt und wie man ihn bedient

- Haben Sie Probleme bei der Auswahl eines Java-Emulators? Diese fünf sind sehr zu empfehlen!