对3D场景的全面理解在自动驾驶中至关重要,最近的3D语义占用预测模型已经成功地解决了描述具有不同形状和类别的真实世界物体的挑战。然而,现有的3D占用预测方法在很大程度上依赖于全景相机图像,这使得它们容易受到照明和天气条件变化的影响。通过集成激光雷达和环视雷达等附加传感器的功能,本文的框架提高了占用预测的准确性和稳健性,从而在nuScenes基准上获得了顶级性能。此外,在nuScene数据集上进行的广泛实验,包括具有挑战性的夜间和雨天场景,证实了我们的传感器融合策略在各种感知范围内的卓越性能。

论文链接:https://arxiv.org/pdf/2403.01644.pdf

论文名称:OccFusion: A Straightforward and Effective Multi-Sensor Fusion Framework for 3D Occupancy Prediction

本文的主要贡献概述如下:

- 提出了一种多传感器融合框架,用于集成相机、激光雷达和雷达信息,以执行3D语义占用预测任务。

- 在3D语义占用预测任务中,将本文的方法与其他最先进的(SOTA)算法进行了比较,以证明多传感器融合的优势。

- 进行了彻底的消融研究,以评估不同传感器组合在具有挑战性的照明和天气条件下(如夜间和雨天)所实现的性能增益。

- 考虑到各种传感器组合和具有挑战性的场景,进行了一项全面的研究,以分析感知范围因素对我们的框架在3D语义占用预测任务中的性能的影响!

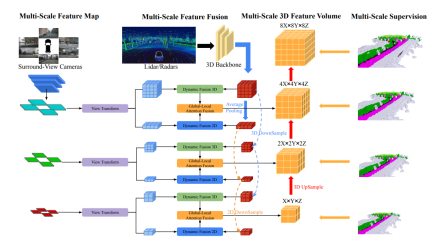

网络结构一览

OccFusion的总体架构如下所示。首先,将环绕视图图像输入到2D主干中以提取多尺度特征。随后,在每个尺度上进行视图变换,以获得每个级别的全局BEV特征和局部3D特征volume 。激光雷达和环视雷达生成的3D点云也被输入到3D主干中,以生成多尺度局部3D特征量和全局BEV特征。每个级别的动态融合3D/2D模块融合了相机和激光雷达/雷达的功能。在此之后,将每个级别的合并的全局BEV特征和局部3D特征volume 馈送到全局-局部注意力融合中,以生成每个尺度的最终3D volume 。最后,对每个级别的3D volume 进行上采样,并在采用多尺度监督机制的情况下进行skip连接。

实验对比分析

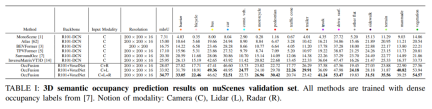

在nuScenes验证集上,展示了基于密集占用标签训练的各种方法在3D语义占用预测中的结果。这些方法涉及不同模态概念,包括相机(C)、激光雷达(L)和雷达(R)。

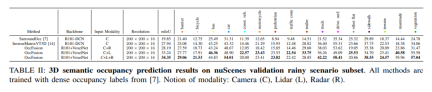

在nuScenes数据集的雨天场景子集上,我们对3D语义占用进行了预测,并使用了密集占用标签进行训练。在这个实验中,我们考虑了相机(C)、激光雷达(L)、雷达(R)等不同模态的数据。这些模态的融合可以帮助我们更好地理解和预测雨天下的场景,为自动驾驶系统的发展提供了重要参考。

nuScenes验证夜间场景子集的3D语义占用预测结果。所有方法都使用密集占用标签进行训练。模态概念:相机(C)、激光雷达(L)、雷达(R)。

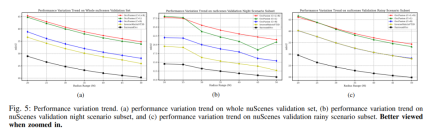

性能变化趋势。(a) 整个nuScenes验证集的性能变化趋势,(b)nuScenes验证夜间场景子集,以及(c)nuScene验证雨天场景子集的性能变化趋势。

表四:不同方法的模型效率比较。实验是在一台A10上使用六幅多摄像头图像、激光雷达和雷达数据进行的。对于输入图像分辨率,所有方法均采用1600×900。↓:越低越好。

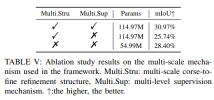

更多消融实验:

以上是OccFusion:一种简单有效的Occ多传感器融合框架(性能SOTA)的详细内容。更多信息请关注PHP中文网其他相关文章!

在LLMS中调用工具Apr 14, 2025 am 11:28 AM

在LLMS中调用工具Apr 14, 2025 am 11:28 AM大型语言模型(LLMS)的流行激增,工具称呼功能极大地扩展了其功能,而不是简单的文本生成。 现在,LLM可以处理复杂的自动化任务,例如Dynamic UI创建和自主a

多动症游戏,健康工具和AI聊天机器人如何改变全球健康Apr 14, 2025 am 11:27 AM

多动症游戏,健康工具和AI聊天机器人如何改变全球健康Apr 14, 2025 am 11:27 AM视频游戏可以缓解焦虑,建立焦点或支持多动症的孩子吗? 随着医疗保健在全球范围内挑战,尤其是在青年中的挑战,创新者正在转向一种不太可能的工具:视频游戏。现在是世界上最大的娱乐印度河之一

没有关于AI的投入:获胜者,失败者和机遇Apr 14, 2025 am 11:25 AM

没有关于AI的投入:获胜者,失败者和机遇Apr 14, 2025 am 11:25 AM“历史表明,尽管技术进步推动了经济增长,但它并不能自行确保公平的收入分配或促进包容性人类发展,”乌托德秘书长Rebeca Grynspan在序言中写道。

通过生成AI学习谈判技巧Apr 14, 2025 am 11:23 AM

通过生成AI学习谈判技巧Apr 14, 2025 am 11:23 AM易于使用,使用生成的AI作为您的谈判导师和陪练伙伴。 让我们来谈谈。 对创新AI突破的这种分析是我正在进行的《福布斯》列的最新覆盖范围的一部分,包括识别和解释

泰德(Ted)从Openai,Google,Meta透露出庭,与我自己自拍Apr 14, 2025 am 11:22 AM

泰德(Ted)从Openai,Google,Meta透露出庭,与我自己自拍Apr 14, 2025 am 11:22 AM在温哥华举行的TED2025会议昨天在4月11日举行了第36版。它有来自60多个国家 /地区的80个发言人,包括Sam Altman,Eric Schmidt和Palmer Luckey。泰德(Ted)的主题“人类重新构想”是量身定制的

约瑟夫·斯蒂格利兹(Joseph StiglitzApr 14, 2025 am 11:21 AM

约瑟夫·斯蒂格利兹(Joseph StiglitzApr 14, 2025 am 11:21 AM约瑟夫·斯蒂格利茨(Joseph Stiglitz)是2001年著名的经济学家,是诺贝尔经济奖的获得者。斯蒂格利茨认为,AI可能会使现有的不平等和合并权力恶化,并在几个主导公司的手中加剧,最终破坏了经济的经济。

什么是图形数据库?Apr 14, 2025 am 11:19 AM

什么是图形数据库?Apr 14, 2025 am 11:19 AM图数据库:通过关系彻底改变数据管理 随着数据的扩展及其特征在各个字段中的发展,图形数据库正在作为管理互连数据的变革解决方案的出现。与传统不同

LLM路由:策略,技术和Python实施Apr 14, 2025 am 11:14 AM

LLM路由:策略,技术和Python实施Apr 14, 2025 am 11:14 AM大型语言模型(LLM)路由:通过智能任务分配优化性能 LLM的快速发展的景观呈现出各种各样的模型,每个模型都具有独特的优势和劣势。 有些在创意内容gen上表现出色

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

Dreamweaver CS6

视觉化网页开发工具

WebStorm Mac版

好用的JavaScript开发工具

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

禅工作室 13.0.1

功能强大的PHP集成开发环境