ChatGPT,这款近期发布的文本生成工具,已经在研究界引起了热烈的讨论。它能写出学生作文、总结研究论文、回答问题、生成可用的计算机代码,甚至足以通过医学考试、MBA 考试、司法考试……

其中一个关键的问题是:ChatGPT 可以被命名为研究论文的作者吗?

现在,来自全球最大预印本发布平台 arXiv 官方的明确回答是:「不能」。

AI 没有署名权

在 ChatGPT 之前,研究者们早就在使用聊天机器人作为研究助手,帮助组织自己的思维,生成对自身工作的反馈,协助编写代码以及对研究文献进行摘要。

这些辅助工作似乎可以被认可,但说到「署名」,又完全是另外一回事。「显然,一个计算机程序不能为一篇论文的内容负责。它也不能同意 arXiv 的条款和条件。」

有一些预印本和已发表的文章已经将正式的作者身份赋予 ChatGPT。为了解决这个问题,arXiv 为作者采用了一项关于使用生成式 AI 语言工具的新政策。

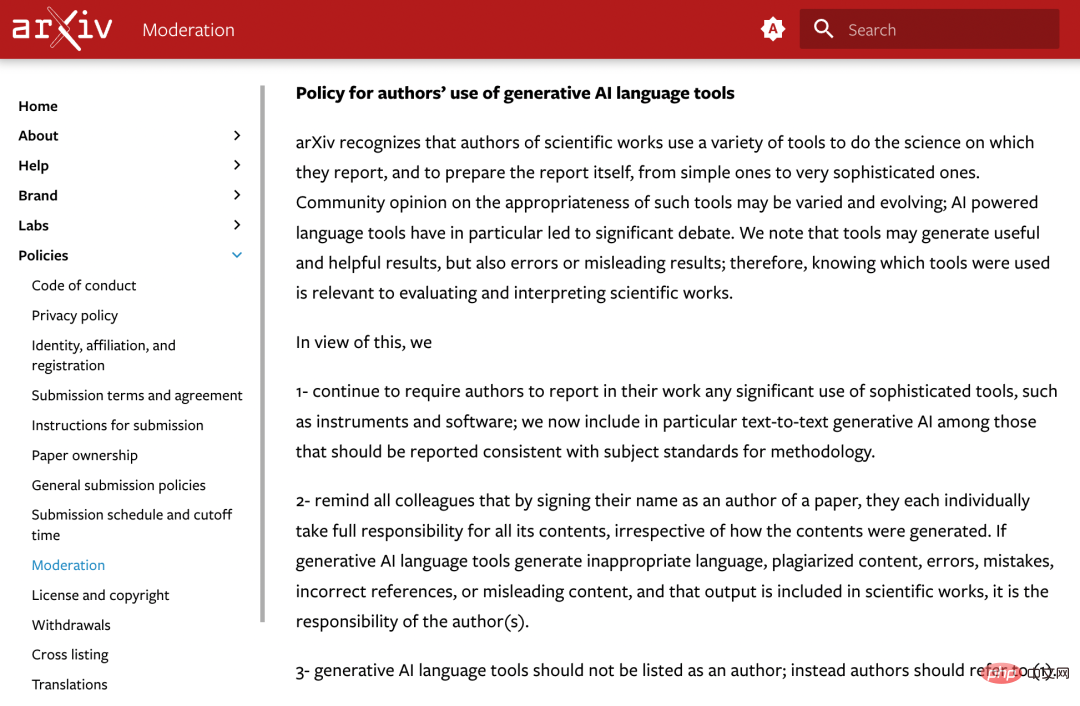

官方声明如下:

arXiv 认识到,科学工作者使用各种工具来进行他们所报告的科学工作以及准备报告本身,包括从简单的工具到非常复杂的工具。

社区对这些工具的适当性的看法可能是不同的,而且在不断变化;人工智能驱动的语言工具引发了重点的辩论。我们注意到,工具可能会产生有用和有帮助的结果,但也可能产生错误或误导性的结果;因此,了解使用了哪些工具与评估和解释科学作品有关。

基于此,arXiv 决定:

1. 继续要求作者在他们的工作中报告任何复杂工具的使用情况,如仪器和软件;我们现在特别将「文本到文本的生成式人工智能」包含在应报告的符合方法论主题标准的工具中。

2. 提醒所有同事,只要在论文中签上自己的名字,他们每个人都要对论文的所有内容承担全部责任,无论这些内容是如何产生的。如果生成式人工智能语言工具产生了不恰当的语言、抄袭的内容、错误的内容、不正确的参考文献或误导性的内容,并且该输出被纳入科学成果中,这就是作者的责任。

3. 生成式人工智能语言工具不应该被列为作者,可参考 1。

「规则」的意义

几天前,《自然》杂志就公开表示,已经与所有 Springer Nature 期刊共同制定了两条原则,并且这些原则已被添加到现有的作者指南中:

首先,任何大型语言模型工具都不会被接受作为研究论文的署名作者。这是因为任何作者的归属权都伴随着对工作的责任,而 AI 工具不能承担这种责任。

第二,使用大型语言模型工具的研究人员应该在方法或致谢部分记录这种使用。如果论文不包括这些部分,可以用引言或其他适当的部分来记录对大型语言模型的使用。

这些规定和 arXiv 最新发布的原则十分相似,看起来,学术出版领域的组织们似乎达成了某种共识。

ChatGPT 的能力纵然强大,但其在学校作业、论文发表等领域的滥用已经引发了人们广泛的担忧。

机器学习会议 ICML 就表示过:「ChatGPT 接受公共数据的训练,这些数据通常是在未经同意的情况下收集的,这会带来一系列的责任归属问题。」

因此,学界开始探索检测 ChatGPT 等大型语言模型(LLM)生成文本的方法和工具。未来,检测内容是否由 AI 生成或许将成为「审稿中的重要一环」。

以上是根据arXiv的正式规定,使用ChatGPT等工具作为作者是不允许的的详细内容。更多信息请关注PHP中文网其他相关文章!

如何使用Huggingface Smollm建立个人AI助手Apr 18, 2025 am 11:52 AM

如何使用Huggingface Smollm建立个人AI助手Apr 18, 2025 am 11:52 AM利用“设备” AI的力量:建立个人聊天机器人CLI 在最近的过去,个人AI助手的概念似乎是科幻小说。 想象一下科技爱好者亚历克斯(Alex)梦见一个聪明的本地AI同伴 - 不依赖

通过斯坦福大学激动人心的新计划,精神健康的AI专心分析Apr 18, 2025 am 11:49 AM

通过斯坦福大学激动人心的新计划,精神健康的AI专心分析Apr 18, 2025 am 11:49 AM他们的首届AI4MH发射于2025年4月15日举行,著名的精神科医生兼神经科学家汤姆·因斯尔(Tom Insel)博士曾担任开幕式演讲者。 Insel博士因其在心理健康研究和技术方面的杰出工作而闻名

2025年WNBA选秀课程进入联盟成长并与在线骚扰作斗争Apr 18, 2025 am 11:44 AM

2025年WNBA选秀课程进入联盟成长并与在线骚扰作斗争Apr 18, 2025 am 11:44 AM恩格伯特说:“我们要确保WNBA仍然是每个人,球员,粉丝和公司合作伙伴,感到安全,重视和授权的空间。” anno

Python内置数据结构的综合指南 - 分析VidhyaApr 18, 2025 am 11:43 AM

Python内置数据结构的综合指南 - 分析VidhyaApr 18, 2025 am 11:43 AM介绍 Python擅长使用编程语言,尤其是在数据科学和生成AI中。 在处理大型数据集时,有效的数据操作(存储,管理和访问)至关重要。 我们以前涵盖了数字和ST

与替代方案相比,Openai新型号的第一印象Apr 18, 2025 am 11:41 AM

与替代方案相比,Openai新型号的第一印象Apr 18, 2025 am 11:41 AM潜水之前,一个重要的警告:AI性能是非确定性的,并且特定于高度用法。简而言之,您的里程可能会有所不同。不要将此文章(或任何其他)文章作为最后一句话 - 目的是在您自己的情况下测试这些模型

AI投资组合|如何为AI职业建立投资组合?Apr 18, 2025 am 11:40 AM

AI投资组合|如何为AI职业建立投资组合?Apr 18, 2025 am 11:40 AM建立杰出的AI/ML投资组合:初学者和专业人士指南 创建引人注目的投资组合对于确保在人工智能(AI)和机器学习(ML)中的角色至关重要。 本指南为建立投资组合提供了建议

代理AI对安全操作可能意味着什么Apr 18, 2025 am 11:36 AM

代理AI对安全操作可能意味着什么Apr 18, 2025 am 11:36 AM结果?倦怠,效率低下以及检测和作用之间的差距扩大。这一切都不应该令任何从事网络安全工作的人感到震惊。 不过,代理AI的承诺已成为一个潜在的转折点。这个新课

Google与Openai:AI为学生打架Apr 18, 2025 am 11:31 AM

Google与Openai:AI为学生打架Apr 18, 2025 am 11:31 AM直接影响与长期伙伴关系? 两周前,Openai提出了强大的短期优惠,在2025年5月底之前授予美国和加拿大大学生免费访问Chatgpt Plus。此工具包括GPT-4O,A A A A A

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

螳螂BT

Mantis是一个易于部署的基于Web的缺陷跟踪工具,用于帮助产品缺陷跟踪。它需要PHP、MySQL和一个Web服务器。请查看我们的演示和托管服务。

SublimeText3 Linux新版

SublimeText3 Linux最新版

SublimeText3汉化版

中文版,非常好用

Atom编辑器mac版下载

最流行的的开源编辑器

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)