这几天,「微软砸下百亿美金注资OpenAI」的消息疯狂刷屏。

作为一家没有商业模式的公司,OpenAI怎么就能估值百亿美金?投资人这么好忽悠吗?

其实,拉出OpenAI背后的ChatGPT,大家就多少能明白一点了。这个语言模型「顶流」,最近可谓是无人不知,无人不晓。

而近水楼台先得月的微软,已经悄咪咪地在互联网巨头混战中,先下了一城。

前脚刚表示ChatGPT即将整合进自家搜索引擎必应,后脚就放出ChatGPT计划加入Office「办公全家桶」这个重磅炸弹。

AIGC革命,又到了拼算力的环节

2022年,是AIGC的革命元年。

DALL·E 2的诞生让「文生图」火了整整一年,紧跟其后的Stable Diffussion、Midjourney更是启发了无数人的艺术灵感,甚至让不少画手感到了「失业危机」。

到了年末,ChatGPT更是在全民中掀起AIGC的风暴。虽然是压轴出场,但「强化学习」(RLHF)赋予它的魔力,成功地掀起了一场全民的狂欢。

刚刚我们提到的这些应用,虽然看起来花里胡哨,但在背后提供支撑的依然是大家熟知的大模型们。

众所周知,对于大模型来说,不管是前期的训练还是后期的推理,都离不开巨量的「算力」。

举个例子,「当红炸子鸡」ChatGPT和DALL·E 2基于的GPT-3,以及国产自研的源1.0、悟道和文心等等,不仅在参数量上达到了千亿级别,而且数据集规模也高达TB级别。

想要搞定这些「庞然大物」的训练,就至少需要投入超过1000PetaFlop/s-day(PD)的计算资源。

也难怪OpenAI在大炼GPT-3之前,会让微软花10亿美元给自己独家定制了一台当时全世界排名前五的超级计算机。

但是问题在于,并不是每个需要到大量AI算力的企业或高校,都能财大气粗地斥巨资搞一个自己的「人工智能高性能计算中心」。

那么,如果我们换一个思路,让算力变得更加「普适普惠」,是不是也能实现相同或更好的效果呢?

于是,在2020年12月的时候,国家信息中心和浪潮信息联合发布了《智能计算中心规划建设指南》。其中,便提到了一个全新的概念——智能计算中心(简称,智算中心)。

智算中心是什么?

为了能更好地解决人工智能领域的问题,智算中心的发展就需要基于最新的AI论和先进的AI计算架构,并以AI芯片、AI服务器、AI集群为算力的载体。

首先,当前主流的AI加速计算,主要是采用CPU系统搭载GPU、FPGA、ASIC等异构AI加速芯片。

由于GPU芯片中原本为图形计算设计的大量算术逻辑单元(ALU),可为以张量计算为主的深度学习计算提供很好的加速效果,因此广受学术界和工业界的欢迎。

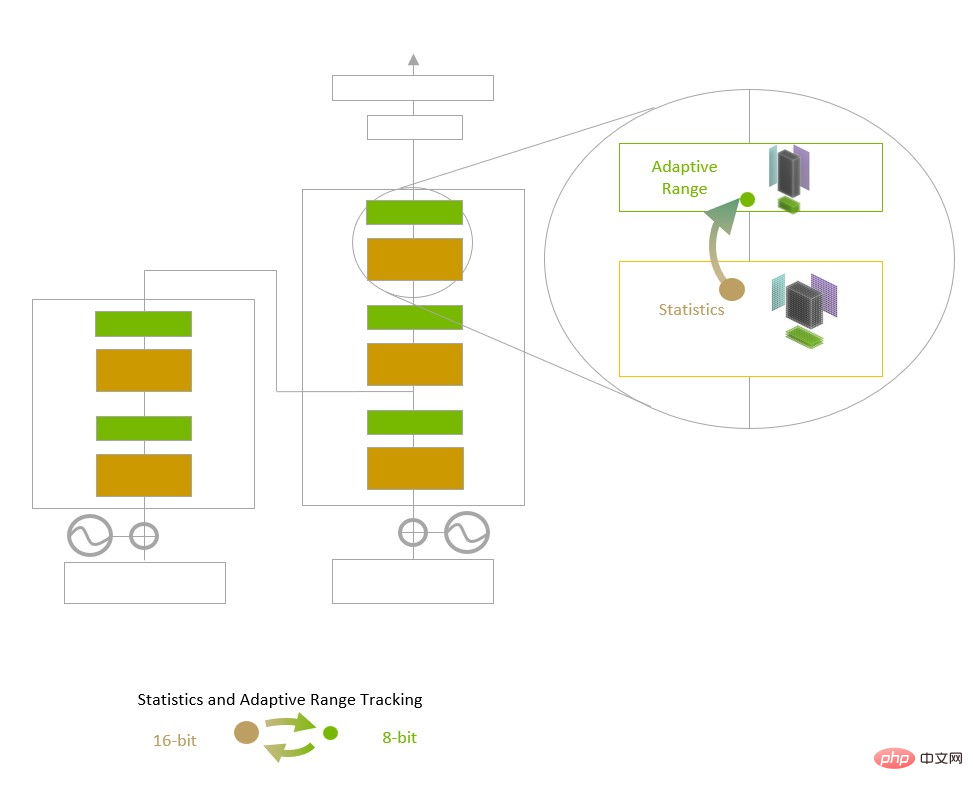

随着越来越深入的应用,GPU芯片本身也根据AI的计算特点,进行了针对性的创新设计,如张量计算单元、TF32/BF16数值精度、Transformer引擎(Transformer Engine)等。

而更加「专一」的AI计算加速芯片,主要脱胎于GPU芯片。

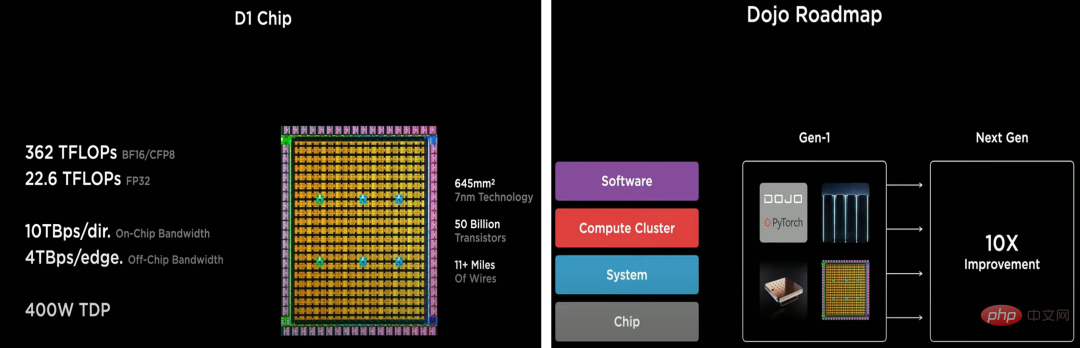

特斯拉Dojo人工智能训练芯片

其次,作为智算中心算力机组的AI服务器,则采用CPU+AI加速芯片的异构架构,通过集成多颗AI加速芯片实现超高计算性能。为了满足各领域场景和复杂的AI模型的计算需求,AI服务器对计算芯片间互联、 扩展性也有着极高要求。

最后,智算中心还需要对业界主流、开源、开放的软件生态提供充分的支持。

比如,用于开发AI算法的深度学习框架TensorFlow和PyTorch,为适应CV、NLP等特定场景开发而构建的一系列开源库等等。

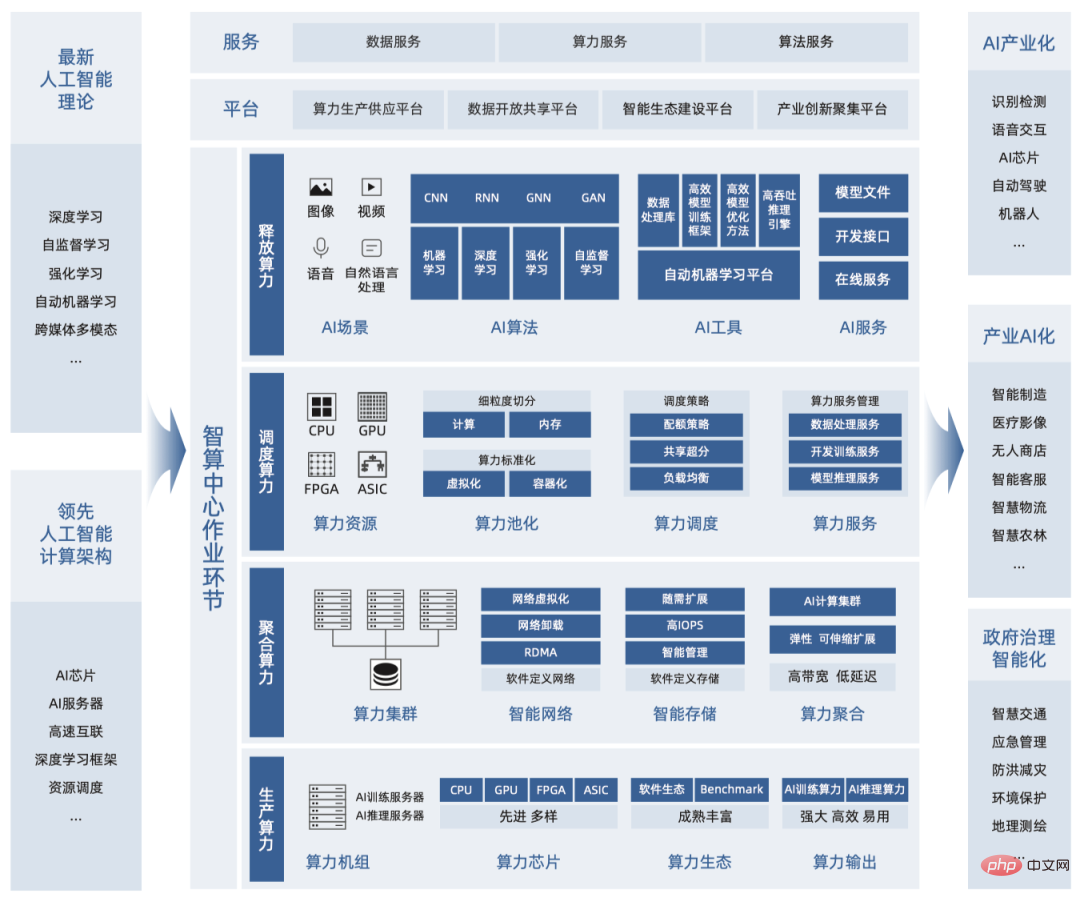

智算中心总体架构

不过,和国外那些大厂给自己定制的高性能计算中心不同,智算中心其实是一个面向公众的基础设施,更好地解决建不起、用不起算力的问题。

其中最为直观的便是,作为「神经中枢」的智算OS(智算中心操作系统)就是为了让智算中心可以对算力资源池进行高效管理和智能调度,从而更好地对外提供算力、数据和算法等服务。

如今,距离2020版《智能计算中心规划建设指南》的发布已经时隔两年,而我国的智算中心发展也已经进入了新阶段。

为此,国家信息中心和浪潮信息联合开展了与时俱进的研究,于2023年1月推出了更新的《智算中心创新发展指南》(以下简称「指南」)。

所以,为何还要兴建智算中心?

智算中心是数字经济时代促进产业转型升级、优化产业结构、提升城市竞争力的关键基础设施,并为快速增长的人工智能算力需求提供了必不可少的支撑。

具体来说可以分为四个方面:

推进AI产业化、赋能产业AI化、助力治理智能化、促进产业集群化。

- AI产业化

AI产业化的一个重要例子,就是自动驾驶。

在自动驾驶的场景中,需要基于AI技术,让车辆能够像人类驾驶员一样准确识别驾驶环境中的关键信息,并对周围运动单元的潜在轨迹做出预判。

在训练算力消耗上,自动驾驶感所采用的知模型要远大于一般的计算机视觉感知模型。

比如,特斯拉的L2级FSD自动驾驶融合感知模型,训练过程使用了百万量级的道路采集视频,算力投入约为500PD。

而且,随着自动驾驶级别从L2提升到L4,对算力的需求将进一步提高。

对此,智算中心提供的普惠算力,可以极大降低自动驾驶所需算力的成本。

- 产业AI化

在2022年,有一个概念非常流行,叫「AI for Science」。

这是一种新的科研范式,指科学家们用AI技术作为生产工具。

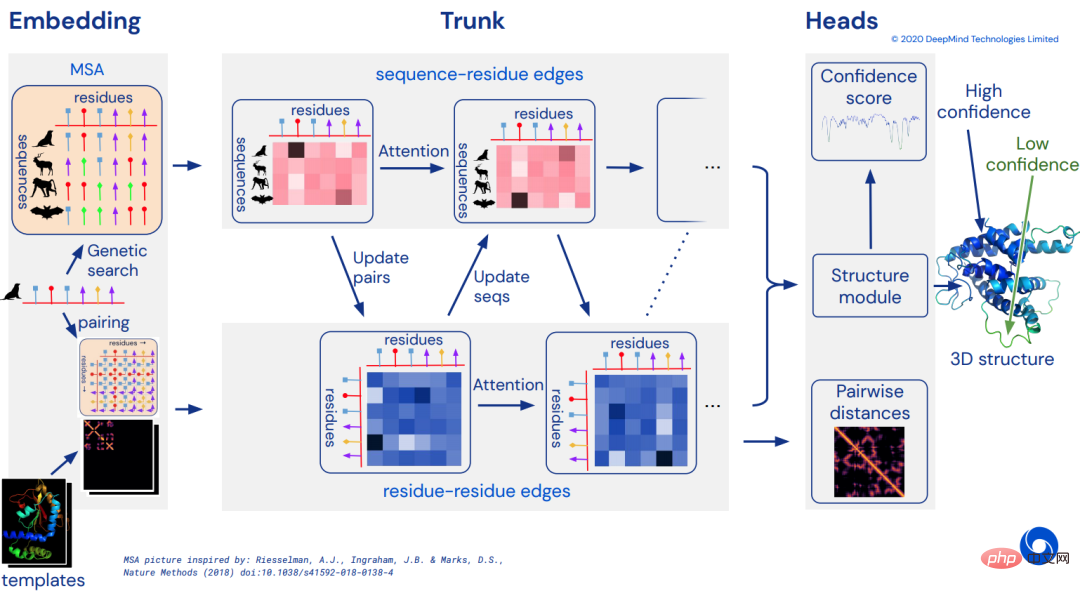

要说今年AI for Science最广为人知的例子之一,就是DeepMind开发的AlphaFold 2了。

截至目前,AlphaFold 2已经可以预测出2亿多个蛋白质结构,几乎覆盖了整个「蛋白质宇宙」。通过AlphaFold 2,单个蛋白结构的预测时间缩短到了分钟级,准确率也达到了92.4%。

AlphaFold 2的开发,就是以巨量算力为支撑的。仅在训练数据准备阶段,AlphaFold 2就消耗了约2亿核时的CPU算力,训练过程中更是消耗了约300PD的AI算力。

而非常契合AI for Science算力需求的智算中心,将成为支撑高校和科研院所高质量科研的重要基础设施。

- 治理智能化

另外,智算中心还能为城市公共服务和智能化治理,提供智算能力支撑。

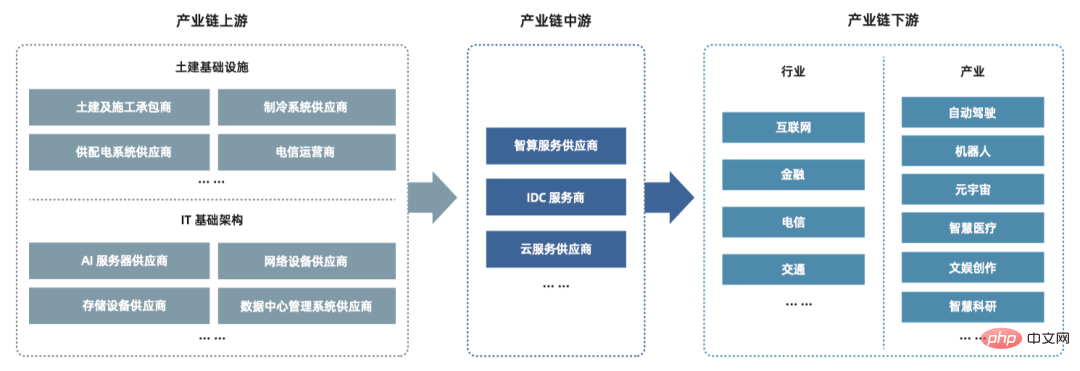

- 产业集群化

智算中心能够聚合当地人工智能的研发优势、人才优势、产品优势与产业投资,实现产业链协同,促进产业集群化发展。

智算中心产业链

现在,智算中心更是成为提升国际竞争力的关键基础设施。

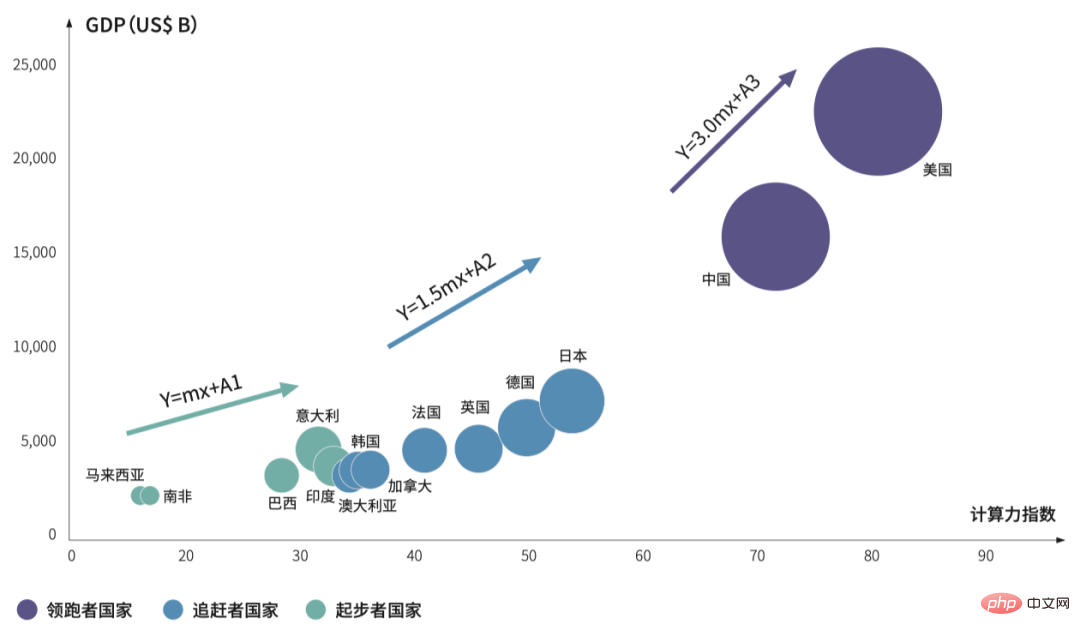

我们都知道,人均GDP指标可以衡量一个国家经济发展,人均算力水平的高低也可以衡量一个国家的智能化水平。

根据《2021-2022全球计算力指数评估报告》,国家计算力指数与GDP的走势呈现出了显著的正相关,计算力指数平均每提高1点,数字经济和GDP将分别增长3.5‰和1.8‰

计算力指数与GDP回归分析趋势

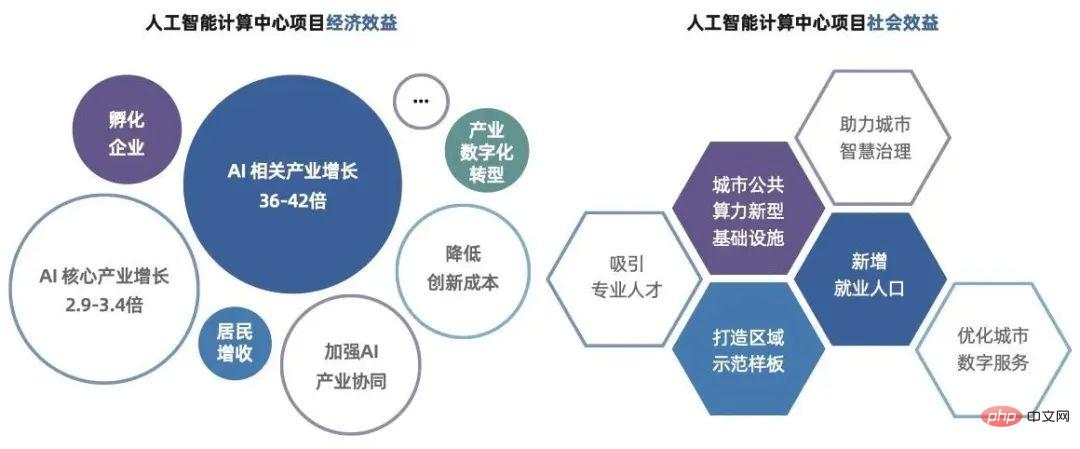

经研究测算,「十四五」期间,在智算中心实现80%应用水平的情况下,城市对智算中心的投资,可带动人工智能核心产业增长约2.9-3.4倍、带动相关产业增长约36-42倍,城市/地区在智算中心建设投入的增长量对创新产出的贡献率约为14%-17%。

不难看出,智算中心对于城市经济发展,已经形成一股不可忽视的力量。

智算中心项目的经济社会效益

基于这些原因,智算中心这个概念一经提出,便引发了建设热潮。据统计,现在全国有超过30个城市正在建设或提出建设智算中心。

然而,问题也随之而来

不可忽视的是,在如火如荼的建设过程中,这些智算中心也暴露出了很多问题和挑战。

首先,我国对智能算力的需求与日俱增。

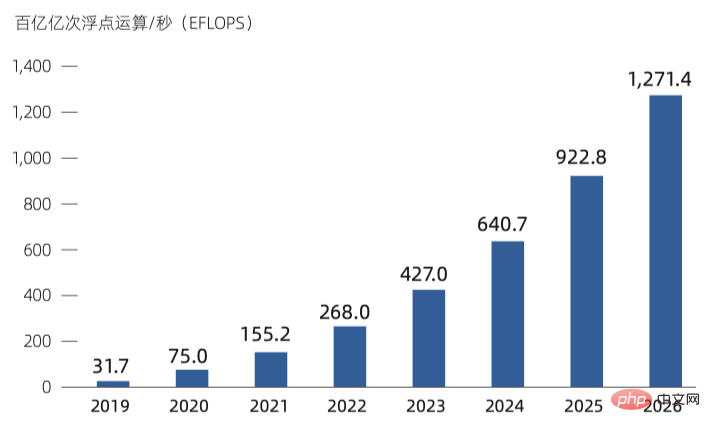

《2022-2023中国人工智能计算力发展评估报告》数据显示,2021年我国智能算力规模达155.2 EFLOPS(FP16),预计到2026年,我国的智能算力规模将达到1,271.4 EFLOPS。

在未来80%的场景都将基于AI,它们所占据的大部分算力资源,都是由智算中心承载。

我国智能算力发展情况

其次,围绕算法的服务模式也需要完善。

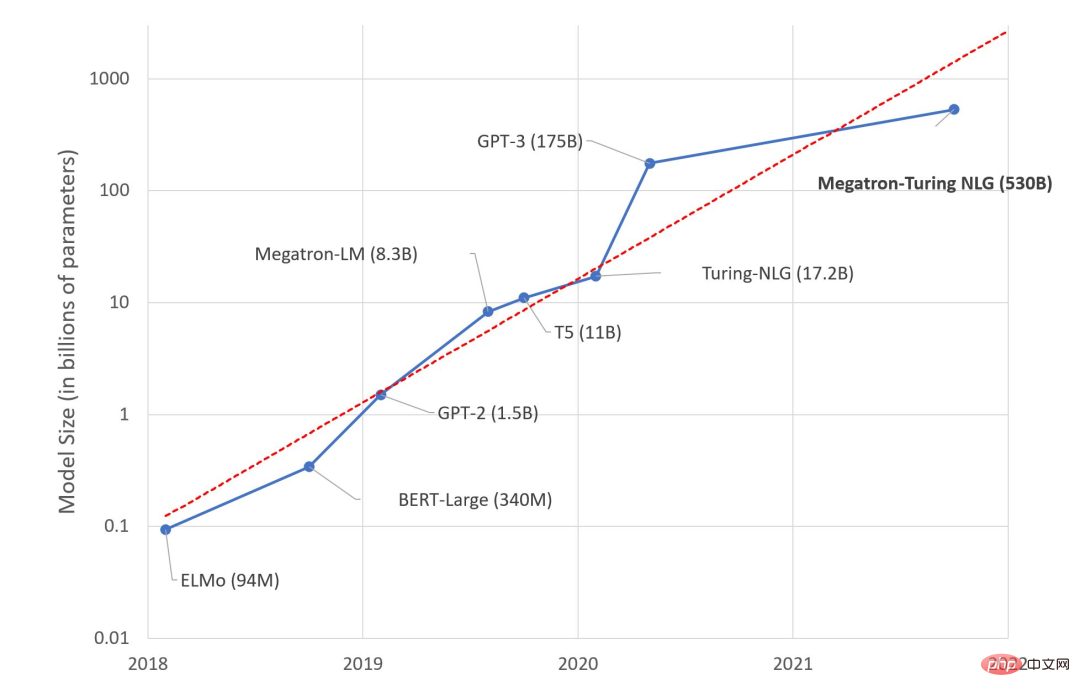

自2011年以来,全球AI领军企业和研究机构纷纷加入AI大模型研究,模型参数急剧增长。在短短三四年时间内,参数规模快速从亿级突破至万亿级,同时出现了很多代表性大模型,如谷歌发布的BERT,OpenAI发布的GPT-3等。

传统计算范式的改变,也必然推动智算中心的服务模式从提供算力为主,向提供「算法+算力」转变。

最后,现阶段存在的概念认知尚不清晰、建设标准尚不统一、应用场景尚不丰富、运营模式尚不成熟等问题,也直接影响着智算中心的发展。

怎么解决?

对此,《指南》给出的解决思路是:1. 普适普惠;2. 开放兼容。

先来说什么叫「普适普惠」。

普适普惠是指,发挥公共基础设施的社会价值,既要满足用户对通用算力的需求,又要满足不同用户不同场景对多元化算力的需求。

具体来说,智算中心要朝着标准化、低成本、低门槛方向发展,使智能计算可以像水电一样,成为社会基本公共服务,满足不同用户不同场景对算力多元化的需求。

其次,就是要「开放兼容」。

具体来说,就是要开源开放、培育生态。以开放硬件和开源软件为主,融合多元算力,实现算力的聚合、调度、释放,让智算中心「用起来、用的好」。同时,要加强对智算中心关键软硬件产品的研发支持和大规模应用推广。

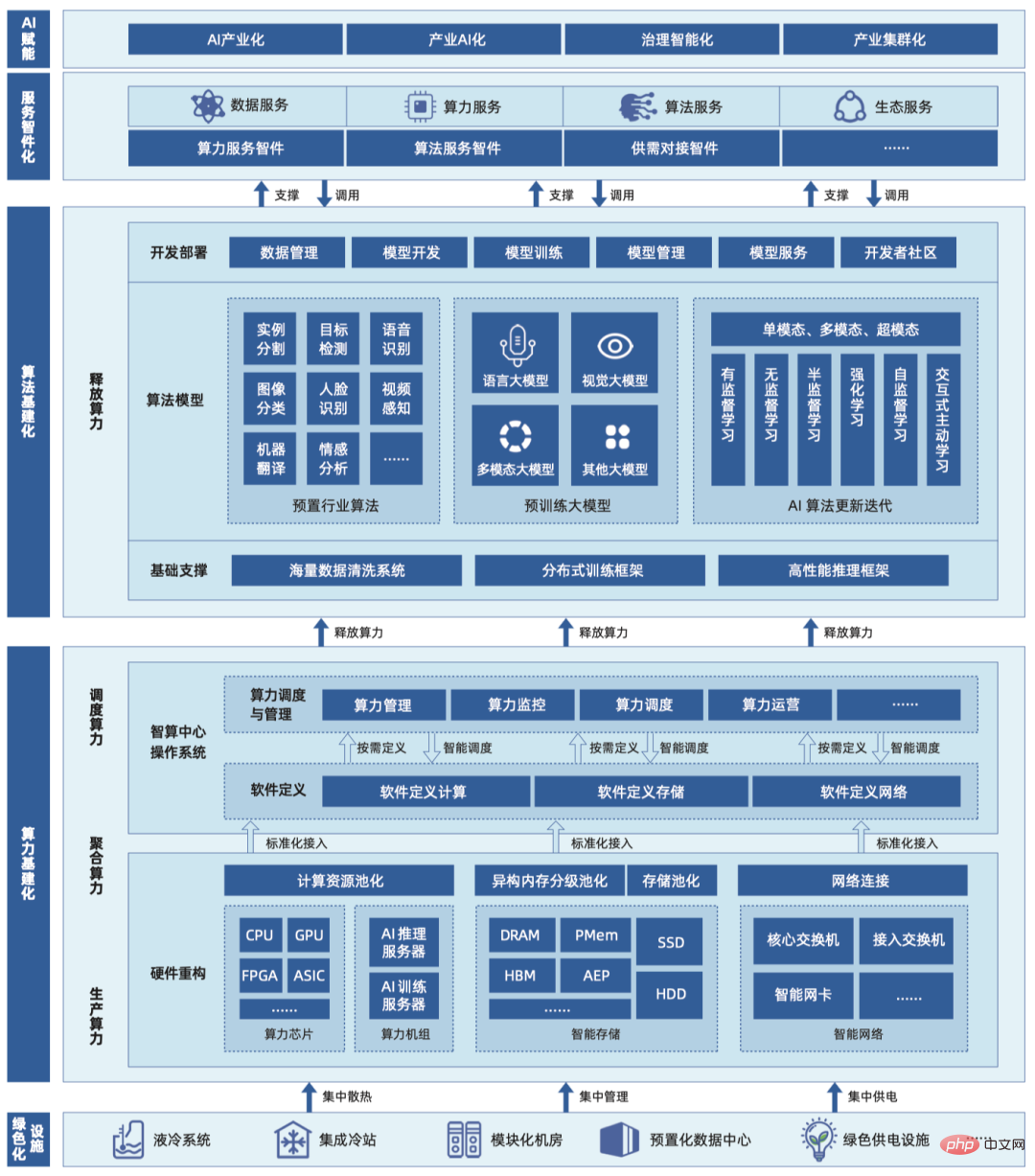

智算中心建设架构

而为了实现算力服务的普适普惠、高效利用,也就是智算中心如何「好用、用好」的问题,《指南》指出智算中心建设还需要构建「算力基建化、算法基建化、服务智件化、设施绿色化」的「四化」技术路线。

算力基建化是指,智算中心要具备对外提供高性价比、普惠、安全算力资源的能力,使AI算力像水、电一样成为城市的公共基础资源,供政府、企业、公众自主取用。

算法基建化是指,智算中心通过提供预置行业算法、构建预训练大模型、推进算法模型持续升级、提供专业化数据和算法服务,让更多的用户享受普适普惠的智能计算服务,实现「带着数据来、拿着成果走」的效果:

服务智件化是指,智算中心的发展将由传统的硬件、软件向「智件」升级。「智件」是指智算中心提供人工智能推广应用的中间件产品和服务。「智件」的构建,通过可视化操作界面,以及低代码开发甚至无代码开发的模式,为用户提供功能丰富、使用便捷的人工智能算力调度、算法供给和个性化开发服务。

最后,还要做到设施绿色化,目前主要发展趋势就是采用液冷技术。

展望未来

现在,以AIGC、元宇宙、智慧科研 (AI for Science)为代表的新兴场景,正在走进我们的日常生活,给我们的未来带来无限的可能。

与之相应的,智算中心建设布局浪潮正在全国快速掀起。

智能算力的普适普惠,对于大多数企业来说,尤其是中小企业,创新的门槛大大地降低了。

相信在不久的将来,我们会很快见证「以数据输入,让智能输出」,智能计算会如水电一般,真正惠及每一个人。

报告链接:

http://scdrc.sic.gov.cn/archiver/SmarterCity/UpFile/Files/Default/20230111181640567177.pdf

以上是搅动100亿美金的ChatGPT,竟然这么依赖TA?的详细内容。更多信息请关注PHP中文网其他相关文章!

在LLMS中调用工具Apr 14, 2025 am 11:28 AM

在LLMS中调用工具Apr 14, 2025 am 11:28 AM大型语言模型(LLMS)的流行激增,工具称呼功能极大地扩展了其功能,而不是简单的文本生成。 现在,LLM可以处理复杂的自动化任务,例如Dynamic UI创建和自主a

多动症游戏,健康工具和AI聊天机器人如何改变全球健康Apr 14, 2025 am 11:27 AM

多动症游戏,健康工具和AI聊天机器人如何改变全球健康Apr 14, 2025 am 11:27 AM视频游戏可以缓解焦虑,建立焦点或支持多动症的孩子吗? 随着医疗保健在全球范围内挑战,尤其是在青年中的挑战,创新者正在转向一种不太可能的工具:视频游戏。现在是世界上最大的娱乐印度河之一

没有关于AI的投入:获胜者,失败者和机遇Apr 14, 2025 am 11:25 AM

没有关于AI的投入:获胜者,失败者和机遇Apr 14, 2025 am 11:25 AM“历史表明,尽管技术进步推动了经济增长,但它并不能自行确保公平的收入分配或促进包容性人类发展,”乌托德秘书长Rebeca Grynspan在序言中写道。

通过生成AI学习谈判技巧Apr 14, 2025 am 11:23 AM

通过生成AI学习谈判技巧Apr 14, 2025 am 11:23 AM易于使用,使用生成的AI作为您的谈判导师和陪练伙伴。 让我们来谈谈。 对创新AI突破的这种分析是我正在进行的《福布斯》列的最新覆盖范围的一部分,包括识别和解释

泰德(Ted)从Openai,Google,Meta透露出庭,与我自己自拍Apr 14, 2025 am 11:22 AM

泰德(Ted)从Openai,Google,Meta透露出庭,与我自己自拍Apr 14, 2025 am 11:22 AM在温哥华举行的TED2025会议昨天在4月11日举行了第36版。它有来自60多个国家 /地区的80个发言人,包括Sam Altman,Eric Schmidt和Palmer Luckey。泰德(Ted)的主题“人类重新构想”是量身定制的

约瑟夫·斯蒂格利兹(Joseph StiglitzApr 14, 2025 am 11:21 AM

约瑟夫·斯蒂格利兹(Joseph StiglitzApr 14, 2025 am 11:21 AM约瑟夫·斯蒂格利茨(Joseph Stiglitz)是2001年著名的经济学家,是诺贝尔经济奖的获得者。斯蒂格利茨认为,AI可能会使现有的不平等和合并权力恶化,并在几个主导公司的手中加剧,最终破坏了经济的经济。

什么是图形数据库?Apr 14, 2025 am 11:19 AM

什么是图形数据库?Apr 14, 2025 am 11:19 AM图数据库:通过关系彻底改变数据管理 随着数据的扩展及其特征在各个字段中的发展,图形数据库正在作为管理互连数据的变革解决方案的出现。与传统不同

LLM路由:策略,技术和Python实施Apr 14, 2025 am 11:14 AM

LLM路由:策略,技术和Python实施Apr 14, 2025 am 11:14 AM大型语言模型(LLM)路由:通过智能任务分配优化性能 LLM的快速发展的景观呈现出各种各样的模型,每个模型都具有独特的优势和劣势。 有些在创意内容gen上表现出色

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境

Dreamweaver Mac版

视觉化网页开发工具

Dreamweaver CS6

视觉化网页开发工具