春夏之交,正是全球各大顶级科技公司举办年度活动的季节。两周前是谷歌,而这一周终于轮到了微软。仅用短短43分钟的时间,微软董事长兼 CEO 萨蒂亚·纳德拉 (Satya Nadella) 就完成了今年 Build 2022 大会主题演讲。有如说快板一般,他发布了微软在开发者流程、云计算、微服务、AI大模型商用化、低代码、工业元宇宙等十大领域的50多项全新产品、技术和项目进展。

其中最值得关注的新发布,包括:

- 采用 OpenAI 技术成功实现商业化的大模型服务 OpenAI Services;

- 机器学习算法驱动的低代码/无代码开发平台、GitHub Copilot AI 代码助手正式面向公众开放;

- 工业元宇宙方面的尝试;

- 面向 Windows on ARM 开发者推出的开发原型机 Project Volterra;

- 办公协作软件 Teams 新推出的 Live Share 实时协作“小程序”平台;等。

而在数量众多的新发布当中,绝大部分可以被归结为以下三个关键角度:

- 通过 AI 以及 AI 工具协助的方式,让开发者和商业用户能够不受工具的拖累,如 GitHub Copilot 代码生成工具、跨设备同步的开发环境虚拟机 Dev Box等);

- 降低多种计算平台(芯片架构、操作系统等)之间的开发壁垒,为开发者提供全“融合 AI 应用”开发能力,如 ARM 架构开发测试原型机 Project Volterra、Azure 云计算机器学习服务等;

- 用 AI 驱动的自动化技术,进一步提高办公效率,如低代码 web app 生成工具 Power Pages、客服-消费者对话摘要生成工具 Text Summarization 等。

从这些角度可以看出,联合创始人兼前CEO鲍尔默高喊“开发者!开发者!开发者!”的雄心, 微软 仍在坚守。只有开发者继续支持和参与构建微软主导的企业级服务和云计算生态,这家公司才能够继续站稳脚跟,避免成为下一家 惠普 /雅虎。

来跟硅星人看看微软今天到底发布了什么重要的开发者工具。

让大模型实现商业化,变成开发者的利器

之前 OpenAI 推出 GPT-3 的时候,很多第三方开发者都获得了测试权限,也做出了很多非常有创意的 demo。

不过,没有人比微软拿到的权限更“高级"。在 GPT-3,以及 OpenAI 在大规模/超大规模的生成语言和多模态模型所作的诸多努力上,微软看到了巨大的商业化前景。在2019年,OpenAI 和微软就已经达成了战略合作关系。

当然,恐怕也只有深谙办公和企业级市场的微软,能够将这些技术真正高效变成驱动商业增长的引擎。

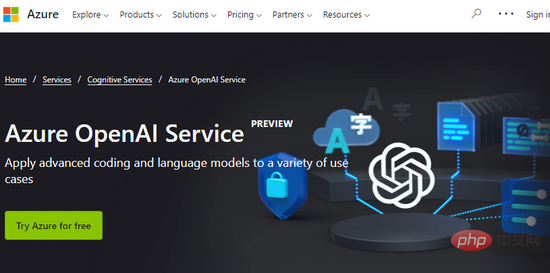

在今天的 Build 大会上,我们看到了微软和 OpenAI 的合作终于开花结果:微软 Azure 云计算平台正式上线 OpenAI Services(预览版),开发者可以申请试用这一服务,在大量不同的使用场景当中,应用 OpenAI 开发的代码生成和语言生成大模型。

一句话概括,就是让所有应用都能得到AI大模型的加持。

Azure OpenAI Services

Azure OpenAI Services

以在线二手车销售平台 CarMax 作为案例:

在选购二手车的时候,消费者总是面临“信息过载”,看着成百上千条车辆技术细节和留言评价,对于非专业人士来说非常头疼。而 CarMax 这家公司正在采用 Azure OpenAI Services ,同时利用 GPT-3 强大的“阅读理解”能力,和 Azure 云计算平台的企业级服务能力,来生成关于车辆的精炼信息。

现在,CarMax 用户可以通过模型总结出的“一段话”,了解最接近真实的车辆情况,比如能装下多少人、空间大小和舒适度、燃油经济性等。OpenAI Services 有效降低了 CarMax 用户在购车流程中的心理压力,降低交易摩擦,提高成交几率。

Carmax 采用 Azure OpenAI Services 示意图 动图来源:微软

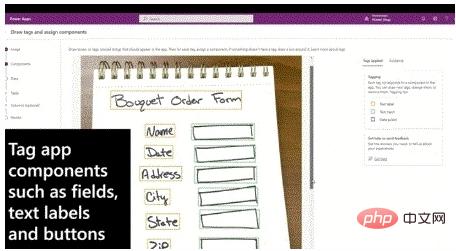

还有一个值得提及的东西:Express Design,一个低/无代码开发功能。通过这项技术,只用几秒钟的时间,就可以直接将设计草稿转化成可工作的应用界面甚至完整应用。

Express Design 是微软低代码开发工具 Power Apps 的功能之一。它支持的包括 Figma 文件、PDF、ppt 等文档格式文件,甚至手绘草稿等在内的多种类型。它的背后同样是微软自家以及包括 OpenAI 等在内合作伙伴开发的语言生成及多模态模型。

Power Apps 的开发者用户今天就可以开始使用 Express Design 功能。

Express Design 能将设计草稿直接转化成可用的应用原型界面,只需要几秒钟时间。动图来源:微软

诚如前面提到,过去我们的确看到了很多有意思、有潜力的 demo ,但大模型的实际场景应用一直是研发机构的难题。

将超大模型和 Azure 云计算平台结合,实现代码和内容的大规模自动化创造——这也是微软在今年提出的“模型即平台”(Model as Platforms) 概念的含义。

可以说,两年前的各种 OpenAI Demo 让我们看到了超大参数量语言生成模型的潜力。而在今天微软所做的,不仅是把大模型交到开发者的手上,更重要的是教会给它们如何进一步解锁大模型的潜力。大模型的商业化并不是简单的开个 API 就完了,毕竟它还是一个崭新的事物,授之以鱼,更要授之以渔。

通过 Azure OpenAI Services、Express Design 等技术服务和功能,微软已经成了第一个吃下了大模型螃蟹的人。

视频会议“分享画面”,变得更高科技了!

疫情以来,大家应该都已经习惯了居家/远程办公和视频会议。在开会讲解幻灯片的时候,相信很多人也经常用到分享画面 (share screen) 的功能。

然而在微软的办公协同软件 Teams 团队看来,现如今很多行业公司都在远程上班,他们需要在多种多样的软件上完成更加复杂的协作任务,这样的需求无法通过“被动式”的分享画面功能满足。

为此,Teams 在今年推出了 Live Share 功能。

Live Share 并不是对分享画面的取代,但可以被视为一个“高级版”的分享画面功能。具体来说,Live Share 就是在视频会议里插入一个第三方应用界面——有点像远程桌面一样,不仅可以观看,所有参会者都可以进行交互。

以下图中的三维建模软件 Hexagon 为例:在 Teams 视频会议中可以发起一个 Live Share 屏幕,其它参会者都可以从各自角度对 3D 模型编辑和观察。这种更加直观的协作体验,能够让参会者更加直观地参与到头脑风暴当中。

Teams 新推出的 Live Share 实时协作功能,让复杂、可交互的第三方程序可以被嵌入到会议当中,极大扩展了视频会议中分享屏幕的可操作性 动图来源:微软

举个最简单的场景:

一个应用开发团队正在演示圆形产品,你想要看到应用菜单点击和图标拖拽的效果,在过去你得举手发言告诉主讲人代替你去操作;

有了 Live Share,现在你可以在自己的屏幕上进行操作,每个参会者都可以同时进行不同的操作,不影响其他人看到的画面。这样不仅大家都对演示内容有了更深的理解,还显著缩短了会议的时间。

(用开发者的语言来说:Live Share 就好比将演示的内容,变成虚拟化的实例,每个参会者都能得到属于自己的实例。)

Live Share 功能基于微软开发的前端框架 Fuild Framework,第三方应用开发者只需要在产品中整合微软新推出的 Live ShareSDK 即可让应用支持这一功能。

可以通过 Live Share 实现功能,包括基本的界面交互、音视频内容同步和多用户编辑等,以及用于计划扑克 (agile poker) 等。该功能的合作伙伴包括视频协作服务 Frame.io、设计公司 Hexagon、咨询公司埃森哲、计划扑克服务 Parabol 等公司。

可以预期的是,有了 Live Share 功能,更多开发者以及密集协作型团队,在挑选办公协作和视频会议方案的时候,会更加青睐 Teams 了。

面向新平台/跨平台开发者,提供开放硬件生态系统

十几年前讨论起开源,恐怕没什么人会拿微软作为正面案例。然而自从2015年之后,从开源 .NET 到 Visual Studio 支持多操作系统/语言开发,再到对 GitHub 的战略收购和技术支持,微软已经成为了开放技术生态领域,最活跃和最重要的贡献者之一。

作为 Wintel 联盟的既得利益者,微软更是毫不避讳 x86 计算平台的式微。过去几年里,微软在支持多平台开发上已经证明了自己。而在本届 Build 大会上,这家公司在支持开放硬件生态上又迈出了关键一步。

今天,微软推出了 Project Volterra,一款 ARM 架构,面向开发者的原型机 (developer kit):

“我们相信 Windows 开放硬件生态能够给予开发者更多弹性和选择,帮助他们开发出能够支持多种场景的产品,”微软表示,Project Volterra 就是这样一个立足于帮助 ARM 架构开发者的产品。

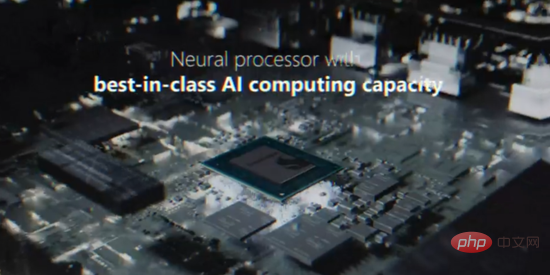

Project Volterra 采用了骁龙 NPU 计算平台,内置高通近年来力推的神经计算单元 (NPU),能够以较低的功耗实现机器学习模型方面的推理以及一些训练工作。这台开发者原型机运行的是 Windows on ARM,适合将 Windows 或适用于 Linux 的 Windows 子系统作为主要工作环境的开发者。

Project Volterra 整合了多个I/O接口,并且微软宣称这台开发机采用了可堆叠式设计,似乎意味着可以堆叠多台机器,实现某种类似于并行计算的工作负载模式:

最近十年里,微软自家的 Surface 设备在 Windows on ARM 方面的尝试没有获得过值得夸耀的成绩,甚至一些尝试非常失败,如前几年的 Surface RT,以及近两年的 Neo/Duo 双屏设备。

在 x86 计算平台式微的年代,ARM 架构在消费级以及物联网市场仍然毫无疑问是最重要的计算平台。微软也没有因为自己的失利就放弃 ARM 市场。和前几年大搞特搞开源一样,这家公司今天正在疯狂拥抱 ARM 架构:

除了 Project Volterra 之外,微软还宣布将在整个 Windows 平台端到端实现对 ARM 架构支持,提供一系列 ARM 原生工具链,包括并不限于 Visual Studio/VSCode、Visual C++、NET 框架等。

在对 ARM/骁龙 NPU 计算平台的大力支持基础之上,微软目前正在筹谋一个宏伟的计划:Hybrid Loop。

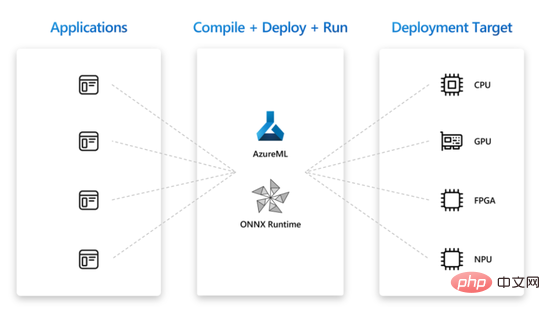

Hybrid Loop 是一个跨平台 AI 开发模式,它的最终目标是:借助 Azure ML,以及 ONNX Runtime(多种神经网络框架兼容)的力量,让任何神经网络模型可以使用于任何应用,并且部署到CPU、GPU、NPU、FPGA 等多种主流计算硬件平台上。

Project Volterra 是这个伟大计划的一次尝试。

以上就是今年 Build 大会我们认为特别值得展开讲述的新产品和技术。正如文章开头提到,今年主题演讲43分钟发布了10个大类别50多项新玩意,如果有兴趣了解全部项目,可以访问微软官网。

不过最后还想补充一点:今年 Build 开发者大会的特色之一就是“不卖期货”。本次50多项新发布当中的绝大多数,都在会后对开发者和公众不同程度开放。

你可以在微软官网收看 Build 大会主题演讲和分场的视频回放,以及了解本文没有提到的更多技术和产品发布。

以上是其他人还在放“大模型”的卫星 微软已经教会开发者怎么用它了的详细内容。更多信息请关注PHP中文网其他相关文章!

如何使用Huggingface Smollm建立个人AI助手Apr 18, 2025 am 11:52 AM

如何使用Huggingface Smollm建立个人AI助手Apr 18, 2025 am 11:52 AM利用“设备” AI的力量:建立个人聊天机器人CLI 在最近的过去,个人AI助手的概念似乎是科幻小说。 想象一下科技爱好者亚历克斯(Alex)梦见一个聪明的本地AI同伴 - 不依赖

通过斯坦福大学激动人心的新计划,精神健康的AI专心分析Apr 18, 2025 am 11:49 AM

通过斯坦福大学激动人心的新计划,精神健康的AI专心分析Apr 18, 2025 am 11:49 AM他们的首届AI4MH发射于2025年4月15日举行,著名的精神科医生兼神经科学家汤姆·因斯尔(Tom Insel)博士曾担任开幕式演讲者。 Insel博士因其在心理健康研究和技术方面的杰出工作而闻名

2025年WNBA选秀课程进入联盟成长并与在线骚扰作斗争Apr 18, 2025 am 11:44 AM

2025年WNBA选秀课程进入联盟成长并与在线骚扰作斗争Apr 18, 2025 am 11:44 AM恩格伯特说:“我们要确保WNBA仍然是每个人,球员,粉丝和公司合作伙伴,感到安全,重视和授权的空间。” anno

Python内置数据结构的综合指南 - 分析VidhyaApr 18, 2025 am 11:43 AM

Python内置数据结构的综合指南 - 分析VidhyaApr 18, 2025 am 11:43 AM介绍 Python擅长使用编程语言,尤其是在数据科学和生成AI中。 在处理大型数据集时,有效的数据操作(存储,管理和访问)至关重要。 我们以前涵盖了数字和ST

与替代方案相比,Openai新型号的第一印象Apr 18, 2025 am 11:41 AM

与替代方案相比,Openai新型号的第一印象Apr 18, 2025 am 11:41 AM潜水之前,一个重要的警告:AI性能是非确定性的,并且特定于高度用法。简而言之,您的里程可能会有所不同。不要将此文章(或任何其他)文章作为最后一句话 - 目的是在您自己的情况下测试这些模型

AI投资组合|如何为AI职业建立投资组合?Apr 18, 2025 am 11:40 AM

AI投资组合|如何为AI职业建立投资组合?Apr 18, 2025 am 11:40 AM建立杰出的AI/ML投资组合:初学者和专业人士指南 创建引人注目的投资组合对于确保在人工智能(AI)和机器学习(ML)中的角色至关重要。 本指南为建立投资组合提供了建议

代理AI对安全操作可能意味着什么Apr 18, 2025 am 11:36 AM

代理AI对安全操作可能意味着什么Apr 18, 2025 am 11:36 AM结果?倦怠,效率低下以及检测和作用之间的差距扩大。这一切都不应该令任何从事网络安全工作的人感到震惊。 不过,代理AI的承诺已成为一个潜在的转折点。这个新课

Google与Openai:AI为学生打架Apr 18, 2025 am 11:31 AM

Google与Openai:AI为学生打架Apr 18, 2025 am 11:31 AM直接影响与长期伙伴关系? 两周前,Openai提出了强大的短期优惠,在2025年5月底之前授予美国和加拿大大学生免费访问Chatgpt Plus。此工具包括GPT-4O,A A A A A

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

Atom编辑器mac版下载

最流行的的开源编辑器

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境