Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail für die Einreichung: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

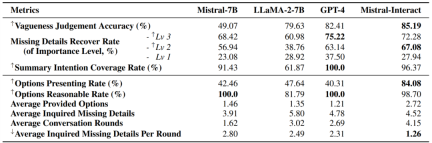

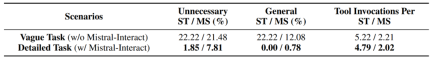

Mit Mistral-7B als Rahmen und basierend auf IN3-Training kann Mistral-Interact die Mehrdeutigkeit von Aufgaben proaktiv bewerten, Benutzerabsichten abfragen und sie in umsetzbare Ziele verfeinern, bevor die Ausführung nachgelagerter Agentenaufgaben gestartet wird. Nach der Einbettung des Modells in das XAgent-Framework führt der Artikel eine umfassende Bewertung des vollständig zustandsbehafteten Agentensystems durch.

Die Ergebnisse zeigen, dass diese Lösung eine hervorragende Leistung bei der Identifizierung mehrdeutiger Benutzeraufgaben, der Wiederherstellung und Zusammenfassung wichtiger fehlender Informationen, der Festlegung genauer und notwendiger Ziele für die Agentenausführung und der Reduzierung des Einsatzes redundanter Tools bietet. Diese innovative Methode schließt nicht nur die Lücke in der Interaktion zwischen intelligenten Agenten und Benutzern und stellt den Menschen wirklich in den Mittelpunkt des Designs intelligenter Agenten, sondern bedeutet auch, dass wir dem Ziel, intelligente Agenten zu entwerfen, die besser aufeinander abgestimmt sind, einen Schritt näher kommen mit menschlichen Absichten.

- Papiertitel: Tell Me More! Towards Implicit User Intention Understanding of Language Model Driven Agents

- Papierlink: https://arxiv.org/abs/2402.09205

- Code-Repository: https ://github.com/HBX-hbx/Mistral-Interact

- Open-Source-Modell: https://huggingface.co/hbx/Mistral-Interact

- Open-Source-Datensatz: https://huggingface.co / datasets/hbx/IN3

以上是开闭源模型「大乱斗」:看看哪个智能体最能窥见人类真实意图的详细内容。更多信息请关注PHP中文网其他相关文章!

AI游戏开发通过Upheaval的Dreamer Portal进入其代理时代May 02, 2025 am 11:17 AM

AI游戏开发通过Upheaval的Dreamer Portal进入其代理时代May 02, 2025 am 11:17 AM动荡游戏:与AI代理商的游戏开发彻底改变 Roupheaval是一家游戏开发工作室,由暴风雪和黑曜石等行业巨头的退伍军人组成,有望用其创新的AI驱动的Platfor革新游戏创作

Uber想成为您的Robotaxi商店,提供商会让他们吗?May 02, 2025 am 11:16 AM

Uber想成为您的Robotaxi商店,提供商会让他们吗?May 02, 2025 am 11:16 AMUber的Robotaxi策略:自动驾驶汽车的骑车生态系统 在最近的Curbivore会议上,Uber的Richard Willder推出了他们成为Robotaxi提供商的乘车平台的策略。 利用他们在

AI代理玩电子游戏将改变未来的机器人May 02, 2025 am 11:15 AM

AI代理玩电子游戏将改变未来的机器人May 02, 2025 am 11:15 AM事实证明,视频游戏是尖端AI研究的宝贵测试场所,尤其是在自主代理和现实世界机器人的开发中,甚至有可能促进人工通用智能(AGI)的追求。 一个

创业公司工业综合体VC 3.0和James Currier的宣言May 02, 2025 am 11:14 AM

创业公司工业综合体VC 3.0和James Currier的宣言May 02, 2025 am 11:14 AM不断发展的风险投资格局的影响在媒体,财务报告和日常对话中显而易见。 但是,对投资者,初创企业和资金的具体后果经常被忽略。 风险资本3.0:范式

Adobe在Adobe Max London 2025更新创意云和萤火虫May 02, 2025 am 11:13 AM

Adobe在Adobe Max London 2025更新创意云和萤火虫May 02, 2025 am 11:13 AMAdobe Max London 2025对Creative Cloud和Firefly进行了重大更新,反映了向可访问性和生成AI的战略转变。 该分析结合了事件前简报中的见解,并融合了Adobe Leadership。 (注意:Adob

Llamacon宣布的所有元数据May 02, 2025 am 11:12 AM

Llamacon宣布的所有元数据May 02, 2025 am 11:12 AMMeta的Llamacon公告展示了一项综合的AI策略,旨在直接与OpenAI等封闭的AI系统竞争,同时为其开源模型创建了新的收入流。 这个多方面的方法目标bo

关于AI仅仅是普通技术的主张的酿造争议May 02, 2025 am 11:10 AM

关于AI仅仅是普通技术的主张的酿造争议May 02, 2025 am 11:10 AM人工智能领域对这一论断存在严重分歧。一些人坚称,是时候揭露“皇帝的新衣”了,而另一些人则强烈反对人工智能仅仅是普通技术的观点。 让我们来探讨一下。 对这一创新性人工智能突破的分析,是我持续撰写的福布斯专栏文章的一部分,该专栏涵盖人工智能领域的最新进展,包括识别和解释各种有影响力的人工智能复杂性(请点击此处查看链接)。 人工智能作为普通技术 首先,需要一些基本知识来为这场重要的讨论奠定基础。 目前有大量的研究致力于进一步发展人工智能。总目标是实现人工通用智能(AGI)甚至可能实现人工超级智能(AS

模型公民,为什么AI值是下一个业务码May 02, 2025 am 11:09 AM

模型公民,为什么AI值是下一个业务码May 02, 2025 am 11:09 AM公司AI模型的有效性现在是一个关键的性能指标。自AI BOOM以来,从编写生日邀请到编写软件代码的所有事物都将生成AI使用。 这导致了语言mod的扩散

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

禅工作室 13.0.1

功能强大的PHP集成开发环境

Atom编辑器mac版下载

最流行的的开源编辑器

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器