提升大型語言模型的推理能力是當前研究的最重要方向之一,在這類任務中,近期發布的許多小模型看起來表現不錯,並且能夠很好地應對這類任務。例如微軟的Phi-3、Mistral 8x22B等模型。

研究人員指出,目前大模型研究領域存在一個關鍵問題:許多研究未能準確地對現有LLM的能力進行基準測試。這提示我們需要花更多的時間來評估和測試目前LLM的能力水準。

這是因為目前大多數的研究都採用GSM8k、MATH、MBPP、HumanEval、SWEBench等測試集作為基準。由於模型是基於互聯網抓取的大量資料集進行訓練的,因此訓練資料集可能包含了與基準測試中的問題高度相似的樣本。

這種污染可能導致模型的推理能力被錯誤評估 —— 它們可能只是在訓練過程中蒙到題了,正好背出了正確答案。

剛剛,Scale AI 的一篇論文對當前最熱門的大模型進行了深度調查,包括 OpenAI 的GPT-4、Gemini、Claude、Mistral、Llama、Phi、Abdin 等系列下參數量不同的模型。

測試結果證實了一個廣泛的疑慮:許多模型受到了基準數據的污染。

論文標題:A Careful Examination of Large Language Model Performance on Grade School Arithmetic

#論文連結:https://arxiv.org/pdf/2405.00332

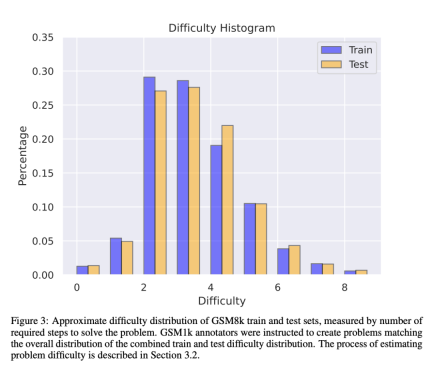

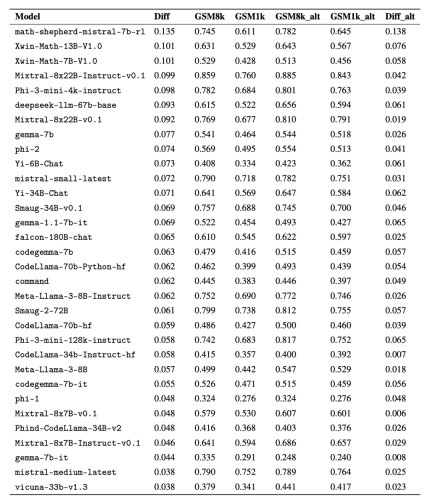

為了避免資料污染問題,來自Scale AI 的研究者們未使用任何LLM 或其他合成資料來源,完全依靠人工註釋創建了GSM1k 資料集。與 GSM8k 相似,GSM1k 內含有 1250 道小學級數學題。為了確保基準測試公平,研究者盡力確保了 GSM1k 在難度分佈上與 GSM8k 是相似的。在 GSM1k 上,研究者對一系列領先的開源和閉源大型語言模型進行了基準測試,結果發現表現最差的模型在 GSM1k 上的性能比在 GSM8k 上低 13%。

尤其是以量小質優聞名的 Mistral 和 Phi 模型系列,根據 GSM1k 的測試結果顯示,幾乎其中的所有版本都顯示出了過擬合的一致證據。

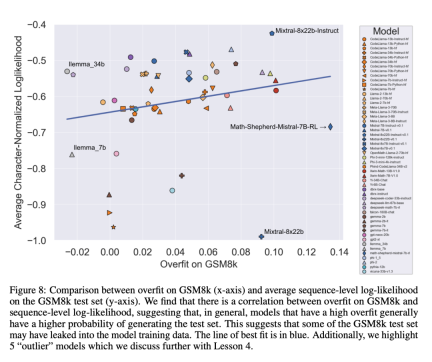

透過進一步分析發現,模型產生 GSM8k 樣本的機率與其在 GSM8k 和 GSM1k 之間的表現差距之間存在正相關關係(相關係數 r^2 = 0.32)。這強烈表明,過度擬合的主要原因是模型部分背出了 GSM8k 中的樣本。 不過,Gemini、GPT、Claude 以及 Llama2 系列過所顯示的適合跡象非常少。 此外,包括最過擬合的模型在內,所有模型仍能夠成功地泛化到新的小學數學問題,雖然有時的成功率低於其基準數據所示。

Scale AI 目前不打算公開 GSM1k,以防未來發生類似的資料污染問題。他們計劃定期對所有主要的開源和閉源 LLM 持續進行評估,也將開源評估程式碼,以便後續研究重現論文中的結果。

GSM1k 資料集

#GSM1k 內包含 1250 道小學數學題。這些問題只需基本的數學推理即可解決。 Scale AI 向每位人工註釋者展示 3 個 GSM8k 的樣本問題,並要求他們提出難度相似的新問題,得到了 GSM1k 資料集。 研究者要求人工註釋者們不要使用任何高階數學概念,只能使用基本算術(加法、減法、乘法和除法)來出題。與 GSM8k 一樣,所有題的解都是正整數。在建構 GSM1k 資料集的過程中,也沒有使用任何語言模型。

為了避免GSM1k 資料集的資料污染問題,Scale AI 目前不會公開發布該資料集,但將開源GSM1k 評估框架,該框架基於EleutherAI 的LM Evaluation Harness。

但Scale AI 承諾,在以下兩個條件中先達成某一項後,將在MIT 許可證下發布完整的GSM1k 資料集:(1) 有三個基於不同預訓練基礎模型譜系的開源模型在GSM1k 上達到95% 的準確率;(2) 至2025 年底。屆時,小學數學很可能不再足以作為評估 LLM 表現的有效基準。

為了評估專有模型,研究者將透過 API 的方式發布資料集。之所以採取這種發布方式,是論文作者認為,LLM 供應商通常不會使用 API 資料點來訓練模型模型。儘管如此,如果 GSM1k 資料透過 API 洩露了,論文作者還保留了未出現在最終 GSM1k 資料集中的資料點,這些備用資料點將在以上條件達成時隨 GSM1k 一併發布。

他們希望未來的基準測試發佈時也能遵循類似的模式 —— 先不公開發布,預先承諾在未來某個日期或滿足某個條件時發布,以防被操縱。

此外,儘管 Scale AI 盡力確保了 GSM8k 和 GSM1k 之間在最大程度上一致。 但 GSM8k 的測試集已經公開發布並廣泛地用於模型測試,因此 GSM1k 和 GSM8k 僅是在理想情況下的近似。 以下評估結果是 GSM8k 和 GSM1k 的分佈並非完全相同的情況下得出的。

評估結果

為了對模型進行評估,研究者使用了 EleutherAI 的 LM Evaluation Harness 分支,並使用了預設設定。 GSM8k 和 GSM1k 問題的運作 prompt 相同,都是從 GSM8k 訓練集中隨機抽取 5 個樣本,這也是該領域的標準配置(完整的 prompt 資訊見附錄 B)。

所有開源模型都在溫度為 0 時進行評估,以確保可重複性。 LM 評估工具包提取回應中的最後一個數字答案,並將其與正確答案進行比較。因此,以與樣本不符的格式產生「正確」答案的模型回應將被標記為不正確。

對於開源模型,如果模型與函式庫相容,會使用 vLLM 來加速模型推斷,否則預設使用標準 HuggingFace 函式庫進行推理。閉源模型透過 LiteLLM 函式庫進行查詢,該函式庫統一了所有已評估專有模型的 API 呼叫格式。所有 API 模型結果均來自 2024 年 4 月 16 日至 4 月 28 日期間的查詢,並使用預設設定。

在評估的模型方面,研究者是根據受歡迎程度選擇的,此外還評估了幾個在 OpenLLMLeaderboard 上排名靠前但鮮為人知的模型。

有趣的是,研究者在這個過程中發現了古德哈特定律(Goodhart's law)的證據:許多模型在GSM1k 上的表現比GSM8k 差很多,這表明它們主要是在迎合GSM8k基準,而不是在真正提高模型推理能力。所有模型的效能請參考下圖附錄 D。

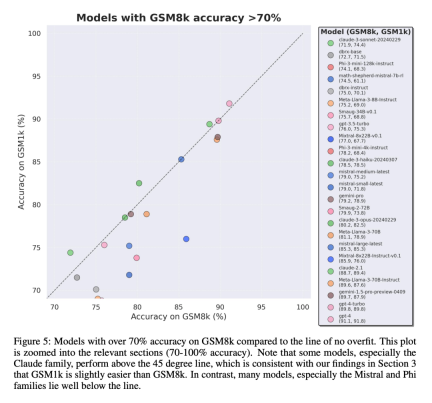

為了進行公平對比,研究者按照模型在GSM8k 上的表現對它們進行了劃分,並與其他表現類似的模型進行了對比(圖5、圖6、圖7)。

得出了哪些結論?

儘管研究者提供了多個模型的客觀評估結果,但同時表示,解釋評估結果就像對夢境的解釋一樣,往往是一項非常主觀的工作。在論文的最後一部分,他們以更主觀的方式闡述了上述評估的四個啟示:

結論1: 一些模型系列是系統性過擬合

#雖然通常很難從單一數據點或模型版本中得出結論,但檢查模型系列並觀察過擬合模式,可以做出更明確的陳述。一些模型系列,包括 Phi 和 Mistral,幾乎每個模型版本和規模都顯示出在 GSM8k 上比 GSM1k 表現更強的系統趨勢。還有其他模型系列,如 Yi、Xwin、Gemma 和 CodeLlama 也在較小程度上顯示出這種模式。

結論2: 其他模型,尤其是前緣模型,沒有表現出過擬合的跡象

許多模型在所有性能區域都顯示出很小的過擬合跡象,特別是包括專有Mistral Large 在內的所有前緣或接近前緣的模型,在GSM8k 和GSM1k 上的表現似乎相似。對此,研究者提出了兩個可能的假設:1)前沿模型具有足夠先進的推理能力,因此即使它們的訓練集中已經出現過GSM8k 問題,它們也能泛化到新的問題上;2)前沿模型的建構者可能對數據污染更為謹慎。

雖然不能查看每個模型的訓練集,也無法確定這些假設,但支持前者的一個證據是,Mistral Large 是 Mistral 系列中唯一沒有過擬合跡象的模型。 Mistral 只確保其最大模型不受資料污染的假設似乎不太可能,因此研究者傾向於足夠強大的 LLM 也會在訓練過程中學習基本的推理能力。如果一個模型學會了足夠強的推理能力來解決給定難度的問題,那麼即使 GSM8k 出現在其訓練集中,它也能夠泛化到新的問題上。

結論3: 過度擬合的模型仍然具有推理能力

很多研究者對模型過擬合的一種擔憂是,模型無法進行推理,而只是記憶訓練資料中的答案,但本論文的結果並不支持這個假設。模型過度擬合的事實並不意味著它的推理能力很差,而僅僅意味著它沒有基準所顯示的那麼好。事實上,研究者發現許多過度擬合模型仍然能夠推理和解決新問題。例如,Phi-3 在 GSM8k 和 GSM1k 之間的準確率幾乎下降了 10%,但它仍能正確解決 68% 以上的 GSM1k 問題 —— 這些問題肯定沒有出現在它的訓練分佈中。 這一表現與 dbrx-instruct 等更大型的模型相似,而後者包含的參數數量幾乎是它們的 35 倍。同樣地,即使考慮到過度擬合的因素,Mistral 模型仍然是最強的開源模型之一。 這為本文結論提供了更多證據,即足夠強大的模型可以學習基本推理,即使基準資料意外洩漏到訓練分佈中,大多數過擬合模型也可能出現這種情況。

結論4: 資料污染可能不是過擬合的完整解釋

一個先驗的、自然的假設是,造成過擬合的主要原因是數據污染,例如,在創建模型的預訓練或指令微調部分,測試集被洩露了。過去的研究表明,模型會對其在訓練過程中見過的數據賦予更高的對數似然性(Carlini et al. [2023])。研究者透過測量模型從 GSM8k 測試集中產生樣本的機率,並將其與 GSM8k 和 GSM1k 相比的過度擬合程度進行比較,來驗證數據污染是造成過擬合的原因這一假設。

研究者表示,資料污染可能並不是全部原因。他們透過幾個異常值觀察到了這一點。仔細研究這些異常值可以發現,每個字元對數似然值最低的模型(Mixtral-8x22b)和每個字元對數似然值最高的模型(Mixtral-8x22b-Instruct)不僅是同一模型的變體,而且具有相似的過擬合程度。更有趣的是,過擬合程度最高的模型(Math-Shepherd-Mistral-7B-RL (Yu et al. [2023]))的每個字元對數似然值相對較低(Math Shepherd 使用合成數據在流程級資料上訓練獎勵模型)。

因此,研究人員假設獎勵建模過程可能洩露了有關 GSM8k 的正確推理鏈的信息,即使這些問題本身從未出現在資料集中。最後他們發現, Llema 模型具有高對數似然和最小過度擬合。由於這些模型是開源的,其訓練資料也是已知的,因此正如 Llema 論文中所述,訓練語料庫中出現了幾個 GSM8k 問題實例。不過,作者發現這幾個實例並沒有導致嚴重的過度擬合。這些異常值的存在表明,GSM8k 上的過度擬合並非純粹是由於數據污染造成的,而可能是透過其他間接方式造成的,例如模型建構者收集了與基準性質相似的數據作為訓練數據,或者根據基準上的表現選擇最終模型檢查點,即使模型本身可能在訓練的任何時候都沒有看到GSM8k 資料集。反之亦然:少量的數據污染並不一定會導致過擬合。

更多研究細節,可參考原論文。

以上是終於有人調查了小模型過擬合:三分之二都有資料污染,微軟Phi-3、Mixtral 8x22B被點名的詳細內容。更多資訊請關注PHP中文網其他相關文章!

如何使用Huggingface Smollm建立個人AI助手Apr 18, 2025 am 11:52 AM

如何使用Huggingface Smollm建立個人AI助手Apr 18, 2025 am 11:52 AM利用“設備” AI的力量:建立個人聊天機器人CLI 在最近的過去,個人AI助手的概念似乎是科幻小說。 想像一下科技愛好者亞歷克斯(Alex)夢見一個聰明的本地AI同伴 - 不依賴

通過斯坦福大學激動人心的新計劃,精神健康的AI專心分析Apr 18, 2025 am 11:49 AM

通過斯坦福大學激動人心的新計劃,精神健康的AI專心分析Apr 18, 2025 am 11:49 AM他們的首屆AI4MH發射於2025年4月15日舉行,著名的精神科醫生兼神經科學家湯姆·因斯爾(Tom Insel)博士曾擔任開幕式演講者。 Insel博士因其在心理健康研究和技術方面的傑出工作而聞名

2025年WNBA選秀課程進入聯盟成長並與在線騷擾作鬥爭Apr 18, 2025 am 11:44 AM

2025年WNBA選秀課程進入聯盟成長並與在線騷擾作鬥爭Apr 18, 2025 am 11:44 AM恩格伯特說:“我們要確保WNBA仍然是每個人,球員,粉絲和公司合作夥伴,感到安全,重視和授權的空間。” anno

Python內置數據結構的綜合指南 - 分析VidhyaApr 18, 2025 am 11:43 AM

Python內置數據結構的綜合指南 - 分析VidhyaApr 18, 2025 am 11:43 AM介紹 Python擅長使用編程語言,尤其是在數據科學和生成AI中。 在處理大型數據集時,有效的數據操作(存儲,管理和訪問)至關重要。 我們以前涵蓋了數字和ST

與替代方案相比,Openai新型號的第一印象Apr 18, 2025 am 11:41 AM

與替代方案相比,Openai新型號的第一印象Apr 18, 2025 am 11:41 AM潛水之前,一個重要的警告:AI性能是非確定性的,並且特定於高度用法。簡而言之,您的里程可能會有所不同。不要將此文章(或任何其他)文章作為最後一句話 - 目的是在您自己的情況下測試這些模型

AI投資組合|如何為AI職業建立投資組合?Apr 18, 2025 am 11:40 AM

AI投資組合|如何為AI職業建立投資組合?Apr 18, 2025 am 11:40 AM建立杰出的AI/ML投資組合:初學者和專業人士指南 創建引人注目的投資組合對於確保在人工智能(AI)和機器學習(ML)中的角色至關重要。 本指南為建立投資組合提供了建議

代理AI對安全操作可能意味著什麼Apr 18, 2025 am 11:36 AM

代理AI對安全操作可能意味著什麼Apr 18, 2025 am 11:36 AM結果?倦怠,效率低下以及檢測和作用之間的差距擴大。這一切都不應該令任何從事網絡安全工作的人感到震驚。 不過,代理AI的承諾已成為一個潛在的轉折點。這個新課

Google與Openai:AI為學生打架Apr 18, 2025 am 11:31 AM

Google與Openai:AI為學生打架Apr 18, 2025 am 11:31 AM直接影響與長期夥伴關係? 兩週前,Openai提出了強大的短期優惠,在2025年5月底之前授予美國和加拿大大學生免費訪問Chatgpt Plus。此工具包括GPT-4O,A A A A A

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3 Linux新版

SublimeText3 Linux最新版

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境