NeRF與自動駕駛的前世今生,近10篇論文總結!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-11-14 15:09:191887瀏覽

神經輻射場(Neural Radiance Fields)自2020年被提出以來,相關論文數量呈指數增長,不但成為了三維重建的重要分支方向,也逐漸作為自動駕駛重要工具活躍在研究前沿。

NeRF這兩年異軍突起,主要因為它跳過了傳統CV重建pipeline的特徵點提取和匹配、對極幾何與三角化、PnP加Bundle Adjustment等步驟,甚至跳過mesh的重建、貼圖和光追,直接從2D輸入影像學習一個輻射場,然後從輻射場輸出逼近真實照片的渲染影像。也就是說,讓一個基於神經網路的隱式三維模型,去擬合指定視角下的2D影像,並使其兼具新視角合成和能力。 NeRF的發展也和自動駕駛息息相關,具體體現在真實的場景重建和自動駕駛模擬器的應用。 NeRF擅長呈現照片等級的影像渲染,因此以NeRF建模的街景能夠為自動駕駛提供高真實感的訓練資料;NeRF的地圖可以編輯,將建築、車輛、行人組合成各種現實中難以捕捉的corner case,能夠用於檢驗感知、規劃、避障等演算法的效能。因此,NeRF作為一個三維重建的分支方向和建模工具,掌握NeRF已經成為了研究者們做重建或自動駕駛方向必不可少的技能。

今天為大家梳理下Nerf與自動駕駛相關的內容,近11篇文章,帶著大家探索Nerf與自動駕駛的前世今生;

#1.Nerf開山之作

重新寫的內容是:NeRF:用於視圖合成的神經輻射場表示場景。 ECCV2020

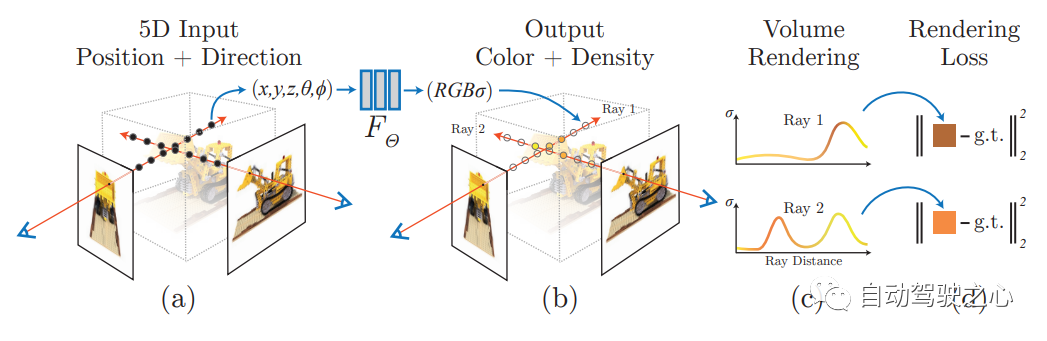

在首篇中,提出了一種Nerf方法,利用稀疏的輸入視圖集來優化底層連續體積場景函數,從而實現合成複雜場景的最新視圖結果。此演算法採用全連接(非卷積)深度網路來表示場景,輸入為單一連續的5D座標(包括空間位置(x,y,z)和觀看方向(θ,ξ)),輸出為該空間位置的體積密度和與視圖相關的發射輻射

NERF用2D 的posed images 作為監督,無需對圖像進行卷積,而是透過不斷學習位置編碼,用圖像顏色作為監督,來學習一組隱式參數,表示複雜的三維場景。透過隱式表示,可以完成任意視角的渲染。

2.Mip-NeRF 360

CVPR2020的研究內容是關於室外無邊界場景的。其中,Mip-NeRF 360:無邊界抗鋸齒神經輻射場是其中的一個研究方向

論文連結:https://arxiv.org/pdf/2111.12077.pdf

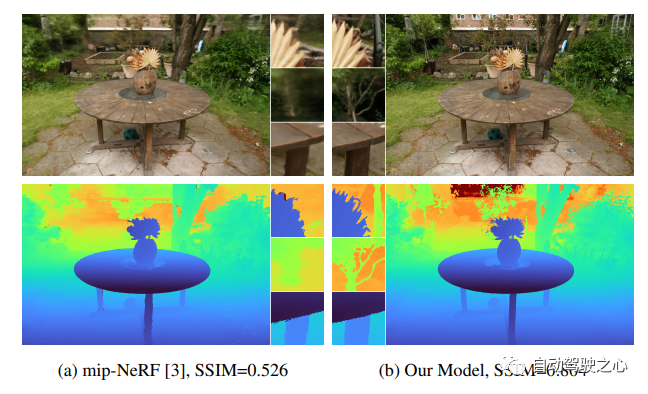

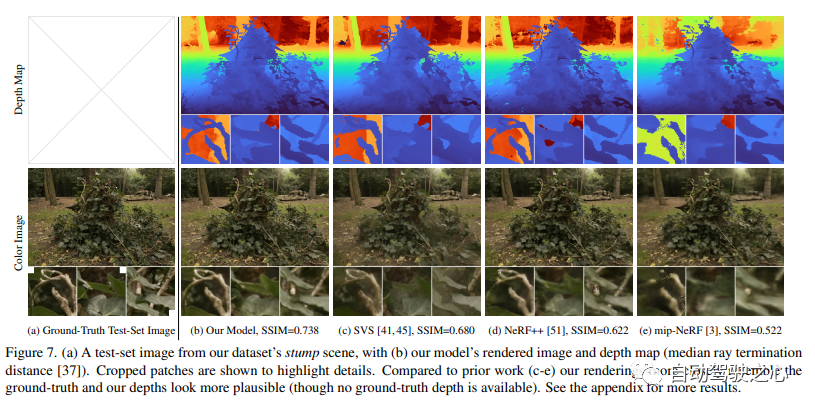

儘管神經輻射場(NeRF)已經在物體和空間的小邊界區域上展示了不錯的視圖合成結果,但它們在“無邊界”場景中很難實現,在這些場景中,相機可能指向任何方向,內容可能存在於任何距離。在這種情況下,現有的類NeRF模型通常會產生模糊或低解析度的渲染(由於附近和遠處物體的細節和比例不平衡),訓練速度較慢,並且由於從一組小圖像重建大場景的任務的固有模糊性,可能會出現偽影。本文提出了mip-NeRF(一種解決採樣和混疊問題的NeRF變體)的擴展,它使用非線性場景參數化、在線蒸餾和一種新的基於失真的正則化子來克服無界場景帶來的挑戰。與mip-NeRF相比,均方誤差減少了57%,並且能夠為高度複雜、無邊界的真實世界場景產生逼真的合成視圖和詳細的深度圖。

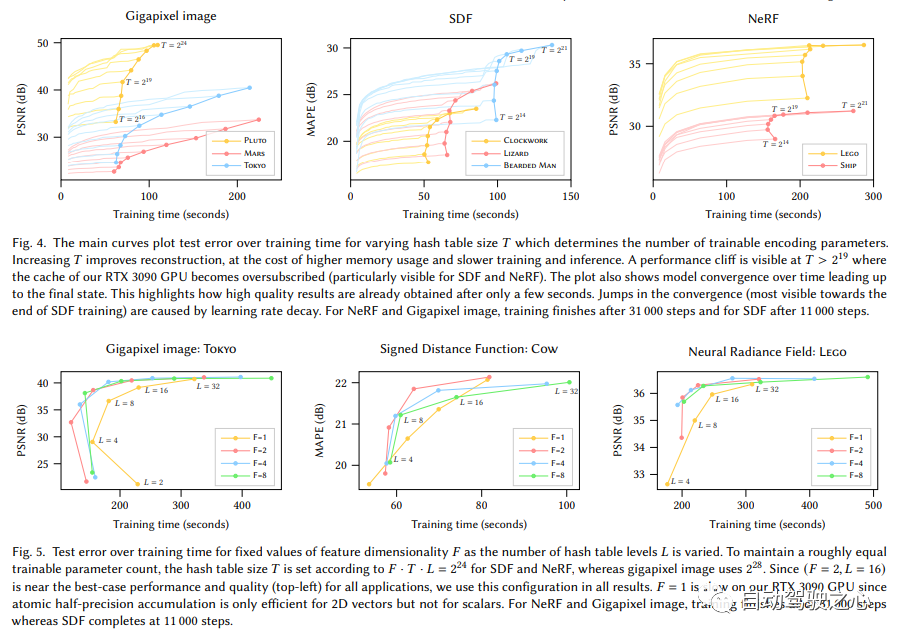

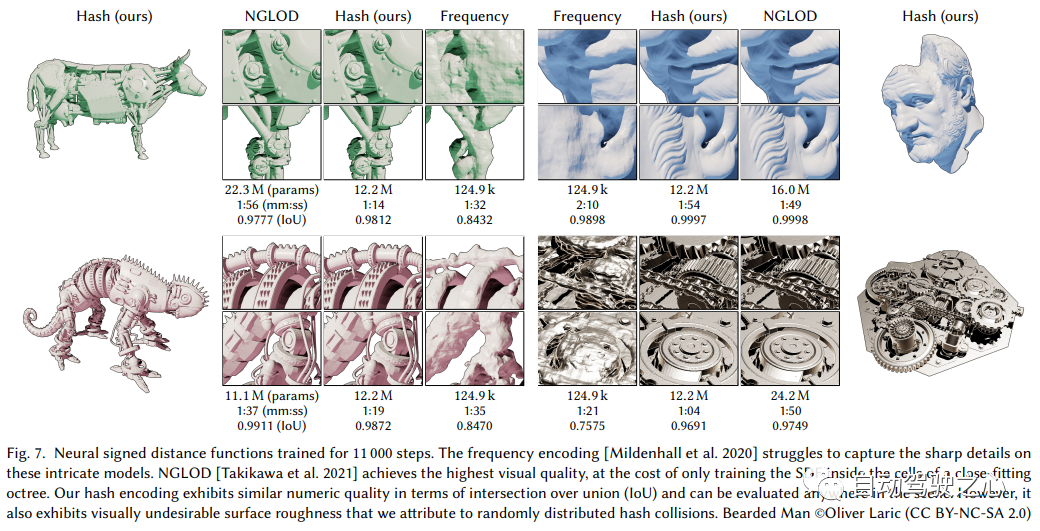

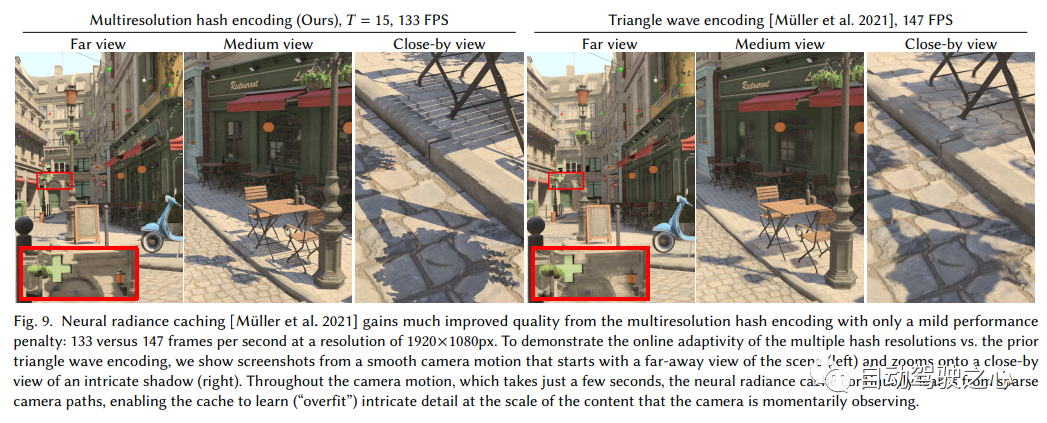

3.Instant-NGP

需要進行改寫的內容是:《顯示體素加隱式特徵的混合場景表達(SIGGRAPH 2022)》

用多分辨率哈希編碼的即時神經圖形基元

需要重寫的內容是:連結:https ://nvlabs.github.io/instant-ngp

讓我們先來看看Instant-NGP和NeRF之間的異同:

- 同樣基於體渲染

- 不同於NeRF的MLP,NGP使用稀疏的參數化的voxel grid作為場景表達;

- 基於梯度,同時優化場景和MLP(其中一個MLP用作decoder)。

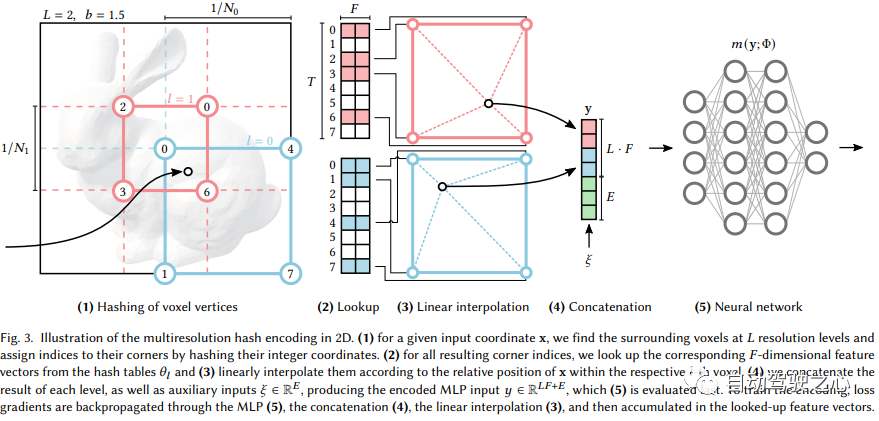

可以看出,大的框架還是一樣的,最重要的不同,是NGP選取了參數化的voxel grid作為場景表達。透過學習,讓voxel中保存的參數成為場景密度的形狀。 MLP最大的問題就是慢。為了能高品質重建場景,往往需要一個比較大的網絡,每個採樣點過一遍網路就會耗費大量時間。而在grid內插值就快的多。但grid要表達高精度的場景,就需要高密度的voxel,會造成極高的記憶體佔用。考慮到場景中有很多地方是空白的,所以NVIDIA就提出了一個稀疏的結構來表達場景。

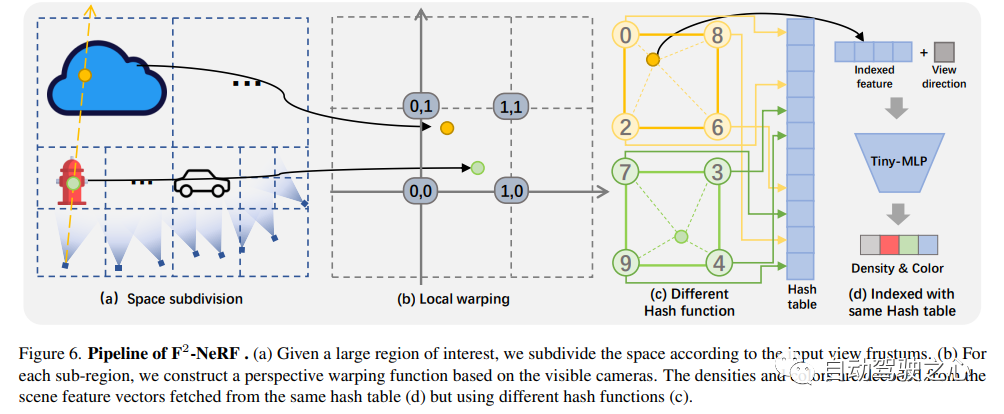

4. F2-NeRF

F2-NeRF: Fast Neural Radiance Field Training with Free Camera Trajectories

論文連結:https://totoro97.github.io/projects/f2-nerf/

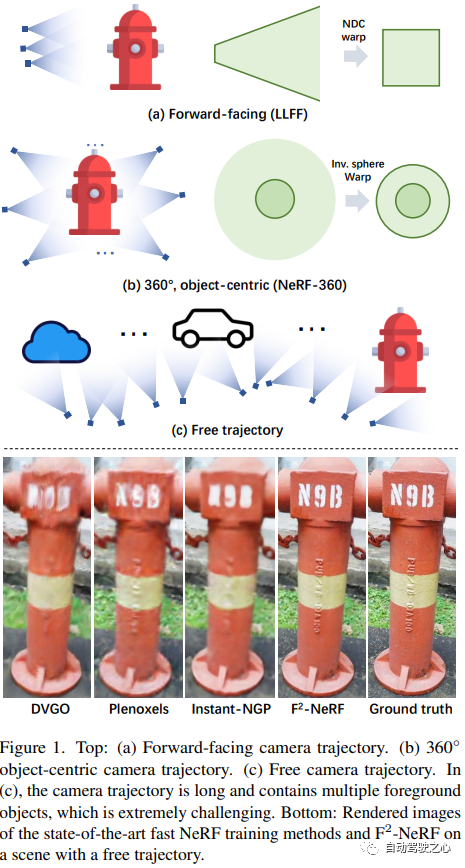

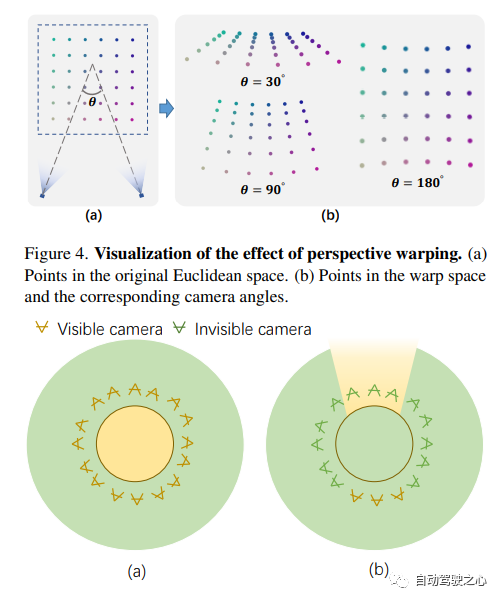

提出了一種新的基於網格的NeRF,稱為F2-NeRF(Fast Free NeRF),用於新的視圖合成,它可以實現任意輸入的相機軌跡,並且只需要幾分鐘的訓練時間。現有的基於快速網格的NeRF訓練框架,如Instant NGP、Plenoxels、DVGO或TensoRF,主要針對有界場景設計,並依靠空間warpping來處理無界場景。現有的兩種廣泛使用的空間warpping方法僅針對面向前方的軌跡或360◦ 以物體為中心的軌跡,但不能處理任意的軌跡。本文深入研究了空間warpping處理無界場景的機制。進一步提出了一種新的空間warpping方法,稱為透視warpping,它允許我們在基於網格的NeRF框架中處理任意軌跡。大量實驗表明,F2-NeRF能夠在收集的兩個標準資料集和一個新的自由軌跡資料集上使用相同的視角warpping來渲染高品質影像。

#5.MobileNeRF

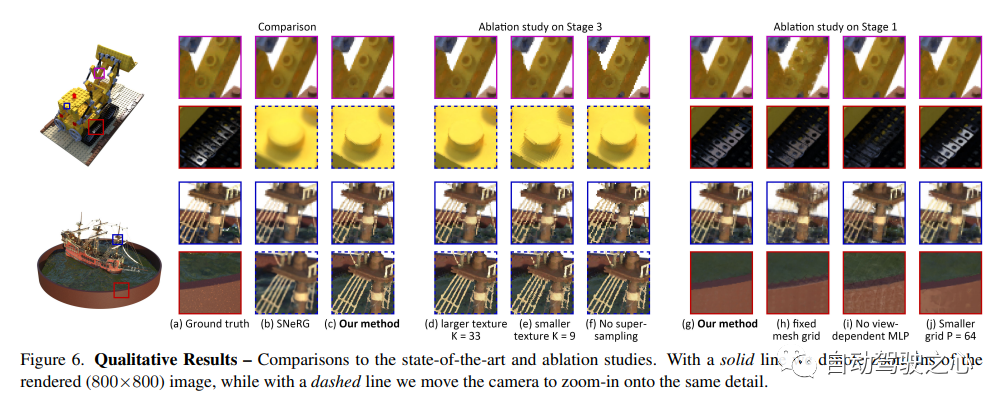

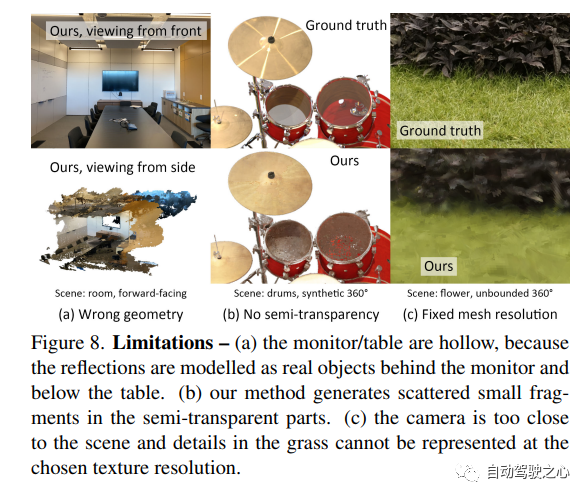

即時渲染在行動端的應用,實現了Nerf導出Mesh的功能,而這項技術已經被CVPR2023會議錄用!

MobileNeRF: Exploiting the Polygon Rasterization Pipeline for Efficient Neural Field Rendering on Mobile Architectures.

需要重寫的內容是:https://arxiv.org/pdf/2208.00277.pdf

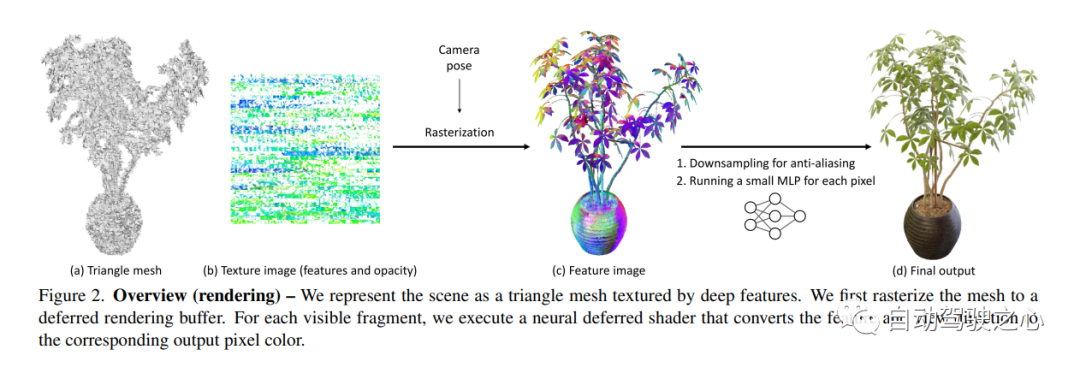

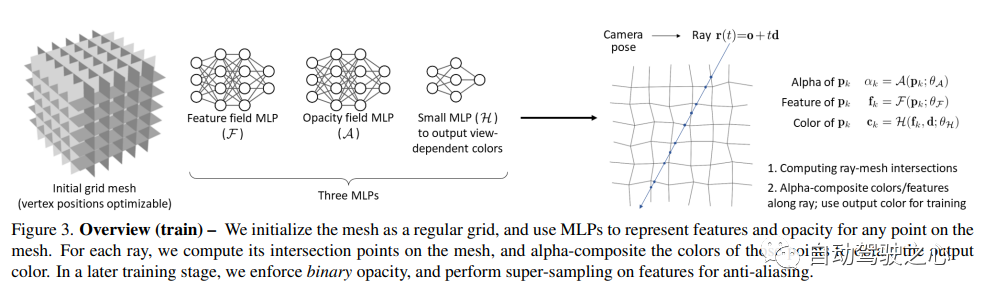

神經輻射場(NeRF)已經證明了從新穎的視圖合成3D場景影像的驚人能力。然而,它們依賴基於光線行進的專用volumetric 渲染演算法,這些演算法與廣泛部署的圖形硬體的功能不匹配。本文介紹了一種新的基於紋理多邊形的NeRF表示,該表示可以透過標準渲染pipeline有效地合成新影像。 NeRF表示為一組多邊形,其紋理表示二元不透明性和特徵向量。使用z緩衝區對多邊形進行傳統渲染會產生每個像素都具有特徵的圖像,這些特徵由片段著色器中運行的小型視圖相關MLP進行解釋,以產生最終的像素顏色。這種方法使NeRF能夠使用傳統的多邊形光柵化pipeline進行渲染,該pipeline提供了巨大的像素級並行性,在包括手機在內的各種運算平台上實現互動式幀率。

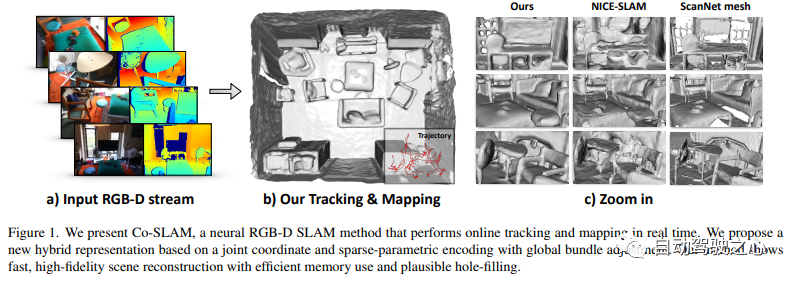

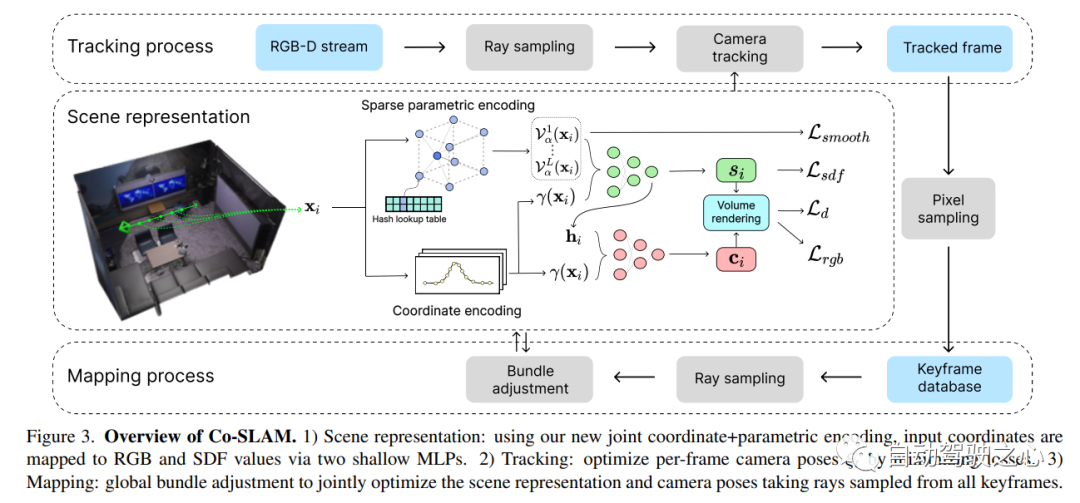

6.Co-SLAM

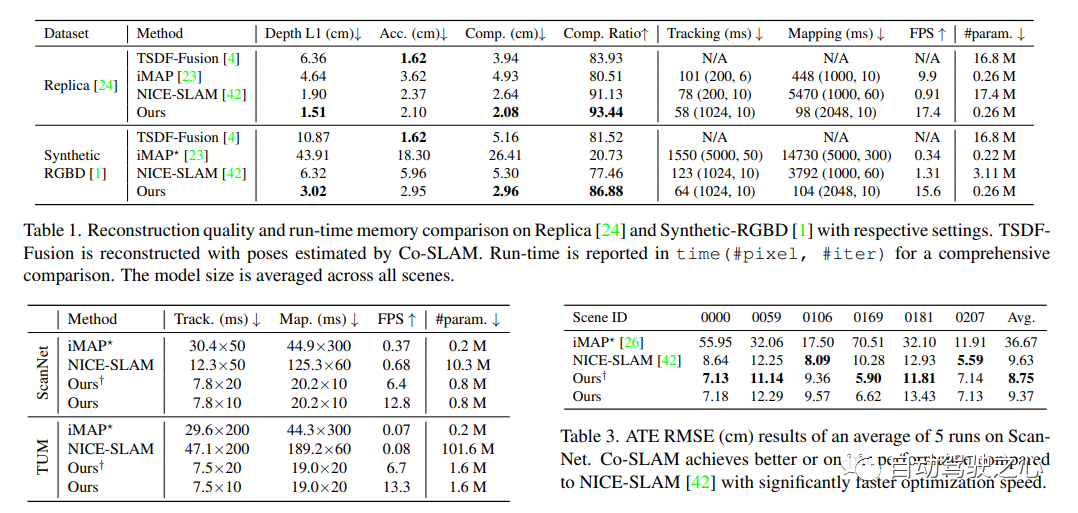

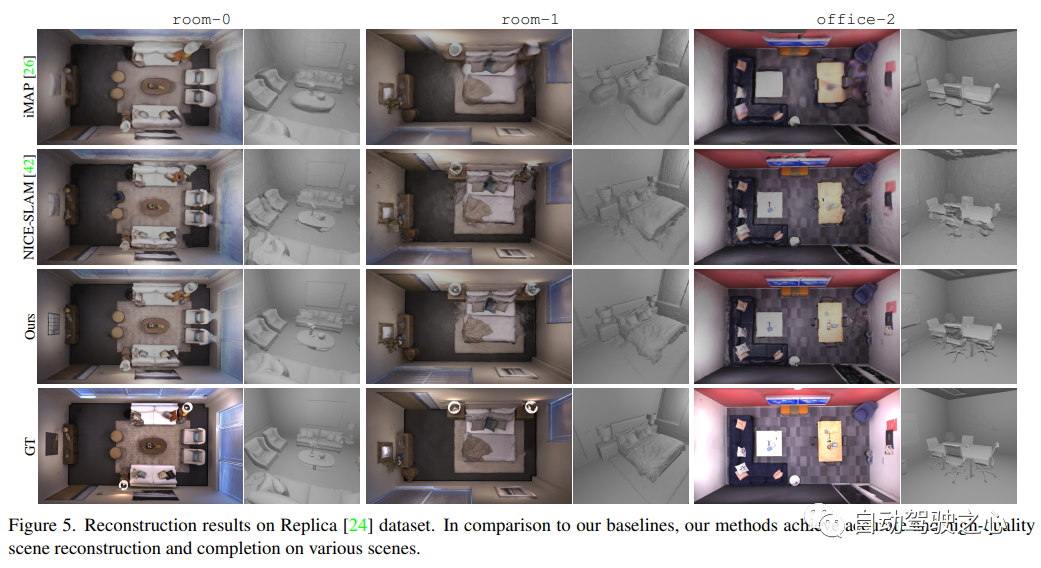

我們的即時視覺定位和NeRF建圖工作已被收錄在CVPR2023

# Co-SLAM: Joint Coordinate and Sparse Parametric Encodings for Neural Real-Time SLAM

論文連結:https://arxiv.org/pdf/2304.14377.pdf

#Co-SLAM是一個即時的RGB-D SLAM系統,使用神經隱式表示進行相機追蹤和高保真度的表面重建。 Co-SLAM將場景表示為多解析度哈希網格,以利用其快速收斂和表示局部特徵的能力。此外,為了融合表面一致性先驗,Co-SLAM使用了塊狀編碼方法,證明它能夠強大地完成未觀測區域的場景補全。我們的聯合編碼結合了Co-SLAM的速度、高保真度重建和表面一致性先驗的優點,透過射線採樣策略,Co-SLAM能夠對所有關鍵影格進行全域捆綁調整!

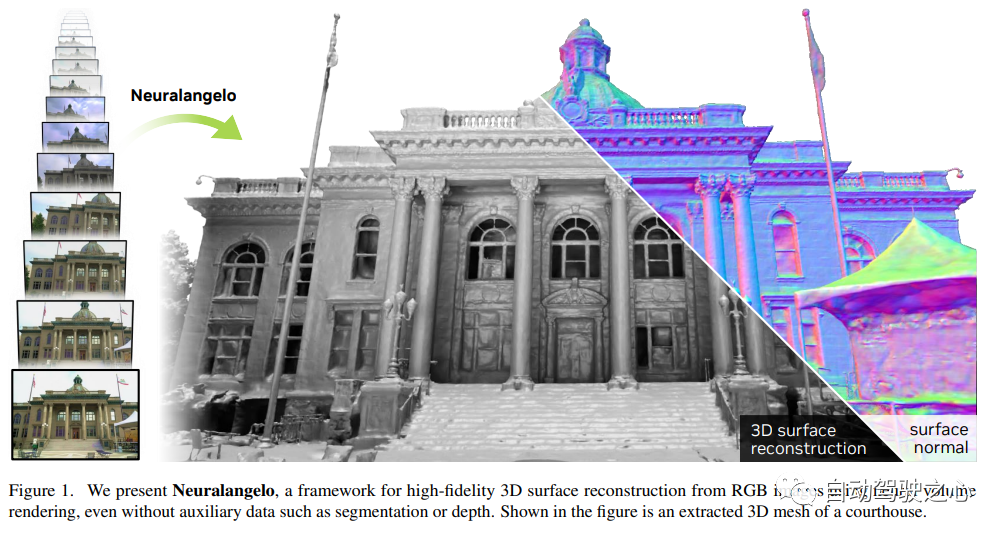

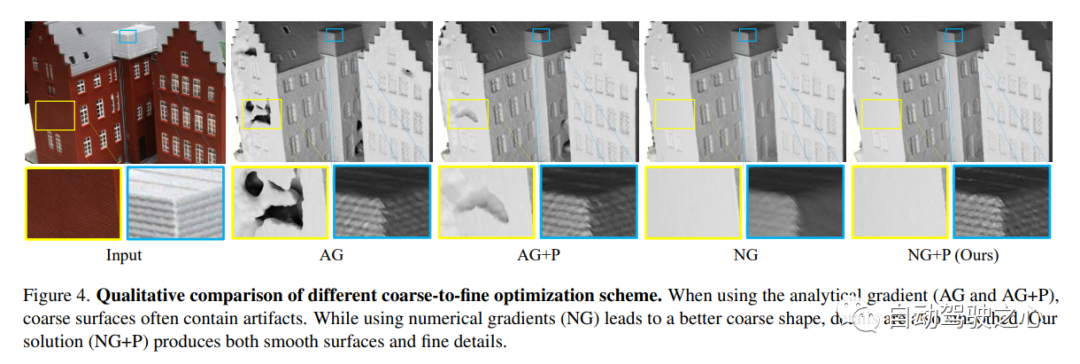

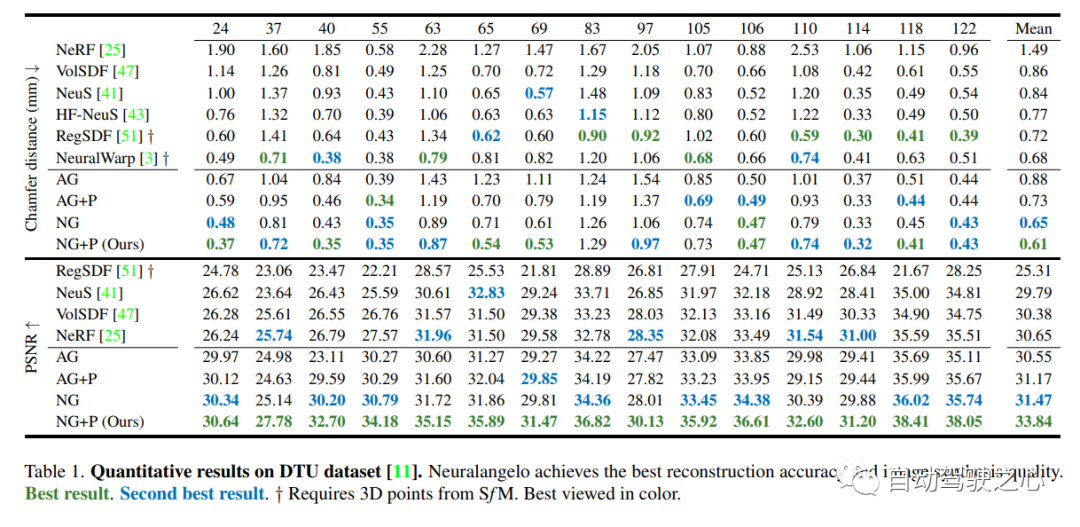

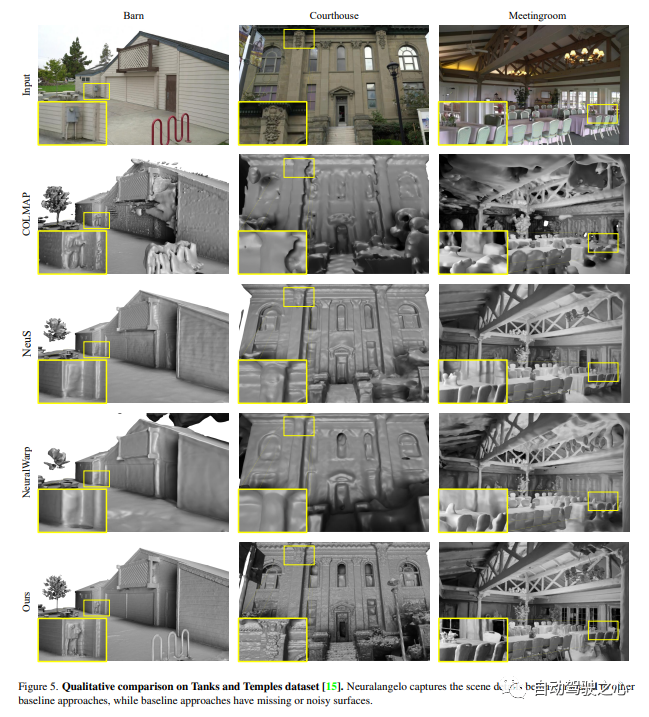

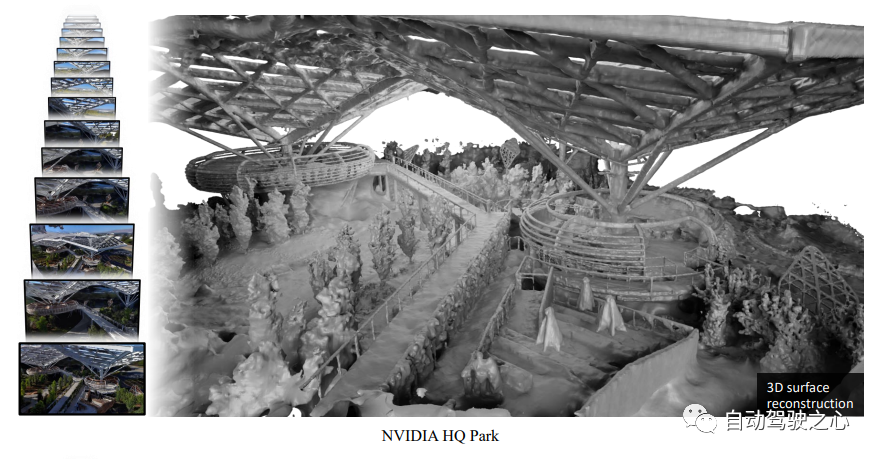

#7.Neuralangelo

目前最好的NeRF表面重建方法(CVPR2023)

#重新編寫的內容如下: 基於影像的神經渲染已被證明能夠重建神經表面,以恢復密集的3D結構。然而,目前的方法在恢復真實世界場景的詳細結構方面仍存在困難。為了解決這個問題,本研究提出了一種名為Neuralangelo的方法,它將多重解析度3D雜湊網格的表示能力與神經表面渲染結合。這種方法的兩個關鍵因素是:

(1) 用於計算作為平滑操作的高階導數的數值梯度,以及(2)控制不同細節層級的哈希網格上的從粗到細優化。

即使沒有深度等輔助輸入,Neuralangelo仍然能夠有效地從多視圖影像中恢復密集的3D表面結構。與以往的方法相比,其保真度大大提升,使得可以從RGB視訊擷取中進行詳細的大規模場景重建!

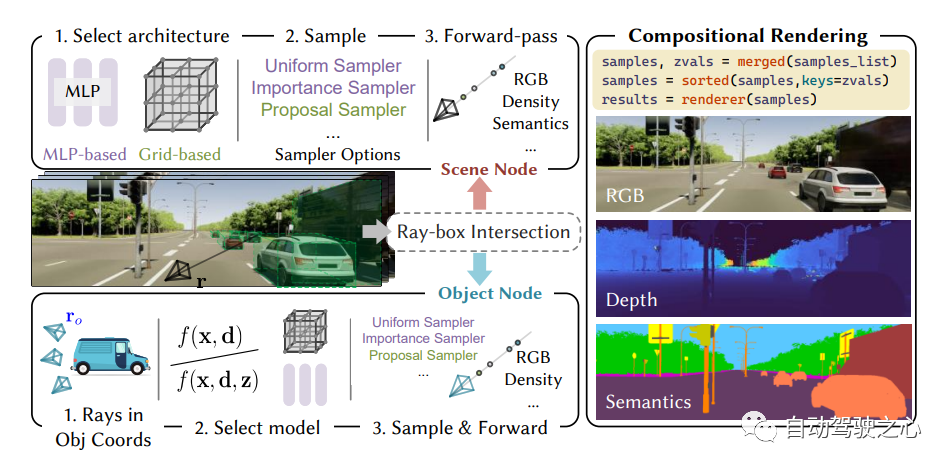

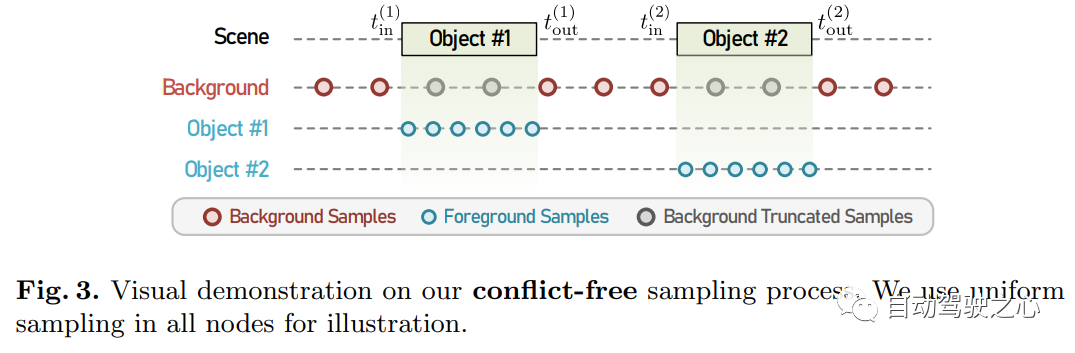

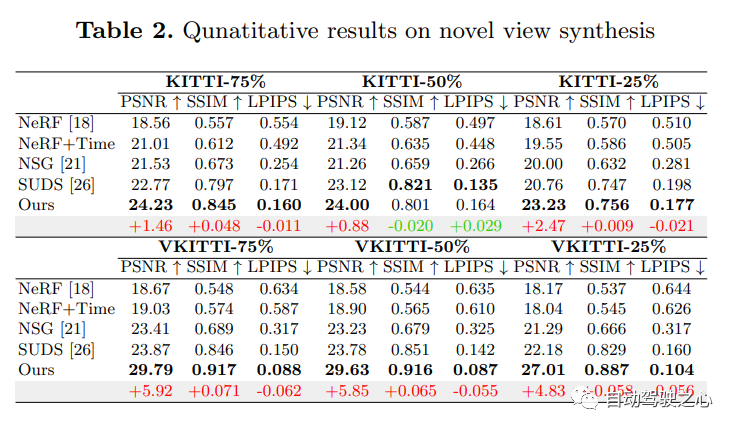

8.MARS

首個開源自動駕駛NeRF模擬工具。

需要重寫的是:https://arxiv.org/pdf/2307.15058.pdf

自動駕駛汽車在普通情況下可以平穩行駛,人們普遍認為,逼真的感測器模擬將在解決剩餘拐角情況方面發揮關鍵作用。為此,MARS提出了一種基於神經輻射場的自動駕駛模擬器。與現有作品相比,MARS有三個顯著特點:(1)實例意識。模擬器使用獨立的網路分別對前景實例和背景環境進行建模,以便可以分別控制實例的靜態(例如大小和外觀)和動態(例如軌跡)特性。 (2) 模組化。模擬器允許在不同的現代NeRF相關主幹、採樣策略、輸入模式等之間靈活切換。希望這種模組化設計能夠推動基於NeRF的自動駕駛模擬的學術進步和工業部署。 (3) 真實。模擬器在最佳模組選擇的情況下,設定了最先進的真實感結果。

最重要的一點是:開源!

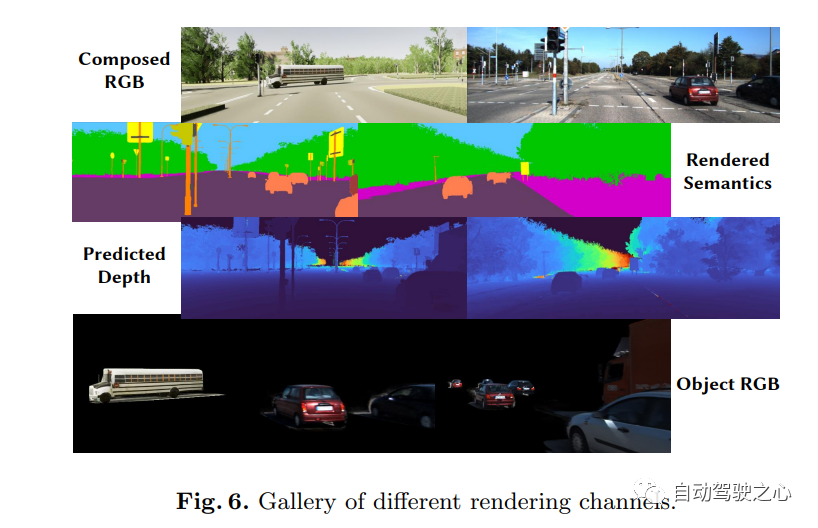

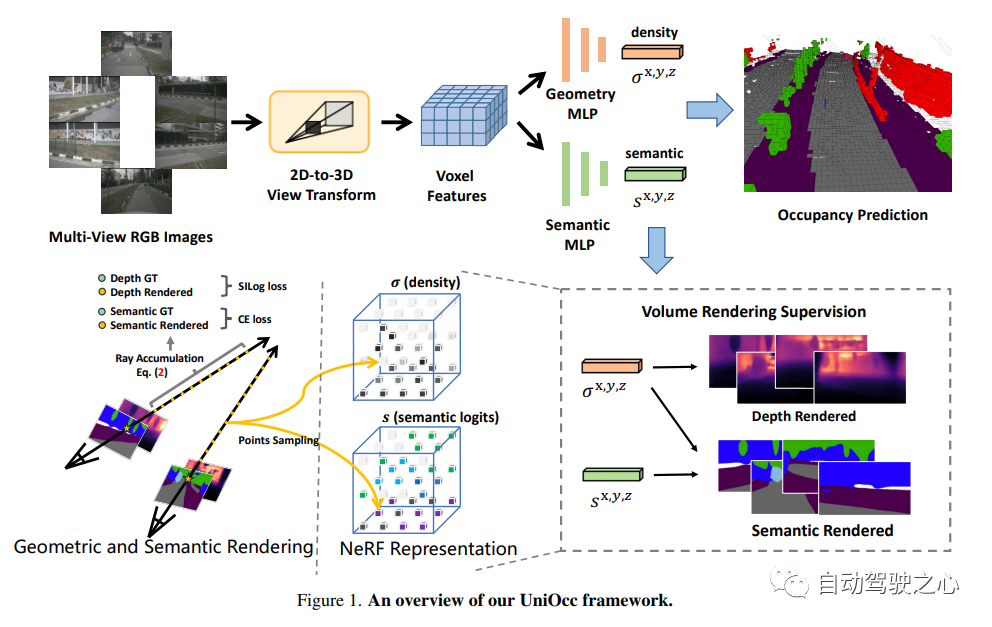

9.UniOcc

对于需要重新写作的内容,“NeRF和3D占用网络,AD2023挑战”

UniOcc: Unifying Vision-Centric 3D Occupancy Prediction with Geometric and Semantic Rendering.

论文链接:https://arxiv.org/abs/2306.09117

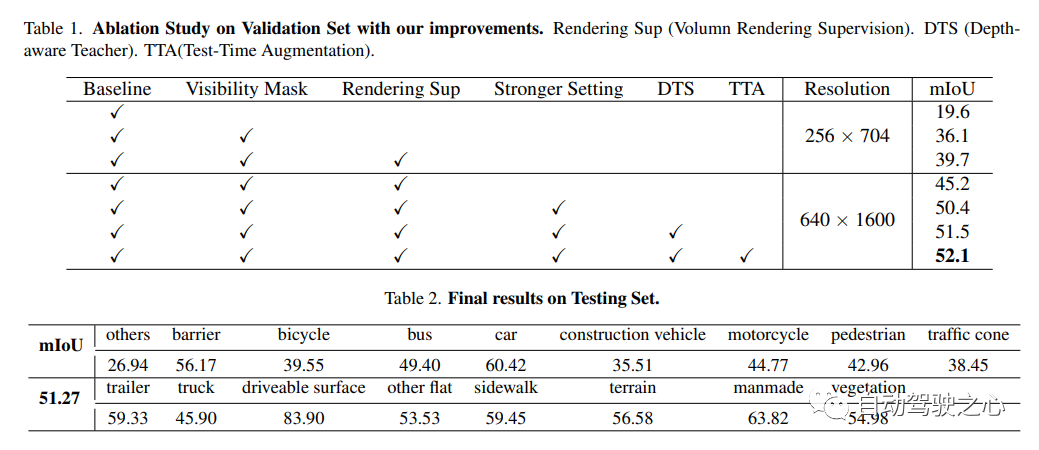

UniOCC是一个以视觉为中心的3D占用预测方法。传统的占用预测方法主要使用3D占用标签来优化3D空间的投影特征,但是这些标签的生成过程复杂且昂贵,需要依赖于3D语义注释,并且受到体素分辨率的限制,无法提供细粒度的空间语义。为了解决这个问题,本文提出了一种新的统一占用(UniOcc)预测方法,它明确施加空间几何约束,并通过体射线渲染来补充细粒度的语义监督。这种方法显著提高了模型的性能,并展示了在降低人工标注成本方面的潜力。考虑到标注3D占用的复杂性,我们进一步引入了深度感知师生(DTS)框架,利用未标记的数据来提高预测的精度。我们的解决方案在单机型的官方排行榜上取得了51.27%的mIoU成绩,在本次挑战中排名第三

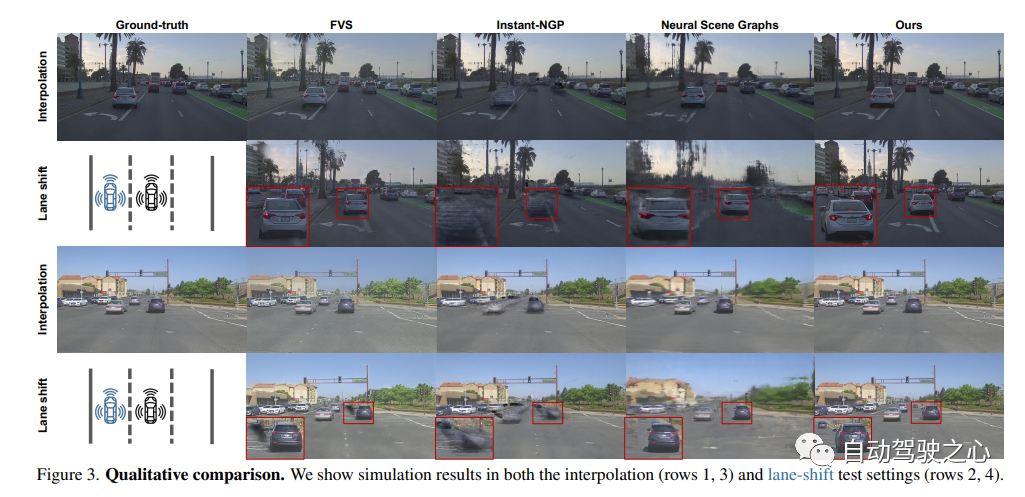

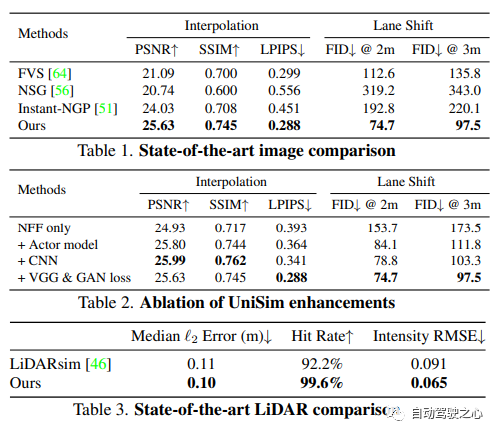

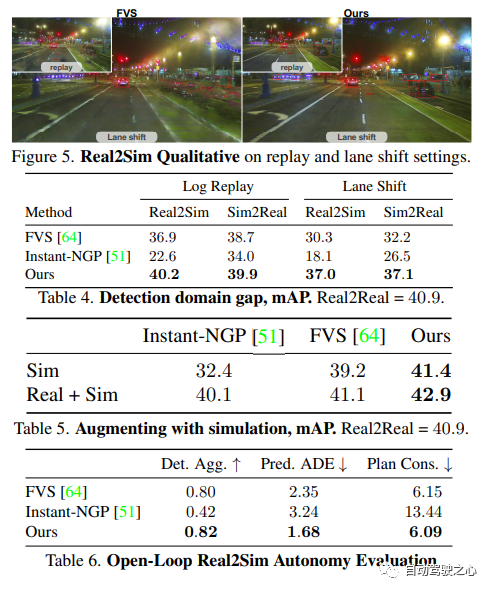

10.Unisim

哇嗷嗷出品,绝对是精品啊!

UniSim:一个神经闭环传感器模拟器

论文链接:https://arxiv.org/pdf/2308.01898.pdf

阻碍自动驾驶普及的一个重要原因是安全性仍然不够。真实世界过于复杂,尤其是存在长尾效应。边界场景对安全驾驶至关重要,很多样,但又很难遇到。测试自动驾驶系统在这些场景的表现非常困难,因为这些场景很难遇到,而且在真实世界中测试非常昂贵和危险

为了解决这个挑战,工业界和学术界都开始重视仿真系统的开发。一开始,仿真系统主要专注于模拟其他车辆/行人的运动行为,测试自动驾驶规划模块的准确性。而最近几年,研究重心逐渐转向传感器层面的仿真,即仿真生成激光雷达、相机图片等原始数据,实现端到端测试自动驾驶系统从感知、预测一直到规划。

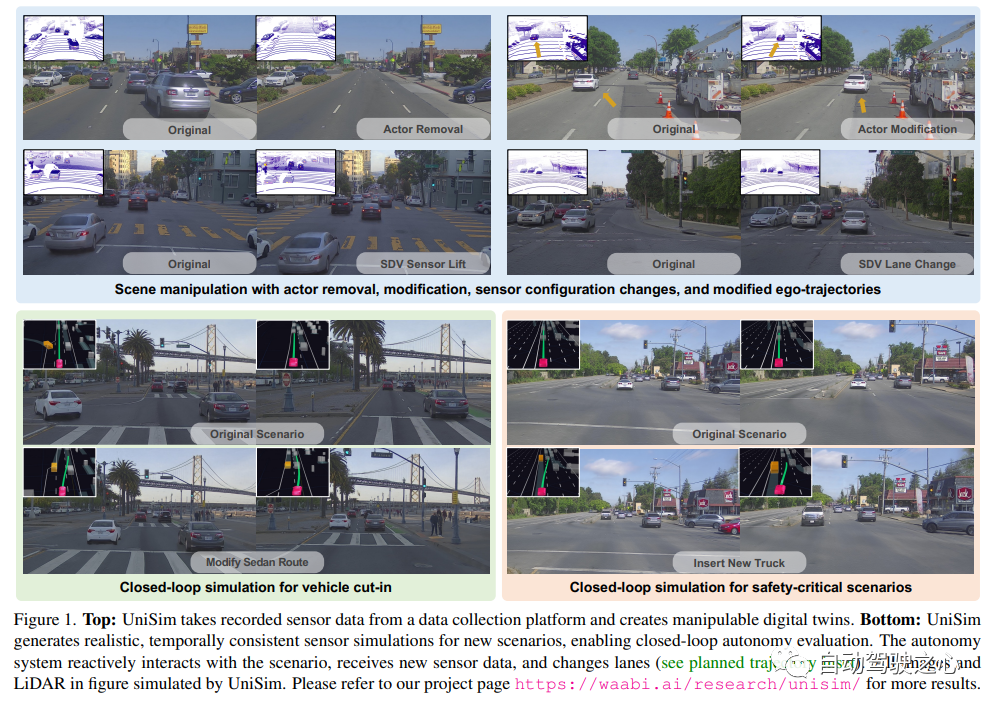

不同于以往工作, UniSim首次同时做到了:

- 高度逼真(high realism): 可以准确地模拟真实世界(图片和LiDAR), 减小鸿沟(domain gap )

- 闭环测试(closed-loop simulation): 可以生成罕见的危险场景测试无人车, 并允许无人车和环境自由交互

- 可扩展 (scalable): 可以很容易的扩展到更多的场景, 只需要采集一次数据, 就能重建并仿真测

需要重新写作的内容是:仿真系统的构建

UniSim 首先从采集的数据中,在数字世界中重建自动驾驶场景,包括汽车、行人、道路、建筑和交通标志。然后,控制重建的场景进行仿真,生成一些罕见的关键场景。

闭环仿真(closed-loop simulation)

UniSim可以进行闭环的仿真测试,首先, 通过控制汽车的行为, UniSim可以创建一个危险的罕见场景, 比如有一辆汽车在当前车道突然迎面驶来;然后, UniSim仿真生成对应的数据;接着, 运行自动驾驶系统, 输出路径规划的结果;根据路径规划的结果, 无人车移动到下一个指定位置, 并更新场景(无人车和其他车辆的位置);然后我们继续进行仿真, 运行自动驾驶系统, 更新虚拟世界状态 ……通过这种闭环测试, 自动驾驶系统和仿真环境可以进行交互, 创造出与原始数据完全不一样的场景

以上是NeRF與自動駕駛的前世今生,近10篇論文總結!的詳細內容。更多資訊請關注PHP中文網其他相關文章!