GPT-4 的思考方式,越來越像人了。

人類在做錯事時,會反思自己的行為,避免再次出錯,如果讓 GPT-4 這類大型語言模型也具備反思能力,性能不知道要提高多少了。

眾所周知,大型語言模型 (LLM) 在各種任務上已經表現出前所未有的表現。然而,這些 SOTA 方法通常需要對已定義的狀態空間進行模型微調、策略最佳化等操作。由於缺乏高品質的訓練資料、定義良好的狀態空間,優化模型實現起來還是比較難的。此外,模型還不具備人類決策過程所固有的某些特質,特別是從錯誤中學習的能力。

不過現在好了,在最近的一篇論文中,來自美國東北大學、MIT 等機構的研究者提出 Reflexion,該方法賦予智能體動態記憶和自我反思的能力。

為了驗證方法的有效性,研究評估了智能體在AlfWorld 環境中完成決策任務的能力,以及在HotPotQA 環境中完成知識密集型、基於搜尋問答任務的能力,在這兩項任務的成功率分別為97% 和51%。

論文網址:https://arxiv.org/pdf/2303.11366.pdf

計畫網址:https://github.com/GammaTauAI/ reflexion-human-eval

如下圖所示,在AlfWorld 環境中,房間裡擺設了各種物品,要求讓智能體給出推理計劃以拿到某件物體,下圖上半部分由於智能體低效率的計劃而失敗。經過反思後,智能體意識到錯誤,修正推理軌跡,給出簡潔的軌跡方式(如圖下半部)。

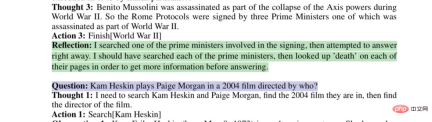

模型反思有缺陷的搜尋策略:

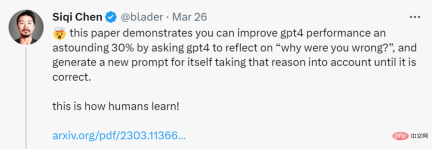

#這篇論文表明,你可以透過要求GPT-4反思「為什麼錯了?」並為自己產生一個新的提示,將這個錯誤原因考慮在內,直到結果正確,從而將GPT-4 的性能提高驚人的30%。

網友不禁感嘆:人工智慧的發展速度已經超過了我們的適應能力。

方法介紹

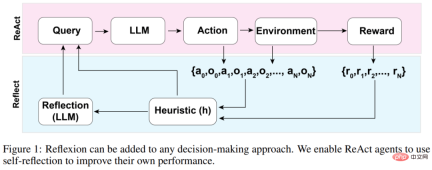

Reflexion 智能體的整體架構如下圖 1 所示,其中 Reflexion 利用 ReAct(Yao et al., 2023)。在第一次試驗中,智能體從構成初始查詢的環境中獲得任務,然後智能體執行 LLM 產生的一系列動作,並從環境中接收觀察和獎勵。對於提供描述型或持續型獎勵的環境,該研究將輸出限制為簡單的二元成功狀態以確保適用性。

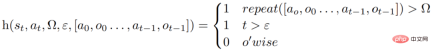

在每個動作a_t 之後,智能體會計算一個啟發性函數h,如下圖所示

這個啟發性函數旨在檢測智能體產生訊息幻覺(即虛假或錯誤的訊息)或效率低下,並「告訴」智能體何時需要反思(reflexion),其中t 是time step,s_t 是當前狀態,Ω表示重複動作循環的次數,ε 表示執行動作的最大總數,[a_o, o_0 . . . , a_(t−1), o_(t−1)] 代表軌跡歷史。 repeat 是一個簡單的函數,用於確定產生相同結果的重複動作循環的次數。

如果函數 h 告訴智能體需要反思,那麼智能體會查詢 LLM 以反映其當前任務、軌跡歷史和上次獎勵,然後智能體在後續試驗中會重置環境再重試。如果函數 h 沒有告訴智能體需要反思,那麼智能體會將 a_t 和 o_t 加到其軌跡歷史記錄中,並向 LLM 查詢下一個動作。

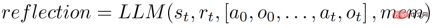

如果如果啟發式h 建議在time step t 時進行反思,則智能體會根據其當前狀態s_t、最後的獎勵r_t、先前的動作和觀察[a_0, o_0, . . . , a_t, o_t],以及智慧體現有的工作儲存mem,啟動一個反思過程。

反思的目的是透過反覆試驗來幫助智能體修正「幻覺」和低效率問題。用於反思的模型是一個使用特定的失敗軌跡和理想的反思範例來 prompt 的 LLM。

智能體會迭代地進行上述反思過程。在實驗中,研究設定在智能體記憶體中儲存的反思最多為 3 次,這是為了避免查詢超出 LLM 的限制。以下幾種情況,運行會終止:

- 超過最大試驗次數;

- 未能在兩次連續試驗之間提高表現;

- 完成任務。

實驗及結果

AlfWorld 提供了六種不同的任務和3000 多個環境,這些任務要求智能體理解目標任務,制定子任務的順序計劃,並在在給定環境中執行操作。

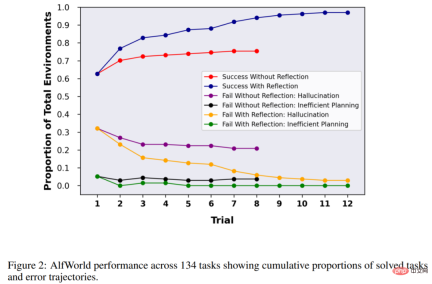

研究在134 個AlfWorld 環境中測試智能體,任務包括尋找隱藏物體(例如,在抽屜裡找到水果刀)、移動物體(例如,將刀移到砧板上),以及用其他物件來操縱另一個物件(例如,在冰箱中冷藏番茄)。

在沒有反思的情況下,智能體的準確率為 63%,之後再加入 Reflexion 進行比較。結果顯示,智能體在 12 次試驗中能夠處理好 97% 的環境,在 134 項任務中僅有 4 項沒有解決。

接下來的實驗是在HotPotQA 中進行了,它是一個基於維基百科的資料集,包含113k 個問答對,主要用來挑戰智能體解析內容和推理的能力。

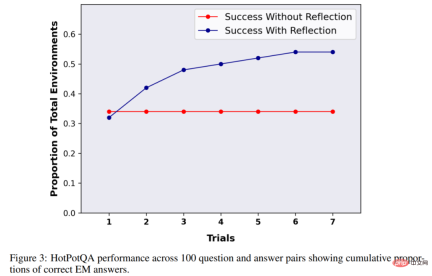

在 HotpotQA 的 100 個問答對測試中,該研究將基礎智能體和基於 Reflexion 的智能體進行比較,直到它們在連續的試驗中無法提高準確性。結果顯示基礎智能體並沒有性能提高,在第一次試驗中,基礎智能體準確率為34%,Reflexion 智能體準確率為32%,但在7 次試驗後,Reflexion 智能體表現大幅改善,性能提升接近30%,大大優於基礎智能體。

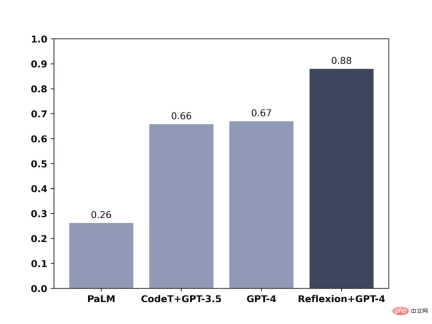

類似地,在測試模型編寫程式碼的能力時,加入Reflexion 的GPT-4 也顯著優於常規的GPT-4:

以上是當GPT-4反思自己錯了:效能提升近30%,程式設計能力提升21%的詳細內容。更多資訊請關注PHP中文網其他相關文章!

在LLMS中調用工具Apr 14, 2025 am 11:28 AM

在LLMS中調用工具Apr 14, 2025 am 11:28 AM大型語言模型(LLMS)的流行激增,工具稱呼功能極大地擴展了其功能,而不是簡單的文本生成。 現在,LLM可以處理複雜的自動化任務,例如Dynamic UI創建和自主a

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康Apr 14, 2025 am 11:27 AM

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康Apr 14, 2025 am 11:27 AM視頻遊戲可以緩解焦慮,建立焦點或支持多動症的孩子嗎? 隨著醫療保健在全球範圍內挑戰,尤其是在青年中的挑戰,創新者正在轉向一種不太可能的工具:視頻遊戲。現在是世界上最大的娛樂印度河之一

沒有關於AI的投入:獲勝者,失敗者和機遇Apr 14, 2025 am 11:25 AM

沒有關於AI的投入:獲勝者,失敗者和機遇Apr 14, 2025 am 11:25 AM“歷史表明,儘管技術進步推動了經濟增長,但它並不能自行確保公平的收入分配或促進包容性人類發展,”烏托德秘書長Rebeca Grynspan在序言中寫道。

通過生成AI學習談判技巧Apr 14, 2025 am 11:23 AM

通過生成AI學習談判技巧Apr 14, 2025 am 11:23 AM易於使用,使用生成的AI作為您的談判導師和陪練夥伴。 讓我們來談談。 對創新AI突破的這種分析是我正在進行的《福布斯》列的最新覆蓋範圍的一部分,包括識別和解釋

泰德(Ted)從Openai,Google,Meta透露出庭,與我自己自拍Apr 14, 2025 am 11:22 AM

泰德(Ted)從Openai,Google,Meta透露出庭,與我自己自拍Apr 14, 2025 am 11:22 AM在溫哥華舉行的TED2025會議昨天在4月11日舉行了第36版。它的特色是來自60多個國家 /地區的80個發言人,包括Sam Altman,Eric Schmidt和Palmer Luckey。泰德(Ted)的主題“人類重新構想”是量身定制的

約瑟夫·斯蒂格利茲(Joseph StiglitzApr 14, 2025 am 11:21 AM

約瑟夫·斯蒂格利茲(Joseph StiglitzApr 14, 2025 am 11:21 AM約瑟夫·斯蒂格利茨(Joseph Stiglitz)是2001年著名的經濟學家,是諾貝爾經濟獎的獲得者。斯蒂格利茨認為,AI可能會使現有的不平等和合併權力惡化,並在一些主導公司手中加劇,最終破壞了經濟上的經濟。

什麼是圖形數據庫?Apr 14, 2025 am 11:19 AM

什麼是圖形數據庫?Apr 14, 2025 am 11:19 AM圖數據庫:通過關係徹底改變數據管理 隨著數據的擴展及其特徵在各個字段中的發展,圖形數據庫正在作為管理互連數據的變革解決方案的出現。與傳統不同

LLM路由:策略,技術和Python實施Apr 14, 2025 am 11:14 AM

LLM路由:策略,技術和Python實施Apr 14, 2025 am 11:14 AM大型語言模型(LLM)路由:通過智能任務分配優化性能 LLM的快速發展的景觀呈現出各種各樣的模型,每個模型都具有獨特的優勢和劣勢。 有些在創意內容gen上表現出色

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

Dreamweaver CS6

視覺化網頁開發工具

WebStorm Mac版

好用的JavaScript開發工具

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

禪工作室 13.0.1

強大的PHP整合開發環境