Rumah >Peranti teknologi >AI >Ringkasan tujuh teknik pengurangan dimensi linear yang biasa digunakan dalam pembelajaran mesin

Ringkasan tujuh teknik pengurangan dimensi linear yang biasa digunakan dalam pembelajaran mesin

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-02-19 23:30:481767semak imbas

Dalam artikel sebelumnya, kami meringkaskan teknik pengurangan dimensi tak linear dalam artikel ini, kami akan meringkaskan teknik pengurangan dimensi linear biasa.

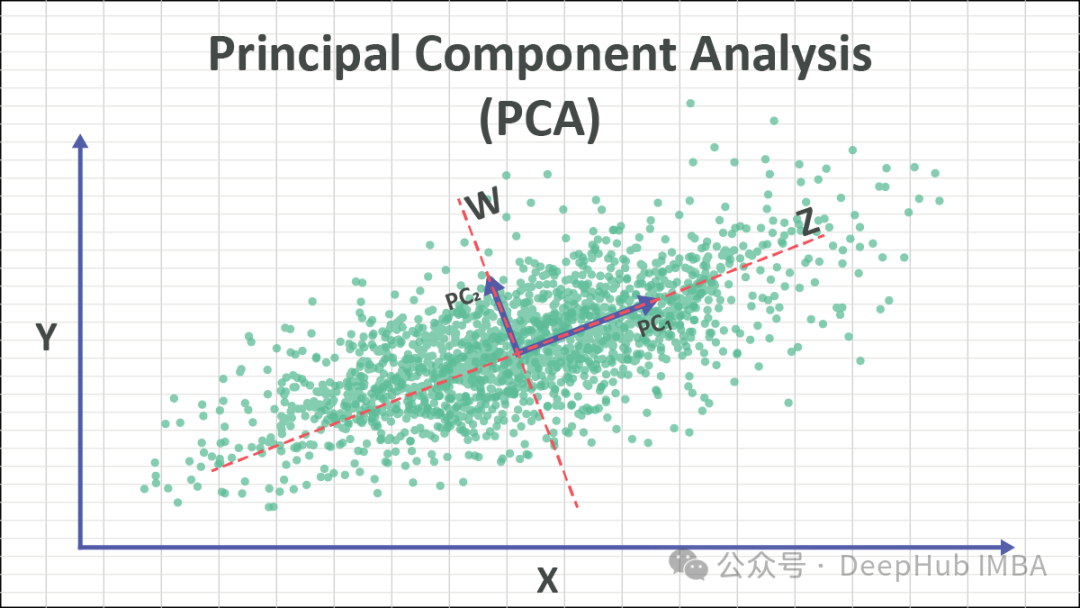

1. Analisis Komponen Utama (PCA)

PCA ialah teknik pengurangan dimensi yang digunakan secara meluas yang boleh menukar set data berdimensi tinggi kepada perwakilan dimensi rendah yang lebih terurus sambil mengekalkan ciri utama data. Dengan mengenal pasti arah (komponen utama) dengan varians terbesar dalam data, PCA boleh mengunjurkan data ke arah ini untuk mencapai matlamat pengurangan dimensi.

Idea teras PCA adalah untuk mengubah data asal kepada sistem koordinat baharu untuk memaksimumkan varians data. Paksi baharu ini dipanggil komponen utama dan merupakan gabungan linear bagi ciri asal. Mengekalkan komponen utama dengan varians terbesar pada asasnya mengekalkan maklumat utama data. Dengan membuang komponen utama dengan varians yang lebih kecil, tujuan pengurangan dimensi boleh dicapai.

Langkah PCA adalah seperti berikut:

- Standardkan data: Seragamkan data asal supaya min setiap ciri ialah 0 dan varians ialah 1.

- Kira matriks kovarians: Kira matriks kovarians data piawai.

- Kira nilai eigen dan vektor eigen: Lakukan penguraian nilai eigen pada matriks kovarians untuk mendapatkan nilai eigen dan vektor eigen yang sepadan.

- Pilih komponen utama: Pilih vektor eigen k teratas sebagai komponen utama mengikut saiz nilai eigen, dengan k ialah dimensi selepas pengurangan dimensi.

- Data unjuran: Unjurkan data asal pada komponen utama yang dipilih untuk mendapatkan set data yang dikurangkan secara dimensi.

PCA boleh digunakan untuk tugasan seperti pengurangan dimensi data, pengekstrakan ciri dan pengecaman corak. Apabila menggunakan PCA, anda perlu memastikan bahawa data memenuhi andaian asas kebolehpisahan linear, dan melaksanakan prapemprosesan dan pemahaman data yang diperlukan untuk mendapatkan kesan pengurangan dimensi yang tepat.

2. Analisis Faktor (FA)

Analisis Faktor (FA) ialah teknik statistik yang digunakan untuk mengenal pasti struktur atau faktor asas di antara pembolehubah yang diperhatikan. akhirnya mengurangkannya kepada bilangan pembolehubah tidak berkaitan yang lebih kecil.

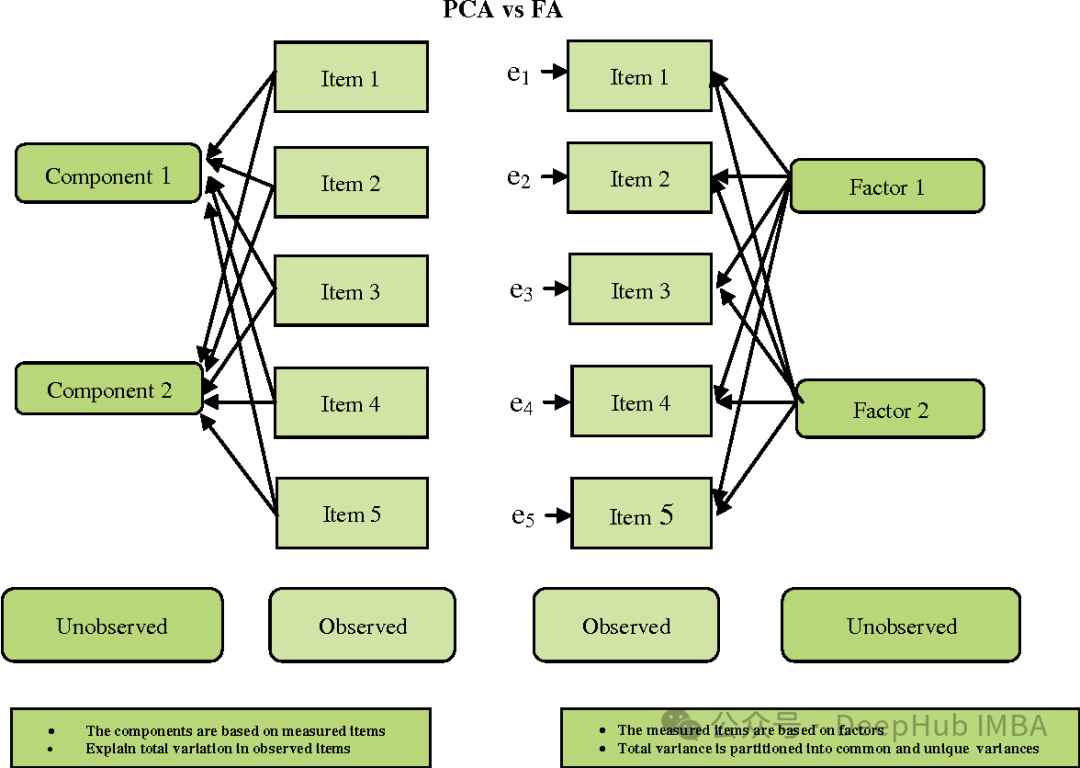

FA dan PCA agak serupa, tetapi terdapat beberapa perbezaan penting:

- Objektif: PCA bertujuan untuk mencari arah varians maksimum, manakala FA bertujuan untuk mencari Pembolehubah asas (faktor) yang menerangkan variasi sepunya yang diperhatikan antara pembolehubah.

- Andaian: PCA menganggap pembolehubah yang diperhatikan adalah ciri asal yang diperhatikan, manakala FA menganggap pembolehubah yang diperhatikan ialah jumlah gabungan linear faktor pendam dan ralat rawak.

- Kebolehtafsiran: PCA cenderung lebih mudah kerana komponen utamanya ialah gabungan linear ciri asal. Dan faktor FA mungkin kurang mudah untuk ditafsirkan kerana ia adalah gabungan linear pembolehubah yang diperhatikan dan bukannya ciri mentah.

- Putaran: Dalam FA, faktor sering diputar untuk memudahkannya ditafsir.

Analisis faktor digunakan secara meluas dalam bidang seperti psikologi, sains sosial dan penyelidikan pasaran. Ia membantu memudahkan set data, menemui struktur asas dan mengurangkan ralat pengukuran. Walau bagaimanapun, berhati-hati perlu diambil dalam memilih bilangan faktor dan kaedah putaran untuk memastikan keputusan boleh ditafsir dan sah.

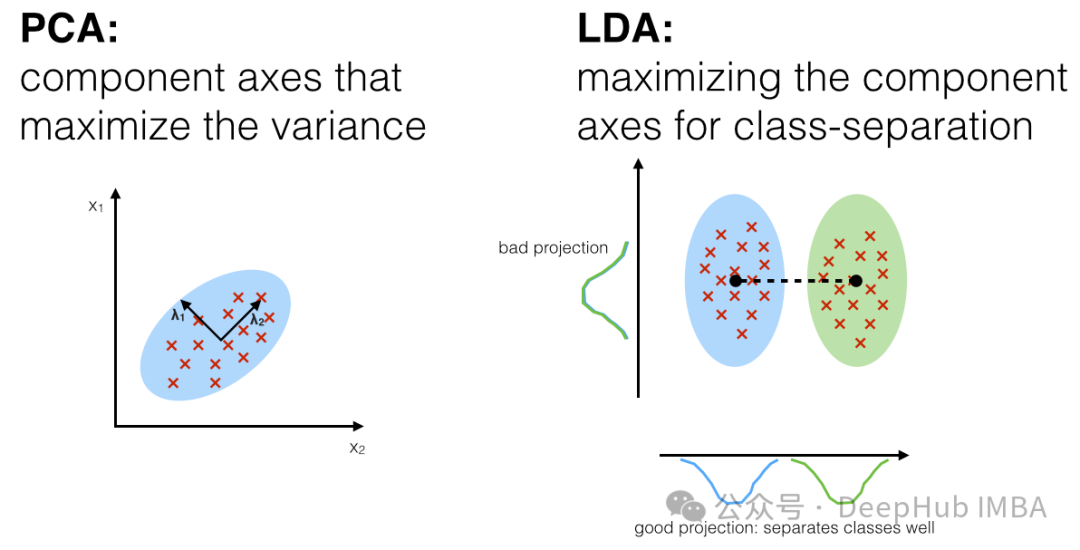

3. Analisis Diskriminasi Linear, LDA

Analisis Diskriminasi Linear (LDA) ialah teknologi pembelajaran yang diselia untuk pengurangan dimensi dan pengekstrakan ciri. Ia berbeza daripada analisis komponen utama (PCA) kerana ia bukan sahaja mempertimbangkan struktur varians data, tetapi juga mempertimbangkan maklumat kategori data. LDA bertujuan untuk mencari arah unjuran yang memaksimumkan jarak antara kategori berbeza (sebaran antara kelas) sambil meminimumkan jarak dalam kategori yang sama (sebaran dalam kelas).

Langkah utama LDA adalah seperti berikut:

- Kira min vektor kategori: Bagi setiap kategori, hitung min vektor semua sampel di bawah kategori tersebut.

- Kira matriks serakan dalam kelas: Untuk setiap kategori, kira matriks serakan antara semua sampel di bawah kategori dan vektor minnya, dan jumlahnya.

- Kira matriks serakan antara kelas: Kira matriks serakan antara vektor min semua kategori dan vektor min keseluruhan.

- Kira nilai eigen dan vektor eigen: Darab matriks songsang matriks dengan matriks serakan antara kelas, dan lakukan penguraian nilai eigen bagi matriks yang terhasil untuk mendapatkan nilai eigen dan vektor eigen.

- Pilih arah unjuran: Pilih vektor eigen k teratas dengan nilai eigen terbesar sebagai arah unjuran, dengan k ialah dimensi selepas pengurangan dimensi.

- Data unjuran: Unjurkan data asal ke arah unjuran yang dipilih untuk mendapatkan data yang dikurangkan secara dimensi.

Kelebihan LDA ialah ia mengambil kira maklumat kategori data, jadi unjuran yang dijana dapat membezakan dengan lebih baik perbezaan antara kategori yang berbeza. Ia digunakan secara meluas dalam pengecaman corak, pengecaman muka, pengecaman pertuturan dan bidang lain. LDA mungkin menghadapi beberapa masalah apabila berurusan dengan pelbagai kelas dan ketidakseimbangan kelas, dan memerlukan perhatian khusus.

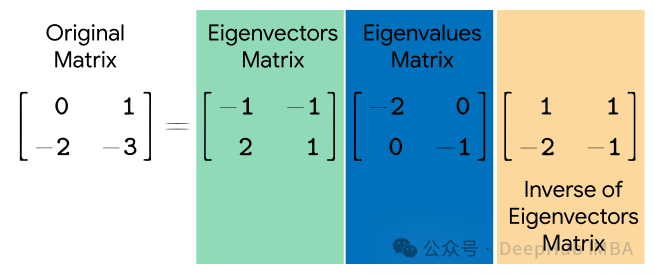

4. Eigendecomposition

Eigendecomposition (penguraian nilai eigen) ialah teknik matematik yang digunakan untuk mengurai matriks segi empat sama. Ia menguraikan matriks segi empat sama kepada satu set vektor eigen dan hasil darab nilai eigen. Vektor eigen mewakili arah yang tidak berubah arah semasa transformasi, manakala nilai eigen mewakili penskalaan sepanjang arah ini semasa transformasi.

Diberi matriks segi empat sama AA, penguraian nilai eigennya dinyatakan sebagai:

di mana, Q ialah matriks yang terdiri daripada vektor eigen A, Λ ialah matriks pepenjuru eigonnya, dan unsur pepenjurunya ialah daripada A.

Penguraian nilai eigen mempunyai banyak aplikasi, termasuk analisis komponen utama (PCA), pengecaman muka eigen, pengelompokan spektrum, dsb. Dalam PCA, penguraian nilai eigen digunakan untuk mencari vektor eigen bagi matriks kovarians data dan dengan itu komponen utama data. Dalam pengelompokan spektrum, penguraian nilai eigen digunakan untuk mencari vektor eigen bagi peta persamaan, dengan itu melakukan pengelompokan. Pengecaman muka eigen menggunakan penguraian nilai eigen untuk mengenal pasti ciri penting dalam imej muka.

Walaupun penguraian nilai eigen sangat berguna dalam banyak aplikasi, tidak semua matriks persegi boleh diuraikan nilai eigen. Contohnya, matriks tunggal atau matriks bukan persegi tidak boleh diuraikan nilai eigen. Penguraian nilai eigen boleh memakan masa yang sangat lama untuk mengira pada matriks besar.

5. Penguraian nilai tunggal (SVD)

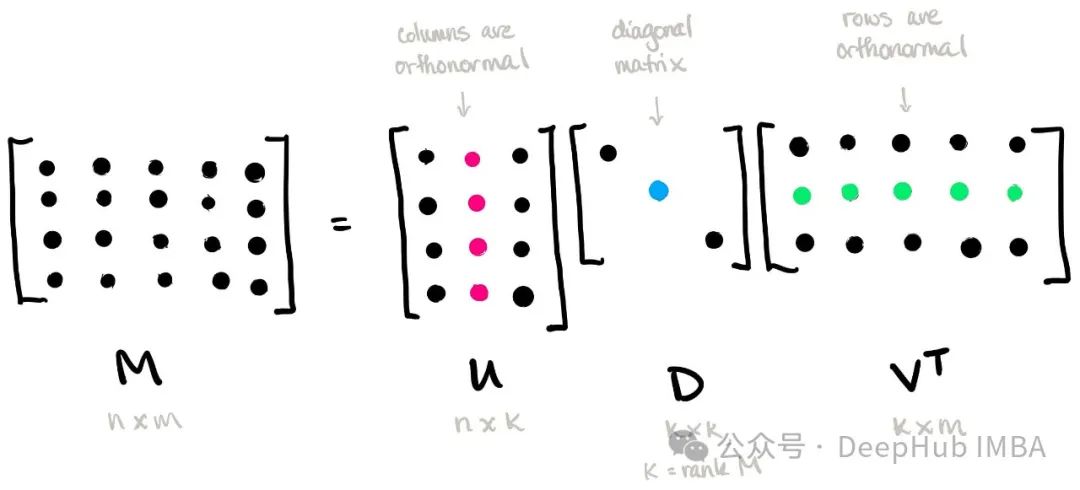

Penguraian Nilai Tunggal (SVD) ialah teknik penting untuk penguraian matriks. Ia menguraikan matriks kepada hasil darab tiga matriks, iaitu transpos matriks ortogon, matriks pepenjuru, dan matriks ortogon yang lain.

Diberi matriks m × n AA, penguraian nilai tunggalnya dinyatakan sebagai:

di mana, U ialah matriks ortogon m × m, dipanggil matriks vektor tunggal kiri Σ ialah m × n ialah matriks pepenjuru , dan unsur-unsur pada pepenjurunya dipanggil nilai tunggal VT ialah transpos bagi matriks ortogonal n × n, dipanggil matriks vektor tunggal tepat.

Penguraian nilai tunggal mempunyai pelbagai aplikasi, termasuk pemampatan data, pengurangan dimensi, penyelesaian songsang matriks, sistem pengesyoran, dsb. Dalam pengurangan dimensi, hanya item dengan nilai tunggal yang lebih besar dikekalkan, yang boleh mencapai pemampatan dan perwakilan data yang berkesan. Dalam sistem pengesyoran, perhubungan antara pengguna dan item boleh dimodelkan melalui penguraian nilai tunggal untuk memberikan pengesyoran yang diperibadikan.

Penguraian nilai tunggal juga boleh digunakan untuk menyelesaikan songsangan matriks, terutamanya untuk matriks tunggal. Dengan mengekalkan istilah dengan nilai tunggal yang lebih besar, matriks songsang boleh diselesaikan lebih kurang, dengan itu mengelakkan masalah penyongsangan matriks tunggal.

6. Penguraian Nilai Tunggal Terpenggal (TSVD)

Penguraian Nilai Tunggal Terpenggal (TSVD) ialah varian Penguraian Nilai Tunggal (SVD), yang hanya mengekalkan jumlah nilai tunggal yang paling penting dalam pengiraan Vektor tunggal yang sepadan, dengan itu mencapai dimensi pengurangan dan pemampatan data.

Diberi matriks m × n AA, penguraian nilai tunggal terpenggalnya dinyatakan sebagai:

di mana, Uk ialah matriks ortogon m × k, Σk ialah matriks pepenjuru k × k, VkT ialah transpos a k × matriks ortogonal yang sepadan dengan mengekalkan nilai tunggal k yang paling penting dan vektor tunggal yang sepadan.

Kelebihan utama TSVD ialah ia boleh mencapai pengurangan dimensi dan pemampatan data dengan mengekalkan nilai tunggal yang paling penting dan vektor tunggal, sekali gus mengurangkan kos penyimpanan dan pengkomputeran. Ini amat berguna apabila bekerja dengan set data berskala besar, kerana ruang storan yang diperlukan dan masa pengiraan boleh dikurangkan dengan ketara.

TSVD mempunyai aplikasi dalam banyak bidang, termasuk pemprosesan imej, pemprosesan isyarat, sistem pengesyoran, dsb. Dalam aplikasi ini, TSVD boleh digunakan untuk mengurangkan dimensi data, mengeluarkan bunyi, mengekstrak ciri utama, dsb.

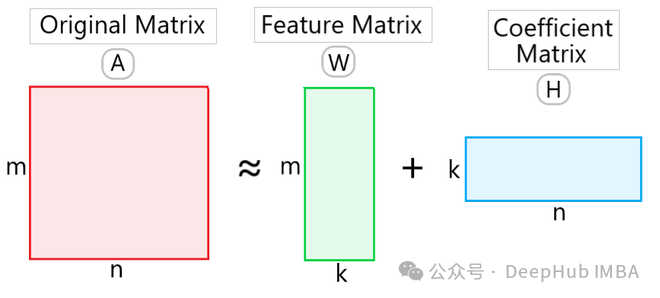

7. Pemfaktoran Matriks Bukan Negatif (NMF)

Pemfaktoran Matriks Bukan Negatif (NMF) ialah teknik untuk penguraian data dan pengurangan dimensi. Ini menjadikan NMF berguna dalam banyak aplikasi, terutamanya dalam bidang seperti perlombongan teks, pemprosesan imej dan sistem pengesyor.

Diberi matriks bukan negatif VV, NMF menguraikannya ke dalam bentuk hasil darab dua matriks bukan negatif WW dan HH:

di mana, W ialah matriks bukan negatif m × k, dipanggil matriks asas ( matriks asas) atau matriks ciri (matriks ciri), H ialah matriks bukan negatif k × n, dipanggil matriks pekali (matriks pekali). Di sini k ialah dimensi selepas pengurangan dimensi.

Kelebihan NMF ialah ia boleh mendapatkan hasil penguraian dengan makna fizikal kerana semua elemen adalah bukan negatif. Ini membolehkan NMF menemui topik terpendam dalam perlombongan teks dan mengekstrak ciri imej dalam pemprosesan imej. Selain itu, NMF juga mempunyai fungsi pengurangan dimensi data, yang boleh mengurangkan dimensi dan ruang penyimpanan data.

Aplikasi NMF termasuk pemodelan topik teks, pembahagian dan pemampatan imej, pemprosesan isyarat audio, sistem pengesyoran, dsb. Dalam bidang ini, NMF digunakan secara meluas dalam tugasan seperti analisis data dan pengekstrakan ciri, serta perolehan dan pengelasan maklumat.

Ringkasan

Teknologi pengurangan dimensi linear ialah sejenis teknologi yang digunakan untuk memetakan set data berdimensi tinggi kepada ruang berdimensi rendah Idea teras adalah untuk mengekalkan ciri utama set data melalui transformasi linear. Teknik pengurangan dimensi linear ini mempunyai kelebihan unik dan kebolehgunaan dalam senario aplikasi yang berbeza, dan kaedah yang sesuai boleh dipilih berdasarkan sifat data dan keperluan tugasan. Sebagai contoh, PCA sesuai untuk pengurangan dimensi data tanpa pengawasan, manakala LDA sesuai untuk tugas pembelajaran yang diselia.

Berdasarkan artikel sebelumnya, kami memperkenalkan 10 teknik pengurangan dimensi tak linear dan 7 teknik pengurangan dimensi linear Mari kita buat ringkasan

Teknologi pengurangan dimensi linear: petakan data ke ruang dimensi rendah berdasarkan transformasi linear set data; seperti kes di mana titik data diedarkan pada subruang linear kerana algoritmanya adalah mudah, ia adalah cekap dari segi pengiraan dan mudah untuk difahami dan dilaksanakan; telah hilang.

Teknologi pengurangan dimensi tak linear: memetakan data ke ruang berdimensi rendah melalui transformasi tak linear, seperti titik data yang diedarkan pada manifold dengan lebih baik boleh mengekalkan ketaklinear dalam Struktur data dan perhubungan setempat; kesan visualisasi; kerumitan pengiraan yang lebih tinggi, biasanya memerlukan lebih banyak sumber dan masa pengkomputeran.

Jika data boleh dipisahkan secara linear atau sumber pengkomputeran terhad, teknologi pengurangan dimensi linear boleh dipilih. Jika data mengandungi struktur tak linear yang kompleks atau memerlukan visualisasi yang lebih baik, anda boleh mempertimbangkan untuk menggunakan teknologi pengurangan dimensi tak linear. Dalam amalan, anda juga boleh mencuba kaedah yang berbeza dan memilih teknologi pengurangan dimensi yang paling sesuai berdasarkan kesan sebenar.

Atas ialah kandungan terperinci Ringkasan tujuh teknik pengurangan dimensi linear yang biasa digunakan dalam pembelajaran mesin. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!