Rumah >Peranti teknologi >AI >'Kemunculan Pintar' Penjanaan Pertuturan: 100,000 Jam Latihan Data, Amazon Menawarkan 1 Bilion Parameter BASE TTS

'Kemunculan Pintar' Penjanaan Pertuturan: 100,000 Jam Latihan Data, Amazon Menawarkan 1 Bilion Parameter BASE TTS

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-02-16 18:40:251386semak imbas

Dengan perkembangan pesat model pembelajaran mendalam generatif, pemprosesan bahasa semula jadi (NLP) dan penglihatan komputer (CV) telah mengalami perubahan ketara. Daripada model yang diselia sebelum ini yang memerlukan latihan khusus, kepada model umum yang hanya memerlukan arahan yang mudah dan jelas untuk menyelesaikan pelbagai tugas. Transformasi ini memberikan kami penyelesaian yang lebih cekap dan fleksibel.

Dalam bidang pemprosesan pertuturan dan text-to-speech (TTS), satu transformasi sedang berlaku. Dengan memanfaatkan beribu-ribu jam data, model ini membawa sintesis lebih dekat dan lebih dekat kepada pertuturan manusia sebenar.

Dalam kajian baru-baru ini, Amazon melancarkan BASE TTS secara rasmi, meningkatkan skala parameter model TTS kepada tahap yang belum pernah berlaku sebelum ini iaitu 1 bilion.

Tajuk kertas: TTS ASAS: Pengajaran daripada membina model Teks-ke-Pertuturan berbilion parameter pada 100K jam data

Pautan kertas: https://arxiv.org/pdf. pdf

BASE TTS ialah sistem TTS (LTTS) berbilang bahasa berskala besar, berbilang pembesar suara. Ia menggunakan kira-kira 100,000 jam data pertuturan domain awam untuk latihan, iaitu dua kali ganda berbanding VALL-E, yang mempunyai jumlah data latihan tertinggi sebelum ini. Diilhamkan oleh pengalaman kejayaan LLM, BASE TTS menganggap TTS sebagai masalah ramalan token seterusnya dan menggabungkannya dengan sejumlah besar data latihan untuk mencapai keupayaan berbilang bahasa dan berbilang pembesar suara yang berkuasa.

Sumbangan utama kertas kerja ini diringkaskan seperti berikut:

BASE TTS yang dicadangkan kini merupakan model TTS terbesar dengan 1 bilion parameter dan dilatih berdasarkan set data yang terdiri daripada 100,000 jam data pertuturan domain awam. Melalui penilaian subjektif, BASE TTS mengatasi prestasi model garis dasar LTTS awam.

Artikel ini menunjukkan cara untuk meningkatkan keupayaan BASE TTS untuk menghasilkan prosodi yang sesuai untuk teks kompleks dengan memanjangkannya kepada set data dan saiz model yang lebih besar. Untuk menilai pemahaman teks dan keupayaan pemaparan model TTS berskala besar, penyelidik membangunkan set ujian "keupayaan timbul" dan melaporkan prestasi varian BASE TTS yang berbeza pada penanda aras ini. Keputusan menunjukkan bahawa apabila saiz set data dan bilangan parameter meningkat, kualiti BASE TTS semakin bertambah baik.

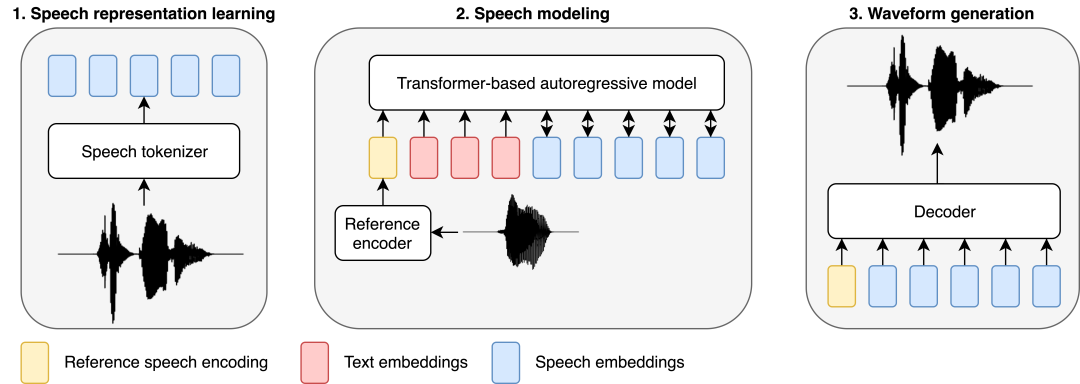

3 Perwakilan pertuturan diskret baharu berdasarkan model SSL WavLM dicadangkan, bertujuan untuk menangkap maklumat fonologi dan prosodik isyarat pertuturan sahaja. Perwakilan ini mengatasi kaedah pengkuantitian garis dasar, membolehkannya dinyahkodkan kepada bentuk gelombang berkualiti tinggi dengan penyahkod mudah, pantas dan penstriman walaupun tahap mampatan tinggi (hanya 400 bit/s).

Seterusnya, mari lihat butiran kertas.

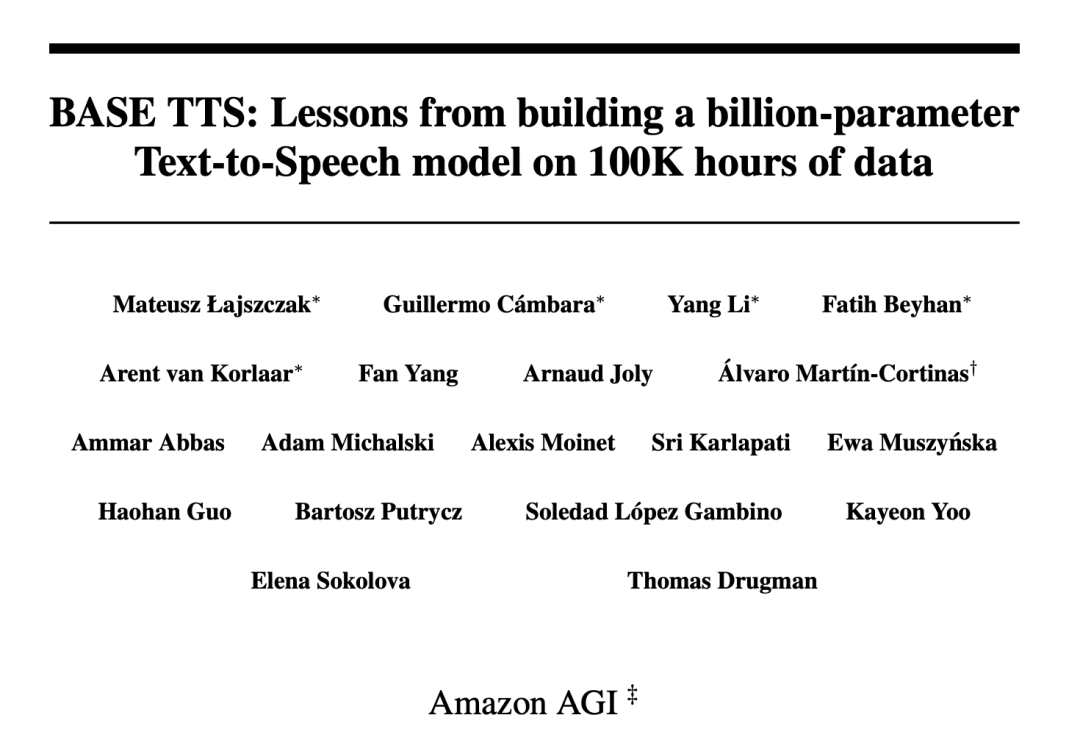

BASE TTS model

Sama seperti kerja pemodelan pertuturan baru-baru ini, penyelidik menggunakan pendekatan berasaskan LLM untuk mengendalikan tugasan TTS. Teks dimasukkan ke dalam model autoregresif berasaskan Transformer yang meramalkan perwakilan audio diskret (dipanggil kod pertuturan), yang kemudiannya dinyahkodkan kepada bentuk gelombang oleh penyahkod terlatih berasingan yang terdiri daripada lapisan linear dan konvolusi.

BASE TTS direka bentuk untuk mensimulasikan pengedaran bersama token teks dan kemudian perwakilan pertuturan diskret, yang penyelidik panggil pengekodan pertuturan. Diskretisasi pertuturan oleh codec audio adalah penting kepada reka bentuk, kerana ini membolehkan penggunaan terus kaedah yang dibangunkan untuk LLM, yang merupakan asas untuk hasil penyelidikan terkini dalam LTTS. Khususnya, kami memodelkan pengekodan pertuturan menggunakan Transformer autoregresif penyahkodan dengan objektif latihan rentas entropi. Walaupun mudah, matlamat ini boleh menangkap taburan kebarangkalian kompleks pertuturan ekspresif, dengan itu mengurangkan masalah terlalu licin yang dilihat dalam sistem TTS saraf awal. Sebagai model bahasa tersirat, sebaik sahaja varian yang cukup besar dilatih pada data yang mencukupi, BASE TTS juga akan membuat lonjakan kualitatif dalam pemaparan prosodi.

Perwakilan Bahasa Diskret

Perwakilan diskrit ialah asas kejayaan LLM, tetapi mengenal pasti perwakilan yang padat dan bermaklumat dalam pertuturan tidak begitu jelas seperti dalam teks, dan kurang diterokai sebelum ini. Untuk BASE TTS, penyelidik mula-mula cuba menggunakan garis dasar VQ-VAE (Bahagian 2.2.1), yang berdasarkan seni bina pengekod auto untuk membina semula spektrogram mel melalui kesesakan diskret. VQ-VAE telah menjadi paradigma yang berjaya untuk pertuturan dan perwakilan imej, terutamanya sebagai unit pemodelan untuk TTS.

Para penyelidik juga memperkenalkan kaedah baharu untuk mempelajari perwakilan pertuturan melalui pengekodan pertuturan berasaskan WavLM (Bahagian 2.2.2). Dalam pendekatan ini, penyelidik mendiskrisikan ciri yang diekstrak daripada model SSL WavLM untuk membina semula spektrogram mel. Para penyelidik menggunakan fungsi kehilangan tambahan untuk memudahkan pemisahan pembesar suara dan memampatkan kod pertuturan yang dijana menggunakan Pengekodan Pasangan Byte (BPE) untuk mengurangkan panjang jujukan, membolehkan penggunaan Transformer untuk Pemodelan audio yang lebih panjang.

Kedua-dua perwakilan dimampatkan (masing-masing 325 bit/s dan 400 bit/s) untuk membolehkan pemodelan autoregresif yang lebih cekap berbanding codec audio popular. Berdasarkan tahap pemampatan ini, matlamat seterusnya adalah untuk mengalih keluar maklumat daripada kod pertuturan yang boleh dibina semula semasa penyahkodan (pembesar suara, bunyi audio, dll.) untuk memastikan kapasiti kod pertuturan digunakan terutamanya untuk mengekod fonetik dan prosodik. maklumat.

Pemodelan Pertuturan Autoregresif (SpeechGPT)

Para penyelidik melatih model autoregresif "SpeechGPT" dengan seni bina GPT-2, yang digunakan untuk meramalkan pengekodan pertuturan yang dikondisikan pada teks dan pertuturan rujukan. Keadaan pertuturan rujukan terdiri daripada ujaran yang dipilih secara rawak daripada penutur yang sama, yang dikodkan sebagai benam bersaiz tetap. Pembenaman pertuturan rujukan, pengekodan teks dan pertuturan disatukan ke dalam urutan yang dimodelkan oleh model autoregresif berasaskan Transformer. Kami menggunakan benam kedudukan yang berasingan dan kepala ramalan yang berasingan untuk teks dan pertuturan. Mereka melatih model autoregresif dari awal tanpa pra-latihan pada teks. Untuk mengekalkan maklumat teks untuk membimbing onomatopoeia, SpeechGPT juga dilatih dengan tujuan untuk meramalkan token seterusnya bagi bahagian teks urutan input, jadi bahagian SpeechGPT ialah LM teks sahaja. Berat yang lebih rendah digunakan di sini untuk kehilangan teks berbanding kehilangan pertuturan.

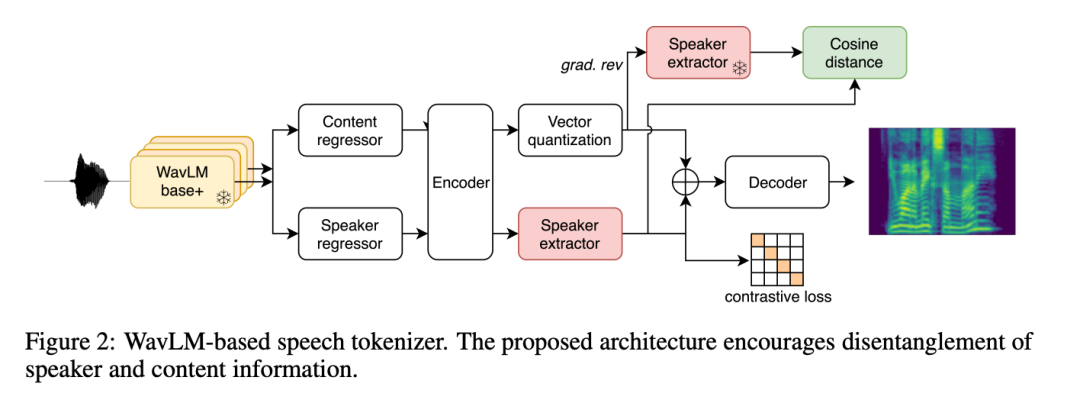

Penjanaan bentuk gelombang

Selain itu, penyelidik menetapkan penyahkod pertuturan-ke-gelombang yang berasingan (dipanggil "codec pertuturan") yang bertanggungjawab untuk membina semula identiti pembesar suara dan keadaan rakaman. Untuk menjadikan model lebih berskala, mereka menggantikan lapisan LSTM dengan lapisan konvolusi untuk menyahkod perwakilan perantaraan. Penyelidikan menunjukkan bahawa codec pertuturan berasaskan konvolusi ini adalah cekap dari segi pengiraan, mengurangkan masa sintesis sistem keseluruhan lebih daripada 70% berbanding dengan penyahkod garis dasar berasaskan resapan.

Para penyelidik juga menegaskan bahawa sebenarnya input codec pertuturan bukanlah pengekodan pertuturan, tetapi keadaan tersembunyi terakhir Transformer autoregresif. Ini dilakukan kerana perwakilan laten padat dalam kaedah TortoiseTTS sebelumnya memberikan maklumat yang lebih kaya daripada satu kod fonetik. Semasa proses latihan, penyelidik memasukkan teks dan kod sasaran ke dalam SpeechGPT terlatih (pembekuan parameter), dan kemudian melaraskan penyahkod berdasarkan keadaan tersembunyi terakhir. Memasukkan keadaan tersembunyi terakhir SpeechGPT membantu meningkatkan pembahagian dan kualiti akustik pertuturan, tetapi juga mengikat penyahkod kepada versi SpeechGPT tertentu. Ini merumitkan eksperimen kerana ia memaksa kedua-dua komponen sentiasa dibina secara berurutan. Batasan ini perlu ditangani dalam kerja akan datang.

Penilaian Eksperimen

Para penyelidik meneroka cara penskalaan mempengaruhi keupayaan model untuk menghasilkan prosodi dan ungkapan yang sesuai untuk input teks yang mencabar, sama seperti cara LLM "muncul" keupayaan baharu melalui penskalaan data dan parameter. Untuk menguji sama ada hipotesis ini juga terpakai kepada LTTS, penyelidik mencadangkan skema penilaian untuk menilai potensi kebolehan muncul dalam TTS, mengenal pasti tujuh kategori yang mencabar: kata nama majmuk, emosi, perkataan asing, parabahasa dan tanda baca , isu dan kerumitan sintaksis.

Berbilang percubaan mengesahkan struktur BASE TTS dan kualiti, kefungsian dan prestasi pengiraannya:

Pertama, penyelidik membandingkan kualiti model yang dicapai oleh pengekodan pertuturan berasaskan autopengekod dan berasaskan WavLM.

Para penyelidik kemudian menilai dua pendekatan untuk penyahkodan akustik kod pertuturan: penyahkod berasaskan resapan dan codec pertuturan.

Selepas melengkapkan ablasi struktur ini, kami menilai keupayaan muncul BASE TTS merentas 3 variasi saiz set data dan parameter model, serta oleh pakar bahasa.

Selain itu, penyelidik menjalankan ujian MUSHRA subjektif untuk mengukur keaslian, serta kebolehfahaman automatik dan ukuran persamaan pembesar suara, dan melaporkan perbandingan kualiti pertuturan dengan model teks ke pertuturan sumber terbuka yang lain.

Pengekodan pertuturan VQ-VAE lwn. pengekodan pertuturan WavLM

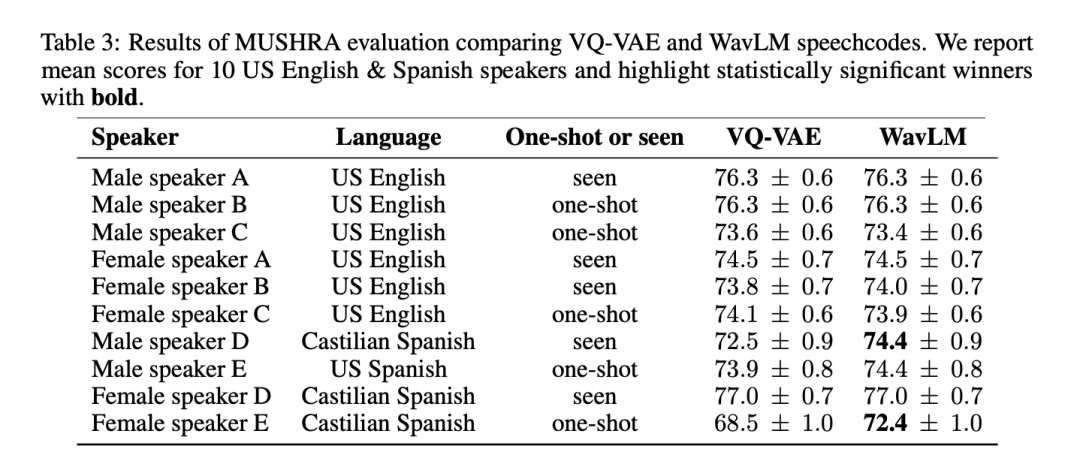

Untuk menguji secara menyeluruh kualiti dan kepelbagaian kedua-dua kaedah tokenisasi pertuturan, para penyelidik menjalankan MUSHRA pada 6 orang Inggeris Amerika dan 4 penutur Sepanyol Evaluate. Dari segi skor min MUSHRA untuk bahasa Inggeris, sistem berasaskan VQ-VAE dan WavLM adalah setanding (VQ-VAE: 74.8 vs WavLM: 74.7). Walau bagaimanapun, untuk bahasa Sepanyol, model berasaskan WavLM secara statistik lebih baik daripada model VQ-VAE (VQ-VAE: 73.3 vs WavLM: 74.7). Ambil perhatian bahawa data Bahasa Inggeris membentuk kira-kira 90% daripada set data, manakala data Sepanyol hanya membentuk 2%.

Jadual 3 menunjukkan keputusan yang dikelaskan mengikut pembesar suara:

Memandangkan sistem berasaskan WavLM berprestasi sekurang-kurangnya atau lebih baik daripada garis dasar VQ-VAE, kami menggunakannya untuk mewakili BASE TTS dalam percubaan selanjutnya.

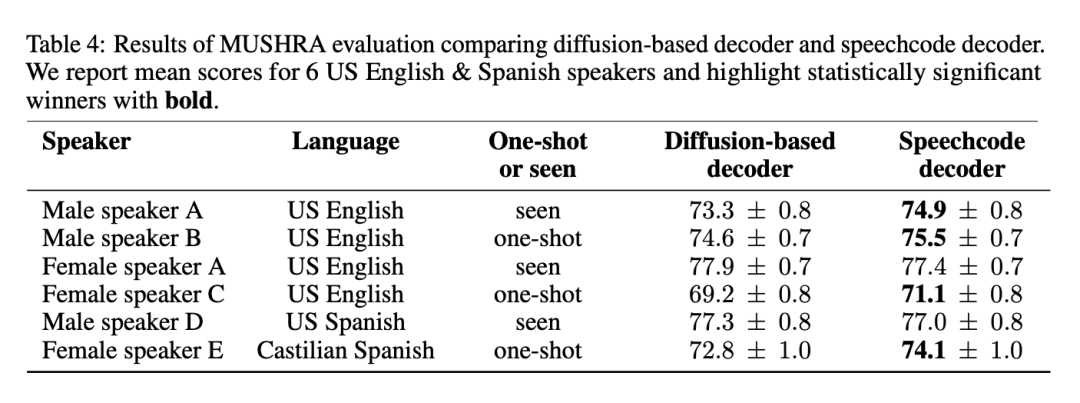

Penyahkod berasaskan resapan vs. penyahkod kod pertuturan

Seperti yang dinyatakan di atas, BASE TTS memudahkan penyahkod garis dasar berasaskan resapan dengan mencadangkan codec pertuturan hujung ke hujung. Kaedah ini fasih dan meningkatkan kelajuan inferens sebanyak 3 kali ganda. Untuk memastikan pendekatan ini tidak merendahkan kualiti, codec pertuturan yang dicadangkan telah dinilai berdasarkan garis dasar. Jadual 4 menyenaraikan keputusan penilaian MUSHRA ke atas 4 orang Amerika berbahasa Inggeris dan 2 orang berbahasa Sepanyol:

Keputusan menunjukkan bahawa codec pertuturan adalah kaedah pilihan kerana ia tidak mengurangkan kualiti, Dan untuk kebanyakan pertuturan, ia meningkatkan kualiti sambil memberikan inferens yang lebih cepat. Para penyelidik juga menyatakan bahawa menggabungkan dua model generatif yang berkuasa untuk pemodelan pertuturan adalah berlebihan dan boleh dipermudahkan dengan meninggalkan penyahkod resapan.

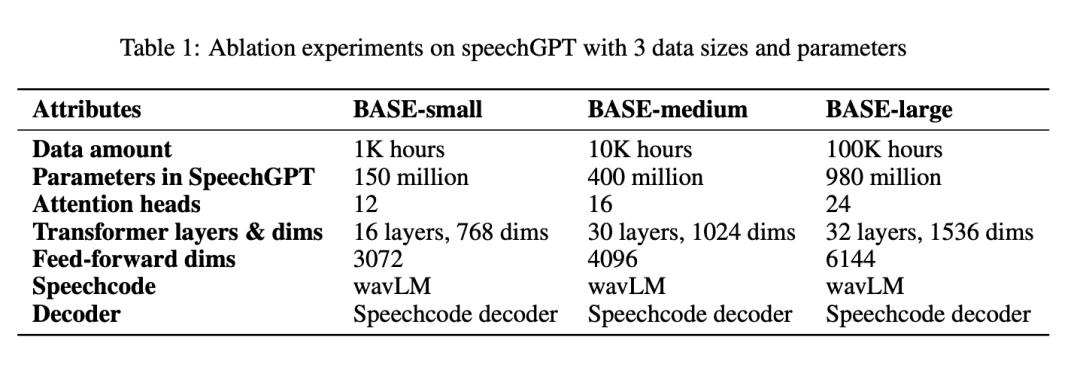

Kuasa kemunculan: ablasi data dan saiz model

Jadual 1 melaporkan semua parameter mengikut sistem BASE-kecil, BASE-sederhana dan BASE-besar:

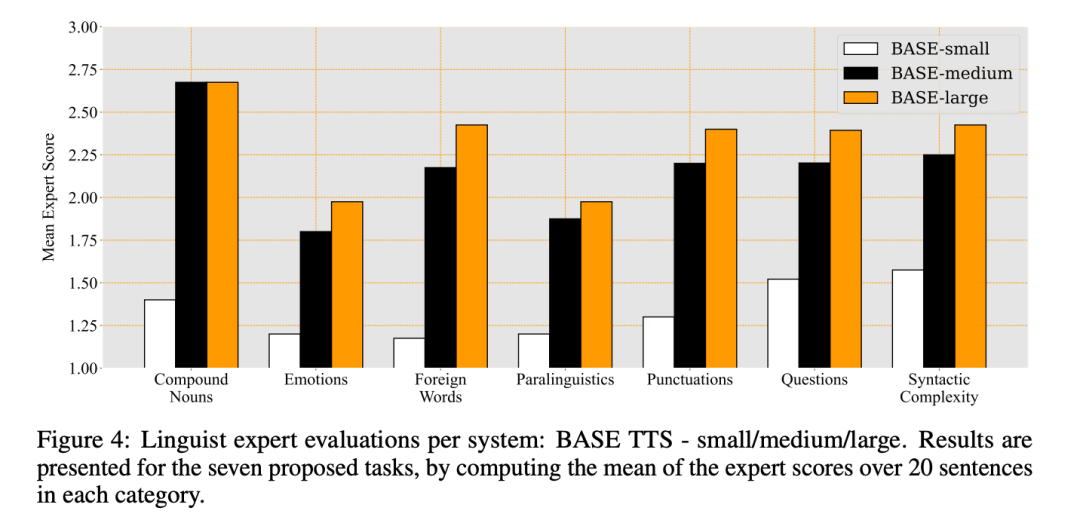

Hasil keputusan pakar dan penilaian pakar bahasa untuk ketiga-tiga sistem bahasa skor purata bagi setiap kategori ditunjukkan dalam Rajah 4:

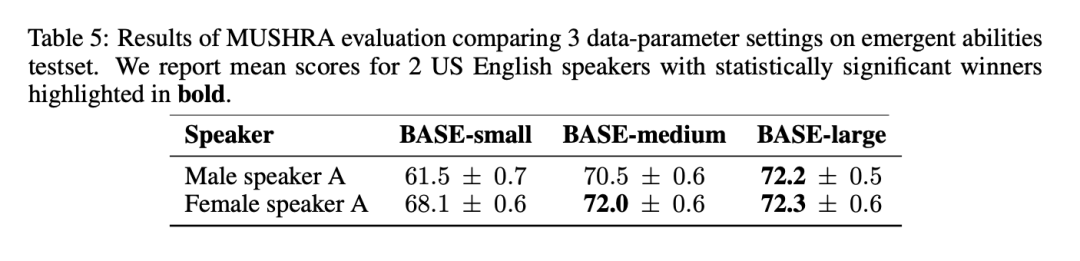

Dalam keputusan MUSHRA dalam Jadual 5, dapat diperhatikan bahawa keaslian pertuturan meningkat dengan ketara daripada BASE-kecil kepada BASE-sederhana, tetapi daripada BASE-sederhana kepada BASE- Penambahbaikan besar adalah lebih kecil:

BASE TTS vs. baseline industri

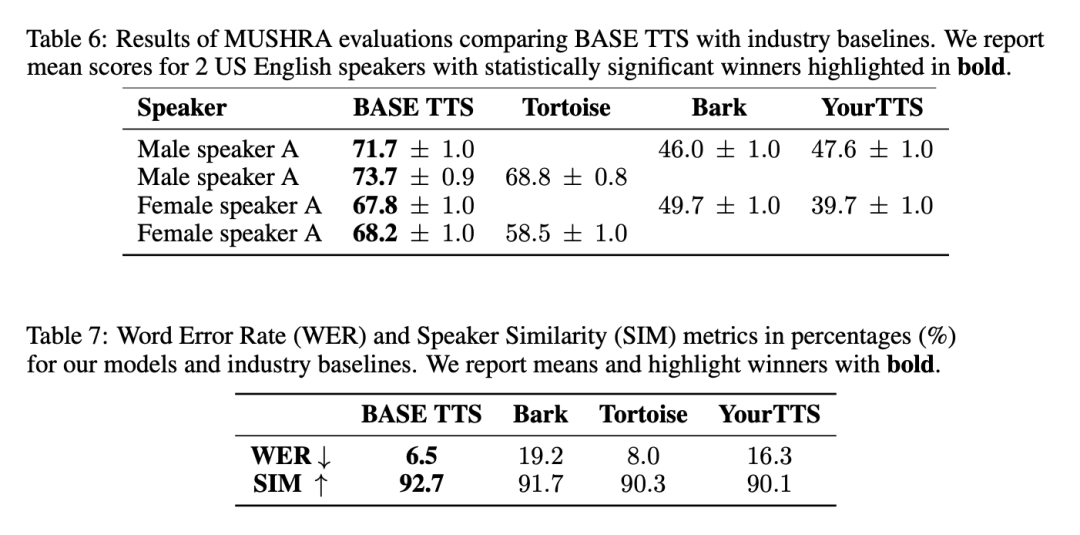

Secara amnya, BASE TTS menjana pertuturan yang paling semula jadi, mempunyai paling sedikit salah jajaran dengan teks input dan paling serupa dengan ucapan penceramah rujukan. Keputusan yang berkaitan ditunjukkan dalam Jadual 6 dan Jadual 7:

Peningkatan kecekapan sintesis yang dibawa oleh codec pertuturan

Codec pertuturan mampu memproses penstriman, iaitu menjana pertuturan secara inkremental cara. Menggabungkan keupayaan ini dengan SpeechGPT autoregresif, sistem boleh mencapai kependaman bait pertama serendah 100 milisaat — cukup untuk menghasilkan pertuturan yang boleh difahami dengan hanya beberapa kod pertuturan yang dinyahkod.

Latensi minimum ini berbeza dengan penyahkod berasaskan resapan, yang memerlukan keseluruhan urutan pertuturan (satu atau lebih ayat) dijana sekali gus, dengan kependaman bait pertama bersamaan dengan jumlah masa penjanaan.

Selain itu, penyelidik mendapati bahawa codec pertuturan menjadikan keseluruhan sistem pengiraan lebih cekap dari segi pengiraan dengan faktor 3 berbanding garis dasar resapan. Mereka menjalankan penanda aras yang menghasilkan 1000 penyata dengan tempoh kira-kira 20 saat dengan saiz kelompok 1 pada GPU NVIDIA® V100. Secara purata, SpeechGPT berbilion parameter menggunakan penyahkod resapan mengambil masa 69.1 saat untuk melengkapkan sintesis, manakala SpeechGPT yang sama menggunakan codec pertuturan hanya mengambil masa 17.8 saat.

Untuk butiran penyelidikan lanjut, sila rujuk kertas asal.

Atas ialah kandungan terperinci 'Kemunculan Pintar' Penjanaan Pertuturan: 100,000 Jam Latihan Data, Amazon Menawarkan 1 Bilion Parameter BASE TTS. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Inovasi teknologi mempercepatkan pelaksanaan industri antara muka otak-komputer negara saya

- Korea Selatan mengumumkan bahawa ia akan melabur 500 bilion won dalam tempoh lima tahun akan datang untuk menyokong industri teras teknologi AI.

- Robot humanoid tujuan am domestik akan dikeluarkan, dan industri akan mempercepatkan kejayaan

- Adakah Amazon Fire HD 10 Plus (2021) berbaloi untuk dibeli?