Rumah >Peranti teknologi >AI >Beidahetu mengeluarkan Galvatron, artifak latihan yang diedarkan, untuk merealisasikan paralelisasi yang cekap dan automatik bagi model besar dengan satu klik

Beidahetu mengeluarkan Galvatron, artifak latihan yang diedarkan, untuk merealisasikan paralelisasi yang cekap dan automatik bagi model besar dengan satu klik

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 21:10:011238semak imbas

Kebelakangan ini, "model besar" telah bersinar dalam pelbagai senario aplikasi dalam bidang AI Antaranya, model pra-latihan berskala besar berdasarkan Transformer adalah salah satu model besar yang paling tipikal. dan telah menjadi asas semasa Seni bina teras Model Asas. Sebagai contoh, siri BERT dan GPT dalam bidang NLP, siri ViT dan Swin Transformer dalam bidang CV, serta model hibrid berbilang pakar MoE dan model CLIP berbilang modal yang sangat popular baru-baru ini, semuanya menggunakan Transformer sebagai infrastruktur teras. Sejajar dengan itu, model besar yang padat itu mempunyai parameter yang selalunya berjumlah berbilion, berpuluh bilion, atau malah bertrilion.

Untuk menyokong latihan model besar, orang ramai telah membangunkan banyak alatan (seperti Megatron yang dicadangkan oleh NVIDIA, DeepSpeed yang dicadangkan oleh Microsoft, FairSeq yang dicadangkan oleh Meta, dll.) untuk mencapai Pelbagai kaedah selari, keselarian data, keselarian model tensor, keselarian saluran paip, keselarian data berpecah, dsb. Sistem ini menyediakan enkapsulasi yang baik bagi kaedah selari di atas dan melindungi butiran pelaksanaan yang sepadan dari luar, membolehkan pengguna melaksanakan strategi selari hibrid dengan menambahkan konfigurasi.

Berdasarkan idea di atas, terdapat banyak kerja yang meneroka cara untuk menyatakan pelbagai kaedah selari pada peringkat tensor atau operator "automasi" jenis kerja ini adalah terutamanya dicerminkan dalam API selari dengan proses transformasi lapisan Pelaksanaan. Walau bagaimanapun, jika ia hanya terhad kepada mereka bentuk API selari atau ungkapan perantaraan, enkapsulasi kejuruteraan ini secara asasnya tidak menyelesaikan masalah latihan teragih. Hasil yang paling intuitif ialah pengguna masih tidak dapat dibebaskan daripada masalah penempatan yang diedarkan. Malah, penggunaan model besar yang diedarkan adalah masalah yang sangat kompleks Kebanyakan sistem latihan yang diedarkan semasa bergantung pada percubaan berulang manual pengguna dan pengalaman pakar sistem untuk digunakan, menyebabkan masalah serius kecekapan penggunaan sumber jurang yang besar daripada "keselarian automatik" sebenar.

Berdasarkan perkara ini, pasukan Beidahetu mencadangkan Galvatron, artifak latihan yang diedarkan, untuk mencapai penyelarasan automatik yang cekap bagi model besar. Kertas penyelidikan telah dipilih untuk persidangan antarabangsa teratas VLDB 2023.

- Alamat kertas: https://arxiv.org/abs/2211.13878

- Pautan kod projek: https://github.com/PKU-DAIR/Hetu/tree/main/tools/Galvatron

Apakah kesukaran dalam penyejajaran automatik model besar

Penyelidik percaya bahawa kesukaran dalam penyejajaran automatik model besar terutamanya dicerminkan dalam tiga aspek berikut:

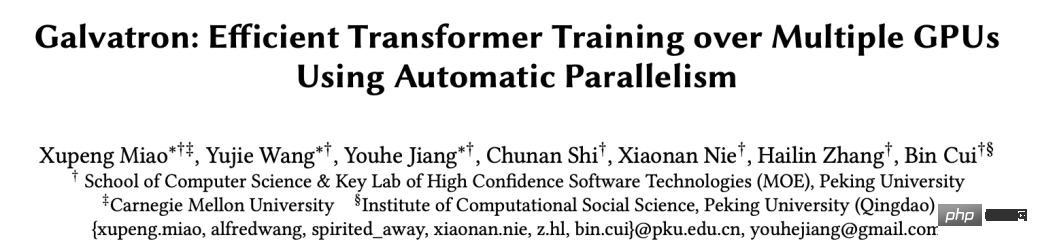

(1) Kepelbagaian: Pertama sekali, dari segi kaedah selari, kaedah selari semasa model besar berkembang Walaupun untuk operator yang sama, tanpa mengira kaedah selari campuran, berbeza Terdapat juga perbezaan yang ketara dalam kaedah paralelisme asas, menyebabkan overhed memori yang berbeza, kos komunikasi dan kecekapan pengiraan. Rajah berikut menunjukkan empat kaedah selari asas yang paling penting, iaitu Keselarian Data, Keselarian Tensor, Keselarian Saluran Paip, dan Keselarian Data Berkongsi Proses pelaksanaan teragih pengendali pendaraban matriks mudah pada GPU Zhang.

Rajah perbandingan kaedah selari

Kedua, dari segi model, pelbagai seni bina model telah muncul tanpa henti baru-baru ini, yang selalunya disertai dengan konfigurasi model yang berbeza (seperti panjang jujukan input yang berbeza, bilangan lapisan model, lebar lapisan tersembunyi model, dll. .), Ini menghasilkan perbezaan dalam beban pengiraan. Di samping itu, dari segi perkakasan, pengguna sering menghadapi persekitaran kluster yang sangat berbeza, dan mungkin menghadapi kapasiti memori yang berbeza, jalur lebar komunikasi, keupayaan pengkomputeran, dsb. Secara amnya, disebabkan kepelbagaian yang disebutkan di atas, tiada teknologi selari sentiasa boleh mencapai kecekapan latihan terbaik, dan "keselarian automatik" telah menjadi cabaran teras latihan yang diedarkan.

(2) Kerumitan: Analisis di atas agak mudah Malah, walaupun untuk operator yang sama, pelbagai kaedah selari asas yang berbeza boleh digunakan pada masa yang sama kaedah asas selari ialah Pendekatan selari campuran akan menyebabkan masalah menjadi sangat rumit. Lebih penting lagi, graf pengiraan model besar selalunya mempunyai struktur yang sangat besar, yang memerlukan kelompok yang lebih besar Jika setiap operator diterokai (termasuk memilih sumber pengkomputeran yang sesuai dalam kelompok dan mereka bentuk kaedah selari hibrid yang sepadan ), akan membawa masalah. gabungan letupan ruang, dan menjadi sukar untuk mencari pelan pelaksanaan teragih optimum untuk keseluruhan model.

(3) Praktikal: Selain itu, praktikal juga merupakan isu yang sangat penting. Di satu pihak, dalam proses carian selari automatik, untuk pelbagai penyelesaian pelaksanaan yang diedarkan, memori yang agak tepat, komunikasi, dan overhed pengkomputeran mesti disediakan jika tidak, keputusan akan menyimpang terlalu banyak daripada pelaksanaan sebenar, mengakibatkan penyelesaian suboptimum atau tidak dapat melakukannya sama sekali. Atas sebab ini, model kos yang sangat tepat diperlukan untuk memodelkan struktur model dan keadaan perkakasan yang berbeza. Sebaliknya, overhed masa tambahan yang disebabkan oleh keupayaan selari automatik sistem mestilah dalam julat yang boleh diterima, dan kos carian yang terlalu tinggi juga tidak boleh diterima.

Galvatron, artifak latihan yang diedarkan, merealisasikan paralelisasi yang cekap dan automatik bagi model besar dengan satu klik

Ciri sistem:

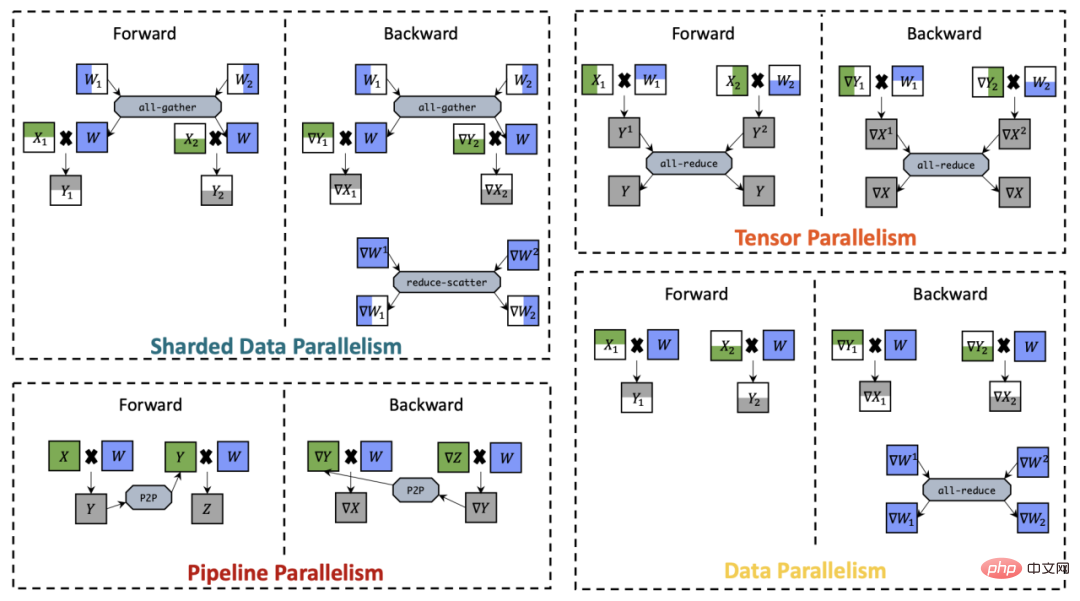

Untuk menyelesaikan masalah di atas, penyelidik telah mencadangkan beberapa siri kerja untuk meneroka carian automatik selari hibrid: satu jenis kerja terutamanya membincangkan ruang carian yang menganggap kedua-dua keselarian data dan keselarian model termasuk FlexFlow, Tauhu dan lain-lain Satu jenis kerja dijana daripada senario selari saluran paip dan menggabungkannya dengan kerja-kerja Perwakilan data termasuk PipeDream dan DAPPLE. Atas dasar ini, terdapat juga beberapa karya terbitan, seperti Unity dan Alpa, yang meluaskan lagi skop penerokaan selari automatik. Sistem "Galvatron" yang dicadangkan oleh pasukan Beidahetu juga tergolong dalam bidang penyelidikan carian selari automatik, tetapi berbanding dengan kerja sedia ada, sistem ini terutamanya mempunyai tiga kelebihan berikut:

(1 ) Dari segi kepelbagaian, dimensi selari yang boleh disokong oleh kerja sedia ada masih agak terhad, dan Galvatron bukan sahaja boleh menyokong lebih banyak dimensi selari, tetapi juga dapat memodelkan dengan tepat struktur model Transformer yang lebih berbeza, dan dalam Keupayaan penalaan adaptifnya mempunyai telah disahkan di bawah keadaan perkakasan kluster yang berbeza.

Rajah perbandingan sistem latihan teragih model besar

(2) Dari segi kerumitan, disebabkan kelebihannya dalam kepelbagaian, Galvatron menghadapi ruang carian yang tidak pernah berlaku sebelum ini, penyelidik telah meneroka beberapa proses dalam proses latihan teragih berskala besar semasa, secara eksperimen atau disahkan secara teori, berfungsi sebagai kriteria pemangkasan untuk ruang carian, dengan itu membolehkan pengoptimuman pelan pelaksanaan teragih yang cekap.

(3) Dari segi praktikal, penyelidikan ini menggabungkan kelebihan pemodelan teori dan pengukuran eksperimen untuk mencapai anggaran tepat memori, komunikasi, dan overhed pengkomputeran, malah mengambil kira masalah kecekapan pelaksanaan GPU yang dikurangkan disebabkan oleh pertindihan pengkomputeran dan komunikasi memastikan keputusan pengoptimuman selari automatik yang cukup tepat boleh diperolehi.

Selain itu, Galvatron memilih PyTorch sebagai enjin pelaksanaan di lapisan bawah, yang serasi dengan pelaksanaan model Transformer arus perdana biasa seperti Huggingface, jadi ia tidak akan membawa sebarang beban tambahan kepada PyTorch pengguna; pada masa yang sama, ia tidak memerlukan Pengguna membayar kos pemasangan atau penyahpepijatan sistem tambahan, dan hanya perlu menambah beberapa baris kod apabila menggunakannya, dan keseluruhan proses selari automatik boleh diselesaikan dengan mudah.

Aliran kerja Galvatron dan paparan antara muka pengguna

Teknologi utama

1. Cari penguraian ruang berdasarkan pepohon keputusan

Galvatron direka bentuk untuk mencari secara automatik secara cekap dalam ruang dasar selari yang kompleks dan besar serta menjana pelan pelaksanaan selari yang optimum untuk model Transformer tertentu dan persekitaran teragih. Dari segi ruang carian, Galvatron ialah sistem latihan selari automatik pertama dalam industri yang mempertimbangkan empat kaedah selari arus perdana, termasuk selari data (DP), selari data beling (SDP), dan selari tensor (keselarian tensor (TP). dan selari saluran paip (PP). Memandangkan strategi selari hibrid akan merangkumi sebarang kombinasi empat algoritma selari di atas, ruang carian yang dibawa oleh gabungan ini adalah sangat besar dalam senario berbilang GPU. Sebagai contoh, dalam senario empat kad dwi-mesin, satu strategi yang boleh dilaksanakan ialah menggunakan TP 2 hala dalam mesin dan PP 2 hala antara mesin Satu lagi strategi yang boleh dilaksanakan ialah menggunakan PP 2 hala dalam mesin dan antara mesin Gunakan DP 2 hala. Apabila bilangan GPU dalam nod dikembangkan kepada 8 kad, terdapat beratus-ratus strategi calon untuk setiap lapisan model. Apabila bilangan lapisan model meningkat, saiz ruang cariannya meningkat secara eksponen, menjadikannya sukar untuk diterokai dengan berkesan.

Untuk mencari ruang carian yang begitu besar dengan cekap, kajian ini mula-mula mencadangkan pemerhatian berikut sebagai panduan:

- Takeway #1 :PP cenderung untuk diletakkan di seluruh pulau peranti. Di sini "pulau peranti" merujuk kepada sekumpulan peranti dengan lebar jalur dalaman yang tinggi Dalam kebanyakan model Transformer, volum komunikasi PP adalah kurang berbanding kaedah selari yang lain. Oleh itu, orang ramai biasanya mengutamakan PP menghiris model dan meletakkannya di antara pulau peralatan.

- Takeway#2: Di bawah premis peranti homogen, strategi selari cenderung untuk membahagikan peranti secara sama rata. Sebagai contoh, DP 2 hala untuk GPU 4 kad akan cenderung untuk membahagikan peranti kepada dua set peranti 2 kad, bukannya satu set 1 kad dan satu set peranti 3 kad. Dalam kes ini, dasar paralelisme hibrid optimum dalam satu kumpulan peranti adalah konsisten dengan dasar optimum dalam kumpulan lain.

-

Takeway #3: Secara umumnya, apabila anda boleh mencampurkan DP dan SDP, hanya menggunakan SDP secara teori adalah lebih baik. Mengikut keputusan analisis, overhed komunikasi dan overhed memori N-way SDP adalah lebih baik daripada gabungan

dan

dan  , di mana

, di mana  .

.

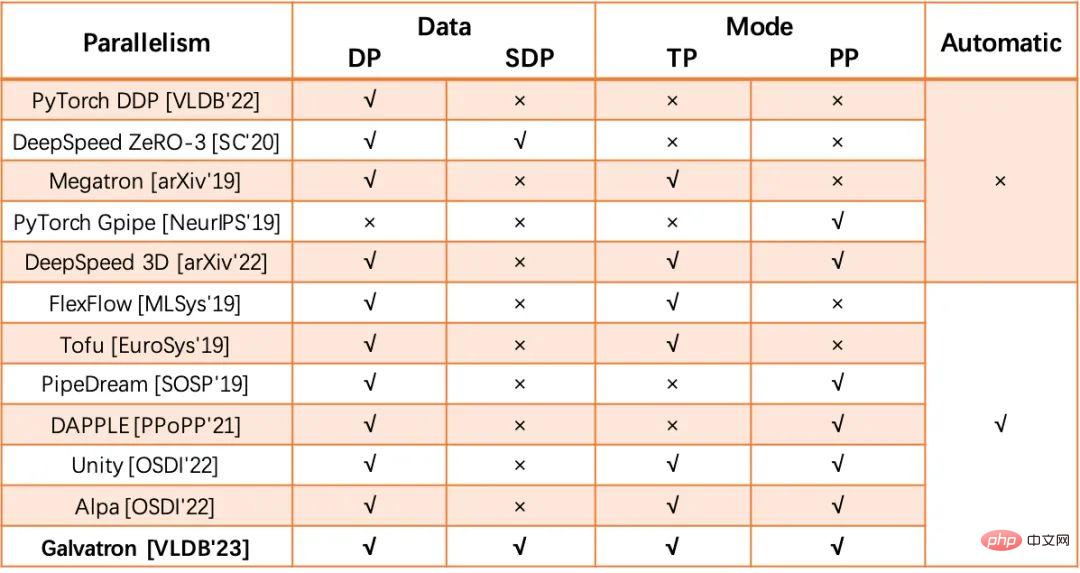

Berdasarkan pemerhatian penting di atas, kajian ini mencadangkan kaedah pembinaan ruang carian berdasarkan pepohon keputusan:

(1) Memandangkan model Transformer, berdasarkan Takeway#1 dan Takeway#2, Galvatron mula-mula menggunakan PP untuk membahagikan model kepada beberapa peringkat, dan pada masa yang sama membahagikan peralatan kepada beberapa kumpulan peralatan secara sama rata dan berterusan. Sebagai contoh, dalam senario 8 kad, model dibahagikan kepada 1/2/4/8 hala PP, dan saiz kumpulan peranti yang sepadan ialah 8/4/2/1 masing-masing.

(2) Setiap segmentasi PP sepadan dengan pepohon keputusan dan ruang sub-carian Jumlah bilangan nod daun keputusan ialah saiz kumpulan peralatan, dan ketinggian pepohon keputusan ialah kaedah selari yang tersedia, iaitu, satu strategi selari boleh digunakan pada setiap peringkat pepohon keputusan.

(3) Strategi selari tidak boleh digunakan semula antara peringkat yang berbeza bagi pepohon keputusan.

(4) Darjah nod bukan daun dipilih daripada kuasa eksponen 2 {2,4,8,…} secara lalai.

Berdasarkan peraturan pembinaan pepohon keputusan di atas, pepohon keputusan yang dibina oleh Galvatron boleh mewakili sebarang gabungan selari di atas. Takeway#1 dan Takeway#2 membantu Galvatron mengelakkan kombinasi selari yang tidak cekap dan mengurangkan ruang carian. Untuk senario melatih model satu lapisan pada GPU 8 kad, peraturan di atas akan menghasilkan 34 strategi selari hibrid calon. Tambahan pula, selepas menggunakan Takeway#3 untuk memangkas situasi di mana DP dan SDP muncul dalam pepohon keputusan pada masa yang sama, bilangan strategi calon 8 kad dikurangkan kepada 22.

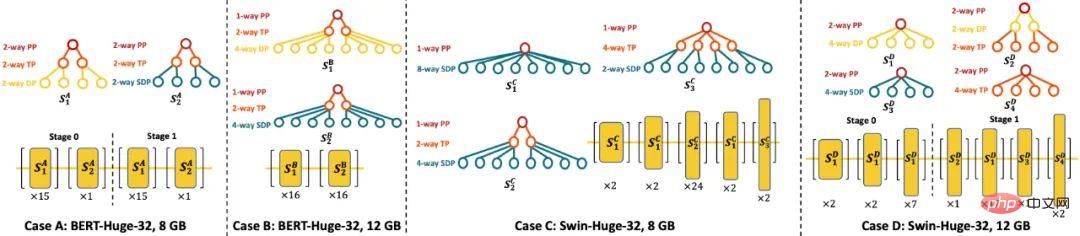

Rajah berikut menunjukkan rajah skema pepohon keputusan di bawah selari PP yang berbeza (8/4/2/1) dalam senario GPU 8 kad.

Gambar rajah skematik pepohon keputusan di bawah selari PP berbeza (8/4/2/1) dalam senario GPU 8 kad

2 . yang sangat mengehadkan penggunaan Keupayaan yang diedarkan untuk menyatakan rancangan untuk pelaksanaan. Matlamat pengoptimuman Galvatron adalah untuk menjana pelan pelaksanaan teragih optimum secara automatik tanpa pengguna menyatakan sebarang konfigurasi selari apabila pengguna diberi definisi model dan persekitaran teragih. Khususnya, memandangkan peranti GPU model M dan N lapisan L dengan kapasiti memori E, matlamat pengoptimuman Galvatron adalah untuk mencari T_pt pemprosesan sistem tertinggi dan mengembalikan penyelesaian selari yang sepadan di sini merujuk kepada lapisan ( atau operator ) sebagai unit asas bagi strategi selari hibrid berbutir halus.

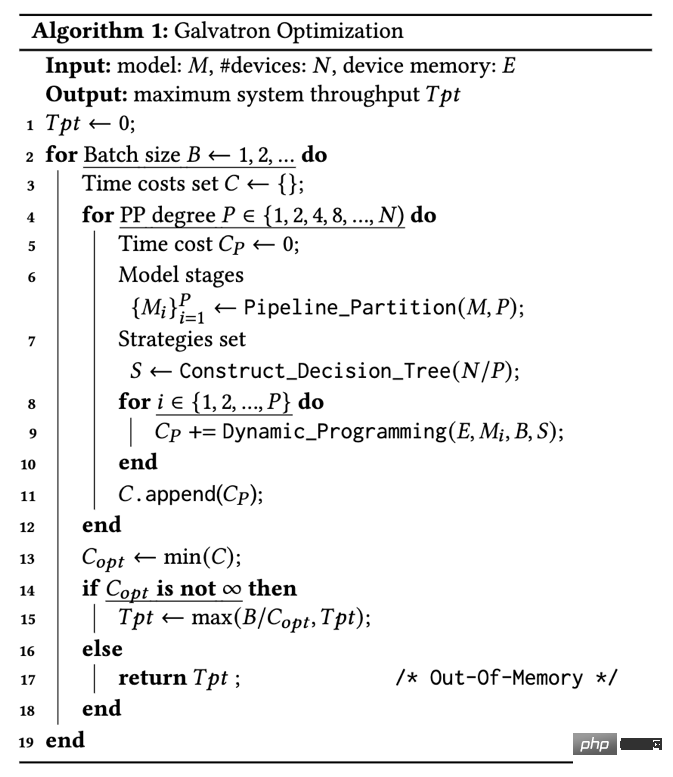

Algoritma 1: Proses Pengoptimuman Galvatron

Algoritma 1: Proses Pengoptimuman Galvatron

Proses pengoptimuman: Proses pengoptimuman Galvatron ditunjukkan dalam Algoritma 1. Gelung paling luar Galvatron secara beransur-ansur meningkatkan saiz kumpulan carian sehingga ia melebihi memori peranti memandangkan setiap saiz kumpulan calon B, Galvatron mula-mula membahagikan model PP mengikut Takeaway#1 dan mencari darjah selari P yang berbeza (baris 4), Selepas memilih P; -cara PP, model dibahagikan kepada peringkat P (baris 6), dan semua peralatan yang sepadan dibahagikan kepada kumpulan P, setiap kumpulan mengandungi peralatan N/P kemudian Galvatron membina pokok keputusan yang sepadan, yang boleh mewakili sebarang kombinasi DP; , SDP, dan TP tanpa pertindihan atau peninggalan, dengan itu memperoleh set strategi S maka untuk setiap peringkat model M_i, di bawah had memori peranti E, Galvatron menggunakan carian pengaturcaraan dinamik untuk mendapatkan setiap lapisan Strategi selari hibrid yang optimum dan mengembalikan masa minimum; kos (baris 9); akhirnya, Galvatron memilih strategi dengan daya pengeluaran tertinggi di antara semua keselarian PP yang mungkin dan saiz kelompok dan mengembalikannya (baris 15).

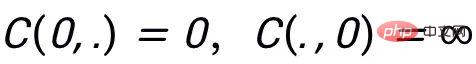

Carian pengaturcaraan dinamik: Berikut memperkenalkan algoritma carian pengaturcaraan dinamik dalam aliran kerja pengoptimuman selari Galvatron. Untuk peringkat model tertentu yang mengandungi lapisan L, fungsi kos C(L,E) digunakan untuk mewakili jumlah masa pelaksanaan model lapisan L di bawah had memori peranti E, dan mewakili masa pelaksanaan lapisan L menggunakan strategi S_j, di mana strategi S_j ialah strategi dalam set calon strategi selari S. Menetapkan nilai awal

, carian pengaturcaraan dinamik Galvatron mengikut persamaan peralihan keadaan berikut (Formula 1):

Di mana,

ialah overhed memori lapisan L menggunakan strategi S_j, ialah overhed penukaran yang disebabkan oleh lapisan L-th menggunakan strategi S_j dan lapisan sebelumnya menggunakan strategi S_i. Semasa proses pemindahan keadaan, apabila overhed memori melebihi had memori peranti had memori peranti E, fungsi overhed C mengembalikan infiniti. Analisis kerumitan: Kerumitan pengiraan carian pengaturcaraan dinamik (Formula 1) yang digunakan oleh Galvatron ialah O(LE|S|). Dapat dilihat bahawa saiz ruang carian S bagi setiap lapisan adalah sangat penting kepada kerumitan carian keseluruhan Penguraian ruang carian berdasarkan pepohon keputusan yang dicadangkan oleh Galvatron boleh mengurangkan ruang carian dengan ketara dan mengawal overhed carian dalam tempoh yang munasabah. julat.

3. Kaedah anggaran kos pelaksanaan berdasarkan pemodelan hibrid

Galvatron menggunakan modul anggaran kos dasar untuk menganggarkan pengkomputeran, komunikasi dan overhed memori bagi strategi selari hibrid. Kaedah anggaran kos sedia ada terutamanya termasuk pengukuran (profil) dan simulasi (simulasi) Galvatron menggunakan kekuatan kedua-duanya dan mereka bentuk kaedah anggaran kos yang efektif, cekap dan tepat. Khususnya, untuk overhed memori, Galvatron menggunakan bentuk dan jenis data tensor untuk melengkapkan anggaran untuk masa pengiraan, Galvatron mengukur masa pengiraan sampel demi sampel melalui pemprofilan pada satu peranti, menggabungkan saiz kelompok dan fungsi pemasangan kepada menganggarkan pengiraan keseluruhan Masa untuk masa komunikasi, Galvatron memperoleh anggaran masa komunikasi dengan membahagikan volum komunikasi dengan lebar jalur komunikasi peranti, di mana volum komunikasi dikira secara teori dan lebar jalur komunikasi diukur dengan pemprofilan.

Berdasarkan keputusan anggaran di atas, Galvatron mengira kos c(l,s) lapisan tertentu menggunakan strategi tertentu melalui proses pelaksanaan simulasi. Berbeza daripada model kos sistem latihan teragih sedia ada, Galvatron mempertimbangkan kesan pertindihan pengkomputeran dan komunikasi terhadap kemerosotan prestasi GPU buat kali pertama dalam pemodelan. Kajian ini secara eksperimen mendapati bahawa kemerosotan prestasi GPU akibat pertindihan boleh menjejaskan kecekapan pelaksanaan sistem dengan ketara, yang telah diabaikan dalam kerja sebelumnya. Akibatnya, anggaran overhed Galvatron adalah lebih tepat dan pengoptimuman selari adalah lebih baik.

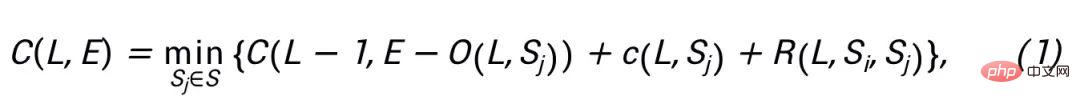

Hasil eksperimen

Tetapan eksperimen: Dalam eksperimen, penyelidik menggabungkan Galvatron dan empat sistem garis dasar (DP, SDP, TP, PP) menggunakan strategi selari tunggal Untuk perbandingan dengan DeepSpeed 3D Parallelism yang ditetapkan oleh pakar, dua versi tambahan Galvatron yang lemah telah disediakan sebagai garis dasar tambahan untuk menjalankan carian selari automatik dalam ruang gabungan strategi selari terhad (iaitu TP+DP, PP+DP). Kajian ini memilih model NLP Transformer BERT dan T5, dan CV Transformer model ViT dan Swin Transformer sebagai subjek eksperimen.

Perbandingan daya pengeluaran antara Galvatron dan sistem garis dasar di bawah 8 GPU dan memori video 20G

Kesan perbandingan eksperimen: Kajian pertama kali dijalankan dalam persekitaran 24GB Nvidia RTX TITAN lapan kad. Eksperimen menunjukkan bahawa di bawah saiz model yang berbeza dan kekangan memori yang berbeza, Galvatron sentiasa mencapai daya tampung yang optimum, dan daya tampung latihannya dipertingkatkan dengan ketara berbanding kaedah selari tunggal dan kaedah selari hibrid yang terkini. Khususnya, pada model ViT, nisbah pecutan daya tampung Galvatron boleh mencapai sehingga 338% berbanding dengan satu strategi, dan nisbah pecutan daya tampungnya boleh mencapai sehingga 55% berbanding strategi selari hibrid yang lain dalam tiga model lain Berbanding dengan strategi tunggal; dan strategi campuran sedia ada, Galvatron mempunyai nisbah pecutan sehingga 200%-334% dan 28%-52%.

Ilustrasi beberapa strategi selari optimum yang diperolehi oleh carian Galvatron

Eksperimen Kebolehtafsiran: Kajian ini memilih beberapa strategi selari optimum yang diperoleh oleh carian Galvatron untuk paparan. Untuk model BERT dalam kes 8GB (Kes A), Galvatron memilih dua strategi selari hibrid PP-TP-DP dan PP-TP-SDP Apabila memori video yang tersedia meningkat kepada 12GB, Galvatron melepaskan PP dan memilih untuk menggunakan lebih banyak Berbilang DP, dan SDP diperkenalkan untuk menjimatkan ruang memori video. Keadaannya sedikit berbeza pada Swin Transformer Lapisan yang berbeza pada model menunjukkan kepelbagaian yang jelas Apabila memori video agak terhad (Kes C), selari SDP cetek adalah lebih tinggi Apabila bilangan lapisan bertambah, setiap lapisan pengaktifan menjadi lebih kecil dan parameter menjadi lebih banyak, jadi TP secara beransur-ansur menggantikan SDP. Apabila memori video meningkat (Kes D), PP bukan sahaja didayakan semula untuk menggantikan sebahagian daripada SDP yang tidak cekap, tetapi lapisan cetek cenderung menggunakan DP dengan lebih jelas.

Eksperimen Skalabiliti: Kajian itu menguji Galvatron lagi pada kelompok yang lebih besar, termasuk persekitaran dengan GPU Nvidia RTX TITAN 16 kad dan persekitaran GPU Nvidia A100 64 kad . Dalam persekitaran 16 kad, Galvatron masih mempunyai daya pengeluaran tertinggi berbanding strategi lain Berbanding dengan keputusan eksperimen 8 kad dengan had memori yang sama, disebabkan oleh strategi selari hibrid yang lebih pelbagai, Galvatron boleh memperoleh lebih daripada 2 kali daya pemprosesan. pada 16 kad nisbah Speedup. Dalam percubaan 64 kad, Galvatron juga mempunyai kadar pemprosesan tertinggi antara strategi lain. Ini menunjukkan bahawa Galvatron mempunyai kebolehskalaan yang baik Keputusan terperinci boleh didapati dalam kertas asal.

Pengenalan kepada pasukan Hetu Universiti Peking

Pasukan pembangunan Hetu berasal dari Makmal Penyelidikan Data dan Perisikan di Universiti Peking (selepas ini dirujuk sebagai makmal diketuai oleh Profesor Cui Bin dari Pusat Pengajian Sains Komputer di Universiti Peking Selama bertahun-tahun, ia telah menjalankan penyelidikan termaju dalam bidang kecerdasan buatan dan data besar. Ia telah mencapai banyak keputusan dalam inovasi teori dan teknologi serta penyelidikan dan pembangunan telah diterbitkan dalam persidangan akademik antarabangsa dan jurnal Lebih daripada 100 kertas kerja akademik.

Sistem Hetu ialah sistem pembelajaran mendalam teragih untuk model yang sangat besar Berbanding dengan rangka kerja pembelajaran mendalam teragih sedia ada, ia mempunyai kelebihan dalam fungsi sistem, kerumitan sistem dan kemudahan sistem banyak sumbangan inovatif dari segi kebolehgunaan, seperti strategi selari teragih automatik, protokol ketekalan dan seni bina komunikasi, pengoptimuman pengendali GPU, dsb. Pasukan Hetu pada masa ini telah menjalankan inovasi akademik dalam pelbagai senario pembelajaran mesin atau pembelajaran mendalam yang diedarkan, dan hasil yang relevan telah dimasukkan dalam persidangan antarabangsa terkemuka seperti SIGMOD, VLDB, ICML, KDD, dll. Antaranya, model besar yang jarang sistem latihan teragih HET memenangi Hadiah Terbaik VLDB 2022 Anugerah Kertas Sains Data Berskala. Galvatron, kertas kerja yang diterima oleh VLDB 2023 kali ini, merupakan satu lagi kejayaan yang dicapai oleh pasukan Hetu dalam senario latihan pengedaran model besar yang padat Ia telah disepadukan ke dalam sistem Hetu dan merupakan sumber terbuka. Pada masa ini, pasukan Hetu telah menjalankan kerjasama penyelidikan saintifik dan pelaksanaan aplikasi dengan banyak syarikat terkenal seperti Tencent, Alibaba, Kuaishou, dan ByteDance.

Atas ialah kandungan terperinci Beidahetu mengeluarkan Galvatron, artifak latihan yang diedarkan, untuk merealisasikan paralelisasi yang cekap dan automatik bagi model besar dengan satu klik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- 5 Trend Keselamatan Siber Terbaik pada 2024

- Cara memilih teknologi AI moden untuk aplikasi pembuatan dan automasi

- Syarikat keselamatan AI TrojAI menerima pembiayaan benih tambahan

- Purata penggunaan harian model Token of Doubao melebihi 500 bilion, dan keluarga model dinaik taraf semula

- cara menggunakan copilot secara percuma