Rumah >Peranti teknologi >AI >Penyanyi Google AI akan datang! AudioLM boleh mengarang muzik dan lagu dengan hanya mendengar selama beberapa saat.

Penyanyi Google AI akan datang! AudioLM boleh mengarang muzik dan lagu dengan hanya mendengar selama beberapa saat.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-11 21:10:061081semak imbas

Model penjanaan imej digulung! Model generatif video digulung!

Yang seterusnya ialah model penjanaan audio.

Baru-baru ini, pasukan penyelidik Google melancarkan model AI untuk penjanaan pertuturan-AudioLM.

Dengan hanya beberapa saat gesaan audio, ia boleh menjana bukan sahaja pertuturan yang berkualiti tinggi dan koheren, tetapi juga muzik piano.

Alamat kertas: https://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

AudioLM ialah rangka kerja penjanaan audio berkualiti tinggi dengan jangka panjang ketekalan , memetakan audio input ke dalam rentetan token diskret dan mengubah tugas penjanaan audio kepada tugas pemodelan bahasa.

Tagger audio sedia ada perlu membuat pertukaran antara kualiti penjanaan audio dan struktur jangka panjang yang stabil.

Untuk menyelesaikan percanggahan ini, Google menggunakan penyelesaian "tokenisasi hibrid", menggunakan pengaktifan diskret model bahasa topeng pra-latihan dan menggunakan kod diskret yang dijana oleh codec audio saraf untuk mencapai sintesis berkualiti tinggi.

Model AudioLM boleh belajar menjana perkataan berterusan yang semula jadi dan koheren berdasarkan gesaan pendek, apabila dilatih tentang pertuturan, tanpa sebarang rakaman atau anotasi Ia mencapai pertuturan berterusan yang tatabahasa lancar dan munasabah dari segi semantik, di samping mengekalkan identiti dan intonasi penutur.

Selain pertuturan, AudioLM juga boleh menjana muzik piano yang koheren tanpa memerlukan sebarang notasi muzik untuk latihan.

Dari teks kepada muzik piano: dua isu utama

Dalam beberapa tahun kebelakangan ini, model bahasa yang dilatih mengenai korpora teks besar-besaran telah menunjukkan keupayaan generatif mereka yang sangat baik, mencapai dialog terbuka, terjemahan Mesin dan juga akal sehat penaakulan, juga boleh memodelkan isyarat selain daripada teks, seperti imej semula jadi.

Idea AudioLM adalah untuk memanfaatkan kemajuan dalam pemodelan bahasa ini untuk menjana audio tanpa latihan mengenai data beranotasi.

Walau bagaimanapun, ini memerlukan dua masalah.

Pertama, kadar data untuk audio jauh lebih tinggi dan jujukan unit lebih panjang. Sebagai contoh, ayat mengandungi berpuluh-puluh perwakilan aksara, tetapi selepas ditukar kepada bentuk gelombang audio, ia biasanya mengandungi ratusan ribu nilai.

Selain itu, terdapat hubungan satu-dengan-banyak antara teks dan audio. Ayat yang sama boleh disampaikan oleh penutur yang berbeza dengan gaya, kandungan emosi dan konteks yang berbeza.

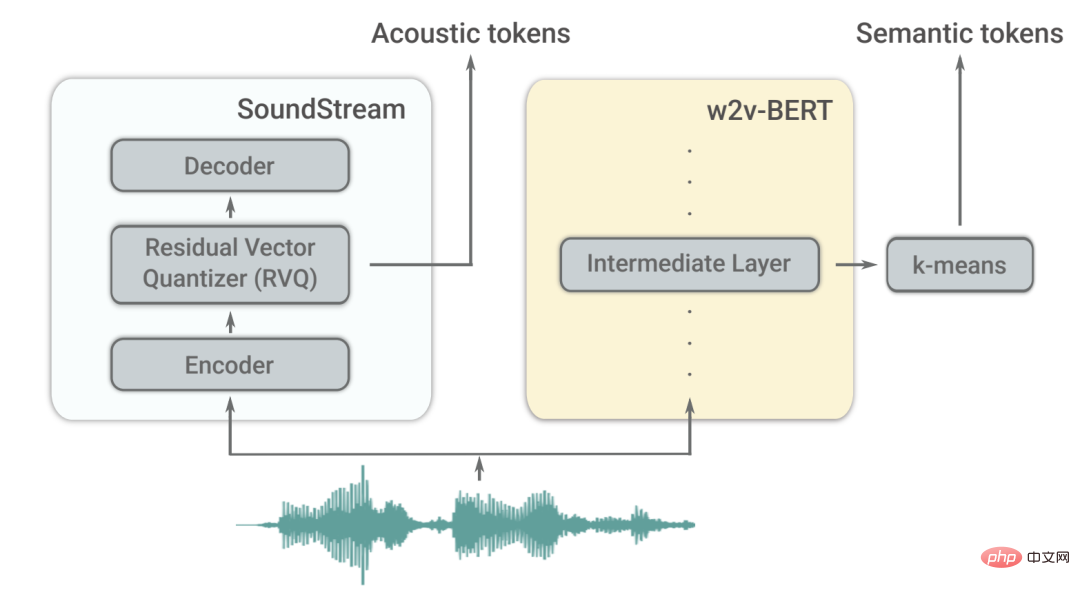

Untuk mengatasi dua cabaran ini, AudioLM menggunakan dua jenis penanda audio.

Pertama, teg semantik diekstrak daripada w2v-BERT, model audio yang diselia sendiri.

Teg ini boleh menangkap kedua-dua kebergantungan tempatan (seperti pertuturan dalam pertuturan, melodi tempatan dalam muzik piano) dan struktur jangka panjang global (seperti sintaks bahasa dan kandungan semantik dalam pertuturan, harmoni dan irama dalam muzik piano) sambil banyak menurunkan pensampelan isyarat audio untuk memodelkan jujukan yang panjang.

Walau bagaimanapun, kesetiaan audio yang dibina semula daripada token ini tidaklah tinggi.

Untuk meningkatkan kualiti bunyi, selain pengetagan semantik, AudioLM juga menggunakan tag akustik yang dijana oleh codec neural SoundStream untuk menangkap butiran bentuk gelombang audio (seperti ciri pembesar suara atau keadaan rakaman) untuk sintesis berkualiti tinggi .

Bagaimana untuk melatih?

AudioLM ialah model audio sahaja yang dilatih tanpa sebarang perwakilan simbolik teks atau muzik.

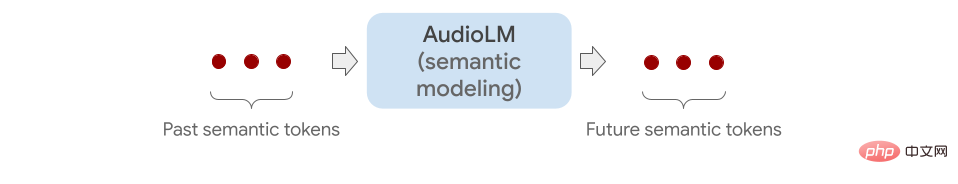

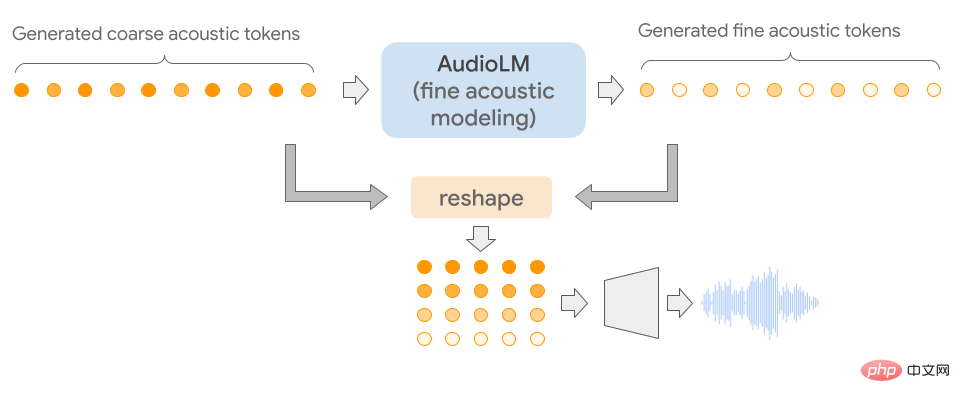

Ia memodelkan jujukan audio secara hierarki dengan merantai berbilang model Transformer (satu untuk setiap peringkat) daripada pengetegan semantik kepada pengetegan akustik halus.

Setiap peringkat dilatih untuk meramalkan token seterusnya berdasarkan token terakhir, sama seperti melatih model bahasa.

Peringkat pertama melaksanakan tugas ini pada teg semantik untuk memodelkan struktur peringkat tinggi jujukan audio.

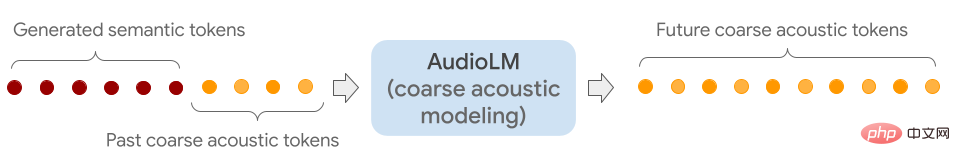

Pada peringkat kedua, dengan menyambungkan keseluruhan jujukan teg semantik dengan teg kasar yang lalu, dan memberi kedua-duanya sebagai syarat kepada model kasar, dan kemudian meramalkan tanda masa hadapan .

Langkah ini mensimulasikan sifat akustik, seperti ciri pembesar suara atau timbre dalam muzik.

Pada peringkat ketiga, model akustik halus digunakan untuk memproses isyarat akustik kasar, menambah butiran lanjut pada audio akhir.

Akhir sekali, penanda akustik dimasukkan ke dalam penyahkod SoundStream untuk membina semula bentuk gelombang.

Selepas latihan selesai, AudioLM boleh dilaraskan pada beberapa saat audio, yang membolehkannya menjana audio berterusan.

Untuk menunjukkan kebolehgunaan umum AudioLM, penyelidik mengujinya melalui 2 tugasan dalam medan audio yang berbeza.

Yang pertama ialah Penerusan Pertuturan Model ini mengekalkan ciri-ciri pembesar suara yang dicadangkan dan prosodi, di samping mengeluarkan kandungan baharu yang betul dari segi tatabahasa dan konsisten dari segi semantik.

Yang kedua ialah sambungan Piano, model ini akan menjana muzik piano yang konsisten dengan gesaan dari segi melodi, harmoni dan irama.

Seperti yang ditunjukkan di bawah, semua bunyi yang anda dengar selepas garis menegak kelabu dijana oleh AudioLM.

Untuk mengesahkan kesannya, penyelidik meminta penilai manusia mendengar klip audio pendek untuk menentukan sama ada ia adalah rakaman asal ucapan manusia atau rakaman yang dihasilkan oleh AudioLM.

Menurut rating yang dikumpul, dapat dilihat bahawa AudioLM mempunyai kadar kejayaan sebanyak 51.2%, bermakna pertuturan yang dihasilkan oleh model AI ini sukar untuk dibezakan oleh pendengar biasa daripada pertuturan sebenar.

Rupal Patel, yang mempelajari sains maklumat dan bahasa di Universiti Timur Laut, berkata bahawa kerja sebelum ini menggunakan kecerdasan buatan untuk menjana audio hanya boleh menangkap nuansa ini jika ia dianotasi secara eksplisit dalam data latihan.

Sebaliknya, AudioLM secara automatik mempelajari ciri ini daripada data input dan juga mencapai hasil ketepatan tinggi.

Dengan kemunculan model ML berbilang modal seperti GPT3 dan Bloom (penjanaan teks), DALLE dan Stable Diffusion (penjanaan imej), RunwayML dan Make-A-Video (penjanaan video), penciptaan kandungan dan kreativiti Kerja sedang berubah.

Dunia masa depan ialah dunia yang dihasilkan oleh kecerdasan buatan.

Rujukan:

https://www.php.cn/link/c11cb55c3d8dcc03a7ab7ab722703e0a

https://www.php.cn/link/c5f7756d9f92a9

https://www.php.cn/link/9b644ca9f37e3699ddf2055800130aa9Atas ialah kandungan terperinci Penyanyi Google AI akan datang! AudioLM boleh mengarang muzik dan lagu dengan hanya mendengar selama beberapa saat.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI