Al Agent--대형 모델 시대의 중요한 구현 방향

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-04-15 09:10:011205검색

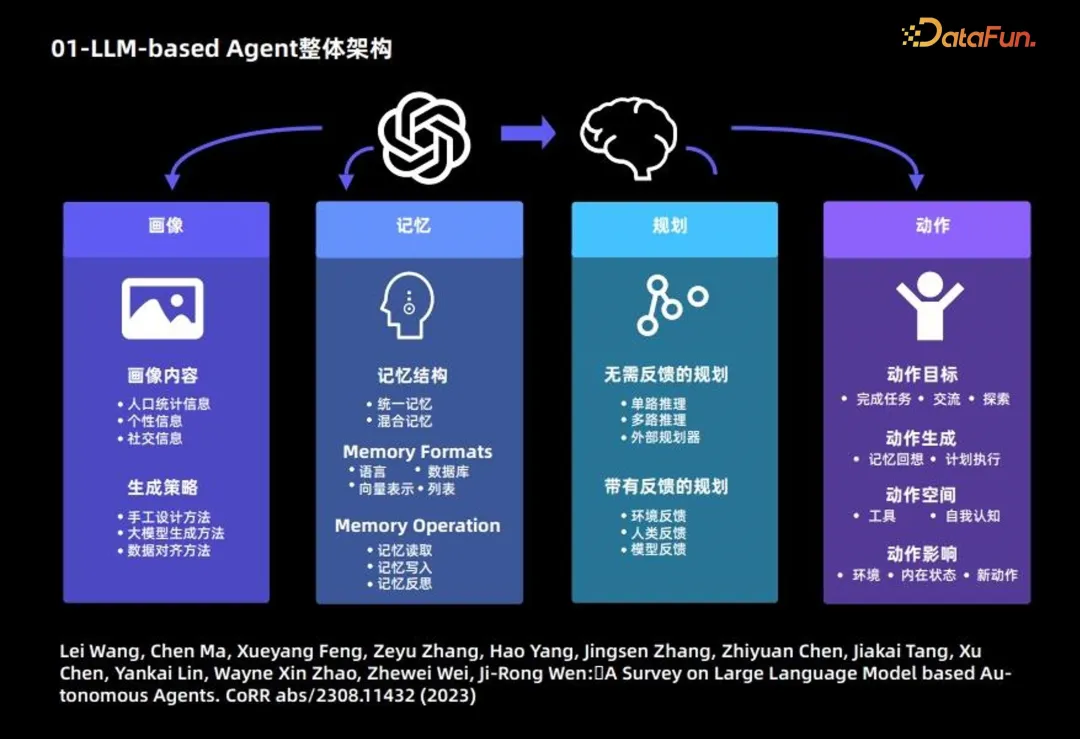

1. LLM 기반 에이전트의 전체 아키텍처

대형 언어 모델 에이전트의 구성은 주로 다음 4개 모듈로 나뉩니다.

1 세로 모듈: 주로 배경을 설명합니다. information of the Agent

다음은 초상화 모듈의 주요 내용과 생성 전략을 소개합니다.

초상화 콘텐츠는 주로 인구통계정보, 성격정보, 사회정보 3가지 정보를 기반으로 합니다.

생성 전략: 초상화 콘텐츠를 생성하는 데 주로 3가지 전략이 사용됩니다.

- 수동 디자인 방법: 사용자 초상화의 콘텐츠를 특정 방식으로 숫자에 적용 가능한 대형 모델의 프롬프트에 작성합니다. of Agents 상대적으로 적은 수의 상황;

- 대규모 모델 생성 방법: 먼저 소수의 초상화를 지정하고 이를 예로 사용한 다음 대규모 언어 모델을 사용하여 다수의 상황에 적합한 더 많은 초상화를 생성합니다. 에이전트;

- 데이터 정렬 방법: 미리 지정된 데이터 세트에 있는 문자의 배경 정보를 대규모 언어 모델의 프롬프트로 사용하고 그에 따른 예측을 하는 것이 필요합니다.

2. 메모리 모듈: 주요 목적은 에이전트 동작을 기록하고 향후 에이전트 결정을 지원하는 것입니다.

메모리 구조:

- 단기 메모리만 고려됩니다. 장기기억이 아닙니다.

- 하이브리드 메모리: 장기 기억과 단기 기억이 결합된 메모리입니다.

기억 형태: 주로 다음 4가지 형태를 기반으로 합니다.

- 언어

- Database

- 벡터 표현

- List

메모리 내용: 다음 3가지 일반적인 작업은 다음과 같습니다.

- 기억 읽기

- 기억 쓰기

- 기억 반영

3. 계획 모듈

- 피드백 없는 계획: 대형 언어 모델 추론 과정에서 피드백 없음 외부 환경이 필요합니다. 이러한 유형의 계획은 세 가지 유형으로 더 세분화됩니다. 즉, 크라우드소싱 아이디어를 활용하여 다중 채널 기반 추론 단계를 완전히 출력하기 위해 대규모 언어 모델을 한 번만 사용하는 단일 채널 기반 추론, 대규모 언어 모델이 여러 이유 경로를 생성하고 외부 계획자를 빌려 최적의 경로를 결정할 수 있도록 합니다.

- 피드백을 통한 계획: 이 계획 방법은 외부 환경의 피드백이 필요한 반면, 대규모 언어 모델은 다음 단계 및 후속 계획을 위해 환경의 피드백이 필요합니다. 이러한 유형의 계획 피드백 제공자는 환경 피드백, 인간 피드백, 모델 피드백의 세 가지 소스에서 나옵니다.

4. 작업 모듈

- 작업 목표: 일부 에이전트 목표는 작업 완료, 일부는 의사소통, 일부는 탐색입니다.

- 액션 생성: 일부 에이전트는 메모리 회상을 사용하여 액션을 생성하고 일부 에이전트는 원래 계획에 따라 특정 액션을 수행합니다.

- 동작 공간: 일부 동작 공간은 도구 모음이고 일부는 전체 동작 공간을 자기 인식의 관점에서 고려하여 대형 언어 모델 자체 지식을 기반으로 합니다.

- 행동 영향: 환경에 대한 영향, 내면 상태에 대한 영향, 미래의 새로운 행동에 대한 영향을 포함합니다.

위 내용은 Agent의 전체 프레임워크입니다. 자세한 내용은 다음 문서를 참조하세요.

Lei Wang, Chen Ma, Xueyang Feng, Zeyu Zhang, Hao Yang, Jingsen Zhang, Zhiyuan Chen , Jiakai Tang, Xu Chen, Yankai Lin, Wayne Xin Zhao, Zhewei Wei, Ji-Rong Wen: 대규모 언어 모델 기반 자율 에이전트에 대한 설문 조사. CoRR abs/2308.11432(2023)

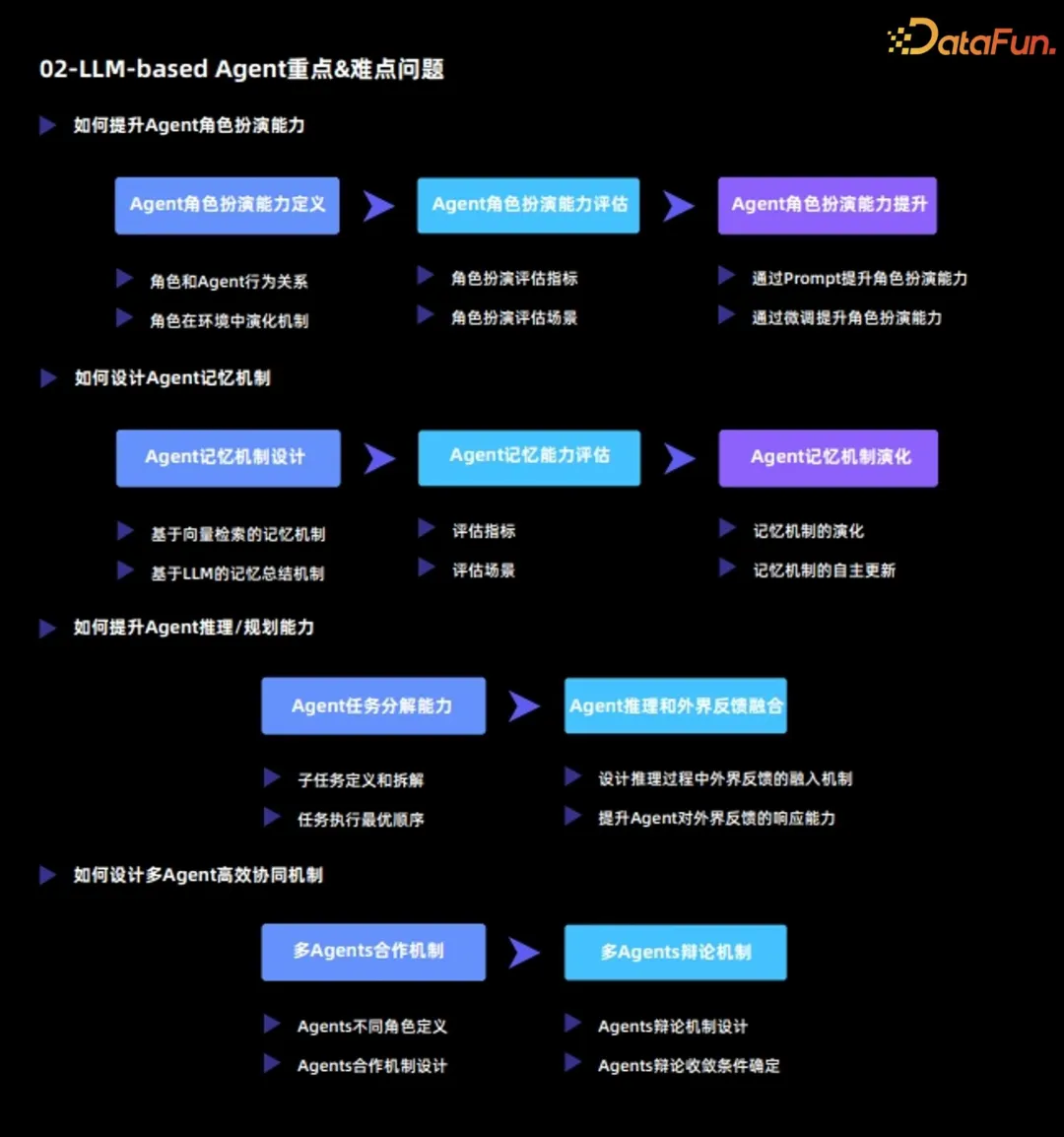

2. LLM 기반 에이전트의 주요 및 어려운 문제

현재 대규모 언어 모델 에이전트의 주요 및 어려운 문제는 주로 다음과 같습니다.

1. 에이전트의 롤플레잉 능력을 향상시키는 방법

에이전트 가장 중요한 기능은 특정 역할을 수행하여 특정 작업을 완료하거나 다양한 시뮬레이션을 완료하는 것이므로 에이전트의 롤플레잉 능력이 중요합니다.

(1) 에이전트 롤플레잉 능력 정의

에이전트 롤플레잉 능력은 두 가지 차원으로 구분됩니다.

- 캐릭터와 에이전트 행동 관계

- 캐릭터 진화 메커니즘 환경

(2) 에이전트 롤플레잉 능력 평가

롤플레잉 능력을 정의한 후 다음 두 가지 측면에서 에이전트 롤플레잉 능력을 평가합니다.

- 롤플레잉 평가 지표

- 롤플레잉 평가 시나리오

(3) 에이전트의 롤플레잉 능력 향상

평가를 바탕으로 에이전트의 롤플레잉 능력이 두 가지 유형이 더 개선되어야 합니다. 방법:

- 프롬프트를 통한 역할극 능력 향상: 이 방법의 핵심은 프롬프트를 디자인하여 원래의 대규모 언어 모델의 능력을 자극하는 것입니다. 미세 조정을 통한 롤플레잉 능력 향상: 이 방법은 일반적으로 외부 데이터를 사용하여 대규모 언어 모델을 다시 미세 조정하여 롤플레잉 능력을 향상시키는 방법을 기반으로 합니다.

- 2. Agent 메모리 메커니즘 설계 방법

Agent와 대규모 언어 모델의 가장 큰 차이점은 Agent가 환경에서 지속적으로 발전하고 자체 학습할 수 있다는 것입니다. 매우 중요한 역할 성격. 에이전트의 메모리 메커니즘을 3차원에서 분석합니다.

(1) 에이전트 메모리 메커니즘 설계

두 가지 일반적인 메모리 메커니즘이 있습니다.

- 벡터 검색 기반 메모리 메커니즘

- LLM 요약에 기반한 메모리 메커니즘

- (2) 에이전트 메모리 능력 평가

에이전트의 메모리 능력을 평가하려면 주로 다음 두 가지 사항을 결정하는 것이 필요합니다.

- 평가 지표

- 평가 시나리오

- (3) 에이전트 메모리 메커니즘 진화

마지막으로 다음을 포함하여 에이전트 메모리 메커니즘의 진화를 분석해야 합니다.

- 메모리 메커니즘의 진화

- 메모리 메커니즘의 자동 업데이트

3. 에이전트 추론/계획 능력을 향상시키는 방법

(1) 에이전트 작업 분해 능력

- 하위 작업 정의 및 해체

- 작업 실행의 최적 순서

(2) Agent 추론과 외부 피드백 통합

- 외부 피드백 통합 메커니즘을 설계 추론 과정: 에이전트와 환경이 상호 작용하는 전체를 형성하도록 합니다.

- 외부 피드백에 응답하는 에이전트의 능력을 향상합니다. 한편으로는 에이전트가 외부 환경에 진정으로 응답해야 합니다. 반면에 에이전트는 외부 환경에 대해 질문하고 해결책을 찾을 수 있어야 합니다.

4. 효율적인 다중 에이전트 협업 메커니즘을 설계하는 방법

(1) 다중 에이전트 협력 메커니즘

- 에이전트의 다양한 역할 정의

- 에이전트 협력 메커니즘 디자인

(2) 다중 에이전트 토론 메커니즘

- 에이전트 토론 메커니즘 설계

- 에이전트 토론 수렴 조건

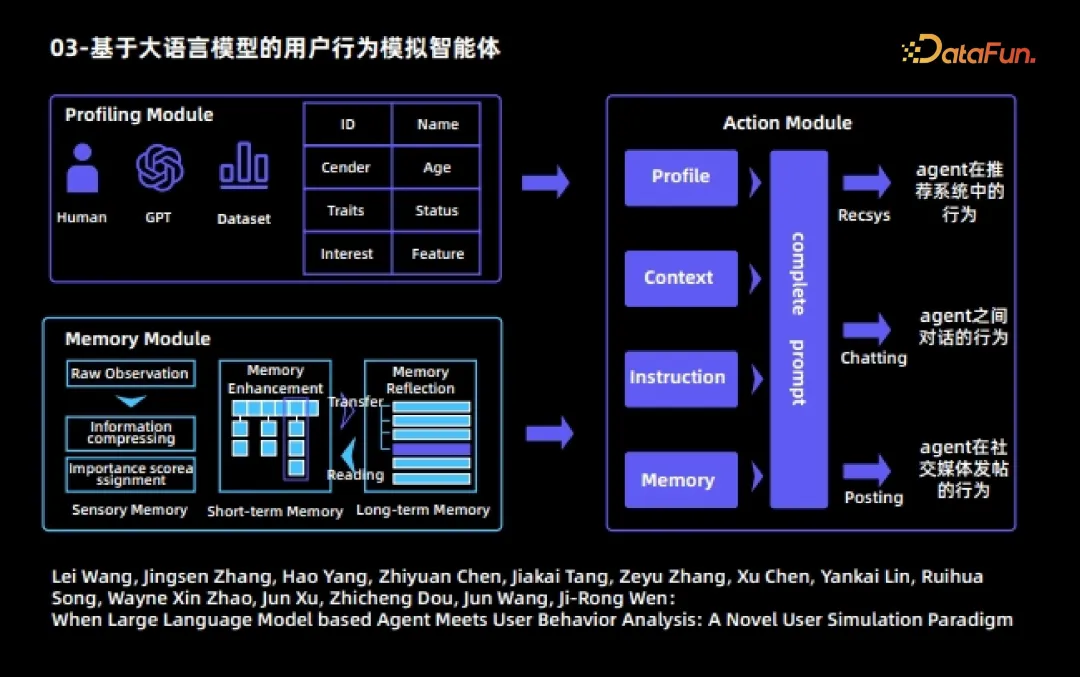

3. 대규모 언어 모델 기반 행동 시뮬레이션 에이전트

다음은 에이전트의 실제 사례입니다. 첫 번째는 대규모 언어 모델을 기반으로 한 사용자 행동 시뮬레이션 에이전트입니다. 이 에이전트는 대규모 언어 모델 에이전트와 사용자 행동 분석을 결합한 초기 작업이기도 합니다. 이 작업에서 각 에이전트는 세 가지 모듈로 나뉩니다.

1. 초상화 모듈

은 ID, 이름, 직업, 나이, 관심사, 특성 등과 같은 다양한 에이전트에 대한 다양한 속성을 지정합니다.

2. 메모리 모듈

메모리 모듈에는 3개의 하위 모듈이 포함됩니다.

(1) 느낌 기억

(2) 단기 기억

- 수행 객관적으로 관찰 원시 관찰 처리 후 더 높은 정보 내용을 가진 관찰이 생성되어 단기 기억에 저장됩니다.

- 단기 기억 내용의 저장 시간은 상대적으로 짧습니다

(3) 장기; memory

- 반복된 트리거링과 활성화 후에 단기 기억의 내용은 자동으로 장기 기억으로 옮겨집니다. 장기 기억 내용의 저장 시간은 상대적으로 길며 독립적인 반영과 승화를 수행합니다. 정제.

- 3. 작업 모듈

- 각 에이전트는 세 가지 작업을 수행할 수 있습니다.

에이전트 간 대화 행동

- 에이전트의 소셜 미디어 게시 행동.

- 전체 시뮬레이션 프로세스 동안 에이전트는 외부 간섭 없이 각 작업 라운드에서 세 가지 작업을 자유롭게 선택할 수 있습니다. 서로 다른 에이전트가 서로 대화하고 소셜 미디어에서 다양한 동작이 자동으로 생성되는 것을 볼 수 있습니다. 또는 추천 시스템, 여러 차례의 시뮬레이션을 통해 몇 가지 흥미로운 사회적 현상과 인터넷에서의 사용자 행동 규칙을 관찰할 수 있습니다.

- 자세한 내용은 다음 문서를 참조하세요.

Lei Wang, Jingsen Zhang, Hao Yang, Zhiyuan Chen, Jiakai Tang, Zeyu Zhang, Xu Chen, Yankai Lin, Ruihua Song, Wayne Xin Zhao, Jun Xu, Zhicheng Dou, Jun Wang, Ji-Rong Wen: 언어가 큰 경우 모델 기반 에이전트와 사용자 행동 분석의 만남: 새로운 사용자 시뮬레이션 패러다임

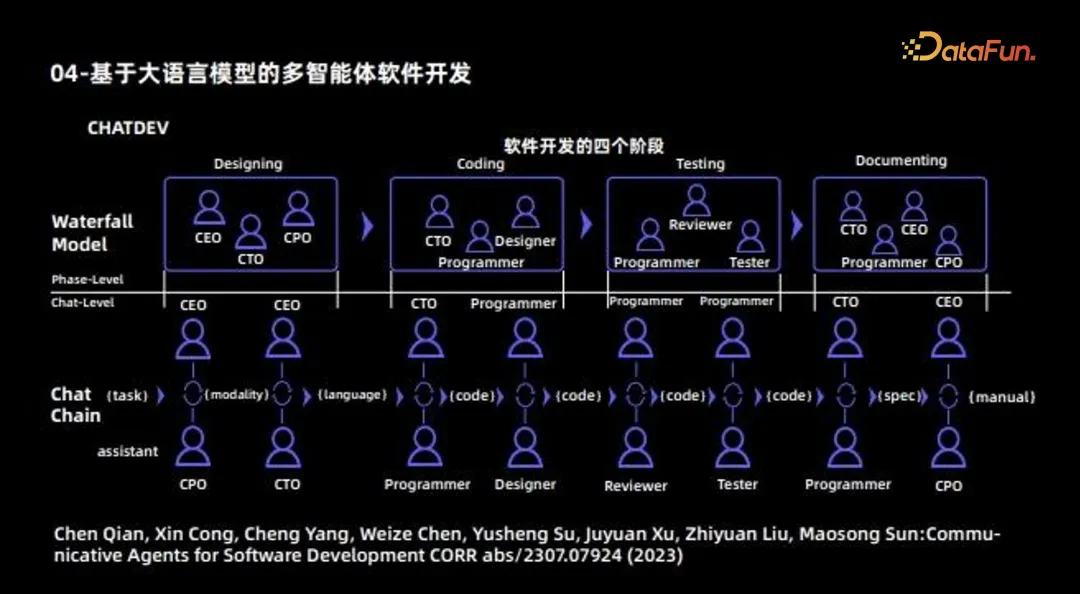

IV. 여러 Agent가 소프트웨어 개발을 수행합니다. 이 작업은 다중 에이전트 협력의 초기 작업이기도 하며, 주요 목적은 서로 다른 에이전트를 사용하여 완전한 소프트웨어를 개발하는 것입니다. 따라서 소프트웨어 회사로 간주될 수 있으며 다양한 에이전트가 다른 역할을 수행합니다. 일부 에이전트는 CEO, CTO, CPO 및 기타 역할을 포함하여 설계를 담당하고 일부 에이전트는 주로 코딩을 담당합니다. 또한 일부 대리인은 문서 작성을 담당합니다. 이러한 방식으로 서로 다른 에이전트가 서로 다른 작업을 담당합니다. 마지막으로 에이전트 간의 협력 메커니즘이 통신을 통해 조정되고 업데이트되며 최종적으로 완전한 소프트웨어 개발 프로세스가 완료됩니다.

5. LLM 기반 에이전트의 향후 방향

대규모 언어 모델의 에이전트는 현재 크게 두 가지 방향으로 나눌 수 있습니다.

다음과 같은 특정 작업을 해결합니다. MetaGPT, ChatDev, Ghost, DESP 등

다음과 같은 특정 작업을 해결합니다. MetaGPT, ChatDev, Ghost, DESP 등 이 유형의 에이전트는 궁극적으로 두 가지 "한정자"를 포함하여 올바른 인간 가치와 일치하는 "슈퍼맨"이어야 합니다.

-

올바른 인간 가치와 일치

평범한 인간의 능력을 뛰어넘습니다. Generative Agent, Social Simulation, RecAgent 등 현실 세계를 시뮬레이션합니다.

이 유형의 에이전트에 필요한 기능은 첫 번째 유형과 완전히 반대입니다. -

에이전트가 다양한 가치를 제시할 수 있도록 해주세요.

에이전트는 평범한 사람을 넘어서는 것이 아니라 평범한 사람에게 맞춰지도록 최선을 다하길 바랍니다.

또한 현재의 대형 언어 모델 에이전트에는 다음과 같은 두 가지 문제점이 있습니다. 환상 문제

에이전트는 환경과 지속적으로 상호 작용해야 하기 때문에 각 단계의 환상이 누적됩니다. 즉, 발생합니다. 누적 효과로 인해 문제가 더욱 심각해집니다. 따라서 여기서는 대형 모델의 환상에 더 많은 주의가 필요합니다. 솔루션에는 다음이 포함됩니다.

-

효율적인 인간-기계 협업 프레임워크를 설계합니다.

Design 효율적인 인간 개입 메커니즘. 효율성 문제

시뮬레이션 프로세스에서 효율성은 매우 중요한 문제입니다. 다음 표에는 다양한 API 번호를 사용하는 다양한 에이전트의 시간 소비가 요약되어 있습니다. -

위는 이번에 공유한 내용입니다. 모두 감사드립니다.

-

위 내용은 Al Agent--대형 모델 시대의 중요한 구현 방향의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

다음과 같은 특정 작업을 해결합니다. MetaGPT, ChatDev, Ghost, DESP 등

다음과 같은 특정 작업을 해결합니다. MetaGPT, ChatDev, Ghost, DESP 등