마법처럼 수정된 RNN이 Transformer에 도전하고 RWKV가 새로워졌습니다: 두 가지 새로운 아키텍처 모델 출시

- 王林앞으로

- 2024-04-15 09:10:061260검색

Transformer의 일반적인 경로를 택하는 대신 RNN의 새로운 국내 아키텍처 RWKV를 수정하고 새로운 진전을 이루었습니다.

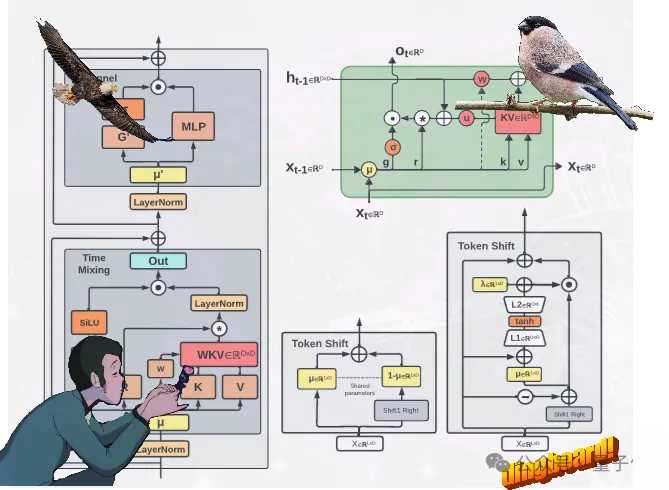

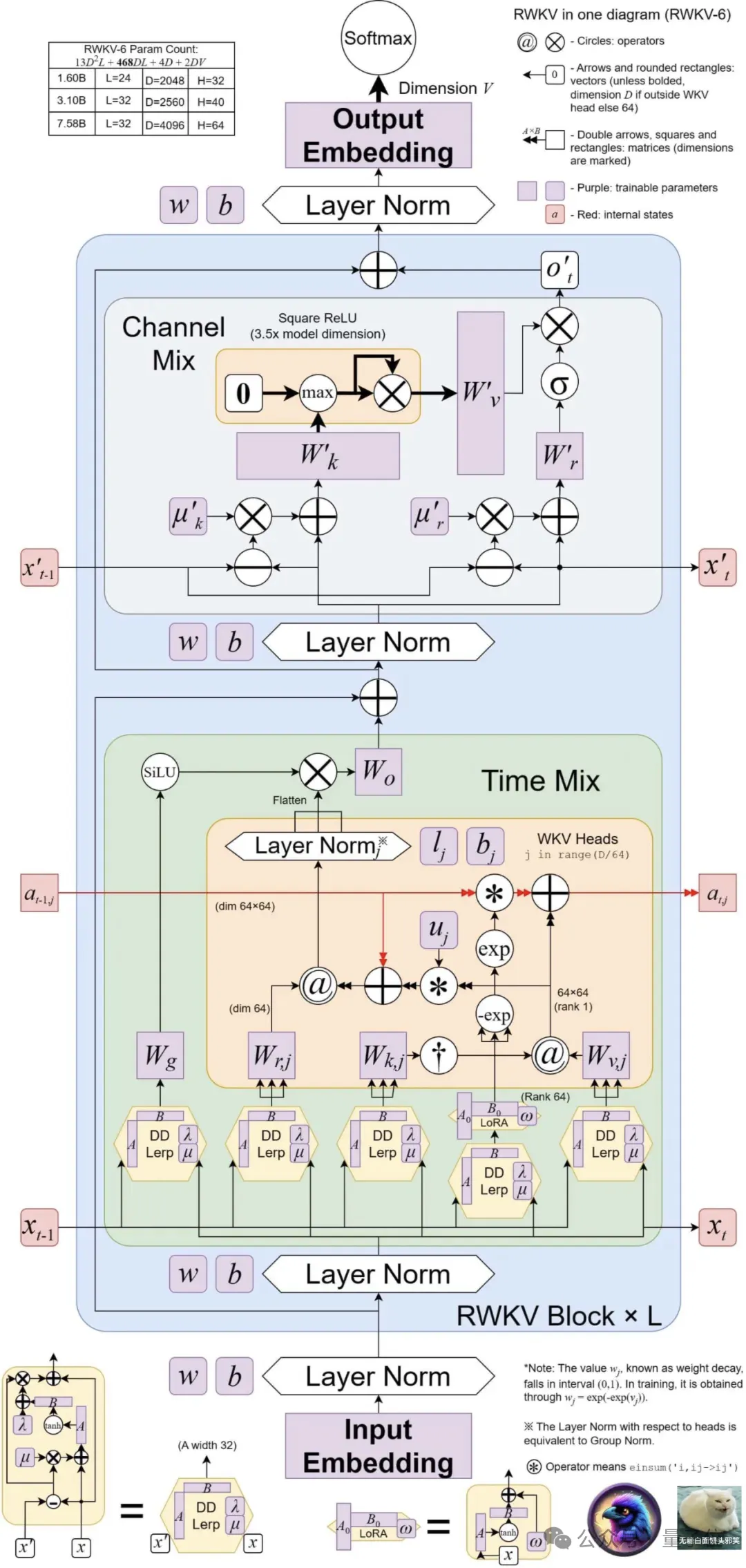

두 개의 새로운 RWKV 아키텍처, 즉 Eagle(RWKV-5) 및 Finch ( RWKV-6).

이 두 시퀀스 모델은 RWKV-4 아키텍처를 기반으로 한 후 개선되었습니다.

새 아키텍처의 디자인 발전에는 다중 행렬 값 상태(다중 행렬 값 상태) 및 동적 재발 메커니즘(동적 재발 메커니즘)이 포함됩니다. RNN의 추론 효율성 특성을 유지하면서 RWKV 모델을 사용합니다.

동시에 새로운 아키텍처는 1조 1200억 개의 토큰을 포함하는 새로운 다국어 코퍼스를 도입합니다.

또한 팀은 RWKV의 다국어 기능을 향상시키기 위해 탐욕스러운 매칭을 기반으로 한 빠른 토크나이저를 개발했습니다.

현재 Huo Hua Face에는 Eagle 모델 4개와 Finch 모델 2개가 출시되었습니다~

4 Eagle (RWKV-5)Model: 매개변수 크기는 각각 0.4B, 1.5B, 3B, 7B

2 Finch(RWKV-6)Model: 매개변수 크기는 각각 1.6B 및 3B입니다.

다중 행렬 값 상태(벡터 값 상태 대신), 재구성된 수용 상태 및 추가 게이팅 메커니즘 일정을 사용하여 RWKV-4에서 학습한 아키텍처 및 학습 붕괴를 개선합니다.

Finch는 매개변수화된 선형 보간을 포함하여 시간 혼합 및 토큰 이동 모듈을 위한새로운 데이터 관련 기능을 도입하여 아키텍처의 성능과 유연성을 더욱 향상시킵니다.

또한 Finch는 훈련 가능한 가중치 행렬이 상황에 맞는 방식으로 학습된 데이터 감쇠 벡터를 효과적으로 증가시킬 수 있도록 낮은 순위 적응 함수의 새로운 사용을 제안합니다. 마지막으로 새로운 RWKV 아키텍처는새로운 토크나이저 RWKV World Tokenizer와 새로운 데이터 세트 RWKV World v2를 도입합니다. 두 가지 모두 다국어 및 코드 데이터 성능에 대한 RWKV 모델을 개선하는 데 사용됩니다. .

새로운 토크나이저 RWKV World Tokenizer는 일반적이지 않은 언어의 단어를 포함하며 Trie 기반 그리디 매칭(탐욕 매칭)을 통해 빠른 토큰화를 수행합니다.

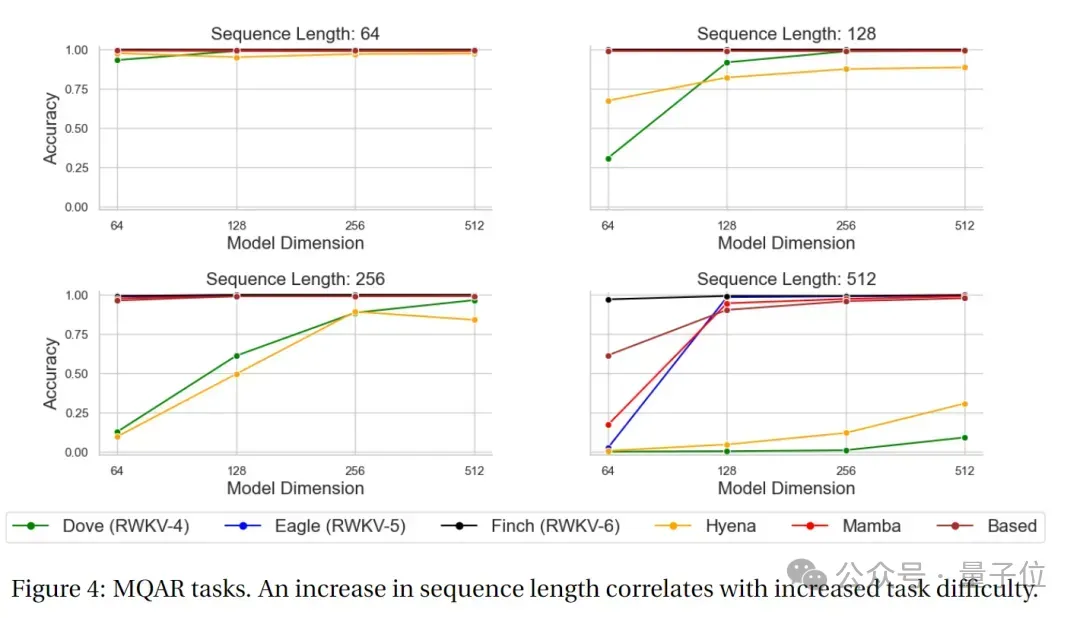

새로운 데이터세트 RWKV World v2는 공개적으로 이용 가능한 다양한 데이터 소스를 엄선하여 가져온 새로운 다국어 1.12T 토큰 데이터세트입니다. 데이터 구성은 약 70%가 영어 데이터, 15%가 다국어 데이터, 15%가 코드 데이터입니다. 벤치마크 결과는 어땠나요? 건축 혁신만으로는 충분하지 않습니다. 핵심은 모델의 실제 성능에 있습니다. 주요 권위 있는 평가 목록에서 새로운 모델의 결과를 살펴보겠습니다 - MQAR 테스트 결과MQAR(Multiple Query Associative Recall)작업은 언어 모델을 평가하는 데 사용되는 작업입니다. , 여러 쿼리에서 모델의 연관 메모리 능력을 테스트하도록 설계되었습니다.

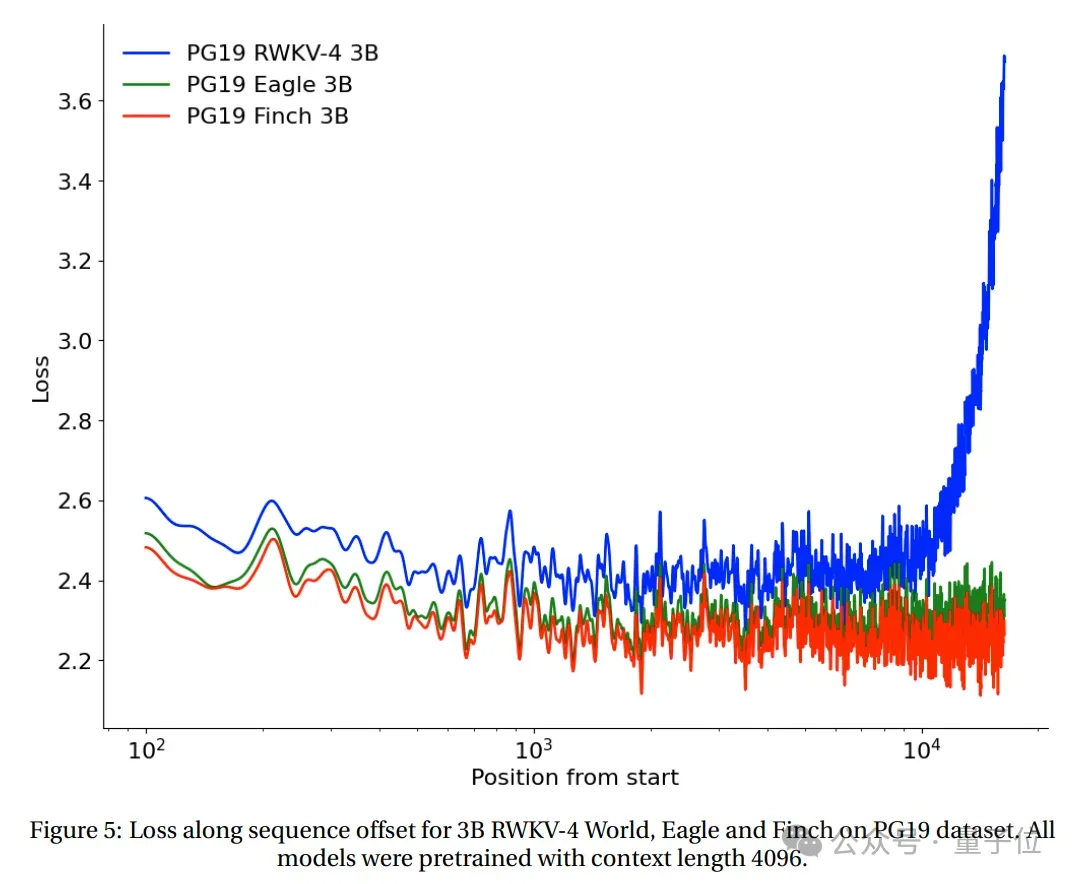

이러한 유형의 작업에서 모델은 여러 쿼리에 대해 관련 정보를 검색해야 합니다. MQAR 작업의 목표는 여러 쿼리에서 정보를 검색하는 모델의 능력은 물론 다양한 쿼리에 대한 적응성과 정확성을 측정하는 것입니다. 아래 그림은 RWKV-4, Eagle, Finch 및 기타 Non-Transformer 아키텍처의 MQAR 작업 테스트 결과를 보여줍니다.

(모든 모델은 컨텍스트 길이 4096을 기반으로 사전 학습되었습니다.) .

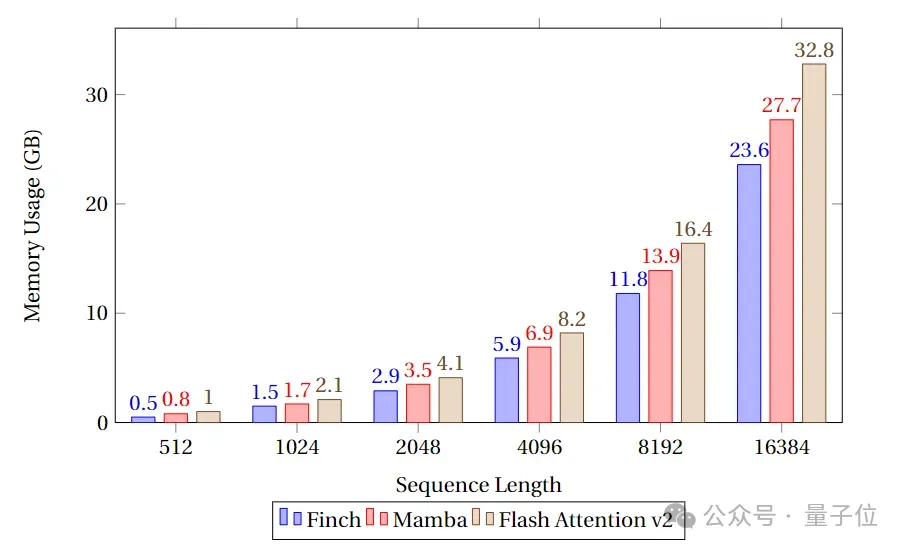

Finch는 메모리 사용량 면에서 항상 Mamba와 Flash Attention보다 우수하며, 메모리 사용량은 Flash Attention과 Mamba보다 각각 40%, 17% 적다는 것을 알 수 있습니다.

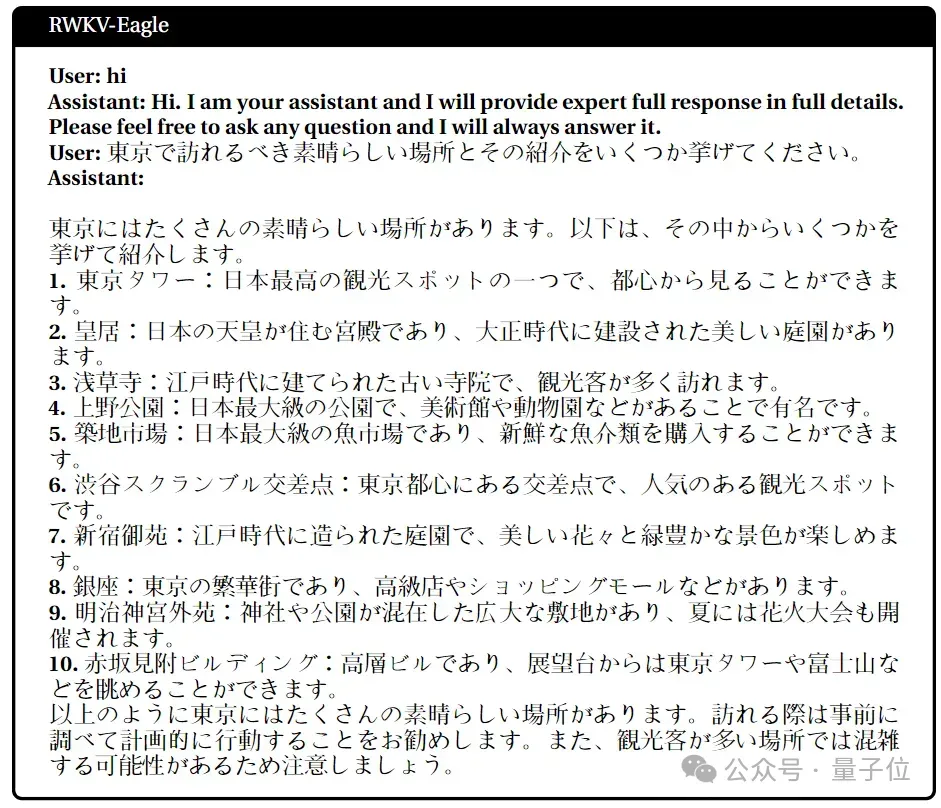

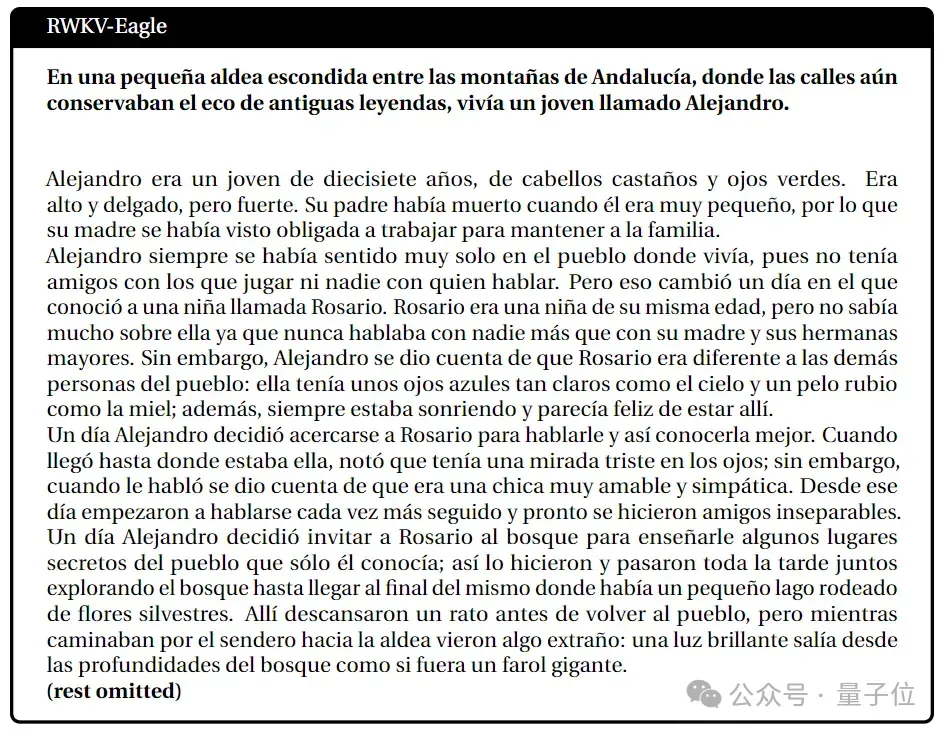

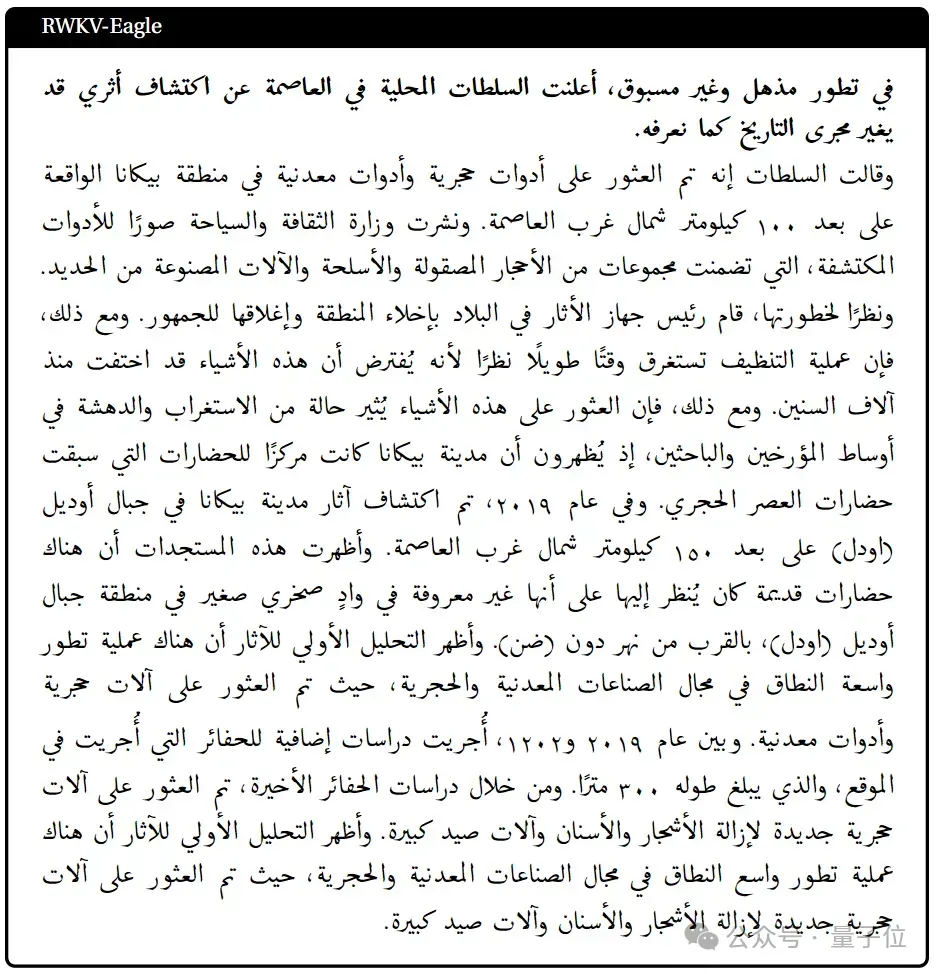

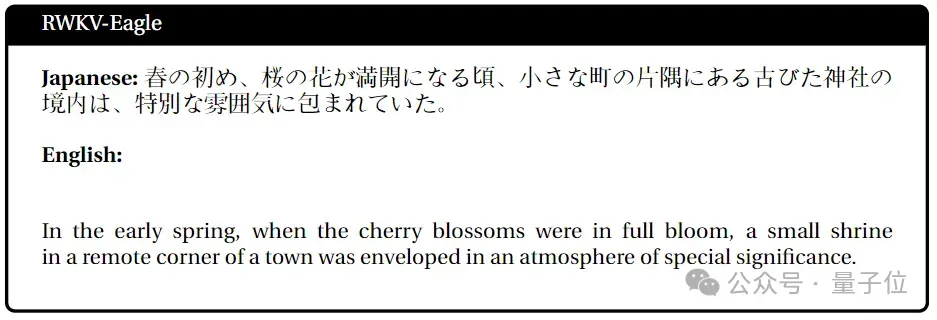

다국어 과제 수행

일본어

스페인어

Arabic

일본어-영어

다음 작품

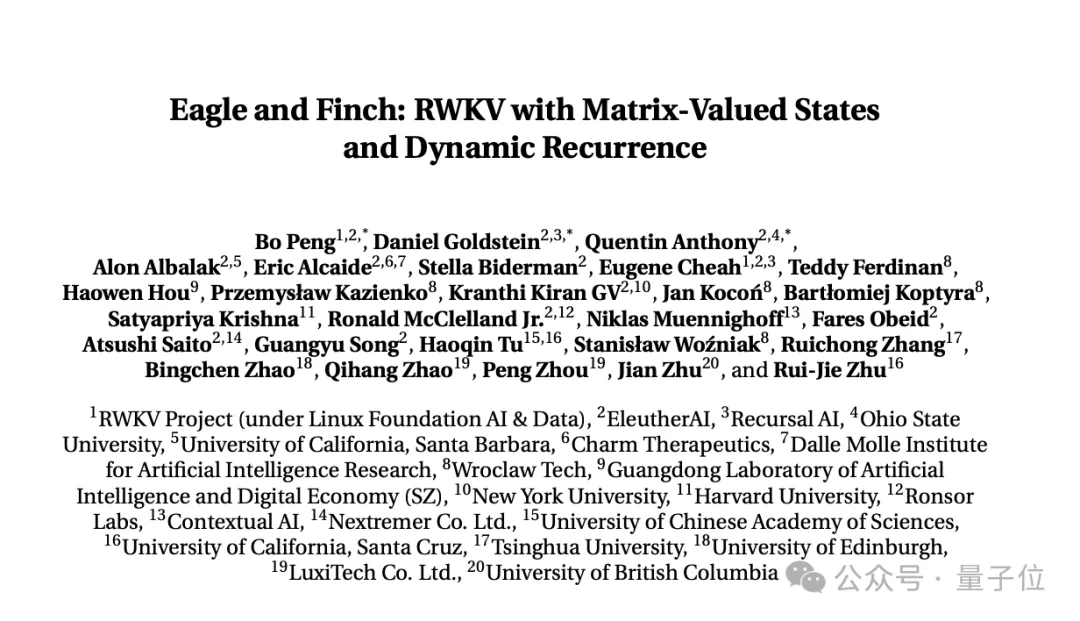

Abo 5개의 연구 콘텐츠, RWKV 재단에서 발행 최신 논문 "Eagle and Finch: 행렬 값 상태 및 동적 재발을 포함하는 RWKV".

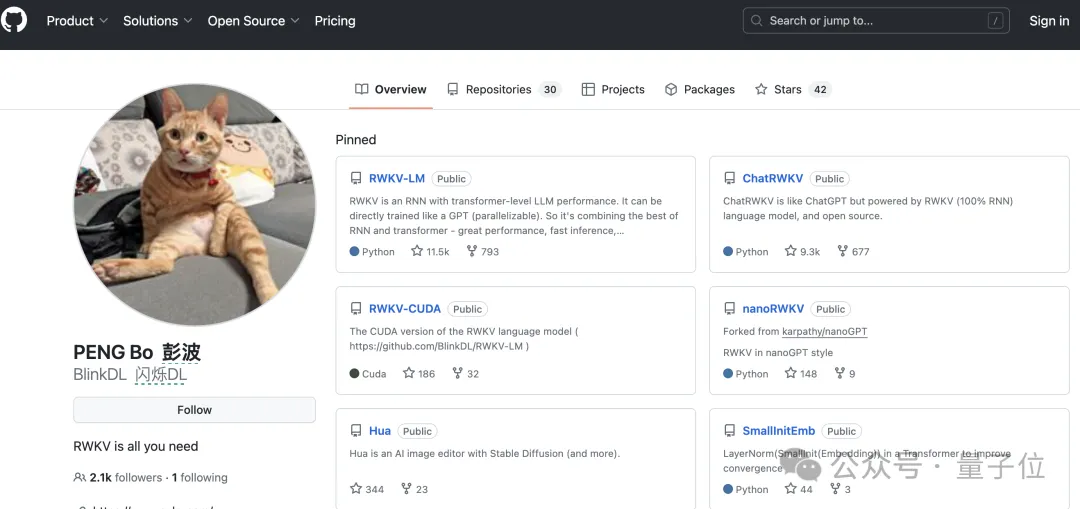

이 논문은 RWKV 창립자 Bo PENG(Bloomberg) 과 RWKV 오픈 소스 커뮤니티 회원이 공동으로 작성했습니다.

Bloomberg 공동저자, 홍콩대학교물리학과 졸업, 20년 이상의 프로그래밍 경험 보유. 한때 세계 최대 외환 헤지펀드 중 하나인 Ortus Capital에서 근무했으며 업무를 담당했습니다. 고주파 퀀트 트레이딩을 위한 것입니다.

심층 컨벌루션 네트워크에 관한 책 "Deep Convolutional Networks·Principles and Practice"도 출판했습니다.

그의 주요 초점과 관심은 소프트웨어 및 하드웨어 개발에 있습니다. 이전 공개 인터뷰에서 그는 AIGC, 특히 소설 세대에 관심이 있음을 분명히 했습니다.

현재 Bloomberg의 Github 팔로워 수는 2100명입니다.

그러나 그의 가장 중요한 공개 정체성은 주로 태양 램프, 천장 램프, 휴대용 책상 램프 등을 만드는 조명 회사 Xinlin Technology의 공동 창립자입니다.

그리고 그는 고양이를 좋아하는 선배일 겁니다. Github, Zhihu, WeChat 아바타는 물론 조명 회사 공식 홈페이지와 Weibo에도 주황색 고양이가 있습니다.

Qubit은 RWKV의 현재 멀티 모달 작업에 RWKV Music(음악 방향) 및 VisualRWKV(이미지 방향) 이 포함되어 있음을 알게 되었습니다.

다음으로 RWKV는 다음 방향에 집중할 것입니다.

- 훈련 코퍼스를 확장 더욱 다양하게 (이것이 모델 성능을 향상시키는 핵심입니다); 7B 및 14B 매개변수와 같은 더 큰 버전의 Finch

- 를 학습 및 출시하고 MoE를 통해 추론 및 학습 비용을 줄여 성능을 더욱 확장합니다. Finch의 CUDA 구현을 더욱 최적화

- (알고리즘 개선 포함)하여 속도가 향상되고 병렬화가 향상되었습니다. 문서 링크:

https://arxiv.org/pdf/2404.05892.pdf

위 내용은 마법처럼 수정된 RNN이 Transformer에 도전하고 RWKV가 새로워졌습니다: 두 가지 새로운 아키텍처 모델 출시의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!