역사상 최초의 100% 오픈소스 대형 모델이 여기에 있습니다! 코드/가중치/데이터 세트/전체 교육 프로세스에 대한 기록적인 공개, AMD는 이를 교육할 수 있습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-02-04 10:03:271020검색

언어 모델은 수년간 자연어 처리(NLP) 기술의 핵심이었습니다. 모델의 엄청난 상업적 가치를 고려하여 가장 진보된 모델의 기술적 세부 사항은 공개되지 않았습니다.

이제 진정한 완전 오픈소스 대형 모델이 탄생했습니다!

Allen Institute for Artificial Intelligence, 워싱턴 대학교, 예일 대학교, 뉴욕 대학교, 카네기 멜론 대학교의 연구원들은 최근 협력하여 AI 오픈 소스 커뮤니티 이정표에 중요해질 중요한 작업을 발표했습니다.

대형 모델을 훈련하는 과정에서 거의 모든 데이터와 정보를 처음부터 오픈소스로 만들어 놨어요!

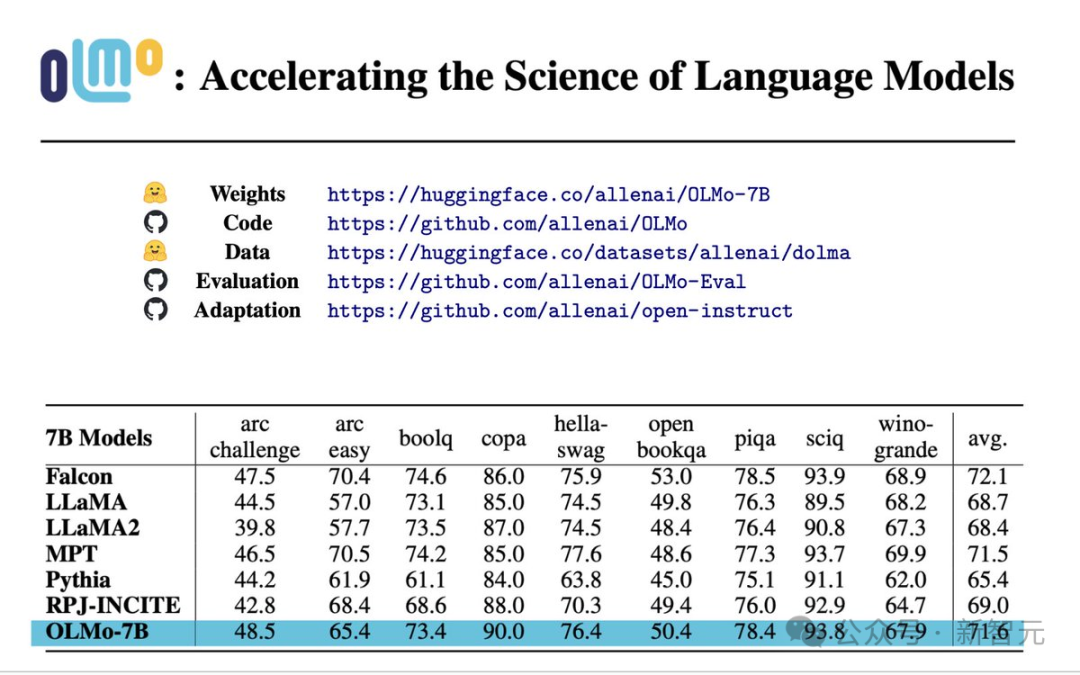

종이: https://allenai.org/olmo/olmo-paper.pdf

중량: https://huggingface.co/allenai/OLMo-7B

코드: https ://github.com/allenai/OLMo

데이터: https://huggingface.co/datasets/allenai/dolma

평가: https://github.com/allenai/OLMo-Eval

적응: https://github.com/allenai/open-instruct

구체적으로 Allen Artificial Intelligence Institute 및 교육 플랫폼에서 시작한 이 OLMo(Open Language Model) 실험은 완전한 오픈 소스를 제공합니다. 대형 모델뿐만 아니라 이 모델의 교육 및 개발과 관련된 모든 데이터 및 기술 세부 정보 -

교육 및 모델링: 여기에는 전체 모델 가중치, 교육 코드, 교육 로그, 절제 연구, 교육 측정항목이 포함됩니다. 그리고 추론 코드.

사전 훈련 코퍼스: 최대 3T 토큰과 이러한 훈련 데이터를 생성하는 코드를 포함하는 사전 훈련된 오픈 소스 코퍼스입니다.

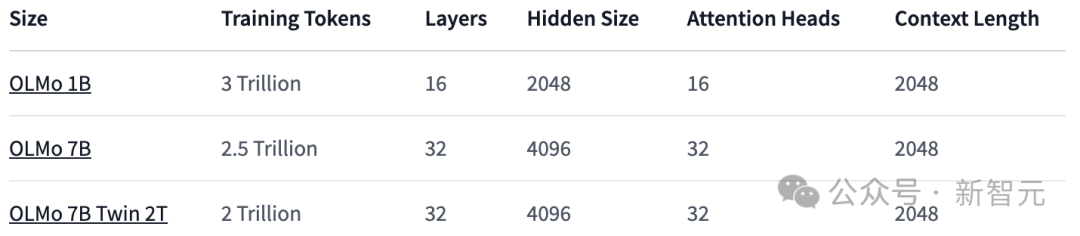

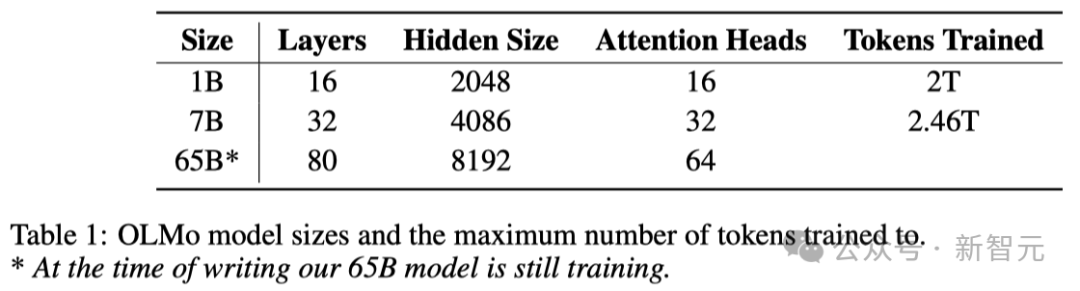

모델 매개변수: OLMo 프레임워크는 1B 크기 모델뿐만 아니라 다양한 아키텍처, 최적화 도구 및 교육 하드웨어 시스템에서 4개의 7B 크기 모델을 제공하며 모든 모델은 최소 2T 토큰입니다. 교육은 다음에서 수행되었습니다. .

동시에 모델 추론에 사용되는 코드, 훈련 과정에 대한 다양한 지표, 훈련 로그도 제공됩니다.

7B: OLMo 7B, OLMo 7B(단련되지 않음), OLMo 7B-2T, OLMo-7B-Twin-2T

평가 도구: 개발 과정에서 평가 도구를 공개했습니다. 이 제품군에는 각 모델 교육 프로세스의 1000단계마다 500개 이상의 체크포인트와 평가 코드가 포함되어 있습니다.

모든 데이터는 apache 2.0에서 사용하도록 허가되었습니다(상업적 용도로는 무료).

이런 철저한 오픈소스가 오픈소스 커뮤니티의 본보기가 되는 것 같습니다. 앞으로는 저처럼 오픈소스가 아니라면 오픈소스 모델이라고 말하지 마세요.

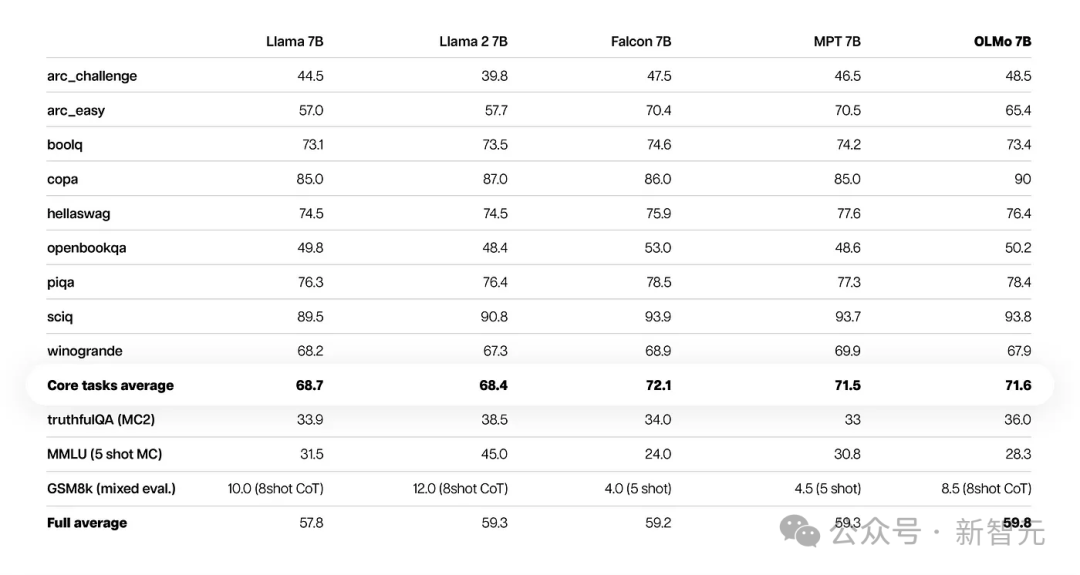

성능 평가

핵심 평가 결과에서 OLMo-7B는 유사한 오픈 소스 모델보다 약간 우수합니다.

처음 9개 평가 중 OLMo-7B는 8개 평가 중 상위 3위에 올랐고, 그 중 2개는 다른 모든 모델을 능가했습니다.

OLMo-7B는 여러 세대 작업이나 독해 작업(예: truefulQA)에서 Llama 2를 능가하지만 일부 인기 있는 질문 및 답변 작업(예: MMLU 또는 Big-bench Hard)에서는 성능이 더 나쁩니다.

처음 9개 작업은 사전 학습된 모델에 대한 연구원의 내부 평가 기준이며, HuggingFace Open LLM 순위를 높이기 위해 다음 3개 작업이 추가되었습니다.

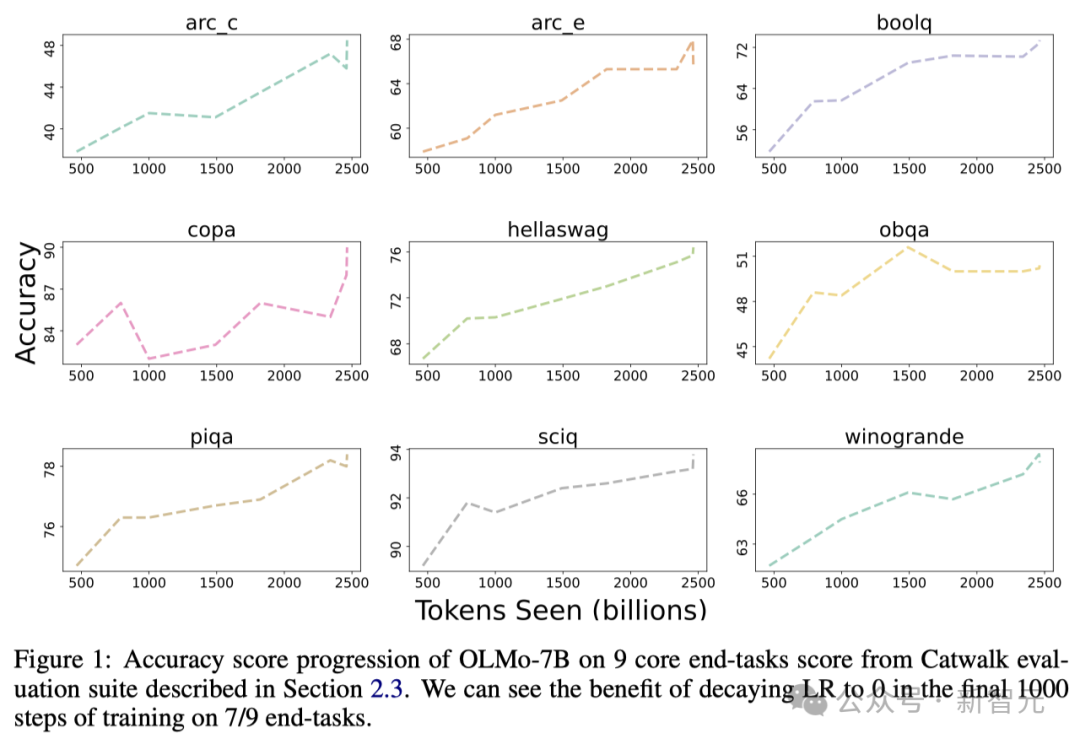

아래 그림은 9개 핵심 작업의 정확도를 보여줍니다. .

OBQA를 제외하고 OLMo-7B는 학습을 위해 더 많은 데이터를 수신할수록 거의 모든 작업의 정확도가 상승하는 추세를 보입니다.

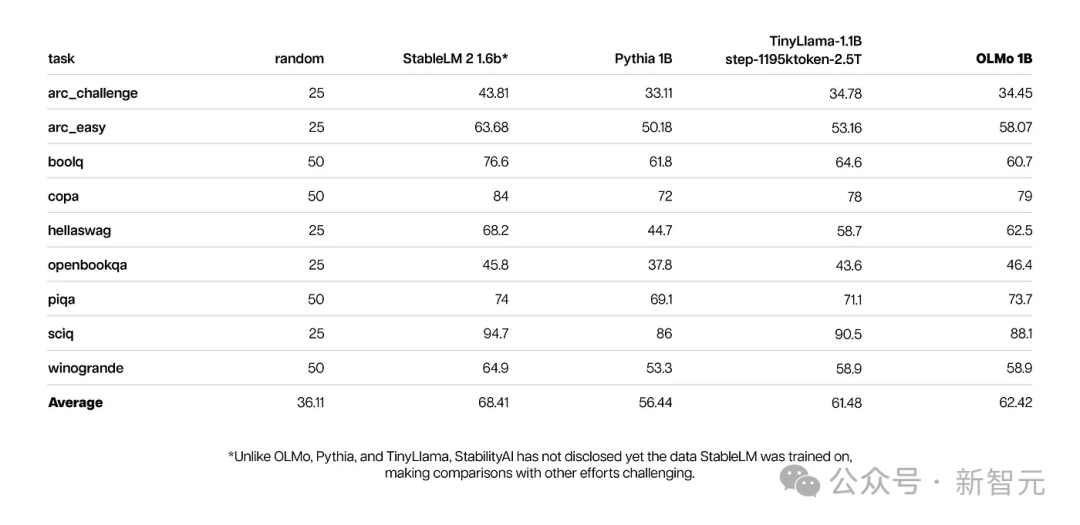

동시에 OLMo 1B 및 유사 모델의 핵심 평가 결과는 OLMo가 그들과 동일한 수준임을 보여줍니다.

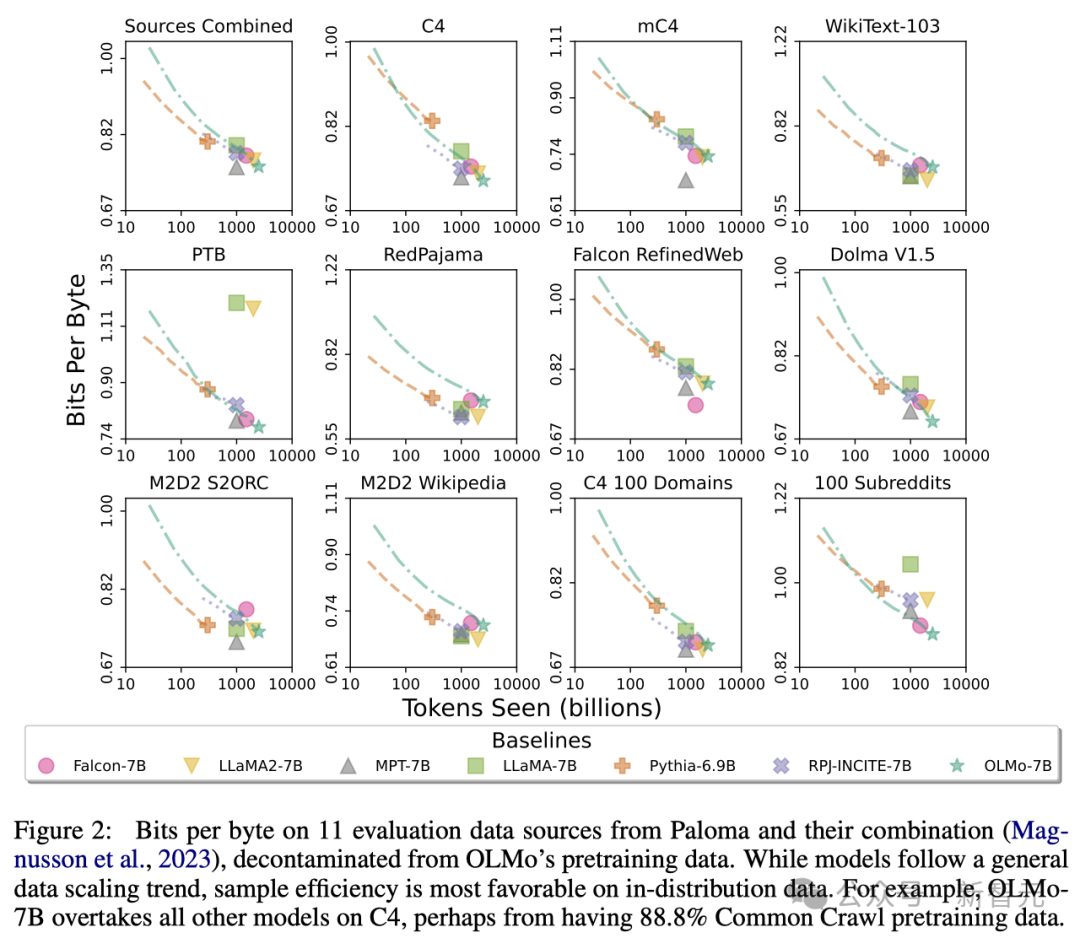

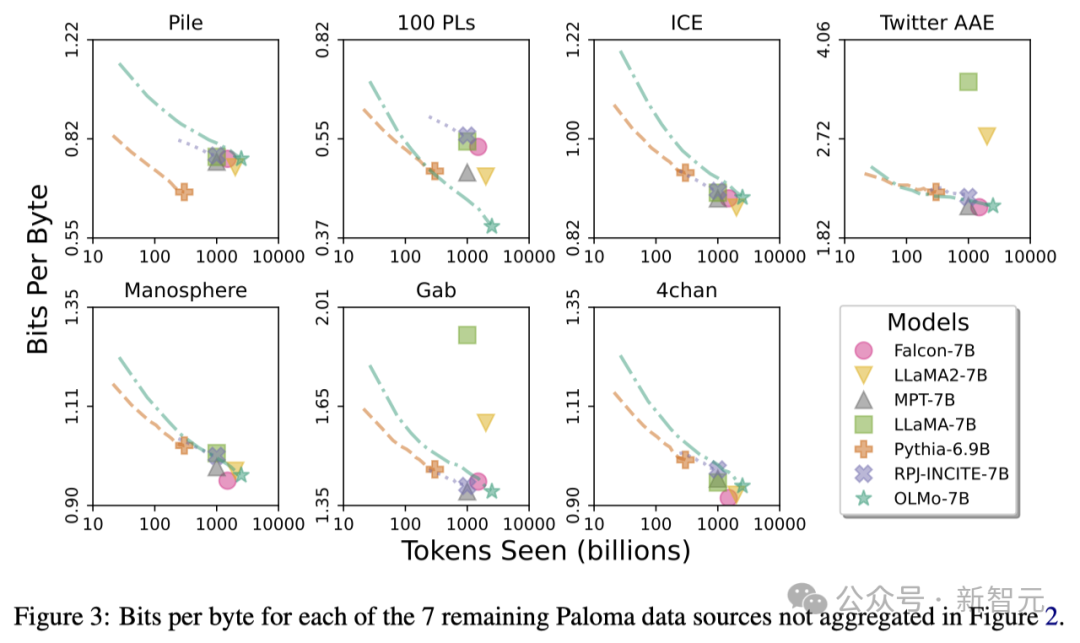

연구원들은 Allen AI Institute의 Paloma(벤치마크)와 사용 가능한 체크포인트를 사용하여 모델의 언어 예측 능력과 모델 크기 요인(예: 훈련된 토큰 수) 관계 간의 관계를 분석했습니다.

OLMo-7B는 성능면에서 주류 모델과 동등한 수준임을 알 수 있습니다. 그중에서도 바이트당 비트 수(Bits per Byte)는 낮을수록 좋습니다.

이러한 분석을 통해 연구원들은 다양한 데이터 소스를 처리하는 모델의 효율성이 크게 달라지며, 이는 주로 모델 훈련 데이터와 평가 데이터 간의 유사성에 따라 달라진다는 사실을 발견했습니다.

특히 OLMo-7B는 주로 Common Crawl(예: C4)을 기반으로 하는 데이터 소스에서 우수한 성능을 발휘합니다.

그러나 OLMo-7B는 WikiText-103, M2D2 S2ORC 및 M2D2 Wikipedia와 같이 웹 스크래핑 텍스트와 거의 관련이 없는 데이터 소스에 대한 다른 모델보다 효율성이 떨어집니다.

RedPajama의 평가도 유사한 추세를 보여줍니다. 아마도 7개 필드 중 2개만 Common Crawl에서 나온 것이고 Paloma는 각 데이터 소스의 각 필드에 동일한 가중치를 부여하기 때문일 것입니다.

Wikipedia 및 arXiv 논문과 같은 선별된 데이터 소스는 웹에서 스크랩한 텍스트보다 훨씬 적은 이질적인 데이터를 제공하므로 사전 학습 데이터 세트의 어려움이 계속 증가함에 따라 이러한 언어 분포에 대해 높은 효율성을 유지하는 것이 더 효율적입니다.

OLMo 아키텍처

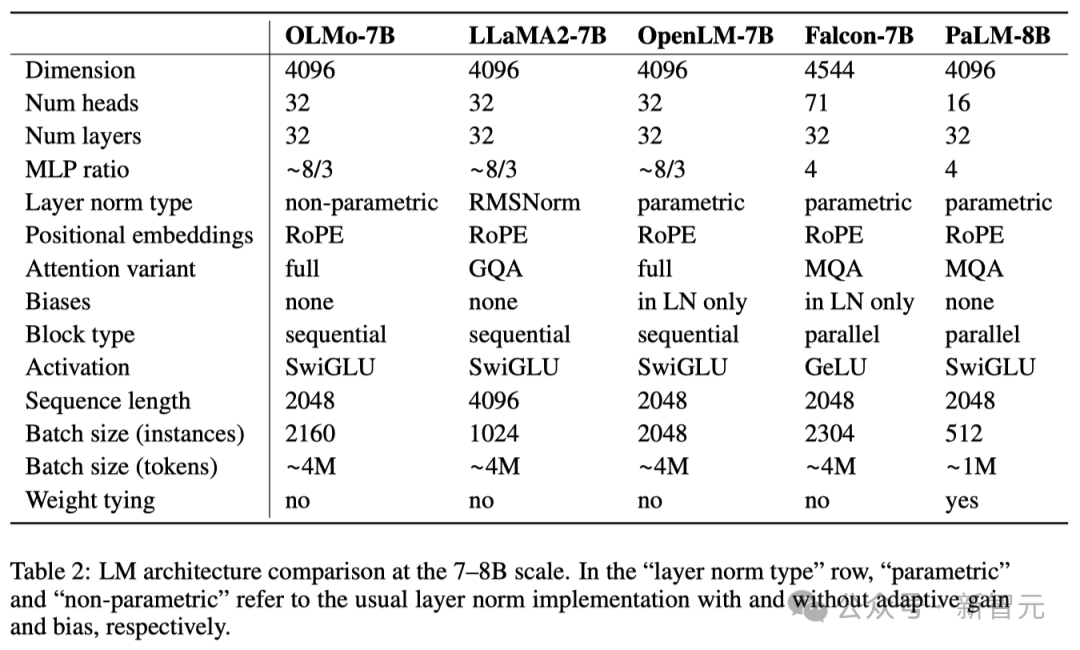

모델 아키텍처 측면에서 팀은 디코더 전용 Transformer 아키텍처를 기반으로 하며 PaLM 및 Llama에서 사용하는 SwiGLU 활성화 기능을 채택하고 RoPE(회전 위치 임베딩 기술)를 도입합니다. 모델 출력에서 개인 식별 정보를 줄이기 위해 GPT-NeoX-20B의 BPE(바이트 쌍 인코딩) 기반 토크나이저를 개선했습니다.

또한 모델의 안정성을 보장하기 위해 연구자들은 편향 용어를 사용하지 않았습니다(PaLM과 동일함).

아래 표와 같이 연구진은 1B와 7B 두 가지 버전을 출시했으며, 곧 65B 버전도 출시할 계획입니다.

아래 표는 비슷한 규모의 다른 모델과 7B 아키텍처의 성능을 자세히 비교한 것입니다.

사전 훈련 데이터세트: Dolma

연구원들이 모델 매개변수를 얻는 데 약간의 진전을 이루었지만 오픈 소스 커뮤니티의 사전 훈련 데이터세트의 현재 개방성 수준은 충분하지 않습니다.

이전 사전 학습 데이터는 모델의 오픈 소스(비공개 소스 모델은 말할 것도 없고)로 공개되지 않는 경우가 많습니다.

그리고 이러한 데이터에 대한 문서에는 충분한 세부 정보가 부족한 경우가 많지만 이러한 세부 정보는 연구를 재현하거나 관련 작업을 완전히 이해하는 데 중요합니다.

이러한 상황은 언어 모델 연구를 더욱 어렵게 만듭니다. 예를 들어 훈련 데이터가 모델 기능과 그 한계에 어떤 영향을 미치는지 이해하는 것입니다.

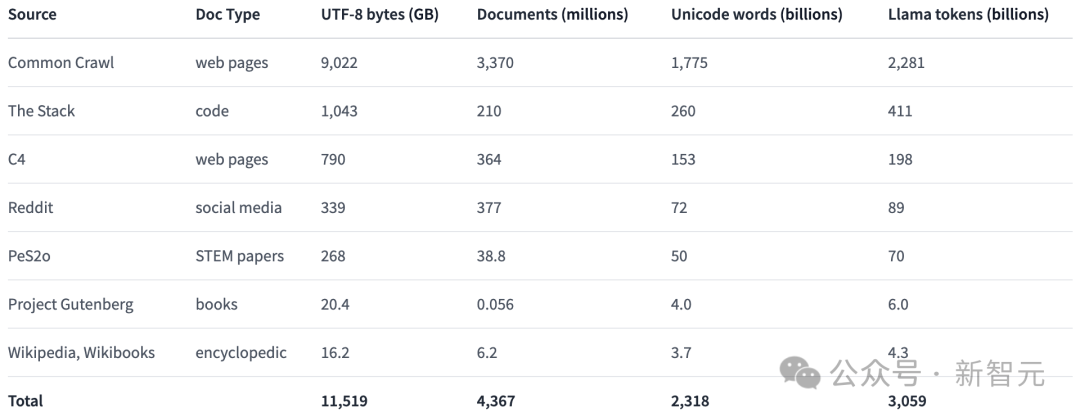

언어 모델 사전 훈련 분야의 공개 연구를 촉진하기 위해 연구자들은 사전 훈련 데이터 세트 Dolma를 구축하여 공개했습니다.

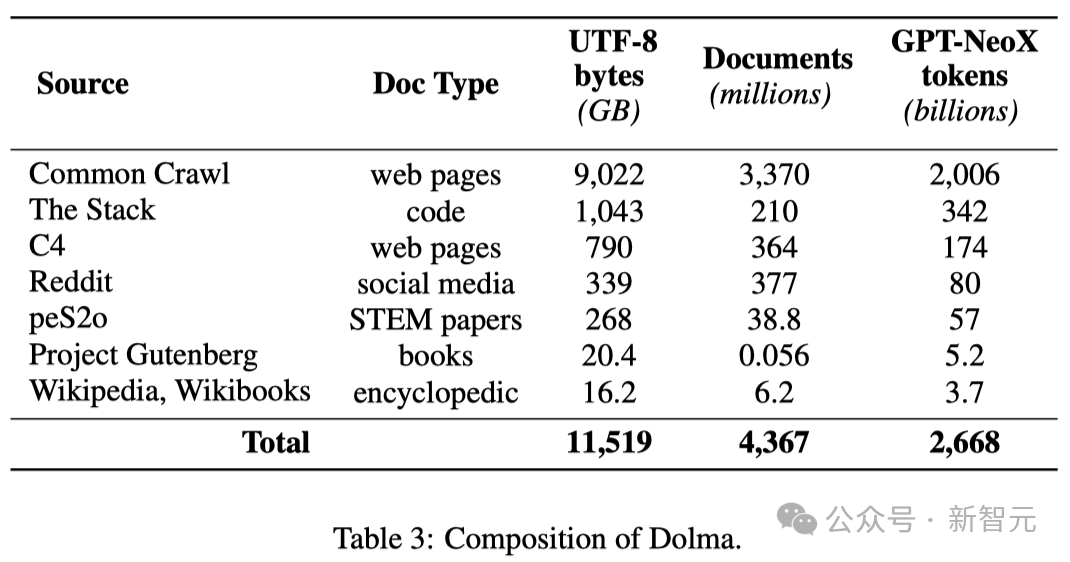

7개의 서로 다른 데이터 소스에서 얻은 3조 개의 토큰을 포함하는 다양한 다중 소스 코퍼스입니다.

이러한 데이터 소스는 대규모 언어 모델 사전 학습에서 흔히 볼 수 있는 반면, 일반 대중에게도 접근이 가능합니다.

아래 표는 다양한 데이터 소스의 데이터 볼륨에 대한 개요를 제공합니다.

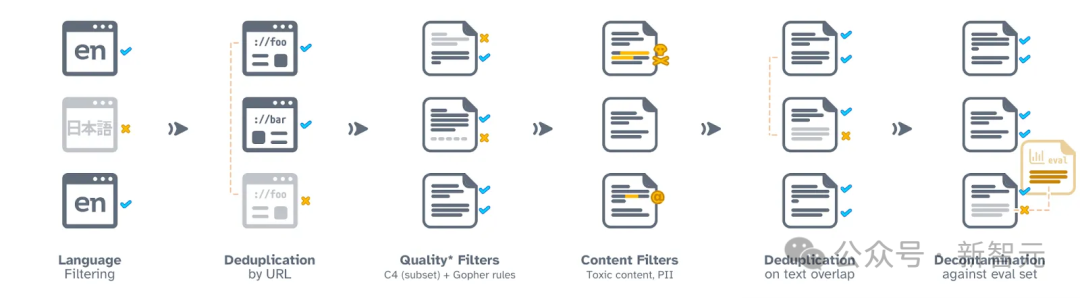

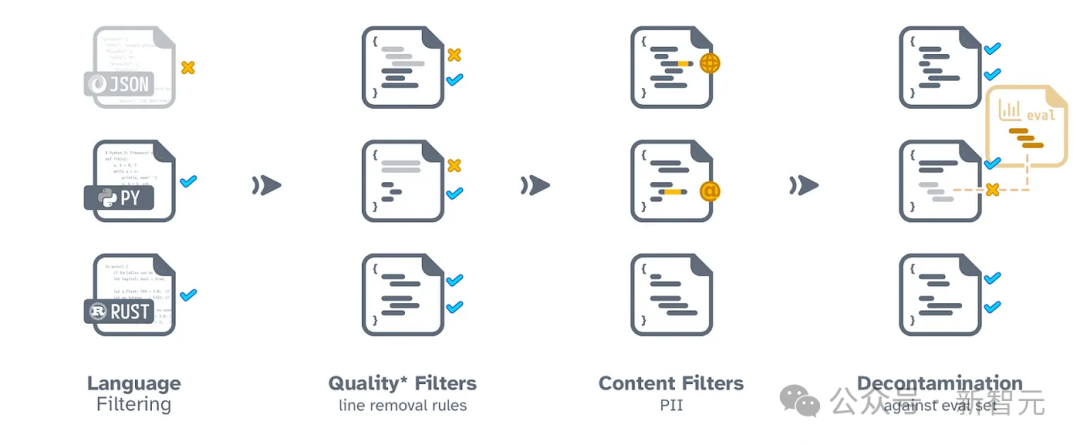

Dolma의 구성 프로세스에는 언어 필터링, 품질 필터링, 콘텐츠 필터링, 중복 제거, 다중 소스 혼합 및 토큰화의 6단계가 포함됩니다.

Dolma를 대조하고 최종 출판하는 과정에서 연구자들은 각 데이터 소스의 문서가 독립적으로 유지되도록 확인했습니다.

또한 Dolma를 추가로 연구하고, 결과를 복제하고, 사전 훈련 코퍼스 구성을 단순화하는 데 도움이 되는 효율적인 데이터 구성 도구 세트를 오픈 소스로 제공했습니다.

또한 연구원들은 데이터 세트 분석을 용이하게 하기 위해 WIMBD 도구를 오픈 소스로 제공했습니다.

네트워크 데이터 처리 프로세스

코드 처리 프로세스

Training OLMo

분산 교육 프레임워크

연구원들이 사용하는 PyTorch 의 FS DP 프레임워크 및 ZeRO 최적화 전략이 제공됩니다. 모델 교육 . 이 접근 방식은 모델의 가중치와 해당 최적화 상태를 여러 GPU에 걸쳐 분할하여 메모리 사용량을 효과적으로 줄입니다.

최대 7B 크기의 모델을 처리할 때 이 기술을 사용하면 연구원은 GPU당 4096개 토큰의 마이크로 배치 크기를 처리하여 보다 효율적인 교육을 수행할 수 있습니다.

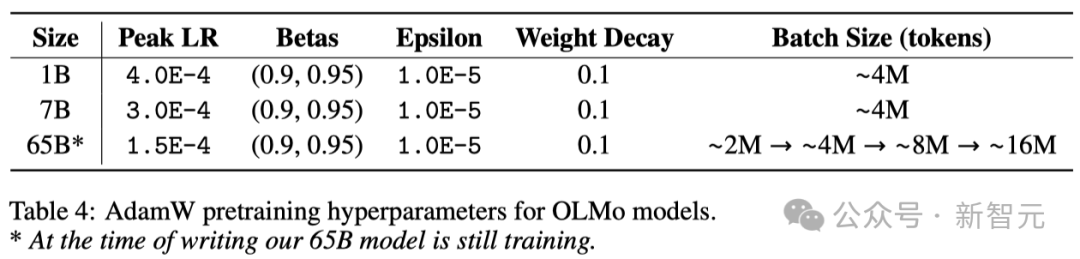

OLMo-1B 및 7B 모델의 경우 연구원들은 약 4M 토큰(2048개의 데이터 인스턴스, 각 인스턴스에 2048개의 토큰 시퀀스가 포함됨)의 전역 배치 크기를 고정했습니다.

현재 교육 중인 OLMo-65B 모델의 경우 연구원들은 약 2M 토큰(1024개 데이터 인스턴스)에서 시작하여 추가 100B 토큰마다 배치 크기를 두 배로 늘리는 배치 크기 워밍업 전략을 채택했습니다. 마침내 약 1600만 개의 토큰(8192개 데이터 인스턴스) 크기에 도달했습니다.

연구원들은 모델 훈련 속도를 높이기 위해 FSDP의 내부 구성과 PyTorch의 앰프 모듈을 통해 구현되는 혼합 정밀 훈련 기술을 채택했습니다.

이 방법은 훈련 프로세스의 안정성을 보장하기 위해 일부 주요 계산 단계(예: 소프트맥스 함수)가 항상 가장 높은 정확도로 수행되도록 특별히 설계되었습니다.

한편, 대부분의 다른 계산에서는 bfloat16이라는 반정밀도 형식을 사용하여 메모리 사용량을 줄이고 계산 효율성을 높입니다.

특정 구성에서는 모델 가중치와 최적화 상태가 각 GPU에 최대 정확도로 저장됩니다.

모델의 순전파 및 역전파를 수행하는 경우, 즉 모델의 출력을 계산하고 가중치를 업데이트하는 경우에만 각 Transformer 모듈 내의 가중치가 일시적으로 bfloat16 형식으로 변환됩니다.

또한 GPU 간에 그라디언트 업데이트가 동기화되면 훈련 품질을 보장하기 위해 가장 높은 정확도로 수행됩니다.

Optimizer

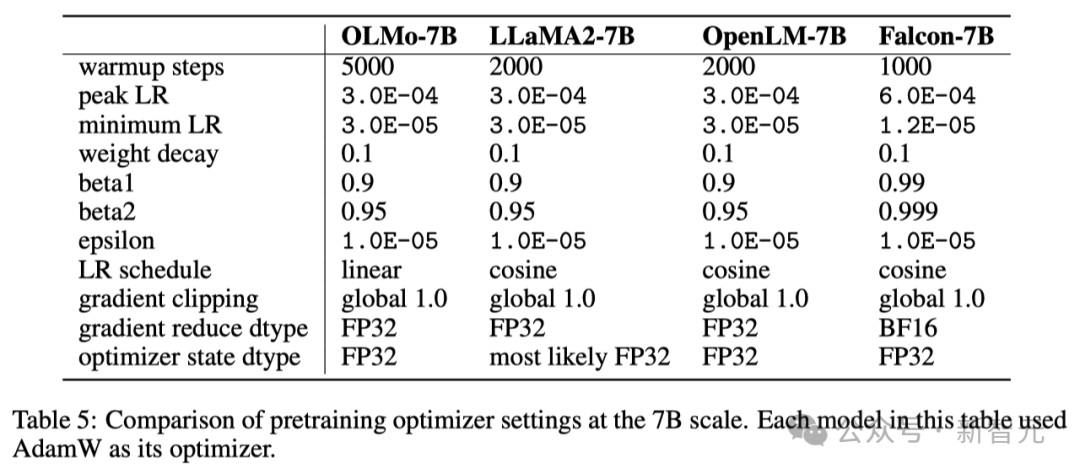

연구원들은 AdamW 최적화 프로그램을 사용하여 모델 매개변수를 조정했습니다.

모델의 크기에 관계없이 연구자들은 학습의 처음 5000단계(대략 210억 개의 토큰 처리) 내에서 학습률을 점차적으로 높입니다. 이 과정을 학습률 워밍업이라고 합니다.

웜업이 완료된 후 학습률은 최대 학습률의 1/10로 떨어질 때까지 선형적으로 점차 감소합니다.

또한 연구원들은 전체 L1 표준이 1.0을 초과하지 않도록 모델 매개변수의 기울기를 잘라낼 것입니다.

아래 표에서 연구원들은 7B 모델 규모의 최적화 구성을 AdamW 최적화를 사용하는 다른 최근 대규모 언어 모델과 비교합니다.

Dataset

연구원들은 공개 데이터 세트 Dolma의 2T 토큰 샘플을 사용하여 훈련 데이터 세트를 구성했습니다.

연구원들은 각 문서의 토큰을 연결하고 각 문서 끝에 특수 EOS 토큰을 추가한 다음 이 토큰을 2048개의 그룹으로 나누어 훈련 샘플을 구성했습니다.

이러한 훈련 샘플은 각 훈련 중에 동일한 방식으로 무작위로 섞입니다. 연구원들은 또한 누구나 각 훈련 배치의 특정 데이터 순서와 구성을 복구할 수 있는 도구를 제공합니다.

연구원들이 출시한 모든 모델은 최소 1라운드(2T 토큰) 동안 훈련되었습니다. 이러한 모델 중 일부는 데이터에 대한 두 번째 훈련을 실행하여 추가로 훈련되었지만 무작위 순서 섞기 순서는 다릅니다.

이전 연구에 따르면 이러한 방식으로 소량의 데이터를 재사용할 때 미치는 영향은 미미합니다.

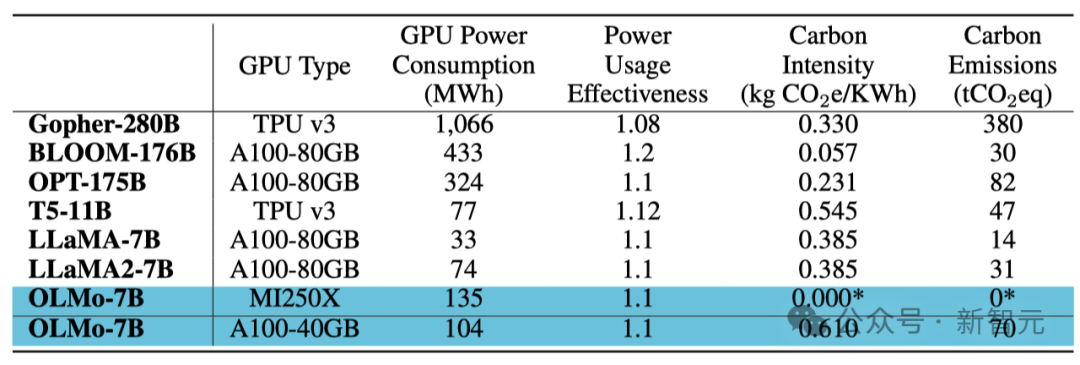

NVIDIA와 AMD 모두 '예'를 원합니다!

코드 베이스가 NVIDIA 및 AMD GPU 모두에서 효율적으로 실행될 수 있도록 하기 위해 연구원들은 모델 훈련 테스트를 위해 두 개의 서로 다른 클러스터를 선택했습니다.

LUMI 슈퍼컴퓨터를 사용하여 연구원들은 최대 256개의 클러스터를 배포했습니다. 노드마다 각 노드에는 4개의 AMD MI250X GPU가 장착되어 있으며 각 GPU에는 128GB 메모리와 800Gbps의 데이터 전송 속도가 있습니다.

MosaicML(Databricks)의 지원으로 연구원들은 27개의 노드를 사용했으며 각 노드에는 8개의 NVIDIA A100 GPU가 장착되었으며 각 GPU에는 40GB의 메모리와 800Gbps의 데이터 전송 속도가 있습니다.

연구원들이 훈련 효율성을 높이기 위해 배치 크기를 미세 조정했지만 2T 토큰 평가를 완료한 후 두 클러스터의 성능에는 거의 차이가 없었습니다.

훈련 에너지 소비

요약

모델 가중치와 추론 코드만 제공하는 대부분의 이전 모델과 달리 연구원들은 훈련 데이터, 훈련 및 평가 코드를 포함한 OLMo의 전체 콘텐츠를 오픈 소스화했습니다. 훈련 로그, 실험 결과, 중요한 결과, 가중치 및 편향 기록 등도 포함됩니다.

또한 팀은 교육 최적화 및 다양한 유형의 강화 학습(RLHF)을 통해 OLMo를 개선하는 방법을 연구하고 있습니다. 이러한 미세 조정된 코드, 데이터 및 미세 조정된 모델도 오픈 소스가 될 것입니다.

연구원들은 OLMo와 그 프레임워크를 지속적으로 지원 및 개발하고, 개방형 언어 모델(LM)의 개발을 촉진하며, 개방형 연구 커뮤니티의 발전을 돕기 위해 최선을 다하고 있습니다. 이를 위해 연구원들은 OLMo 제품군을 풍부하게 하기 위해 다양한 규모, 다양한 양식, 데이터 세트, 보안 조치 및 평가 방법을 갖춘 더 많은 모델을 도입할 계획입니다.

앞으로도 계속되는 철저한 오픈소스 작업을 통해 오픈소스 연구 커뮤니티의 저력을 강화하고 새로운 혁신의 물결을 일으키기를 기대합니다.

팀 소개

Yizhong Wang(王义中)

Yizhong Wang은 워싱턴 대학교 컴퓨터 공학부 Paul G. Allen School of Computer Science and Engineering의 박사 과정 학생으로 Hannaneh Hajishirzi와 Noah의 멘토를 받고 있습니다. 스미스. 동시에 그는 Allen Institute for Artificial Intelligence에서 시간제 연구 인턴이기도 합니다.

이전에는 Meta AI, Microsoft Research 및 Baidu NLP에서 인턴을 했습니다. 이전에는 북경대학교에서 석사학위를, 상하이 교통대학교에서 학사학위를 취득했습니다.

그의 연구 방향은 자연어 처리, 기계 학습, 대형 언어 모델(LLM)입니다.

- LLM의 적응성: 지침을 따를 수 있는 모델을 보다 효율적으로 구축하고 평가하는 방법은 무엇입니까? 이러한 모델을 미세 조정할 때 고려해야 할 요소는 무엇이며 모델의 일반화 가능성에 어떤 영향을 줍니까? 어떤 유형의 감독이 효과적이고 확장 가능합니까?

- LLM을 위한 지속적인 학습: 사전 교육과 미세 조정 사이의 경계는 어디입니까? LLM이 사전 교육 이후에도 계속해서 발전할 수 있도록 하는 아키텍처와 학습 전략은 무엇입니까? 모델 내의 기존 지식은 새로 학습된 지식과 어떻게 상호 작용합니까?

- 대규모 합성 데이터의 적용: 오늘날 생성 모델이 데이터를 빠르게 생성할 때 이 데이터는 모델 개발은 물론 인터넷과 사회 전체에 어떤 영향을 미칠까요? 다양하고 고품질의 데이터를 대규모로 생성할 수 있는지 어떻게 보장합니까? 이 데이터를 인간이 생성한 데이터와 구별할 수 있습니까?

Yuling Gu

Yuling Gu는 Allen Institute for Artificial Intelligence(AI2)의 Aristo 팀 연구원입니다.

2020년에 그녀는 뉴욕 대학교(NYU)에서 학사 학위를 받았습니다. 그녀는 컴퓨터 과학 전공 외에도 언어학, 심리학, 철학을 결합한 학제간 전공인 언어와 정신을 부전공했습니다. 이후 그녀는 워싱턴 대학교(UW)에서 석사 학위를 취득했습니다.

머신러닝 기술과 인지과학 이론의 통합과 응용에 대한 열정이 넘치는 분입니다.

위 내용은 역사상 최초의 100% 오픈소스 대형 모델이 여기에 있습니다! 코드/가중치/데이터 세트/전체 교육 프로세스에 대한 기록적인 공개, AMD는 이를 교육할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!